Guia de Início Rápido: NVIDIA Jetson com Ultralytics YOLO26

Este guia abrangente oferece um passo a passo detalhado para implantar o Ultralytics YOLO26 em dispositivos NVIDIA Jetson. Além disso, ele apresenta benchmarks de desempenho para demonstrar as capacidades do YOLO26 nesses dispositivos pequenos e poderosos.

Novo suporte a produtos

Atualizamos este guia com o mais recente NVIDIA Jetson AGX Thor Developer Kit, que oferece até 2070 FP4 TFLOPS de computação de IA e 128 GB de memória com potência configurável entre 40 W e 130 W. Oferece mais de 7,5 vezes mais computação de IA do que o NVIDIA Jetson AGX Orin, com uma eficiência energética 3,5 vezes melhor para executar perfeitamente os modelos de IA mais populares.

Assista: Como usar o Ultralytics YOLO26 em Dispositivos NVIDIA Jetson

Nota

Este guia foi testado com NVIDIA Jetson AGX Thor Developer Kit (Jetson T5000) executando a versão estável mais recente do JetPack JP7.0, NVIDIA Jetson AGX Orin Developer Kit (64GB) executando a versão do JetPack JP6.2, NVIDIA Jetson Orin Nano Super Developer Kit executando a versão do JetPack JP6.1, Seeed Studio reComputer J4012 que é baseado em NVIDIA Jetson Orin NX 16GB executando a versão do JetPack JP6.0/ versão do JetPack JP5.1.3 e Seeed Studio reComputer J1020 v2 que é baseado em NVIDIA Jetson Nano 4GB executando a versão do JetPack JP4.6.1. Espera-se que funcione em toda a linha de hardware NVIDIA Jetson, incluindo os dispositivos mais recentes e legados.

O que é NVIDIA Jetson?

NVIDIA Jetson é uma série de placas de computação embarcada projetadas para levar a computação de IA (inteligência artificial) acelerada a dispositivos de borda. Esses dispositivos compactos e poderosos são construídos em torno da arquitetura GPU da NVIDIA e podem executar algoritmos complexos de IA e modelos de deep learning diretamente no dispositivo, sem depender de recursos de computação em nuvem. As placas Jetson são frequentemente usadas em robótica, veículos autônomos, automação industrial e outras aplicações onde a inferência de IA precisa ser realizada localmente com baixa latência e alta eficiência. Além disso, essas placas são baseadas na arquitetura ARM64 e operam com menor consumo de energia em comparação com os dispositivos de computação GPU tradicionais.

Comparação da Série NVIDIA Jetson

NVIDIA Jetson AGX Thor é a iteração mais recente da família NVIDIA Jetson baseada na arquitetura NVIDIA Blackwell, que traz um desempenho de IA drasticamente aprimorado em comparação com as gerações anteriores. A tabela abaixo compara alguns dos dispositivos Jetson no ecossistema.

| Jetson AGX Thor (T5000) | Jetson AGX Orin 64GB | Jetson Orin NX 16GB | Jetson Orin Nano Super | Jetson AGX Xavier | Jetson Xavier NX | Jetson Nano | |

|---|---|---|---|---|---|---|---|

| Desempenho de IA | 2070 TFLOPS | 275 TOPS | 100 TOPS | 67 TOPS | 32 TOPS | 21 TOPS | 472 GFLOPS |

| GPU | GPU NVIDIA Blackwell architecture de 2560 núcleos com 96 Tensor Cores | GPU NVIDIA Ampere com arquitetura de 2048 núcleos e 64 Cores Tensor | GPU NVIDIA Ampere architecture de 1024 núcleos com 32 Tensor Cores | GPU NVIDIA Ampere architecture de 1024 núcleos com 32 Tensor Cores | GPU NVIDIA Volta com arquitetura de 512 núcleos e 64 Tensor Cores | GPU NVIDIA Volta™ com arquitetura de 384 núcleos e 48 Cores Tensor | GPU NVIDIA Maxwell™ architecture de 128 núcleos |

| Frequência Máxima da GPU | 1.57 GHz | 1.3 GHz | 918 MHz | 1020 MHz | 1377 MHz | 1100 MHz | 921MHz |

| CPU | CPU Arm® Neoverse®-V3AE de 64 bits e 14 núcleos, 1 MB L2 + 16 MB L3 | CPU NVIDIA Arm® Cortex A78AE v8.2 de 64 bits e 12 núcleos, 3 MB L2 + 6 MB L3 | CPU NVIDIA Arm® Cortex A78AE v8.2 de 8 núcleos e 64 bits, 2 MB L2 + 4 MB L3 | CPU Arm® Cortex®-A78AE v8.2 de 6 núcleos e 64 bits, 1,5 MB L2 + 4 MB L3 | CPU NVIDIA Carmel Arm®v8.2 de 8 núcleos e 64 bits, 8 MB L2 + 4 MB L3 | CPU NVIDIA Carmel Arm®v8.2 de 6 núcleos e 64 bits, 6 MB L2 + 4 MB L3 | Processador Quad-Core Arm® Cortex®-A57 MPCore |

| Frequência Máxima da CPU | 2.6 GHz | 2.2 GHz | 2.0 GHz | 1.7 GHz | 2.2 GHz | 1.9 GHz | 1.43GHz |

| Memória | 128 GB 256-bit LPDDR5X 273 GB/s | LPDDR5 de 64 GB e 256 bits, 204,8 GB/s | 16 GB 128-bit LPDDR5 102,4 GB/s | LPDDR5 de 8 GB e 128 bits, 102 GB/s | 32 GB 256-bit LPDDR4x 136,5 GB/s | LPDDR4x de 8 GB e 128 bits, 59,7 GB/s | 4GB 64-bit LPDDR4 25.6GB/s |

Para uma tabela de comparação mais detalhada, visite a seção Compare Specifications da página oficial do NVIDIA Jetson.

O que é NVIDIA JetPack?

O NVIDIA JetPack SDK, que alimenta os módulos Jetson, é a solução mais abrangente e fornece um ambiente de desenvolvimento completo para a criação de aplicações de IA aceleradas de ponta a ponta e reduz o tempo de lançamento no mercado. O JetPack inclui Jetson Linux com bootloader, kernel Linux, ambiente de desktop Ubuntu e um conjunto completo de bibliotecas para aceleração de computação de GPU, multimídia, gráficos e visão computacional. Ele também inclui amostras, documentação e ferramentas de desenvolvedor para computador host e kit de desenvolvedor, e suporta SDKs de nível superior, como DeepStream para análise de vídeo em streaming, Isaac para robótica e Riva para IA conversacional.

Instalar o JetPack no NVIDIA Jetson

O primeiro passo após adquirir um dispositivo NVIDIA Jetson é fazer o flash do NVIDIA JetPack no dispositivo. Existem várias maneiras diferentes de fazer o flash em dispositivos NVIDIA Jetson.

- Se você possui um Kit de Desenvolvimento NVIDIA oficial, como o Jetson AGX Thor Developer Kit, você pode baixar uma imagem e preparar um stick USB inicializável para instalar o JetPack no SSD incluído.

- Se você possui um Kit de Desenvolvimento NVIDIA oficial, como o Jetson Orin Nano Developer Kit, você pode baixar uma imagem e preparar um cartão SD com o JetPack para inicializar o dispositivo.

- Se você possui qualquer outro Kit de Desenvolvimento NVIDIA, você pode instalar o JetPack no dispositivo usando o SDK Manager.

- Se você possui um dispositivo Seeed Studio reComputer J4012, você pode instalar o JetPack no SSD incluído e, se você possui um dispositivo Seeed Studio reComputer J1020 v2, você pode instalar o JetPack no eMMC/SSD.

- Se você possui qualquer outro dispositivo de terceiros alimentado pelo módulo NVIDIA Jetson, é recomendado seguir o flashing por linha de comando.

Nota

Para os métodos 1, 4 e 5 acima, após instalar o sistema e inicializar o dispositivo, insira "sudo apt update && sudo apt install nvidia-jetpack -y" no terminal do dispositivo para instalar todos os componentes JetPack restantes necessários.

Suporte do JetPack Baseado no Dispositivo Jetson

A tabela abaixo destaca as versões do NVIDIA JetPack suportadas por diferentes dispositivos NVIDIA Jetson.

| JetPack 4 | JetPack 5 | JetPack 6 | JetPack 7 | |

|---|---|---|---|---|

| Jetson Nano | ✅ | ❌ | ❌ | ❌ |

| Jetson TX2 | ✅ | ❌ | ❌ | ❌ |

| Jetson Xavier NX | ✅ | ✅ | ❌ | ❌ |

| Jetson AGX Xavier | ✅ | ✅ | ❌ | ❌ |

| Jetson AGX Orin | ❌ | ✅ | ✅ | ❌ |

| Jetson Orin NX | ❌ | ✅ | ✅ | ❌ |

| Jetson Orin Nano | ❌ | ✅ | ✅ | ❌ |

| Jetson AGX Thor | ❌ | ❌ | ❌ | ✅ |

Início Rápido com Docker

A maneira mais rápida de começar com o Ultralytics YOLO26 em NVIDIA Jetson é executar com imagens Docker pré-construídas para Jetson. Consulte a tabela acima e escolha a versão do JetPack de acordo com o dispositivo Jetson que você possui.

t=ultralytics/ultralytics:latest-jetson-jetpack4

sudo docker pull $t && sudo docker run -it --ipc=host --runtime=nvidia $t

t=ultralytics/ultralytics:latest-jetson-jetpack5

sudo docker pull $t && sudo docker run -it --ipc=host --runtime=nvidia $t

t=ultralytics/ultralytics:latest-jetson-jetpack6

sudo docker pull $t && sudo docker run -it --ipc=host --runtime=nvidia $t

t=ultralytics/ultralytics:latest-nvidia-arm64

sudo docker pull $t && sudo docker run -it --ipc=host --runtime=nvidia $t

Depois de feito isso, pule para a seção Usar TensorRT no NVIDIA Jetson.

Comece com a Instalação Nativa

Para uma instalação nativa sem Docker, consulte os passos abaixo.

Executar no JetPack 7.0

Instalar Pacote Ultralytics

Aqui, instalaremos o pacote Ultralytics no Jetson com dependências opcionais para que possamos exportar os modelos PyTorch para outros formatos diferentes. Focaremos principalmente nas exportações NVIDIA TensorRT, porque o TensorRT garantirá que possamos obter o máximo desempenho dos dispositivos Jetson.

Atualize a lista de pacotes, instale o pip e atualize para a versão mais recente

sudo apt update sudo apt install python3-pip -y pip install -U pipInstalar

ultralyticspacote pip com dependências opcionaispip install ultralytics[export]Reinicie o dispositivo

sudo reboot

Instalar PyTorch e Torchvision

A instalação ultralytics acima irá instalar o Torch e o Torchvision. No entanto, esses 2 pacotes instalados via pip não são compatíveis para serem executados no Jetson AGX Thor que vem com JetPack 7.0 e CUDA 13. Portanto, precisamos instalá-los manualmente.

Instalar torch e torchvision de acordo com JP7.0

pip install torch torchvision --index-url https://download.pytorch.org/whl/cu130

Instalar onnxruntime-gpu

O onnxruntime-gpu pacote hospedado no PyPI não tem aarch64 binários para o Jetson. Portanto, precisamos instalar este pacote manualmente. Este pacote é necessário para algumas das exportações.

Aqui vamos baixar e instalar onnxruntime-gpu 1.24.0 com Python3.12 suporte.

pip install https://github.com/ultralytics/assets/releases/download/v0.0.0/onnxruntime_gpu-1.24.0-cp312-cp312-linux_aarch64.whl

Executar no JetPack 6.1

Instalar Pacote Ultralytics

Aqui, instalaremos o pacote Ultralytics no Jetson com dependências opcionais para que possamos exportar os modelos PyTorch para outros formatos diferentes. Focaremos principalmente nas exportações NVIDIA TensorRT, porque o TensorRT garantirá que possamos obter o máximo desempenho dos dispositivos Jetson.

Atualize a lista de pacotes, instale o pip e atualize para a versão mais recente

sudo apt update sudo apt install python3-pip -y pip install -U pipInstalar

ultralyticspacote pip com dependências opcionaispip install ultralytics[export]Reinicie o dispositivo

sudo reboot

Instalar PyTorch e Torchvision

A instalação ultralytics acima irá instalar o Torch e o Torchvision. No entanto, esses dois pacotes instalados via pip não são compatíveis com a plataforma Jetson, que é baseada na arquitetura ARM64. Portanto, precisamos instalar manualmente um wheel pip PyTorch pré-compilado e compilar ou instalar o Torchvision a partir do código fonte.

Instalar torch 2.5.0 e torchvision 0.20 de acordo com JP6.1

pip install https://github.com/ultralytics/assets/releases/download/v0.0.0/torch-2.5.0a0+872d972e41.nv24.08-cp310-cp310-linux_aarch64.whl

pip install https://github.com/ultralytics/assets/releases/download/v0.0.0/torchvision-0.20.0a0+afc54f7-cp310-cp310-linux_aarch64.whl

Nota

Visite a página do PyTorch para Jetson para acessar todas as diferentes versões do PyTorch para diferentes versões do JetPack. Para uma lista mais detalhada sobre a compatibilidade do PyTorch e Torchvision, visite a página de compatibilidade do PyTorch e Torchvision.

Instalar cuSPARSELt para corrigir um problema de dependência com torch 2.5.0

wget https://developer.download.nvidia.com/compute/cuda/repos/ubuntu2204/arm64/cuda-keyring_1.1-1_all.deb

sudo dpkg -i cuda-keyring_1.1-1_all.deb

sudo apt-get update

sudo apt-get -y install libcusparselt0 libcusparselt-dev

Instalar onnxruntime-gpu

O onnxruntime-gpu pacote hospedado no PyPI não tem aarch64 binários para o Jetson. Portanto, precisamos instalar este pacote manualmente. Este pacote é necessário para algumas das exportações.

Você pode encontrar todos os onnxruntime-gpu pacotes — organizados por versão do JetPack, versão do Python e outros detalhes de compatibilidade — no Matriz de compatibilidade do Jetson Zoo ONNX Runtime.

Para JetPack 6 com Python 3.10 suporte, você pode instalar onnxruntime-gpu 1.23.0:

pip install https://github.com/ultralytics/assets/releases/download/v0.0.0/onnxruntime_gpu-1.23.0-cp310-cp310-linux_aarch64.whl

Alternativamente, para onnxruntime-gpu 1.20.0:

pip install https://github.com/ultralytics/assets/releases/download/v0.0.0/onnxruntime_gpu-1.20.0-cp310-cp310-linux_aarch64.whl

Executar no JetPack 5.1.2

Instalar Pacote Ultralytics

Aqui, instalaremos o pacote Ultralytics no Jetson com dependências opcionais para que possamos exportar os modelos PyTorch para outros formatos diferentes. Focaremos principalmente nas exportações NVIDIA TensorRT, porque o TensorRT garantirá que possamos obter o máximo desempenho dos dispositivos Jetson.

Atualize a lista de pacotes, instale o pip e atualize para a versão mais recente

sudo apt update sudo apt install python3-pip -y pip install -U pipInstalar

ultralyticspacote pip com dependências opcionaispip install ultralytics[export]Reinicie o dispositivo

sudo reboot

Instalar PyTorch e Torchvision

A instalação ultralytics acima irá instalar o Torch e o Torchvision. No entanto, esses dois pacotes instalados via pip não são compatíveis com a plataforma Jetson, que é baseada na arquitetura ARM64. Portanto, precisamos instalar manualmente um wheel pip PyTorch pré-compilado e compilar ou instalar o Torchvision a partir do código fonte.

Desinstale o PyTorch e o Torchvision atualmente instalados.

pip uninstall torch torchvisionInstalar

torch 2.2.0etorchvision 0.17.2de acordo com JP5.1.2pip install https://github.com/ultralytics/assets/releases/download/v0.0.0/torch-2.2.0-cp38-cp38-linux_aarch64.whl pip install https://github.com/ultralytics/assets/releases/download/v0.0.0/torchvision-0.17.2+c1d70fe-cp38-cp38-linux_aarch64.whl

Nota

Visite a página do PyTorch para Jetson para acessar todas as diferentes versões do PyTorch para diferentes versões do JetPack. Para uma lista mais detalhada sobre a compatibilidade do PyTorch e Torchvision, visite a página de compatibilidade do PyTorch e Torchvision.

Instalar onnxruntime-gpu

O onnxruntime-gpu pacote hospedado no PyPI não tem aarch64 binários para o Jetson. Portanto, precisamos instalar este pacote manualmente. Este pacote é necessário para algumas das exportações.

Você pode encontrar todos os onnxruntime-gpu pacotes — organizados por versão do JetPack, versão do Python e outros detalhes de compatibilidade — no Matriz de compatibilidade do Jetson Zoo ONNX Runtime. Aqui vamos baixar e instalar onnxruntime-gpu 1.17.0 com Python3.8 suporte.

wget https://nvidia.box.com/shared/static/zostg6agm00fb6t5uisw51qi6kpcuwzd.whl -O onnxruntime_gpu-1.17.0-cp38-cp38-linux_aarch64.whl

pip install onnxruntime_gpu-1.17.0-cp38-cp38-linux_aarch64.whl

Nota

onnxruntime-gpu reverterá automaticamente a versão do numpy para a mais recente. Portanto, precisamos reinstalar o numpy para 1.23.5 para corrigir um problema executando:

pip install numpy==1.23.5

Usar TensorRT no NVIDIA Jetson

Entre todos os formatos de exportação de modelos suportados pela Ultralytics, o TensorRT oferece o maior desempenho de inferência em dispositivos NVIDIA Jetson, tornando-o a nossa principal recomendação para implementações Jetson. Para obter instruções de configuração e utilização avançada, consulte o nosso guia de integração TensorRT dedicado.

Converter Modelo para TensorRT e Executar Inferência

O modelo YOLO26n no formato PyTorch é convertido para TensorRT para executar inferência com o modelo exportado.

Exemplo

from ultralytics import YOLO

# Load a YOLO26n PyTorch model

model = YOLO("yolo26n.pt")

# Export the model to TensorRT

model.export(format="engine") # creates 'yolo26n.engine'

# Load the exported TensorRT model

trt_model = YOLO("yolo26n.engine")

# Run inference

results = trt_model("https://ultralytics.com/images/bus.jpg")

# Export a YOLO26n PyTorch model to TensorRT format

yolo export model=yolo26n.pt format=engine # creates 'yolo26n.engine'

# Run inference with the exported model

yolo predict model=yolo26n.engine source='https://ultralytics.com/images/bus.jpg'

Nota

Visite a página de Exportação para acessar argumentos adicionais ao exportar modelos para diferentes formatos de modelo.

Use o Acelerador de Aprendizado Profundo (DLA) da NVIDIA

O NVIDIA Deep Learning Accelerator (DLA) é um componente de hardware especializado integrado aos dispositivos NVIDIA Jetson que otimiza a inferência de deep learning para eficiência energética e desempenho. Ao descarregar tarefas da GPU (liberando-a para processos mais intensivos), o DLA permite que os modelos sejam executados com menor consumo de energia, mantendo o alto rendimento, ideal para sistemas embarcados e aplicações de IA em tempo real.

Os seguintes dispositivos Jetson estão equipados com hardware DLA:

| Dispositivo Jetson | Núcleos DLA | Frequência Máxima DLA |

|---|---|---|

| Série Jetson AGX Orin | 2 | 1.6 GHz |

| Jetson Orin NX 16GB | 2 | 614 MHz |

| Jetson Orin NX 8GB | 1 | 614 MHz |

| Série Jetson AGX Xavier | 2 | 1.4 GHz |

| Série Jetson Xavier NX | 2 | 1.1 GHz |

Exemplo

from ultralytics import YOLO

# Load a YOLO26n PyTorch model

model = YOLO("yolo26n.pt")

# Export the model to TensorRT with DLA enabled (only works with FP16 or INT8)

model.export(format="engine", device="dla:0", half=True) # dla:0 or dla:1 corresponds to the DLA cores

# Load the exported TensorRT model

trt_model = YOLO("yolo26n.engine")

# Run inference

results = trt_model("https://ultralytics.com/images/bus.jpg")

# Export a YOLO26n PyTorch model to TensorRT format with DLA enabled (only works with FP16 or INT8)

# Once DLA core number is specified at export, it will use the same core at inference

yolo export model=yolo26n.pt format=engine device="dla:0" half=True # dla:0 or dla:1 corresponds to the DLA cores

# Run inference with the exported model on the DLA

yolo predict model=yolo26n.engine source='https://ultralytics.com/images/bus.jpg'

Nota

Ao usar exportações DLA, algumas camadas podem não ser suportadas para serem executadas no DLA e recorrerão à GPU para execução. Esse fallback pode introduzir latência adicional e impactar o desempenho geral da inferência. Portanto, o DLA não foi projetado principalmente para reduzir a latência de inferência em comparação com o TensorRT sendo executado inteiramente na GPU. Em vez disso, seu objetivo principal é aumentar a taxa de transferência e melhorar a eficiência energética.

NVIDIA Jetson YOLO11/ YOLO26 Benchmarks

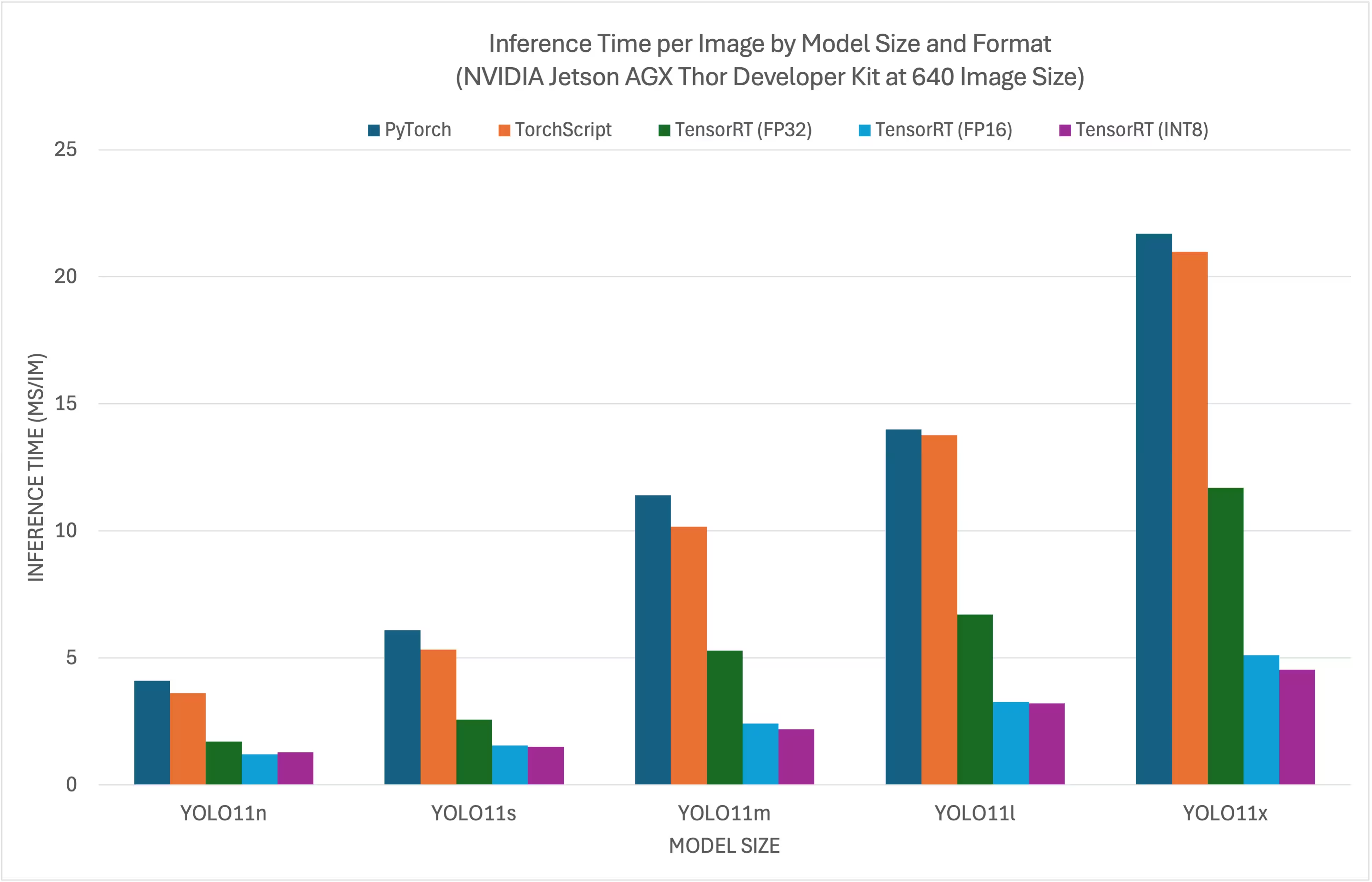

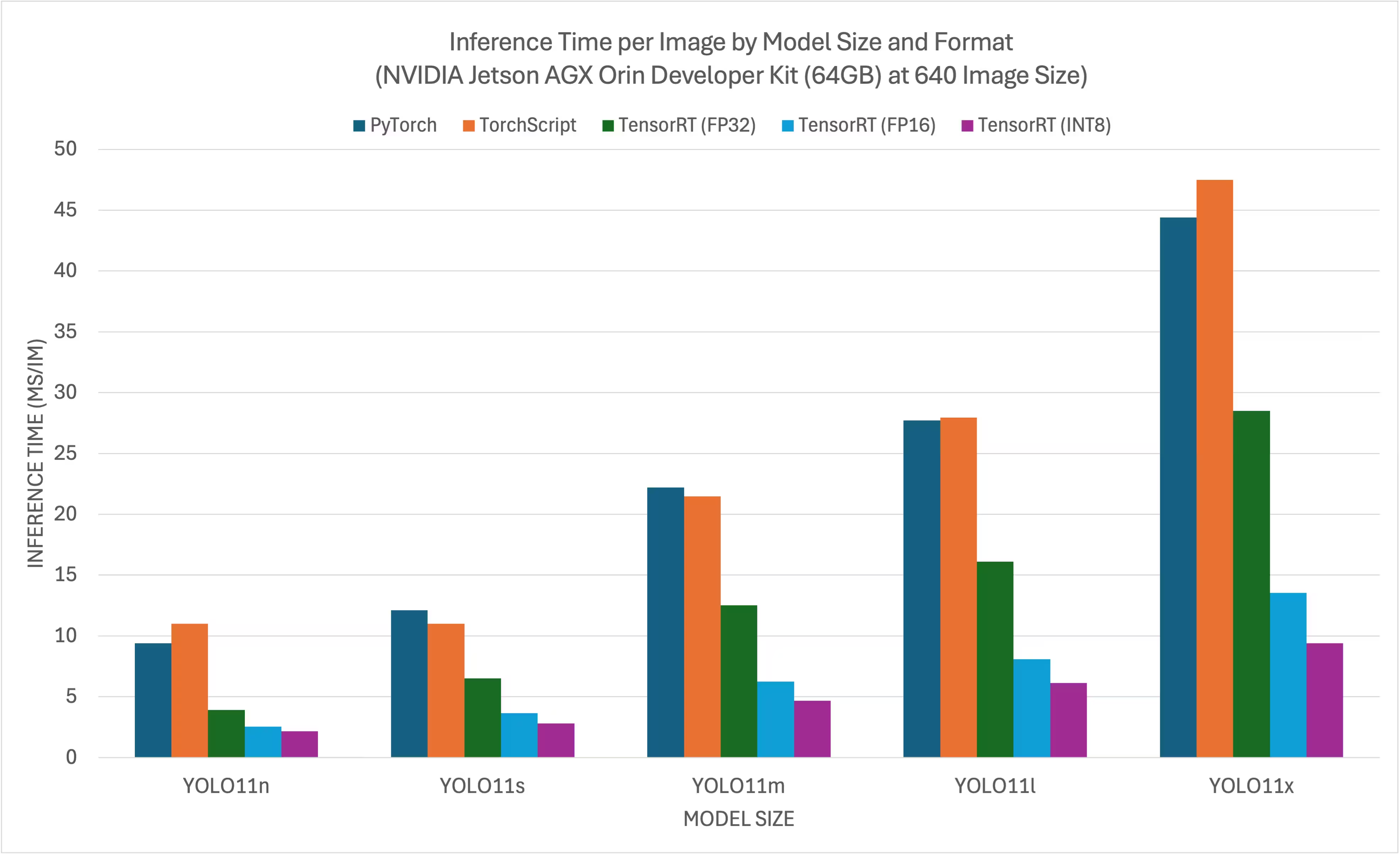

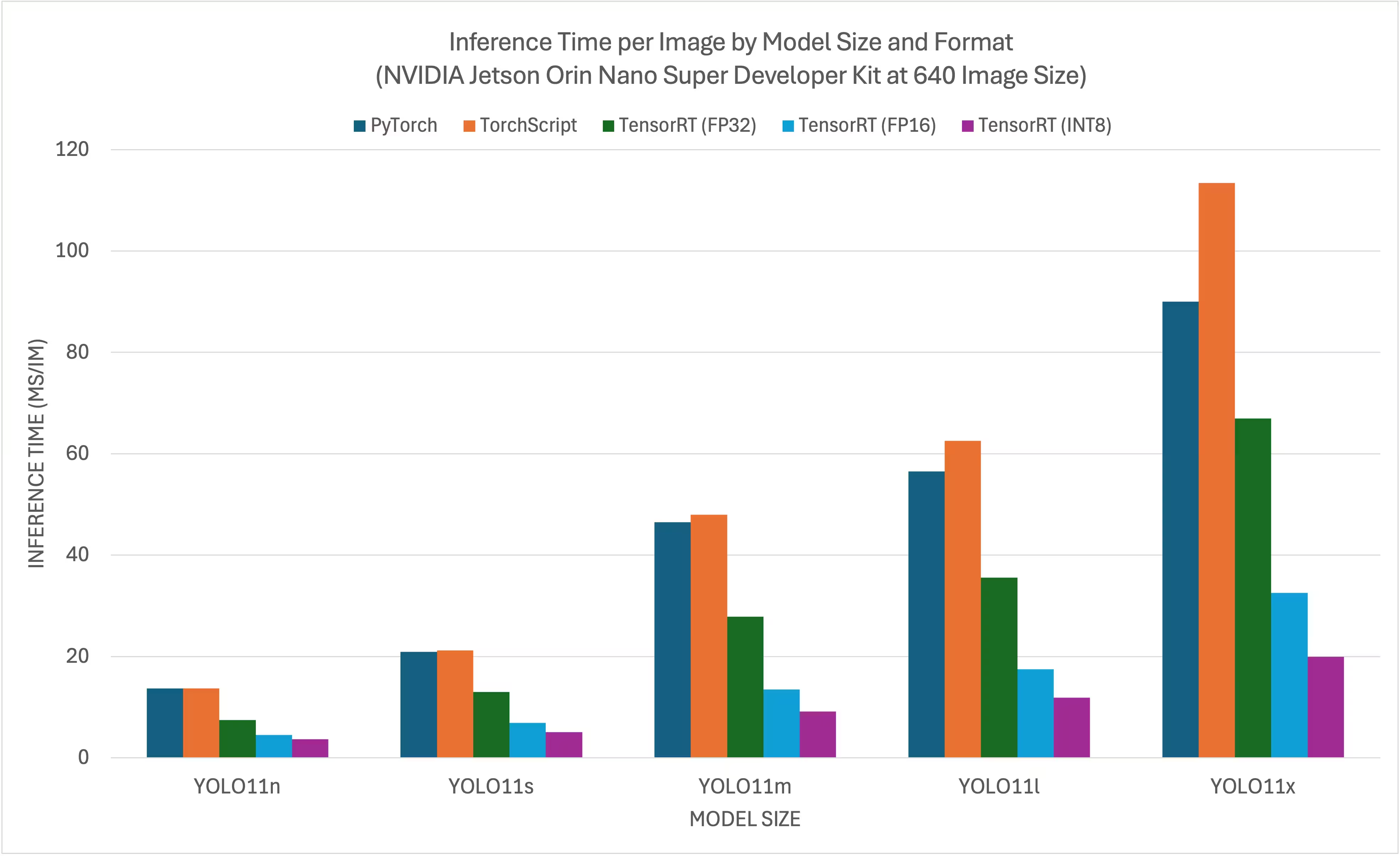

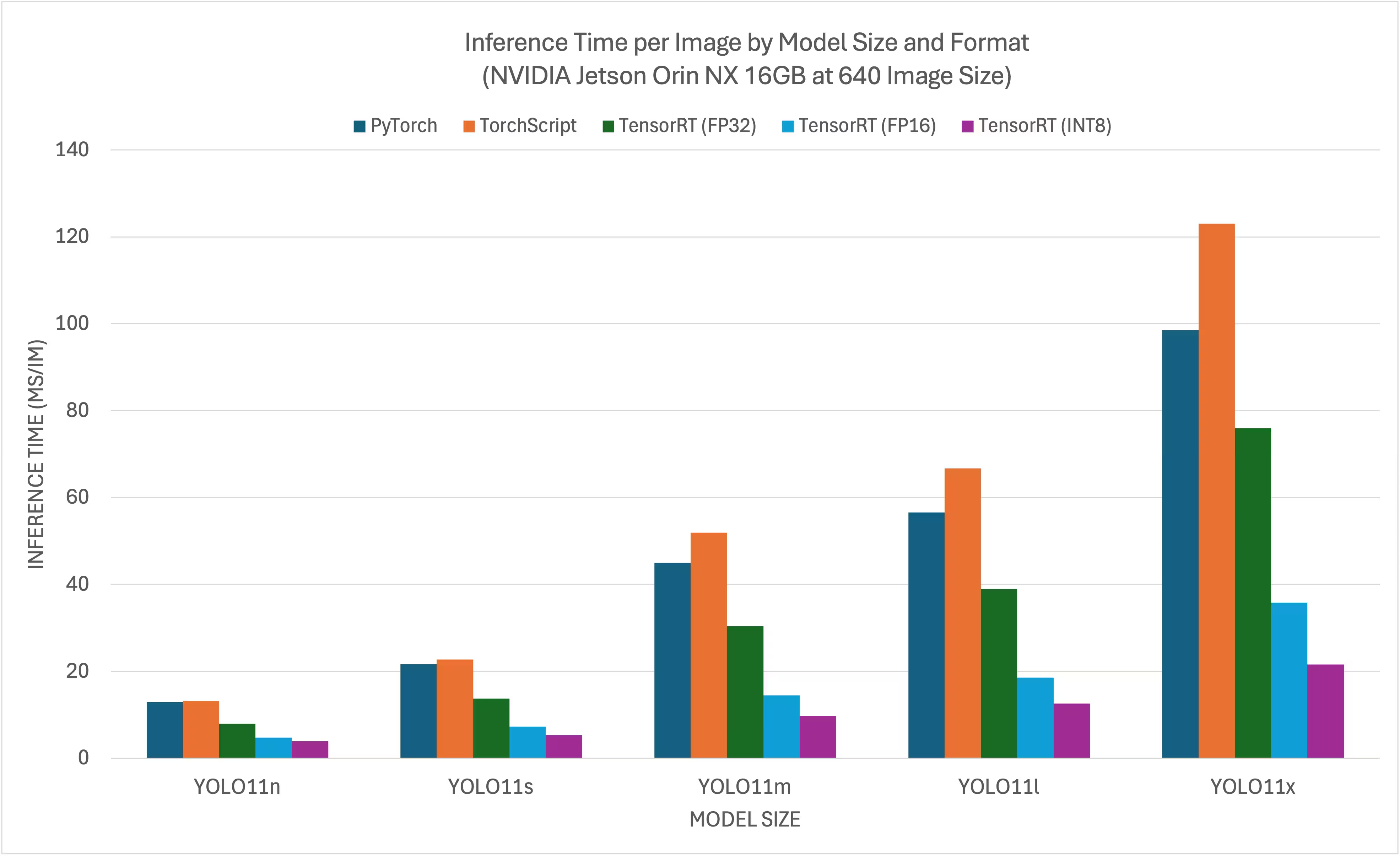

YOLO11/ YOLO26 benchmarks were run by the Ultralytics team on 11 different model formats measuring speed and accuracy: PyTorch, TorchScript, ONNX, OpenVINO, TensorRT, TF SavedModel, TF GraphDef, TF Lite, MNN, NCNN, ExecuTorch. Benchmarks were run on NVIDIA Jetson AGX Thor Developer Kit, NVIDIA Jetson AGX Orin Developer Kit (64GB), NVIDIA Jetson Orin Nano Super Developer Kit and Seeed Studio reComputer J4012 powered by Jetson Orin NX 16GB device at FP32 precision with default input image size of 640.

Gráficos de Comparação

Embora todas as exportações de modelo funcionem no NVIDIA Jetson, incluímos apenas PyTorch, TorchScript, TensorRT para o gráfico de comparação abaixo porque eles utilizam a GPU no Jetson e garantem os melhores resultados. Todas as outras exportações utilizam apenas a CPU e o desempenho não é tão bom quanto o dos três acima. Você pode encontrar benchmarks para todas as exportações na seção após este gráfico.

NVIDIA Jetson AGX Thor Developer Kit

NVIDIA Jetson AGX Orin Developer Kit (64GB)

Kit de Superdesenvolvedor NVIDIA Jetson Orin Nano

NVIDIA Jetson Orin NX 16GB

Tabelas de Comparação Detalhadas

A tabela abaixo representa os resultados de benchmark para cinco modelos diferentes (YOLO11n, YOLO11s, YOLO11m, YOLO11l, YOLO11x) em 11 formatos diferentes (PyTorch, TorchScript, ONNX, OpenVINO, TensorRT, TF SavedModel, TF GraphDef, TF Lite, MNN, NCNN, ExecuTorch), dando-nos o status, tamanho, métrica mAP50-95(B) e tempo de inferência para cada combinação.

NVIDIA Jetson AGX Thor Developer Kit

Desempenho

| Formato | Status | Tamanho no disco (MB) | mAP50-95(B) | Tempo de inferência (ms/im) |

|---|---|---|---|---|

| PyTorch | ✅ | 5.3 | 0.4798 | 7.39 |

| TorchScript | ✅ | 9.8 | 0.4789 | 4.21 |

| ONNX | ✅ | 9.5 | 0.4767 | 6.58 |

| OpenVINO | ✅ | 10.1 | 0.4794 | 17.50 |

| TensorRT (FP32) | ✅ | 13.9 | 0.4791 | 1.90 |

| TensorRT (FP16) | ✅ | 7.6 | 0.4797 | 1.39 |

| TensorRT (INT8) | ✅ | 6.5 | 0.4273 | 1.52 |

| TF SavedModel | ✅ | 25.7 | 0.4764 | 47.24 |

| TF GraphDef | ✅ | 9.5 | 0.4764 | 45.98 |

| TF Lite | ✅ | 9.9 | 0.4764 | 182.04 |

| MNN | ✅ | 9.4 | 0.4784 | 21.83 |

| Formato | Status | Tamanho no disco (MB) | mAP50-95(B) | Tempo de inferência (ms/im) |

|---|---|---|---|---|

| PyTorch | ✅ | 19.5 | 0.5738 | 7.99 |

| TorchScript | ✅ | 36.8 | 0.5664 | 6.01 |

| ONNX | ✅ | 36.5 | 0.5666 | 9.31 |

| OpenVINO | ✅ | 38.5 | 0.5656 | 35.56 |

| TensorRT (FP32) | ✅ | 38.9 | 0.5664 | 2.95 |

| TensorRT (FP16) | ✅ | 21.0 | 0.5650 | 1.77 |

| TensorRT (INT8) | ✅ | 13.5 | 0.5010 | 1.75 |

| TF SavedModel | ✅ | 96.6 | 0.5665 | 88.87 |

| TF GraphDef | ✅ | 36.5 | 0.5665 | 89.20 |

| TF Lite | ✅ | 36.9 | 0.5665 | 604.25 |

| MNN | ✅ | 36.4 | 0.5651 | 53.75 |

| Formato | Status | Tamanho no disco (MB) | mAP50-95(B) | Tempo de inferência (ms/im) |

|---|---|---|---|---|

| PyTorch | ✅ | 42.2 | 0.6237 | 10.76 |

| TorchScript | ✅ | 78.5 | 0.6217 | 10.57 |

| ONNX | ✅ | 78.2 | 0.6211 | 14.91 |

| OpenVINO | ✅ | 82.2 | 0.6204 | 86.27 |

| TensorRT (FP32) | ✅ | 82.2 | 0.6230 | 5.56 |

| TensorRT (FP16) | ✅ | 41.6 | 0.6209 | 2.58 |

| TensorRT (INT8) | ✅ | 24.3 | 0.5595 | 2.49 |

| TF SavedModel | ✅ | 205.8 | 0.6229 | 200.96 |

| TF GraphDef | ✅ | 78.2 | 0.6229 | 203.00 |

| TF Lite | ✅ | 78.6 | 0.6229 | 1867.12 |

| MNN | ✅ | 78.0 | 0.6176 | 142.00 |

| Formato | Status | Tamanho no disco (MB) | mAP50-95(B) | Tempo de inferência (ms/im) |

|---|---|---|---|---|

| PyTorch | ✅ | 50.7 | 0.6258 | 13.34 |

| TorchScript | ✅ | 95.5 | 0.6248 | 13.86 |

| ONNX | ✅ | 95.0 | 0.6247 | 18.44 |

| OpenVINO | ✅ | 99.9 | 0.6238 | 106.67 |

| TensorRT (FP32) | ✅ | 99.0 | 0.6249 | 6.74 |

| TensorRT (FP16) | ✅ | 50.3 | 0.6243 | 3.34 |

| TensorRT (INT8) | ✅ | 29.0 | 0.5708 | 3.24 |

| TF SavedModel | ✅ | 250.0 | 0.6245 | 259.74 |

| TF GraphDef | ✅ | 95.0 | 0.6245 | 263.42 |

| TF Lite | ✅ | 95.4 | 0.6245 | 2367.83 |

| MNN | ✅ | 94.8 | 0.6272 | 174.39 |

| Formato | Status | Tamanho no disco (MB) | mAP50-95(B) | Tempo de inferência (ms/im) |

|---|---|---|---|---|

| PyTorch | ✅ | 113.2 | 0.6565 | 20.92 |

| TorchScript | ✅ | 213.5 | 0.6595 | 21.76 |

| ONNX | ✅ | 212.9 | 0.6590 | 26.72 |

| OpenVINO | ✅ | 223.6 | 0.6620 | 205.27 |

| TensorRT (FP32) | ✅ | 217.2 | 0.6593 | 12.29 |

| TensorRT (FP16) | ✅ | 112.1 | 0.6611 | 5.16 |

| TensorRT (INT8) | ✅ | 58.9 | 0.5222 | 4.72 |

| TF SavedModel | ✅ | 559.2 | 0.6593 | 498.85 |

| TF GraphDef | ✅ | 213.0 | 0.6593 | 507.43 |

| TF Lite | ✅ | 213.3 | 0.6593 | 5134.22 |

| MNN | ✅ | 212.8 | 0.6625 | 347.84 |

Benchmarked with Ultralytics 8.4.7

Nota

O tempo de inferência não inclui o pré/pós-processamento.

NVIDIA Jetson AGX Orin Developer Kit (64GB)

Desempenho

| Formato | Status | Tamanho no disco (MB) | mAP50-95(B) | Tempo de inferência (ms/im) |

|---|---|---|---|---|

| PyTorch | ✅ | 5.4 | 0.5101 | 9.40 |

| TorchScript | ✅ | 10.5 | 0.5083 | 11.00 |

| ONNX | ✅ | 10.2 | 0.5077 | 48.32 |

| OpenVINO | ✅ | 10.4 | 0.5058 | 27.24 |

| TensorRT (FP32) | ✅ | 12.1 | 0.5085 | 3.93 |

| TensorRT (FP16) | ✅ | 8.3 | 0.5063 | 2.55 |

| TensorRT (INT8) | ✅ | 5.4 | 0.4719 | 2.18 |

| TF SavedModel | ✅ | 25.9 | 0.5077 | 66.87 |

| TF GraphDef | ✅ | 10.3 | 0.5077 | 65.68 |

| TF Lite | ✅ | 10.3 | 0.5077 | 272.92 |

| MNN | ✅ | 10.1 | 0.5059 | 36.33 |

| NCNN | ✅ | 10.2 | 0.5031 | 28.51 |

| Formato | Status | Tamanho no disco (MB) | mAP50-95(B) | Tempo de inferência (ms/im) |

|---|---|---|---|---|

| PyTorch | ✅ | 18.4 | 0.5783 | 12.10 |

| TorchScript | ✅ | 36.5 | 0.5782 | 11.01 |

| ONNX | ✅ | 36.3 | 0.5782 | 107.54 |

| OpenVINO | ✅ | 36.4 | 0.5810 | 55.03 |

| TensorRT (FP32) | ✅ | 38.1 | 0.5781 | 6.52 |

| TensorRT (FP16) | ✅ | 21.4 | 0.5803 | 3.65 |

| TensorRT (INT8) | ✅ | 12.1 | 0.5735 | 2.81 |

| TF SavedModel | ✅ | 91.0 | 0.5782 | 132.73 |

| TF GraphDef | ✅ | 36.4 | 0.5782 | 134.96 |

| TF Lite | ✅ | 36.3 | 0.5782 | 798.21 |

| MNN | ✅ | 36.2 | 0.5777 | 82.35 |

| NCNN | ✅ | 36.2 | 0.5784 | 56.07 |

| Formato | Status | Tamanho no disco (MB) | mAP50-95(B) | Tempo de inferência (ms/im) |

|---|---|---|---|---|

| PyTorch | ✅ | 38.8 | 0.6265 | 22.20 |

| TorchScript | ✅ | 77.3 | 0.6307 | 21.47 |

| ONNX | ✅ | 76.9 | 0.6307 | 270.89 |

| OpenVINO | ✅ | 77.1 | 0.6284 | 129.10 |

| TensorRT (FP32) | ✅ | 78.8 | 0.6306 | 12.53 |

| TensorRT (FP16) | ✅ | 41.9 | 0.6305 | 6.25 |

| TensorRT (INT8) | ✅ | 23.2 | 0.6291 | 4.69 |

| TF SavedModel | ✅ | 192.7 | 0.6307 | 299.95 |

| TF GraphDef | ✅ | 77.1 | 0.6307 | 310.58 |

| TF Lite | ✅ | 77.0 | 0.6307 | 2400.54 |

| MNN | ✅ | 76.8 | 0.6308 | 213.56 |

| NCNN | ✅ | 76.8 | 0.6284 | 141.18 |

| Formato | Status | Tamanho no disco (MB) | mAP50-95(B) | Tempo de inferência (ms/im) |

|---|---|---|---|---|

| PyTorch | ✅ | 49.0 | 0.6364 | 27.70 |

| TorchScript | ✅ | 97.6 | 0.6399 | 27.94 |

| ONNX | ✅ | 97.0 | 0.6409 | 345.47 |

| OpenVINO | ✅ | 97.3 | 0.6378 | 161.93 |

| TensorRT (FP32) | ✅ | 99.1 | 0.6406 | 16.11 |

| TensorRT (FP16) | ✅ | 52.6 | 0.6376 | 8.08 |

| TensorRT (INT8) | ✅ | 30.8 | 0.6208 | 6.12 |

| TF SavedModel | ✅ | 243.1 | 0.6409 | 390.78 |

| TF GraphDef | ✅ | 97.2 | 0.6409 | 398.76 |

| TF Lite | ✅ | 97.1 | 0.6409 | 3037.05 |

| MNN | ✅ | 96.9 | 0.6372 | 265.46 |

| NCNN | ✅ | 96.9 | 0.6364 | 179.68 |

| Formato | Status | Tamanho no disco (MB) | mAP50-95(B) | Tempo de inferência (ms/im) |

|---|---|---|---|---|

| PyTorch | ✅ | 109.3 | 0.7005 | 44.40 |

| TorchScript | ✅ | 218.1 | 0.6898 | 47.49 |

| ONNX | ✅ | 217.5 | 0.6900 | 682.98 |

| OpenVINO | ✅ | 217.8 | 0.6876 | 298.15 |

| TensorRT (FP32) | ✅ | 219.6 | 0.6904 | 28.50 |

| TensorRT (FP16) | ✅ | 112.2 | 0.6887 | 13.55 |

| TensorRT (INT8) | ✅ | 60.0 | 0.6574 | 9.40 |

| TF SavedModel | ✅ | 544.3 | 0.6900 | 749.85 |

| TF GraphDef | ✅ | 217.7 | 0.6900 | 753.86 |

| TF Lite | ✅ | 217.6 | 0.6900 | 6603.27 |

| MNN | ✅ | 217.3 | 0.6868 | 519.77 |

| NCNN | ✅ | 217.3 | 0.6849 | 298.58 |

Testado com Ultralytics 8.3.157

Nota

O tempo de inferência não inclui o pré/pós-processamento.

Kit de Superdesenvolvedor NVIDIA Jetson Orin Nano

Desempenho

| Formato | Status | Tamanho no disco (MB) | mAP50-95(B) | Tempo de inferência (ms/im) |

|---|---|---|---|---|

| PyTorch | ✅ | 5.4 | 0.5101 | 13.70 |

| TorchScript | ✅ | 10.5 | 0.5082 | 13.69 |

| ONNX | ✅ | 10.2 | 0.5081 | 14.47 |

| OpenVINO | ✅ | 10.4 | 0.5058 | 56.66 |

| TensorRT (FP32) | ✅ | 12.0 | 0.5081 | 7.44 |

| TensorRT (FP16) | ✅ | 8.2 | 0.5061 | 4.53 |

| TensorRT (INT8) | ✅ | 5.4 | 0.4825 | 3.70 |

| TF SavedModel | ✅ | 25.9 | 0.5077 | 116.23 |

| TF GraphDef | ✅ | 10.3 | 0.5077 | 114.92 |

| TF Lite | ✅ | 10.3 | 0.5077 | 340.75 |

| MNN | ✅ | 10.1 | 0.5059 | 76.26 |

| NCNN | ✅ | 10.2 | 0.5031 | 45.03 |

| Formato | Status | Tamanho no disco (MB) | mAP50-95(B) | Tempo de inferência (ms/im) |

|---|---|---|---|---|

| PyTorch | ✅ | 18.4 | 0.5790 | 20.90 |

| TorchScript | ✅ | 36.5 | 0.5781 | 21.22 |

| ONNX | ✅ | 36.3 | 0.5781 | 25.07 |

| OpenVINO | ✅ | 36.4 | 0.5810 | 122.98 |

| TensorRT (FP32) | ✅ | 37.9 | 0.5783 | 13.02 |

| TensorRT (FP16) | ✅ | 21.8 | 0.5779 | 6.93 |

| TensorRT (INT8) | ✅ | 12.2 | 0.5735 | 5.08 |

| TF SavedModel | ✅ | 91.0 | 0.5782 | 250.65 |

| TF GraphDef | ✅ | 36.4 | 0.5782 | 252.69 |

| TF Lite | ✅ | 36.3 | 0.5782 | 998.68 |

| MNN | ✅ | 36.2 | 0.5781 | 188.01 |

| NCNN | ✅ | 36.2 | 0.5784 | 101.37 |

| Formato | Status | Tamanho no disco (MB) | mAP50-95(B) | Tempo de inferência (ms/im) |

|---|---|---|---|---|

| PyTorch | ✅ | 38.8 | 0.6266 | 46.50 |

| TorchScript | ✅ | 77.3 | 0.6307 | 47.95 |

| ONNX | ✅ | 76.9 | 0.6307 | 53.06 |

| OpenVINO | ✅ | 77.1 | 0.6284 | 301.63 |

| TensorRT (FP32) | ✅ | 78.8 | 0.6305 | 27.86 |

| TensorRT (FP16) | ✅ | 41.7 | 0.6309 | 13.50 |

| TensorRT (INT8) | ✅ | 23.2 | 0.6291 | 9.12 |

| TF SavedModel | ✅ | 192.7 | 0.6307 | 622.24 |

| TF GraphDef | ✅ | 77.1 | 0.6307 | 628.74 |

| TF Lite | ✅ | 77.0 | 0.6307 | 2997.93 |

| MNN | ✅ | 76.8 | 0.6299 | 509.96 |

| NCNN | ✅ | 76.8 | 0.6284 | 292.99 |

| Formato | Status | Tamanho no disco (MB) | mAP50-95(B) | Tempo de inferência (ms/im) |

|---|---|---|---|---|

| PyTorch | ✅ | 49.0 | 0.6364 | 56.50 |

| TorchScript | ✅ | 97.6 | 0.6409 | 62.51 |

| ONNX | ✅ | 97.0 | 0.6399 | 68.35 |

| OpenVINO | ✅ | 97.3 | 0.6378 | 376.03 |

| TensorRT (FP32) | ✅ | 99.2 | 0.6396 | 35.59 |

| TensorRT (FP16) | ✅ | 52.1 | 0.6361 | 17.48 |

| TensorRT (INT8) | ✅ | 30.9 | 0.6207 | 11.87 |

| TF SavedModel | ✅ | 243.1 | 0.6409 | 807.47 |

| TF GraphDef | ✅ | 97.2 | 0.6409 | 822.88 |

| TF Lite | ✅ | 97.1 | 0.6409 | 3792.23 |

| MNN | ✅ | 96.9 | 0.6372 | 631.16 |

| NCNN | ✅ | 96.9 | 0.6364 | 350.46 |

| Formato | Status | Tamanho no disco (MB) | mAP50-95(B) | Tempo de inferência (ms/im) |

|---|---|---|---|---|

| PyTorch | ✅ | 109.3 | 0.7005 | 90.00 |

| TorchScript | ✅ | 218.1 | 0.6901 | 113.40 |

| ONNX | ✅ | 217.5 | 0.6901 | 122.94 |

| OpenVINO | ✅ | 217.8 | 0.6876 | 713.1 |

| TensorRT (FP32) | ✅ | 219.5 | 0.6904 | 66.93 |

| TensorRT (FP16) | ✅ | 112.2 | 0.6892 | 32.58 |

| TensorRT (INT8) | ✅ | 61.5 | 0.6612 | 19.90 |

| TF SavedModel | ✅ | 544.3 | 0.6900 | 1605.4 |

| TF GraphDef | ✅ | 217.8 | 0.6900 | 2961.8 |

| TF Lite | ✅ | 217.6 | 0.6900 | 8234.86 |

| MNN | ✅ | 217.3 | 0.6893 | 1254.18 |

| NCNN | ✅ | 217.3 | 0.6849 | 725.50 |

Testado com Ultralytics 8.3.157

Nota

O tempo de inferência não inclui o pré/pós-processamento.

NVIDIA Jetson Orin NX 16GB

Desempenho

| Formato | Status | Tamanho no disco (MB) | mAP50-95(B) | Tempo de inferência (ms/im) |

|---|---|---|---|---|

| PyTorch | ✅ | 5.4 | 0.5101 | 12.90 |

| TorchScript | ✅ | 10.5 | 0.5082 | 13.17 |

| ONNX | ✅ | 10.2 | 0.5081 | 15.43 |

| OpenVINO | ✅ | 10.4 | 0.5058 | 39.80 |

| TensorRT (FP32) | ✅ | 11.8 | 0.5081 | 7.94 |

| TensorRT (FP16) | ✅ | 8.1 | 0.5085 | 4.73 |

| TensorRT (INT8) | ✅ | 5.4 | 0.4786 | 3.90 |

| TF SavedModel | ✅ | 25.9 | 0.5077 | 88.48 |

| TF GraphDef | ✅ | 10.3 | 0.5077 | 86.67 |

| TF Lite | ✅ | 10.3 | 0.5077 | 302.55 |

| MNN | ✅ | 10.1 | 0.5059 | 52.73 |

| NCNN | ✅ | 10.2 | 0.5031 | 32.04 |

| Formato | Status | Tamanho no disco (MB) | mAP50-95(B) | Tempo de inferência (ms/im) |

|---|---|---|---|---|

| PyTorch | ✅ | 18.4 | 0.5790 | 21.70 |

| TorchScript | ✅ | 36.5 | 0.5781 | 22.71 |

| ONNX | ✅ | 36.3 | 0.5781 | 26.49 |

| OpenVINO | ✅ | 36.4 | 0.5810 | 84.73 |

| TensorRT (FP32) | ✅ | 37.8 | 0.5783 | 13.77 |

| TensorRT (FP16) | ✅ | 21.2 | 0.5796 | 7.31 |

| TensorRT (INT8) | ✅ | 12.0 | 0.5735 | 5.33 |

| TF SavedModel | ✅ | 91.0 | 0.5782 | 185.06 |

| TF GraphDef | ✅ | 36.4 | 0.5782 | 186.45 |

| TF Lite | ✅ | 36.3 | 0.5782 | 882.58 |

| MNN | ✅ | 36.2 | 0.5775 | 126.36 |

| NCNN | ✅ | 36.2 | 0.5784 | 66.73 |

| Formato | Status | Tamanho no disco (MB) | mAP50-95(B) | Tempo de inferência (ms/im) |

|---|---|---|---|---|

| PyTorch | ✅ | 38.8 | 0.6266 | 45.00 |

| TorchScript | ✅ | 77.3 | 0.6307 | 51.87 |

| ONNX | ✅ | 76.9 | 0.6307 | 56.00 |

| OpenVINO | ✅ | 77.1 | 0.6284 | 202.69 |

| TensorRT (FP32) | ✅ | 78.7 | 0.6305 | 30.38 |

| TensorRT (FP16) | ✅ | 41.8 | 0.6302 | 14.48 |

| TensorRT (INT8) | ✅ | 23.2 | 0.6291 | 9.74 |

| TF SavedModel | ✅ | 192.7 | 0.6307 | 445.58 |

| TF GraphDef | ✅ | 77.1 | 0.6307 | 460.94 |

| TF Lite | ✅ | 77.0 | 0.6307 | 2653.65 |

| MNN | ✅ | 76.8 | 0.6308 | 339.38 |

| NCNN | ✅ | 76.8 | 0.6284 | 187.64 |

| Formato | Status | Tamanho no disco (MB) | mAP50-95(B) | Tempo de inferência (ms/im) |

|---|---|---|---|---|

| PyTorch | ✅ | 49.0 | 0.6364 | 56.60 |

| TorchScript | ✅ | 97.6 | 0.6409 | 66.72 |

| ONNX | ✅ | 97.0 | 0.6399 | 71.92 |

| OpenVINO | ✅ | 97.3 | 0.6378 | 254.17 |

| TensorRT (FP32) | ✅ | 99.2 | 0.6406 | 38.89 |

| TensorRT (FP16) | ✅ | 51.9 | 0.6363 | 18.59 |

| TensorRT (INT8) | ✅ | 30.9 | 0.6207 | 12.60 |

| TF SavedModel | ✅ | 243.1 | 0.6409 | 575.98 |

| TF GraphDef | ✅ | 97.2 | 0.6409 | 583.79 |

| TF Lite | ✅ | 97.1 | 0.6409 | 3353.41 |

| MNN | ✅ | 96.9 | 0.6367 | 421.33 |

| NCNN | ✅ | 96.9 | 0.6364 | 228.26 |

| Formato | Status | Tamanho no disco (MB) | mAP50-95(B) | Tempo de inferência (ms/im) |

|---|---|---|---|---|

| PyTorch | ✅ | 109.3 | 0.7005 | 98.50 |

| TorchScript | ✅ | 218.1 | 0.6901 | 123.03 |

| ONNX | ✅ | 217.5 | 0.6901 | 129.55 |

| OpenVINO | ✅ | 217.8 | 0.6876 | 483.44 |

| TensorRT (FP32) | ✅ | 219.6 | 0.6904 | 75.92 |

| TensorRT (FP16) | ✅ | 112.1 | 0.6885 | 35.78 |

| TensorRT (INT8) | ✅ | 61.6 | 0.6592 | 21.60 |

| TF SavedModel | ✅ | 544.3 | 0.6900 | 1120.43 |

| TF GraphDef | ✅ | 217.7 | 0.6900 | 1172.35 |

| TF Lite | ✅ | 217.6 | 0.6900 | 7283.63 |

| MNN | ✅ | 217.3 | 0.6877 | 840.16 |

| NCNN | ✅ | 217.3 | 0.6849 | 474.41 |

Testado com Ultralytics 8.3.157

Nota

O tempo de inferência não inclui o pré/pós-processamento.

Explore mais esforços de benchmarking da Seeed Studio executados em diferentes versões do hardware NVIDIA Jetson.

Reproduzir Nossos Resultados

Para reproduzir os benchmarks Ultralytics acima em todos os formatos de exportação, execute este código:

Exemplo

from ultralytics import YOLO

# Load a YOLO11n PyTorch model

model = YOLO("yolo11n.pt")

# Benchmark YOLO11n speed and accuracy on the COCO128 dataset for all export formats

results = model.benchmark(data="coco128.yaml", imgsz=640)

# Benchmark YOLO11n speed and accuracy on the COCO128 dataset for all export formats

yolo benchmark model=yolo11n.pt data=coco128.yaml imgsz=640

Note que os resultados de benchmarking podem variar com base na configuração exata de hardware e software de um sistema, bem como na carga de trabalho atual do sistema no momento em que os benchmarks são executados. Para resultados mais confiáveis, utilize um conjunto de dados com um grande número de imagens, por exemplo, data='coco.yaml' (5000 imagens de validação).

Melhores Práticas ao usar NVIDIA Jetson

Ao usar o NVIDIA Jetson, há algumas melhores práticas a seguir a fim de permitir o desempenho máximo no NVIDIA Jetson executando o YOLO26.

Ativar Modo de Potência MÁX.

Ativar o Modo de Potência MÁX. no Jetson garantirá que todos os núcleos da CPU e GPU sejam ativados.

sudo nvpmodel -m 0Ativar Clocks Jetson

Ativar os Clocks Jetson garantirá que todos os núcleos da CPU e GPU sejam sincronizados em sua frequência máxima.

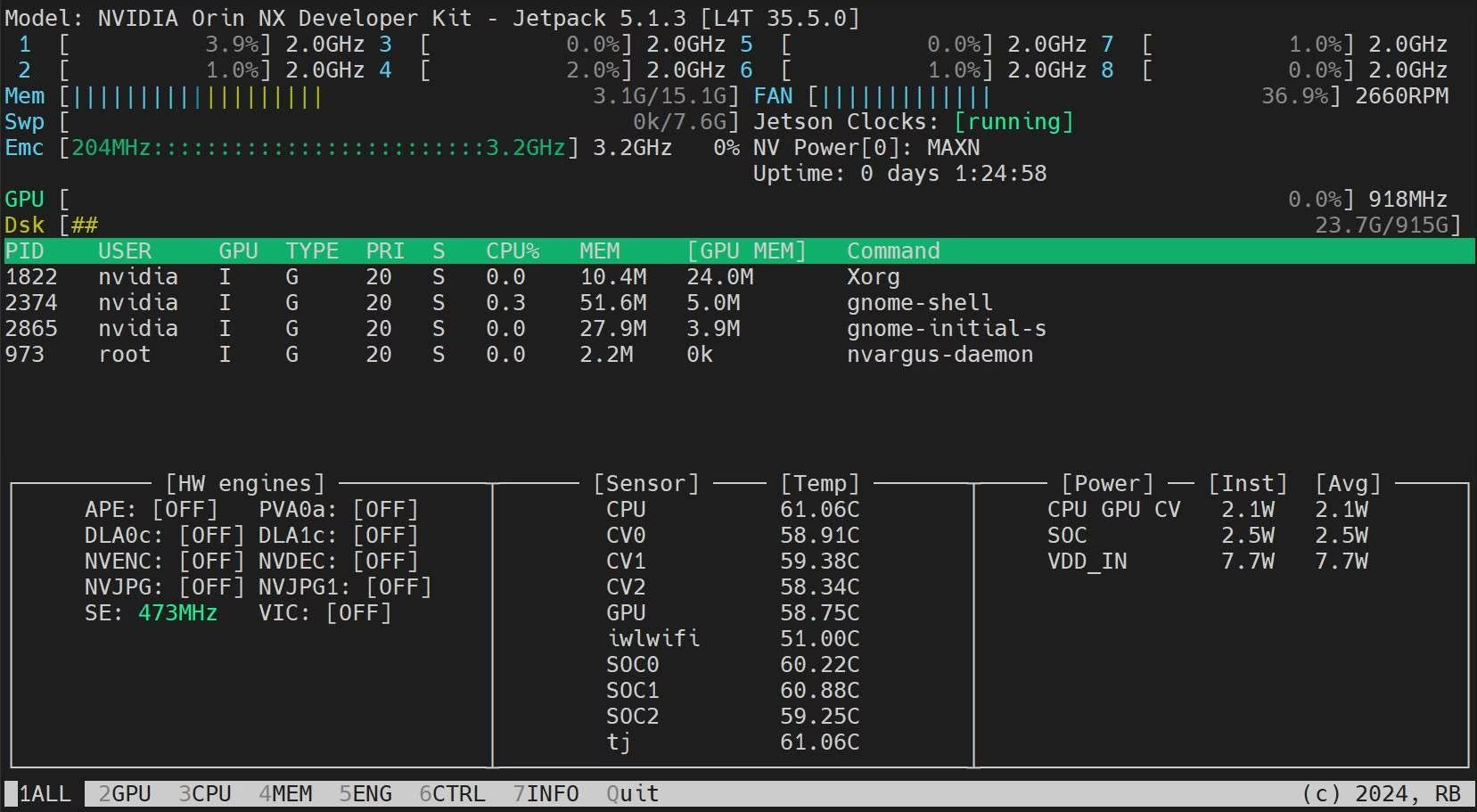

sudo jetson_clocksInstalar o Aplicativo Jetson Stats

Podemos usar o aplicativo jetson stats para monitorar as temperaturas dos componentes do sistema e verificar outros detalhes do sistema, como visualizar a utilização de CPU, GPU, RAM, alterar os modos de energia, definir os clocks máximos, verificar as informações do JetPack

sudo apt update sudo pip install jetson-stats sudo reboot jtop

Próximos Passos

Para mais aprendizado e suporte, consulte a Documentação do Ultralytics YOLO26.

FAQ

Como faço para implantar o Ultralytics YOLO26 em dispositivos NVIDIA Jetson?

A implantação do Ultralytics YOLO26 em dispositivos NVIDIA Jetson é um processo direto. Primeiro, grave o SDK NVIDIA JetPack no seu dispositivo Jetson. Em seguida, use uma imagem Docker pré-construída para uma configuração rápida ou instale manualmente os pacotes necessários. Etapas detalhadas para cada abordagem podem ser encontradas nas seções Início Rápido com Docker e Início com Instalação Nativa.

Quais benchmarks de desempenho posso esperar dos modelos YOLO11 em dispositivos NVIDIA Jetson?

Os modelos YOLO11 foram comparados em vários dispositivos NVIDIA Jetson, mostrando melhorias significativas de desempenho. Por exemplo, o formato TensorRT oferece o melhor desempenho de inferência. A tabela na seção Tabelas de Comparação Detalhadas fornece uma visão abrangente de métricas de desempenho como mAP50-95 e tempo de inferência em diferentes formatos de modelo.

Por que devo usar o TensorRT para implantar o YOLO26 em dispositivos NVIDIA Jetson?

O TensorRT é altamente recomendado para implantar modelos YOLO26 em NVIDIA Jetson devido ao seu desempenho ideal. Ele acelera a inferência aproveitando os recursos da GPU do Jetson, garantindo máxima eficiência e velocidade. Saiba mais sobre como converter para TensorRT e executar a inferência na seção Usar TensorRT em NVIDIA Jetson.

Como posso instalar PyTorch e Torchvision no NVIDIA Jetson?

Para instalar o PyTorch e o Torchvision no NVIDIA Jetson, primeiro desinstale quaisquer versões existentes que possam ter sido instaladas via pip. Em seguida, instale manualmente as versões compatíveis do PyTorch e do Torchvision para a arquitetura ARM64 do Jetson. Instruções detalhadas para este processo são fornecidas na seção Instalar o PyTorch e o Torchvision.

Quais são as melhores práticas para maximizar o desempenho em NVIDIA Jetson ao usar o YOLO26?

Para maximizar o desempenho em NVIDIA Jetson com o YOLO26, siga estas melhores práticas:

- Ative o Modo de Potência MÁX. para utilizar todos os núcleos da CPU e GPU.

- Ative os Clocks Jetson para executar todos os núcleos em sua frequência máxima.

- Instale o aplicativo Jetson Stats para monitorar as métricas do sistema.

Para comandos e detalhes adicionais, consulte a seção Melhores Práticas ao usar NVIDIA Jetson.