Optimierung von YOLO26-Inferenzläufen mit der DeepSparse Engine von Neural Magic

Beim Einsatz von Objekterkennungsmodellen wie Ultralytics YOLO26 auf unterschiedlicher Hardware können einzigartige Herausforderungen wie die Optimierung auftreten. Hier kommt die Integration von YOLO26 mit Neural Magic's DeepSparse Engine ins Spiel. Sie verändert die Ausführung von YOLO26-Modellen und ermöglicht GPU-ähnliche Leistung direkt auf CPUs.

Dieser Leitfaden zeigt Ihnen, wie Sie YOLO26 mit Neural Magic's DeepSparse bereitstellen, wie Sie Inferenzen ausführen und wie Sie die Leistung benchmarken, um sicherzustellen, dass sie optimiert ist.

SparseML EOL

Neural Magic war im Januar 2025 von Red Hat übernommen, und die Community-Versionen ihrer Produkte werden nicht mehr unterstützt deepsparse, sparseml, sparsezoound sparsify Bibliotheken. Weitere Informationen finden Sie im veröffentlichten Hinweis in der Readme auf der sparseml GitHub-Repository.

DeepSparse von Neural Magic

Neural Magic's DeepSparse ist eine Inferenz-Laufzeitumgebung, die entwickelt wurde, um die Ausführung neuronaler Netze auf CPUs zu optimieren. Es wendet fortschrittliche Techniken wie Sparsity, Pruning und Quantisierung an, um den Rechenbedarf drastisch zu reduzieren und gleichzeitig die Genauigkeit zu erhalten. DeepSparse bietet eine agile Lösung für die effiziente und skalierbare Ausführung von neuronalen Netzen auf verschiedenen Geräten.

Vorteile der Integration von Neural Magic DeepSparse mit YOLO26

Bevor wir uns mit der Bereitstellung von YOLO26 mittels DeepSparse befassen, lassen Sie uns die Vorteile der Verwendung von DeepSparse verstehen. Einige wesentliche Vorteile sind:

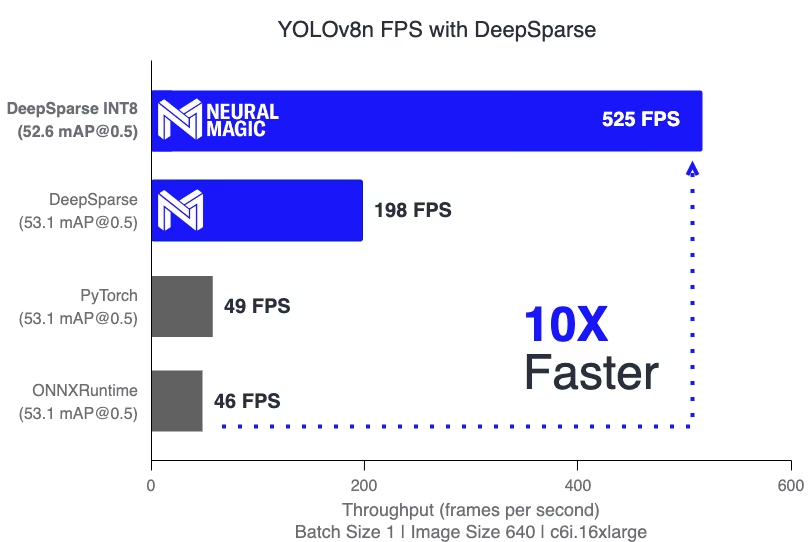

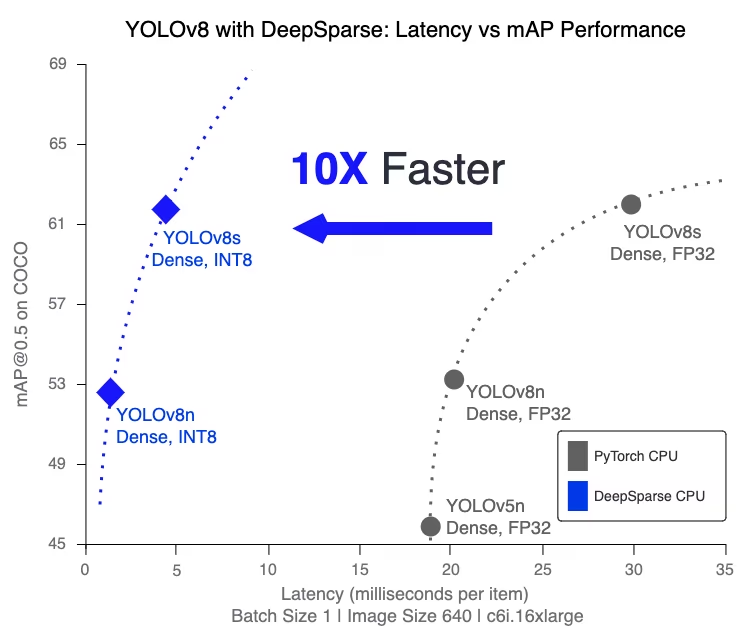

- Verbesserte Inferenzgeschwindigkeit: Erreicht bis zu 525 FPS (auf YOLO11n), was die Inferenzfähigkeiten von YOLO im Vergleich zu herkömmlichen Methoden erheblich beschleunigt.

- Optimierte Modelleffizienz: Nutzt Pruning und Quantisierung, um die Effizienz von YOLO26 zu steigern, wodurch Modellgröße und Rechenanforderungen reduziert werden, während die Genauigkeit erhalten bleibt.

Hohe Leistung auf Standard-CPUs: Bietet GPU-ähnliche Leistung auf CPUs und bietet eine zugänglichere und kostengünstigere Option für verschiedene Anwendungen.

Optimierte Integration und Bereitstellung: Bietet benutzerfreundliche Tools zur einfachen Integration von YOLO26 in Anwendungen, einschließlich Funktionen zur Bild- und Videoannotation.

Unterstützung verschiedener Modelltypen: Kompatibel mit sowohl Standard- als auch Sparsity-optimierten YOLO26-Modellen, was die Bereitstellungsflexibilität erhöht.

Kosteneffektive und skalierbare Lösung: Reduziert die Betriebskosten und bietet eine skalierbare Bereitstellung fortschrittlicher Objekterkennungsmodelle.

Wie funktioniert die DeepSparse-Technologie von Neural Magic?

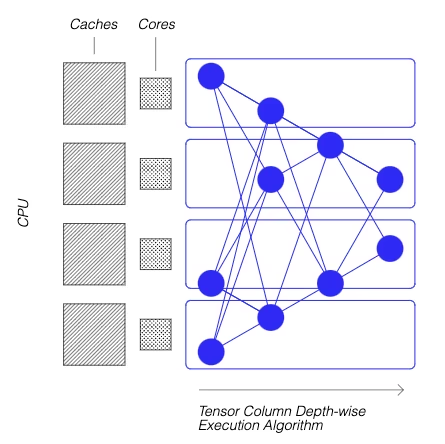

Die DeepSparse-Technologie von Neural Magic ist von der Effizienz des menschlichen Gehirns bei der Berechnung neuronaler Netze inspiriert. Sie übernimmt zwei Schlüsselprinzipien des Gehirns, wie folgt:

Sparsity (Datenreduktion): Der Prozess der Sparsifizierung beinhaltet das Entfernen redundanter Informationen aus Deep-Learning-Netzwerken, was zu kleineren und schnelleren Modellen führt, ohne die Genauigkeit zu beeinträchtigen. Diese Technik reduziert die Größe des Netzwerks und den Rechenbedarf erheblich.

Lokalität der Referenz: DeepSparse verwendet eine einzigartige Ausführungsmethode, bei der das Netzwerk in Tensor-Spalten aufgeteilt wird. Diese Spalten werden tiefenweise ausgeführt und passen vollständig in den Cache der CPU. Dieser Ansatz ahmt die Effizienz des Gehirns nach, minimiert die Datenbewegung und maximiert die Nutzung des CPU-Cache.

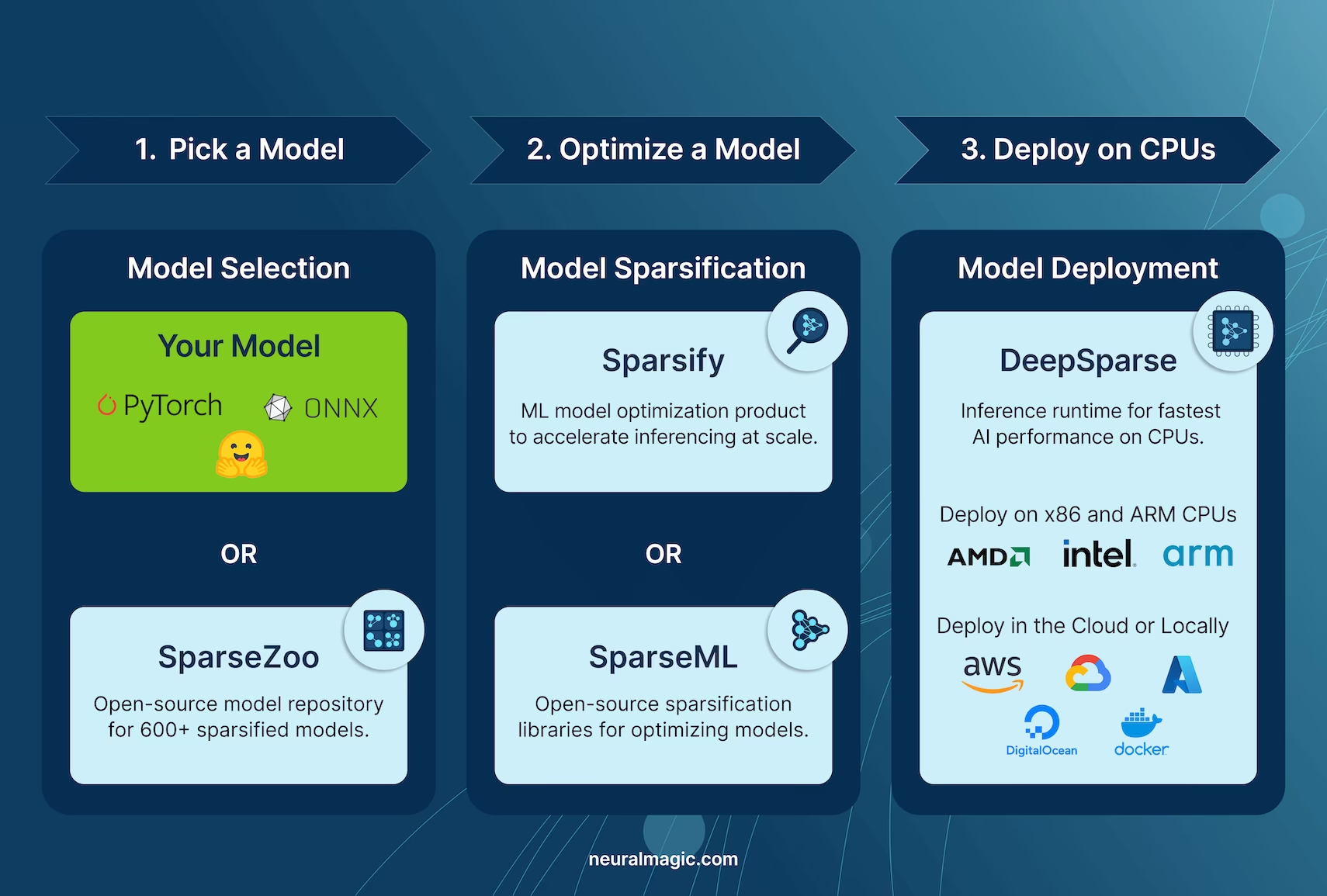

Erstellung einer Sparse-Version von YOLO26, trainiert auf einem benutzerdefinierten Datensatz

SparseZoo, ein Open-Source-Modell-Repository von Neural Magic, bietet eine Sammlung von vor-sparsifizierten YOLO26-Modell-Checkpoints. Mit SparseML, nahtlos in Ultralytics integriert, können Benutzer diese sparsifizierten Checkpoints mühelos auf ihren spezifischen Datensätzen über eine einfache Befehlszeilenschnittstelle feinabstimmen.

Weitere Details finden Sie in Neural Magic's SparseML YOLO26 Dokumentation.

Anwendung: Bereitstellung von YOLO26 mit DeepSparse

Die Bereitstellung von YOLO26 mit Neural Magic's DeepSparse umfasst einige einfache Schritte. Bevor Sie sich mit den Nutzungsanweisungen befassen, sehen Sie sich unbedingt die Palette der YOLO26-Modelle von Ultralytics an. Dies hilft Ihnen, das am besten geeignete Modell für Ihre Projektanforderungen auszuwählen. So können Sie beginnen.

Schritt 1: Installation

Um die erforderlichen Pakete zu installieren, führen Sie Folgendes aus:

Installation

# Install the required packages

pip install deepsparse[yolov8]

Schritt 2: Export von YOLO26 in das ONNX-Format

Die DeepSparse Engine benötigt YOLO26-Modelle im ONNX-Format. Der Export Ihres Modells in dieses Format ist für die Kompatibilität mit DeepSparse unerlässlich. Verwenden Sie den folgenden Befehl, um YOLO26-Modelle zu exportieren:

Modellexport

# Export YOLO26 model to ONNX format

yolo task=detect mode=export model=yolo26n.pt format=onnx opset=13

Dieser Befehl speichert die yolo26n.onnx Modell auf Ihre Festplatte.

Schritt 3: Bereitstellung und Ausführung von Inferenz

Mit Ihrem YOLO26-Modell im ONNX-Format können Sie Inferenzen mit DeepSparse bereitstellen und ausführen. Dies lässt sich einfach mit ihrer intuitiven Python API bewerkstelligen:

Bereitstellung und Ausführung von Inferenz

from deepsparse import Pipeline

# Specify the path to your YOLO26 ONNX model

model_path = "path/to/yolo26n.onnx"

# Set up the DeepSparse Pipeline

yolo_pipeline = Pipeline.create(task="yolov8", model_path=model_path)

# Run the model on your images

images = ["path/to/image.jpg"]

pipeline_outputs = yolo_pipeline(images=images)

Schritt 4: Performance-Benchmarking

Es ist wichtig zu überprüfen, ob Ihr YOLO26-Modell auf DeepSparse optimal funktioniert. Sie können die Leistung Ihres Modells benchmarken, um Durchsatz und Latenz zu analysieren:

Benchmarking

# Benchmark performance

deepsparse.benchmark model_path="path/to/yolo26n.onnx" --scenario=sync --input_shapes="[1,3,640,640]"

Schritt 5: Zusätzliche Funktionen

DeepSparse bietet zusätzliche Funktionen für die praktische Integration von YOLO26 in Anwendungen, wie Bildannotation und Datensatzbewertung.

Zusätzliche Funktionen

# For image annotation

deepsparse.yolov8.annotate --source "path/to/image.jpg" --model_filepath "path/to/yolo26n.onnx"

# For evaluating model performance on a dataset

deepsparse.yolov8.eval --model_path "path/to/yolo26n.onnx"

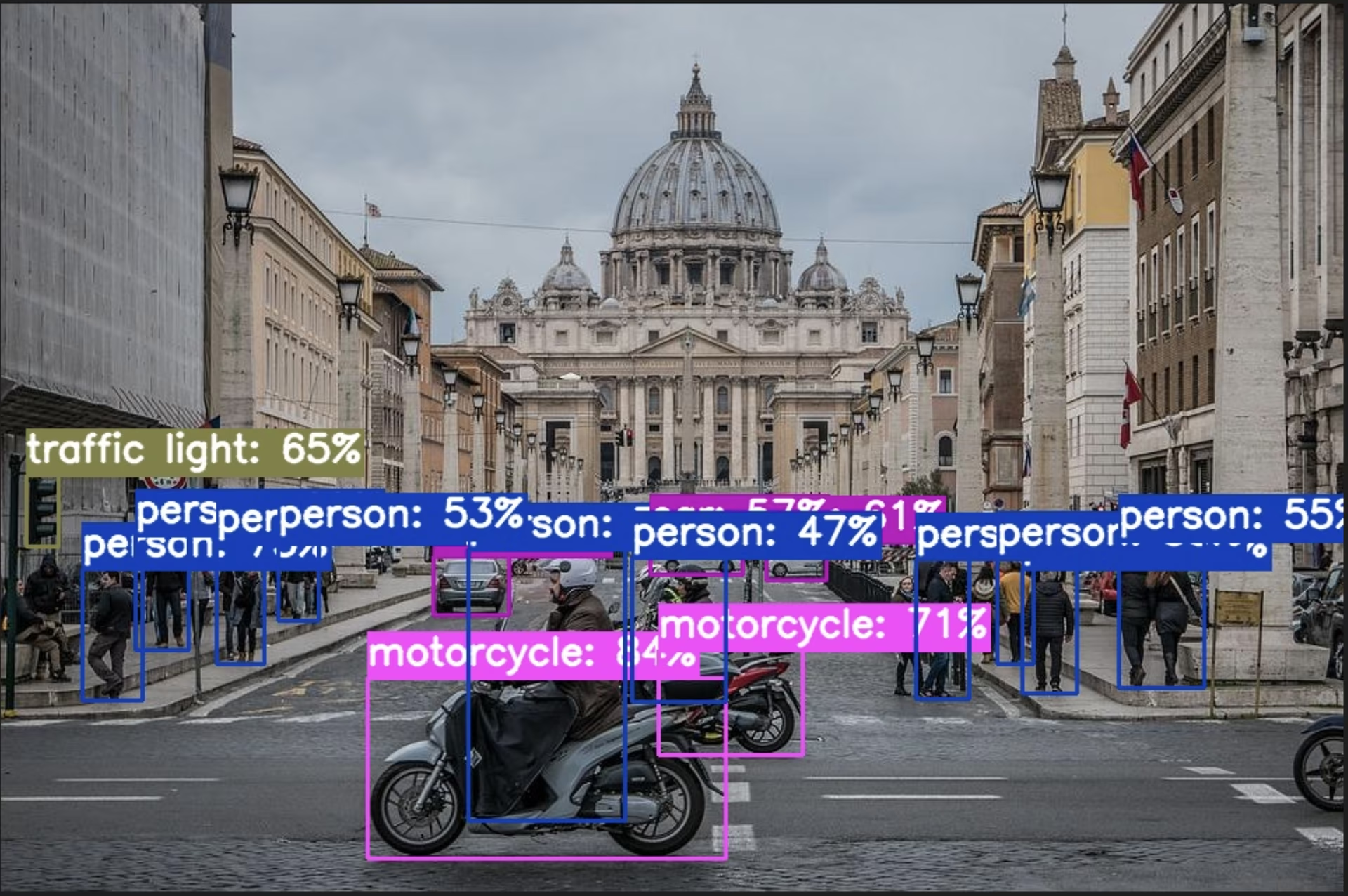

Das Ausführen des Annotationsbefehls verarbeitet Ihr angegebenes Bild, erkennt Objekte und speichert das annotierte Bild mit Begrenzungsrahmen und Klassifizierungen. Das annotierte Bild wird in einem Annotationsergebnis-Ordner gespeichert. Dies trägt dazu bei, eine visuelle Darstellung der Erkennungsfähigkeiten des Modells zu ermöglichen.

Nach Ausführung des eval-Befehls erhalten Sie detaillierte Ausgabemetriken wie Precision, Recall und mAP (mean Average Precision). Dies bietet einen umfassenden Überblick über die Leistung Ihres Modells auf dem Datensatz und ist besonders nützlich für die Feinabstimmung und Optimierung Ihrer YOLO26-Modelle für spezifische Anwendungsfälle, um hohe Genauigkeit und Effizienz zu gewährleisten.

Zusammenfassung

Dieser Leitfaden untersuchte die Integration von Ultralytics' YOLO26 mit Neural Magic's DeepSparse Engine. Er hob hervor, wie diese Integration die Leistung von YOLO26 auf CPU-Plattformen verbessert, indem sie GPU-ähnliche Effizienz und fortschrittliche Techniken zur Sparsity von neuronalen Netzen bietet.

Für detailliertere Informationen und fortgeschrittene Nutzung besuchen Sie die DeepSparse-Dokumentation von Neural Magic. Sie können auch den YOLO26-Integrationsleitfaden erkunden und eine exemplarische Sitzung auf YouTube ansehen.

Zusätzlich, für ein umfassenderes Verständnis verschiedener YOLO26-Integrationen, besuchen Sie die Ultralytics Integrationsleitfaden-Seite, wo Sie eine Reihe weiterer spannender Integrationsmöglichkeiten entdecken können.

FAQ

Was ist die DeepSparse Engine von Neural Magic und wie optimiert sie die YOLO26-Leistung?

Neural Magic's DeepSparse Engine ist eine Inferenz-Laufzeitumgebung, die darauf ausgelegt ist, die Ausführung neuronaler Netze auf CPUs durch fortschrittliche Techniken wie Sparsity, Pruning und Quantisierung zu optimieren. Durch die Integration von DeepSparse mit YOLO26 können Sie GPU-ähnliche Leistung auf Standard-CPUs erzielen, wodurch Inferenzgeschwindigkeit, Modelleffizienz und Gesamtleistung erheblich verbessert werden, während die Genauigkeit erhalten bleibt. Weitere Details finden Sie im DeepSparse-Abschnitt von Neural Magic.

Wie installiere ich die benötigten Pakete, um YOLO26 mit Neural Magic DeepSparse bereitzustellen?

Die Installation der erforderlichen Pakete für die Bereitstellung von YOLO26 mit Neural Magic's DeepSparse ist unkompliziert. Sie können sie einfach über die CLI installieren. Hier ist der Befehl, den Sie ausführen müssen:

pip install deepsparse[yolov8]

Nach der Installation folgen Sie den Schritten im Installationsabschnitt, um Ihre Umgebung einzurichten und DeepSparse mit YOLO26 zu verwenden.

Wie konvertiere ich YOLO26-Modelle in das ONNX-Format zur Verwendung mit DeepSparse?

Um YOLO26-Modelle in das ONNX-Format zu konvertieren, das für die Kompatibilität mit DeepSparse erforderlich ist, können Sie den folgenden CLI-Befehl verwenden:

yolo task=detect mode=export model=yolo26n.pt format=onnx opset=13

Dieser Befehl exportiert Ihr YOLO26-Modell (yolo26n.pt) in ein Format (yolo26n.onnx), das von der DeepSparse Engine genutzt werden kann. Weitere Informationen zum Modellexport finden Sie in der Abschnitt Modellexport.

Wie messe ich die YOLO26-Leistung auf der DeepSparse Engine?

Das Benchmarking der YOLO26-Leistung auf DeepSparse hilft Ihnen, Durchsatz und Latenz zu analysieren, um sicherzustellen, dass Ihr Modell optimiert ist. Sie können den folgenden CLI-Befehl verwenden, um einen Benchmark auszuführen:

deepsparse.benchmark model_path="path/to/yolo26n.onnx" --scenario=sync --input_shapes="[1,3,640,640]"

Dieser Befehl liefert Ihnen wichtige Leistungsmetriken. Weitere Informationen finden Sie im Abschnitt Benchmarking der Leistung.

Warum sollte ich Neural Magic's DeepSparse mit YOLO26 für Objekterkennungsaufgaben verwenden?

Die Integration von Neural Magic's DeepSparse mit YOLO26 bietet mehrere Vorteile:

- Verbesserte Inferenzgeschwindigkeit: Erreicht bis zu 525 FPS (auf YOLO11n), was die Optimierungsfähigkeiten von DeepSparse demonstriert.

- Optimierte Modelleffizienz: Nutzt Sparsity-, Pruning- und Quantisierungstechniken, um die Modellgröße und den Rechenbedarf zu reduzieren und gleichzeitig die Genauigkeit zu erhalten.

- Hohe Leistung auf Standard-CPUs: Bietet GPU-ähnliche Leistung auf kostengünstiger CPU-Hardware.

- Optimierte Integration: Benutzerfreundliche Tools für einfache Bereitstellung und Integration.

- Flexibilität: Unterstützt sowohl Standard- als auch Sparsity-optimierte YOLO26-Modelle.

- Kosteneffektiv: Reduziert die Betriebskosten durch effiziente Ressourcennutzung.

Für einen tieferen Einblick in diese Vorteile besuchen Sie den Abschnitt Vorteile der Integration von Neural Magic's DeepSparse mit YOLO26.