Distribuzione

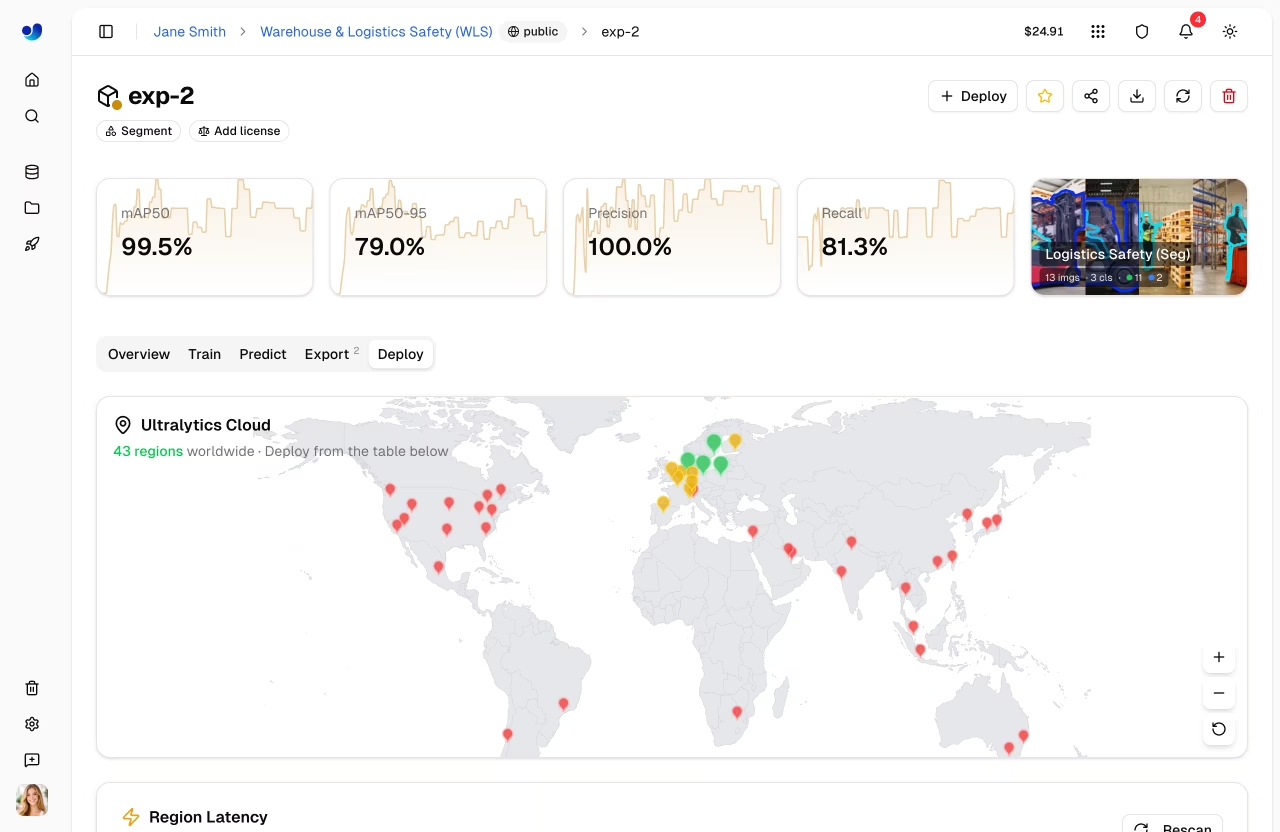

Ultralytics offre opzioni di implementazione complete per mettere in produzione YOLO . È possibile testare i modelli con inferenza basata su browser, implementarli su endpoint dedicati in 43 regioni globali e monitorarne le prestazioni in tempo reale.

Panoramica

La sezione Distribuzione ti aiuta a:

- Test modelli direttamente nel browser con il

Predictscheda - Distribuire su endpoint dedicati in 43 regioni globali

- Monitorare le metriche delle richieste, i registri e i controlli di integrità

- Scalabilità automatica in base al traffico (inclusa la scalabilità a zero)

Opzioni di Deployment

Ultralytics Platform offre molteplici percorsi di distribuzione:

| Opzione | Descrizione | Ideale per |

|---|---|---|

| Scheda Previsione | Inferenza basata su browser con immagini, webcam ed esempi | Sviluppo, validazione |

| Inferenza Condivisa | Servizio multi-tenant in 3 regioni | Uso leggero, test |

| Endpoint Dedicati | Servizi per singoli clienti in 43 regioni | Produzione, bassa latenza |

Flusso di Lavoro

graph LR

A[✅ Test] --> B[⚙️ Configure]

B --> C[🌐 Deploy]

C --> D[📊 Monitor]

style A fill:#4CAF50,color:#fff

style B fill:#2196F3,color:#fff

style C fill:#FF9800,color:#fff

style D fill:#9C27B0,color:#fff| Fase | Descrizione |

|---|---|

| Test | Convalida il modello con il Predict scheda |

| Configura | Seleziona regione, risorse e nome distribuzione |

| Distribuisci | Crea un endpoint dedicato dal Deploy scheda |

| Monitora | Traccia richieste, latenza, errori e registri in Monitoraggio |

Architettura

Inferenza Condivisa

Il servizio di inferenza condiviso è attivo in 3 regioni chiave e instrada automaticamente le richieste in base alla regione dei dati:

graph TB

User[User Request] --> API[Platform API]

API --> Router{Region Router}

Router -->|US users| US["US Predict Service<br/>Iowa"]

Router -->|EU users| EU["EU Predict Service<br/>Belgium"]

Router -->|AP users| AP["AP Predict Service<br/>Hong Kong"]

style User fill:#f5f5f5,color:#333

style API fill:#2196F3,color:#fff

style Router fill:#FF9800,color:#fff

style US fill:#4CAF50,color:#fff

style EU fill:#4CAF50,color:#fff

style AP fill:#4CAF50,color:#fff| Regione | Località |

|---|---|

| USA | Iowa, USA |

| UE | Belgio, Europa |

| AP | Hong Kong, Asia-Pacifico |

Endpoint Dedicati

Distribuzione in 43 regioni in tutto il mondo su Ultralytics :

- Americhe: 14 regioni

- Europa: 13 regioni

- Asia-Pacifico: 12 regioni

- Medio Oriente e Africa: 4 regioni

Ogni endpoint è un servizio single-tenant con:

- Risorse di calcolo dedicate ( CPU memoria configurabili)

- Scalabilità automatica (riduzione a zero in caso di inattività)

- URL endpoint unico

- Monitoraggio indipendente, registri e controlli di integrità

Pagina delle distribuzioni

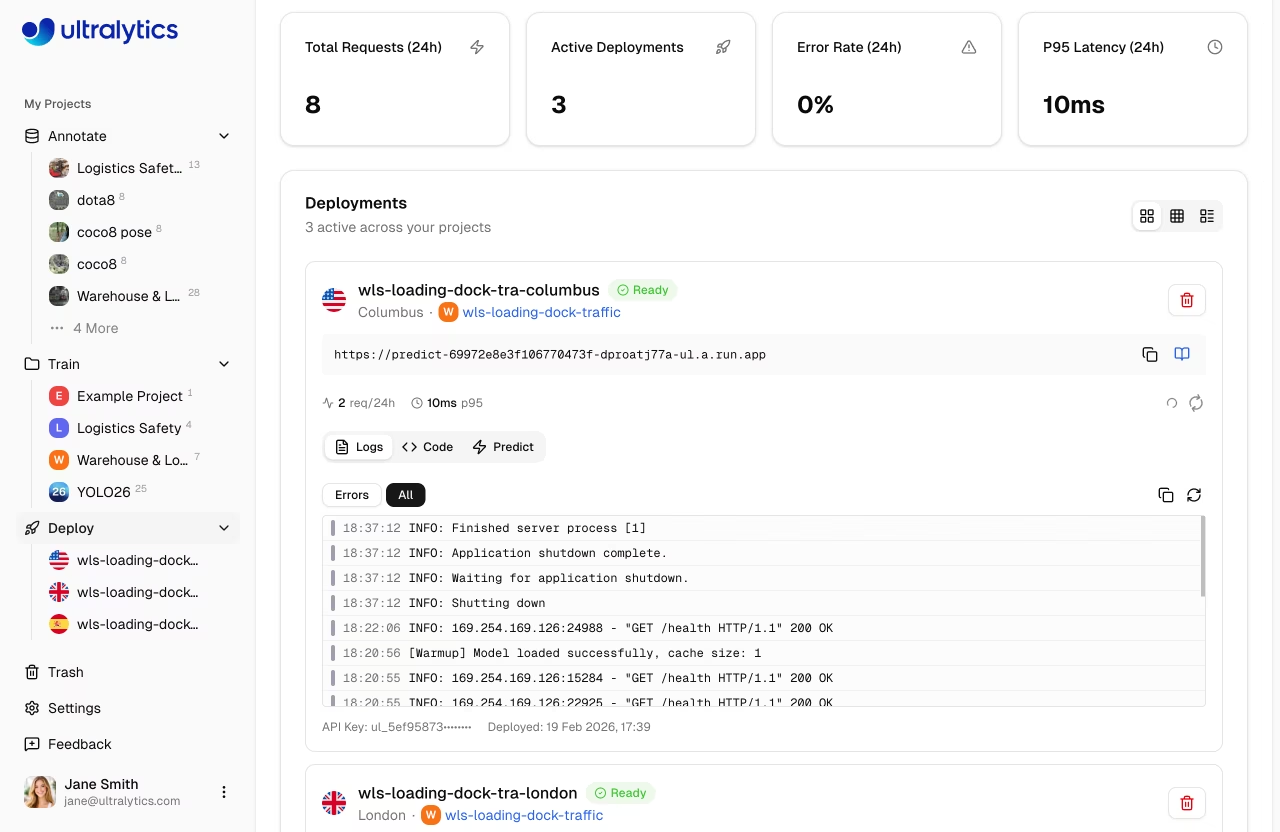

Accedi alla pagina delle distribuzioni globali dalla barra laterale sotto Deploy. Questa pagina mostra:

- Mappa mondiale con indicatori delle regioni interessate (mappa interattiva)

- Schede panoramica: Richieste totali (24 ore), Distribuzioni attive, Tasso di errore (24 ore), Latenza P95 (24 ore)

- Elenco delle distribuzioni con tre modalità di visualizzazione: schede, compatta e tabella

- Nuovo pulsante "Distribuzione " per creare endpoint da qualsiasi modello completato

Sondaggio automatico

La pagina esegue un polling ogni 30 secondi per gli aggiornamenti delle metriche. Quando le distribuzioni sono in uno stato di transizione (creazione, distribuzione, arresto), il polling aumenta a ogni 2-3 secondi per un feedback quasi istantaneo.

Caratteristiche principali

Copertura Globale

Effettua il deployment vicino ai tuoi utenti con 43 regioni che coprono:

- Nord America, Sud America

- Europa, Medio Oriente, Africa

- Asia Pacifico, Oceania

Auto-Scaling

Gli endpoint scalano automaticamente:

- Scala a zero: nessun costo quando inattivo (impostazione predefinita)

- Scalabilità: gestione automatica dei picchi di traffico

Risparmio sui costi

L'opzione Scale-to-zero è abilitata per impostazione predefinita (numero minimo di istanze = 0). Paghi solo per il tempo di inferenza attivo.

Bassa Latenza

Gli endpoint dedicati offrono:

- Avvio a freddo: ~5-15 secondi (contenitore memorizzato nella cache), fino a ~45 secondi (prima distribuzione)

- Inferenza a caldo: 50-200 ms (dipendente dal modello)

- Routing regionale per prestazioni ottimali

Controlli sanitari

Ogni distribuzione in esecuzione include un controllo automatico dello stato di integrità con:

- Indicatore di stato in tempo reale (funzionamento corretto/non corretto)

- Visualizzazione della latenza di risposta

- Riprova automaticamente quando non funziona correttamente (controlla ogni 20 secondi)

- Pulsante di aggiornamento manuale

Guida rapida

Distribuisci un modello in meno di 2 minuti:

- Addestrare o caricare un modello in un progetto

- Vai alla scheda Distribuzione del modello

- Seleziona una regione dalla tabella della latenza

- Clicca su Distribuisci: il tuo endpoint è attivo

Distribuzione rapida

Model → Deploy tab → Select region → Click Deploy → Endpoint URL ready

Una volta implementato, utilizza l'URL dell'endpoint con la tua chiave API per inviare richieste di inferenza da qualsiasi applicazione.

Link Rapidi

- Inferenza: Testa i modelli nel browser

- Endpoint: Implementa endpoint dedicati

- Monitoraggio: Monitora le prestazioni del deployment

FAQ

Qual è la differenza tra inferenza condivisa e dedicata?

| Funzionalità | Condiviso | Dedicato |

|---|---|---|

| Latenza | Variabile | Costante |

| Costo | Pagamento per richiesta | Pagamento per tempo di attività |

| Scala | Limitato | Configurabile |

| Regioni | 3 | 43 |

| URL | Generico | Personalizzato |

Quanto tempo richiede la distribuzione?

Il deployment di un endpoint dedicato richiede tipicamente 1-2 minuti:

- Pull dell'immagine (~30s)

- Avvio del container (~30s)

- Health check (~30s)

È possibile distribuire più modelli?

Sì, ogni modello può avere più endpoint in diverse regioni. Non c'è un limite al numero totale di endpoint (soggetto al tuo piano).

Cosa succede quando un endpoint è inattivo?

Con scale-to-zero abilitato:

- L'endpoint si ridimensiona dopo inattività

- La prima richiesta attiva un cold start

- Le richieste successive sono veloci

Le prime richieste dopo un periodo di inattività attivano un avvio a freddo.