Implantação

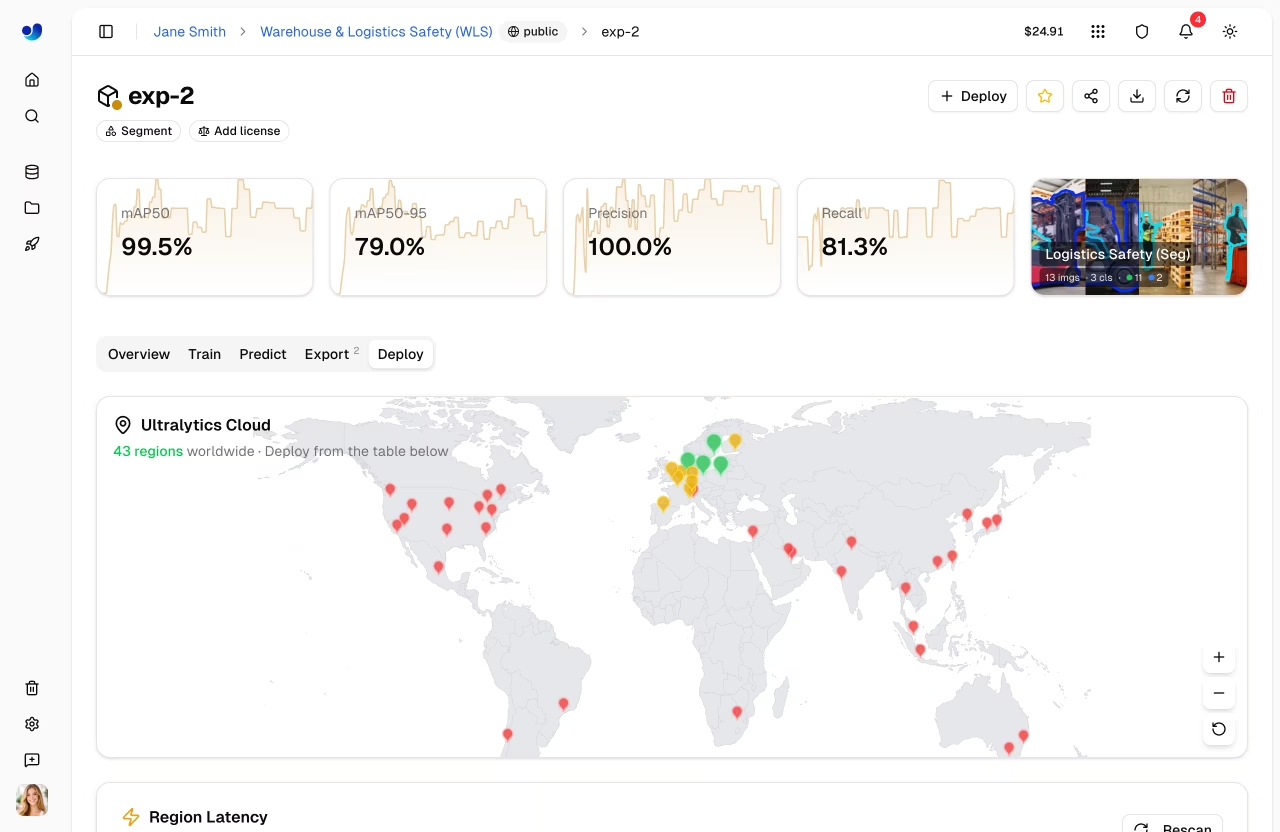

Ultralytics oferece opções abrangentes de implementação para colocar YOLO seus YOLO em produção. Teste modelos com inferência baseada em navegador, implemente em terminais dedicados em 43 regiões globais e monitore o desempenho em tempo real.

Visão geral

A seção de Implantação ajuda você a:

- Testar modelos diretamente no navegador com o

Predictaba - Implantar em endpoints dedicados em 43 regiões globais

- Monitorize métricas de pedidos, registos e verificações de integridade

- Escala automaticamente com o tráfego (incluindo escala para zero)

Opções de Implantação

Ultralytics Platform oferece múltiplos caminhos de implantação:

| Opção | Descrição | Ideal Para |

|---|---|---|

| Guia Prever | Inferência baseada em navegador com imagem, webcam e exemplos | Desenvolvimento, validação |

| Inferência Compartilhada | Serviço multi-tenant em 3 regiões | Uso leve, testes |

| Endpoints Dedicados | Serviços para um único inquilino em 43 regiões | Produção, baixa latência |

Fluxo de Trabalho

graph LR

A[✅ Test] --> B[⚙️ Configure]

B --> C[🌐 Deploy]

C --> D[📊 Monitor]

style A fill:#4CAF50,color:#fff

style B fill:#2196F3,color:#fff

style C fill:#FF9800,color:#fff

style D fill:#9C27B0,color:#fff| Etapa | Descrição |

|---|---|

| Testar | Validar o modelo com o Predict aba |

| Configurar | Selecione a região, os recursos e o nome da implementação |

| Implantação | Crie um ponto de extremidade dedicado a partir do Deploy aba |

| Monitorar | Acompanhe solicitações, latência, erros e registos no Monitoramento |

Arquitetura

Inferência Compartilhada

O serviço de inferência partilhada é executado em três regiões principais, encaminhando automaticamente as solicitações com base na sua região de dados:

graph TB

User[User Request] --> API[Platform API]

API --> Router{Region Router}

Router -->|US users| US["US Predict Service<br/>Iowa"]

Router -->|EU users| EU["EU Predict Service<br/>Belgium"]

Router -->|AP users| AP["AP Predict Service<br/>Hong Kong"]

style User fill:#f5f5f5,color:#333

style API fill:#2196F3,color:#fff

style Router fill:#FF9800,color:#fff

style US fill:#4CAF50,color:#fff

style EU fill:#4CAF50,color:#fff

style AP fill:#4CAF50,color:#fff| Região | Localização |

|---|---|

| EUA | Iowa, EUA |

| UE | Bélgica, Europa |

| AP | Hong Kong, Ásia-Pacífico |

Endpoints Dedicados

Implemente em 43 regiões em todo o mundo na Ultralytics :

- Américas: 14 regiões

- Europa: 13 regiões

- Ásia-Pacífico: 12 regiões

- Médio Oriente e África: 4 regiões

Cada endpoint é um serviço de tenant único com:

- Recursos de computação dedicados ( CPU memória configuráveis)

- Autoescalonamento (escalonamento para zero quando inativo)

- URL de ponto final exclusivo

- Monitorização independente, registos e verificações de integridade

Página de implementações

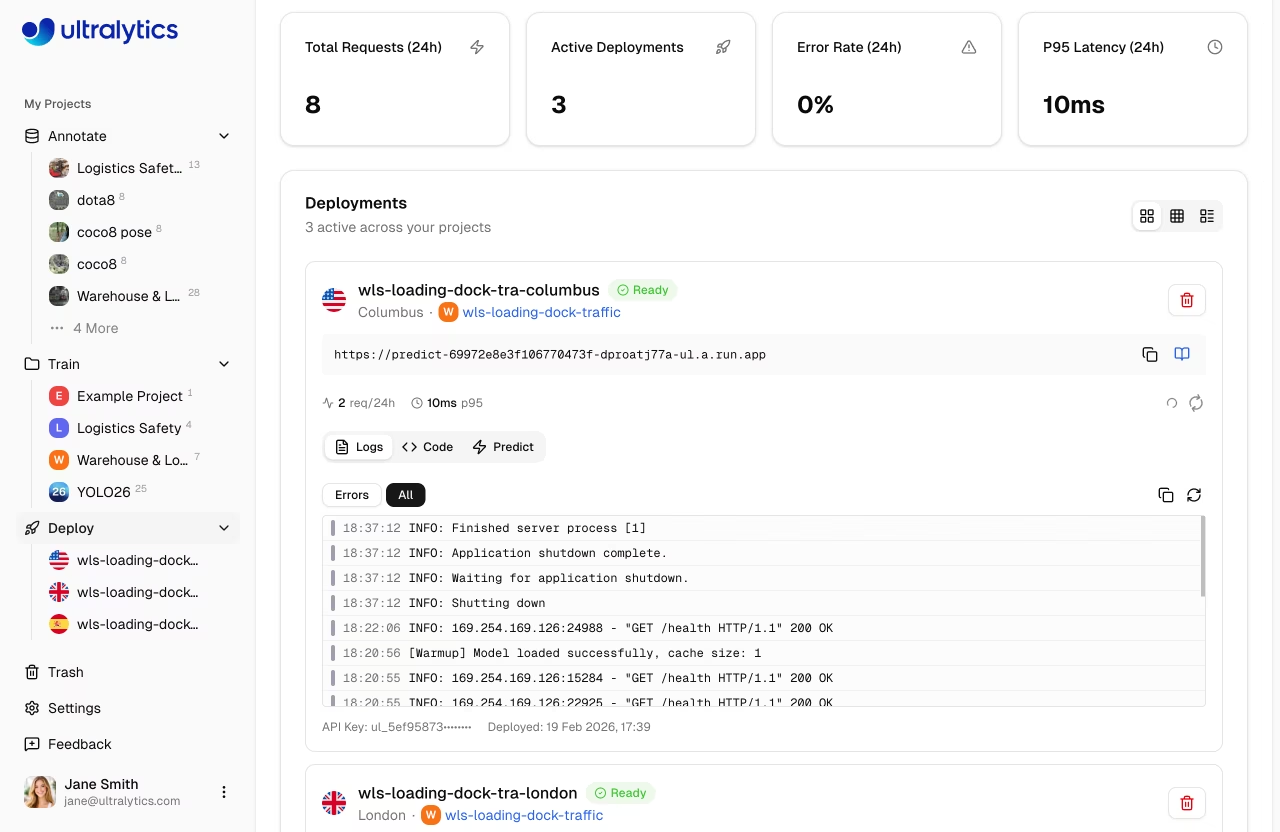

Aceda à página de implementações globais na barra lateral em Deploy. Esta página mostra:

- Mapa-múndi com marcadores das regiões implantadas (mapa interativo)

- Cartões de visão geral: Total de solicitações (24 horas), Implantações ativas, Taxa de erros (24 horas), Latência P95 (24 horas)

- Lista de implementações com três modos de visualização: cartões, compacto e tabela

- Botão Nova Implementação para criar pontos finais a partir de qualquer modelo concluído

Pesquisa automática

A página faz uma sondagem a cada 30 segundos para atualizações métricas. Quando as implementações estão num estado de transição (criação, implementação, paragem), a sondagem aumenta para cada 2-3 segundos para um feedback quase instantâneo.

Principais Características

Cobertura Global

Implemente próximo aos seus usuários com 43 regiões cobrindo:

- América do Norte, América do Sul

- Europa, Oriente Médio, África

- Ásia-Pacífico, Oceania

Autoescalabilidade

Endpoints escalam automaticamente:

- Escala para zero: sem custo quando inativo (padrão)

- Amplie: lide com picos de tráfego automaticamente

Poupança de custos

A escala para zero está ativada por predefinição (mínimo de instâncias = 0). Só paga pelo tempo de inferência ativo.

Baixa Latência

Endpoints dedicados oferecem:

- Arranque a frio: ~5-15 segundos (contentor em cache), até ~45 segundos (primeira implementação)

- Inferência aquecida: 50-200ms (dependente do modelo)

- Roteamento regional para desempenho ideal

Exames de saúde

Cada implementação em execução inclui uma verificação automática de integridade com:

- Indicador de estado em tempo real (funcionando/não funcionando)

- Exibição da latência de resposta

- Reentrada automática quando não estiver em boas condições (verifica a cada 20 segundos)

- Botão de atualização manual

Início Rápido

Implemente um modelo em menos de 2 minutos:

- Treinar ou carregar um modelo para um projeto

- Vá para o separador Implantar do modelo

- Selecione uma região na tabela de latência

- Clique em Implementar — o seu terminal está ativo

Implantação rápida

Model → Deploy tab → Select region → Click Deploy → Endpoint URL ready

Depois de implementado, utilize o URL do ponto final com a sua chave API para enviar pedidos de inferência a partir de qualquer aplicação.

Links Rápidos

- Inferência: Teste modelos no navegador

- Endpoints: Implemente endpoints dedicados

- Monitoramento: Acompanhar o desempenho da implantação

FAQ

Qual a diferença entre inferência compartilhada e dedicada?

| Funcionalidade | Compartilhado | Dedicado |

|---|---|---|

| Latência | Variável | Consistente |

| Custo | Pagamento por solicitação | Pagamento pelo tempo de atividade |

| Escala | Limitado | Configurável |

| Regiões | 3 | 43 |

| URL | Genérico | Personalizado |

Quanto tempo leva a implantação?

A implantação de endpoint dedicado geralmente leva de 1 a 2 minutos:

- Pull da imagem (~30s)

- Inicialização do contêiner (~30s)

- Verificação de integridade (~30s)

Posso implantar vários modelos?

Sim, cada modelo pode ter múltiplos endpoints em diferentes regiões. Não há limite para o total de endpoints (sujeito ao seu plano).

O que acontece quando um endpoint está ocioso?

Com escala para zero habilitada:

- O endpoint é reduzido após inatividade

- A primeira solicitação aciona o início a frio

- As solicitações subsequentes são rápidas

As primeiras solicitações após um período de inatividade acionam uma inicialização a frio.