Ultralytics YOLO26

Visão geral

O Ultralytics YOLO26 é a mais recente evolução na série YOLO de detectores de objetos em tempo real, projetado desde o início para dispositivos edge e de baixa potência. Ele introduz um design simplificado que remove a complexidade desnecessária, integrando inovações direcionadas para fornecer uma implantação mais rápida, leve e acessível.

Experimente a Ultralytics

Explore e execute modelos YOLO26 diretamente na Ultralytics .

A arquitetura do YOLO26 é orientada por três princípios básicos:

- Simplicidade: YOLO26 é um modelo nativo end-to-end, produzindo previsões diretamente sem a necessidade de supressão não máxima (NMS). Ao eliminar esta etapa de pós-processamento, a inferência torna-se mais rápida, leve e fácil de implementar em sistemas do mundo real. Esta abordagem inovadora foi pioneira em YOLOv10 por Ao Wang na Universidade de Tsinghua e foi ainda mais aprimorada no YOLO26.

- Eficiência de Implantação: O design end-to-end elimina toda uma etapa do pipeline, simplificando drasticamente a integração, reduzindo a latência e tornando a implantação mais robusta em diversos ambientes.

- Inovação no Treinamento: O YOLO26 introduz o otimizador MuSGD, um híbrido de SGD e Muon — inspirado nos avanços da Moonshot AI em Kimi K2 no treinamento de LLM. Este otimizador traz maior estabilidade e convergência mais rápida, transferindo avanços de otimização de modelos de linguagem para visão computacional.

- Otimizações Específicas da Tarefa: YOLO26 introduz melhorias direcionadas para tarefas especializadas, incluindo perda de segmentação semântica e módulos proto multi-escala para Segmentation, Estimativa de Log-Verossimilhança Residual (RLE) para estimativa de Pose de alta precisão, e decodificação otimizada com perda angular para resolver problemas de limite em OBB.

Juntas, essas inovações fornecem uma família de modelos que alcança maior precisão em pequenos objetos, oferece implantação perfeita e é executada até 43% mais rápido em CPUs — tornando o YOLO26 um dos modelos YOLO mais práticos e implantáveis até o momento para ambientes com recursos limitados.

Principais Características

Remoção do DFL

O módulo Distribution Focal Loss (DFL), embora eficaz, frequentemente complicava a exportação e limitava a compatibilidade de hardware. YOLO26 remove o DFL completamente, simplificando a inferência e ampliando o suporte para dispositivos de borda e de baixa potência.Inferência End-to-End Livre de NMS

Ao contrário dos detectores tradicionais que dependem do NMS como uma etapa de pós-processamento separada, o YOLO26 é nativamente end-to-end. As predições são geradas diretamente, reduzindo a latência e tornando a integração em sistemas de produção mais rápida, leve e confiável.ProgLoss + STAL

Funções de perda aprimoradas aumentam a precisão da detecção, com melhorias notáveis no reconhecimento de objetos pequenos, um requisito crítico para IoT, robótica, imagens aéreas e outras aplicações de edge.Otimizador MuSGD

Um novo otimizador híbrido que combina SGD com Muon. Inspirado no Kimi K2 da Moonshot AI, o MuSGD introduz métodos avançados de otimização do treinamento de LLM na visão computacional, permitindo um treinamento mais estável e uma convergência mais rápida.Inferência de CPU até 43% Mais Rápida

Especificamente otimizado para computação de borda, o YOLO26 oferece inferência de CPU significativamente mais rápida, garantindo desempenho em tempo real em dispositivos sem GPUs.Aprimoramentos de Segmentação de Instância

Introduz perda de segmentação semântica para melhorar a convergência do modelo e um módulo proto atualizado que aproveita informações multi-escala para uma qualidade de máscara superior.Estimativa de Posição de Precisão

Integra a Estimativa de Log-Verossimilhança Residual (RLE) para uma localização mais precisa de pontos-chave e otimiza o processo de decodificação para maior velocidade de inferência.Decodificação OBB Refinada

Introduz uma perda de ângulo especializada para melhorar a precisão da detecção de objetos de formato quadrado e otimiza a decodificação OBB para resolver problemas de descontinuidade de limites.

Tarefas e Modos Suportados

YOLO26 baseia-se na versátil gama de modelos estabelecida por lançamentos anteriores do Ultralytics YOLO, oferecendo suporte aprimorado em várias tarefas de visão computacional:

| Modelo | Nomes de arquivos | Tarefa | Inferência | Validação | Treinamento | Exportar |

|---|---|---|---|---|---|---|

| YOLO26 | yolo26n.pt yolo26s.pt yolo26m.pt yolo26l.pt yolo26x.pt | Detecção | ✅ | ✅ | ✅ | ✅ |

| YOLO26-seg | yolo26n-seg.pt yolo26s-seg.pt yolo26m-seg.pt yolo26l-seg.pt yolo26x-seg.pt | Segmentação de Instância | ✅ | ✅ | ✅ | ✅ |

| YOLO26-pose | yolo26n-pose.pt yolo26s-pose.pt yolo26m-pose.pt yolo26l-pose.pt yolo26x-pose.pt | Pose/Keypoints | ✅ | ✅ | ✅ | ✅ |

| YOLO26-obb | yolo26n-obb.pt yolo26s-obb.pt yolo26m-obb.pt yolo26l-obb.pt yolo26x-obb.pt | Detecção Orientada | ✅ | ✅ | ✅ | ✅ |

| YOLO26-cls | yolo26n-cls.pt yolo26s-cls.pt yolo26m-cls.pt yolo26l-cls.pt yolo26x-cls.pt | Classificação | ✅ | ✅ | ✅ | ✅ |

Esta estrutura unificada garante que o YOLO26 seja aplicável em detecção em tempo real, segmentação, classificação, estimativa de pose e detecção de objetos orientados — tudo com suporte para treinamento, validação, inferência e exportação.

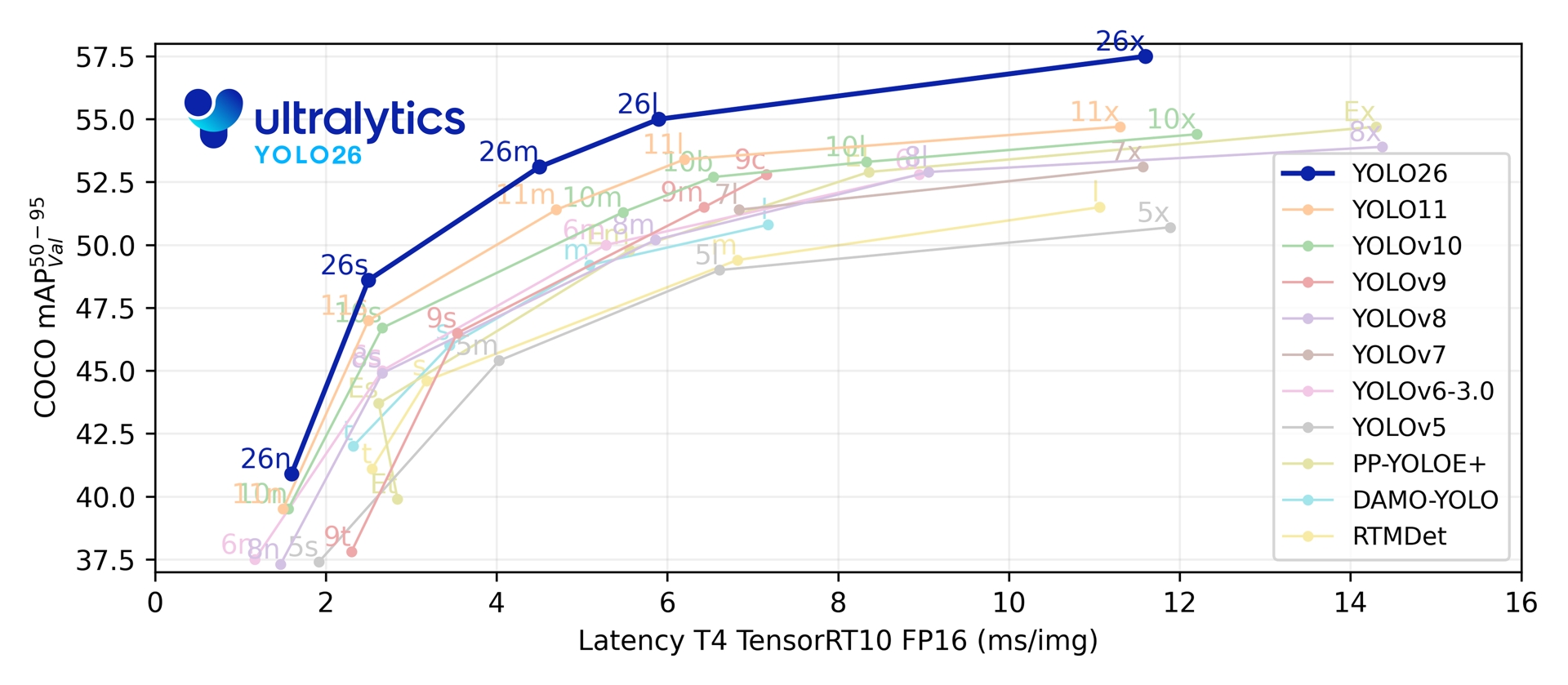

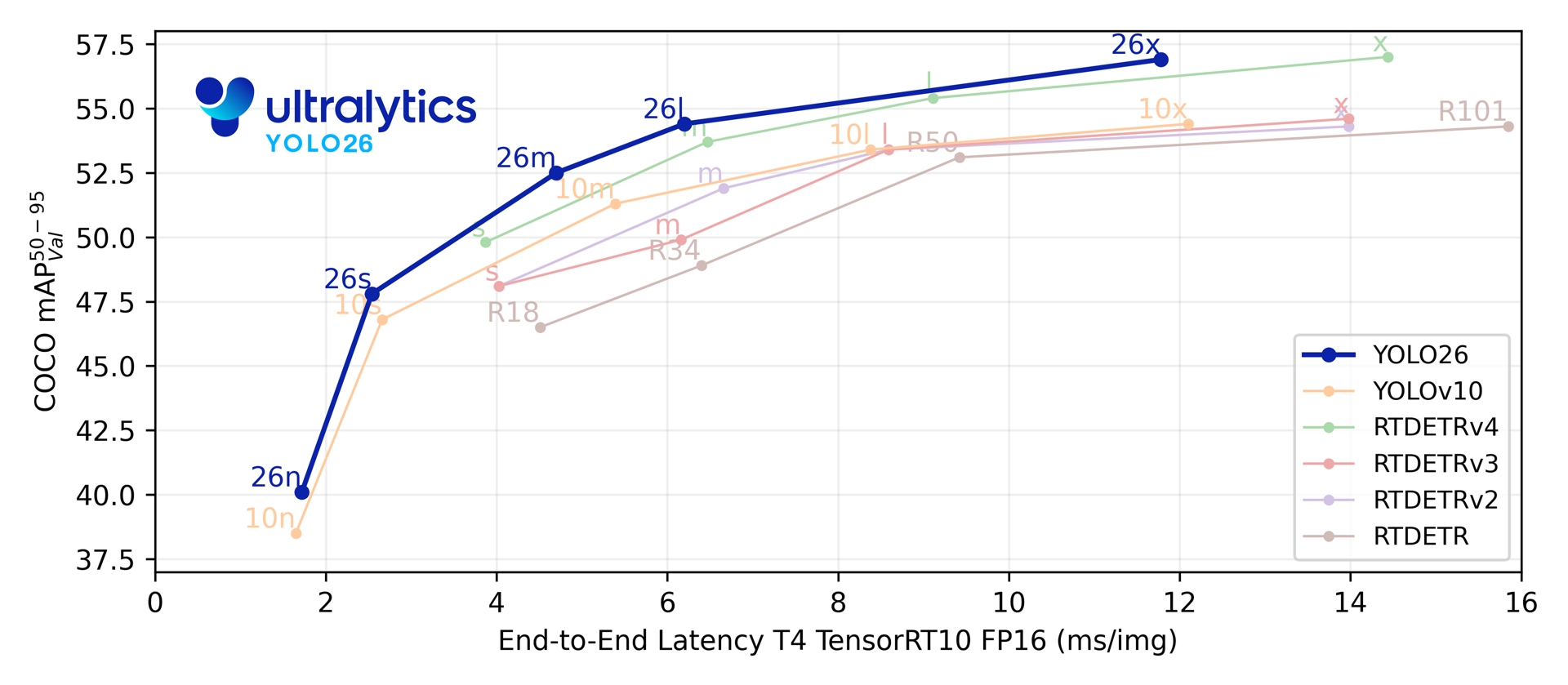

Métricas de Desempenho

Desempenho

Consulte a Documentação de Detecção para exemplos de uso com esses modelos treinados no COCO, que incluem 80 classes pré-treinadas.

| Modelo | tamanho (pixels) | mAPval 50-95 | mAPval 50-95(e2e) | Velocidade CPU ONNX (ms) | Velocidade T4 TensorRT10 (ms) | parâmetros (M) | FLOPs (B) |

|---|---|---|---|---|---|---|---|

| YOLO26n | 640 | 40.9 | 40.1 | 38.9 ± 0.7 | 1.7 ± 0.0 | 2.4 | 5.4 |

| YOLO26s | 640 | 48.6 | 47.8 | 87.2 ± 0.9 | 2.5 ± 0.0 | 9.5 | 20.7 |

| YOLO26m | 640 | 53.1 | 52.5 | 220.0 ± 1.4 | 4.7 ± 0.1 | 20.4 | 68.2 |

| YOLO26l | 640 | 55.0 | 54.4 | 286.2 ± 2.0 | 6.2 ± 0.2 | 24.8 | 86.4 |

| YOLO26x | 640 | 57.5 | 56.9 | 525.8 ± 4.0 | 11.8 ± 0.2 | 55.7 | 193.9 |

Consulte a Documentação de Segmentação para exemplos de uso com esses modelos treinados no COCO, que incluem 80 classes pré-treinadas.

| Modelo | tamanho (pixels) | mAPbox 50-95(e2e) | mAPmask 50-95(e2e) | Velocidade CPU ONNX (ms) | Velocidade T4 TensorRT10 (ms) | parâmetros (M) | FLOPs (B) |

|---|---|---|---|---|---|---|---|

| YOLO26n-seg | 640 | 39.6 | 33.9 | 53.3 ± 0.5 | 2.1 ± 0.0 | 2.7 | 9.1 |

| YOLO26s-seg | 640 | 47.3 | 40.0 | 118.4 ± 0.9 | 3.3 ± 0.0 | 10.4 | 34.2 |

| YOLO26m-seg | 640 | 52.5 | 44.1 | 328.2 ± 2.4 | 6.7 ± 0.1 | 23.6 | 121.5 |

| YOLO26l-seg | 640 | 54.4 | 45.5 | 387.0 ± 3.7 | 8.0 ± 0.1 | 28.0 | 139.8 |

| YOLO26x-seg | 640 | 56.5 | 47.0 | 787.0 ± 6.8 | 16.4 ± 0.1 | 62.8 | 313.5 |

Consulte a Documentação de Classificação para exemplos de uso com esses modelos treinados no ImageNet, que incluem 1000 classes pré-treinadas.

| Modelo | tamanho (pixels) | acc top1 | acc top5 | Velocidade CPU ONNX (ms) | Velocidade T4 TensorRT10 (ms) | parâmetros (M) | FLOPs (B) a 224 |

|---|---|---|---|---|---|---|---|

| YOLO26n-cls | 224 | 71.4 | 90.1 | 5.0 ± 0.3 | 1.1 ± 0.0 | 2.8 | 0.5 |

| YOLO26s-cls | 224 | 76.0 | 92.9 | 7.9 ± 0.2 | 1.3 ± 0.0 | 6.7 | 1.6 |

| YOLO26m-cls | 224 | 78.1 | 94.2 | 17.2 ± 0.4 | 2.0 ± 0.0 | 11.6 | 4.9 |

| YOLO26l-cls | 224 | 79.0 | 94.6 | 23.2 ± 0.3 | 2.8 ± 0.0 | 14.1 | 6.2 |

| YOLO26x-cls | 224 | 79.9 | 95.0 | 41.4 ± 0.9 | 3.8 ± 0.0 | 29.6 | 13.6 |

Consulte a Documentação de Estimativa de Pose para exemplos de uso com estes modelos treinados em COCO, que incluem 1 classe pré-treinada, 'pessoa'.

| Modelo | tamanho (pixels) | mAPpose 50-95(e2e) | mAPpose 50(e2e) | Velocidade CPU ONNX (ms) | Velocidade T4 TensorRT10 (ms) | parâmetros (M) | FLOPs (B) |

|---|---|---|---|---|---|---|---|

| YOLO26n-pose | 640 | 57.2 | 83.3 | 40.3 ± 0.5 | 1.8 ± 0.0 | 2.9 | 7.5 |

| YOLO26s-pose | 640 | 63.0 | 86.6 | 85.3 ± 0.9 | 2.7 ± 0.0 | 10.4 | 23.9 |

| YOLO26m-pose | 640 | 68.8 | 89.6 | 218.0 ± 1.5 | 5.0 ± 0.1 | 21.5 | 73.1 |

| YOLO26l-pose | 640 | 70.4 | 90.5 | 275.4 ± 2.4 | 6.5 ± 0.1 | 25.9 | 91.3 |

| YOLO26x-pose | 640 | 71.6 | 91.6 | 565.4 ± 3.0 | 12.2 ± 0.2 | 57.6 | 201.7 |

Consulte a Documentação de Detecção Orientada para exemplos de uso com esses modelos treinados no DOTAv1, que incluem 15 classes pré-treinadas.

| Modelo | tamanho (pixels) | mAPtest 50-95(e2e) | mAPtest 50(e2e) | Velocidade CPU ONNX (ms) | Velocidade T4 TensorRT10 (ms) | parâmetros (M) | FLOPs (B) |

|---|---|---|---|---|---|---|---|

| YOLO26n-obb | 1024 | 52.4 | 78.9 | 97.7 ± 0.9 | 2.8 ± 0.0 | 2.5 | 14.0 |

| YOLO26s-obb | 1024 | 54.8 | 80.9 | 218.0 ± 1.4 | 4.9 ± 0.1 | 9.8 | 55.1 |

| YOLO26m-obb | 1024 | 55.3 | 81.0 | 579.2 ± 3.8 | 10.2 ± 0.3 | 21.2 | 183.3 |

| YOLO26l-obb | 1024 | 56.2 | 81.6 | 735.6 ± 3.1 | 13.0 ± 0.2 | 25.6 | 230.0 |

| YOLO26x-obb | 1024 | 56.7 | 81.7 | 1485.7 ± 11.5 | 30.5 ± 0.9 | 57.6 | 516.5 |

Os valores dos parâmetros e FLOPs são para o modelo fundido após model.fuse(), que combina as camadas Conv e BatchNorm e remove o cabeçalho auxiliar de detecção um-para-muitos. Os pontos de verificação pré-treinados mantêm a arquitetura de treino completa e podem apresentar contagens mais elevadas.

Exemplos de uso

Esta seção fornece exemplos simples de treinamento e inferência do YOLO26. Para documentação completa sobre estes e outros modos, consulte as páginas de documentação de Predict, Train, Val e Export.

Observe que o exemplo abaixo é para modelos YOLO26 Detect para detecção de objetos. Para tarefas adicionais suportadas, consulte a documentação de Segment, Classify, OBB e Pose.

Exemplo

PyTorch pré-treinados *.pt modelos, bem como a configuração *.yaml os arquivos podem ser passados para o YOLO() class para criar uma instância de modelo em Python:

from ultralytics import YOLO

# Load a COCO-pretrained YOLO26n model

model = YOLO("yolo26n.pt")

# Train the model on the COCO8 example dataset for 100 epochs

results = model.train(data="coco8.yaml", epochs=100, imgsz=640)

# Run inference with the YOLO26n model on the 'bus.jpg' image

results = model("path/to/bus.jpg")

Comandos da CLI estão disponíveis para executar os modelos diretamente:

# Load a COCO-pretrained YOLO26n model and train it on the COCO8 example dataset for 100 epochs

yolo train model=yolo26n.pt data=coco8.yaml epochs=100 imgsz=640

# Load a COCO-pretrained YOLO26n model and run inference on the 'bus.jpg' image

yolo predict model=yolo26n.pt source=path/to/bus.jpg

Arquitetura de cabeça dupla

O YOLO26 apresenta uma arquitetura de cabeça dupla que oferece flexibilidade para diferentes cenários de implementação:

- Cabeça individual (padrão): Produz previsões completas sem NMS, gerando

(N, 300, 6)com um máximo de 300 detecções por imagem. Esta cabeça é otimizada para inferência rápida e implementação simplificada. - Cabeça Um-para-Muitos: Gera YOLO tradicionais que requerem NMS , produzindo

(N, nc + 4, 8400)ondencé o número de classes. Este cabeçalho normalmente alcança uma precisão ligeiramente superior, mas à custa de um processamento adicional.

Você pode alternar entre cabeças durante a exportação, previsão ou validação:

from ultralytics import YOLO

model = YOLO("yolo26n.pt")

# Use one-to-one head (default, no NMS required)

results = model.predict("image.jpg") # inference

metrics = model.val(data="coco.yaml") # validation

model.export(format="onnx") # export

# Use one-to-many head (requires NMS)

results = model.predict("image.jpg", end2end=False) # inference

metrics = model.val(data="coco.yaml", end2end=False) # validation

model.export(format="onnx", end2end=False) # export

# Use one-to-one head (default, no NMS required)

yolo predict model=yolo26n.pt source=image.jpg

yolo val model=yolo26n.pt data=coco.yaml

yolo export model=yolo26n.pt format=onnx

# Use one-to-many head (requires NMS)

yolo predict model=yolo26n.pt source=image.jpg end2end=False

yolo val model=yolo26n.pt data=coco.yaml end2end=False

yolo export model=yolo26n.pt format=onnx end2end=False

A escolha depende dos seus requisitos de implementação: use o cabeçote um-para-um para obter velocidade e simplicidade máximas ou o cabeçote um-para-muitos quando a precisão for a principal prioridade.

YOLOE-26: Segmentação de Instância de Vocabulário Aberto

YOLOE-26 integra a arquitetura de alto desempenho YOLO26 com as capacidades de vocabulário aberto da série YOLOE. Ele permite a detecção e segmentação em tempo real de qualquer classe de objeto usando prompts de texto, prompts visuais ou um modo sem prompt para inferência zero-shot, removendo efetivamente as restrições do treinamento de categoria fixa.

Ao aproveitar o design NMS-free e de ponta a ponta do YOLO26, o YOLOE-26 oferece inferência rápida em mundo aberto. Isso o torna uma solução poderosa para aplicações de borda em ambientes dinâmicos onde os objetos de interesse representam um vocabulário amplo e em evolução.

Desempenho

Consulte a documentação de YOLOE para exemplos de uso com esses modelos treinados nos conjuntos de dados Objects365v1, GQA e Flickr30k.

| Modelo | tamanho (pixels) | Tipo de Prompt | mAPminival 50-95(e2e) | mAPminival 50-95 | mAPr | mAPc | mAPf | parâmetros (M) | FLOPs (B) |

|---|---|---|---|---|---|---|---|---|---|

| YOLOE-26n-seg | 640 | Texto/Visual | 23.7 / 20.9 | 24.7 / 21.9 | 20.5 / 17.6 | 24.1 / 22.3 | 26.1 / 22.4 | 4.8 | 6.0 |

| YOLOE-26s-seg | 640 | Texto/Visual | 29.9 / 27.1 | 30.8 / 28.6 | 23.9 / 25.1 | 29.6 / 27.8 | 33.0 / 29.9 | 13.1 | 21.7 |

| YOLOE-26m-seg | 640 | Texto/Visual | 35.4 / 31.3 | 35.4 / 33.9 | 31.1 / 33.4 | 34.7 / 34.0 | 36.9 / 33.8 | 27.9 | 70.1 |

| YOLOE-26l-seg | 640 | Texto/Visual | 36.8 / 33.7 | 37.8 / 36.3 | 35.1 / 37.6 | 37.6 / 36.2 | 38.5 / 36.1 | 32.3 | 88.3 |

| YOLOE-26x-seg | 640 | Texto/Visual | 39.5 / 36.2 | 40.6 / 38.5 | 37.4 / 35.3 | 40.9 / 38.8 | 41.0 / 38.8 | 69.9 | 196.7 |

Consulte a documentação de YOLOE para exemplos de uso com esses modelos treinados nos conjuntos de dados Objects365v1, GQA e Flickr30k.

| Modelo | tamanho (pixels) | mAPminival 50-95(e2e) | mAPminival 50(e2e) | parâmetros (M) | FLOPs (B) |

|---|---|---|---|---|---|

| YOLOE-26n-seg-pf | 640 | 16.6 | 22.7 | 6.5 | 15.8 |

| YOLOE-26s-seg-pf | 640 | 21.4 | 28.6 | 16.2 | 35.5 |

| YOLOE-26m-seg-pf | 640 | 25.7 | 33.6 | 36.2 | 122.1 |

| YOLOE-26l-seg-pf | 640 | 27.2 | 35.4 | 40.6 | 140.4 |

| YOLOE-26x-seg-pf | 640 | 29.9 | 38.7 | 86.3 | 314.4 |

Exemplo de Uso

YOLOE-26 suporta tanto o prompting baseado em texto quanto o visual. Usar prompts é simples—basta passá-los através do predict método, conforme mostrado abaixo:

Exemplo

Prompts de texto permitem especificar as classes que se deseja detect através de descrições textuais. O código a seguir mostra como usar YOLOE-26 para detect pessoas e ônibus em uma imagem:

from ultralytics import YOLO

# Initialize model

model = YOLO("yoloe-26l-seg.pt") # or select yoloe-26s/m-seg.pt for different sizes

# Set text prompt to detect person and bus. You only need to do this once after you load the model.

model.set_classes(["person", "bus"])

# Run detection on the given image

results = model.predict("path/to/image.jpg")

# Show results

results[0].show()

Os prompts visuais permitem que você guie o modelo mostrando exemplos visuais das classes-alvo, em vez de descrevê-las em texto.

import numpy as np

from ultralytics import YOLO

from ultralytics.models.yolo.yoloe import YOLOEVPSegPredictor

# Initialize model

model = YOLO("yoloe-26l-seg.pt")

# Define visual prompts using bounding boxes and their corresponding class IDs.

# Each box highlights an example of the object you want the model to detect.

visual_prompts = dict(

bboxes=np.array(

[

[221.52, 405.8, 344.98, 857.54], # Box enclosing person

[120, 425, 160, 445], # Box enclosing glasses

],

),

cls=np.array(

[

0, # ID to be assigned for person

1, # ID to be assigned for glasses

]

),

)

# Run inference on an image, using the provided visual prompts as guidance

results = model.predict(

"ultralytics/assets/bus.jpg",

visual_prompts=visual_prompts,

predictor=YOLOEVPSegPredictor,

)

# Show results

results[0].show()

YOLOE-26 inclui variantes sem prompt que vêm com um vocabulário integrado. Esses modelos não exigem prompts e funcionam como modelos YOLO tradicionais. Em vez de depender de rótulos fornecidos pelo usuário ou exemplos visuais, eles detect objetos de uma lista predefinida de 4.585 classes com base no conjunto de tags usado pelo Recognize Anything Model Plus (RAM++).

from ultralytics import YOLO

# Initialize model

model = YOLO("yoloe-26l-seg-pf.pt")

# Run prediction. No prompts required.

results = model.predict("path/to/image.jpg")

# Show results

results[0].show()

Para uma análise aprofundada das técnicas de prompting, treinamento do zero e exemplos completos de uso, visite a Documentação YOLOE.

Citações e Agradecimentos

Publicação Ultralytics YOLO26

A Ultralytics não publicou um artigo de pesquisa formal para o YOLO26 devido à natureza de rápida evolução dos modelos. Em vez disso, focamos em fornecer modelos de ponta e torná-los fáceis de usar. Para obter as atualizações mais recentes sobre recursos, arquiteturas e uso do YOLO, visite nosso repositório GitHub e documentação.

Se você usar o YOLO26 ou outro software Ultralytics em seu trabalho, cite-o como:

@software{yolo26_ultralytics,

author = {Glenn Jocher and Jing Qiu},

title = {Ultralytics YOLO26},

version = {26.0.0},

year = {2026},

url = {https://github.com/ultralytics/ultralytics},

orcid = {0000-0001-5950-6979, 0000-0003-3783-7069},

license = {AGPL-3.0}

}

DOI pendente. O YOLO26 está disponível sob as licenças AGPL-3.0 e Enterprise.

FAQ

Quais são as principais melhorias no YOLO26 em comparação com o YOLO11?

- Remoção de DFL: Simplifica a exportação e expande a compatibilidade de borda

- Inferência End-to-End Livre de NMS: Elimina o NMS para uma implementação mais rápida e simples.

- ProgLoss + STAL: Aumenta a precisão, especialmente em objetos pequenos

- Otimizador MuSGD: Combina SGD e Muon (inspirado no Kimi K2 da Moonshot) para um treinamento mais estável e eficiente

- Até 43% Mais Rápido na Inferência de CPU: Ganhos de desempenho importantes para dispositivos somente com CPU

Quais tarefas o YOLO26 suporta?

YOLO26 é uma família de modelos unificada, oferecendo suporte de ponta a ponta para múltiplas tarefas de visão computacional:

- Detecção de Objetos

- Segmentação de Instância

- Classificação de Imagem

- Estimativa de Pose

- Detecção de Objetos Orientados (OBB)

Cada variante de tamanho (n, s, m, l, x) suporta todas as tarefas, além de versões de vocabulário aberto via YOLOE-26.

Por que o YOLO26 é otimizado para implantação em edge?

O YOLO26 oferece desempenho de ponta com:

- Inferência de CPU até 43% mais rápida

- Tamanho do modelo e espaço de memória reduzidos

- Arquitetura simplificada para compatibilidade (sem DFL, sem NMS)

- Formatos de exportação flexíveis, incluindo TensorRT, ONNX, CoreML, TFLite e OpenVINO

Como começo a usar o YOLO26?

Os modelos YOLO26 foram lançados em 14 de janeiro de 2026 e estão disponíveis para download. Instale ou atualize o ultralytics pacote e carregue um modelo:

from ultralytics import YOLO

# Load a pretrained YOLO26 nano model

model = YOLO("yolo26n.pt")

# Run inference on an image

results = model("image.jpg")

Consulte a seção Exemplos de Uso para obter instruções de treinamento, validação e exportação.