Экспорт в Intel OpenVINO

В этом руководстве мы рассматриваем экспорт моделей YOLO26 в формат OpenVINO, который может обеспечить до 3-кратного ускорения CPU, а также ускорение инференса YOLO на оборудовании Intel GPU и NPU.

OpenVINO, сокращение от Open Visual Inference & Neural Network Optimization toolkit, — это комплексный набор инструментов для оптимизации и развертывания моделей логического вывода ИИ. Несмотря на то, что в названии присутствует Visual, OpenVINO также поддерживает различные дополнительные задачи, включая язык, аудио, временные ряды и т. д.

Смотреть: Как экспортировать Ultralytics YOLO26 в формат Intel OpenVINO для более быстрого инференса 🚀

Примеры использования

Экспортируйте модель YOLO26n в формат OpenVINO и выполните инференс с экспортированной моделью.

Пример

from ultralytics import YOLO

# Load a YOLO26n PyTorch model

model = YOLO("yolo26n.pt")

# Export the model

model.export(format="openvino") # creates 'yolo26n_openvino_model/'

# Load the exported OpenVINO model

ov_model = YOLO("yolo26n_openvino_model/")

# Run inference

results = ov_model("https://ultralytics.com/images/bus.jpg")

# Run inference with specified device, available devices: ["intel:gpu", "intel:npu", "intel:cpu"]

results = ov_model("https://ultralytics.com/images/bus.jpg", device="intel:gpu")

# Export a YOLO26n PyTorch model to OpenVINO format

yolo export model=yolo26n.pt format=openvino # creates 'yolo26n_openvino_model/'

# Run inference with the exported model

yolo predict model=yolo26n_openvino_model source='https://ultralytics.com/images/bus.jpg'

# Run inference with specified device, available devices: ["intel:gpu", "intel:npu", "intel:cpu"]

yolo predict model=yolo26n_openvino_model source='https://ultralytics.com/images/bus.jpg' device="intel:gpu"

Аргументы экспорта

| Аргумент | Тип | По умолчанию | Описание |

|---|---|---|---|

format | str | 'openvino' | Целевой формат для экспортируемой модели, определяющий совместимость с различными средами развертывания. |

imgsz | int или tuple | 640 | Желаемый размер изображения для ввода модели. Может быть целым числом для квадратных изображений или кортежем (height, width) для конкретных размеров. |

half | bool | False | Включает квантование FP16 (полуточной точности), уменьшая размер модели и потенциально ускоряя вывод на поддерживаемом оборудовании. |

int8 | bool | False | Активирует квантование INT8, дополнительно сжимая модель и ускоряя вывод с минимальной потерей точности, в основном для периферийных устройств. |

dynamic | bool | False | Обеспечивает динамические размеры входных данных, повышая гибкость при обработке различных размеров изображений. |

nms | bool | False | Добавляет Non-Maximum Suppression (NMS) (Немаксимальное подавление), необходимый для точной и эффективной постобработки обнаружения. |

batch | int | 1 | Указывает размер пакета для модели экспорта или максимальное количество изображений, которые экспортируемая модель будет обрабатывать одновременно в режиме predict режиме. |

data | str | 'coco8.yaml' | Путь к dataset файл конфигурации (по умолчанию: coco8.yaml), необходимые для квантования. |

fraction | float | 1.0 | Указывает долю набора данных, используемую для калибровки квантования INT8. Позволяет проводить калибровку на подмножестве полного набора данных, что полезно для экспериментов или при ограниченности ресурсов. Если не указано при включенном INT8, будет использован полный набор данных. |

Для получения более подробной информации о процессе экспорта посетите страницу документации Ultralytics по экспорту.

Предупреждение

OpenVINO™ совместим с большинством процессоров Intel®, но для обеспечения оптимальной производительности:

Проверьте поддержку OpenVINO™. Узнайте, официально ли поддерживается ваш чип Intel® технологией OpenVINO™, используя список совместимости Intel.

Определите свой ускоритель. Узнайте, включает ли ваш процессор интегрированный NPU (нейронный процессор) или GPU (интегрированный GPU), обратившись к руководству по оборудованию Intel.

Установите последние драйверы. Если ваш чип поддерживает NPU или GPU, но OpenVINO™ его не detect, возможно, вам потребуется установить или обновить соответствующие драйверы. Следуйте инструкциям по установке драйверов, чтобы включить полное ускорение.

Выполнив эти три шага, вы можете обеспечить оптимальную работу OpenVINO™ на вашем оборудовании Intel®.

Преимущества OpenVINO

- Производительность: OpenVINO обеспечивает высокую производительность логического вывода, используя мощность CPU Intel, интегрированных и дискретных GPU и FPGA.

- Поддержка гетерогенного выполнения: OpenVINO предоставляет API для однократной записи и развертывания на любом поддерживаемом оборудовании Intel (CPU, GPU, FPGA, VPU и т. д.).

- Оптимизатор моделей: OpenVINO предоставляет оптимизатор моделей, который импортирует, преобразует и оптимизирует модели из популярных фреймворков глубокого обучения, таких как PyTorch, TensorFlow, TensorFlow Lite, Keras, ONNX, PaddlePaddle и Caffe.

- Простота использования: Инструментарий поставляется с более чем 80 обучающими блокнотами (включая оптимизацию YOLOv8), обучающими различным аспектам инструментария.

Структура экспорта OpenVINO

При экспорте модели в формат OpenVINO получается каталог, содержащий следующее:

- XML-файл: Описывает топологию сети.

- BIN-файл: Содержит двоичные данные весов и смещений.

- Файл сопоставления: Содержит соответствие исходных выходных тензоров модели именам тензоров OpenVINO.

Вы можете использовать эти файлы для запуска inference с OpenVINO Inference Engine.

Использование экспорта OpenVINO при развертывании

После успешного экспорта вашей модели в формат OpenVINO у вас есть два основных варианта запуска инференса:

Используйте

ultralyticspackage, который предоставляет высокоуровневый API и оборачивает OpenVINO Runtime.Использовать нативный

openvinopackage для более продвинутого или индивидуального контроля над поведением инференса.

Логический вывод с Ultralytics

Пакет ultralytics позволяет легко запускать inference с использованием экспортированной модели OpenVINO с помощью метода predict. Вы также можете указать целевое устройство (например, intel:gpu, intel:npu, intel:cpu) используя аргумент device.

from ultralytics import YOLO

# Load the exported OpenVINO model

ov_model = YOLO("yolo26n_openvino_model/") # the path of your exported OpenVINO model

# Run inference with the exported model

ov_model.predict(device="intel:gpu") # specify the device you want to run inference on

Этот подход идеально подходит для быстрого прототипирования или развертывания, когда вам не нужен полный контроль над конвейером инференса.

Логический вывод с OpenVINO Runtime

OpenVINO Runtime предоставляет унифицированный API для инференса на всем поддерживаемом оборудовании Intel. Он также предоставляет расширенные возможности, такие как балансировка нагрузки на оборудовании Intel и асинхронное выполнение. Для получения дополнительной информации о выполнении инференса обратитесь к ноутбукам YOLO26.

Помните, что вам понадобятся файлы XML и BIN, а также любые специфические для приложения параметры, такие как размер входных данных, коэффициент масштабирования для нормализации и т. д., чтобы правильно настроить и использовать модель со средой выполнения.

В вашем приложении для развертывания обычно выполняются следующие шаги:

- Инициализировать OpenVINO путем создания

core = Core(). - Загрузите модель, используя

core.read_model()метод. - Скомпилируйте модель, используя

core.compile_model()функцию. - Подготовьте входные данные (изображение, текст, аудио и т. д.).

- Запустите inference, используя

compiled_model(input_data).

Для получения более подробных инструкций и фрагментов кода обратитесь к документации OpenVINO или учебнику по API.

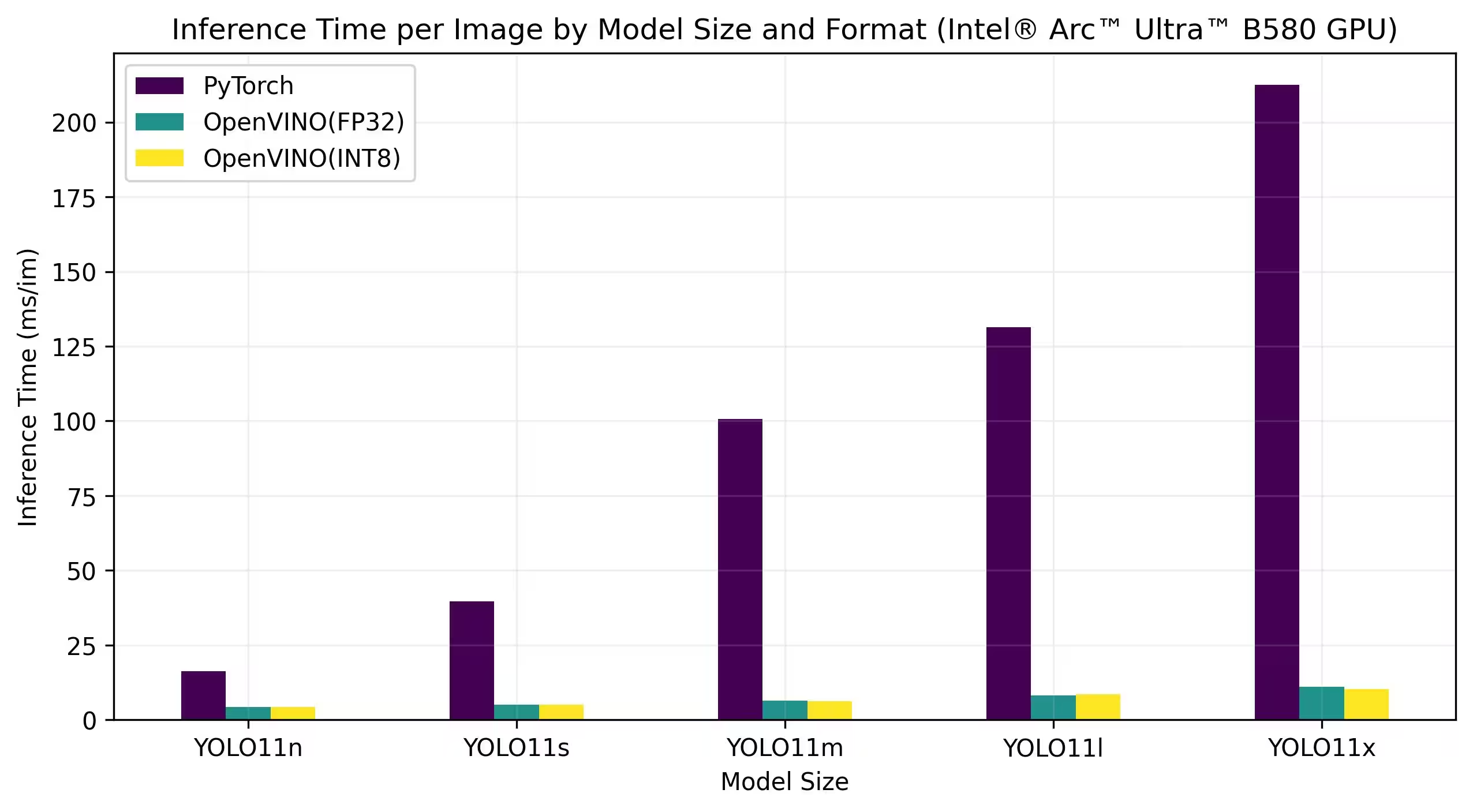

Бенчмарки OpenVINO YOLO11

Команда Ultralytics провела сравнительный анализ YOLO11 для различных форматов моделей и точности, оценивая скорость и точность на различных устройствах Intel, совместимых с OpenVINO.

Примечание

Приведенные ниже результаты бенчмаркинга предназначены для справки и могут варьироваться в зависимости от точной конфигурации аппаратного и программного обеспечения системы, а также от текущей рабочей нагрузки системы во время проведения бенчмарков.

Все тесты запускаются с openvino Версия python-пакета 2025.1.0.

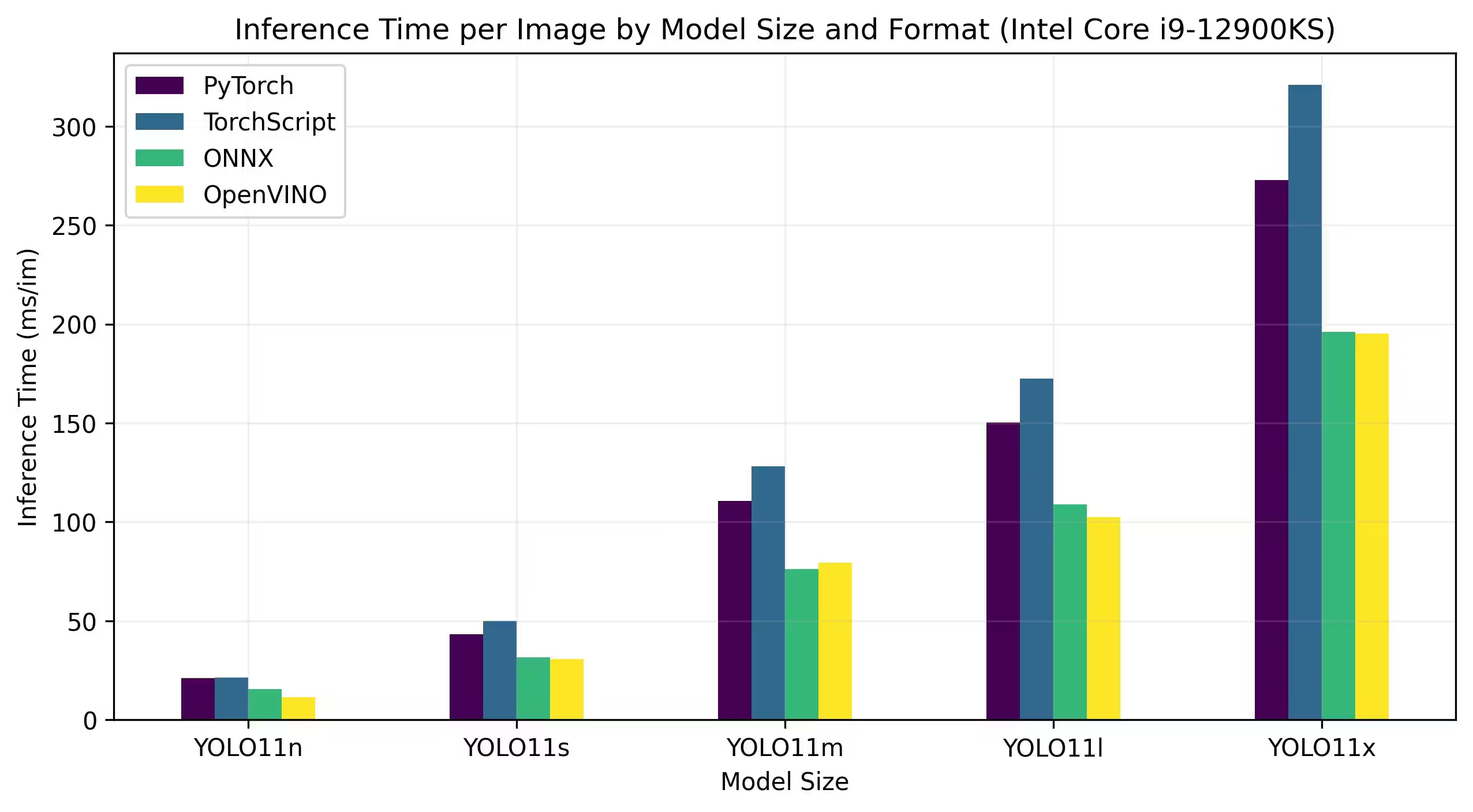

Intel Core CPU

Intel® Core® series — это линейка высокопроизводительных процессоров от Intel. В линейку входят Core i3 (начальный уровень), Core i5 (средний уровень), Core i7 (высокий уровень) и Core i9 (экстремальная производительность). Каждая серия предназначена для различных вычислительных потребностей и бюджетов, от повседневных задач до ресурсоемких профессиональных рабочих нагрузок. С каждым новым поколением вносятся улучшения в производительность, энергоэффективность и функциональность.

Приведенные ниже тесты запускаются на 12th Gen Intel® Core® i9-12900KS CPU с точностью FP32.

Подробные результаты эталонного тестирования

| Модель | Формат | Статус | Размер (МБ) | metrics/mAP50-95(B) | Время инференса (мс/изобр.) |

|---|---|---|---|---|---|

| YOLO11n | PyTorch | ✅ | 5.4 | 0.5071 | 21.00 |

| YOLO11n | TorchScript | ✅ | 10.5 | 0.5077 | 21.39 |

| YOLO11n | ONNX | ✅ | 10.2 | 0.5077 | 15.55 |

| YOLO11n | OpenVINO | ✅ | 10.4 | 0.5077 | 11.49 |

| YOLO11s | PyTorch | ✅ | 18.4 | 0.5770 | 43.16 |

| YOLO11s | TorchScript | ✅ | 36.6 | 0.5781 | 50.06 |

| YOLO11s | ONNX | ✅ | 36.3 | 0.5781 | 31.53 |

| YOLO11s | OpenVINO | ✅ | 36.4 | 0.5781 | 30.82 |

| YOLO11m | PyTorch | ✅ | 38.8 | 0.6257 | 110.60 |

| YOLO11m | TorchScript | ✅ | 77.3 | 0.6306 | 128.09 |

| YOLO11m | ONNX | ✅ | 76.9 | 0.6306 | 76.06 |

| YOLO11m | OpenVINO | ✅ | 77.1 | 0.6306 | 79.38 |

| YOLO11l | PyTorch | ✅ | 49.0 | 0.6367 | 150.38 |

| YOLO11l | TorchScript | ✅ | 97.7 | 0.6408 | 172.57 |

| YOLO11l | ONNX | ✅ | 97.0 | 0.6408 | 108.91 |

| YOLO11l | OpenVINO | ✅ | 97.3 | 0.6408 | 102.30 |

| YOLO11x | PyTorch | ✅ | 109.3 | 0.6989 | 272.72 |

| YOLO11x | TorchScript | ✅ | 218.1 | 0.6900 | 320.86 |

| YOLO11x | ONNX | ✅ | 217.5 | 0.6900 | 196.20 |

| YOLO11x | OpenVINO | ✅ | 217.8 | 0.6900 | 195.32 |

Intel® Core™ Ultra

Серия Intel® Core™ Ultra™ представляет собой новый эталон в высокопроизводительных вычислениях, разработанный для удовлетворения растущих потребностей современных пользователей — от геймеров и создателей контента до профессионалов, использующих ИИ. Эта линейка нового поколения — больше, чем традиционная серия CPU; она сочетает в себе мощные ядра CPU, интегрированные высокопроизводительные возможности GPU и выделенный блок нейронной обработки (NPU) в одном чипе, предлагая унифицированное решение для разнообразных и интенсивных вычислительных нагрузок.

В основе архитектуры Intel® Core Ultra™ лежит гибридная конструкция, обеспечивающая исключительную производительность при выполнении традиционных задач обработки, рабочих нагрузок с ускорением GPU и операций, управляемых искусственным интеллектом. Включение NPU улучшает инференс AI на устройстве, обеспечивая более быстрое и эффективное машинное обучение и обработку данных в широком спектре приложений.

Семейство Core Ultra™ включает в себя различные модели, адаптированные для различных потребностей в производительности, с вариантами, варьирующимися от энергоэффективных конструкций до мощных вариантов, отмеченных обозначением "H" — идеально подходящих для ноутбуков и компактных форм-факторов, требующих серьезной вычислительной мощности. Во всей линейке пользователи получают выгоду от синергии интеграции CPU, GPU и NPU, обеспечивающей замечательную эффективность, скорость реагирования и возможности многозадачности.

В рамках непрерывных инноваций Intel серия Core Ultra™ устанавливает новый стандарт для вычислений, ориентированных на будущее. Благодаря множеству доступных моделей и новым разработкам, эта серия подчеркивает стремление Intel предоставлять передовые решения для следующего поколения интеллектуальных устройств с расширенными возможностями искусственного интеллекта.

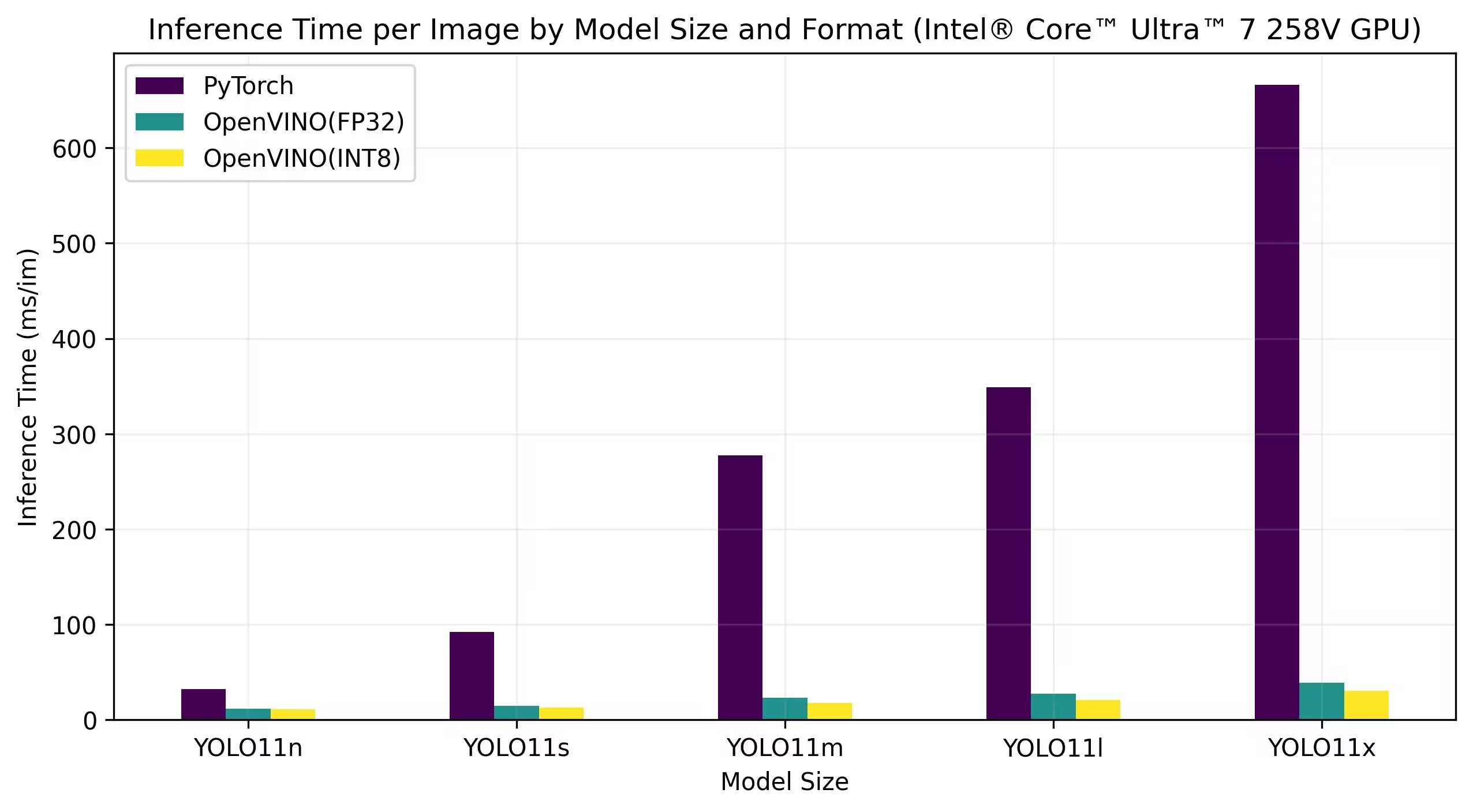

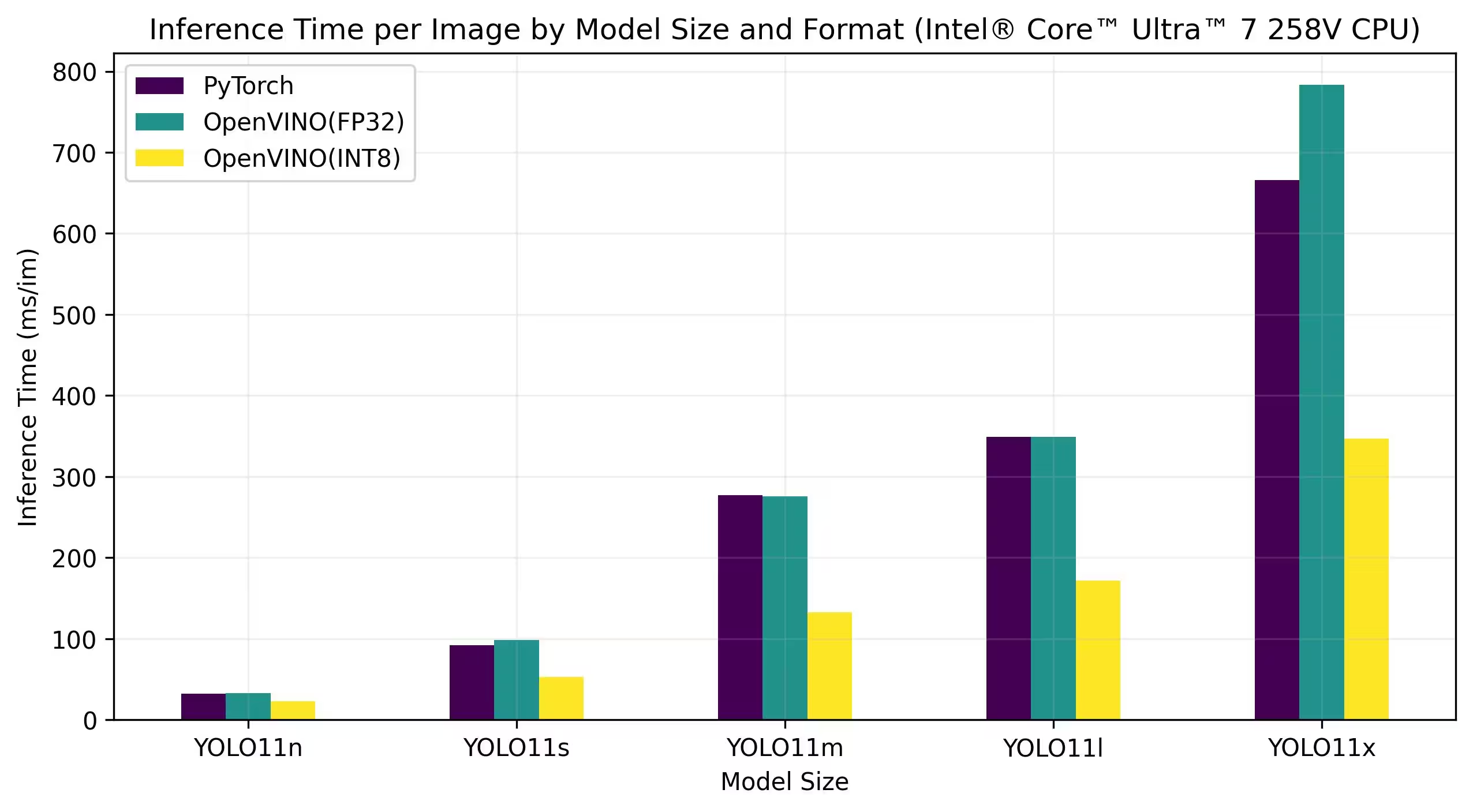

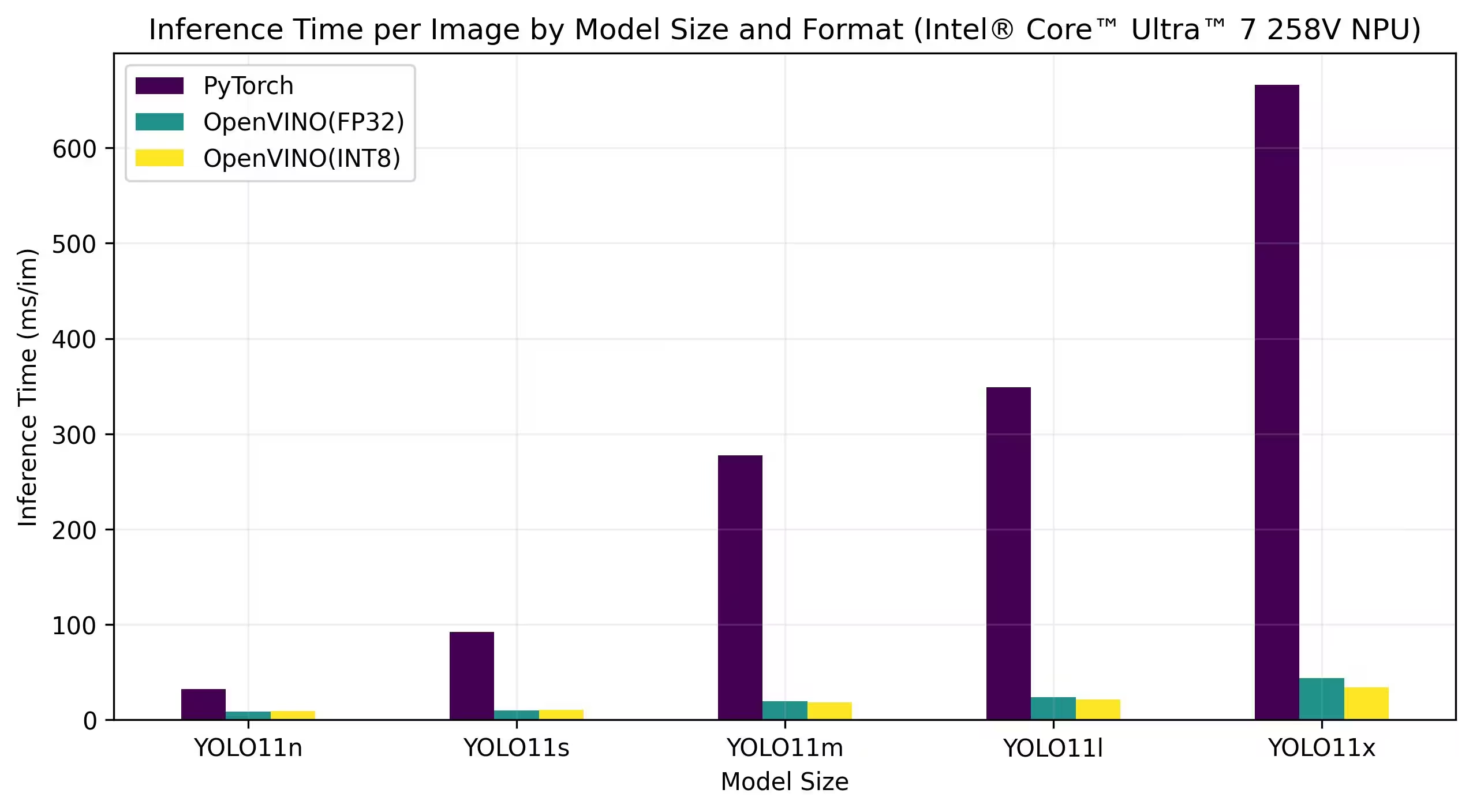

Приведенные ниже тесты производительности выполнялись на Intel® Core™ Ultra™ 7 258V и Intel® Core™ Ultra™ 7 265K с точностью FP32 и INT8.

Intel® Core™ Ultra™ 7 258V

Оценка производительности

Подробные результаты эталонного тестирования

| Модель | Формат | Точность | Статус | Размер (МБ) | metrics/mAP50-95(B) | Время инференса (мс/изобр.) |

|---|---|---|---|---|---|---|

| YOLO11n | PyTorch | FP32 | ✅ | 5.4 | 0.5052 | 32.27 |

| YOLO11n | OpenVINO | FP32 | ✅ | 10.4 | 0.5068 | 11.84 |

| YOLO11n | OpenVINO | INT8 | ✅ | 3.3 | 0.4969 | 11.24 |

| YOLO11s | PyTorch | FP32 | ✅ | 18.4 | 0.5776 | 92.09 |

| YOLO11s | OpenVINO | FP32 | ✅ | 36.4 | 0.5797 | 14.82 |

| YOLO11s | OpenVINO | INT8 | ✅ | 9.8 | 0.5751 | 12.88 |

| YOLO11m | PyTorch | FP32 | ✅ | 38.8 | 0.6262 | 277.24 |

| YOLO11m | OpenVINO | FP32 | ✅ | 77.1 | 0.6306 | 22.94 |

| YOLO11m | OpenVINO | INT8 | ✅ | 20.2 | 0.6126 | 17.85 |

| YOLO11l | PyTorch | FP32 | ✅ | 49.0 | 0.6361 | 348.97 |

| YOLO11l | OpenVINO | FP32 | ✅ | 97.3 | 0.6365 | 27.34 |

| YOLO11l | OpenVINO | INT8 | ✅ | 25.7 | 0.6242 | 20.83 |

| YOLO11x | PyTorch | FP32 | ✅ | 109.3 | 0.6984 | 666.07 |

| YOLO11x | OpenVINO | FP32 | ✅ | 217.8 | 0.6890 | 39.09 |

| YOLO11x | OpenVINO | INT8 | ✅ | 55.9 | 0.6856 | 30.60 |

Подробные результаты эталонного тестирования

| Модель | Формат | Точность | Статус | Размер (МБ) | metrics/mAP50-95(B) | Время инференса (мс/изобр.) |

|---|---|---|---|---|---|---|

| YOLO11n | PyTorch | FP32 | ✅ | 5.4 | 0.5052 | 32.27 |

| YOLO11n | OpenVINO | FP32 | ✅ | 10.4 | 0.5077 | 32.55 |

| YOLO11n | OpenVINO | INT8 | ✅ | 3.3 | 0.4980 | 22.98 |

| YOLO11s | PyTorch | FP32 | ✅ | 18.4 | 0.5776 | 92.09 |

| YOLO11s | OpenVINO | FP32 | ✅ | 36.4 | 0.5782 | 98.38 |

| YOLO11s | OpenVINO | INT8 | ✅ | 9.8 | 0.5745 | 52.84 |

| YOLO11m | PyTorch | FP32 | ✅ | 38.8 | 0.6262 | 277.24 |

| YOLO11m | OpenVINO | FP32 | ✅ | 77.1 | 0.6307 | 275.74 |

| YOLO11m | OpenVINO | INT8 | ✅ | 20.2 | 0.6172 | 132.63 |

| YOLO11l | PyTorch | FP32 | ✅ | 49.0 | 0.6361 | 348.97 |

| YOLO11l | OpenVINO | FP32 | ✅ | 97.3 | 0.6361 | 348.97 |

| YOLO11l | OpenVINO | INT8 | ✅ | 25.7 | 0.6240 | 171.36 |

| YOLO11x | PyTorch | FP32 | ✅ | 109.3 | 0.6984 | 666.07 |

| YOLO11x | OpenVINO | FP32 | ✅ | 217.8 | 0.6900 | 783.16 |

| YOLO11x | OpenVINO | INT8 | ✅ | 55.9 | 0.6890 | 346.82 |

Подробные результаты эталонного тестирования

| Модель | Формат | Точность | Статус | Размер (МБ) | metrics/mAP50-95(B) | Время инференса (мс/изобр.) |

|---|---|---|---|---|---|---|

| YOLO11n | PyTorch | FP32 | ✅ | 5.4 | 0.5052 | 32.27 |

| YOLO11n | OpenVINO | FP32 | ✅ | 10.4 | 0.5085 | 8.33 |

| YOLO11n | OpenVINO | INT8 | ✅ | 3.3 | 0.5019 | 8.91 |

| YOLO11s | PyTorch | FP32 | ✅ | 18.4 | 0.5776 | 92.09 |

| YOLO11s | OpenVINO | FP32 | ✅ | 36.4 | 0.5788 | 9.72 |

| YOLO11s | OpenVINO | INT8 | ✅ | 9.8 | 0.5710 | 10.58 |

| YOLO11m | PyTorch | FP32 | ✅ | 38.8 | 0.6262 | 277.24 |

| YOLO11m | OpenVINO | FP32 | ✅ | 77.1 | 0.6301 | 19.41 |

| YOLO11m | OpenVINO | INT8 | ✅ | 20.2 | 0.6124 | 18.26 |

| YOLO11l | PyTorch | FP32 | ✅ | 49.0 | 0.6361 | 348.97 |

| YOLO11l | OpenVINO | FP32 | ✅ | 97.3 | 0.6362 | 23.70 |

| YOLO11l | OpenVINO | INT8 | ✅ | 25.7 | 0.6240 | 21.40 |

| YOLO11x | PyTorch | FP32 | ✅ | 109.3 | 0.6984 | 666.07 |

| YOLO11x | OpenVINO | FP32 | ✅ | 217.8 | 0.6892 | 43.91 |

| YOLO11x | OpenVINO | INT8 | ✅ | 55.9 | 0.6890 | 34.04 |

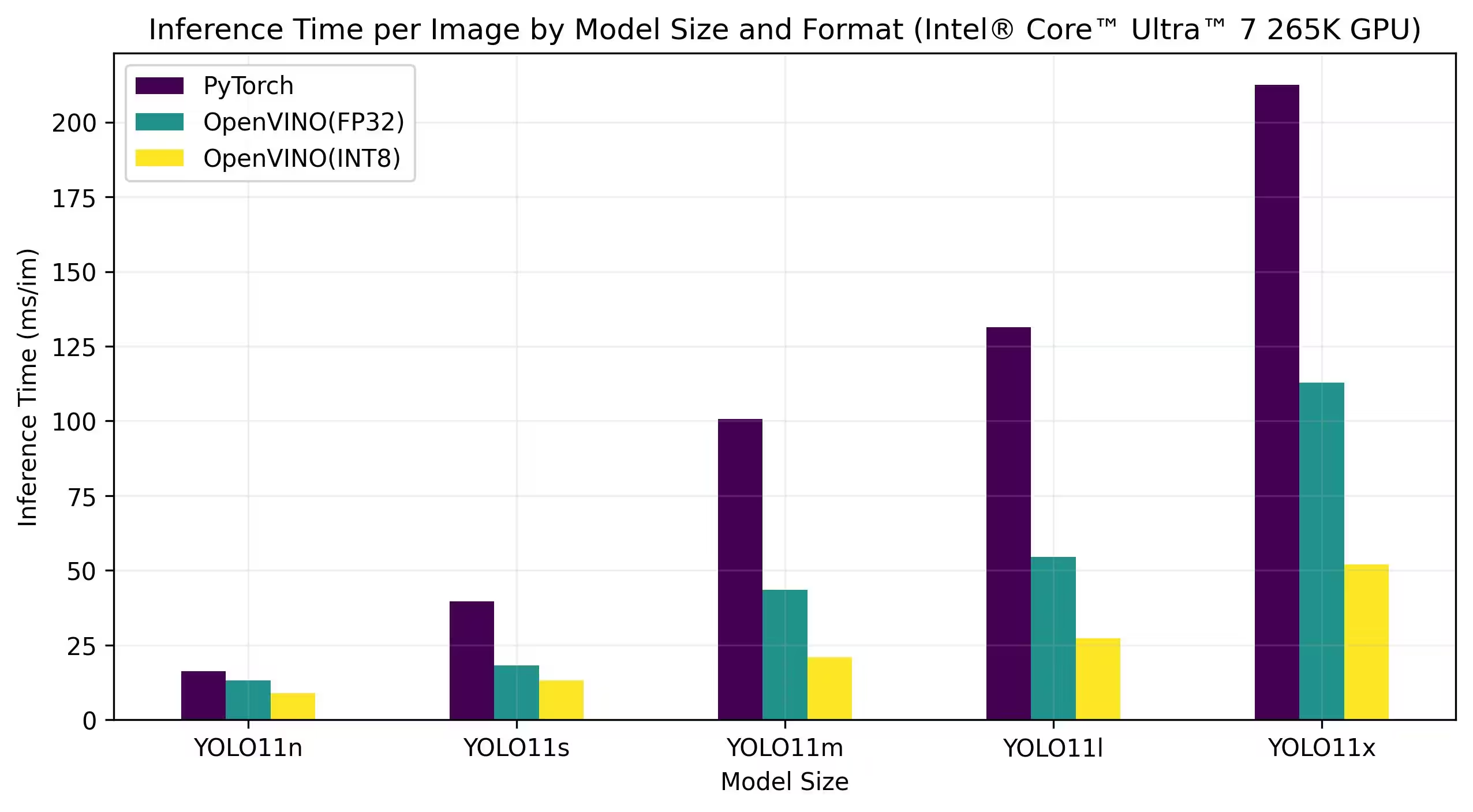

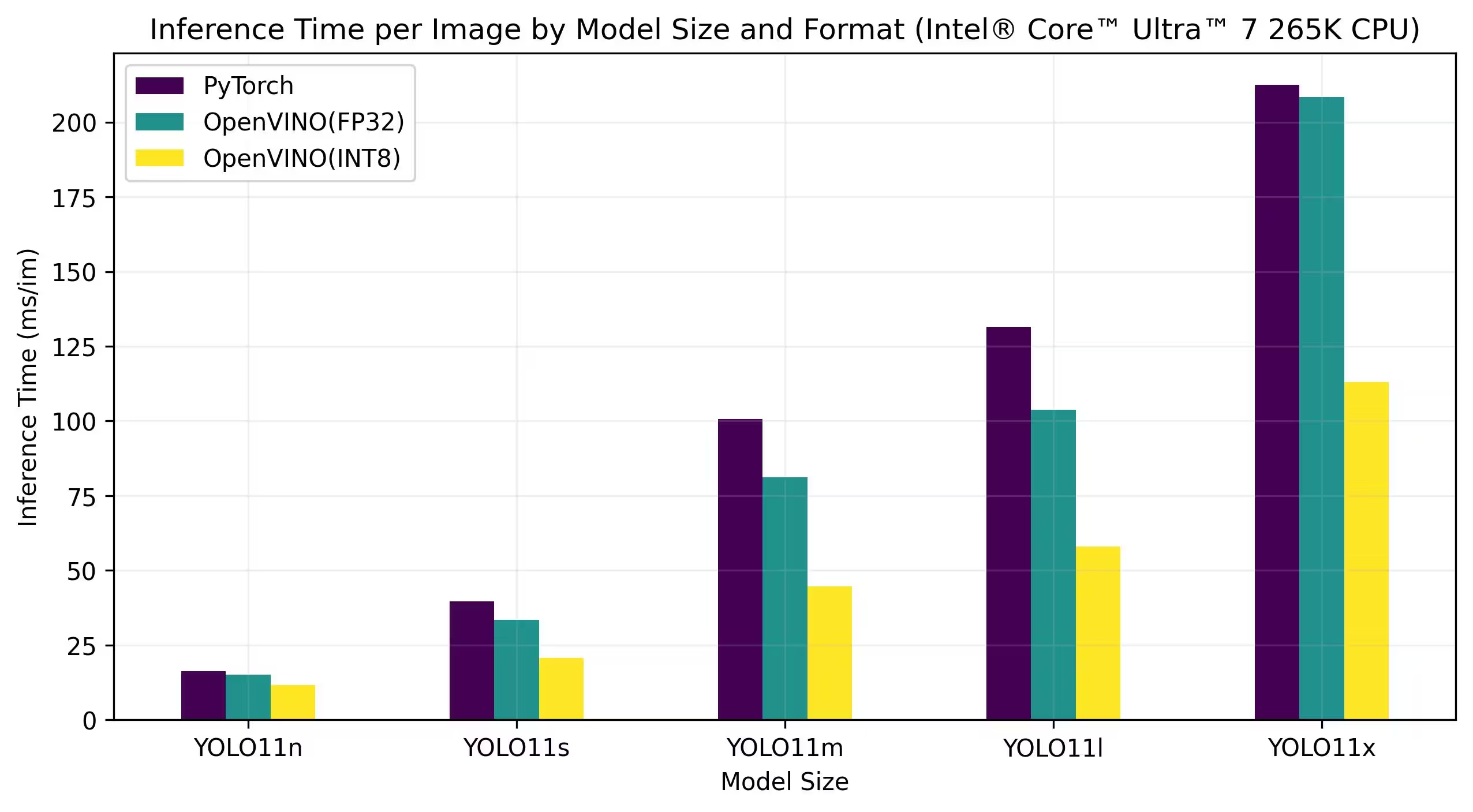

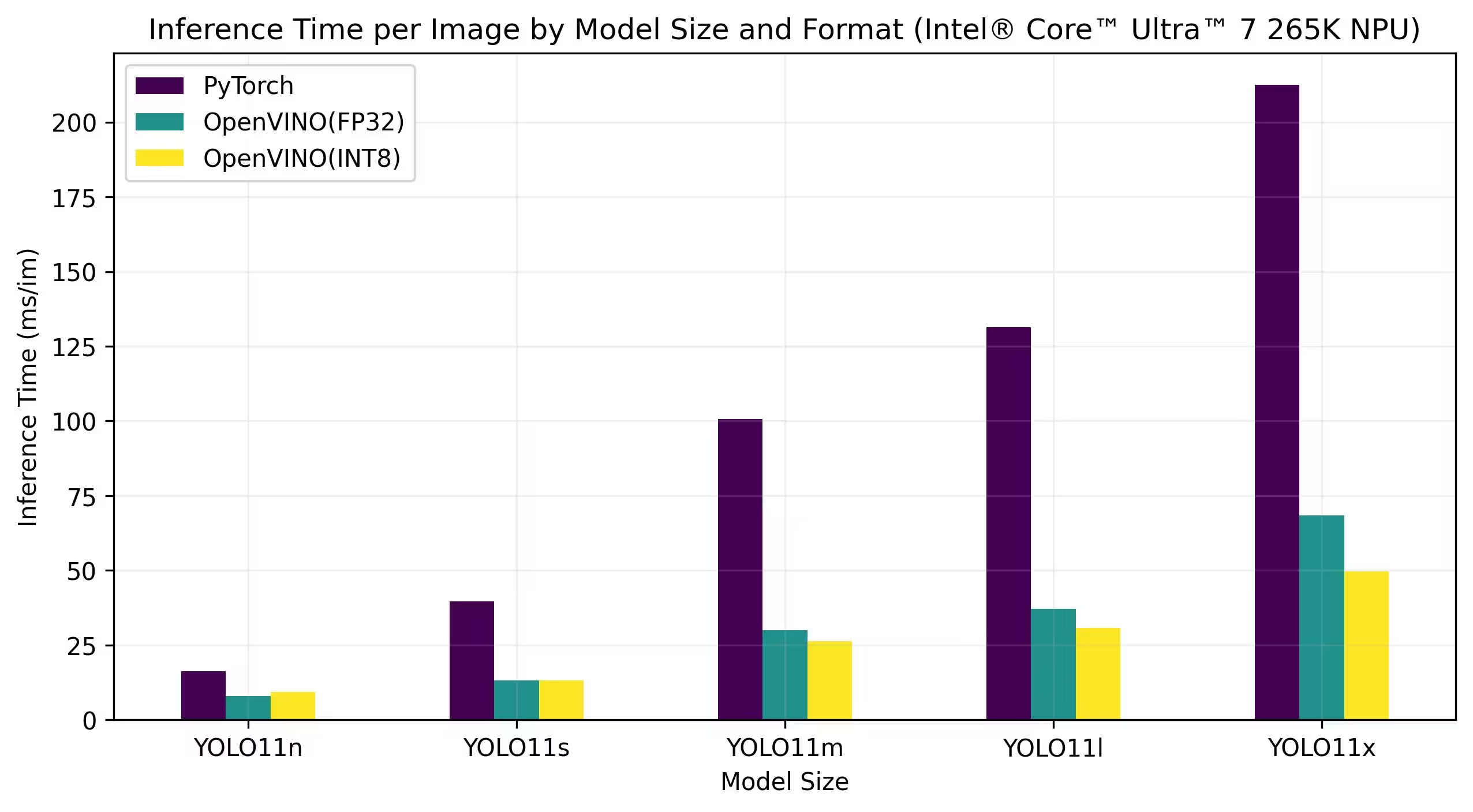

Intel® Core™ Ultra™ 7 265K

Оценка производительности

Подробные результаты эталонного тестирования

| Модель | Формат | Точность | Статус | Размер (МБ) | metrics/mAP50-95(B) | Время инференса (мс/изобр.) |

|---|---|---|---|---|---|---|

| YOLO11n | PyTorch | FP32 | ✅ | 5.4 | 0.5072 | 16.29 |

| YOLO11n | OpenVINO | FP32 | ✅ | 10.4 | 0.5079 | 13.13 |

| YOLO11n | OpenVINO | INT8 | ✅ | 3.3 | 0.4976 | 8.86 |

| YOLO11s | PyTorch | FP32 | ✅ | 18.4 | 0.5771 | 39.61 |

| YOLO11s | OpenVINO | FP32 | ✅ | 36.4 | 0.5808 | 18.26 |

| YOLO11s | OpenVINO | INT8 | ✅ | 9.8 | 0.5726 | 13.24 |

| YOLO11m | PyTorch | FP32 | ✅ | 38.8 | 0.6258 | 100.65 |

| YOLO11m | OpenVINO | FP32 | ✅ | 77.1 | 0.6310 | 43.50 |

| YOLO11m | OpenVINO | INT8 | ✅ | 20.2 | 0.6137 | 20.90 |

| YOLO11l | PyTorch | FP32 | ✅ | 49.0 | 0.6367 | 131.37 |

| YOLO11l | OpenVINO | FP32 | ✅ | 97.3 | 0.6371 | 54.52 |

| YOLO11l | OpenVINO | INT8 | ✅ | 25.7 | 0.6226 | 27.36 |

| YOLO11x | PyTorch | FP32 | ✅ | 109.3 | 0.6990 | 212.45 |

| YOLO11x | OpenVINO | FP32 | ✅ | 217.8 | 0.6884 | 112.76 |

| YOLO11x | OpenVINO | INT8 | ✅ | 55.9 | 0.6900 | 52.06 |

Подробные результаты эталонного тестирования

| Модель | Формат | Точность | Статус | Размер (МБ) | metrics/mAP50-95(B) | Время инференса (мс/изобр.) |

|---|---|---|---|---|---|---|

| YOLO11n | PyTorch | FP32 | ✅ | 5.4 | 0.5072 | 16.29 |

| YOLO11n | OpenVINO | FP32 | ✅ | 10.4 | 0.5077 | 15.04 |

| YOLO11n | OpenVINO | INT8 | ✅ | 3.3 | 0.4980 | 11.60 |

| YOLO11s | PyTorch | FP32 | ✅ | 18.4 | 0.5771 | 39.61 |

| YOLO11s | OpenVINO | FP32 | ✅ | 36.4 | 0.5782 | 33.45 |

| YOLO11s | OpenVINO | INT8 | ✅ | 9.8 | 0.5745 | 20.64 |

| YOLO11m | PyTorch | FP32 | ✅ | 38.8 | 0.6258 | 100.65 |

| YOLO11m | OpenVINO | FP32 | ✅ | 77.1 | 0.6307 | 81.15 |

| YOLO11m | OpenVINO | INT8 | ✅ | 20.2 | 0.6172 | 44.63 |

| YOLO11l | PyTorch | FP32 | ✅ | 49.0 | 0.6367 | 131.37 |

| YOLO11l | OpenVINO | FP32 | ✅ | 97.3 | 0.6409 | 103.77 |

| YOLO11l | OpenVINO | INT8 | ✅ | 25.7 | 0.6240 | 58.00 |

| YOLO11x | PyTorch | FP32 | ✅ | 109.3 | 0.6990 | 212.45 |

| YOLO11x | OpenVINO | FP32 | ✅ | 217.8 | 0.6900 | 208.37 |

| YOLO11x | OpenVINO | INT8 | ✅ | 55.9 | 0.6897 | 113.04 |

Подробные результаты эталонного тестирования

| Модель | Формат | Точность | Статус | Размер (МБ) | metrics/mAP50-95(B) | Время инференса (мс/изобр.) |

|---|---|---|---|---|---|---|

| YOLO11n | PyTorch | FP32 | ✅ | 5.4 | 0.5072 | 16.29 |

| YOLO11n | OpenVINO | FP32 | ✅ | 10.4 | 0.5075 | 8.02 |

| YOLO11n | OpenVINO | INT8 | ✅ | 3.3 | 0.3656 | 9.28 |

| YOLO11s | PyTorch | FP32 | ✅ | 18.4 | 0.5771 | 39.61 |

| YOLO11s | OpenVINO | FP32 | ✅ | 36.4 | 0.5801 | 13.12 |

| YOLO11s | OpenVINO | INT8 | ✅ | 9.8 | 0.5686 | 13.12 |

| YOLO11m | PyTorch | FP32 | ✅ | 38.8 | 0.6258 | 100.65 |

| YOLO11m | OpenVINO | FP32 | ✅ | 77.1 | 0.6310 | 29.88 |

| YOLO11m | OpenVINO | INT8 | ✅ | 20.2 | 0.6111 | 26.32 |

| YOLO11l | PyTorch | FP32 | ✅ | 49.0 | 0.6367 | 131.37 |

| YOLO11l | OpenVINO | FP32 | ✅ | 97.3 | 0.6356 | 37.08 |

| YOLO11l | OpenVINO | INT8 | ✅ | 25.7 | 0.6245 | 30.81 |

| YOLO11x | PyTorch | FP32 | ✅ | 109.3 | 0.6990 | 212.45 |

| YOLO11x | OpenVINO | FP32 | ✅ | 217.8 | 0.6894 | 68.48 |

| YOLO11x | OpenVINO | INT8 | ✅ | 55.9 | 0.6417 | 49.76 |

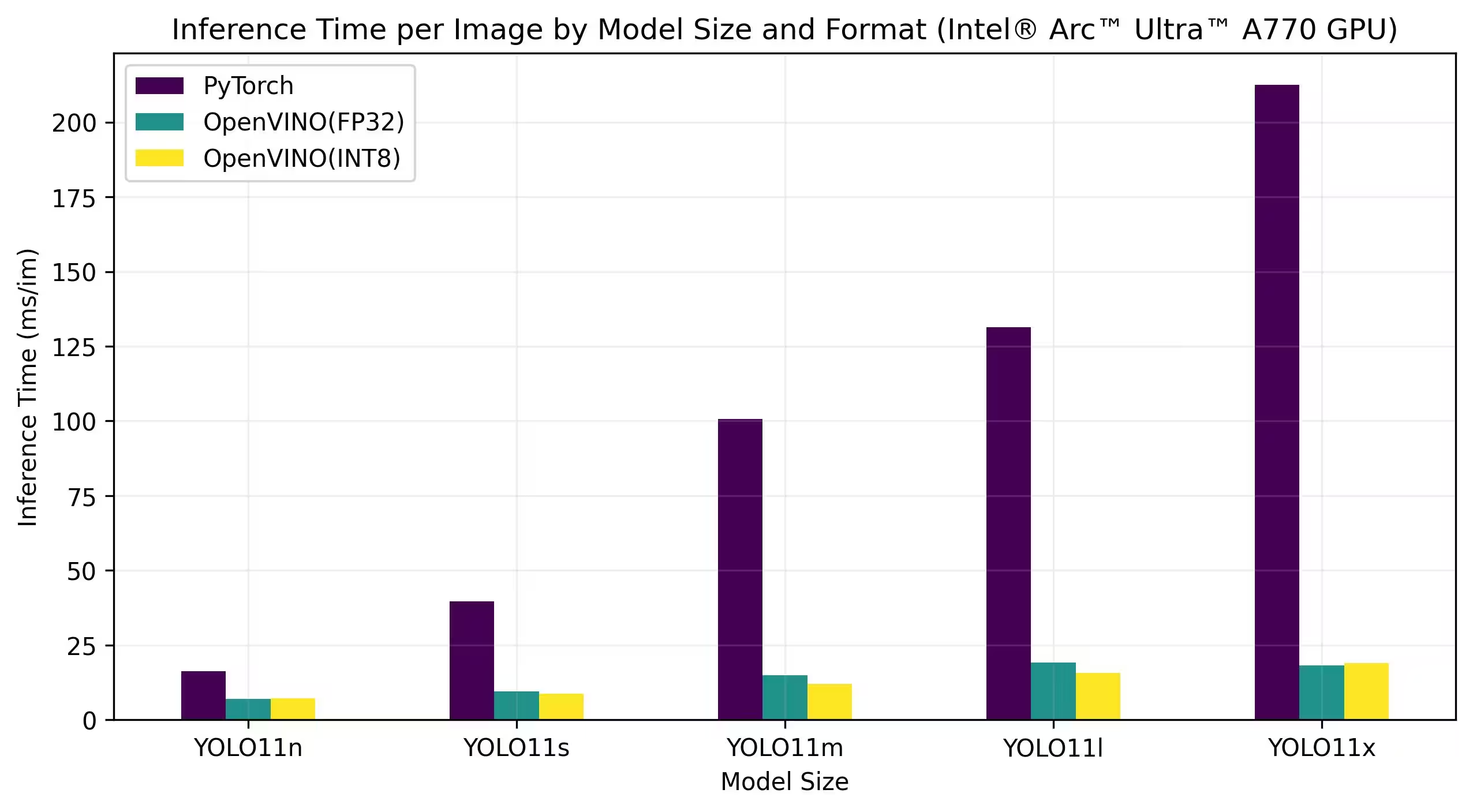

Intel® Arc GPU

Intel® Arc™ — это линейка дискретных видеокарт Intel, предназначенных для высокопроизводительных игр, создания контента и рабочих нагрузок ИИ. Серия Arc включает в себя передовые архитектуры GPU, поддерживающие трассировку лучей в реальном времени, графику с улучшением на основе ИИ и игры с высоким разрешением. Ориентируясь на производительность и эффективность, Intel® Arc™ стремится конкурировать с другими ведущими брендами GPU, предоставляя при этом уникальные функции, такие как аппаратно-ускоренное кодирование AV1 и поддержку новейших графических API.

Приведенные ниже тесты производительности выполнялись на Intel Arc A770 и Intel Arc B580 с точностью FP32 и INT8.

Intel Arc A770

Подробные результаты эталонного тестирования

| Модель | Формат | Точность | Статус | Размер (МБ) | metrics/mAP50-95(B) | Время инференса (мс/изобр.) |

|---|---|---|---|---|---|---|

| YOLO11n | PyTorch | FP32 | ✅ | 5.4 | 0.5072 | 16.29 |

| YOLO11n | OpenVINO | FP32 | ✅ | 10.4 | 0.5073 | 6.98 |

| YOLO11n | OpenVINO | INT8 | ✅ | 3.3 | 0.4978 | 7.24 |

| YOLO11s | PyTorch | FP32 | ✅ | 18.4 | 0.5771 | 39.61 |

| YOLO11s | OpenVINO | FP32 | ✅ | 36.4 | 0.5798 | 9.41 |

| YOLO11s | OpenVINO | INT8 | ✅ | 9.8 | 0.5751 | 8.72 |

| YOLO11m | PyTorch | FP32 | ✅ | 38.8 | 0.6258 | 100.65 |

| YOLO11m | OpenVINO | FP32 | ✅ | 77.1 | 0.6311 | 14.88 |

| YOLO11m | OpenVINO | INT8 | ✅ | 20.2 | 0.6126 | 11.97 |

| YOLO11l | PyTorch | FP32 | ✅ | 49.0 | 0.6367 | 131.37 |

| YOLO11l | OpenVINO | FP32 | ✅ | 97.3 | 0.6364 | 19.17 |

| YOLO11l | OpenVINO | INT8 | ✅ | 25.7 | 0.6241 | 15.75 |

| YOLO11x | PyTorch | FP32 | ✅ | 109.3 | 0.6990 | 212.45 |

| YOLO11x | OpenVINO | FP32 | ✅ | 217.8 | 0.6888 | 18.13 |

| YOLO11x | OpenVINO | INT8 | ✅ | 55.9 | 0.6930 | 18.91 |

Intel Arc B580

Подробные результаты эталонного тестирования

| Модель | Формат | Точность | Статус | Размер (МБ) | metrics/mAP50-95(B) | Время инференса (мс/изобр.) |

|---|---|---|---|---|---|---|

| YOLO11n | PyTorch | FP32 | ✅ | 5.4 | 0.5072 | 16.29 |

| YOLO11n | OpenVINO | FP32 | ✅ | 10.4 | 0.5072 | 4.27 |

| YOLO11n | OpenVINO | INT8 | ✅ | 3.3 | 0.4981 | 4.33 |

| YOLO11s | PyTorch | FP32 | ✅ | 18.4 | 0.5771 | 39.61 |

| YOLO11s | OpenVINO | FP32 | ✅ | 36.4 | 0.5789 | 5.04 |

| YOLO11s | OpenVINO | INT8 | ✅ | 9.8 | 0.5746 | 4.97 |

| YOLO11m | PyTorch | FP32 | ✅ | 38.8 | 0.6258 | 100.65 |

| YOLO11m | OpenVINO | FP32 | ✅ | 77.1 | 0.6306 | 6.45 |

| YOLO11m | OpenVINO | INT8 | ✅ | 20.2 | 0.6125 | 6.28 |

| YOLO11l | PyTorch | FP32 | ✅ | 49.0 | 0.6367 | 131.37 |

| YOLO11l | OpenVINO | FP32 | ✅ | 97.3 | 0.6360 | 8.23 |

| YOLO11l | OpenVINO | INT8 | ✅ | 25.7 | 0.6236 | 8.49 |

| YOLO11x | PyTorch | FP32 | ✅ | 109.3 | 0.6990 | 212.45 |

| YOLO11x | OpenVINO | FP32 | ✅ | 217.8 | 0.6889 | 11.10 |

| YOLO11x | OpenVINO | INT8 | ✅ | 55.9 | 0.6924 | 10.30 |

Воспроизведение наших результатов

Чтобы воспроизвести тесты Ultralytics, приведенные выше, для всех форматов экспорта, запустите этот код:

Пример

from ultralytics import YOLO

# Load a YOLO11n PyTorch model

model = YOLO("yolo11n.pt")

# Benchmark YOLO11n speed and accuracy on the COCO128 dataset for all export formats

results = model.benchmark(data="coco128.yaml")

# Benchmark YOLO11n speed and accuracy on the COCO128 dataset for all export formats

yolo benchmark model=yolo11n.pt data=coco128.yaml

Обратите внимание, что результаты тестов могут варьироваться в зависимости от конкретной конфигурации оборудования и программного обеспечения системы, а также от текущей нагрузки на систему во время проведения тестов. Для получения наиболее надежных результатов используйте набор данных с большим количеством изображений, например, data='coco.yaml' (5000 изображений для проверки).

Заключение

Результаты сравнительного анализа ясно демонстрируют преимущества экспорта модели YOLO11 в формат OpenVINO. В разных моделях и на разных аппаратных платформах формат OpenVINO неизменно превосходит другие форматы с точки зрения скорости вывода, сохраняя при этом сопоставимую точность.

Результаты бенчмарков подчеркивают эффективность OpenVINO как инструмента для развертывания моделей глубокого обучения. Преобразуя модели в формат OpenVINO, разработчики могут добиться значительного повышения производительности, что упрощает развертывание этих моделей в реальных приложениях.

Для получения более подробной информации и инструкций по использованию OpenVINO обратитесь к официальной документации OpenVINO.

Часто задаваемые вопросы

Как экспортировать модели YOLO26 в формат OpenVINO?

Экспорт моделей YOLO26 в формат OpenVINO может значительно увеличить скорость CPU и обеспечить ускорение GPU и NPU на оборудовании Intel. Для экспорта вы можете использовать python или CLI, как показано ниже:

Пример

from ultralytics import YOLO

# Load a YOLO26n PyTorch model

model = YOLO("yolo26n.pt")

# Export the model

model.export(format="openvino") # creates 'yolo26n_openvino_model/'

# Export a YOLO26n PyTorch model to OpenVINO format

yolo export model=yolo26n.pt format=openvino # creates 'yolo26n_openvino_model/'

Для получения дополнительной информации обратитесь к документации по форматам экспорта.

Каковы преимущества использования OpenVINO с моделями YOLO26?

Использование инструментария Intel OpenVINO с моделями YOLO26 предлагает несколько преимуществ:

- Производительность: Добейтесь 3-кратного увеличения скорости логического вывода на CPU и используйте Intel GPU и NPU для ускорения.

- Оптимизатор моделей: Преобразуйте, оптимизируйте и выполняйте модели из популярных фреймворков, таких как PyTorch, TensorFlow и ONNX.

- Простота использования: Доступно более 80 обучающих ноутбуков, которые помогут пользователям начать работу, включая те, что предназначены для YOLO26.

- Гетерогенное выполнение: Развертывайте модели на различном оборудовании Intel с унифицированным API.

Подробные сравнения производительности можно найти в нашем разделе тестов производительности.

Как выполнить инференс, используя модель YOLO26, экспортированную в OpenVINO?

После экспорта модели YOLO26n в формат OpenVINO вы можете выполнить инференс, используя python или CLI:

Пример

from ultralytics import YOLO

# Load the exported OpenVINO model

ov_model = YOLO("yolo26n_openvino_model/")

# Run inference

results = ov_model("https://ultralytics.com/images/bus.jpg")

# Run inference with the exported model

yolo predict model=yolo26n_openvino_model source='https://ultralytics.com/images/bus.jpg'

Для получения более подробной информации обратитесь к нашей документации по режиму предсказания.

Почему следует выбрать Ultralytics YOLO26, а не другие модели для экспорта в OpenVINO?

Ultralytics YOLO26 оптимизирован для обнаружения объектов в реальном времени с высокой точностью и скоростью. В частности, в сочетании с OpenVINO, YOLO26 обеспечивает:

- Ускорение до 3 раз на CPU Intel

- Простое развертывание на графических процессорах и NPU Intel

- Стабильная и сопоставимая точность для различных форматов экспорта

Для углубленного анализа производительности ознакомьтесь с нашими подробными бенчмарками YOLO11 на различном оборудовании.

Могу ли я сравнить модели YOLO26 в разных форматах, таких как PyTorch, ONNX и OpenVINO?

Да, вы можете проводить тестирование моделей YOLO26 в различных форматах, включая PyTorch, TorchScript, ONNX и OpenVINO. Используйте следующий фрагмент кода для запуска тестов на выбранном вами наборе данных:

Пример

from ultralytics import YOLO

# Load a YOLO26n PyTorch model

model = YOLO("yolo26n.pt")

# Benchmark YOLO26n speed and [accuracy](https://www.ultralytics.com/glossary/accuracy) on the COCO8 dataset for all export formats

results = model.benchmark(data="coco8.yaml")

# Benchmark YOLO26n speed and accuracy on the COCO8 dataset for all export formats

yolo benchmark model=yolo26n.pt data=coco8.yaml

Подробные результаты тестов производительности можно найти в нашем разделе тестов производительности и в документации по форматам экспорта.