COCO-Pose Veri Kümesi

COCO-Pose veri kümesi, poz tahmini görevleri için tasarlanmış COCO (Bağlamdaki Ortak Nesneler) veri kümesinin özel bir sürümüdür. Poz tahmini görevleri için YOLO gibi modellerin eğitimini sağlamak üzere COCO Keypoints 2017 görüntülerini ve etiketlerini kullanır.

COCO-Pose Önceden Eğitilmiş Modeller

| Model | boyut (piksel) | mAPpose 50-95(e2e) | mAPpose 50(e2e) | Hız CPU ONNX (ms) | Hız T4 TensorRT10 (ms) | parametreler (M) | FLOP'lar (B) |

|---|---|---|---|---|---|---|---|

| YOLO26n-pose | 640 | 57.2 | 83.3 | 40.3 ± 0.5 | 1.8 ± 0.0 | 2.9 | 7.5 |

| YOLO26s-pose | 640 | 63.0 | 86.6 | 85.3 ± 0.9 | 2.7 ± 0.0 | 10.4 | 23.9 |

| YOLO26m-pose | 640 | 68.8 | 89.6 | 218.0 ± 1.5 | 5.0 ± 0.1 | 21.5 | 73.1 |

| YOLO26l-pose | 640 | 70.4 | 90.5 | 275.4 ± 2.4 | 6.5 ± 0.1 | 25.9 | 91.3 |

| YOLO26x-pose | 640 | 71.6 | 91.6 | 565.4 ± 3.0 | 12.2 ± 0.2 | 57.6 | 201.7 |

Temel Özellikler

- COCO-Pose, poz tahmini görevleri için anahtar noktalarla etiketlenmiş 200 bin görüntü içeren COCO Anahtar Noktaları 2017 veri kümesi üzerine kurulmuştur.

- Veri kümesi, insan figürleri için 17 anahtar noktasını destekleyerek ayrıntılı poz tahmini yapılmasını kolaylaştırır.

- COCO gibi, poz tahmini görevleri için Nesne Anahtar Noktası Benzerliği (OKS) dahil olmak üzere standartlaştırılmış değerlendirme metrikleri sağlar ve model performansını karşılaştırmak için uygundur.

Veri Seti Yapısı

COCO-Pose veri seti üç alt kümeye ayrılmıştır:

- Train2017: Bu alt küme, poz tahmini modellerini eğitmek için açıklama eklenmiş COCO veri kümesinden 56599 resim içerir.

- Val2017: Bu alt küme, model eğitimi sırasında doğrulama amacıyla kullanılan 2346 resme sahiptir.

- Test2017: Bu alt küme, eğitilmiş modelleri test etmek ve kıyaslamak için kullanılan resimlerden oluşur. Bu alt küme için temel doğruluk açıklamaları herkese açık değildir ve sonuçlar performans değerlendirmesi için COCO değerlendirme sunucusuna gönderilir.

Uygulamalar

COCO-Pose veri seti özellikle OpenPose gibi anahtar nokta tespiti ve poz tahmini görevlerinde derin öğrenme modellerini eğitmek ve değerlendirmek için kullanılır. Veri setinin çok sayıda açıklanmış görüntü ve standartlaştırılmış değerlendirme metrikleri, onu poz tahminine odaklanan bilgisayarlı görü araştırmacıları ve uygulayıcıları için vazgeçilmez bir kaynak haline getirmektedir.

Veri Seti YAML

Bir YAML (Yet Another Markup Language) dosyası, veri kümesi yapılandırmasını tanımlamak için kullanılır. Veri kümesinin yolları, sınıfları ve diğer ilgili bilgiler hakkında bilgi içerir. COCO-Pose veri kümesi örneğinde, coco-pose.yaml dosyası şu adreste tutulur: https://github.com/ultralytics/ultralytics/blob/main/ultralytics/cfg/datasets/coco-pose.yaml.

ultralytics/cfg/datasets/coco-pose.yaml

# Ultralytics 🚀 AGPL-3.0 License - https://ultralytics.com/license

# COCO 2017 Keypoints dataset https://cocodataset.org by Microsoft

# Documentation: https://docs.ultralytics.com/datasets/pose/coco/

# Example usage: yolo train data=coco-pose.yaml

# parent

# ├── ultralytics

# └── datasets

# └── coco-pose ← downloads here (20.1 GB)

# Train/val/test sets as 1) dir: path/to/imgs, 2) file: path/to/imgs.txt, or 3) list: [path/to/imgs1, path/to/imgs2, ..]

path: coco-pose # dataset root dir

train: train2017.txt # train images (relative to 'path') 56599 images

val: val2017.txt # val images (relative to 'path') 2346 images

test: test-dev2017.txt # 20288 of 40670 images, submit to https://codalab.lisn.upsaclay.fr/competitions/7403

# Keypoints

kpt_shape: [17, 3] # number of keypoints, number of dims (2 for x,y or 3 for x,y,visible)

flip_idx: [0, 2, 1, 4, 3, 6, 5, 8, 7, 10, 9, 12, 11, 14, 13, 16, 15]

# Classes

names:

0: person

# Keypoint names per class

kpt_names:

0:

- nose

- left_eye

- right_eye

- left_ear

- right_ear

- left_shoulder

- right_shoulder

- left_elbow

- right_elbow

- left_wrist

- right_wrist

- left_hip

- right_hip

- left_knee

- right_knee

- left_ankle

- right_ankle

# Download script/URL (optional)

download: |

from pathlib import Path

from ultralytics.utils import ASSETS_URL

from ultralytics.utils.downloads import download

# Download labels

dir = Path(yaml["path"]) # dataset root dir

urls = [f"{ASSETS_URL}/coco2017labels-pose.zip"]

download(urls, dir=dir.parent)

# Download data

urls = [

"http://images.cocodataset.org/zips/train2017.zip", # 19G, 118k images

"http://images.cocodataset.org/zips/val2017.zip", # 1G, 5k images

"http://images.cocodataset.org/zips/test2017.zip", # 7G, 41k images (optional)

]

download(urls, dir=dir / "images", threads=3)

Kullanım

COCO-Pose veri seti üzerinde 640 görüntü boyutuyla 100 epoch boyunca bir YOLO26n-pose modelini eğitmek için aşağıdaki kod parçacıklarını kullanabilirsiniz. Mevcut argümanların kapsamlı bir listesi için model Eğitim sayfasına bakınız.

Eğitim Örneği

from ultralytics import YOLO

# Load a model

model = YOLO("yolo26n-pose.pt") # load a pretrained model (recommended for training)

# Train the model

results = model.train(data="coco-pose.yaml", epochs=100, imgsz=640)

# Start training from a pretrained *.pt model

yolo pose train data=coco-pose.yaml model=yolo26n-pose.pt epochs=100 imgsz=640

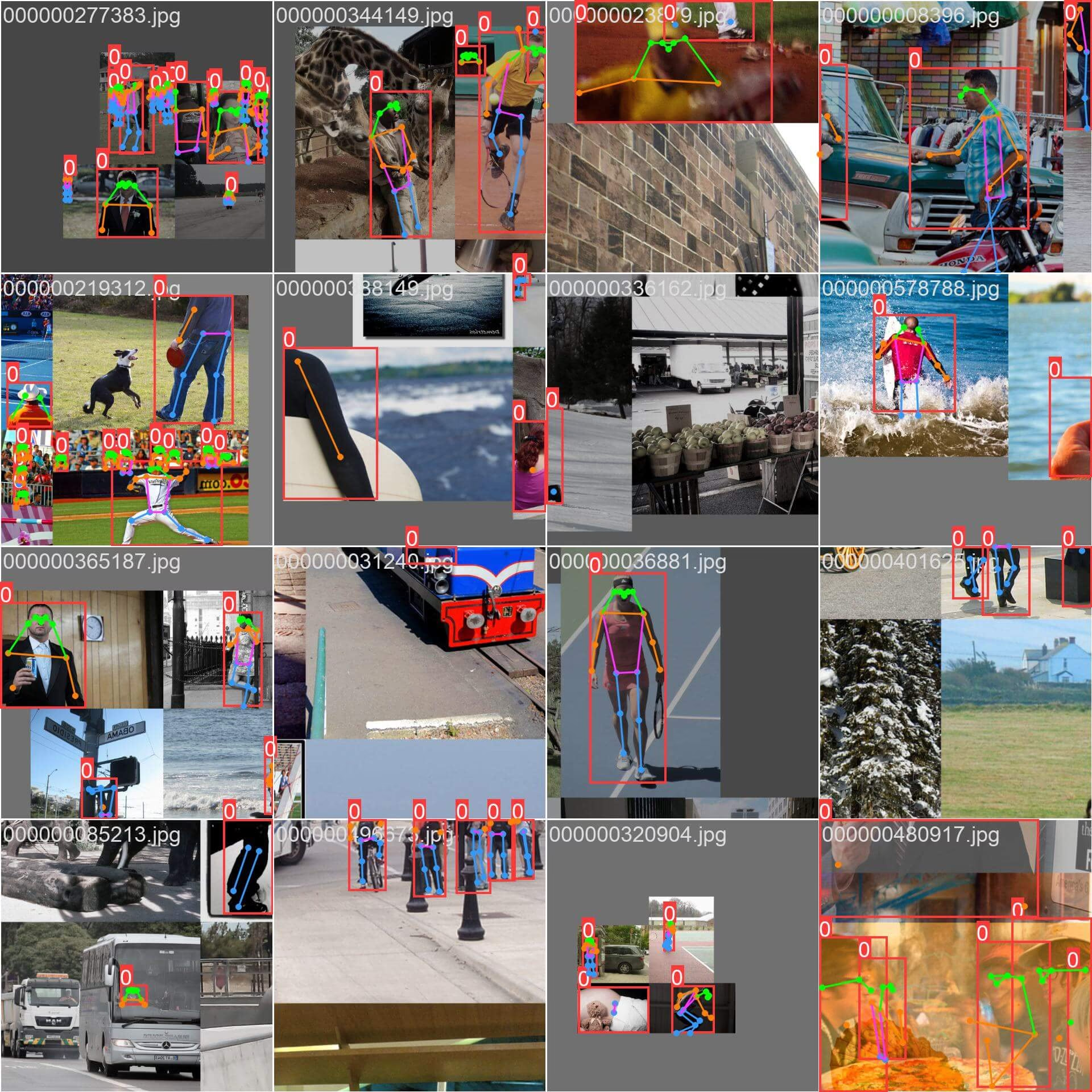

Örnek Görüntüler ve Açıklamalar

COCO-Pose veri seti, anahtar noktalarla açıklanmış insan figürleri içeren çeşitli görüntülerden oluşur. İşte veri setinden bazı görüntü örnekleri ve bunlara karşılık gelen açıklamalar:

- Mozaiklenmiş Görüntü: Bu görüntü, mozaiklenmiş veri seti görüntülerinden oluşan bir eğitim grubunu göstermektedir. Mozaikleme, her eğitim grubundaki nesnelerin ve sahnelerin çeşitliliğini artırmak için birden çok görüntüyü tek bir görüntüde birleştiren eğitim sırasında kullanılan bir tekniktir. Bu, modelin farklı nesne boyutlarına, en boy oranlarına ve bağlamlara genelleme yeteneğini geliştirmeye yardımcı olur.

Bu örnek, COCO-Pose veri kümesindeki görüntülerin çeşitliliğini ve karmaşıklığını ve eğitim sürecinde mozaiklemenin kullanımının faydalarını sergilemektedir.

Alıntılar ve Teşekkürler

Araştırma veya geliştirme çalışmalarınızda COCO-Pose veri kümesini kullanıyorsanız, lütfen aşağıdaki makaleye atıfta bulunun:

@misc{lin2015microsoft,

title={Microsoft COCO: Common Objects in Context},

author={Tsung-Yi Lin and Michael Maire and Serge Belongie and Lubomir Bourdev and Ross Girshick and James Hays and Pietro Perona and Deva Ramanan and C. Lawrence Zitnick and Piotr Dollár},

year={2015},

eprint={1405.0312},

archivePrefix={arXiv},

primaryClass={cs.CV}

}

Bilgisayar görüşü topluluğu için bu değerli kaynağı oluşturdukları ve sürdürdükleri için COCO Konsorsiyumu'na teşekkür etmek isteriz. COCO-Pose veri seti ve yaratıcıları hakkında daha fazla bilgi için COCO veri seti web sitesini ziyaret edin.

SSS

COCO-Pose veri seti nedir ve poz tahmini için Ultralytics YOLO ile nasıl kullanılır?

COCO-Pose veri seti, poz tahmini görevleri için tasarlanmış, COCO (Common Objects in Context) veri setinin özel bir versiyonudur. COCO Keypoints 2017 görüntüleri ve ek açıklamaları üzerine inşa edilmiştir, Ultralytics YOLO gibi modellerin detaylı poz tahmini için eğitilmesine olanak tanır. Örneğin, önceden eğitilmiş bir modeli yükleyerek ve bir yaml yapılandırmasıyla eğiterek bir YOLO26n-pose modelini COCO-Pose veri seti üzerinde eğitebilirsiniz. Eğitim örnekleri için Eğitim belgelerine bakınız.

COCO-Pose veri seti üzerinde bir YOLO26 modelini nasıl eğitebilirim?

COCO-Pose veri seti üzerinde bir YOLO26 modelini eğitmek python veya CLI komutları kullanılarak gerçekleştirilebilir. Örneğin, 640 görüntü boyutuyla 100 epoch boyunca bir YOLO26n-pose modelini eğitmek için aşağıdaki adımları takip edebilirsiniz:

Eğitim Örneği

from ultralytics import YOLO

# Load a model

model = YOLO("yolo26n-pose.pt") # load a pretrained model (recommended for training)

# Train the model

results = model.train(data="coco-pose.yaml", epochs=100, imgsz=640)

# Start training from a pretrained *.pt model

yolo pose train data=coco-pose.yaml model=yolo26n-pose.pt epochs=100 imgsz=640

Eğitim süreci ve mevcut argümanlar hakkında daha fazla bilgi için eğitim sayfasına bakın.

Model performansını değerlendirmek için COCO-Pose veri kümesi tarafından sağlanan farklı metrikler nelerdir?

COCO-Pose veri seti, orijinal COCO veri setine benzer şekilde, poz tahmini görevleri için çeşitli standartlaştırılmış değerlendirme metrikleri sunar. Temel metrikler arasında, tahmin edilen anahtar noktaların gerçek etiketlere karşı doğruluğunu değerlendiren Nesne Anahtar Noktası Benzerliği (OKS) bulunur. Bu metrikler, farklı modeller arasında kapsamlı performans karşılaştırmalarına olanak tanır. Örneğin, YOLO26n-pose, YOLO26s-pose ve diğerleri gibi COCO-Pose önceden eğitilmiş modelleri, belgelerde mAPpose50-95 ve mAPpose50 gibi belirli performans metriklerine sahiptir.

COCO-Pose veri kümesi için veri kümesi nasıl yapılandırılır ve bölünür?

COCO-Pose veri seti üç alt kümeye ayrılmıştır:

- Train2017: Poz tahmini modellerini eğitmek için açıklama eklenmiş 56599 COCO görüntüsü içerir.

- Val2017: Model eğitimi sırasında doğrulama amacıyla kullanılan 2346 resim.

- Test2017: Eğitilmiş modelleri test etmek ve kıyaslamak için kullanılan resimler. Bu alt küme için temel doğruluk açıklamaları herkese açık değildir; sonuçlar performans değerlendirmesi için COCO değerlendirme sunucusuna gönderilir.

Bu alt kümeler, eğitim, doğrulama ve test aşamalarını etkili bir şekilde düzenlemeye yardımcı olur. Yapılandırma ayrıntıları için şurayı inceleyin: coco-pose.yaml dosyası şurada mevcut: GitHub.

COCO-Pose veri kümesinin temel özellikleri ve uygulamaları nelerdir?

COCO-Pose veri seti, insan figürleri için 17 anahtar nokta içerecek şekilde COCO Keypoints 2017 ek açıklamalarını genişleterek detaylı poz tahmini sağlar. Standartlaştırılmış değerlendirme metrikleri (örn. OKS), farklı modeller arasında karşılaştırmaları kolaylaştırır. COCO-Pose veri setinin uygulamaları, insan figürlerinin detaylı poz tahmininin gerektiği spor analizi, sağlık hizmetleri ve insan-bilgisayar etkileşimi gibi çeşitli alanları kapsar. Pratik kullanım için, belgelerde sağlanan (örn. YOLO26n-pose) gibi önceden eğitilmiş modellerden yararlanmak süreci önemli ölçüde kolaylaştırabilir (Temel Özellikler).

Araştırma veya geliştirme çalışmalarınızda COCO-Pose veri kümesini kullanıyorsanız, lütfen aşağıdaki BibTeX girdisi ile makaleye atıfta bulunun.