Hướng dẫn xuất mô hình YOLO26 sang TFLite để triển khai

Việc triển khai các mô hình computer vision trên các thiết bị biên hoặc thiết bị nhúng đòi hỏi một định dạng có thể đảm bảo hiệu suất liền mạch.

Định dạng xuất TensorFlow Lite hoặc TFLite cho phép bạn tối ưu hóa các mô hình Ultralytics YOLO26 của mình cho các tác vụ như phát hiện đối tượng và phân loại hình ảnh trong các ứng dụng dựa trên thiết bị biên. Trong hướng dẫn này, chúng tôi sẽ hướng dẫn các bước chuyển đổi mô hình của bạn sang định dạng TFLite, giúp mô hình của bạn hoạt động tốt hơn trên nhiều thiết bị biên khác nhau.

Tại sao bạn nên xuất sang TFLite?

Được Google giới thiệu vào tháng 5 năm 2017 như một phần của framework TensorFlow của họ, TensorFlow Lite, hay viết tắt là TFLite, là một framework học sâu mã nguồn mở được thiết kế để suy luận trên thiết bị, còn được gọi là điện toán biên. Nó cung cấp cho các nhà phát triển các công cụ cần thiết để thực thi các mô hình đã huấn luyện của họ trên thiết bị di động, nhúng và IoT, cũng như máy tính truyền thống.

TensorFlow Lite tương thích với nhiều nền tảng, bao gồm Linux nhúng, Android, iOS và vi điều khiển (MCU). Việc xuất mô hình của bạn sang TFLite giúp ứng dụng của bạn nhanh hơn, đáng tin cậy hơn và có khả năng chạy ngoại tuyến.

Các tính năng chính của mô hình TFLite

Các mô hình TFLite cung cấp một loạt các tính năng chính cho phép học máy trên thiết bị bằng cách giúp các nhà phát triển chạy mô hình của họ trên thiết bị di động, nhúng và biên:

Tối ưu hóa trên thiết bị: TFLite tối ưu hóa cho ML trên thiết bị, giảm độ trễ bằng cách xử lý dữ liệu cục bộ, tăng cường quyền riêng tư bằng cách không truyền dữ liệu cá nhân và giảm thiểu kích thước mô hình để tiết kiệm không gian.

Hỗ trợ đa nền tảng: TFLite cung cấp khả năng tương thích nền tảng rộng rãi, hỗ trợ Android, iOS, Linux nhúng và vi điều khiển.

Hỗ trợ đa dạng ngôn ngữ: TFLite tương thích với nhiều ngôn ngữ lập trình khác nhau, bao gồm Java, Swift, Objective-C, C++ và Python.

Hiệu suất cao: Đạt được hiệu suất vượt trội thông qua tăng tốc phần cứng và tối ưu hóa mô hình.

Các tùy chọn triển khai trong TFLite

Trước khi chúng ta xem xét mã để xuất các mô hình YOLO26 sang định dạng TFLite, hãy cùng tìm hiểu cách các mô hình TFLite thường được sử dụng.

TFLite cung cấp nhiều tùy chọn triển khai trên thiết bị cho các mô hình học máy, bao gồm:

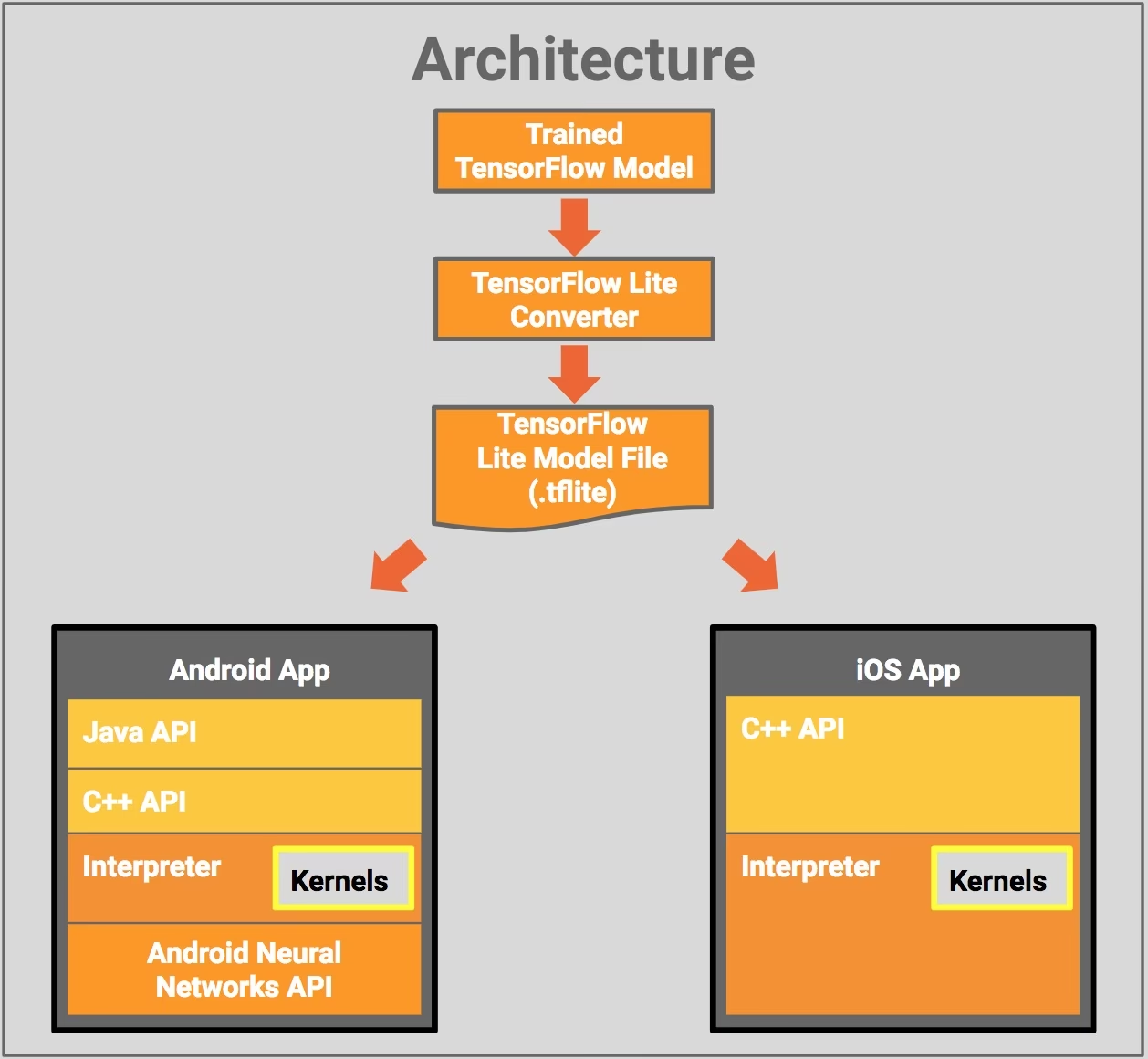

- Triển khai với Android và iOS: Cả ứng dụng Android và iOS với TFLite đều có thể phân tích nguồn cấp dữ liệu camera và cảm biến dựa trên biên để detect và nhận dạng đối tượng. TFLite cũng cung cấp các thư viện iOS gốc được viết bằng Swift và Objective-C. Sơ đồ kiến trúc dưới đây cho thấy quá trình triển khai một mô hình đã huấn luyện lên các nền tảng Android và iOS bằng TensorFlow Lite.

Triển khai với Embedded Linux: Nếu việc chạy suy luận trên Raspberry Pi bằng Hướng dẫn của Ultralytics không đáp ứng yêu cầu về tốc độ cho trường hợp sử dụng của bạn, bạn có thể sử dụng mô hình TFLite đã xuất để tăng tốc thời gian suy luận. Ngoài ra, có thể cải thiện hiệu suất hơn nữa bằng cách tận dụng thiết bị Coral Edge TPU.

Triển khai với Vi điều khiển: Các mô hình TFLite cũng có thể được triển khai trên vi điều khiển và các thiết bị khác chỉ với vài kilobyte bộ nhớ. Thời gian chạy cốt lõi chỉ vừa vặn trong 16 KB trên Arm Cortex M3 và có thể chạy nhiều mô hình cơ bản. Nó không yêu cầu hỗ trợ hệ điều hành, bất kỳ thư viện C hoặc C++ tiêu chuẩn nào, hay cấp phát bộ nhớ động.

Xuất sang TFLite: Chuyển đổi mô hình YOLO26 của bạn

Bạn có thể cải thiện hiệu quả thực thi mô hình trên thiết bị và tối ưu hóa hiệu suất bằng cách chuyển đổi mô hình của bạn sang định dạng TFLite.

Cài đặt

Để cài đặt các gói cần thiết, hãy chạy:

Cài đặt

# Install the required package for YOLO26

pip install ultralytics

Để biết hướng dẫn chi tiết và các phương pháp hay nhất liên quan đến quá trình cài đặt, hãy kiểm tra hướng dẫn cài đặt Ultralytics của chúng tôi. Trong quá trình cài đặt các gói cần thiết cho YOLO26, nếu bạn gặp bất kỳ khó khăn nào, hãy tham khảo hướng dẫn Các Vấn đề Thường Gặp của chúng tôi để tìm giải pháp và mẹo.

Cách sử dụng

Tất cả các mô hình Ultralytics YOLO26 đều được thiết kế để hỗ trợ xuất ngay lập tức, giúp dễ dàng tích hợp chúng vào quy trình triển khai ưa thích của bạn. Bạn có thể xem danh sách đầy đủ các định dạng xuất được hỗ trợ và các tùy chọn cấu hình để chọn thiết lập tốt nhất cho ứng dụng của mình.

Cách sử dụng

from ultralytics import YOLO

# Load the YOLO26 model

model = YOLO("yolo26n.pt")

# Export the model to TFLite format

model.export(format="tflite") # creates 'yolo26n_float32.tflite'

# Load the exported TFLite model

tflite_model = YOLO("yolo26n_float32.tflite")

# Run inference

results = tflite_model("https://ultralytics.com/images/bus.jpg")

# Export a YOLO26n PyTorch model to TFLite format

yolo export model=yolo26n.pt format=tflite # creates 'yolo26n_float32.tflite'

# Run inference with the exported model

yolo predict model='yolo26n_float32.tflite' source='https://ultralytics.com/images/bus.jpg'

Các đối số xuất

| Đối số | Loại | Mặc định | Mô tả |

|---|---|---|---|

format | str | 'tflite' | Dạng mục tiêu cho mô hình được xuất, xác định khả năng tương thích với các môi trường triển khai khác nhau. |

imgsz | int hoặc tuple | 640 | Kích thước hình ảnh mong muốn cho đầu vào của mô hình. Có thể là một số nguyên cho hình ảnh vuông hoặc một bộ giá trị (height, width) cho các kích thước cụ thể. |

half | bool | False | Cho phép lượng tử hóa FP16 (nửa độ chính xác), giảm kích thước mô hình và có khả năng tăng tốc độ suy luận trên phần cứng được hỗ trợ. |

int8 | bool | False | Kích hoạt lượng tử hóa INT8, nén thêm mô hình và tăng tốc độ suy luận với mức giảm độ chính xác tối thiểu, chủ yếu dành cho các thiết bị biên. |

nms | bool | False | Thêm Non-Maximum Suppression (NMS), cần thiết cho quá trình hậu xử lý detect chính xác và hiệu quả. |

batch | int | 1 | Chỉ định kích thước suy luận theo lô của mô hình xuất hoặc số lượng hình ảnh tối đa mà mô hình đã xuất sẽ xử lý đồng thời ở chế độ predict chế độ. |

data | str | 'coco8.yaml' | Đường dẫn đến tập dữ liệu tệp cấu hình (mặc định: coco8.yaml), cần thiết cho lượng tử hóa. |

fraction | float | 1.0 | Chỉ định tỷ lệ phần trăm của tập dữ liệu được sử dụng để hiệu chỉnh lượng tử hóa INT8. Cho phép hiệu chỉnh trên một tập hợp con của toàn bộ tập dữ liệu, hữu ích cho các thử nghiệm hoặc khi tài nguyên bị hạn chế. Nếu không được chỉ định khi bật INT8, toàn bộ tập dữ liệu sẽ được sử dụng. |

device | str | None | Chỉ định thiết bị để xuất: CPU (device=cpu), MPS cho Apple silicon (device=mps). |

Để biết thêm chi tiết về quy trình xuất, hãy truy cập trang tài liệu Ultralytics về xuất.

Triển khai các mô hình YOLO26 TFLite đã xuất

Sau khi xuất thành công các mô hình Ultralytics YOLO26 của bạn sang định dạng TFLite, giờ đây bạn có thể triển khai chúng. Bước đầu tiên chính và được khuyến nghị để chạy mô hình TFLite là sử dụng YOLO("model.tflite") phương pháp, như đã nêu trong đoạn mã sử dụng trước đó. Tuy nhiên, để biết hướng dẫn chuyên sâu về việc triển khai các mô hình TFLite của bạn trong nhiều cài đặt khác, hãy xem các tài nguyên sau:

Android: Hướng dẫn khởi động nhanh để tích hợp TensorFlow Lite vào các ứng dụng Android, cung cấp các bước dễ thực hiện để thiết lập và chạy các mô hình máy học.

iOS: Hãy xem hướng dẫn chi tiết này dành cho nhà phát triển về tích hợp và triển khai các mô hình TensorFlow Lite trong các ứng dụng iOS, cung cấp hướng dẫn và tài nguyên từng bước.

Ví dụ Toàn diện: Trang này cung cấp tổng quan về các ví dụ TensorFlow Lite khác nhau, giới thiệu các ứng dụng thực tế và hướng dẫn được thiết kế để giúp các nhà phát triển triển khai TensorFlow Lite trong các dự án máy học của họ trên thiết bị di động và thiết bị biên.

Tóm tắt

Trong hướng dẫn này, chúng tôi tập trung vào cách xuất sang định dạng TFLite. Bằng cách chuyển đổi các mô hình Ultralytics YOLO26 của bạn sang định dạng mô hình TFLite, bạn có thể cải thiện hiệu quả và tốc độ của các mô hình YOLO26, làm cho chúng hiệu quả hơn và phù hợp hơn với môi trường điện toán biên.

Để biết thêm chi tiết về cách sử dụng, hãy truy cập tài liệu chính thức của TFLite.

Ngoài ra, nếu bạn tò mò về các tích hợp Ultralytics YOLO26 khác, hãy xem trang hướng dẫn tích hợp của chúng tôi. Bạn sẽ tìm thấy rất nhiều thông tin và hiểu biết hữu ích ở đó.

Câu hỏi thường gặp

Làm cách nào để xuất mô hình YOLO26 sang định dạng TFLite?

Để xuất mô hình YOLO26 sang định dạng TFLite, bạn có thể sử dụng thư viện Ultralytics. Đầu tiên, cài đặt gói cần thiết bằng cách sử dụng:

pip install ultralytics

Sau đó, sử dụng đoạn mã sau để xuất mô hình của bạn:

from ultralytics import YOLO

# Load the YOLO26 model

model = YOLO("yolo26n.pt")

# Export the model to TFLite format

model.export(format="tflite") # creates 'yolo26n_float32.tflite'

Đối với người dùng CLI, bạn có thể đạt được điều này bằng:

yolo export model=yolo26n.pt format=tflite # creates 'yolo26n_float32.tflite'

Để biết thêm chi tiết, hãy truy cập hướng dẫn xuất Ultralytics.

Lợi ích của việc sử dụng TensorFlow Lite để triển khai mô hình YOLO26 là gì?

TensorFlow Lite (TFLite) là một khung học sâu mã nguồn mở được thiết kế để suy luận trên thiết bị, làm cho nó lý tưởng để triển khai các mô hình YOLO26 trên thiết bị di động, nhúng và IoT. Các lợi ích chính bao gồm:

- Tối ưu hóa trên thiết bị: Giảm thiểu độ trễ và tăng cường quyền riêng tư bằng cách xử lý dữ liệu cục bộ.

- Khả năng tương thích nền tảng: Hỗ trợ Android, iOS, embedded Linux và MCU.

- Hiệu suất: Sử dụng khả năng tăng tốc phần cứng để tối ưu hóa tốc độ và hiệu quả của mô hình.

Để tìm hiểu thêm, hãy xem hướng dẫn TFLite.

Có thể chạy các mô hình YOLO26 TFLite trên Raspberry Pi không?

Có, bạn có thể chạy các mô hình YOLO26 TFLite trên Raspberry Pi để cải thiện tốc độ suy luận. Đầu tiên, hãy xuất mô hình của bạn sang định dạng TFLite như đã giải thích ở trên. Sau đó, sử dụng một công cụ như TensorFlow Lite Interpreter để thực thi mô hình trên Raspberry Pi của bạn.

Để tối ưu hóa hơn nữa, bạn có thể cân nhắc sử dụng Coral Edge TPU. Để biết các bước chi tiết, hãy tham khảo hướng dẫn triển khai Raspberry Pi và hướng dẫn tích hợp Edge TPU của chúng tôi.

Tôi có thể sử dụng các mô hình TFLite trên vi điều khiển để dự đoán YOLO26 không?

Có, TFLite hỗ trợ triển khai trên các vi điều khiển có tài nguyên hạn chế. Thời gian chạy cốt lõi của TFLite chỉ yêu cầu 16 KB bộ nhớ trên Arm Cortex M3 và có thể chạy các mô hình YOLO26 cơ bản. Điều này làm cho nó phù hợp để triển khai trên các thiết bị có sức mạnh tính toán và bộ nhớ tối thiểu.

Để bắt đầu, hãy truy cập hướng dẫn TFLite Micro cho Vi điều khiển.

Những nền tảng nào tương thích với các mô hình YOLO26 đã xuất sang TFLite?

TensorFlow Lite cung cấp khả năng tương thích nền tảng rộng rãi, cho phép bạn triển khai các mô hình YOLO26 trên nhiều loại thiết bị, bao gồm:

- Android và iOS: Hỗ trợ gốc thông qua các thư viện TFLite Android và iOS.

- Embedded Linux: Lý tưởng cho các máy tính đơn bảng như Raspberry Pi.

- Vi điều khiển: Phù hợp cho các MCU có tài nguyên hạn chế.

Để biết thêm thông tin về các tùy chọn triển khai, hãy xem hướng dẫn triển khai chi tiết của chúng tôi.

Làm cách nào để khắc phục các sự cố thường gặp trong quá trình xuất mô hình YOLO26 sang TFLite?

Nếu bạn gặp lỗi khi xuất các mô hình YOLO26 sang TFLite, các giải pháp phổ biến bao gồm:

- Kiểm tra tính tương thích của gói: Đảm bảo bạn đang sử dụng các phiên bản tương thích của Ultralytics và TensorFlow. Tham khảo hướng dẫn cài đặt của chúng tôi.

- Hỗ trợ mô hình: Xác minh rằng mô hình YOLO26 cụ thể hỗ trợ xuất TFLite bằng cách kiểm tra trang tài liệu xuất của Ultralytics.

- Các vấn đề về lượng tử hóa: Khi sử dụng lượng tử hóa INT8, hãy đảm bảo đường dẫn bộ dữ liệu của bạn được chỉ định chính xác trong

datatham số.

Để biết thêm các mẹo khắc phục sự cố, hãy truy cập hướng dẫn Các vấn đề thường gặp của chúng tôi.