手部关键点数据集

简介

手部关键点数据集包含 26,768 张带有关键点标注的手部图像,使其适用于训练 Ultralytics YOLO 等模型进行姿势估计任务。这些标注是使用 Google MediaPipe 库生成的,确保了高准确性和一致性,并且该数据集与Ultralytics YOLO26格式兼容。

观看: 使用 Ultralytics YOLO26 进行手部关键点估计 | 人手姿势估计教程

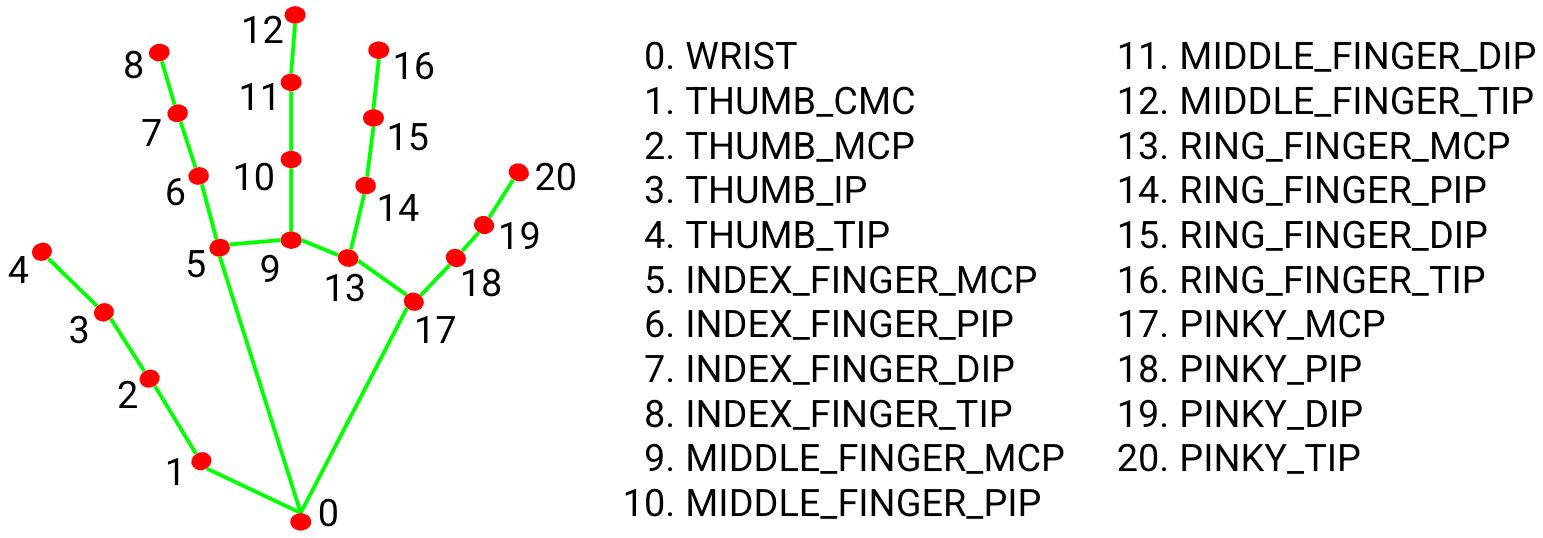

手部地标

关键点

该数据集包括用于手部检测的关键点。关键点注释如下:

- 手腕

- 拇指(4 个点)

- 食指(4 个点)

- 中指(4 个点)

- 无名指(4 个点)

- 小指(4 个点)

每只手总共有 21 个关键点。

主要功能

- 大型数据集:包含 26,768 张带有手部关键点注释的图像。

- YOLO26 兼容性:标签以 YOLO 关键点格式提供,可直接用于 YOLO26 模型。

- 21 个关键点:详细的手部姿势代表,覆盖手腕和每个手指四个点。

数据集结构

手部关键点数据集分为两个子集:

- 训练:此子集包含来自手部关键点数据集的 18,776 张图像,这些图像已针对训练姿势估计模型进行了注释。

- Val:此子集包含 7,992 张图像,可在模型训练期间用于验证。

应用

手部关键点可用于手势识别、AR/VR 控制、机器人操作以及医疗保健领域中的手部运动分析。它们还可以应用于动画中的动作捕捉和用于安全目的的生物识别认证系统。对手指位置的详细跟踪能够实现与虚拟对象的精确交互和非接触式控制界面。

数据集 YAML

YAML(Yet Another Markup Language)文件用于定义数据集配置,其中包含数据集的路径、类别和其他相关信息。对于Hand Keypoints数据集, hand-keypoints.yaml 文件保存在 https://github.com/ultralytics/ultralytics/blob/main/ultralytics/cfg/datasets/hand-keypoints.yaml.

Ultralytics/cfg/datasets/手部关键点.yaml

# Ultralytics 🚀 AGPL-3.0 License - https://ultralytics.com/license

# Hand Keypoints dataset by Ultralytics

# Documentation: https://docs.ultralytics.com/datasets/pose/hand-keypoints/

# Example usage: yolo train data=hand-keypoints.yaml

# parent

# ├── ultralytics

# └── datasets

# └── hand-keypoints ← downloads here (369 MB)

# Train/val/test sets as 1) dir: path/to/imgs, 2) file: path/to/imgs.txt, or 3) list: [path/to/imgs1, path/to/imgs2, ..]

path: hand-keypoints # dataset root dir

train: images/train # train images (relative to 'path') 18776 images

val: images/val # val images (relative to 'path') 7992 images

# Keypoints

kpt_shape: [21, 3] # number of keypoints, number of dims (2 for x,y or 3 for x,y,visible)

flip_idx: [0, 1, 2, 4, 3, 10, 11, 12, 13, 14, 5, 6, 7, 8, 9, 15, 16, 17, 18, 19, 20]

# Classes

names:

0: hand

# Keypoint names per class

kpt_names:

0:

- wrist

- thumb_cmc

- thumb_mcp

- thumb_ip

- thumb_tip

- index_mcp

- index_pip

- index_dip

- index_tip

- middle_mcp

- middle_pip

- middle_dip

- middle_tip

- ring_mcp

- ring_pip

- ring_dip

- ring_tip

- pinky_mcp

- pinky_pip

- pinky_dip

- pinky_tip

# Download script/URL (optional)

download: https://github.com/ultralytics/assets/releases/download/v0.0.0/hand-keypoints.zip

用法

要在手部关键点数据集上训练 YOLO26n-姿势估计模型 100 个 epoch,图像尺寸为 640,您可以使用以下代码片段。有关可用参数的完整列表,请参阅模型训练页面。

训练示例

from ultralytics import YOLO

# Load a model

model = YOLO("yolo26n-pose.pt") # load a pretrained model (recommended for training)

# Train the model

results = model.train(data="hand-keypoints.yaml", epochs=100, imgsz=640)

# Start training from a pretrained *.pt model

yolo pose train data=hand-keypoints.yaml model=yolo26n-pose.pt epochs=100 imgsz=640

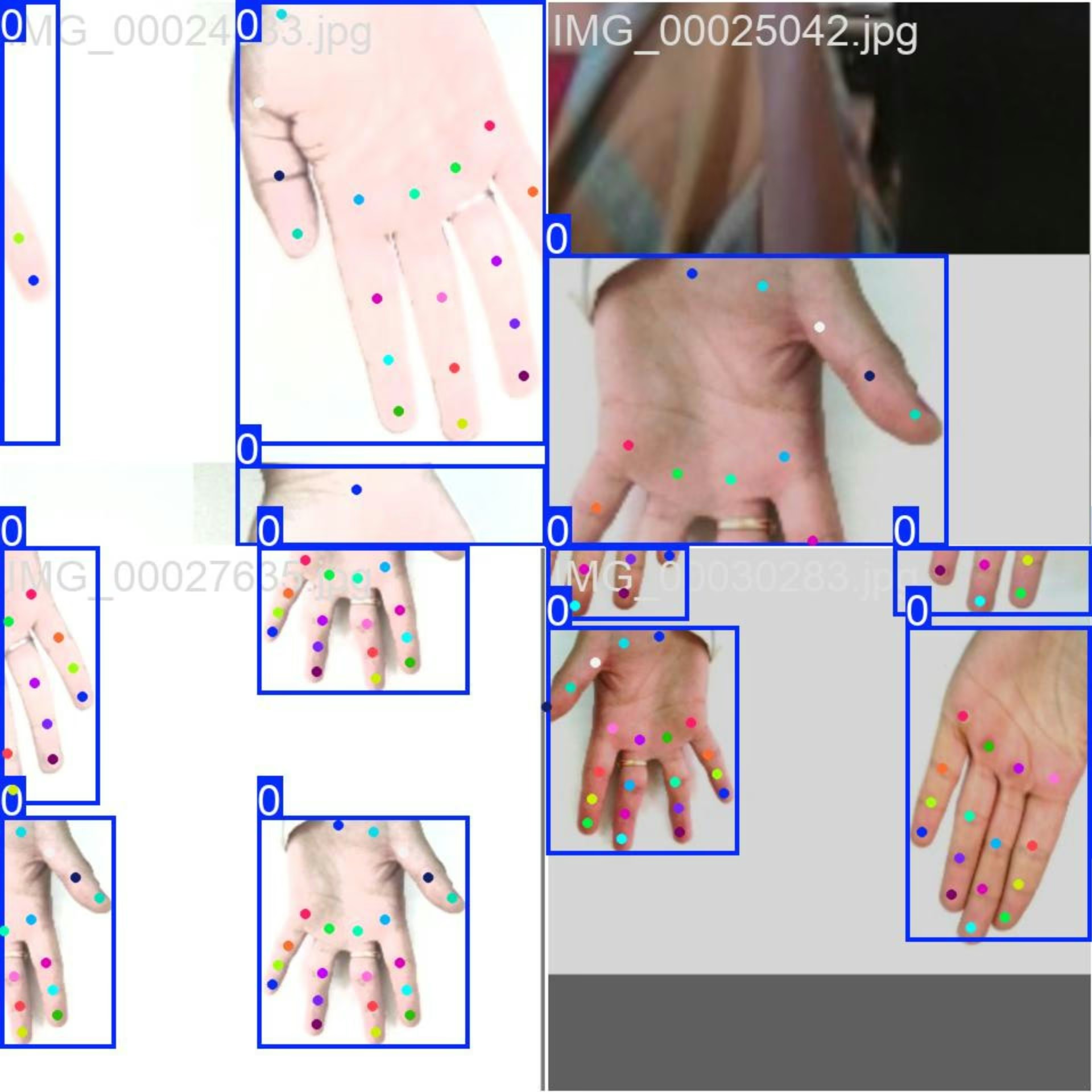

Sample Images 和注释

手部关键点数据集包含一组多样化的图像,其中包含用关键点注释的人手。以下是数据集中图像的一些示例,以及它们对应的注释:

- Mosaiced Image:此图像演示了一个由 mosaiced 数据集图像组成的训练批次。Mosaicing 是一种在训练期间使用的技术,它将多个图像组合成一个图像,以增加每个训练批次中对象和场景的多样性。这有助于提高模型泛化到不同对象大小、纵横比和上下文的能力。

该示例展示了 Hand Keypoints 数据集中图像的多样性和复杂性,以及在训练过程中使用图像拼接的好处。

引用和致谢

如果您在研究或开发工作中使用 hand-keypoints 数据集,请鸣谢以下来源:

感谢以下来源提供本数据集中使用的图像:

这些图像是在每个平台提供的相应许可下收集和使用的,并根据 Creative Commons Attribution-NonCommercial-ShareAlike 4.0 International License 分发。

我们还要感谢此数据集的创建者 Rion Dsilva,他对视觉 AI 研究做出了巨大贡献。

常见问题

如何在手部关键点数据集上训练 YOLO26 模型?

要在手部关键点数据集上训练 YOLO26 模型,您可以使用 Python 或命令行界面 (CLI)。以下是训练 YOLO26n-姿势估计模型 100 个 epoch,图像尺寸为 640 的示例:

示例

from ultralytics import YOLO

# Load a model

model = YOLO("yolo26n-pose.pt") # load a pretrained model (recommended for training)

# Train the model

results = model.train(data="hand-keypoints.yaml", epochs=100, imgsz=640)

# Start training from a pretrained *.pt model

yolo pose train data=hand-keypoints.yaml model=yolo26n-pose.pt epochs=100 imgsz=640

有关可用参数的完整列表,请参阅模型训练页面。

Hand Keypoints 数据集的主要特点是什么?

手部关键点数据集专为高级姿势估计任务而设计,包含以下几个关键特性:

- 大型数据集:包含 26,768 张带有手部关键点注释的图像。

- YOLO26 兼容性:可直接用于 YOLO26 模型。

- 21 个关键点:详细的手部姿势表示,包括手腕和手指关节。

更多详情,您可以浏览手部关键点数据集部分。

哪些应用可以从使用 Hand Keypoints 数据集中受益?

手部关键点数据集可应用于各个领域,包括:

- 手势识别: 增强人机交互。

- AR/VR 控制: 改善增强现实和虚拟现实中的用户体验。

- 机器人操作: 实现对机器人手的精确控制。

- 医疗保健:分析手部动作以进行医学诊断。

- 动画: 捕捉运动以实现逼真的动画。

- 生物识别身份验证: 增强安全系统。

更多信息,请参考应用部分。

Hand Keypoints 数据集的结构是怎样的?

手部关键点数据集分为两个子集:

- 训练:包含 18,776 张图像,用于训练姿势估计模型。

- Val: 包含 7,992 张图像,用于模型训练期间的验证。

这种结构确保了全面的训练和验证过程。有关更多详细信息,请参见数据集结构部分。

如何使用数据集 YAML 文件进行训练?

数据集配置在 YAML 文件中定义,其中包括路径、类和其他相关信息。 hand-keypoints.yaml 文件可以在以下位置找到: 手部关键点.yaml.

要使用此 YAML 文件进行训练,请在您的训练脚本或 CLI 命令中指定它,如上面的训练示例所示。有关更多详细信息,请参阅数据集 YAML部分。