SAM 2: نموذج تقسيم أي شيء 2

تطور SAM

يعتمد SAM 2 على SAM الأصلي مع قدرات تجزئة الفيديو. لتجزئة المفاهيم القابلة للتوجيه باستخدام موجهات أمثلة النص والصور، راجع SAM 3.

SAM 2، خليفة نموذج تقسيم أي شيء (SAM) من Meta، هو أداة متطورة مصممة لتقسيم الكائنات الشامل في كل من الصور ومقاطع الفيديو. يتفوق في التعامل مع البيانات المرئية المعقدة من خلال بنية نموذج موحدة وقابلة للتوجيه تدعم المعالجة في الوقت الفعلي والتعميم بدون تدريب.

الميزات الرئيسية

شاهد: كيفية تشغيل الاستنتاج باستخدام SAM2 الخاص بـ Meta باستخدام Ultralytics | دليل خطوة بخطوة 🎉

هيكلة نموذج موحدة

يجمع SAM 2 بين قدرات تقسيم الصور والفيديو في نموذج واحد. يعمل هذا التوحيد على تبسيط النشر ويسمح بأداء ثابت عبر أنواع الوسائط المختلفة. إنه يستفيد من واجهة مرنة قائمة على المطالبات، مما يتيح للمستخدمين تحديد الكائنات ذات الأهمية من خلال أنواع مطالبات مختلفة، مثل النقاط أو المربعات المحيطة أو الأقنعة.

أداء في الوقت الحقيقي

يحقق النموذج سرعات استدلال في الوقت الفعلي، حيث يعالج ما يقرب من 44 إطارًا في الثانية. وهذا يجعل SAM 2 مناسبًا للتطبيقات التي تتطلب استجابة فورية، مثل تحرير الفيديو والواقع المعزز.

تعميم بدون تلقيم

يمكن لـ SAM 2 تقسيم الأجسام التي لم يسبق له أن واجهها من قبل، مما يدل على تعميم قوي في ظروف لم يتدرب عليها. وهذا مفيد بشكل خاص في المجالات المرئية المتنوعة أو المتطورة حيث قد لا تغطي الفئات المحددة مسبقًا جميع الأجسام الممكنة.

التحسين التفاعلي

يمكن للمستخدمين تحسين نتائج التقسيم بشكل متكرر من خلال تقديم مطالبات إضافية، مما يسمح بتحكم دقيق في الإخراج. هذه التفاعلية ضرورية لضبط النتائج بدقة في تطبيقات مثل ترميز الفيديو أو التصوير الطبي.

معالجة متقدمة للتحديات البصرية

يتضمن SAM 2 آليات لإدارة تحديات تقسيم الفيديو الشائعة، مثل انسداد الجسم وإعادة ظهوره. يستخدم آلية ذاكرة متطورة لتتبع الأجسام عبر الإطارات، مما يضمن الاستمرارية حتى عندما تكون الأجسام محجوبة مؤقتًا أو تخرج ثم تعود إلى المشهد.

لفهم أعمق لهندسة وقدرات SAM 2، استكشف ورقة بحث SAM 2.

الأداء والتفاصيل التقنية

يضع SAM 2 معيارًا جديدًا في هذا المجال، متفوقًا على النماذج السابقة في مختلف المقاييس:

| مقياس (Metric) | SAM 2 | SOTA السابق |

|---|---|---|

| تجزئة الفيديو التفاعلية | الأفضل | - |

| التفاعلات البشرية مطلوبة | أقل بـ 3 مرات | خط الأساس |

| دقة تجزئة الصور | محسّن | SAM |

| سرعة الاستدلال | أسرع 6 مرات | SAM |

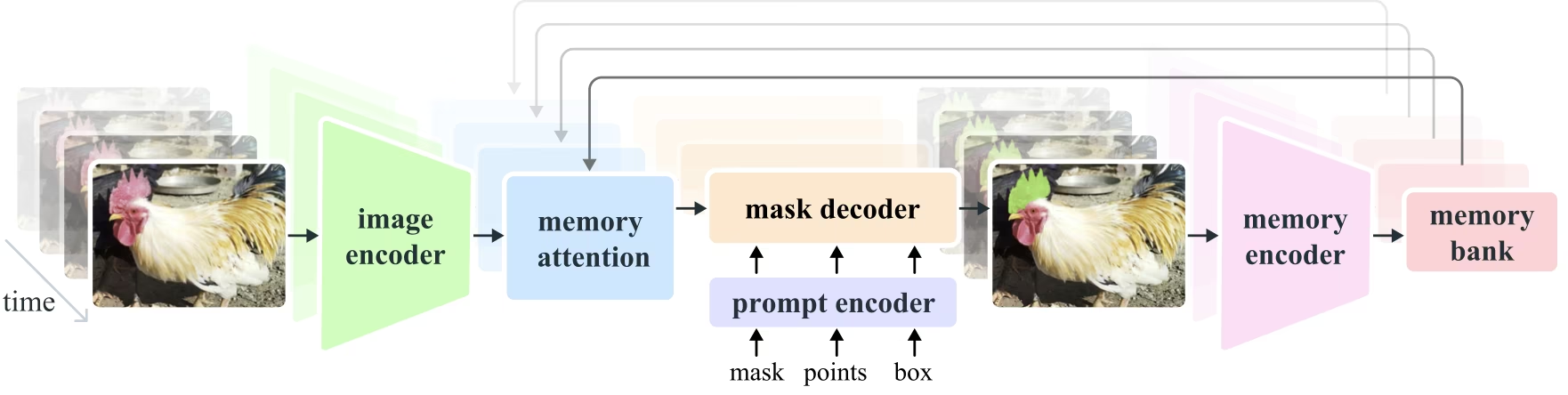

بنية النموذج

المكونات الأساسية

- ترميز الصور والفيديو: يستخدم بنية قائمة على محوّل (transformer) لاستخراج ميزات عالية المستوى من كل من الصور وإطارات الفيديو. هذا المكون مسؤول عن فهم المحتوى المرئي في كل خطوة زمنية.

- ترميز الموجه: يعالج مطالبات المستخدم المقدمة (نقاط، مربعات، أقنعة) لتوجيه مهمة التجزئة. يتيح هذا لـ SAM 2 التكيف مع مدخلات المستخدم واستهداف كائنات معينة داخل المشهد.

- آلية الذاكرة: تتضمن وحدة ترميز الذاكرة، وبنك الذاكرة، ووحدة انتباه الذاكرة. تقوم هذه المكونات بشكل جماعي بتخزين واستخدام المعلومات من الإطارات السابقة، مما يمكّن النموذج من الحفاظ على تتبع الكائنات المتسق بمرور الوقت.

- فك تشفير القناع: يقوم بإنشاء أقنعة التجزئة النهائية بناءً على ميزات الصورة المشفرة والمطالبات. في الفيديو، يستخدم أيضًا سياق الذاكرة لضمان تتبع دقيق عبر الإطارات.

آلية الذاكرة ومعالجة الانسداد

تسمح آلية الذاكرة في SAM 2 بمعالجة التبعيات الزمنية والتداخلات في بيانات الفيديو. فمع حركة الأجسام وتفاعلها، يسجل SAM 2 ميزاتها في بنك ذاكرة. وعندما يتم حجب جسم ما، يمكن للنموذج الاعتماد على هذه الذاكرة للتنبؤ بموضعه ومظهره عند ظهوره مرة أخرى. ويتعامل رأس الانسداد تحديدًا مع السيناريوهات التي تكون فيها الأجسام غير مرئية، ويتنبأ باحتمالية حجب الجسم.

حل الغموض متعدد الأقنعة

في الحالات التي يوجد فيها غموض (على سبيل المثال، الكائنات المتداخلة)، يمكن لـ SAM 2 إنشاء تنبؤات متعددة للقناع. هذه الميزة ضرورية لتمثيل المشاهد المعقدة بدقة حيث قد لا يصف قناع واحد بدقة تفاصيل المشهد.

مجموعة بيانات SA-V

تعد مجموعة بيانات SA-V، التي تم تطويرها لتدريب SAM 2، واحدة من أكبر مجموعات بيانات تجزئة الفيديو وأكثرها تنوعًا المتاحة. وهي تشمل:

- أكثر من 51,000 مقطع فيديو: تم التقاطها في 47 دولة، مما يوفر مجموعة واسعة من السيناريوهات الواقعية.

- أكثر من 600,000 ترميز للقناع: ترميزات قناع زمانية مكانية مفصلة، يشار إليها بـ "masklets"، تغطي الكائنات والأجزاء بأكملها.

- حجم مجموعة البيانات: يتميز بـ 4.5 أضعاف مقاطع الفيديو و 53 ضعفًا من التعليقات التوضيحية مقارنة بأكبر مجموعات البيانات السابقة، مما يوفر تنوعًا وتعقيدًا غير مسبوقين.

المعايير

تقسيم كائنات الفيديو

أظهر SAM 2 أداءً فائقًا عبر معايير تقسيم الفيديو الرئيسية:

| مجموعة البيانات | J&F | J | F |

|---|---|---|---|

| DAVIS 2017 | 82.5 | 79.8 | 85.2 |

| YouTube-VOS | 81.2 | 78.9 | 83.5 |

التجزئة التفاعلية

في مهام التجزئة التفاعلية، يُظهر SAM 2 كفاءة ودقة كبيرتين:

| مجموعة البيانات | NoC@90 | AUC |

|---|---|---|

| DAVIS Interactive | 1.54 | 0.872 |

التثبيت

لتثبيت SAM 2، استخدم الأمر التالي. سيتم تنزيل جميع نماذج SAM 2 تلقائيًا عند الاستخدام الأول.

pip install ultralytics

كيفية استخدام SAM 2: تعدد الاستخدامات في تجزئة الصور والفيديو

يوضح الجدول التالي تفاصيل نماذج SAM 2 المتاحة، وأوزانها المدربة مسبقًا، والمهام المدعومة، والتوافق مع أوضاع التشغيل المختلفة مثل الاستدلال، والتحقق، والتدريب، والتصدير.

| نوع النموذج | الأوزان المدربة مسبقًا | المهام المدعومة | الاستدلال | التحقق | التدريب | تصدير |

|---|---|---|---|---|---|---|

| SAM 2 ضئيل | sam2_t.pt | تجزئة المثيل | ✅ | ❌ | ❌ | ❌ |

| SAM 2 صغير | sam2_s.pt | تجزئة المثيل | ✅ | ❌ | ❌ | ❌ |

| الأساس في SAM 2 | sam2_b.pt | تجزئة المثيل | ✅ | ❌ | ❌ | ❌ |

| SAM 2 كبير | sam2_l.pt | تجزئة المثيل | ✅ | ❌ | ❌ | ❌ |

| SAM 2.1 ضئيل | sam2.1_t.pt | تجزئة المثيل | ✅ | ❌ | ❌ | ❌ |

| SAM 2.1 صغير | sam2.1_s.pt | تجزئة المثيل | ✅ | ❌ | ❌ | ❌ |

| SAM 2.1 أساسي | sam2.1_b.pt | تجزئة المثيل | ✅ | ❌ | ❌ | ❌ |

| SAM 2.1 كبير | sam2.1_l.pt | تجزئة المثيل | ✅ | ❌ | ❌ | ❌ |

أمثلة لتوقعات SAM 2

يمكن استخدام SAM 2 في نطاق واسع من المهام، بما في ذلك تحرير الفيديو في الوقت الفعلي، والتصوير الطبي، والأنظمة المستقلة. إن قدرته على تقسيم البيانات المرئية الثابتة والديناميكية تجعله أداة متعددة الاستخدامات للباحثين والمطورين.

التقسيم باستخدام المطالبات

التقسيم باستخدام المطالبات

استخدم المطالبات لتقطيع كائنات معينة في الصور أو مقاطع الفيديو.

from ultralytics import SAM

# Load a model

model = SAM("sam2.1_b.pt")

# Display model information (optional)

model.info()

# Run inference with bboxes prompt

results = model("path/to/image.jpg", bboxes=[100, 100, 200, 200])

# Run inference with single point

results = model(points=[900, 370], labels=[1])

# Run inference with multiple points

results = model(points=[[400, 370], [900, 370]], labels=[1, 1])

# Run inference with multiple points prompt per object

results = model(points=[[[400, 370], [900, 370]]], labels=[[1, 1]])

# Run inference with negative points prompt

results = model(points=[[[400, 370], [900, 370]]], labels=[[1, 0]])

تقسيم كل شيء

تقسيم كل شيء

تقسيم الصورة بأكملها أو محتوى الفيديو بدون مطالبات محددة.

from ultralytics import SAM

# Load a model

model = SAM("sam2.1_b.pt")

# Display model information (optional)

model.info()

# Run inference

model("path/to/video.mp4")

# Run inference with a SAM 2 model

yolo predict model=sam2.1_b.pt source=path/to/video.mp4

تقسيم الفيديو وتتبع الكائنات

تقسيم الفيديو

قم بتقسيم محتوى الفيديو بالكامل باستخدام مطالبات محددة و track الأجسام.

from ultralytics.models.sam import SAM2VideoPredictor

# Create SAM2VideoPredictor

overrides = dict(conf=0.25, task="segment", mode="predict", imgsz=1024, model="sam2_b.pt")

predictor = SAM2VideoPredictor(overrides=overrides)

# Run inference with single point

results = predictor(source="test.mp4", points=[920, 470], labels=[1])

# Run inference with multiple points

results = predictor(source="test.mp4", points=[[920, 470], [909, 138]], labels=[1, 1])

# Run inference with multiple points prompt per object

results = predictor(source="test.mp4", points=[[[920, 470], [909, 138]]], labels=[[1, 1]])

# Run inference with negative points prompt

results = predictor(source="test.mp4", points=[[[920, 470], [909, 138]]], labels=[[1, 0]])

- يوضح هذا المثال كيف يمكن استخدام SAM 2 لتقسيم المحتوى الكامل للصورة أو الفيديو إذا لم يتم تقديم أي مطالبات (bboxes/نقاط/أقنعة).

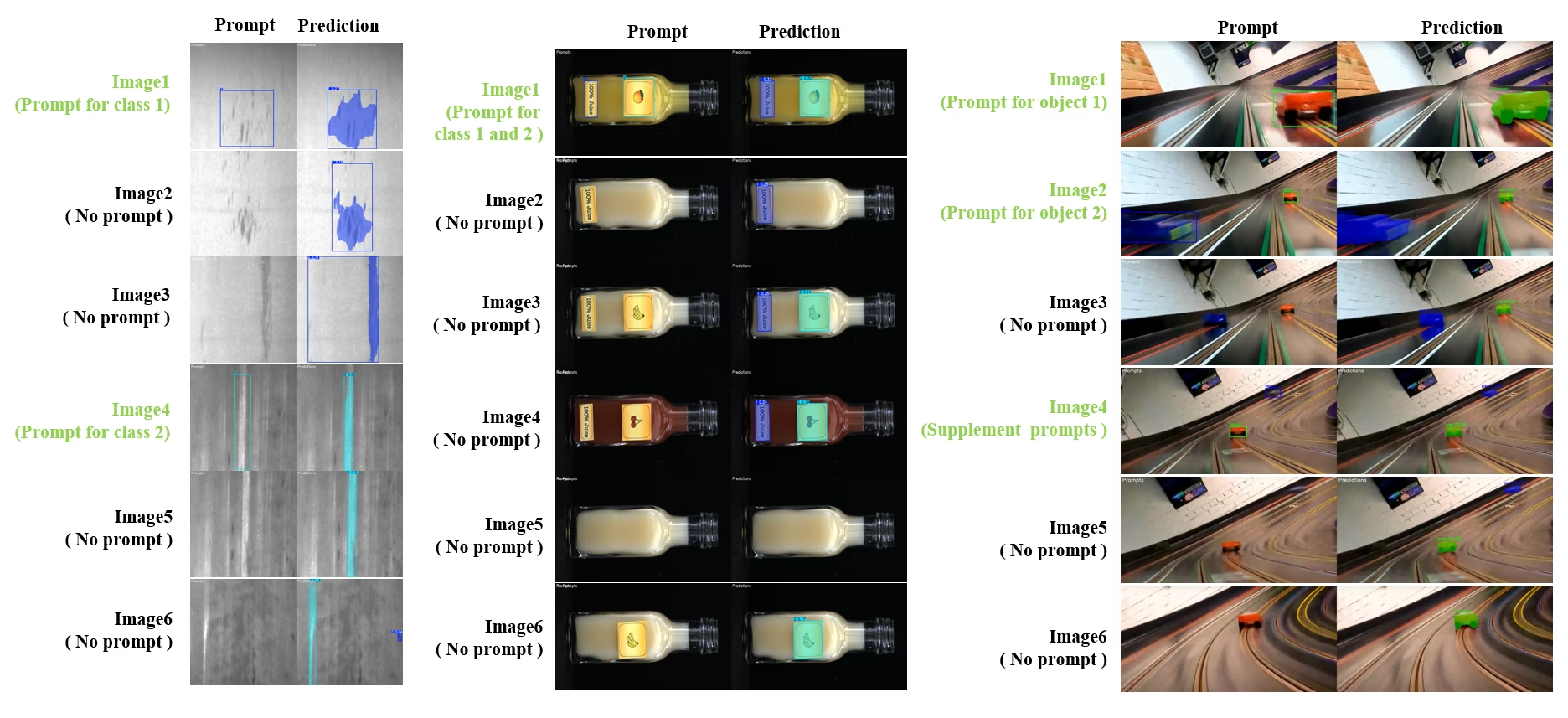

تجزئة وتتبع تفاعلي ديناميكي

SAM2DynamicInteractivePredictor هو امتداد متقدم لـ SAM2 لا يتطلب تدريبًا، ويمكّن التفاعل الديناميكي مع إطارات متعددة وقدرات التعلم المستمر. يدعم هذا المتنبئ تحديثات الموجهات في الوقت الفعلي وإدارة الذاكرة لتحسين أداء التتبع عبر تسلسل من الصور. مقارنةً بـ SAM2 الأصلي، يعيد SAM2DynamicInteractivePredictor بناء تدفق الاستدلال للاستفادة القصوى من نماذج SAM2 المدربة مسبقًا دون الحاجة إلى تدريب إضافي.

الميزات الرئيسية

يوفر ثلاثة تحسينات كبيرة:

- تفاعل ديناميكي: إضافة مطالبات جديدة لدمج / تتبع الحالات الجديدة غير المتعقبة في الإطارات التالية في أي وقت أثناء معالجة الفيديو

- التعلم المستمر: أضف مطالبات جديدة للمثيلات الحالية لتحسين أداء النموذج بمرور الوقت

- دعم مستقل للصور المتعددة: معالجة صور مستقلة متعددة (ليست بالضرورة من تسلسل فيديو) مع مشاركة الذاكرة وتتبع الكائنات عبر الصور

القدرات الأساسية

- مرونة المطالبة: يقبل مربعات الإحاطة والنقاط والأقنعة كمطالبات

- إدارة بنك الذاكرة: يحتفظ ببنك ذاكرة ديناميكي لتخزين حالات الكائنات عبر الإطارات

- تتبع متعدد الكائنات: يدعم تتبع كائنات متعددة في وقت واحد بمعرفات كائنات فردية

- تحديثات آنية: يسمح بإضافة مطالبات جديدة أثناء الاستدلال دون إعادة معالجة الإطارات السابقة

- معالجة صور مستقلة: معالجة الصور المستقلة مع سياق الذاكرة المشتركة لاتساق الكائنات عبر الصور

إضافة كائنات ديناميكية

from ultralytics.models.sam import SAM2DynamicInteractivePredictor

# Create SAM2DynamicInteractivePredictor

overrides = dict(conf=0.01, task="segment", mode="predict", imgsz=1024, model="sam2_t.pt", save=False)

predictor = SAM2DynamicInteractivePredictor(overrides=overrides, max_obj_num=10)

# Define a category by box prompt

predictor(source="image1.jpg", bboxes=[[100, 100, 200, 200]], obj_ids=[0], update_memory=True)

# Detect this particular object in a new image

results = predictor(source="image2.jpg")

# Add new category with a new object ID

results = predictor(

source="image4.jpg",

bboxes=[[300, 300, 400, 400]], # New object

obj_ids=[1], # New object ID

update_memory=True, # Add to memory

)

# Perform inference

results = predictor(source="image5.jpg")

# Add refinement prompts to the same category to boost performance

# This helps when object appearance changes significantly

results = predictor(

source="image6.jpg",

points=[[150, 150]], # Refinement point

labels=[1], # Positive point

obj_ids=[1], # Same object ID

update_memory=True, # Update memory with new information

)

# Perform inference on new image

results = predictor(source="image7.jpg")

ملاحظة

في SAM2DynamicInteractivePredictor مصمم للعمل مع نماذج SAM2، ويدعم إضافة / تحسين الفئات بواسطة جميع مطالبات المربع/النقطة/القناع أصليًا يدعم SAM2. وهو مفيد بشكل خاص في السيناريوهات التي تظهر فيها الكائنات أو تتغير بمرور الوقت، كما هو الحال في مهام ترميز الفيديو أو التحرير التفاعلي.

الوسائط

| الاسم | القيمة الافتراضية | نوع البيانات | الوصف |

|---|---|---|---|

max_obj_num | 3 | int | العدد الأقصى المحدد مسبقًا للفئات |

update_memory | False | bool | ما إذا كان سيتم تحديث الذاكرة بمطالبات جديدة |

obj_ids | None | List[int] | قائمة بمعرفات الكائنات المطابقة للمطالبات |

حالات الاستخدام

SAM2DynamicInteractivePredictor مثالي لـ:

- سير عمل ترميز الفيديو حيث تظهر كائنات جديدة أثناء التسلسل

- تحرير الفيديو التفاعلي الذي يتطلب إضافة الكائنات وتحسينها في الوقت الفعلي

- تطبيقات المراقبة التي تحتاج إلى تتبع الأجسام بشكل ديناميكي

- التصوير الطبي لـ track الهياكل التشريحية عبر السلاسل الزمنية

- الأنظمة الذاتية التي تتطلب detect وتتبع الأجسام التكيفي

- مجموعات البيانات متعددة الصور لتقسيم الكائنات باستمرار عبر صور مستقلة

- تحليل مجموعة الصور حيث يجب تتبع الكائنات عبر مشاهد مختلفة

- تقسيم عبر المجالات (Cross-domain segmentation) يستفيد من الذاكرة من سياقات صور متنوعة

- شرح توضيحي شبه تلقائي لإنشاء مجموعة بيانات فعالة بأقل تدخل يدوي

مقارنة SAM 2 مقابل YOLO

نقارن هنا نماذج SAM 2 الخاصة بـ Meta، بما في ذلك أصغر متغير SAM2-t، مع أصغر نموذج segment من Ultralytics، YOLO11n-seg:

| النموذج | الحجم (ميجابايت) | المعلمات (M) | السرعة (وحدة المعالجة المركزية (CPU)) (بالمللي ثانية/صورة) |

|---|---|---|---|

| Meta SAM-b | 375 | 93.7 | 49401 |

| Meta SAM2-b | 162 | 80.8 | 31901 |

| Meta SAM2-t | 78.1 | 38.9 | 25997 |

| MobileSAM | 40.7 | 10.1 | 25381 |

| FastSAM-s مع العمود الفقري لـ YOLOv8 | 23.7 | 11.8 | 55.9 |

| Ultralytics YOLOv8n-seg | 6.7 (أصغر بـ 11.7 مرة) | 3.4 (أقل بـ 11.4 مرة) | 24.5 (أسرع بـ 1061 مرة) |

| Ultralytics YOLO11n-seg | 5.9 (أصغر بـ 13.2 مرة) | 2.9 (أقل بـ 13.4 مرة) | 30.1 (أسرع بـ 864 مرة) |

توضح هذه المقارنة الاختلافات الكبيرة في أحجام النماذج وسرعاتها بين متغيرات SAM ونماذج تجزئة YOLO. بينما يوفر SAM قدرات تجزئة تلقائية فريدة، فإن نماذج YOLO، وخاصة YOLOv8n-seg و YOLO11n-seg، أصغر وأسرع وأكثر كفاءة من الناحية الحسابية.

يتم تشغيل الاختبارات على جهاز 2025 Apple M4 Pro بذاكرة وصول عشوائي (RAM) سعة 24 جيجابايت باستخدام torch==2.6.0 و ultralytics==8.3.90. لإعادة إنتاج هذا الاختبار:

مثال

from ultralytics import ASSETS, SAM, YOLO, FastSAM

# Profile SAM2-t, SAM2-b, SAM-b, MobileSAM

for file in ["sam_b.pt", "sam2_b.pt", "sam2_t.pt", "mobile_sam.pt"]:

model = SAM(file)

model.info()

model(ASSETS)

# Profile FastSAM-s

model = FastSAM("FastSAM-s.pt")

model.info()

model(ASSETS)

# Profile YOLO models

for file_name in ["yolov8n-seg.pt", "yolo11n-seg.pt"]:

model = YOLO(file_name)

model.info()

model(ASSETS)

الترميز التلقائي: إنشاء مجموعة بيانات فعالة

التسمية التلقائية هي ميزة قوية في SAM 2، تمكّن المستخدمين من إنشاء مجموعات بيانات تجزئة بسرعة ودقة من خلال الاستفادة من النماذج المدربة مسبقًا. هذه القدرة مفيدة بشكل خاص لإنشاء مجموعات بيانات كبيرة وعالية الجودة دون جهد يدوي مكثف.

كيفية التعليق التلقائي باستخدام SAM 2

شاهد: الترميز التلقائي باستخدام نموذج تجزئة أي شيء 2 الخاص بـ Meta باستخدام Ultralytics | ترميز البيانات

لترميز البيانات تلقائيًا باستخدام SAM 2، اتبع هذا المثال:

مثال على الترميز التلقائي

from ultralytics.data.annotator import auto_annotate

auto_annotate(data="path/to/images", det_model="yolo11x.pt", sam_model="sam2_b.pt")

| الوسيطة | النوع | افتراضي | الوصف |

|---|---|---|---|

data | str | مطلوب | مسار الدليل الذي يحتوي على الصور المستهدفة للشرح أو التجزئة. |

det_model | str | 'yolo26x.pt' | مسار نموذج الكشف عن YOLO للكشف الأولي عن الكائنات. |

sam_model | str | 'sam_b.pt' | مسار نموذج SAM للتجزئة (يدعم نماذج SAM و SAM2 و MobileSAM). |

device | str | '' | جهاز الحساب (مثل، 'cuda:0'، 'cpu'، أو '' للكشف التلقائي عن الجهاز). |

conf | float | 0.25 | عتبة الثقة للكشف عن YOLO لتصفية الاكتشافات الضعيفة. |

iou | float | 0.45 | عتبة IoU لـ Non-Maximum Suppression لتصفية الصناديق المتداخلة. |

imgsz | int | 640 | حجم الإدخال لتغيير حجم الصور (يجب أن يكون من مضاعفات 32). |

max_det | int | 300 | الحد الأقصى لعدد الاكتشافات لكل صورة لتحقيق كفاءة الذاكرة. |

classes | list[int] | None | قائمة بمؤشرات الفئات المراد اكتشافها (على سبيل المثال، [0, 1] (للأشخاص والدراجات) . |

output_dir | str | None | حفظ الدليل التلقائي للتعليقات التوضيحية (افتراضيا './labels' بالنسبة لمسار البيانات). |

تسهل هذه الوظيفة الإنشاء السريع لمجموعات بيانات تجزئة عالية الجودة، وهي مثالية للباحثين والمطورين الذين يهدفون إلى تسريع مشاريعهم.

القيود

على الرغم من نقاط قوته، إلا أن SAM 2 لديه بعض القيود:

- استقرار التتبع: قد يفقد SAM 2 تتبع الكائنات أثناء التسلسلات الممتدة أو التغييرات الكبيرة في وجهة النظر.

- التباس الكائنات: يمكن للنموذج في بعض الأحيان أن يخلط بين الكائنات المتشابهة، خاصة في المشاهد المزدحمة.

- الكفاءة مع كائنات متعددة: تنخفض كفاءة التقسيم عند معالجة كائنات متعددة في وقت واحد بسبب نقص التواصل بين الكائنات.

- تفاصيل الدقة: قد تفوت التفاصيل الدقيقة، خاصة مع الأجسام سريعة الحركة. يمكن للمطالبات الإضافية معالجة هذه المشكلة جزئيًا، ولكن النعومة الزمنية ليست مضمونة.

الاقتباسات والإقرارات

إذا كان SAM 2 جزءًا أساسيًا من عملك البحثي أو التطويري، فيرجى الاستشهاد به باستخدام المرجع التالي:

@article{ravi2024sam2,

title={SAM 2: Segment Anything in Images and Videos},

author={Ravi, Nikhila and Gabeur, Valentin and Hu, Yuan-Ting and Hu, Ronghang and Ryali, Chaitanya and Ma, Tengyu and Khedr, Haitham and R{\"a}dle, Roman and Rolland, Chloe and Gustafson, Laura and Mintun, Eric and Pan, Junting and Alwala, Kalyan Vasudev and Carion, Nicolas and Wu, Chao-Yuan and Girshick, Ross and Doll{\'a}r, Piotr and Feichtenhofer, Christoph},

journal={arXiv preprint},

year={2024}

}

نعرب عن امتناننا لـ Meta AI لمساهماتهم في مجتمع الذكاء الاصطناعي بهذا النموذج ومجموعة البيانات الرائدة.

الأسئلة الشائعة

ما هو SAM 2 وكيف يحسن من نموذج تجزئة أي شيء الأصلي (SAM)؟

SAM 2، خليفة نموذج تقسيم أي شيء (SAM) من Meta، هو أداة متطورة مصممة لتقسيم الكائنات الشامل في كل من الصور ومقاطع الفيديو. يتفوق في التعامل مع البيانات المرئية المعقدة من خلال بنية نموذج موحدة وقابلة للتوجيه تدعم المعالجة في الوقت الفعلي والتعميم بدون تدريب. يقدم SAM 2 العديد من التحسينات على SAM الأصلي، بما في ذلك:

- بنية نموذج موحدة: تجمع بين إمكانات تجزئة الصور والفيديو في نموذج واحد.

- أداء في الوقت الفعلي: يعالج ما يقرب من 44 إطارًا في الثانية، مما يجعله مناسبًا للتطبيقات التي تتطلب ملاحظات فورية.

- تعميم بدون تدريب: يقوم بتقسيم الأجسام التي لم يسبق له رؤيتها، وهو مفيد في المجالات البصرية المتنوعة.

- التحسين التفاعلي: يسمح للمستخدمين بتحسين نتائج التقسيم بشكل متكرر من خلال تقديم مطالبات إضافية.

- معالجة متقدمة للتحديات البصرية: يدير تحديات تجزئة الفيديو الشائعة مثل انسداد الكائن وإعادة ظهوره.

لمزيد من التفاصيل حول بنية وقدرات SAM 2، استكشف ورقة بحث SAM 2.

كيف يمكنني استخدام SAM 2 لتقسيم الفيديو في الوقت الفعلي؟

يمكن استخدام SAM 2 لتقسيم الفيديو في الوقت الفعلي من خلال الاستفادة من واجهته القابلة للإعداد وقدرات الاستدلال في الوقت الفعلي. إليك مثال أساسي:

التقسيم باستخدام المطالبات

استخدم المطالبات لتقطيع كائنات معينة في الصور أو مقاطع الفيديو.

from ultralytics import SAM

# Load a model

model = SAM("sam2_b.pt")

# Display model information (optional)

model.info()

# Segment with bounding box prompt

results = model("path/to/image.jpg", bboxes=[100, 100, 200, 200])

# Segment with point prompt

results = model("path/to/image.jpg", points=[150, 150], labels=[1])

للاستخدام الأكثر شمولاً، راجع قسم كيفية استخدام SAM 2.

ما هي مجموعات البيانات المستخدمة لتدريب SAM 2، وكيف تعزز أداءه؟

تم تدريب SAM 2 على مجموعة بيانات SA-V، وهي واحدة من أكبر مجموعات بيانات تجزئة الفيديو وأكثرها تنوعًا. تتضمن مجموعة بيانات SA-V:

- أكثر من 51,000 مقطع فيديو: تم التقاطها في 47 دولة، مما يوفر مجموعة واسعة من السيناريوهات الواقعية.

- أكثر من 600,000 ترميز للقناع: ترميزات قناع زمانية مكانية مفصلة، يشار إليها بـ "masklets"، تغطي الكائنات والأجزاء بأكملها.

- حجم مجموعة البيانات: يتميز بـ 4.5 أضعاف مقاطع الفيديو و 53 ضعفًا من التعليقات التوضيحية مقارنة بأكبر مجموعات البيانات السابقة، مما يوفر تنوعًا وتعقيدًا غير مسبوقين.

تسمح مجموعة البيانات الشاملة هذه لـ SAM 2 بتحقيق أداء فائق عبر معايير تجزئة الفيديو الرئيسية وتعزيز قدرات التعميم الخاصة به دون الحاجة إلى تدريب. لمزيد من المعلومات، راجع قسم مجموعة بيانات SA-V.

كيف يتعامل SAM 2 مع الانسدادات وإعادة ظهور الكائنات في تجزئة الفيديو؟

يتضمن SAM 2 آلية ذاكرة متطورة لإدارة التبعيات الزمنية والانسدادات في بيانات الفيديو. تتكون آلية الذاكرة من:

- مشفر الذاكرة وبنك الذاكرة: يخزن ميزات من الإطارات السابقة.

- وحدة انتباه الذاكرة: تستخدم المعلومات المخزنة للحفاظ على تتبع الكائنات المتسق بمرور الوقت.

- Occlusion Head: يعالج على وجه التحديد السيناريوهات التي تكون فيها الكائنات غير مرئية، ويتوقع احتمالية إخفاء الكائن.

تضمن هذه الآلية الاستمرارية حتى عندما يتم حجب الأجسام مؤقتًا أو تخرج ثم تعود إلى المشهد. لمزيد من التفاصيل، راجع قسم آلية الذاكرة والتعامل مع الانسداد.

كيف تتم مقارنة SAM 2 بنماذج التجزئة الأخرى مثل YOLO11؟

توفر نماذج SAM 2، مثل SAM2-t و SAM2-b من Meta، إمكانات تقسيم قوية في ظروف لم يتدرب عليها ولكنهما أكبر وأبطأ بكثير مقارنة بنماذج YOLO11. على سبيل المثال، YOLO11n-segment أصغر بحوالي 13 مرة وأسرع بأكثر من 860 مرة من SAM2-b. في حين أن SAM 2 يتفوق في سيناريوهات التقسيم متعددة الاستخدامات والقائمة على المطالبات وتلك التي لم يتدرب عليها، فإن YOLO11 مُحسَّن للسرعة والكفاءة والتطبيقات في الوقت الفعلي، مما يجعله أكثر ملاءمة للنشر في البيئات محدودة الموارد.