COCO128 Datensatz

Einführung

Ultralytics COCO128 ist ein kleiner, aber vielseitiger object detection-Datensatz, der aus den ersten 128 Bildern des COCO Train 2017-Sets besteht. Dieser Datensatz ist ideal zum Testen und Debuggen von Object Detection-Modellen oder zum Experimentieren mit neuen Detektionsansätzen. Mit 128 Bildern ist er klein genug, um leicht verwaltet werden zu können, aber dennoch vielfältig genug, um Trainingspipelines auf Fehler zu testen und als Plausibilitätsprüfung vor dem Training mit größeren Datensätzen zu dienen.

Ansehen: Ultralytics COCO Datensatz-Übersicht

Dieser Datensatz ist für die Verwendung mit Ultralytics Platform und YOLO26 vorgesehen.

Datensatz-YAML

Eine YAML (Yet Another Markup Language)-Datei wird verwendet, um die Dataset-Konfiguration zu definieren. Sie enthält Informationen über die Pfade, Klassen und andere relevante Informationen des Datasets. Im Falle des COCO128-Datasets, coco128.yaml Datei wird verwaltet unter https://github.com/ultralytics/ultralytics/blob/main/ultralytics/cfg/datasets/coco128.yaml.

Ultralytics/cfg/datasets/COCO128.yaml

# Ultralytics 🚀 AGPL-3.0 License - https://ultralytics.com/license

# COCO128 dataset https://www.kaggle.com/datasets/ultralytics/coco128 (first 128 images from COCO train2017) by Ultralytics

# Documentation: https://docs.ultralytics.com/datasets/detect/coco/

# Example usage: yolo train data=coco128.yaml

# parent

# ├── ultralytics

# └── datasets

# └── coco128 ← downloads here (7 MB)

# Train/val/test sets as 1) dir: path/to/imgs, 2) file: path/to/imgs.txt, or 3) list: [path/to/imgs1, path/to/imgs2, ..]

path: coco128 # dataset root dir

train: images/train2017 # train images (relative to 'path') 128 images

val: images/train2017 # val images (relative to 'path') 128 images

test: # test images (optional)

# Classes

names:

0: person

1: bicycle

2: car

3: motorcycle

4: airplane

5: bus

6: train

7: truck

8: boat

9: traffic light

10: fire hydrant

11: stop sign

12: parking meter

13: bench

14: bird

15: cat

16: dog

17: horse

18: sheep

19: cow

20: elephant

21: bear

22: zebra

23: giraffe

24: backpack

25: umbrella

26: handbag

27: tie

28: suitcase

29: frisbee

30: skis

31: snowboard

32: sports ball

33: kite

34: baseball bat

35: baseball glove

36: skateboard

37: surfboard

38: tennis racket

39: bottle

40: wine glass

41: cup

42: fork

43: knife

44: spoon

45: bowl

46: banana

47: apple

48: sandwich

49: orange

50: broccoli

51: carrot

52: hot dog

53: pizza

54: donut

55: cake

56: chair

57: couch

58: potted plant

59: bed

60: dining table

61: toilet

62: tv

63: laptop

64: mouse

65: remote

66: keyboard

67: cell phone

68: microwave

69: oven

70: toaster

71: sink

72: refrigerator

73: book

74: clock

75: vase

76: scissors

77: teddy bear

78: hair drier

79: toothbrush

# Download script/URL (optional)

download: https://github.com/ultralytics/assets/releases/download/v0.0.0/coco128.zip

Nutzung

Um ein YOLO26n-Modell auf dem COCO128-Datensatz für 100 Epochen mit einer Bildgröße von 640 zu trainieren, können Sie die folgenden Code-Snippets verwenden. Eine umfassende Liste der verfügbaren Argumente finden Sie auf der Trainingsseite des Modells.

Trainingsbeispiel

from ultralytics import YOLO

# Load a model

model = YOLO("yolo26n.pt") # load a pretrained model (recommended for training)

# Train the model

results = model.train(data="coco128.yaml", epochs=100, imgsz=640)

# Start training from a pretrained *.pt model

yolo detect train data=coco128.yaml model=yolo26n.pt epochs=100 imgsz=640

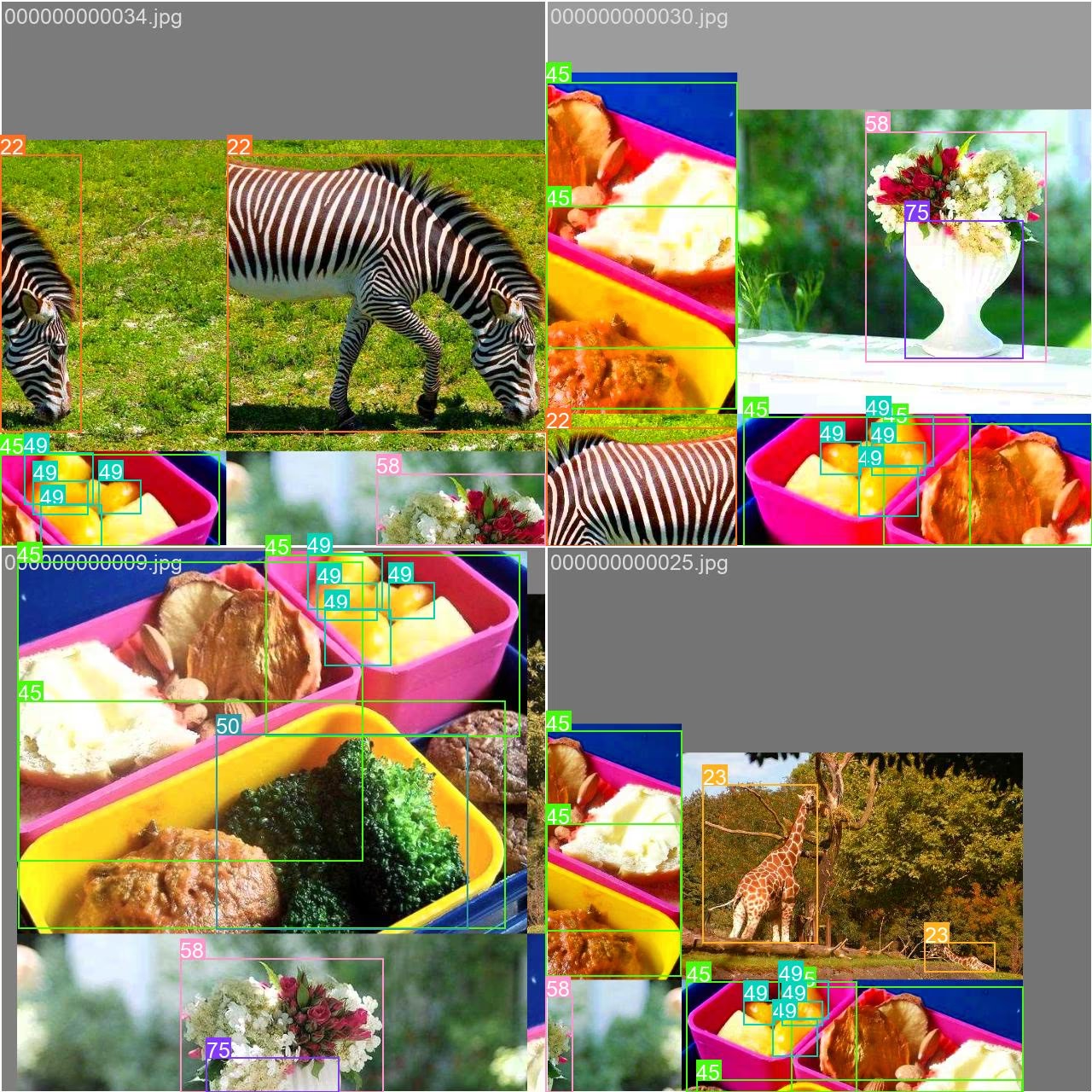

sample_images und Anmerkungen

Hier sind einige Beispiele von Bildern aus dem COCO128-Datensatz, zusammen mit ihren entsprechenden Annotationen:

- Mosaikbild: Dieses Bild zeigt einen Trainings-Batch, der aus Mosaik-Datensatzbildern besteht. Mosaicing ist eine Technik, die während des Trainings verwendet wird und mehrere Bilder zu einem einzigen Bild kombiniert, um die Vielfalt der Objekte und Szenen innerhalb jedes Trainings-Batch zu erhöhen. Dies trägt dazu bei, die Fähigkeit des Modells zu verbessern, auf verschiedene Objektgrößen, Seitenverhältnisse und Kontexte zu generalisieren.

Das Beispiel veranschaulicht die Vielfalt und Komplexität der Bilder im COCO128-Datensatz sowie die Vorteile der Verwendung von Mosaicing während des Trainingsprozesses.

Zitate und Danksagungen

Wenn Sie den COCO-Datensatz in Ihrer Forschungs- oder Entwicklungsarbeit verwenden, zitieren Sie bitte das folgende Paper:

@misc{lin2015microsoft,

title={Microsoft COCO: Common Objects in Context},

author={Tsung-Yi Lin and Michael Maire and Serge Belongie and Lubomir Bourdev and Ross Girshick and James Hays and Pietro Perona and Deva Ramanan and C. Lawrence Zitnick and Piotr Dollár},

year={2015},

eprint={1405.0312},

archivePrefix={arXiv},

primaryClass={cs.CV}

}

Wir möchten dem COCO Consortium für die Erstellung und Pflege dieser wertvollen Ressource für die Computer-Vision-Community danken. Weitere Informationen zum COCO-Datensatz und seinen Erstellern finden Sie auf der COCO-Datensatz-Website.

FAQ

Wofür wird der Ultralytics COCO128-Datensatz verwendet?

Der Ultralytics COCO128-Datensatz ist eine kompakte Untermenge, die die ersten 128 Bilder aus dem COCO train 2017 Datensatz enthält. Er wird hauptsächlich zum Testen und Debuggen von Objekterkennungsmodellen, zum Experimentieren mit neuen Erkennungsansätzen und zur Validierung von Trainingspipelines verwendet, bevor auf größere Datensätze skaliert wird. Seine überschaubare Größe macht ihn perfekt für schnelle Iterationen, während er dennoch genügend Vielfalt bietet, um ein aussagekräftiger Testfall zu sein.

Wie trainiere ich ein YOLO26-Modell mit dem COCO128-Datensatz?

Um ein YOLO26-Modell auf dem COCO128-Datensatz zu trainieren, können Sie entweder Python- oder CLI-Befehle verwenden. So geht's:

Trainingsbeispiel

from ultralytics import YOLO

# Load a pretrained model

model = YOLO("yolo26n.pt")

# Train the model

results = model.train(data="coco128.yaml", epochs=100, imgsz=640)

yolo detect train data=coco128.yaml model=yolo26n.pt epochs=100 imgsz=640

Weitere Trainingsoptionen und -parameter finden Sie in der Trainingsdokumentation.

Welche Vorteile bietet die Verwendung von Mosaic Augmentation mit COCO128?

Die Mosaic-Augmentierung, wie in den sample_images gezeigt, kombiniert mehrere Trainingsbilder zu einem einzigen Kompositbild. Diese Technik bietet mehrere Vorteile beim Training mit COCO128:

- Erhöht die Vielfalt der Objekte und Kontexte innerhalb jedes Trainings-Batches

- Verbessert die Modellgeneralisierung über verschiedene Objektgrößen und Seitenverhältnisse hinweg

- Verbessert die Erkennungsleistung für Objekte unterschiedlicher Größe

- Maximiert den Nutzen eines kleinen Datensatzes, indem vielfältigere Trainingsbeispiele erstellt werden

Diese Technik ist besonders wertvoll für kleinere Datensätze wie COCO128 und hilft Modellen, robustere Merkmale aus begrenzten Daten zu lernen.

Wie vergleicht sich COCO128 mit anderen COCO-Datensatzvarianten?

COCO128 (128 Bilder) liegt größenmäßig zwischen COCO8 (8 Bildern) und dem vollständigen COCO-Datensatz (über 118.000 Bilder):

- COCO8: Enthält nur 8 Bilder (4 Training, 4 Validierung) – ideal für schnelle Tests und Debugging.

- COCO128: Enthält 128 Bilder – ausgewogen in Größe und Vielfalt.

- Vollständiges COCO: Enthält über 118.000 Trainingsbilder – umfassend, aber ressourcenintensiv.

COCO128 bietet einen guten Mittelweg, indem es mehr Vielfalt als COCO8 bietet, während es für Experimente und die anfängliche Modellentwicklung wesentlich überschaubarer bleibt als der vollständige COCO-Datensatz.

Kann ich COCO128 für andere Aufgaben als die Objekterkennung verwenden?

Obwohl COCO128 primär für die Objekterkennung konzipiert ist, können die Annotationen des Datensatzes für andere Computer-Vision-Aufgaben angepasst werden:

- Instanzsegmentierung: Verwenden der in den Anmerkungen enthaltenen Segmentierungsmasken

- Keypoint-Erkennung: Für Bilder, die Personen mit Keypoint-Annotationen enthalten

- Transfer Learning: Als Ausgangspunkt für die Feinabstimmung von Modellen für benutzerdefinierte Aufgaben

Für spezialisierte Aufgaben wie die segment-Erkennung sollten Sie zweckgebundene Varianten wie COCO8-seg verwenden, die die entsprechenden Annotationen enthalten.