Despliegue

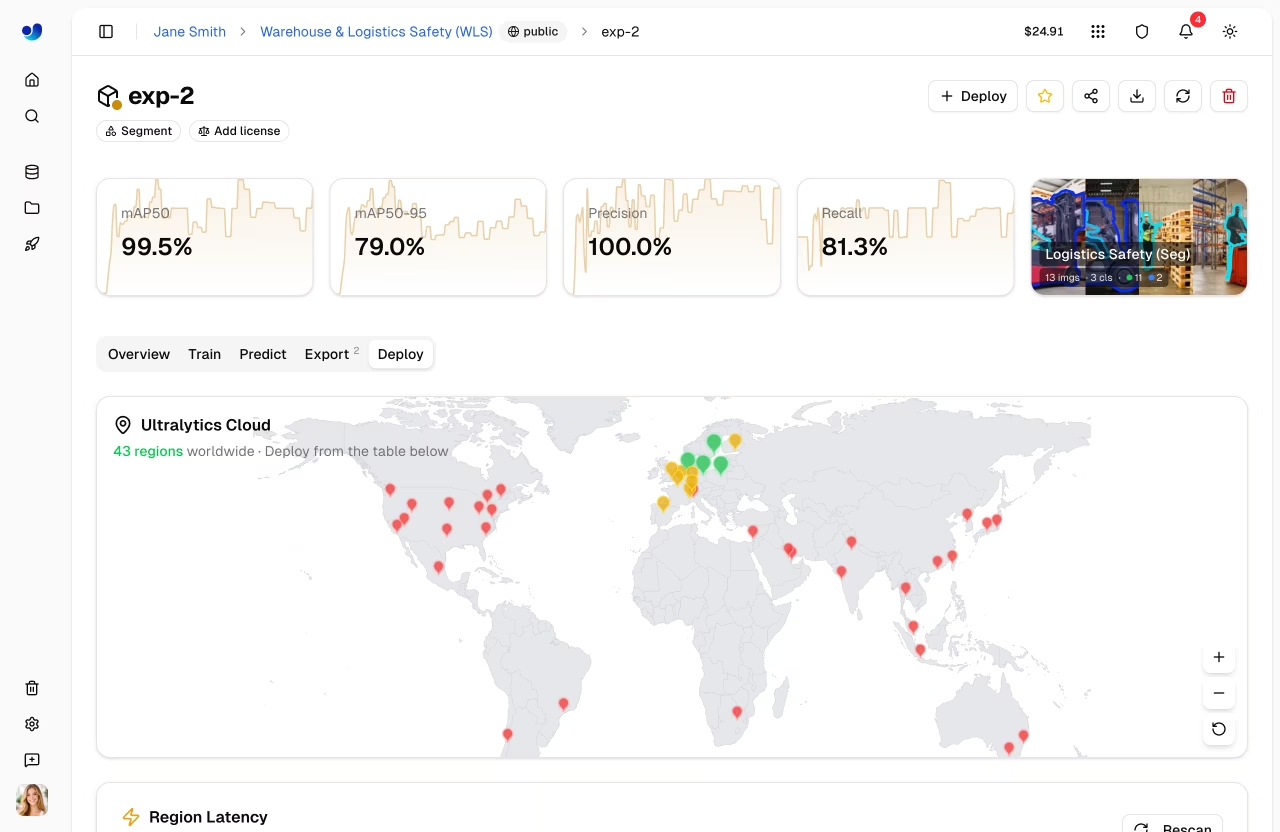

Ultralytics ofrece opciones de implementación completas para poner en producción sus YOLO . Pruebe los modelos con inferencia basada en navegador, impleméntelos en terminales dedicados en 43 regiones de todo el mundo y supervise el rendimiento en tiempo real.

Visión general

La sección de Despliegue le ayuda a:

- Prueba modelos directamente en el navegador con el

Predictpestaña - Desplegar en endpoints dedicados en 43 regiones globales

- Supervisar métricas de solicitudes, registros y comprobaciones de estado.

- Escalar automáticamente con el tráfico (incluido el escalado a cero)

Opciones de Despliegue

Ultralytics Platform ofrece múltiples rutas de despliegue:

| Opción | Descripción | Ideal para |

|---|---|---|

| Pestaña Predecir | Inferencia basada en navegador con imágenes, cámara web y ejemplos. | Desarrollo, validación |

| Inferencia Compartida | Servicio multitenant en 3 regiones | Uso ligero, pruebas |

| Endpoints Dedicados | Servicios para un único inquilino en 43 regiones | Producción, baja latencia |

Flujo de Trabajo

graph LR

A[✅ Test] --> B[⚙️ Configure]

B --> C[🌐 Deploy]

C --> D[📊 Monitor]

style A fill:#4CAF50,color:#fff

style B fill:#2196F3,color:#fff

style C fill:#FF9800,color:#fff

style D fill:#9C27B0,color:#fff| Etapa | Descripción |

|---|---|

| Prueba | Validar el modelo con el Predict pestaña |

| Configurar | Seleccione la región, los recursos y el nombre de la implementación. |

| Despliegue | Cree un punto final dedicado desde el Deploy pestaña |

| Monitorizar | Realiza un seguimiento de las solicitudes, la latencia, los errores y los registros en Monitoring. |

Arquitectura

Inferencia Compartida

El servicio de inferencia compartida se ejecuta en tres regiones clave y enruta automáticamente las solicitudes en función de su región de datos:

graph TB

User[User Request] --> API[Platform API]

API --> Router{Region Router}

Router -->|US users| US["US Predict Service<br/>Iowa"]

Router -->|EU users| EU["EU Predict Service<br/>Belgium"]

Router -->|AP users| AP["AP Predict Service<br/>Hong Kong"]

style User fill:#f5f5f5,color:#333

style API fill:#2196F3,color:#fff

style Router fill:#FF9800,color:#fff

style US fill:#4CAF50,color:#fff

style EU fill:#4CAF50,color:#fff

style AP fill:#4CAF50,color:#fff| Región | Ubicación |

|---|---|

| EE. UU. | Iowa, EE. UU. |

| UE | Bélgica, Europa |

| AP | Hong Kong, Asia-Pacífico |

Endpoints Dedicados

Implemente en 43 regiones de todo el mundo en Ultralytics :

- América: 14 regiones

- Europa: 13 regiones

- Asia-Pacífico: 12 regiones

- Oriente Medio y África: 4 regiones

Cada punto final es un servicio de inquilino único con:

- Recursos informáticos dedicados ( CPU memoria configurables)

- Autoescalado (escalado a cero cuando está inactivo)

- URL de punto final único

- Supervisión independiente, registros y comprobaciones de estado

Página de implementaciones

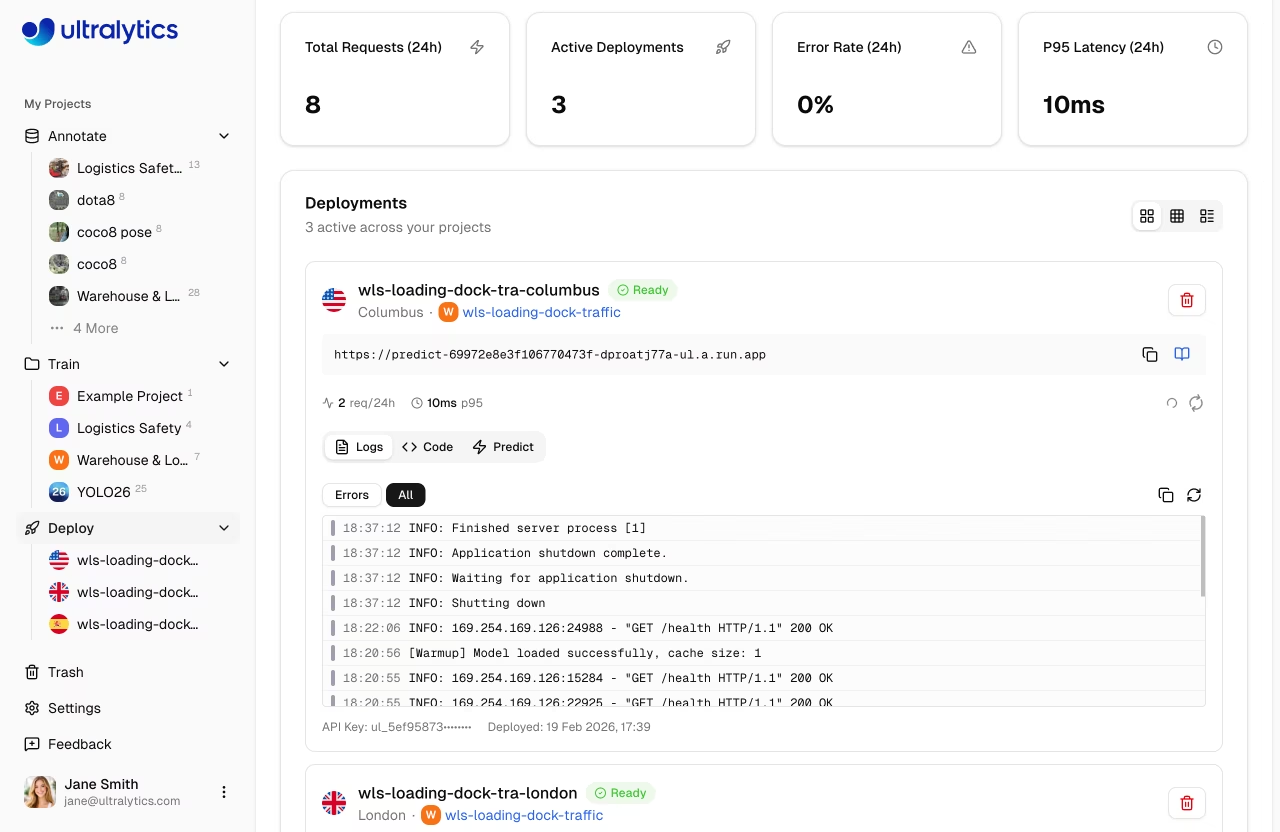

Acceda a la página de implementaciones globales desde la barra lateral, debajo de Deploy. Esta página muestra:

- Mapa mundial con marcadores de regiones desplegadas (mapa interactivo)

- Tarjetas de resumen: Total de solicitudes (24 h), Implementaciones activas, Tasa de error (24 h), Latencia P95 (24 h)

- Lista de implementaciones con tres modos de visualización: tarjetas, compacto y tabla.

- Nuevo botón «Implementar» para crear puntos finales a partir de cualquier modelo completado.

Encuesta automática

La página realiza sondeos cada 30 segundos para obtener actualizaciones métricas. Cuando las implementaciones se encuentran en un estado de transición (creación, implementación, detención), los sondeos aumentan a cada 2-3 segundos para obtener una respuesta casi instantánea.

Características clave

Cobertura Global

Despliegue cerca de sus usuarios con 43 regiones que cubren:

- América del Norte, América del Sur

- Europa, Oriente Medio, África

- Asia Pacífico, Oceanía

Autoescalado

Los endpoints escalan automáticamente:

- Escala a cero: sin coste cuando está inactivo (predeterminado)

- Ampliación: gestiona automáticamente los picos de tráfico.

Ahorro de costes

La escala a cero está habilitada de forma predeterminada (instancias mínimas = 0). Solo pagas por el tiempo de inferencia activo.

Baja Latencia

Los endpoints dedicados ofrecen:

- Inicio en frío: ~5-15 segundos (contenedor almacenado en caché), hasta ~45 segundos (primera implementación)

- Inferencia en caliente: 50-200ms (depende del modelo)

- Enrutamiento regional para un rendimiento óptimo

Revisiones médicas

Cada implementación en ejecución incluye una comprobación automática del estado con:

- Indicador de estado en tiempo real (correcto/incorrecto)

- Visualización de la latencia de respuesta

- Reintento automático cuando no funciona correctamente (consultas cada 20 segundos)

- Botón de actualización manual

Inicio rápido

Implemente un modelo en menos de 2 minutos:

- Entrenar o cargar un modelo en un proyecto

- Vaya a la pestaña Implementar del modelo.

- Seleccione una región de la tabla de latencia.

- Haga clic en Implementar: su punto final está activo.

Despliegue rápido

Model → Deploy tab → Select region → Click Deploy → Endpoint URL ready

Una vez implementado, utilice la URL del punto final con su clave API para enviar solicitudes de inferencia desde cualquier aplicación.

Enlaces rápidos

- Inferencia: Prueba modelos en el navegador

- Endpoints: Despliega endpoints dedicados

- Monitorización: track el rendimiento del despliegue

Preguntas frecuentes

¿Cuál es la diferencia entre la inferencia compartida y la dedicada?

| Característica | Compartido | Dedicado |

|---|---|---|

| Latencia | Variable | Consistente |

| Coste | Pago por solicitud | Pago por tiempo de actividad |

| Escala | Limitado | Configurable |

| Regiones | 3 | 43 |

| URL | Genérico | Personalizado |

¿Cuánto tiempo tarda el despliegue?

El despliegue de un endpoint dedicado suele tardar de 1 a 2 minutos:

- Extracción de imagen (~30s)

- Inicio de contenedor (~30s)

- Verificación de estado (~30s)

¿Puedo desplegar múltiples modelos?

Sí, cada modelo puede tener múltiples endpoints en diferentes regiones. No hay límite en el número total de endpoints (sujeto a su plan).

¿Qué sucede cuando un endpoint está inactivo?

Con el escalado a cero habilitado:

- El endpoint se escala a cero después de la inactividad

- La primera solicitud provoca un arranque en frío

- Las solicitudes posteriores son rápidas

Las primeras solicitudes tras un periodo de inactividad activan un arranque en frío.