Ultralytics YOLO26

Visión general

Ultralytics YOLO26 es la última evolución en la serie YOLO de detectores de objetos en tiempo real, diseñado desde cero para dispositivos de borde y de bajo consumo. Introduce un diseño optimizado que elimina la complejidad innecesaria al tiempo que integra innovaciones específicas para ofrecer una implementación más rápida, ligera y accesible.

Prueba Ultralytics

Explora y ejecuta modelos YOLO26 directamente en Ultralytics .

La arquitectura de YOLO26 se guía por tres principios fundamentales:

- Simplicidad: YOLO26 es un modelo nativo de extremo a extremo, que produce predicciones directamente sin necesidad de supresión no máxima (NMS). Al eliminar este paso de post-procesamiento, la inferencia se vuelve más rápida, ligera y fácil de implementar en sistemas del mundo real. Este enfoque innovador fue iniciado por primera vez en YOLOv10 por Ao Wang en la Universidad de Tsinghua y ha sido perfeccionado en YOLO26.

- Eficiencia de la Implementación: El diseño de extremo a extremo elimina una etapa completa del pipeline, lo que simplifica drásticamente la integración, reduce la latencia y hace que la implementación sea más robusta en diversos entornos.

- Innovación en el entrenamiento: YOLO26 introduce el optimizador MuSGD, un híbrido de SGD y Muon — inspirado en los avances de Kimi K2 de Moonshot AI en el entrenamiento de LLM. Este optimizador aporta una estabilidad mejorada y una convergencia más rápida, transfiriendo los avances en optimización de los modelos de lenguaje a la visión por computadora.

- Optimizaciones Específicas de Tarea: YOLO26 introduce mejoras dirigidas para tareas especializadas, incluyendo la pérdida de segmentación semántica y módulos proto multiescala para la Segmentación, la Estimación de Log-Verosimilitud Residual (RLE) para la estimación de Pose de alta precisión, y la decodificación optimizada con pérdida angular para resolver problemas de límites en OBB.

En conjunto, estas innovaciones ofrecen una familia de modelos que logra una mayor precisión en objetos pequeños, proporciona una implementación perfecta y se ejecuta hasta un 43% más rápido en las CPU, lo que convierte a YOLO26 en uno de los modelos YOLO más prácticos e implementables hasta la fecha para entornos con recursos limitados.

Características clave

Eliminación de DFL

El módulo Distribution Focal Loss (DFL), aunque eficaz, a menudo complicaba la exportación y limitaba la compatibilidad del hardware. YOLO26 elimina DFL por completo, simplificando la inferencia y ampliando el soporte para dispositivos edge y de baja potencia.Inferencia integral sin NMS

A diferencia de los detectores tradicionales que se basan en NMS como un paso de post-procesamiento separado, YOLO26 es nativamente integral. Las predicciones se generan directamente, lo que reduce la latencia y hace que la integración en los sistemas de producción sea más rápida, ligera y fiable.ProgLoss + STAL

Las funciones de pérdida mejoradas aumentan la precisión de la detección, con mejoras notables en el reconocimiento de objetos pequeños, un requisito fundamental para IoT, robótica, imágenes aéreas y otras aplicaciones en el borde.Optimizador MuSGD

Un nuevo optimizador híbrido que combina SGD con Muon. Inspirado en Kimi K2 de Moonshot AI, MuSGD introduce métodos de optimización avanzados del entrenamiento de LLM en la visión artificial, permitiendo un entrenamiento más estable y una convergencia más rápida.Inferencia de CPU hasta un 43% más rápida

Específicamente optimizado para la computación en el borde, YOLO26 ofrece una inferencia de CPU significativamente más rápida, lo que garantiza un rendimiento en tiempo real en dispositivos sin GPU.Mejoras en la Segmentación de Instancias

Introduce la pérdida de segmentación semántica para mejorar la convergencia del modelo y un módulo proto actualizado que aprovecha la información multiescala para una calidad de máscara superior.Estimación de Pose de Precisión

Integra la Estimación de Verosimilitud Logarítmica Residual (RLE) para una localización de puntos clave más precisa y optimiza el proceso de decodificación para una mayor velocidad de inferencia.Decodificación OBB Refinada

Introduce una pérdida de ángulo especializada para mejorar la precisión de detección de objetos cuadrados y optimiza la decodificación OBB para resolver problemas de discontinuidad de límites.

Tareas y modos admitidos

YOLO26 se basa en la versátil gama de modelos establecida por versiones anteriores de Ultralytics YOLO, ofreciendo un soporte mejorado en diversas tareas de visión por computadora:

| Modelo | Nombres de archivo | Tarea | Inferencia | Validación | Entrenamiento | Exportar |

|---|---|---|---|---|---|---|

| YOLO26 | yolo26n.pt yolo26s.pt yolo26m.pt yolo26l.pt yolo26x.pt | Detección | ✅ | ✅ | ✅ | ✅ |

| YOLO26-seg | yolo26n-seg.pt yolo26s-seg.pt yolo26m-seg.pt yolo26l-seg.pt yolo26x-seg.pt | Segmentación de instancias | ✅ | ✅ | ✅ | ✅ |

| YOLO26-pose | yolo26n-pose.pt yolo26s-pose.pt yolo26m-pose.pt yolo26l-pose.pt yolo26x-pose.pt | Pose/Keypoints | ✅ | ✅ | ✅ | ✅ |

| YOLO26-obb | yolo26n-obb.pt yolo26s-obb.pt yolo26m-obb.pt yolo26l-obb.pt yolo26x-obb.pt | Detección Orientada | ✅ | ✅ | ✅ | ✅ |

| YOLO26-cls | yolo26n-cls.pt yolo26s-cls.pt yolo26m-cls.pt yolo26l-cls.pt yolo26x-cls.pt | Clasificación | ✅ | ✅ | ✅ | ✅ |

Este marco unificado garantiza que YOLO26 sea aplicable a la detección en tiempo real, la segmentación, la clasificación, la estimación de la pose y la detección de objetos orientados, todo ello con soporte para el entrenamiento, la validación, la inferencia y la exportación.

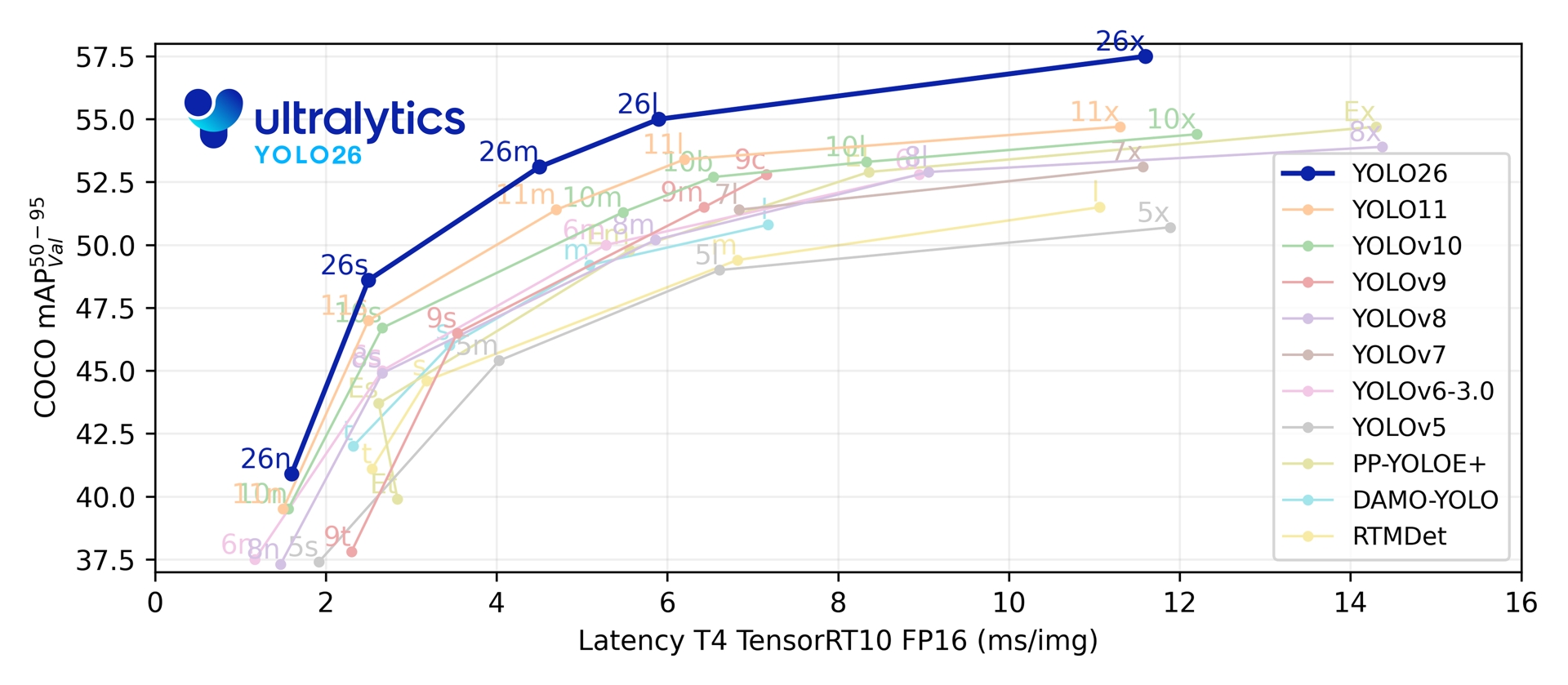

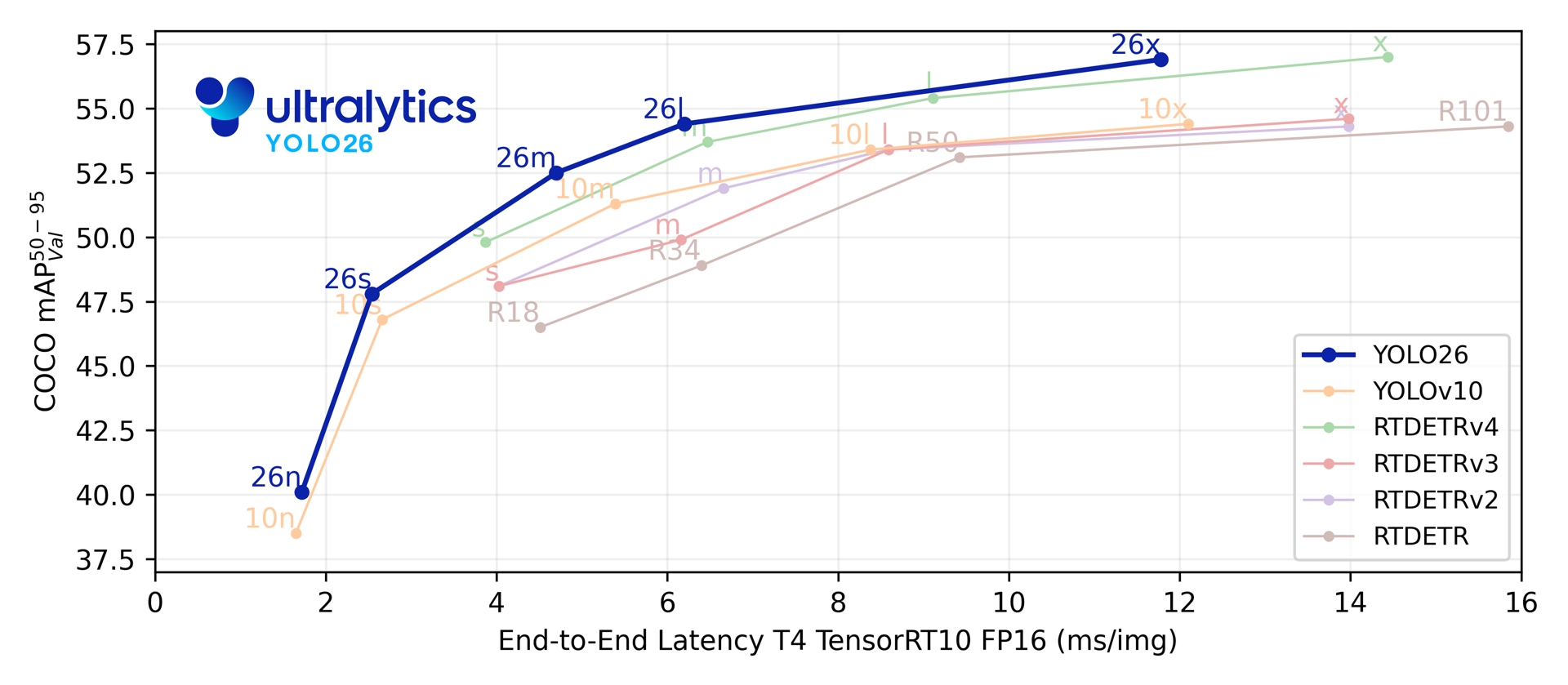

Métricas de rendimiento

Rendimiento

Consulte la Documentación de Detección para ver ejemplos de uso con estos modelos entrenados en COCO, que incluyen 80 clases preentrenadas.

| Modelo | tamaño (píxeles) | mAPval 50-95 | mAPval 50-95(e2e) | Velocidad CPU ONNX (ms) | Velocidad T4 TensorRT10 (ms) | parámetros (M) | FLOPs (B) |

|---|---|---|---|---|---|---|---|

| YOLO26n | 640 | 40.9 | 40.1 | 38.9 ± 0.7 | 1.7 ± 0.0 | 2.4 | 5.4 |

| YOLO26s | 640 | 48.6 | 47.8 | 87.2 ± 0.9 | 2.5 ± 0.0 | 9.5 | 20.7 |

| YOLO26m | 640 | 53.1 | 52.5 | 220.0 ± 1.4 | 4.7 ± 0.1 | 20.4 | 68.2 |

| YOLO26l | 640 | 55.0 | 54.4 | 286.2 ± 2.0 | 6.2 ± 0.2 | 24.8 | 86.4 |

| YOLO26x | 640 | 57.5 | 56.9 | 525.8 ± 4.0 | 11.8 ± 0.2 | 55.7 | 193.9 |

Consulte la Documentación de Segmentación para ver ejemplos de uso con estos modelos entrenados en COCO, que incluyen 80 clases preentrenadas.

| Modelo | tamaño (píxeles) | mAPbox 50-95(e2e) | mAPmask 50(e2e) | Velocidad CPU ONNX (ms) | Velocidad T4 TensorRT10 (ms) | parámetros (M) | FLOPs (B) |

|---|---|---|---|---|---|---|---|

| YOLO26n-seg | 640 | 39.6 | 33.9 | 53.3 ± 0.5 | 2.1 ± 0.0 | 2.7 | 9.1 |

| YOLO26s-seg | 640 | 47.3 | 40.0 | 118.4 ± 0.9 | 3.3 ± 0.0 | 10.4 | 34.2 |

| YOLO26m-seg | 640 | 52.5 | 44.1 | 328.2 ± 2.4 | 6.7 ± 0.1 | 23.6 | 121.5 |

| YOLO26l-seg | 640 | 54.4 | 45.5 | 387.0 ± 3.7 | 8.0 ± 0.1 | 28.0 | 139.8 |

| YOLO26x-seg | 640 | 56.5 | 47.0 | 787.0 ± 6.8 | 16.4 ± 0.1 | 62.8 | 313.5 |

Consulte la Documentación de Clasificación para ver ejemplos de uso con estos modelos entrenados en ImageNet, que incluyen 1000 clases preentrenadas.

| Modelo | tamaño (píxeles) | acc top1 | acc top5 | Velocidad CPU ONNX (ms) | Velocidad T4 TensorRT10 (ms) | parámetros (M) | FLOPs (B) a 224 |

|---|---|---|---|---|---|---|---|

| YOLO26n-cls | 224 | 71.4 | 90.1 | 5.0 ± 0.3 | 1.1 ± 0.0 | 2.8 | 0.5 |

| YOLO26s-cls | 224 | 76.0 | 92.9 | 7.9 ± 0.2 | 1.3 ± 0.0 | 6.7 | 1.6 |

| YOLO26m-cls | 224 | 78.1 | 94.2 | 17.2 ± 0.4 | 2.0 ± 0.0 | 11.6 | 4.9 |

| YOLO26l-cls | 224 | 79.0 | 94.6 | 23.2 ± 0.3 | 2.8 ± 0.0 | 14.1 | 6.2 |

| YOLO26x-cls | 224 | 79.9 | 95.0 | 41.4 ± 0.9 | 3.8 ± 0.0 | 29.6 | 13.6 |

Consulte la Documentación de Estimación de Pose para ver ejemplos de uso con estos modelos entrenados en COCO, que incluyen 1 clase preentrenada, 'person'.

| Modelo | tamaño (píxeles) | mAPpose 50-95(e2e) | mAPpose 50(e2e) | Velocidad CPU ONNX (ms) | Velocidad T4 TensorRT10 (ms) | parámetros (M) | FLOPs (B) |

|---|---|---|---|---|---|---|---|

| YOLO26n-pose | 640 | 57.2 | 83.3 | 40.3 ± 0.5 | 1.8 ± 0.0 | 2.9 | 7.5 |

| YOLO26s-pose | 640 | 63.0 | 86.6 | 85.3 ± 0.9 | 2.7 ± 0.0 | 10.4 | 23.9 |

| YOLO26m-pose | 640 | 68.8 | 89.6 | 218.0 ± 1.5 | 5.0 ± 0.1 | 21.5 | 73.1 |

| YOLO26l-pose | 640 | 70.4 | 90.5 | 275.4 ± 2.4 | 6.5 ± 0.1 | 25.9 | 91.3 |

| YOLO26x-pose | 640 | 71.6 | 91.6 | 565.4 ± 3.0 | 12.2 ± 0.2 | 57.6 | 201.7 |

Consulte la Documentación de Detección Orientada para ver ejemplos de uso con estos modelos entrenados en DOTAv1, que incluyen 15 clases preentrenadas.

| Modelo | tamaño (píxeles) | mAPtest 50(e2e) | mAPtest 50(e2e) | Velocidad CPU ONNX (ms) | Velocidad T4 TensorRT10 (ms) | parámetros (M) | FLOPs (B) |

|---|---|---|---|---|---|---|---|

| YOLO26n-obb | 1024 | 52.4 | 78.9 | 97.7 ± 0.9 | 2.8 ± 0.0 | 2.5 | 14.0 |

| YOLO26s-obb | 1024 | 54.8 | 80.9 | 218.0 ± 1.4 | 4.9 ± 0.1 | 9.8 | 55.1 |

| YOLO26m-obb | 1024 | 55.3 | 81.0 | 579.2 ± 3.8 | 10.2 ± 0.3 | 21.2 | 183.3 |

| YOLO26l-obb | 1024 | 56.2 | 81.6 | 735.6 ± 3.1 | 13.0 ± 0.2 | 25.6 | 230.0 |

| YOLO26x-obb | 1024 | 56.7 | 81.7 | 1485.7 ± 11.5 | 30.5 ± 0.9 | 57.6 | 516.5 |

Los valores de Params y FLOPs corresponden al modelo fusionado después de model.fuse(), que fusiona las capas Conv y BatchNorm y elimina el cabezal de detección auxiliar uno a muchos. Los puntos de control preentrenados conservan la arquitectura de entrenamiento completa y pueden mostrar recuentos más altos.

Ejemplos de uso

Esta sección proporciona ejemplos sencillos de entrenamiento e inferencia de YOLO26. Para obtener la documentación completa sobre estos y otros modos, consulte las páginas de documentación de Predict, Train, Val y Export.

Tenga en cuenta que el ejemplo siguiente es para modelos YOLO26 Detect para detección de objetos. Para otras tareas compatibles, consulte la documentación de Segment, Classify, OBB y Pose.

Ejemplo

PyTorch preentrenados *.pt modelos, así como la configuración *.yaml los archivos se pueden pasar a la YOLO() class para crear una instancia de modelo en Python:

from ultralytics import YOLO

# Load a COCO-pretrained YOLO26n model

model = YOLO("yolo26n.pt")

# Train the model on the COCO8 example dataset for 100 epochs

results = model.train(data="coco8.yaml", epochs=100, imgsz=640)

# Run inference with the YOLO26n model on the 'bus.jpg' image

results = model("path/to/bus.jpg")

Hay comandos de la CLI disponibles para ejecutar directamente los modelos:

# Load a COCO-pretrained YOLO26n model and train it on the COCO8 example dataset for 100 epochs

yolo train model=yolo26n.pt data=coco8.yaml epochs=100 imgsz=640

# Load a COCO-pretrained YOLO26n model and run inference on the 'bus.jpg' image

yolo predict model=yolo26n.pt source=path/to/bus.jpg

Arquitectura de doble cabezal

YOLO26 cuenta con una arquitectura de doble cabezal que ofrece flexibilidad para diferentes escenarios de implementación:

- Cabezal uno a uno (predeterminado): Produce predicciones de extremo a extremo sin NMS, generando

(N, 300, 6)con un máximo de 300 detecciones por imagen. Este cabezal está optimizado para una inferencia rápida y una implementación simplificada. - Cabezal uno a muchos: Genera YOLO tradicionales que requieren NMS , generando

(N, nc + 4, 8400)dondences el número de clases. Este cabezal suele alcanzar una precisión ligeramente superior a costa de un procesamiento adicional.

Puede cambiar entre cabezales durante la exportación, la predicción o la validación:

from ultralytics import YOLO

model = YOLO("yolo26n.pt")

# Use one-to-one head (default, no NMS required)

results = model.predict("image.jpg") # inference

metrics = model.val(data="coco.yaml") # validation

model.export(format="onnx") # export

# Use one-to-many head (requires NMS)

results = model.predict("image.jpg", end2end=False) # inference

metrics = model.val(data="coco.yaml", end2end=False) # validation

model.export(format="onnx", end2end=False) # export

# Use one-to-one head (default, no NMS required)

yolo predict model=yolo26n.pt source=image.jpg

yolo val model=yolo26n.pt data=coco.yaml

yolo export model=yolo26n.pt format=onnx

# Use one-to-many head (requires NMS)

yolo predict model=yolo26n.pt source=image.jpg end2end=False

yolo val model=yolo26n.pt data=coco.yaml end2end=False

yolo export model=yolo26n.pt format=onnx end2end=False

La elección depende de sus requisitos de implementación: utilice el cabezal uno a uno para obtener la máxima velocidad y simplicidad, o el cabezal uno a muchos cuando la precisión sea la máxima prioridad.

YOLOE-26: Segmentación de instancias de vocabulario abierto

YOLOE-26 integra la arquitectura YOLO26 de alto rendimiento con las capacidades de vocabulario abierto de la serie YOLOE. Permite la detección y segmentación en tiempo real de cualquier clase de objeto utilizando prompts de texto, prompts visuales o un modo sin prompts para inferencia zero-shot, eliminando eficazmente las limitaciones del entrenamiento de categorías fijas.

Al aprovechar el diseño de extremo a extremo y sin NMS de YOLO26, YOLOE-26 ofrece una inferencia rápida en mundo abierto. Esto lo convierte en una solución potente para aplicaciones de borde en entornos dinámicos donde los objetos de interés representan un vocabulario amplio y en evolución.

Rendimiento

Consulte la documentación de YOLOE para ver ejemplos de uso con estos modelos entrenados en los conjuntos de datos Objects365v1, GQA y Flickr30k.

| Modelo | tamaño (píxeles) | Tipo de prompt | mAPminival 50-95(e2e) | mAPminival 50-95 | mAPr | mAPc | mAPf | parámetros (M) | FLOPs (B) |

|---|---|---|---|---|---|---|---|---|---|

| YOLOE-26n-seg | 640 | Texto/Visual | 23.7 / 20.9 | 24.7 / 21.9 | 20.5 / 17.6 | 24.1 / 22.3 | 26.1 / 22.4 | 4.8 | 6.0 |

| YOLOE-26s-seg | 640 | Texto/Visual | 29.9 / 27.1 | 30.8 / 28.6 | 23.9 / 25.1 | 29.6 / 27.8 | 33.0 / 29.9 | 13.1 | 21.7 |

| YOLOE-26m-seg | 640 | Texto/Visual | 35.4 / 31.3 | 35.4 / 33.9 | 31.1 / 33.4 | 34.7 / 34.0 | 36.9 / 33.8 | 27.9 | 70.1 |

| YOLOE-26l-seg | 640 | Texto/Visual | 36.8 / 33.7 | 37.8 / 36.3 | 35.1 / 37.6 | 37.6 / 36.2 | 38.5 / 36.1 | 32.3 | 88.3 |

| YOLOE-26x-seg | 640 | Texto/Visual | 39.5 / 36.2 | 40.6 / 38.5 | 37.4 / 35.3 | 40.9 / 38.8 | 41.0 / 38.8 | 69.9 | 196.7 |

Consulte la documentación de YOLOE para ver ejemplos de uso con estos modelos entrenados en los conjuntos de datos Objects365v1, GQA y Flickr30k.

| Modelo | tamaño (píxeles) | mAPminival 50-95(e2e) | mAPminival 50(e2e) | parámetros (M) | FLOPs (B) |

|---|---|---|---|---|---|

| YOLOE-26n-seg-pf | 640 | 16.6 | 22.7 | 6.5 | 15.8 |

| YOLOE-26s-seg-pf | 640 | 21.4 | 28.6 | 16.2 | 35.5 |

| YOLOE-26m-seg-pf | 640 | 25.7 | 33.6 | 36.2 | 122.1 |

| YOLOE-26l-seg-pf | 640 | 27.2 | 35.4 | 40.6 | 140.4 |

| YOLOE-26x-seg-pf | 640 | 29.9 | 38.7 | 86.3 | 314.4 |

Ejemplo de uso

YOLOE-26 admite tanto la incitación basada en texto como la visual. El uso de incitaciones es sencillo: simplemente páselas a través del predict método como se muestra a continuación:

Ejemplo

Las incitaciones de texto le permiten especificar las clases que desea detect mediante descripciones textuales. El siguiente código muestra cómo puede utilizar YOLOE-26 para detect personas y autobuses en una imagen:

from ultralytics import YOLO

# Initialize model

model = YOLO("yoloe-26l-seg.pt") # or select yoloe-26s/m-seg.pt for different sizes

# Set text prompt to detect person and bus. You only need to do this once after you load the model.

model.set_classes(["person", "bus"])

# Run detection on the given image

results = model.predict("path/to/image.jpg")

# Show results

results[0].show()

Las indicaciones visuales le permiten guiar el modelo mostrándole ejemplos visuales de las clases objetivo, en lugar de describirlas en texto.

import numpy as np

from ultralytics import YOLO

from ultralytics.models.yolo.yoloe import YOLOEVPSegPredictor

# Initialize model

model = YOLO("yoloe-26l-seg.pt")

# Define visual prompts using bounding boxes and their corresponding class IDs.

# Each box highlights an example of the object you want the model to detect.

visual_prompts = dict(

bboxes=np.array(

[

[221.52, 405.8, 344.98, 857.54], # Box enclosing person

[120, 425, 160, 445], # Box enclosing glasses

],

),

cls=np.array(

[

0, # ID to be assigned for person

1, # ID to be assigned for glasses

]

),

)

# Run inference on an image, using the provided visual prompts as guidance

results = model.predict(

"ultralytics/assets/bus.jpg",

visual_prompts=visual_prompts,

predictor=YOLOEVPSegPredictor,

)

# Show results

results[0].show()

YOLOE-26 incluye variantes sin incitación que vienen con un vocabulario incorporado. Estos modelos no requieren incitaciones y funcionan como los modelos YOLO tradicionales. En lugar de depender de etiquetas proporcionadas por el usuario o ejemplos visuales, detect objetos de una lista predefinida de 4.585 clases basada en el conjunto de etiquetas utilizado por el Recognize Anything Model Plus (RAM++).

from ultralytics import YOLO

# Initialize model

model = YOLO("yoloe-26l-seg-pf.pt")

# Run prediction. No prompts required.

results = model.predict("path/to/image.jpg")

# Show results

results[0].show()

Para una inmersión profunda en las técnicas de incitación, el entrenamiento desde cero y ejemplos de uso completos, visite la Documentación de YOLOE.

Citas y agradecimientos

Publicación de Ultralytics YOLO26

Ultralytics no ha publicado un artículo de investigación formal para YOLO26 debido a la naturaleza rápidamente cambiante de los modelos. En cambio, nos centramos en ofrecer modelos de vanguardia y hacerlos fáciles de usar. Para obtener las últimas actualizaciones sobre las características, arquitecturas y el uso de YOLO, visite nuestro repositorio de GitHub y nuestra documentación.

Si utiliza YOLO26 u otro software de Ultralytics en su trabajo, por favor, cítelo como:

@software{yolo26_ultralytics,

author = {Glenn Jocher and Jing Qiu},

title = {Ultralytics YOLO26},

version = {26.0.0},

year = {2026},

url = {https://github.com/ultralytics/ultralytics},

orcid = {0000-0001-5950-6979, 0000-0003-3783-7069},

license = {AGPL-3.0}

}

DOI pendiente. YOLO26 está disponible bajo licencias AGPL-3.0 y Enterprise.

Preguntas frecuentes

¿Cuáles son las mejoras clave en YOLO26 en comparación con YOLO11?

- Eliminación de DFL: Simplifica la exportación y amplía la compatibilidad con el edge

- Inferencia integral sin NMS: Elimina NMS para una implementación más rápida y sencilla

- ProgLoss + STAL: Aumenta la precisión, especialmente en objetos pequeños

- Optimizador MuSGD: Combina SGD y Muon (inspirado en Kimi K2 de Moonshot) para un entrenamiento más estable y eficiente

- Inferencia de CPU hasta un 43% más rápida: Importantes ganancias de rendimiento para dispositivos solo con CPU

¿Qué tareas soporta YOLO26?

YOLO26 es una familia de modelos unificada, que proporciona soporte de extremo a extremo para múltiples tareas de visión por computadora:

- Detección de objetos

- Segmentación de instancias

- Clasificación de imágenes

- Estimación de pose

- Detección de Objetos Orientados (OBB)

Cada variante de tamaño (n, s, m, l, x) admite todas las tareas, además de versiones de vocabulario abierto a través de YOLOE-26.

¿Por qué está YOLO26 optimizado para la implementación en el edge?

YOLO26 ofrece un rendimiento de vanguardia en el edge con:

- Inferencia en CPU hasta un 43% más rápida

- Tamaño de modelo y huella de memoria reducidos

- Arquitectura simplificada para compatibilidad (sin DFL, sin NMS)

- Formatos de exportación flexibles que incluyen TensorRT, ONNX, CoreML, TFLite y OpenVINO

¿Cómo empiezo con YOLO26?

Los modelos YOLO26 fueron lanzados el 14 de enero de 2026 y están disponibles para su descarga. Instale o actualice el ultralytics paquete y cargue un modelo:

from ultralytics import YOLO

# Load a pretrained YOLO26 nano model

model = YOLO("yolo26n.pt")

# Run inference on an image

results = model("image.jpg")

Consulte la sección de Ejemplos de Uso para obtener instrucciones de entrenamiento, validación y exportación.