Dataset KITTI

Il dataset kitti è uno dei dataset di riferimento più influenti per la guida autonoma e la computer vision. Rilasciato dal Karlsruhe Institute of Technology e dal Toyota Technological Institute di Chicago, contiene dati di telecamere stereo, LiDAR e GPS/IMU raccolti da scenari di guida nel mondo reale.

Guarda: Come addestrare Ultralytics YOLO26 sul dataset KITTI 🚀

È ampiamente utilizzato per la valutazione di algoritmi nel rilevamento di oggetti, stima della profondità, flusso ottico e odometria visiva. Il dataset è pienamente compatibile con Ultralytics YOLO26 per attività di rilevamento di oggetti 2D e può essere facilmente integrato nella piattaforma Ultralytics per l'addestramento e la valutazione.

Struttura del set di dati

Attenzione

Il set di test originale di Kitti è escluso qui poiché non contiene annotazioni ground-truth.

In totale, il dataset include 7.481 immagini, ciascuna abbinata ad annotazioni dettagliate per oggetti come auto, pedoni, ciclisti e altri elementi stradali. Il dataset è diviso in due sottoinsiemi principali:

- Set di addestramento: Contiene 5.985 immagini con etichette annotate utilizzate per l'addestramento del modello.

- Set di validazione: Include 1.496 immagini con annotazioni corrispondenti utilizzate per la valutazione delle prestazioni e il benchmarking.

Applicazioni

Il dataset Kitti consente progressi nella guida autonoma e nella robotica, supportando attività come:

- Percezione dei veicoli autonomi: Addestramento di modelli per detect e track di veicoli, pedoni e ostacoli per una navigazione sicura in sistemi di guida autonoma.

- Comprensione della scena 3D: supporto per la stima della profondità, la visione stereo e la localizzazione di oggetti 3D per aiutare le macchine a comprendere gli ambienti spaziali.

- Flusso ottico e predizione del movimento: Permette l'analisi del movimento per prevedere lo spostamento degli oggetti e migliorare la pianificazione della traiettoria in ambienti dinamici.

- Benchmarking di computer vision: Funge da benchmark standard per valutare le prestazioni in diverse attività di visione, tra cui il detect di oggetti e il track.

YAML del set di dati

Ultralytics definisce la configurazione del dataset kitti utilizzando un file YAML. Questo file specifica i percorsi del dataset, le etichette delle classi e i metadati necessari per l'addestramento. Il file di configurazione è disponibile all'indirizzo https://github.com/ultralytics/ultralytics/blob/main/ultralytics/cfg/datasets/kitti.yaml.

ultralytics/cfg/datasets/kitti.yaml

# Ultralytics 🚀 AGPL-3.0 License - https://ultralytics.com/license

# KITTI dataset by Karlsruhe Institute of Technology and Toyota Technological Institute at Chicago

# Documentation: https://docs.ultralytics.com/datasets/detect/kitti/

# Example usage: yolo train data=kitti.yaml

# parent

# ├── ultralytics

# └── datasets

# └── kitti ← downloads here (390.5 MB)

# Train/val/test sets as 1) dir: path/to/imgs, 2) file: path/to/imgs.txt, or 3) list: [path/to/imgs1, path/to/imgs2, ..]

path: kitti # dataset root dir

train: images/train # train images (relative to 'path') 5985 images

val: images/val # val images (relative to 'path') 1496 images

names:

0: car

1: van

2: truck

3: pedestrian

4: person_sitting

5: cyclist

6: tram

7: misc

# Download script/URL (optional)

download: https://github.com/ultralytics/assets/releases/download/v0.0.0/kitti.zip

Utilizzo

Per addestrare un modello YOLO26n sul dataset kitti per 100 epoche con una dimensione dell'immagine di 640, utilizza i seguenti comandi. Per maggiori dettagli, fai riferimento alla pagina Addestramento.

Esempio di addestramento

from ultralytics import YOLO

# Load a pretrained YOLO26 model

model = YOLO("yolo26n.pt")

# Train on kitti dataset

results = model.train(data="kitti.yaml", epochs=100, imgsz=640)

yolo detect train data=kitti.yaml model=yolo26n.pt epochs=100 imgsz=640

Puoi anche eseguire valutazioni, inference e attività di export direttamente dalla riga di comando o dall'API Python utilizzando lo stesso file di configurazione.

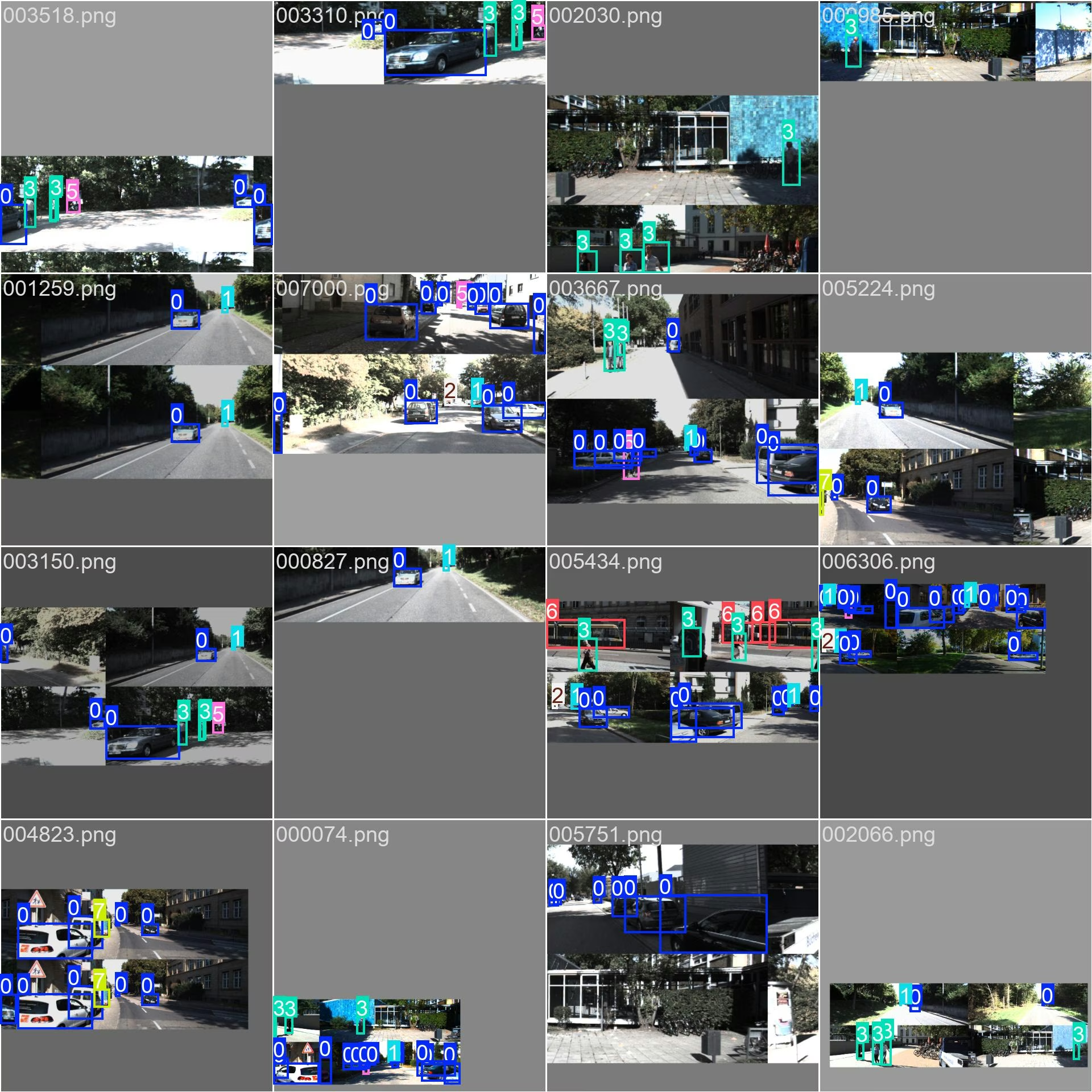

Immagini di esempio e annotazioni

Il dataset Kitti fornisce diversi scenari di guida. Ogni immagine include annotazioni con riquadri di delimitazione per attività di rilevamento di oggetti 2D. Gli esempi mostrano la ricca varietà del dataset, consentendo una solida generalizzazione del modello in diverse condizioni reali.

Citazioni e ringraziamenti

Se utilizzi il dataset kitti nella tua ricerca, cita il seguente articolo:

Citazione

@article{Geiger2013IJRR,

author = {Andreas Geiger and Philip Lenz and Christoph Stiller and Raquel Urtasun},

title = {Vision meets Robotics: The KITTI Dataset},

journal = {International Journal of Robotics Research (IJRR)},

year = {2013}

}

Ringraziamo il KITTI Vision Benchmark Suite per aver fornito questo set di dati completo che continua a plasmare il progresso nella computer vision, nella robotica e nei sistemi autonomi. Visita il sito web di kitti per maggiori informazioni.

FAQ

A cosa serve il dataset kitti?

Il dataset kitti è utilizzato principalmente per la ricerca sulla computer vision nella guida autonoma, supportando attività come l'object detection, la stima della profondità, il flusso ottico e la localizzazione 3D.

Quante immagini sono incluse nel dataset kitti?

Il dataset include 5.985 immagini di addestramento etichettate e 1.496 immagini di convalida acquisite in scene urbane, rurali e autostradali. Il set di test originale è escluso qui poiché non contiene annotazioni ground-truth.

Quali classi di oggetti sono annotate nel dataset?

Kitti include annotazioni per oggetti come auto, pedoni, ciclisti, camion, tram e diversi utenti della strada.

Posso addestrare modelli Ultralytics YOLO26 utilizzando il dataset kitti?

Sì, kitti è pienamente compatibile con Ultralytics YOLO26. È possibile addestrare e validare modelli direttamente utilizzando il file di configurazione YAML fornito.

Dove posso trovare il file di configurazione del dataset kitti?

Puoi accedere al file YAML all'indirizzo https://github.com/ultralytics/ultralytics/blob/main/ultralytics/cfg/datasets/kitti.yaml.