YOLO26에서 TF SavedModel 형식으로 내보내는 방법 이해하기

머신 러닝 모델을 배포하는 것은 어려울 수 있습니다. 그러나 효율적이고 유연한 모델 형식을 사용하면 작업을 더 쉽게 수행할 수 있습니다. TF SavedModel은 TensorFlow에서 머신 러닝 모델을 일관된 방식으로 로드하는 데 사용되는 오픈 소스 머신 러닝 프레임워크입니다. TensorFlow 모델을 위한 휴대용 가방과 같아서 다양한 장치와 시스템에서 쉽게 휴대하고 사용할 수 있습니다.

Ultralytics YOLO26 모델에서 TF SavedModel로 내보내는 방법을 배우면 다양한 플랫폼 및 환경에 모델을 쉽게 배포할 수 있습니다. 이 가이드에서는 모델을 TF SavedModel 형식으로 변환하여 다양한 장치에서 모델로 추론을 실행하는 과정을 간소화하는 방법을 안내합니다.

TF SavedModel로 내보내야 하는 이유는 무엇입니까?

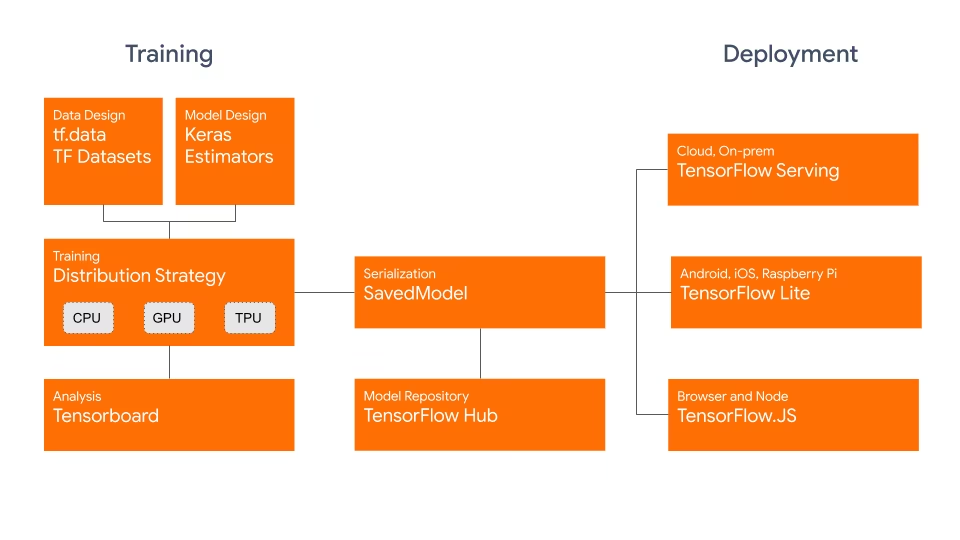

TensorFlow SavedModel 형식은 아래와 같이 Google 개발한 TensorFlow 에코시스템의 일부입니다. 이 형식은 TensorFlow 모델을 원활하게 저장하고 직렬화하도록 설계되었습니다. 아키텍처, 가중치, 컴파일 정보 등 모델의 전체 세부 정보를 캡슐화합니다. 따라서 다양한 환경에서 모델을 공유하고, 배포하고, 계속 교육할 수 있습니다.

TF SavedModel은 호환성이라는 중요한 이점을 가지고 있습니다. TensorFlow Serving, TensorFlow Lite 및 TensorFlow와 잘 작동합니다. 이러한 호환성 덕분에 웹 및 모바일 애플리케이션을 포함한 다양한 플랫폼에서 모델을 더 쉽게 공유하고 배포할 수 있습니다. TF SavedModel 형식은 연구 및 프로덕션 모두에 유용합니다. 모델을 관리하는 통합된 방법을 제공하여 모든 애플리케이션에 사용할 수 있도록 보장합니다.

TF SavedModels의 주요 기능

다음은 TF SavedModel을 AI 개발자를 위한 훌륭한 옵션으로 만드는 주요 기능입니다.

이식성: TF SavedModel은 언어에 중립적이고 복구 가능하며 완전한 직렬화 형식을 제공합니다. 이를 통해 상위 시스템 및 도구가 TensorFlow 모델을 생성, 사용 및 변환할 수 있습니다. SavedModel은 다양한 플랫폼과 환경에서 쉽게 공유하고 배포할 수 있습니다.

쉬운 배포: TF SavedModel은 계산 그래프, 훈련된 파라미터 및 필요한 메타데이터를 단일 패키지로 묶습니다. 모델을 빌드한 원본 코드가 없어도 쉽게 로드하여 추론에 사용할 수 있습니다. 따라서 다양한 프로덕션 환경에서 TensorFlow 모델을 간단하고 효율적으로 배포할 수 있습니다.

자산 관리: TF SavedModel은 어휘, 임베딩 또는 조회 테이블과 같은 외부 자산의 포함을 지원합니다. 이러한 자산은 그래프 정의 및 변수와 함께 저장되어 모델이 로드될 때 사용할 수 있도록 보장합니다. 이 기능은 외부 리소스에 의존하는 모델의 관리 및 배포를 간소화합니다.

TF SavedModel을 사용한 배포 옵션

YOLO26 모델을 TF SavedModel 형식으로 내보내는 과정에 들어가기 전에, 이 형식이 사용되는 몇 가지 일반적인 배포 시나리오를 살펴보겠습니다.

TF SavedModel은 머신 러닝 모델을 배포할 수 있는 다양한 옵션을 제공합니다.

TensorFlow Serving: TensorFlow Serving은 프로덕션 환경을 위해 설계된 유연한 고성능 서빙 시스템입니다. TF SavedModel을 기본적으로 지원하므로 클라우드 플랫폼, 온프레미스 서버 또는 에지 장치에 모델을 쉽게 배포하고 제공할 수 있습니다.

클라우드 플랫폼: Google Cloud Platform(GCP), Amazon Web Services(AWS) 및 Microsoft Azure와 같은 주요 클라우드 공급자는 TF SavedModels를 포함하여 TensorFlow 모델을 배포하고 실행하기 위한 서비스를 제공합니다. 이러한 서비스는 확장 가능하고 관리되는 인프라를 제공하여 모델을 쉽게 배포하고 확장할 수 있도록 합니다.

모바일 및 임베디드 디바이스: 모바일, 임베디드 및 IoT 디바이스에서 머신 러닝 모델을 실행하기 위한 경량 솔루션인TensorFlow Lite는 TF 저장 모델을 TensorFlow Lite 형식으로 변환하는 것을 지원합니다. 이를 통해 스마트폰과 태블릿부터 마이크로컨트롤러와 엣지 디바이스에 이르기까지 다양한 디바이스에 모델을 배포할 수 있습니다.

TensorFlow 런타임: TensorFlow 런타임 (

tfrt)은 실행을 위한 고성능 런타임입니다. TensorFlow 그래프를 제공합니다. 또한 C++ 환경에서 TF SavedModel을 로드하고 실행하기 위한 하위 수준 API를 제공합니다. TensorFlow Runtime은 표준 TensorFlow 런타임에 비해 더 나은 성능을 제공하며, 짧은 지연 시간의 추론과 기존 C++ 코드베이스와의 긴밀한 통합이 필요한 배포 시나리오에 적합합니다.

YOLO26 모델을 TF SavedModel로 내보내기

YOLO26 모델을 TF SavedModel 형식으로 내보냄으로써 다양한 플랫폼에서 모델의 적응성과 배포 용이성을 향상시킬 수 있습니다.

설치

필수 패키지를 설치하려면 다음을 실행합니다.

설치

# Install the required package for YOLO26

pip install ultralytics

설치 과정과 관련된 자세한 지침 및 모범 사례는 Ultralytics 설치 가이드를 확인하십시오. YOLO26에 필요한 패키지를 설치하는 동안 어려움이 발생하면 해결책과 팁을 얻기 위해 일반적인 문제 가이드를 참조하십시오.

사용법

모든 Ultralytics YOLO26 모델은 기본적으로 내보내기를 지원하도록 설계되어 선호하는 배포 워크플로에 쉽게 통합할 수 있습니다. 애플리케이션에 가장 적합한 설정을 선택하려면 지원되는 내보내기 형식 및 구성 옵션의 전체 목록을 볼 수 있습니다.

사용법

from ultralytics import YOLO

# Load the YOLO26 model

model = YOLO("yolo26n.pt")

# Export the model to TF SavedModel format

model.export(format="saved_model") # creates '/yolo26n_saved_model'

# Load the exported TF SavedModel model

tf_savedmodel_model = YOLO("./yolo26n_saved_model")

# Run inference

results = tf_savedmodel_model("https://ultralytics.com/images/bus.jpg")

# Export a YOLO26n PyTorch model to TF SavedModel format

yolo export model=yolo26n.pt format=saved_model # creates '/yolo26n_saved_model'

# Run inference with the exported model

yolo predict model='./yolo26n_saved_model' source='https://ultralytics.com/images/bus.jpg'

인수 내보내기

| 인수 | 유형 | 기본값 | 설명 |

|---|---|---|---|

format | str | 'saved_model' | 다양한 배포 환경과의 호환성을 정의하는 내보낸 모델의 대상 형식입니다. |

imgsz | int 또는 tuple | 640 | 모델 입력에 대한 원하는 이미지 크기입니다. 정사각형 이미지의 경우 정수이거나 튜플일 수 있습니다. (height, width) 특정 크기의 경우. |

keras | bool | False | TensorFlow 서비스 및 API와의 호환성을 제공하여 Keras 형식으로 내보내기를 활성화합니다. |

int8 | bool | False | INT8 양자화를 활성화하여 모델을 더욱 압축하고 정확도 손실을 최소화하면서 추론 속도를 높입니다(주로 에지 장치용). |

nms | bool | False | 정확하고 효율적인 detect 후처리(post-processing)에 필수적인 Non-Maximum Suppression (NMS)을 추가합니다. |

batch | int | 1 | 내보내기 모델 배치 추론 크기 또는 내보내기 모델이 동시에 처리할 이미지의 최대 수를 지정합니다. predict mode. |

device | str | None | 내보내기 장치를 지정합니다: CPU (device=cpu), Apple Silicon용 MPS (device=mps)입니다. |

내보내기 프로세스에 대한 자세한 내용은 내보내기에 대한 Ultralytics 문서 페이지를 참조하십시오.

내보낸 YOLO26 TF SavedModel 모델 배포

이제 YOLO26 모델을 TF SavedModel 형식으로 내보냈으므로 다음 단계는 이를 배포하는 것입니다. TF SavedModel 모델을 실행하기 위한 주요 권장 첫 번째 단계는 다음을 사용하는 것입니다. YOLO("yolo26n_saved_model/") 메서드는 앞서 사용 코드 스니펫에서 본 것과 같습니다.

그러나 TF SavedModel 모델을 배포하는 방법에 대한 자세한 지침은 다음 리소스를 참조하십시오.

TensorFlow Serving: TensorFlow Serving을 사용하여 TF SavedModel 모델을 배포하는 방법에 대한 개발자 문서입니다.

Node.js에서 TensorFlow SavedModel 실행: 변환 없이 Node.js에서 TensorFlow SavedModel을 직접 실행하는 방법에 대한 TensorFlow 블로그 게시물입니다.

클라우드에 배포: 클라우드 AI 플랫폼에 TensorFlow SavedModel 모델을 배포하는 방법에 대한 TensorFlow 블로그 게시물입니다.

요약

이 가이드에서는 Ultralytics YOLO26 모델을 TF SavedModel 형식으로 내보내는 방법을 살펴보았습니다. TF SavedModel로 내보냄으로써 다양한 플랫폼에서 YOLO26 모델을 최적화하고 배포하며 확장할 수 있는 유연성을 얻을 수 있습니다.

사용법에 대한 자세한 내용은 TF SavedModel 공식 문서를 참조하십시오.

Ultralytics YOLO26을 다른 플랫폼 및 프레임워크와 통합하는 방법에 대한 자세한 내용은 통합 가이드 페이지를 확인하는 것을 잊지 마십시오. 프로젝트에서 YOLO26을 최대한 활용하는 데 도움이 되는 훌륭한 자료가 가득합니다.

FAQ

Ultralytics YOLO 모델을 TensorFlow SavedModel 형식으로 어떻게 내보냅니까?

Ultralytics YOLO 모델을 TensorFlow SavedModel 형식으로 내보내는 것은 간단합니다. Python 또는 CLI를 사용하여 이를 수행할 수 있습니다.

YOLO26을 TF SavedModel로 내보내기

from ultralytics import YOLO

# Load the YOLO26 model

model = YOLO("yolo26n.pt")

# Export the model to TF SavedModel format

model.export(format="saved_model") # creates '/yolo26n_saved_model'

# Load the exported TF SavedModel for inference

tf_savedmodel_model = YOLO("./yolo26n_saved_model")

results = tf_savedmodel_model("https://ultralytics.com/images/bus.jpg")

# Export the YOLO26 model to TF SavedModel format

yolo export model=yolo26n.pt format=saved_model # creates '/yolo26n_saved_model'

# Run inference with the exported model

yolo predict model='./yolo26n_saved_model' source='https://ultralytics.com/images/bus.jpg'

자세한 내용은 Ultralytics Export 문서를 참조하십시오.

TensorFlow SavedModel 포맷을 사용해야 하는 이유는 무엇인가요?

TensorFlow SavedModel 형식은 모델 배포에 여러 가지 이점을 제공합니다.

- 이식성: 언어에 중립적인 형식을 제공하여 다양한 환경에서 모델을 쉽게 공유하고 배포할 수 있습니다.

- 호환성: 웹 및 모바일 애플리케이션을 포함한 다양한 플랫폼에 모델을 배포하는 데 필수적인 TensorFlow Serving, TensorFlow Lite 및 TensorFlow.js와 같은 도구와 원활하게 통합됩니다.

- 완전한 캡슐화: 모델 아키텍처, 가중치 및 컴파일 정보를 인코딩하여 간단한 공유 및 학습 지속이 가능합니다.

더 많은 이점 및 배포 옵션을 확인하려면 Ultralytics YOLO 모델 배포 옵션을 확인하십시오.

TF SavedModel의 일반적인 배포 시나리오는 무엇입니까?

TF SavedModel은 다음을 포함한 다양한 환경에 배포할 수 있습니다.

- TensorFlow Serving: 확장 가능하고 고성능 모델 제공이 필요한 프로덕션 환경에 이상적입니다.

- 클라우드 플랫폼: 확장 가능한 모델 배포를 위해 Google Cloud Platform (GCP), Amazon Web Services (AWS) 및 Microsoft Azure와 같은 주요 클라우드 서비스를 지원합니다.

- 모바일 및 임베디드 장치: TensorFlow Lite를 사용하여 TF SavedModel을 변환하면 모바일 장치, IoT 장치 및 마이크로컨트롤러에 배포할 수 있습니다.

- TensorFlow Runtime: 더 나은 성능으로 짧은 지연 시간의 추론이 필요한 C++ 환경에 적합합니다.

자세한 배포 옵션은 TensorFlow 모델 배포에 대한 공식 가이드를 참조하십시오.

YOLO26 모델을 내보내는 데 필요한 패키지를 어떻게 설치할 수 있나요?

YOLO26 모델을 내보내려면 다음을 설치해야 합니다. ultralytics 패키지. 터미널에서 다음 명령을 실행합니다:

pip install ultralytics

자세한 설치 지침 및 모범 사례는 Ultralytics 설치 가이드를 참조하십시오. 문제가 발생하면 일반적인 문제 가이드를 참조하십시오.

TensorFlow SavedModel 형식의 주요 특징은 무엇입니까?

TF SavedModel 형식은 다음과 같은 기능으로 인해 AI 개발자에게 유용합니다.

- 이식성: 다양한 환경에서 손쉽게 공유하고 배포할 수 있습니다.

- 쉬운 배포: 계산 그래프, 훈련된 파라미터 및 메타데이터를 단일 패키지로 캡슐화하여 로딩 및 추론을 간소화합니다.

- 자산 관리: 어휘와 같은 외부 자산을 지원하여 모델이 로드될 때 사용할 수 있도록 합니다.

자세한 내용은 공식 TensorFlow 문서를 참조하십시오.