배포를 위한 YOLO26 모델 TFLite 내보내기 가이드

에지 장치 또는 임베디드 장치에 컴퓨터 비전 모델을 배포하려면 원활한 성능을 보장할 수 있는 형식이 필요합니다.

TensorFlow Lite 또는 TFLite 내보내기 형식을 사용하면 엣지 장치 기반 애플리케이션에서 Ultralytics YOLO26 모델을 object detect 및 image classification과 같은 작업에 최적화할 수 있습니다. 이 가이드에서는 모델을 TFLite 형식으로 변환하는 단계를 안내하여 모델이 다양한 엣지 장치에서 더 잘 작동하도록 돕습니다.

TFLite로 내보내야 하는 이유

Google이 2017년 5월 TensorFlow 프레임워크의 일부로 소개한 TensorFlow Lite, 줄여서 TFLite는 엣지 컴퓨팅으로도 알려진 온디바이스 추론을 위해 설계된 오픈소스 딥러닝 프레임워크입니다. 이는 개발자들이 훈련된 모델을 모바일, 임베디드, IoT 장치뿐만 아니라 기존 컴퓨터에서도 실행할 수 있도록 필요한 도구를 제공합니다.

TensorFlow Lite는 임베디드 Linux, Android, iOS, 마이크로컨트롤러(MCU)를 포함한 광범위한 플랫폼과 호환됩니다. 모델을 TFLite로 내보내면 애플리케이션이 더 빠르고 안정적이며 오프라인으로 실행될 수 있습니다.

TFLite 모델의 주요 기능

TFLite 모델은 개발자들이 모바일, 임베디드, 엣지 장치에서 모델을 실행할 수 있도록 지원하여 온디바이스 머신러닝을 가능하게 하는 다양한 주요 기능을 제공합니다:

온디바이스 최적화: TFLite는 온디바이스 ML에 최적화되어 데이터를 로컬에서 처리하여 지연 시간을 줄이고, 개인 데이터를 전송하지 않아 개인 정보 보호를 강화하며, 모델 크기를 최소화하여 공간을 절약합니다.

다중 플랫폼 지원: TFLite는 Android, iOS, 임베디드 Linux 및 마이크로컨트롤러를 지원하는 광범위한 플랫폼 호환성을 제공합니다.

다양한 언어 지원: TFLite는 Java, Swift, Objective-C, C++, Python을 포함한 다양한 프로그래밍 언어와 호환됩니다.

고성능: 하드웨어 가속 및 모델 최적화를 통해 뛰어난 성능을 달성합니다.

TFLite의 배포 옵션

YOLO26 모델을 TFLite 형식으로 내보내는 코드를 살펴보기 전에 TFLite 모델이 일반적으로 어떻게 사용되는지 이해해 봅시다.

TFLite는 머신러닝 모델을 위한 다양한 온디바이스 배포 옵션을 제공합니다. 다음은 그 예시입니다:

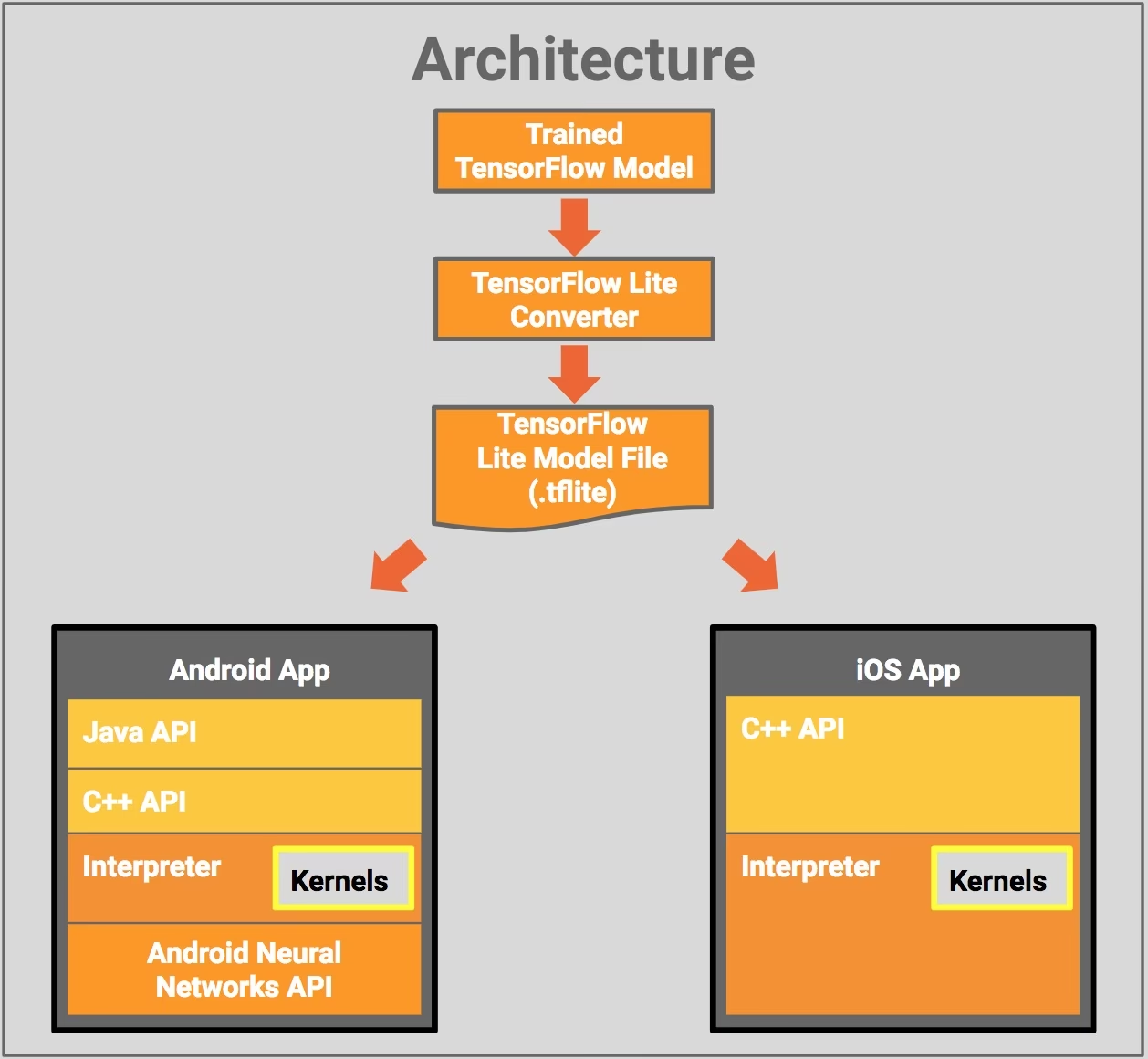

- Android 및 iOS로 배포: TFLite를 사용하는 Android 및 iOS 애플리케이션은 엣지 기반 카메라 피드와 센서를 분석하여 객체를 detect하고 식별할 수 있습니다. TFLite는 또한 Swift 및 Objective-C로 작성된 네이티브 iOS 라이브러리를 제공합니다. 아래 아키텍처 다이어그램은 TensorFlow Lite를 사용하여 훈련된 모델을 Android 및 iOS 플랫폼에 배포하는 과정을 보여줍니다.

임베디드 Linux로 구현: Raspberry Pi에서 Ultralytics 가이드를 사용하여 추론을 실행하는 것이 사용 사례의 속도 요구 사항을 충족하지 못하는 경우, 내보낸 TFLite 모델을 사용하여 추론 시간을 가속화할 수 있습니다. 또한 Coral Edge TPU 장치를 활용하여 성능을 더욱 향상시킬 수 있습니다.

마이크로컨트롤러로 배포: TFLite 모델은 마이크로컨트롤러 및 수 킬로바이트의 메모리만 있는 다른 장치에도 배포할 수 있습니다. 코어 런타임은 Arm Cortex M3에서 16KB에 불과하며 많은 기본 모델을 실행할 수 있습니다. 운영 체제 지원, 표준 C 또는 C++ 라이브러리 또는 동적 메모리 할당이 필요하지 않습니다.

TFLite로 내보내기: YOLO26 모델 변환하기

모델을 TFLite 형식으로 변환하여 온디바이스 모델 실행 효율성을 개선하고 성능을 최적화할 수 있습니다.

설치

필수 패키지를 설치하려면 다음을 실행합니다:

설치

# Install the required package for YOLO26

pip install ultralytics

설치 과정과 관련된 자세한 지침 및 모범 사례는 Ultralytics 설치 가이드를 확인하십시오. YOLO26에 필요한 패키지를 설치하는 동안 어려움이 발생하면 해결책과 팁을 얻기 위해 일반적인 문제 가이드를 참조하십시오.

사용법

모든 Ultralytics YOLO26 모델은 기본적으로 내보내기를 지원하도록 설계되어 선호하는 배포 워크플로에 쉽게 통합할 수 있습니다. 애플리케이션에 가장 적합한 설정을 선택하려면 지원되는 내보내기 형식 및 구성 옵션의 전체 목록을 볼 수 있습니다.

사용법

from ultralytics import YOLO

# Load the YOLO26 model

model = YOLO("yolo26n.pt")

# Export the model to TFLite format

model.export(format="tflite") # creates 'yolo26n_float32.tflite'

# Load the exported TFLite model

tflite_model = YOLO("yolo26n_float32.tflite")

# Run inference

results = tflite_model("https://ultralytics.com/images/bus.jpg")

# Export a YOLO26n PyTorch model to TFLite format

yolo export model=yolo26n.pt format=tflite # creates 'yolo26n_float32.tflite'

# Run inference with the exported model

yolo predict model='yolo26n_float32.tflite' source='https://ultralytics.com/images/bus.jpg'

인수 내보내기

| 인수 | 유형 | 기본값 | 설명 |

|---|---|---|---|

format | str | 'tflite' | 다양한 배포 환경과의 호환성을 정의하는 내보낸 모델의 대상 형식입니다. |

imgsz | int 또는 tuple | 640 | 모델 입력에 대한 원하는 이미지 크기입니다. 정사각형 이미지의 경우 정수이거나 튜플일 수 있습니다. (height, width) 특정 크기의 경우. |

half | bool | False | FP16(반정밀도) 양자화를 활성화하여 모델 크기를 줄이고 지원되는 하드웨어에서 추론 속도를 높일 수 있습니다. |

int8 | bool | False | INT8 양자화를 활성화하여 모델을 더욱 압축하고 정확도 손실을 최소화하면서 추론 속도를 높입니다(주로 에지 장치용). |

nms | bool | False | 정확하고 효율적인 detect 후처리(post-processing)에 필수적인 Non-Maximum Suppression (NMS)을 추가합니다. |

batch | int | 1 | 내보내기 모델 배치 추론 크기 또는 내보내기 모델이 동시에 처리할 이미지의 최대 수를 지정합니다. predict mode. |

data | str | 'coco8.yaml' | 다음 경로: 데이터 세트 구성 파일(기본값: coco8.yaml), 양자화에 필수적입니다. |

fraction | float | 1.0 | INT8 양자화 보정에 사용할 데이터 세트의 비율을 지정합니다. 전체 데이터 세트의 하위 집합에서 보정할 수 있으므로 실험이나 리소스가 제한적일 때 유용합니다. INT8을 활성화한 상태에서 지정하지 않으면 전체 데이터 세트가 사용됩니다. |

device | str | None | 내보내기 장치를 지정합니다: CPU (device=cpu), Apple Silicon용 MPS (device=mps)입니다. |

내보내기 프로세스에 대한 자세한 내용은 내보내기에 대한 Ultralytics 문서 페이지를 참조하십시오.

내보낸 YOLO26 TFLite 모델 배포하기

Ultralytics YOLO26 모델을 TFLite 형식으로 성공적으로 내보낸 후 이제 배포할 수 있습니다. TFLite 모델을 실행하기 위한 주요 권장 첫 번째 단계는 다음을 사용하는 것입니다. YOLO("model.tflite") 이전 사용 코드 스니펫에 설명된 방법입니다. 그러나 다양한 다른 환경에서 TFLite 모델을 배포하는 방법에 대한 심층적인 지침은 다음 자료를 참조하십시오:

Android: TensorFlow Lite를 Android 애플리케이션에 통합하기 위한 빠른 시작 가이드로, 머신 러닝 모델을 설정하고 실행하기 위한 따라하기 쉬운 단계를 제공합니다.

iOS: iOS 애플리케이션에서 TensorFlow Lite 모델을 통합하고 배포하는 방법에 대한 개발자를 위한 자세한 가이드를 확인하여 단계별 지침과 리소스를 제공합니다.

End-To-End Examples: 이 페이지에서는 다양한 TensorFlow Lite 예제에 대한 개요를 제공하여 개발자가 모바일 및 에지 장치에서 머신 러닝 프로젝트에 TensorFlow Lite를 구현하는 데 도움이 되도록 설계된 실용적인 애플리케이션 및 자습서를 보여줍니다.

요약

이 가이드에서는 TFLite 형식으로 내보내는 방법에 중점을 두었습니다. Ultralytics YOLO26 모델을 TFLite 모델 형식으로 변환함으로써 YOLO26 모델의 효율성과 속도를 향상시켜 엣지 컴퓨팅 환경에 더 효과적이고 적합하게 만들 수 있습니다.

사용법에 대한 자세한 내용은 TFLite 공식 문서를 참조하십시오.

또한, 다른 Ultralytics YOLO26 통합에 대해 궁금하다면 저희 통합 가이드 페이지를 확인해 보세요. 거기서 많은 유용한 정보와 통찰력을 찾을 수 있을 것입니다.

FAQ

YOLO26 모델을 TFLite 형식으로 내보내려면 어떻게 해야 합니까?

YOLO26 모델을 TFLite 형식으로 내보내려면 Ultralytics 라이브러리를 사용할 수 있습니다. 먼저 다음을 사용하여 필요한 패키지를 설치하십시오.

pip install ultralytics

다음으로, 아래 코드 스니펫을 사용하여 모델을 내보냅니다.

from ultralytics import YOLO

# Load the YOLO26 model

model = YOLO("yolo26n.pt")

# Export the model to TFLite format

model.export(format="tflite") # creates 'yolo26n_float32.tflite'

CLI 사용자의 경우 다음 명령어로 이를 수행할 수 있습니다:

yolo export model=yolo26n.pt format=tflite # creates 'yolo26n_float32.tflite'

자세한 내용은 Ultralytics 내보내기 가이드를 참조하십시오.

YOLO26 모델 배포에 TensorFlow Lite를 사용하는 이점은 무엇입니까?

TensorFlow Lite (TFLite)는 온디바이스 추론을 위해 설계된 오픈 소스 deep learning 프레임워크로, 모바일, 임베디드 및 IoT 장치에 YOLO26 모델을 배포하는 데 이상적입니다. 주요 이점은 다음과 같습니다.

- 장치 내 최적화: 데이터를 로컬에서 처리하여 대기 시간을 최소화하고 개인 정보 보호를 강화합니다.

- 플랫폼 호환성: Android, iOS, 임베디드 Linux 및 MCU를 지원합니다.

- 성능: 하드웨어 가속을 활용하여 모델 속도와 효율성을 최적화합니다.

더 자세한 내용은 TFLite 가이드를 확인하십시오.

YOLO26 TFLite 모델을 Raspberry Pi에서 실행할 수 있습니까?

예, 추론 속도를 향상시키기 위해 Raspberry Pi에서 YOLO26 TFLite 모델을 실행할 수 있습니다. 먼저 위에서 설명한 대로 모델을 TFLite 형식으로 내보내십시오. 그런 다음 TensorFlow Lite Interpreter와 같은 도구를 사용하여 Raspberry Pi에서 모델을 실행하십시오.

추가 최적화를 위해 Coral Edge TPU 사용을 고려할 수 있습니다. 자세한 단계는 Raspberry Pi 배포 가이드 및 Edge TPU 통합 가이드를 참조하십시오.

YOLO26 예측을 위해 마이크로컨트롤러에서 TFLite 모델을 사용할 수 있습니까?

예, TFLite는 제한된 리소스를 가진 마이크로컨트롤러에 배포를 지원합니다. TFLite의 코어 런타임은 Arm Cortex M3에서 단 16KB의 메모리만 필요하며 기본 YOLO26 모델을 실행할 수 있습니다. 이는 최소한의 연산 능력과 메모리를 가진 장치에 배포하기에 적합합니다.

시작하려면 마이크로컨트롤러용 TFLite Micro 가이드를 방문하십시오.

TFLite로 내보낸 YOLO26 모델과 호환되는 플랫폼은 무엇입니까?

TensorFlow Lite는 광범위한 플랫폼 호환성을 제공하여 다음과 같은 다양한 장치에 YOLO26 모델을 배포할 수 있도록 합니다.

- Android 및 iOS: TFLite Android 및 iOS 라이브러리를 통해 기본 지원합니다.

- 임베디드 Linux: Raspberry Pi와 같은 싱글 보드 컴퓨터에 적합합니다.

- 마이크로컨트롤러: 제한된 리소스를 가진 MCU에 적합합니다.

배포 옵션에 대한 자세한 내용은 자세한 배포 가이드를 참조하십시오.

YOLO26 모델을 TFLite로 내보내는 동안 발생하는 일반적인 문제를 어떻게 해결합니까?

YOLO26 모델을 TFLite로 내보내는 동안 오류가 발생하면 일반적인 해결책은 다음과 같습니다.

- 패키지 호환성 확인: Ultralytics 및 TensorFlow의 호환되는 버전을 사용하고 있는지 확인하십시오. 설치 가이드를 참조하십시오.

- 모델 지원: Ultralytics 내보내기 문서 페이지를 확인하여 특정 YOLO26 모델이 TFLite 내보내기를 지원하는지 확인하십시오.

- 양자화 문제: INT8 양자화를 사용할 때는 데이터세트 경로가 다음 위치에 올바르게 지정되었는지 확인하세요.

data파라미터입니다.

추가 문제 해결 팁은 일반적인 문제 가이드를 참조하십시오.