Recorte de Objetos usando Ultralytics YOLO26

O que é o Recorte de Objetos?

O recorte de objetos com Ultralytics YOLO26 envolve isolar e extrair objetos detectados específicos de uma imagem ou vídeo. As capacidades do modelo YOLO26 são utilizadas para identificar e delinear objetos com precisão, permitindo um recorte exato para análise ou manipulação posterior.

Assista: Recorte de Objetos usando Ultralytics YOLO

Vantagens do Recorte de Objetos

- Análise Focada: O YOLO26 facilita o recorte de objetos direcionado, permitindo um exame aprofundado ou processamento de itens individuais dentro de uma cena.

- Volume de Dados Reduzido: Ao extrair apenas objetos relevantes, o recorte de objetos ajuda a minimizar o tamanho dos dados, tornando-o eficiente para armazenamento, transmissão ou tarefas computacionais subsequentes.

- Precisão Aprimorada: A detecção de objetos e precisão do YOLO26 garantem que os objetos recortados mantenham suas relações espaciais, preservando a integridade das informações visuais para análise detalhada.

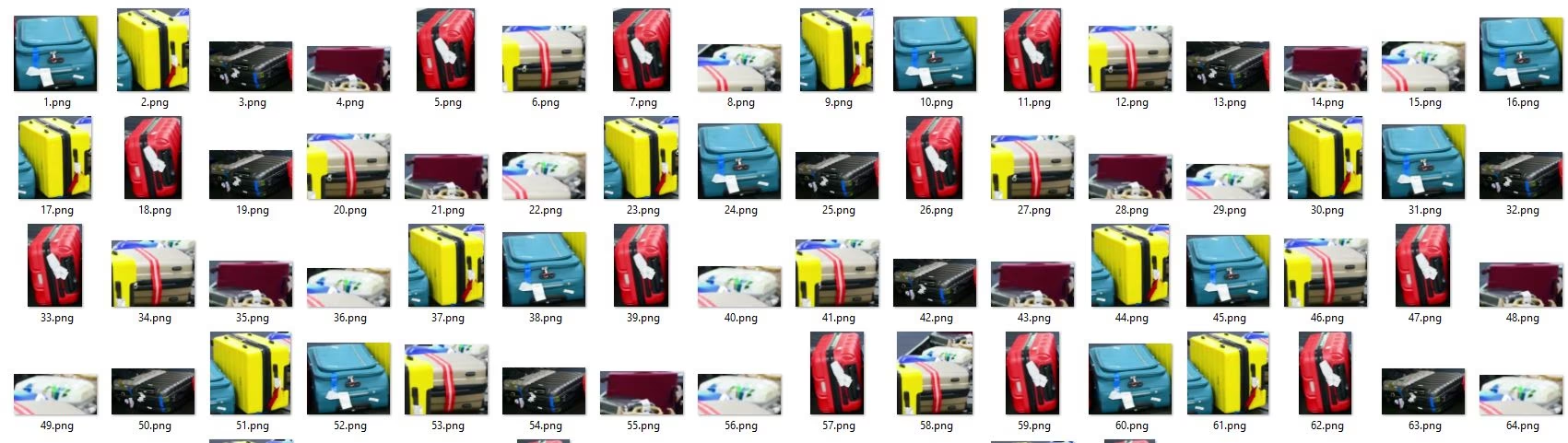

Visuais

| Bagagem de Aeroporto |

|---|

|

| Recorte de Malas em esteira de bagagens do aeroporto usando Ultralytics YOLO26 |

Recorte de Objetos usando Ultralytics YOLO

# Crop the objects

yolo solutions crop show=True

# Pass a source video

yolo solutions crop source="path/to/video.mp4"

# Crop specific classes

yolo solutions crop classes="[0, 2]"

import cv2

from ultralytics import solutions

cap = cv2.VideoCapture("path/to/video.mp4")

assert cap.isOpened(), "Error reading video file"

# Initialize object cropper

cropper = solutions.ObjectCropper(

show=True, # display the output

model="yolo26n.pt", # model for object cropping, e.g., yolo26x.pt.

classes=[0, 2], # crop specific classes such as person and car with the COCO pretrained model.

# conf=0.5, # adjust confidence threshold for the objects.

# crop_dir="cropped-detections", # set the directory name for cropped detections

)

# Process video

while cap.isOpened():

success, im0 = cap.read()

if not success:

print("Video frame is empty or processing is complete.")

break

results = cropper(im0)

# print(results) # access the output

cap.release()

cv2.destroyAllWindows() # destroy all opened windows

Quando você fornece o opcional crop_dir argumento, cada objeto recortado é gravado nessa pasta com nomes de arquivos que incluem o nome da imagem de origem e a classe. Isso facilita a inspeção de detecções ou a construção de conjuntos de dados downstream sem escrever código extra.

ObjectCropper Argumentos

Aqui está uma tabela com o ObjectCropper argumentos:

| Argumento | Tipo | Padrão | Descrição |

|---|---|---|---|

model | str | None | Caminho para um arquivo de modelo Ultralytics YOLO. |

crop_dir | str | 'cropped-detections' | Nome do diretório para armazenar detecções recortadas. |

Além disso, os seguintes argumentos de visualização estão disponíveis para uso:

| Argumento | Tipo | Padrão | Descrição |

|---|---|---|---|

show | bool | False | Se True, exibe as imagens ou vídeos anotados em uma janela. Útil para feedback visual imediato durante o desenvolvimento ou teste. |

line_width | int or None | None | Especifica a largura da linha das caixas delimitadoras. Se None, a largura da linha é ajustada automaticamente com base no tamanho da imagem. Fornece personalização visual para clareza. |

FAQ

O que é recorte de objetos no Ultralytics YOLO26 e como funciona?

O recorte de objetos usando Ultralytics YOLO26 envolve isolar e extrair objetos específicos de uma imagem ou vídeo com base nas capacidades de detecção do YOLO26. Este processo permite análise focada, volume de dados reduzido e precisão aprimorada, aproveitando o YOLO26 para identificar objetos com alta precisão e recortá-los de acordo. Para um tutorial aprofundado, consulte o exemplo de recorte de objetos.

Por que devo usar o Ultralytics YOLO26 para recorte de objetos em vez de outras soluções?

O Ultralytics YOLO26 se destaca por sua precisão, velocidade e facilidade de uso. Ele permite a detecção e o recorte detalhados e precisos de objetos, essenciais para análise focada e aplicações que exigem alta integridade de dados. Além disso, o YOLO26 se integra perfeitamente com ferramentas como OpenVINO e TensorRT para implantações que exigem capacidades em tempo real e otimização em diversos hardwares. Explore os benefícios no guia de exportação de modelos.

Como posso reduzir o volume de dados do meu conjunto de dados usando o recorte de objetos?

Ao usar o Ultralytics YOLO26 para recortar apenas objetos relevantes de suas imagens ou vídeos, você pode reduzir significativamente o tamanho dos dados, tornando-os mais eficientes para armazenamento e processamento. Este processo envolve treinar o modelo para detect objetos específicos e, em seguida, usar os resultados para recortar e salvar apenas essas porções. Para mais informações sobre como explorar as capacidades do Ultralytics YOLO26, visite nosso guia de início rápido.

Posso usar o Ultralytics YOLO26 para análise de vídeo em tempo real e recorte de objetos?

Sim, o Ultralytics YOLO26 pode processar feeds de vídeo em tempo real para detect e recortar objetos dinamicamente. As capacidades de inferência de alta velocidade do modelo o tornam ideal para aplicações em tempo real, como vigilância, análise esportiva e sistemas de inspeção automatizados. Consulte os modos de rastreamento e previsão para entender como implementar o processamento em tempo real.

Quais são os requisitos de hardware para executar eficientemente o YOLO26 para recorte de objetos?

O Ultralytics YOLO26 é otimizado para ambientes de CPU e GPU, mas para alcançar o desempenho ideal, especialmente para inferência em tempo real ou de alto volume, uma GPU dedicada (por exemplo, NVIDIA Tesla, série RTX) é recomendada. Para implantação em dispositivos leves, considere usar CoreML para iOS ou TFLite para Android. Mais detalhes sobre dispositivos e formatos suportados podem ser encontrados em nossas opções de implantação de modelo.