Intel OpenVINO Dışa Aktarma

Bu kılavuzda, YOLO26 modellerini OpenVINO formatına aktarmayı ele alıyoruz. Bu format, 3 kata kadar CPU hızlandırması sağlayabilir ve Intel GPU ve NPU donanımında YOLO çıkarımını hızlandırabilir.

Açık Görsel Çıkarım ve Sinir Ağı Optimizasyon araç setinin kısaltması olan OpenVINO, AI çıkarım modellerini optimize etmek ve dağıtmak için kapsamlı bir araç setidir. Adında Görsel geçmesine rağmen, OpenVINO dil, ses, zaman serileri vb. gibi çeşitli ek görevleri de destekler.

İzle: Ultralytics YOLO26'yı Daha Hızlı Çıkarım için Intel OpenVINO Formatına Nasıl Aktarırsınız 🚀

Kullanım Örnekleri

Bir YOLO26n modelini OpenVINO formatına aktarın ve aktarılmış modelle çıkarım yapın.

Örnek

from ultralytics import YOLO

# Load a YOLO26n PyTorch model

model = YOLO("yolo26n.pt")

# Export the model

model.export(format="openvino") # creates 'yolo26n_openvino_model/'

# Load the exported OpenVINO model

ov_model = YOLO("yolo26n_openvino_model/")

# Run inference

results = ov_model("https://ultralytics.com/images/bus.jpg")

# Run inference with specified device, available devices: ["intel:gpu", "intel:npu", "intel:cpu"]

results = ov_model("https://ultralytics.com/images/bus.jpg", device="intel:gpu")

# Export a YOLO26n PyTorch model to OpenVINO format

yolo export model=yolo26n.pt format=openvino # creates 'yolo26n_openvino_model/'

# Run inference with the exported model

yolo predict model=yolo26n_openvino_model source='https://ultralytics.com/images/bus.jpg'

# Run inference with specified device, available devices: ["intel:gpu", "intel:npu", "intel:cpu"]

yolo predict model=yolo26n_openvino_model source='https://ultralytics.com/images/bus.jpg' device="intel:gpu"

Dışa Aktarma Argümanları

| Argüman | Tür | Varsayılan | Açıklama |

|---|---|---|---|

format | str | 'openvino' | Çeşitli dağıtım ortamlarıyla uyumluluğu tanımlayan, dışa aktarılan modelin hedef formatı. |

imgsz | int veya tuple | 640 | Model girişi için istenen görüntü boyutu. Kare görüntüler için bir tamsayı veya bir demet olabilir (height, width) belirli boyutlar için. |

half | bool | False | FP16 (yarı duyarlıklı) nicelemeyi etkinleştirir, model boyutunu küçültür ve desteklenen donanımda çıkarımı potansiyel olarak hızlandırır. |

int8 | bool | False | INT8 nicelemesini etkinleştirir, modeli daha da sıkıştırır ve öncelikle uç cihazlar için minimum doğruluk kaybıyla çıkarımı hızlandırır. |

dynamic | bool | False | Değişken görüntü boyutlarını işlemede esnekliği artırarak dinamik giriş boyutlarına olanak tanır. |

nms | bool | False | Doğru ve verimli detect etme işlem sonrası için gerekli olan Non-Maximum Suppression'ı (NMS) ekler. |

batch | int | 1 | Dışa aktarma modeli toplu çıkarım boyutunu veya dışa aktarılan modelin aynı anda işleyeceği maksimum görüntü sayısını belirtir. predict modu. |

data | str | 'coco8.yaml' | Şuraya giden yol: veri kümesi yapılandırma dosyası (varsayılan: coco8.yaml), niceleme için önemlidir. |

fraction | float | 1.0 | Veri kümesinin INT8 niceleme kalibrasyonu için kullanılacak kısmını belirtir. Tam veri kümesinin bir alt kümesi üzerinde kalibrasyon yapılmasına olanak tanır, bu da deneyler için veya kaynaklar sınırlı olduğunda kullanışlıdır. INT8 etkinleştirilmişse belirtilmezse, tam veri kümesi kullanılır. |

Dışa aktarma süreci hakkında daha fazla bilgi için Ultralytics'in dışa aktarma hakkındaki dokümantasyon sayfasını ziyaret edin.

Uyarı

OpenVINO™ çoğu Intel® işlemciyle uyumludur, ancak optimum performansı sağlamak için:

OpenVINO™ desteğini doğrulayın Intel® çipinizin OpenVINO™ tarafından resmi olarak desteklenip desteklenmediğini Intel'in uyumluluk listesini kullanarak kontrol edin.

Hızlandırıcınızı belirleyin Intel'in donanım kılavuzuna başvurarak işlemcinizin entegre bir NPU (Nöral İşlem Birimi) veya GPU (entegre GPU) içerip içermediğini belirleyin.

Öğeniz bir NPU veya GPU'yu destekliyorsa ancak OpenVINO™ bunu algılamıyorsa, ilgili sürücüleri yüklemeniz veya güncellemeniz gerekebilir. Tam hızlandırmayı etkinleştirmek için sürücü yükleme talimatlarını izleyin.

Bu üç adımı izleyerek, OpenVINO™'nun Intel® donanımınızda en iyi şekilde çalışmasını sağlayabilirsiniz.

OpenVINO'nun Faydaları

- Performans: OpenVINO, Intel CPU'larının, entegre ve ayrık GPU'ların ve FPGA'lerin gücünü kullanarak yüksek performanslı çıkarım sağlar.

- Heterojen Yürütme Desteği: OpenVINO, bir kez yazıp desteklenen herhangi bir Intel donanımında (CPU, GPU, FPGA, VPU, vb.) dağıtmak için bir API sağlar.

- Model Optimizatörü: OpenVINO, PyTorch, TensorFlow, TensorFlow Lite, Keras, ONNX, PaddlePaddle ve Caffe gibi popüler derin öğrenme framework'lerinden modelleri içe aktaran, dönüştüren ve optimize eden bir Model Optimizatörü sağlar.

- Kullanım Kolaylığı: Araç seti, araç setinin farklı yönlerini öğreten (YOLOv8 optimizasyonu dahil) 80'den fazla eğitim not defteriyle birlikte gelir.

OpenVINO Dışa Aktarma Yapısı

Bir modeli OpenVINO formatına aktardığınızda, aşağıdakileri içeren bir dizinle sonuçlanır:

- XML dosyası: Ağ topolojisini tanımlar.

- BIN dosyası: Ağırlıklar ve yanlılıklar ikili verilerini içerir.

- Eşleme dosyası: Orijinal model çıktı tensörlerinin OpenVINO tensör adlarına eşlemesini tutar.

Bu dosyaları OpenVINO Inference Engine ile çıkarım yapmak için kullanabilirsiniz.

Dağıtımda OpenVINO Dışa Aktarımını Kullanma

Modeliniz OpenVINO biçiminde başarıyla dışa aktarıldıktan sonra, çıkarımı çalıştırmak için iki temel seçeneğiniz vardır:

Şunu kullanın:

ultralyticsyüksek düzeyli bir API sağlayan ve OpenVINO Runtime'ı saran paket.Yerel olanı kullanın

openvinoçıkarım davranışı üzerinde daha gelişmiş veya özelleştirilmiş kontrol için paket.

Ultralytics ile Çıkarım

Ultralytics paketi, dışa aktarılan OpenVINO modelini tahmin yöntemiyle kullanarak kolayca çıkarım çalıştırmanıza olanak tanır. Ayrıca hedef cihazı da belirtebilirsiniz (örneğin, intel:gpu, intel:npu, intel:cpu) cihaz argümanını kullanarak.

from ultralytics import YOLO

# Load the exported OpenVINO model

ov_model = YOLO("yolo26n_openvino_model/") # the path of your exported OpenVINO model

# Run inference with the exported model

ov_model.predict(device="intel:gpu") # specify the device you want to run inference on

Bu yaklaşım, çıkarım hattı üzerinde tam kontrole ihtiyaç duymadığınız durumlarda hızlı prototipleme veya dağıtım için idealdir.

OpenVINO Runtime ile Çıkarım

OpenVINO Runtime, desteklenen tüm Intel donanımlarında çıkarım için birleşik bir API sağlar. Ayrıca Intel donanımları arasında yük dengeleme ve eşzamansız yürütme gibi gelişmiş yetenekler sunar. Çıkarım çalıştırma hakkında daha fazla bilgi için YOLO26 not defterlerine bakın.

Unutmayın, modeli Çalışma Zamanı ile doğru şekilde kurmak ve kullanmak için XML ve BIN dosyalarının yanı sıra giriş boyutu, normalleştirme için ölçek faktörü vb. gibi uygulamaya özel ayarlara da ihtiyacınız olacaktır.

Dağıtım uygulamanızda, genellikle aşağıdaki adımları yaparsınız:

- oluşturarak OpenVINO'yu başlat

core = Core(). - Modeli kullanarak yükleyin

core.read_model()yöntemi. - Modeli kullanarak derleyin

core.compile_model()fonksiyonu. - Girdiyi hazırlayın (resim, metin, ses vb.).

- Kullanarak çıkarım çalıştırın

compiled_model(input_data).

Daha ayrıntılı adımlar ve kod parçacıkları için OpenVINO dökümanlarına veya API eğitimine bakın.

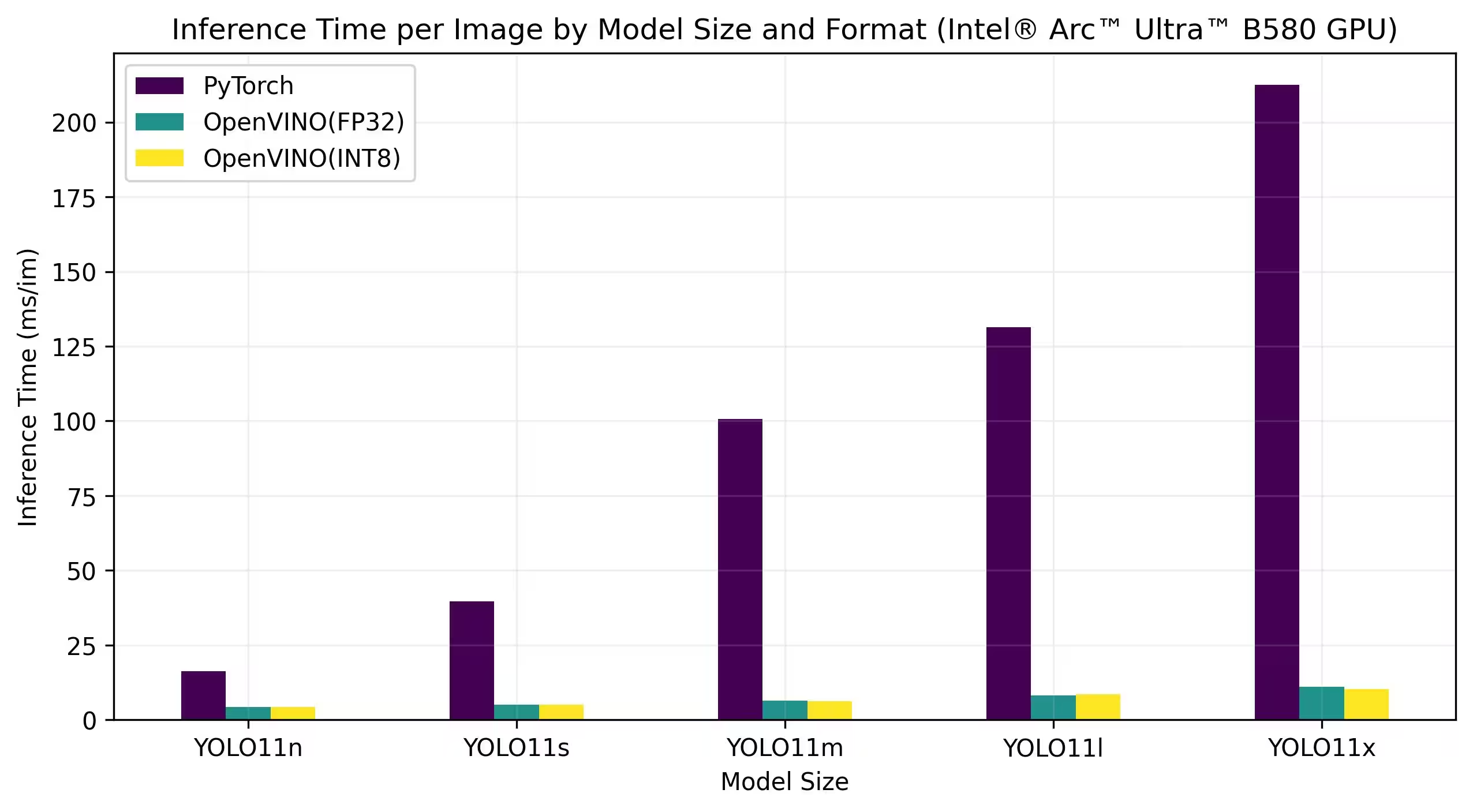

OpenVINO YOLO11 Kıyaslamaları

Ultralytics ekibi, OpenVINO ile uyumlu farklı Intel cihazlarında hızı ve doğruluğu değerlendirerek çeşitli model formatları ve kesinlik genelinde YOLO11'i kıyasladı.

Not

Aşağıdaki kıyaslama sonuçları referans amaçlıdır ve bir sistemin kesin donanım ve yazılım yapılandırmasına ve ayrıca kıyaslamaların yapıldığı andaki sistemin mevcut iş yüküne bağlı olarak değişebilir.

Tüm kıyaslamalar şunlarla çalıştırılır: openvino python paket sürümü 2025.1.0.

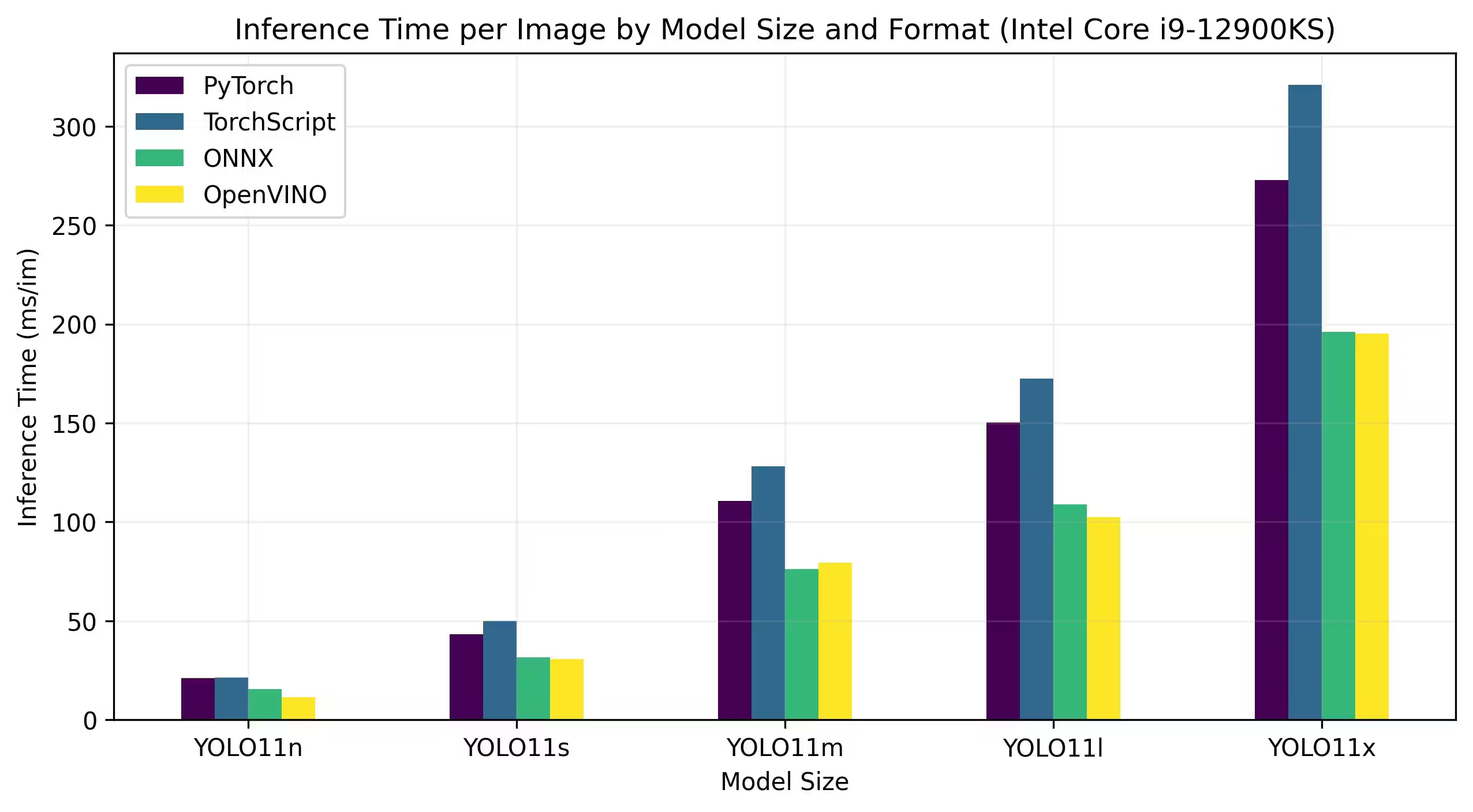

Intel Core CPU

Intel® Core® serisi, Intel tarafından üretilen yüksek performanslı işlemcilerden oluşan bir seridir. Bu seri, Core i3 (giriş seviyesi), Core i5 (orta seviye), Core i7 (üst seviye) ve Core i9 (aşırı performans) işlemcilerini içerir. Her seri, günlük görevlerden zorlu profesyonel iş yüklerine kadar farklı bilgi işlem ihtiyaçlarına ve bütçelere hitap eder. Her yeni nesilde, performans, enerji verimliliği ve özelliklerde iyileştirmeler yapılır.

Aşağıdaki kıyaslamalar, FP32 hassasiyetinde 12. Nesil Intel® Core® i9-12900KS CPU üzerinde çalışır.

Ayrıntılı Kıyaslama Sonuçları

| Model | Format | Durum | Boyut (MB) | metrikler/mAP50-95(B) | Çıkarım süresi (ms/im) |

|---|---|---|---|---|---|

| YOLO11n | PyTorch | ✅ | 5.4 | 0.5071 | 21.00 |

| YOLO11n | TorchScript | ✅ | 10.5 | 0.5077 | 21.39 |

| YOLO11n | ONNX | ✅ | 10.2 | 0.5077 | 15.55 |

| YOLO11n | OpenVINO | ✅ | 10.4 | 0.5077 | 11.49 |

| YOLO11s | PyTorch | ✅ | 18.4 | 0.5770 | 43.16 |

| YOLO11s | TorchScript | ✅ | 36.6 | 0.5781 | 50.06 |

| YOLO11s | ONNX | ✅ | 36.3 | 0.5781 | 31.53 |

| YOLO11s | OpenVINO | ✅ | 36.4 | 0.5781 | 30.82 |

| YOLO11m | PyTorch | ✅ | 38.8 | 0.6257 | 110.60 |

| YOLO11m | TorchScript | ✅ | 77.3 | 0.6306 | 128.09 |

| YOLO11m | ONNX | ✅ | 76.9 | 0.6306 | 76.06 |

| YOLO11m | OpenVINO | ✅ | 77.1 | 0.6306 | 79.38 |

| YOLO11l | PyTorch | ✅ | 49.0 | 0.6367 | 150.38 |

| YOLO11l | TorchScript | ✅ | 97.7 | 0.6408 | 172.57 |

| YOLO11l | ONNX | ✅ | 97.0 | 0.6408 | 108.91 |

| YOLO11l | OpenVINO | ✅ | 97.3 | 0.6408 | 102.30 |

| YOLO11x | PyTorch | ✅ | 109.3 | 0.6989 | 272.72 |

| YOLO11x | TorchScript | ✅ | 218.1 | 0.6900 | 320.86 |

| YOLO11x | ONNX | ✅ | 217.5 | 0.6900 | 196.20 |

| YOLO11x | OpenVINO | ✅ | 217.8 | 0.6900 | 195.32 |

Intel® Core™ Ultra

Intel® Core™ Ultra™ serisi, oyuncular ve içerik oluşturuculardan yapay zekadan yararlanan profesyonellere kadar modern kullanıcıların gelişen taleplerini karşılamak üzere tasarlanmış, yüksek performanslı bilişimde yeni bir ölçüt temsil ediyor. Bu yeni nesil ürün grubu, geleneksel bir CPU serisinden daha fazlasıdır; güçlü CPU çekirdeklerini, entegre yüksek performanslı GPU özelliklerini ve tek bir çip içinde özel bir Nöral İşleme Birimini (NPU) birleştirerek çeşitli ve yoğun bilgi işlem iş yükleri için birleşik bir çözüm sunar.

Intel® Core Ultra™ mimarisinin kalbinde, geleneksel işleme görevleri, GPU hızlandırmalı iş yükleri ve yapay zeka odaklı operasyonlar genelinde olağanüstü performans sağlayan hibrit bir tasarım bulunur. NPU'nun dahil edilmesi, cihaz üzerinde yapay zeka çıkarımını geliştirerek, çok çeşitli uygulamalarda daha hızlı, daha verimli makine öğrenimi ve veri işlemeyi mümkün kılar.

Core Ultra™ ailesi, enerji açısından verimli tasarımlardan, ciddi bilgi işlem gücü gerektiren dizüstü bilgisayarlar ve kompakt form faktörleri için ideal olan "H" tanımıyla işaretlenmiş yüksek güçlü varyantlara kadar farklı performans ihtiyaçlarına göre uyarlanmış çeşitli modeller içerir. Seri genelinde, kullanıcılar CPU, GPU ve NPU entegrasyonunun sinerjisinden yararlanarak olağanüstü verimlilik, yanıt verme ve çoklu görev yetenekleri sunar.

Intel'in devam eden inovasyonunun bir parçası olarak, Core Ultra™ serisi, geleceğe hazır bilgi işlem için yeni bir standart belirliyor. Mevcut birden fazla model ve ufukta daha fazlası ile bu seri, Intel'in yeni nesil akıllı, AI ile geliştirilmiş cihazlar için en son teknoloji çözümler sunma taahhüdünün altını çiziyor.

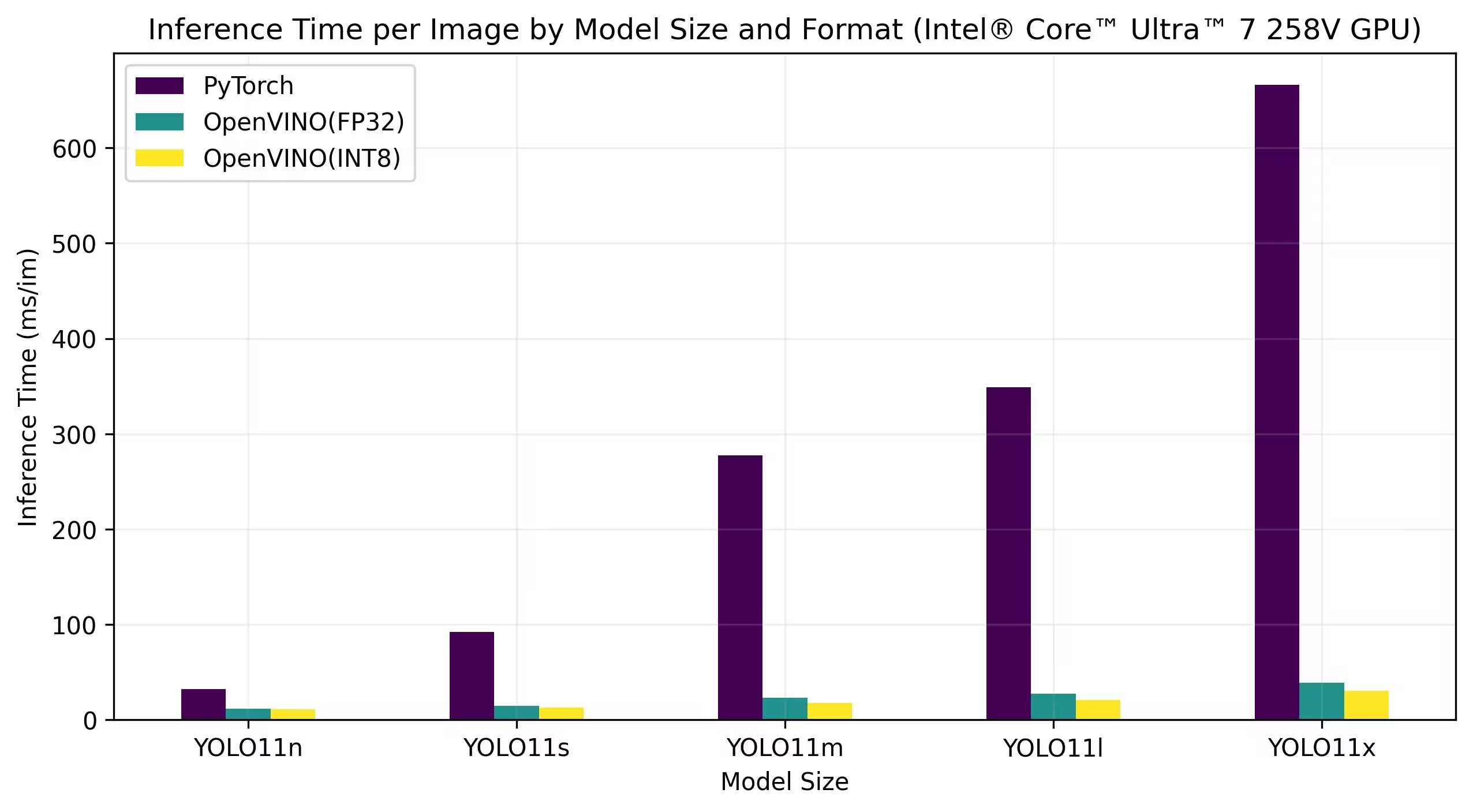

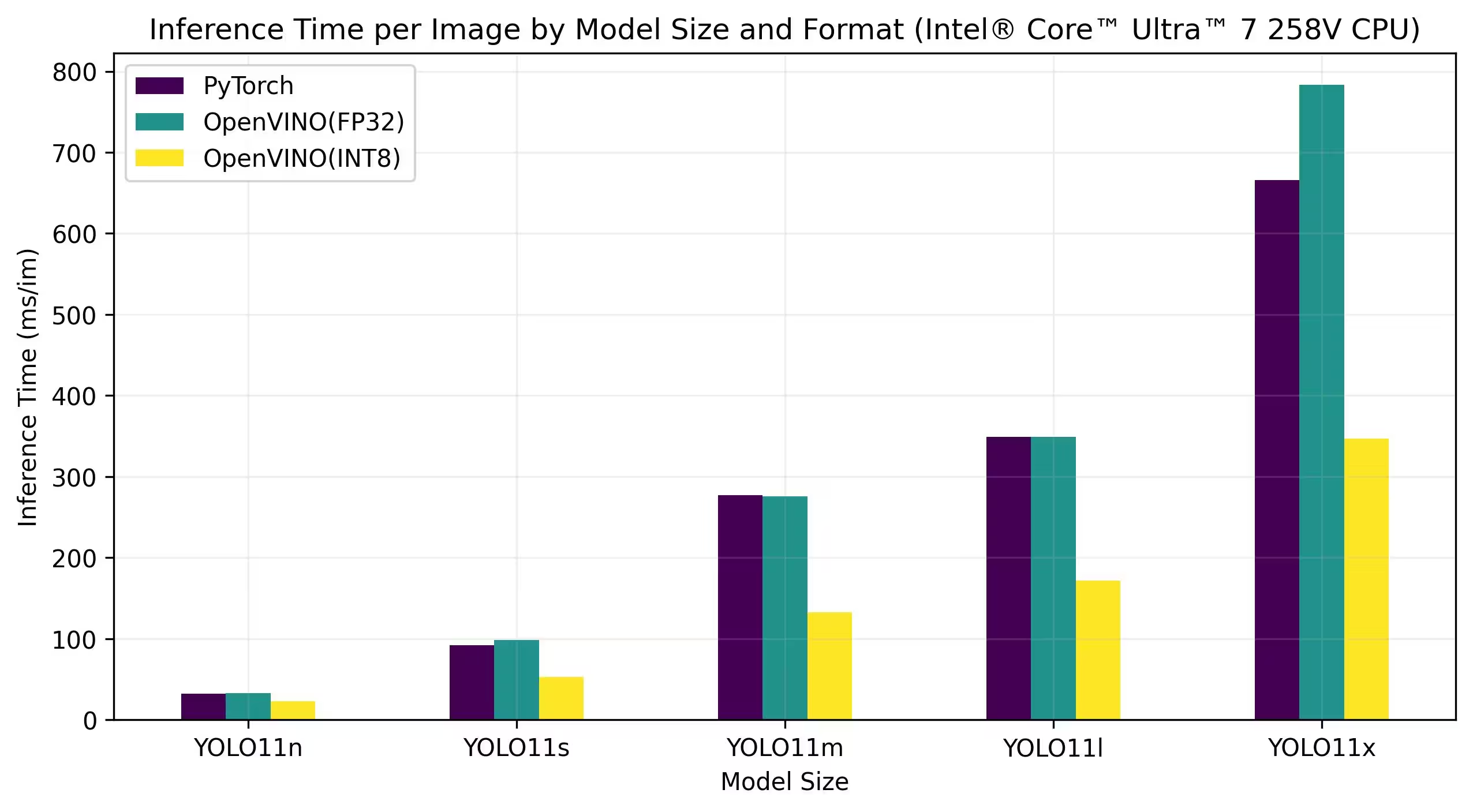

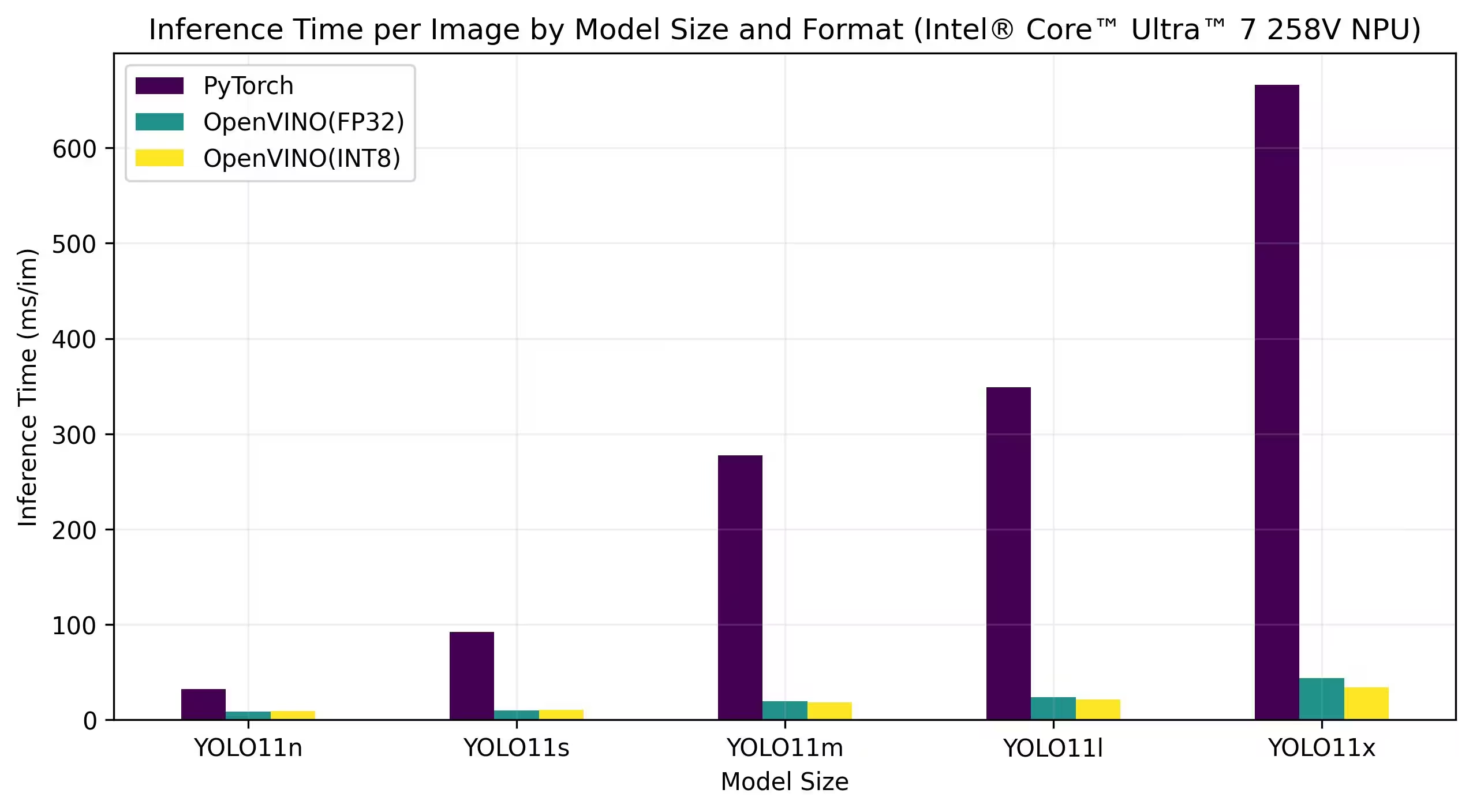

Aşağıdaki kıyaslamalar, FP32 ve INT8 hassasiyetinde Intel® Core™ Ultra™ 7 258V ve Intel® Core™ Ultra™ 7 265K üzerinde çalışır.

Intel® Core™ Ultra™ 7 258V

Kıyaslamalar

Ayrıntılı Kıyaslama Sonuçları

| Model | Format | Kesinlik | Durum | Boyut (MB) | metrikler/mAP50-95(B) | Çıkarım süresi (ms/im) |

|---|---|---|---|---|---|---|

| YOLO11n | PyTorch | FP32 | ✅ | 5.4 | 0.5052 | 32.27 |

| YOLO11n | OpenVINO | FP32 | ✅ | 10.4 | 0.5068 | 11.84 |

| YOLO11n | OpenVINO | INT8 | ✅ | 3.3 | 0.4969 | 11.24 |

| YOLO11s | PyTorch | FP32 | ✅ | 18.4 | 0.5776 | 92.09 |

| YOLO11s | OpenVINO | FP32 | ✅ | 36.4 | 0.5797 | 14.82 |

| YOLO11s | OpenVINO | INT8 | ✅ | 9.8 | 0.5751 | 12.88 |

| YOLO11m | PyTorch | FP32 | ✅ | 38.8 | 0.6262 | 277.24 |

| YOLO11m | OpenVINO | FP32 | ✅ | 77.1 | 0.6306 | 22.94 |

| YOLO11m | OpenVINO | INT8 | ✅ | 20.2 | 0.6126 | 17.85 |

| YOLO11l | PyTorch | FP32 | ✅ | 49.0 | 0.6361 | 348.97 |

| YOLO11l | OpenVINO | FP32 | ✅ | 97.3 | 0.6365 | 27.34 |

| YOLO11l | OpenVINO | INT8 | ✅ | 25.7 | 0.6242 | 20.83 |

| YOLO11x | PyTorch | FP32 | ✅ | 109.3 | 0.6984 | 666.07 |

| YOLO11x | OpenVINO | FP32 | ✅ | 217.8 | 0.6890 | 39.09 |

| YOLO11x | OpenVINO | INT8 | ✅ | 55.9 | 0.6856 | 30.60 |

Ayrıntılı Kıyaslama Sonuçları

| Model | Format | Kesinlik | Durum | Boyut (MB) | metrikler/mAP50-95(B) | Çıkarım süresi (ms/im) |

|---|---|---|---|---|---|---|

| YOLO11n | PyTorch | FP32 | ✅ | 5.4 | 0.5052 | 32.27 |

| YOLO11n | OpenVINO | FP32 | ✅ | 10.4 | 0.5077 | 32.55 |

| YOLO11n | OpenVINO | INT8 | ✅ | 3.3 | 0.4980 | 22.98 |

| YOLO11s | PyTorch | FP32 | ✅ | 18.4 | 0.5776 | 92.09 |

| YOLO11s | OpenVINO | FP32 | ✅ | 36.4 | 0.5782 | 98.38 |

| YOLO11s | OpenVINO | INT8 | ✅ | 9.8 | 0.5745 | 52.84 |

| YOLO11m | PyTorch | FP32 | ✅ | 38.8 | 0.6262 | 277.24 |

| YOLO11m | OpenVINO | FP32 | ✅ | 77.1 | 0.6307 | 275.74 |

| YOLO11m | OpenVINO | INT8 | ✅ | 20.2 | 0.6172 | 132.63 |

| YOLO11l | PyTorch | FP32 | ✅ | 49.0 | 0.6361 | 348.97 |

| YOLO11l | OpenVINO | FP32 | ✅ | 97.3 | 0.6361 | 348.97 |

| YOLO11l | OpenVINO | INT8 | ✅ | 25.7 | 0.6240 | 171.36 |

| YOLO11x | PyTorch | FP32 | ✅ | 109.3 | 0.6984 | 666.07 |

| YOLO11x | OpenVINO | FP32 | ✅ | 217.8 | 0.6900 | 783.16 |

| YOLO11x | OpenVINO | INT8 | ✅ | 55.9 | 0.6890 | 346.82 |

Ayrıntılı Kıyaslama Sonuçları

| Model | Format | Kesinlik | Durum | Boyut (MB) | metrikler/mAP50-95(B) | Çıkarım süresi (ms/im) |

|---|---|---|---|---|---|---|

| YOLO11n | PyTorch | FP32 | ✅ | 5.4 | 0.5052 | 32.27 |

| YOLO11n | OpenVINO | FP32 | ✅ | 10.4 | 0.5085 | 8.33 |

| YOLO11n | OpenVINO | INT8 | ✅ | 3.3 | 0.5019 | 8.91 |

| YOLO11s | PyTorch | FP32 | ✅ | 18.4 | 0.5776 | 92.09 |

| YOLO11s | OpenVINO | FP32 | ✅ | 36.4 | 0.5788 | 9.72 |

| YOLO11s | OpenVINO | INT8 | ✅ | 9.8 | 0.5710 | 10.58 |

| YOLO11m | PyTorch | FP32 | ✅ | 38.8 | 0.6262 | 277.24 |

| YOLO11m | OpenVINO | FP32 | ✅ | 77.1 | 0.6301 | 19.41 |

| YOLO11m | OpenVINO | INT8 | ✅ | 20.2 | 0.6124 | 18.26 |

| YOLO11l | PyTorch | FP32 | ✅ | 49.0 | 0.6361 | 348.97 |

| YOLO11l | OpenVINO | FP32 | ✅ | 97.3 | 0.6362 | 23.70 |

| YOLO11l | OpenVINO | INT8 | ✅ | 25.7 | 0.6240 | 21.40 |

| YOLO11x | PyTorch | FP32 | ✅ | 109.3 | 0.6984 | 666.07 |

| YOLO11x | OpenVINO | FP32 | ✅ | 217.8 | 0.6892 | 43.91 |

| YOLO11x | OpenVINO | INT8 | ✅ | 55.9 | 0.6890 | 34.04 |

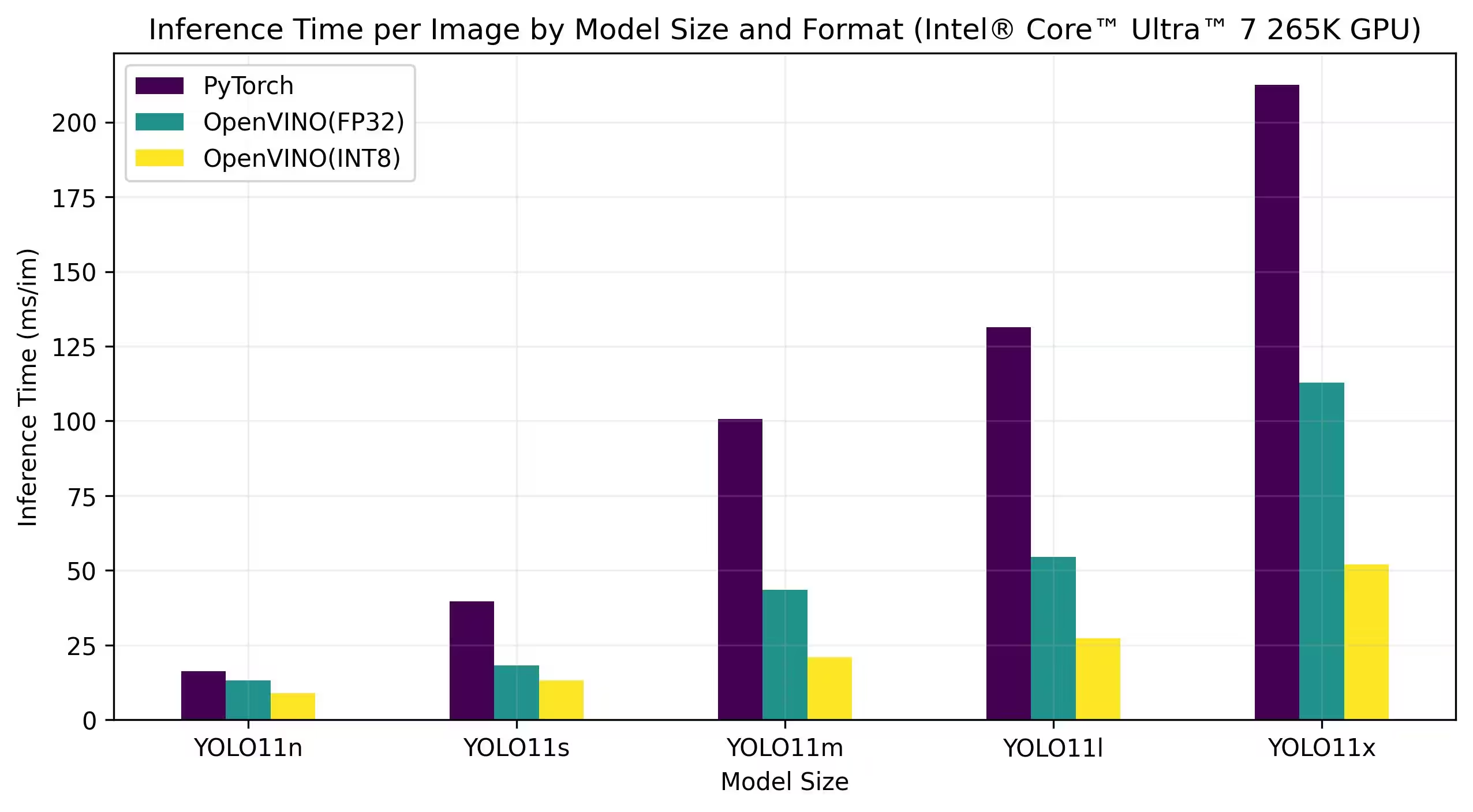

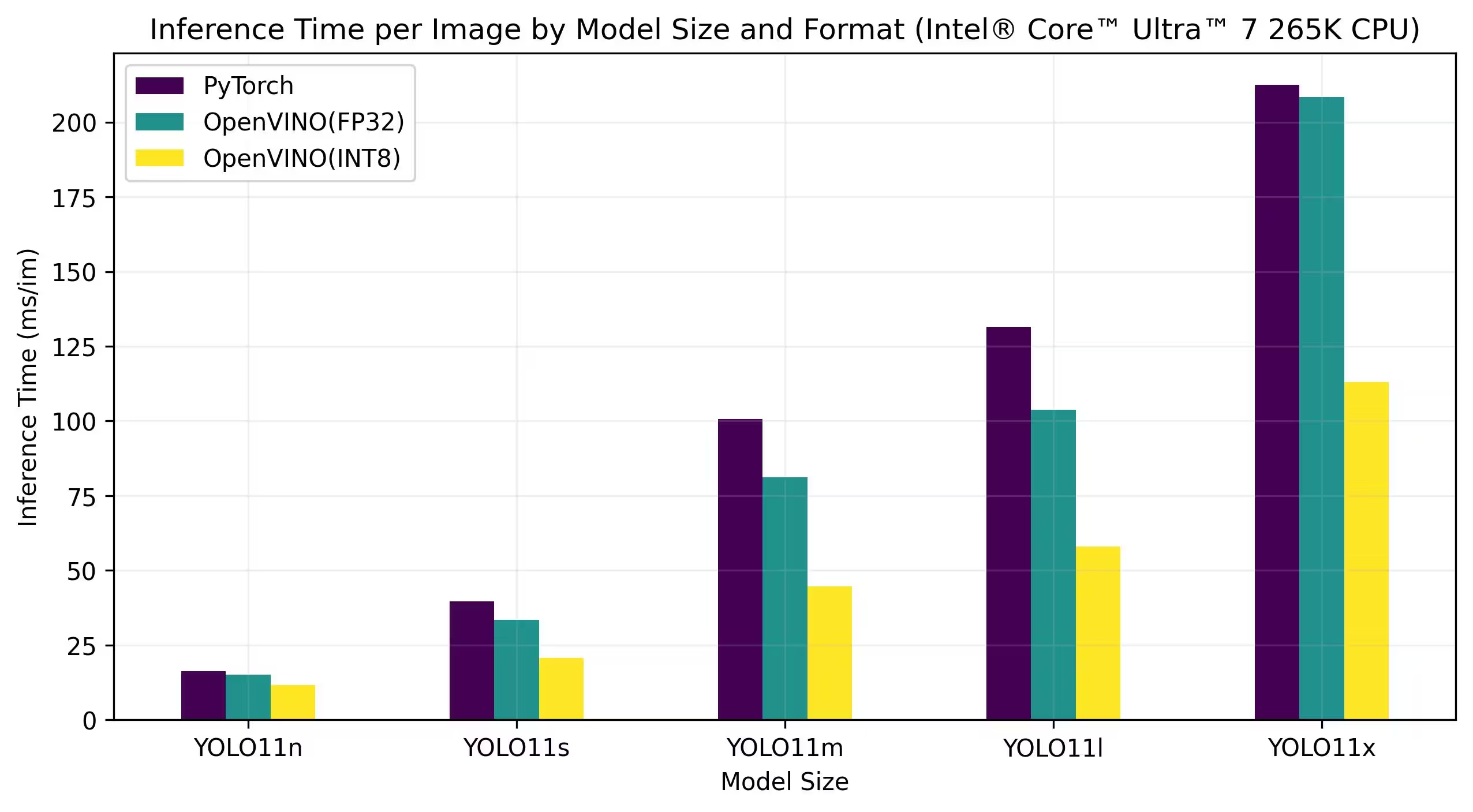

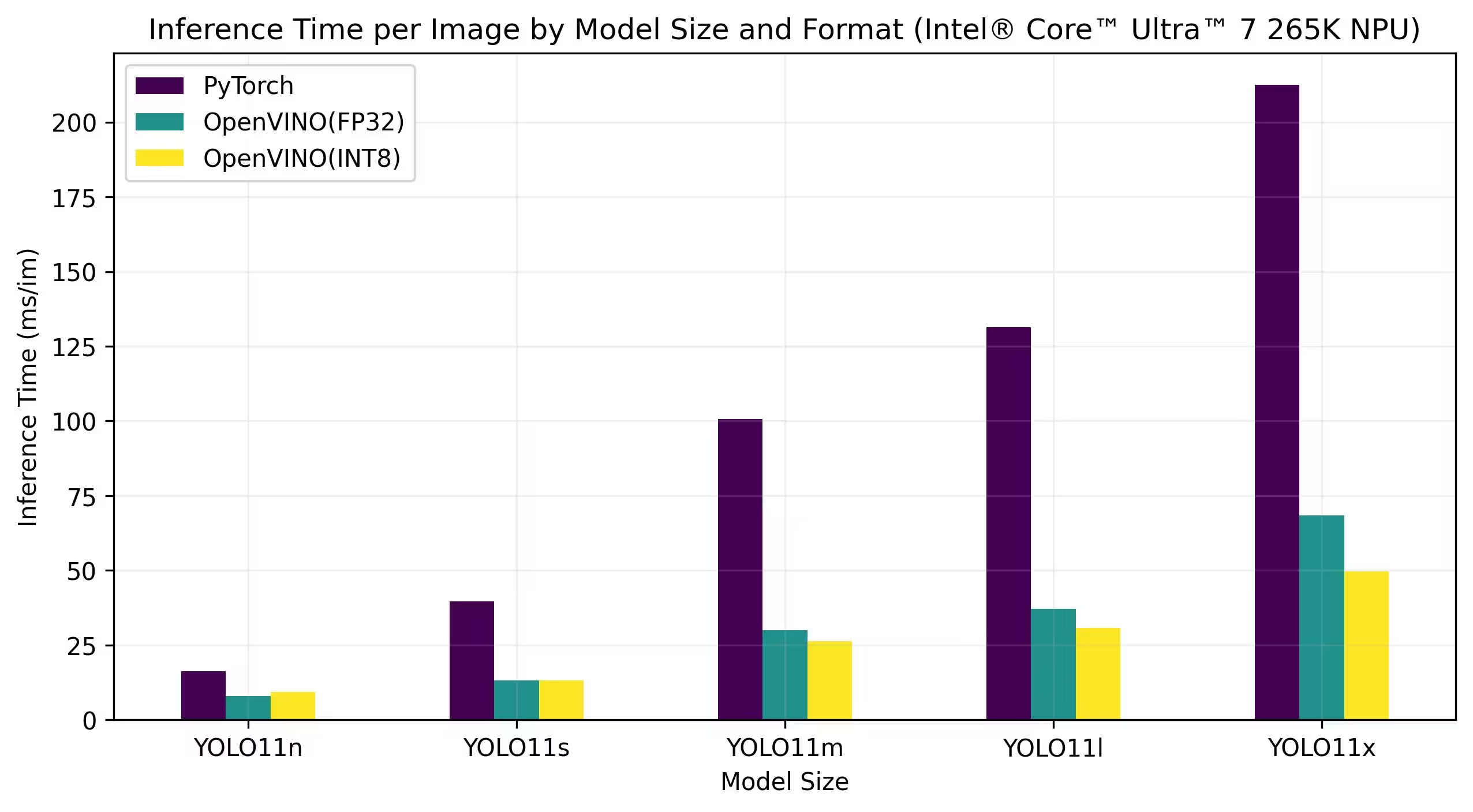

Intel® Core™ Ultra™ 7 265K

Kıyaslamalar

Ayrıntılı Kıyaslama Sonuçları

| Model | Format | Kesinlik | Durum | Boyut (MB) | metrikler/mAP50-95(B) | Çıkarım süresi (ms/im) |

|---|---|---|---|---|---|---|

| YOLO11n | PyTorch | FP32 | ✅ | 5.4 | 0.5072 | 16.29 |

| YOLO11n | OpenVINO | FP32 | ✅ | 10.4 | 0.5079 | 13.13 |

| YOLO11n | OpenVINO | INT8 | ✅ | 3.3 | 0.4976 | 8.86 |

| YOLO11s | PyTorch | FP32 | ✅ | 18.4 | 0.5771 | 39.61 |

| YOLO11s | OpenVINO | FP32 | ✅ | 36.4 | 0.5808 | 18.26 |

| YOLO11s | OpenVINO | INT8 | ✅ | 9.8 | 0.5726 | 13.24 |

| YOLO11m | PyTorch | FP32 | ✅ | 38.8 | 0.6258 | 100.65 |

| YOLO11m | OpenVINO | FP32 | ✅ | 77.1 | 0.6310 | 43.50 |

| YOLO11m | OpenVINO | INT8 | ✅ | 20.2 | 0.6137 | 20.90 |

| YOLO11l | PyTorch | FP32 | ✅ | 49.0 | 0.6367 | 131.37 |

| YOLO11l | OpenVINO | FP32 | ✅ | 97.3 | 0.6371 | 54.52 |

| YOLO11l | OpenVINO | INT8 | ✅ | 25.7 | 0.6226 | 27.36 |

| YOLO11x | PyTorch | FP32 | ✅ | 109.3 | 0.6990 | 212.45 |

| YOLO11x | OpenVINO | FP32 | ✅ | 217.8 | 0.6884 | 112.76 |

| YOLO11x | OpenVINO | INT8 | ✅ | 55.9 | 0.6900 | 52.06 |

Ayrıntılı Kıyaslama Sonuçları

| Model | Format | Kesinlik | Durum | Boyut (MB) | metrikler/mAP50-95(B) | Çıkarım süresi (ms/im) |

|---|---|---|---|---|---|---|

| YOLO11n | PyTorch | FP32 | ✅ | 5.4 | 0.5072 | 16.29 |

| YOLO11n | OpenVINO | FP32 | ✅ | 10.4 | 0.5077 | 15.04 |

| YOLO11n | OpenVINO | INT8 | ✅ | 3.3 | 0.4980 | 11.60 |

| YOLO11s | PyTorch | FP32 | ✅ | 18.4 | 0.5771 | 39.61 |

| YOLO11s | OpenVINO | FP32 | ✅ | 36.4 | 0.5782 | 33.45 |

| YOLO11s | OpenVINO | INT8 | ✅ | 9.8 | 0.5745 | 20.64 |

| YOLO11m | PyTorch | FP32 | ✅ | 38.8 | 0.6258 | 100.65 |

| YOLO11m | OpenVINO | FP32 | ✅ | 77.1 | 0.6307 | 81.15 |

| YOLO11m | OpenVINO | INT8 | ✅ | 20.2 | 0.6172 | 44.63 |

| YOLO11l | PyTorch | FP32 | ✅ | 49.0 | 0.6367 | 131.37 |

| YOLO11l | OpenVINO | FP32 | ✅ | 97.3 | 0.6409 | 103.77 |

| YOLO11l | OpenVINO | INT8 | ✅ | 25.7 | 0.6240 | 58.00 |

| YOLO11x | PyTorch | FP32 | ✅ | 109.3 | 0.6990 | 212.45 |

| YOLO11x | OpenVINO | FP32 | ✅ | 217.8 | 0.6900 | 208.37 |

| YOLO11x | OpenVINO | INT8 | ✅ | 55.9 | 0.6897 | 113.04 |

Ayrıntılı Kıyaslama Sonuçları

| Model | Format | Kesinlik | Durum | Boyut (MB) | metrikler/mAP50-95(B) | Çıkarım süresi (ms/im) |

|---|---|---|---|---|---|---|

| YOLO11n | PyTorch | FP32 | ✅ | 5.4 | 0.5072 | 16.29 |

| YOLO11n | OpenVINO | FP32 | ✅ | 10.4 | 0.5075 | 8.02 |

| YOLO11n | OpenVINO | INT8 | ✅ | 3.3 | 0.3656 | 9.28 |

| YOLO11s | PyTorch | FP32 | ✅ | 18.4 | 0.5771 | 39.61 |

| YOLO11s | OpenVINO | FP32 | ✅ | 36.4 | 0.5801 | 13.12 |

| YOLO11s | OpenVINO | INT8 | ✅ | 9.8 | 0.5686 | 13.12 |

| YOLO11m | PyTorch | FP32 | ✅ | 38.8 | 0.6258 | 100.65 |

| YOLO11m | OpenVINO | FP32 | ✅ | 77.1 | 0.6310 | 29.88 |

| YOLO11m | OpenVINO | INT8 | ✅ | 20.2 | 0.6111 | 26.32 |

| YOLO11l | PyTorch | FP32 | ✅ | 49.0 | 0.6367 | 131.37 |

| YOLO11l | OpenVINO | FP32 | ✅ | 97.3 | 0.6356 | 37.08 |

| YOLO11l | OpenVINO | INT8 | ✅ | 25.7 | 0.6245 | 30.81 |

| YOLO11x | PyTorch | FP32 | ✅ | 109.3 | 0.6990 | 212.45 |

| YOLO11x | OpenVINO | FP32 | ✅ | 217.8 | 0.6894 | 68.48 |

| YOLO11x | OpenVINO | INT8 | ✅ | 55.9 | 0.6417 | 49.76 |

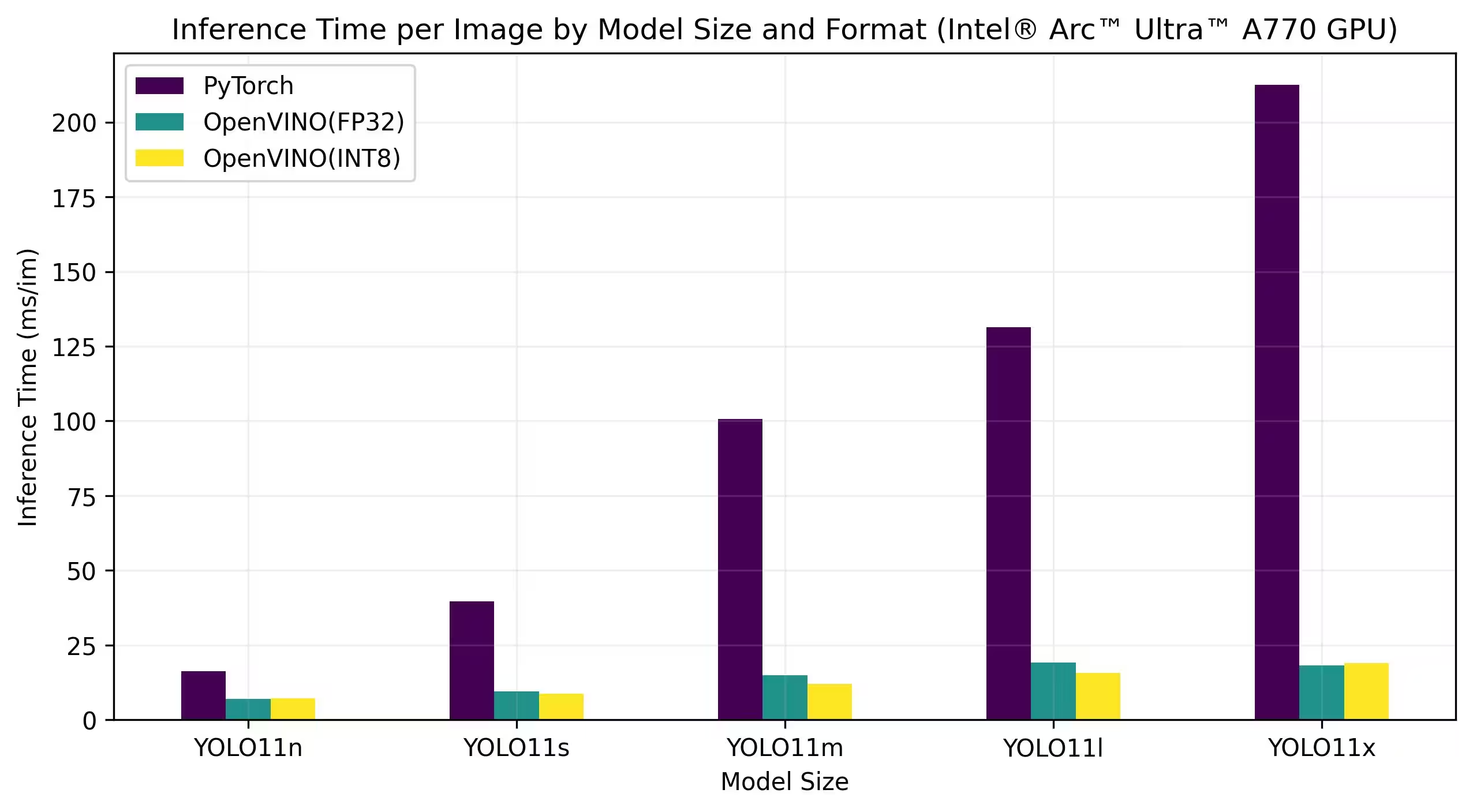

Intel® Arc GPU

Intel® Arc™, yüksek performanslı oyun, içerik oluşturma ve yapay zeka iş yükleri için tasarlanmış Intel'in ayrık grafik kartları serisidir. Arc serisi, gerçek zamanlı ışın izlemeyi, yapay zeka ile geliştirilmiş grafikleri ve yüksek çözünürlüklü oyun oynamayı destekleyen gelişmiş GPU mimarilerine sahiptir. Performans ve verimliliğe odaklanan Intel® Arc™, donanım hızlandırmalı AV1 kodlama ve en son grafik API'leri için destek gibi benzersiz özellikler sunarak diğer önde gelen GPU markalarıyla rekabet etmeyi amaçlamaktadır.

Aşağıdaki kıyaslamalar, FP32 ve INT8 hassasiyetinde Intel Arc A770 ve Intel Arc B580 üzerinde çalışır.

Intel Arc A770

Ayrıntılı Kıyaslama Sonuçları

| Model | Format | Kesinlik | Durum | Boyut (MB) | metrikler/mAP50-95(B) | Çıkarım süresi (ms/im) |

|---|---|---|---|---|---|---|

| YOLO11n | PyTorch | FP32 | ✅ | 5.4 | 0.5072 | 16.29 |

| YOLO11n | OpenVINO | FP32 | ✅ | 10.4 | 0.5073 | 6.98 |

| YOLO11n | OpenVINO | INT8 | ✅ | 3.3 | 0.4978 | 7.24 |

| YOLO11s | PyTorch | FP32 | ✅ | 18.4 | 0.5771 | 39.61 |

| YOLO11s | OpenVINO | FP32 | ✅ | 36.4 | 0.5798 | 9.41 |

| YOLO11s | OpenVINO | INT8 | ✅ | 9.8 | 0.5751 | 8.72 |

| YOLO11m | PyTorch | FP32 | ✅ | 38.8 | 0.6258 | 100.65 |

| YOLO11m | OpenVINO | FP32 | ✅ | 77.1 | 0.6311 | 14.88 |

| YOLO11m | OpenVINO | INT8 | ✅ | 20.2 | 0.6126 | 11.97 |

| YOLO11l | PyTorch | FP32 | ✅ | 49.0 | 0.6367 | 131.37 |

| YOLO11l | OpenVINO | FP32 | ✅ | 97.3 | 0.6364 | 19.17 |

| YOLO11l | OpenVINO | INT8 | ✅ | 25.7 | 0.6241 | 15.75 |

| YOLO11x | PyTorch | FP32 | ✅ | 109.3 | 0.6990 | 212.45 |

| YOLO11x | OpenVINO | FP32 | ✅ | 217.8 | 0.6888 | 18.13 |

| YOLO11x | OpenVINO | INT8 | ✅ | 55.9 | 0.6930 | 18.91 |

Intel Arc B580

Ayrıntılı Kıyaslama Sonuçları

| Model | Format | Kesinlik | Durum | Boyut (MB) | metrikler/mAP50-95(B) | Çıkarım süresi (ms/im) |

|---|---|---|---|---|---|---|

| YOLO11n | PyTorch | FP32 | ✅ | 5.4 | 0.5072 | 16.29 |

| YOLO11n | OpenVINO | FP32 | ✅ | 10.4 | 0.5072 | 4.27 |

| YOLO11n | OpenVINO | INT8 | ✅ | 3.3 | 0.4981 | 4.33 |

| YOLO11s | PyTorch | FP32 | ✅ | 18.4 | 0.5771 | 39.61 |

| YOLO11s | OpenVINO | FP32 | ✅ | 36.4 | 0.5789 | 5.04 |

| YOLO11s | OpenVINO | INT8 | ✅ | 9.8 | 0.5746 | 4.97 |

| YOLO11m | PyTorch | FP32 | ✅ | 38.8 | 0.6258 | 100.65 |

| YOLO11m | OpenVINO | FP32 | ✅ | 77.1 | 0.6306 | 6.45 |

| YOLO11m | OpenVINO | INT8 | ✅ | 20.2 | 0.6125 | 6.28 |

| YOLO11l | PyTorch | FP32 | ✅ | 49.0 | 0.6367 | 131.37 |

| YOLO11l | OpenVINO | FP32 | ✅ | 97.3 | 0.6360 | 8.23 |

| YOLO11l | OpenVINO | INT8 | ✅ | 25.7 | 0.6236 | 8.49 |

| YOLO11x | PyTorch | FP32 | ✅ | 109.3 | 0.6990 | 212.45 |

| YOLO11x | OpenVINO | FP32 | ✅ | 217.8 | 0.6889 | 11.10 |

| YOLO11x | OpenVINO | INT8 | ✅ | 55.9 | 0.6924 | 10.30 |

Sonuçlarımızı Tekrar Üretin

Yukarıdaki Ultralytics kıyaslamalarını tüm dışa aktarma biçimlerinde yeniden oluşturmak için bu kodu çalıştırın:

Örnek

from ultralytics import YOLO

# Load a YOLO11n PyTorch model

model = YOLO("yolo11n.pt")

# Benchmark YOLO11n speed and accuracy on the COCO128 dataset for all export formats

results = model.benchmark(data="coco128.yaml")

# Benchmark YOLO11n speed and accuracy on the COCO128 dataset for all export formats

yolo benchmark model=yolo11n.pt data=coco128.yaml

Karşılaştırma sonuçlarının, bir sistemin kesin donanım ve yazılım yapılandırmasına ve ayrıca karşılaştırmaların çalıştırıldığı sırada sistemin mevcut iş yüküne bağlı olarak değişebileceğini unutmayın. En güvenilir sonuçlar için çok sayıda görüntü içeren bir veri kümesi kullanın, örneğin: data='coco.yaml' (5000 doğrulama görüntüsü).

Sonuç

Karşılaştırma sonuçları, YOLO11 modelini OpenVINO formatına aktarmanın faydalarını açıkça göstermektedir. Farklı modeller ve donanım platformlarında, OpenVINO formatı, karşılaştırılabilir doğruluğu korurken çıkarım hızı açısından diğer formatlardan sürekli olarak daha iyi performans göstermektedir.

Kıyaslamalar, derin öğrenme modellerini dağıtmak için bir araç olarak OpenVINO'nun etkinliğinin altını çizmektedir. Geliştiriciler, modelleri OpenVINO formatına dönüştürerek önemli performans iyileştirmeleri elde edebilir ve bu modelleri gerçek dünya uygulamalarında dağıtmayı kolaylaştırabilir.

OpenVINO'yu kullanma hakkında daha ayrıntılı bilgi ve talimatlar için resmi OpenVINO belgelerine bakın.

SSS

YOLO26 modellerini OpenVINO formatına nasıl aktarırım?

YOLO26 modellerini OpenVINO formatına aktarmak, CPU hızını önemli ölçüde artırabilir ve Intel donanımında GPU ve NPU ivmelendirmelerini etkinleştirebilir. Aktarım için aşağıda gösterildiği gibi Python veya CLI kullanabilirsiniz:

Örnek

from ultralytics import YOLO

# Load a YOLO26n PyTorch model

model = YOLO("yolo26n.pt")

# Export the model

model.export(format="openvino") # creates 'yolo26n_openvino_model/'

# Export a YOLO26n PyTorch model to OpenVINO format

yolo export model=yolo26n.pt format=openvino # creates 'yolo26n_openvino_model/'

Daha fazla bilgi için dışa aktarma formatları belgelerine bakın.

OpenVINO'yu YOLO26 modelleriyle kullanmanın faydaları nelerdir?

Intel'in OpenVINO araç kitini YOLO26 modelleriyle kullanmak çeşitli avantajlar sunar:

- Performans: CPU çıkarımında 3 kata kadar hızlanma elde edin ve hızlandırma için Intel GPU'larından ve NPU'larından yararlanın.

- Model Optimizatörü: PyTorch, TensorFlow ve ONNX gibi popüler framework'lerden modelleri dönüştürün, optimize edin ve yürütün.

- Kullanım Kolaylığı: Kullanıcıların başlamasına yardımcı olmak için YOLO26 için olanlar da dahil olmak üzere 80'den fazla eğitim not defteri mevcuttur.

- Heterojen Yürütme: Modelleri birleşik bir API ile çeşitli Intel donanımlarında dağıtın.

Ayrıntılı performans karşılaştırmaları için benchmark bölümümüzü ziyaret edin.

OpenVINO'ya aktarılmış bir YOLO26 modeli kullanarak çıkarım işlemini nasıl yapabilirim?

Bir YOLO26n modelini OpenVINO formatına aktardıktan sonra, Python veya CLI kullanarak çıkarım yapabilirsiniz:

Örnek

from ultralytics import YOLO

# Load the exported OpenVINO model

ov_model = YOLO("yolo26n_openvino_model/")

# Run inference

results = ov_model("https://ultralytics.com/images/bus.jpg")

# Run inference with the exported model

yolo predict model=yolo26n_openvino_model source='https://ultralytics.com/images/bus.jpg'

Daha fazla ayrıntı için tahmin modu belgelerimize bakın.

OpenVINO aktarımı için neden diğer modeller yerine Ultralytics YOLO26'yı seçmeliyim?

Ultralytics YOLO26, yüksek doğruluk ve hız ile gerçek zamanlı nesne algılama için optimize edilmiştir. Özellikle OpenVINO ile birleştirildiğinde, YOLO26 şunları sağlar:

- Intel CPU'larda 3 kata kadar hızlanma

- Intel GPU'lar ve NPU'lar üzerinde sorunsuz dağıtım

- Çeşitli dışa aktarım formatlarında tutarlı ve karşılaştırılabilir doğruluk

Derinlemesine performans analizi için, farklı donanımlar üzerindeki detaylı YOLO11 kıyaslamalarımıza göz atın.

YOLO26 modellerini PyTorch, ONNX ve OpenVINO gibi farklı formatlarda karşılaştırabilir miyim?

Evet, YOLO26 modellerini PyTorch, TorchScript, ONNX ve OpenVINO dahil olmak üzere çeşitli formatlarda karşılaştırmalı olarak değerlendirebilirsiniz. Seçtiğiniz veri kümesinde karşılaştırmalı değerlendirmeler yapmak için aşağıdaki kod parçasını kullanın:

Örnek

from ultralytics import YOLO

# Load a YOLO26n PyTorch model

model = YOLO("yolo26n.pt")

# Benchmark YOLO26n speed and [accuracy](https://www.ultralytics.com/glossary/accuracy) on the COCO8 dataset for all export formats

results = model.benchmark(data="coco8.yaml")

# Benchmark YOLO26n speed and accuracy on the COCO8 dataset for all export formats

yolo benchmark model=yolo26n.pt data=coco8.yaml

Ayrıntılı kıyaslama sonuçları için kıyaslama bölümümüze ve dışa aktarma biçimleri belgelerimize bakın.