Ultralytics YOLO26

Überblick

Ultralytics YOLO26 ist die neueste Entwicklung in der YOLO-Serie von Echtzeit-Objektdetektoren, die von Grund auf für Edge- und Low-Power-Geräte entwickelt wurde. Es führt ein optimiertes Design ein, das unnötige Komplexität reduziert und gleichzeitig gezielte Innovationen integriert, um eine schnellere, schlankere und zugänglichere Bereitstellung zu ermöglichen.

Probieren Sie Ultralytics aus

Entdecken und nutzen Sie YOLO26-Modelle direkt auf Ultralytics .

Die Architektur von YOLO26 basiert auf drei Kernprinzipien:

- Einfachheit: YOLO26 ist ein natives End-to-End-Modell, das Vorhersagen direkt liefert, ohne die Notwendigkeit einer Non-Maximum Suppression (NMS). Durch die Eliminierung dieses Nachbearbeitungsschritts wird die Inferenz schneller, schlanker und einfacher in realen Systemen bereitzustellen. Dieser bahnbrechende Ansatz wurde erstmals in YOLOv10 von Ao Wang an der Tsinghua-Universität entwickelt und in YOLO26 weiter vorangetrieben.

- Deployment-Effizienz: Das End-to-End-Design spart eine ganze Phase der Pipeline ein, was die Integration erheblich vereinfacht, die Latenz reduziert und die Bereitstellung in verschiedenen Umgebungen robuster macht.

- Trainingsinnovation: YOLO26 führt den MuSGD-Optimierer ein, eine Mischung aus SGD und Muon — inspiriert von Moonshot AIs Kimi K2-Durchbrüchen im LLM-Training. Dieser Optimierer sorgt für verbesserte Stabilität und schnellere Konvergenz und überträgt Optimierungsfortschritte von Sprachmodellen in die Computer Vision.

- Aufgabenspezifische Optimierungen: YOLO26 führt gezielte Verbesserungen für spezialisierte Aufgaben ein, darunter semantischer Segmentierungsverlust und mehrskalige Proto-Module für die Segmentation, Residual Log-Likelihood Estimation (RLE) für hochpräzise Pose-Schätzung und optimierte Dekodierung mit Winkelfehler zur Behebung von Grenzproblemen bei OBB.

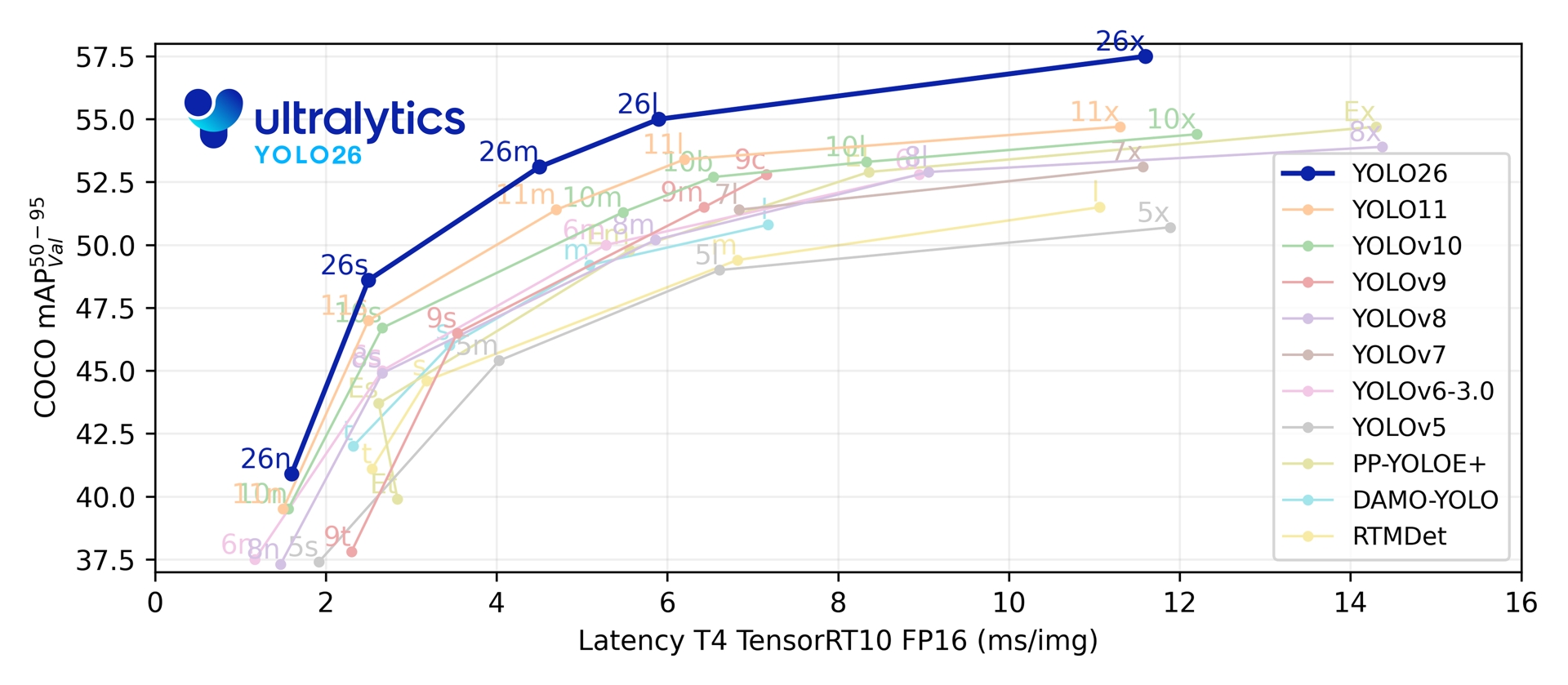

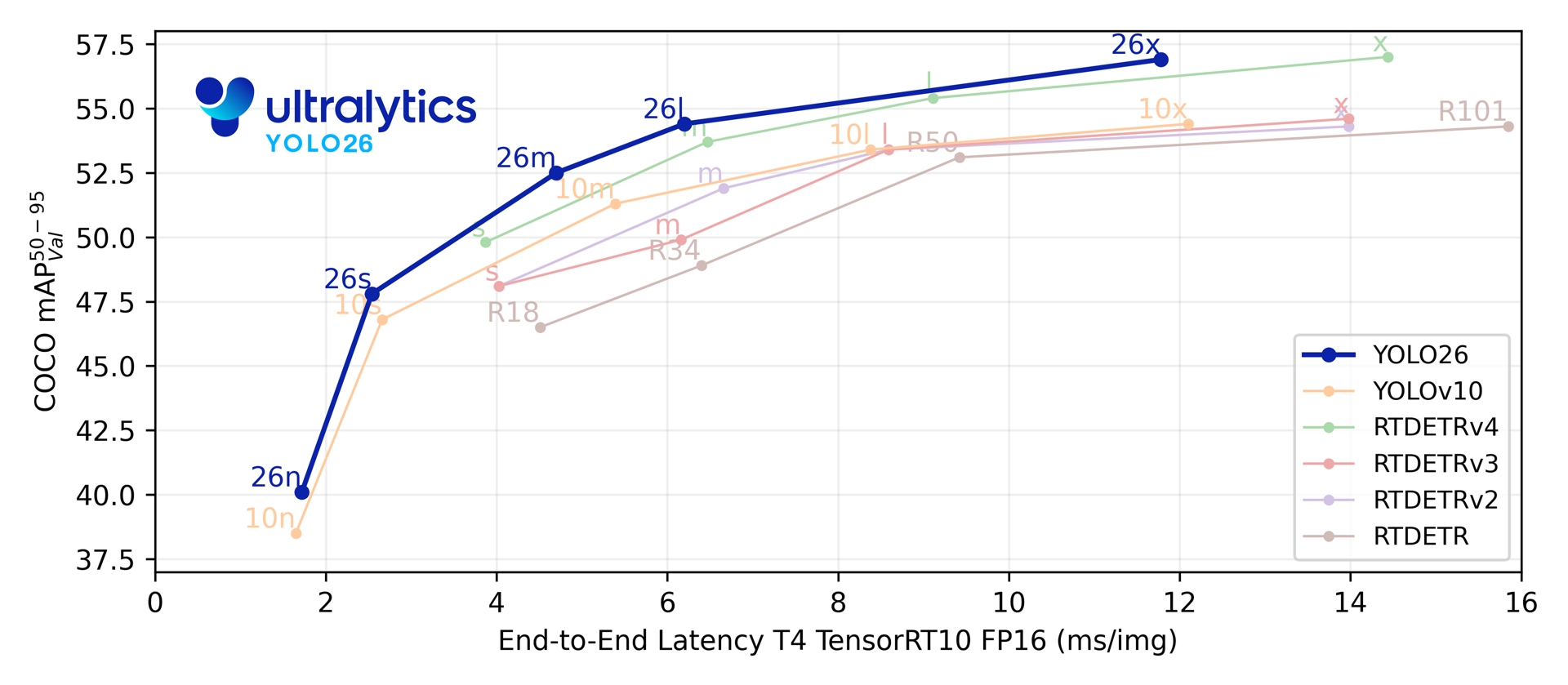

Zusammen liefern diese Innovationen eine Modellfamilie, die eine höhere Genauigkeit bei kleinen Objekten erreicht, eine nahtlose Bereitstellung ermöglicht und bis zu 43 % schneller auf CPUs läuft — was YOLO26 zu einem der praktischsten und am besten einsetzbaren YOLO-Modelle für ressourcenbeschränkte Umgebungen macht.

Hauptmerkmale

Entfernung von DFL

Das Distribution Focal Loss (DFL)-Modul, obwohl effektiv, erschwerte oft den Export und schränkte die Hardware-Kompatibilität ein. YOLO26 entfernt DFL vollständig, was die Inferenz vereinfacht und die Unterstützung für Edge- und Low-Power-Geräte erweitert.End-to-End NMS-freie Inferenz

Im Gegensatz zu traditionellen Detektoren, die sich auf NMS als separaten Nachbearbeitungsschritt verlassen, ist YOLO26 nativ End-to-End. Vorhersagen werden direkt generiert, was die Latenz reduziert und die Integration in Produktionssysteme schneller, leichter und zuverlässiger macht.ProgLoss + STAL

Verbesserte Verlustfunktionen erhöhen die detect-Genauigkeit, mit bemerkenswerten Verbesserungen bei der Erkennung kleiner Objekte, einer kritischen Anforderung für IoT, Robotik, Luftbildaufnahmen und andere Edge-Anwendungen.MuSGD-Optimizer

Ein neuer hybrider Optimizer, der SGD mit Muon kombiniert. Inspiriert von Moonshot AIs Kimi K2, führt MuSGD fortschrittliche Optimierungsmethoden aus dem LLM-Training in die Computer Vision ein, was ein stabileres Training und eine schnellere Konvergenz ermöglicht.Bis zu 43 % schnellere CPU-Inferenz

Speziell für Edge Computing optimiert, liefert YOLO26 eine deutlich schnellere CPU-Inferenz und gewährleistet Echtzeit-Performance auf Geräten ohne GPUs.Verbesserungen bei der Instanzsegmentierung

Führt einen semantischen Segmentierungsverlust ein, um die Modellkonvergenz zu verbessern, und ein aktualisiertes Proto-Modul, das mehrskalige Informationen für eine überlegene Maskenqualität nutzt.Präzise Pose-Schätzung

Integriert Residual Log-Likelihood Estimation (RLE) für eine genauere Schlüsselpunktlokalisierung und optimiert den Dekodierungsprozess für eine erhöhte Inferenzgeschwindigkeit.Verfeinerte OBB-Dekodierung

Führt einen spezialisierten Winkelfehler ein, um die detect-Genauigkeit für quadratische Objekte zu verbessern, und optimiert die obb-Dekodierung, um Probleme mit Grenzdiskontinuitäten zu lösen.

Unterstützte Aufgaben und Modi

YOLO26 baut auf der vielseitigen Modellpalette auf, die durch frühere Ultralytics YOLO-Veröffentlichungen etabliert wurde, und bietet erweiterte Unterstützung für verschiedene Computer-Vision-Aufgaben:

| Modell | Dateinamen | Aufgabe | Inferenz | Validierung | Training | Export |

|---|---|---|---|---|---|---|

| YOLO26 | yolo26n.pt yolo26s.pt yolo26m.pt yolo26l.pt yolo26x.pt | Erkennung | ✅ | ✅ | ✅ | ✅ |

| YOLO26-seg | yolo26n-seg.pt yolo26s-seg.pt yolo26m-seg.pt yolo26l-seg.pt yolo26x-seg.pt | Instanzsegmentierung | ✅ | ✅ | ✅ | ✅ |

| YOLO26-pose | yolo26n-pose.pt yolo26s-pose.pt yolo26m-pose.pt yolo26l-pose.pt yolo26x-pose.pt | Pose/Keypoints | ✅ | ✅ | ✅ | ✅ |

| YOLO26-obb | yolo26n-obb.pt yolo26s-obb.pt yolo26m-obb.pt yolo26l-obb.pt yolo26x-obb.pt | Orientierte Erkennung | ✅ | ✅ | ✅ | ✅ |

| YOLO26-cls | yolo26n-cls.pt yolo26s-cls.pt yolo26m-cls.pt yolo26l-cls.pt yolo26x-cls.pt | Klassifizierung | ✅ | ✅ | ✅ | ✅ |

Dieses einheitliche Framework stellt sicher, dass YOLO26 für Echtzeit-Detektion, -Segmentierung, -Klassifizierung, -Pose-Schätzung und -orientierte Objektdetektion eingesetzt werden kann — alles mit Unterstützung für Training, Validierung, Inferenz und Export.

Leistungsmetriken

Performance

Siehe detect-Dokumentation für Anwendungsbeispiele mit diesen Modellen, die auf COCO trainiert wurden und 80 vortrainierte Klassen umfassen.

| Modell | Größe (Pixel) | mAPval 50-95 | mAPval 50-95(e2e) | Geschwindigkeit CPU ONNX (ms) | Geschwindigkeit T4 TensorRT10 (ms) | Parameter (M) | FLOPs (B) |

|---|---|---|---|---|---|---|---|

| YOLO26n | 640 | 40.9 | 40.1 | 38.9 ± 0.7 | 1.7 ± 0.0 | 2.4 | 5.4 |

| YOLO26s | 640 | 48.6 | 47.8 | 87.2 ± 0.9 | 2.5 ± 0.0 | 9.5 | 20.7 |

| YOLO26m | 640 | 53.1 | 52.5 | 220.0 ± 1.4 | 4.7 ± 0.1 | 20.4 | 68.2 |

| YOLO26l | 640 | 55.0 | 54.4 | 286.2 ± 2.0 | 6.2 ± 0.2 | 24.8 | 86.4 |

| YOLO26x | 640 | 57.5 | 56.9 | 525.8 ± 4.0 | 11.8 ± 0.2 | 55.7 | 193.9 |

Siehe Dokumentation zur Segmentierung für Anwendungsbeispiele mit diesen auf COCO trainierten Modellen, die 80 vortrainierte Klassen enthalten.

| Modell | Größe (Pixel) | mAPbox 50-95(e2e) | mAPmask 50-95(e2e) | Geschwindigkeit CPU ONNX (ms) | Geschwindigkeit T4 TensorRT10 (ms) | Parameter (M) | FLOPs (B) |

|---|---|---|---|---|---|---|---|

| YOLO26n-seg | 640 | 39.6 | 33.9 | 53.3 ± 0.5 | 2.1 ± 0.0 | 2.7 | 9.1 |

| YOLO26s-seg | 640 | 47.3 | 40.0 | 118.4 ± 0.9 | 3.3 ± 0.0 | 10.4 | 34.2 |

| YOLO26m-seg | 640 | 52.5 | 44.1 | 328.2 ± 2.4 | 6.7 ± 0.1 | 23.6 | 121.5 |

| YOLO26l-seg | 640 | 54.4 | 45.5 | 387.0 ± 3.7 | 8.0 ± 0.1 | 28.0 | 139.8 |

| YOLO26x-seg | 640 | 56.5 | 47.0 | 787.0 ± 6.8 | 16.4 ± 0.1 | 62.8 | 313.5 |

Siehe Klassifizierungs-Dokumentation für Anwendungsbeispiele mit diesen Modellen, die auf ImageNet trainiert wurden und 1000 vortrainierte Klassen umfassen.

| Modell | Größe (Pixel) | acc top1 | acc top5 | Geschwindigkeit CPU ONNX (ms) | Geschwindigkeit T4 TensorRT10 (ms) | Parameter (M) | FLOPs (B) bei 224 |

|---|---|---|---|---|---|---|---|

| YOLO26n-cls | 224 | 71.4 | 90.1 | 5.0 ± 0.3 | 1.1 ± 0.0 | 2.8 | 0.5 |

| YOLO26s-cls | 224 | 76.0 | 92.9 | 7.9 ± 0.2 | 1.3 ± 0.0 | 6.7 | 1.6 |

| YOLO26m-cls | 224 | 78.1 | 94.2 | 17.2 ± 0.4 | 2.0 ± 0.0 | 11.6 | 4.9 |

| YOLO26l-cls | 224 | 79.0 | 94.6 | 23.2 ± 0.3 | 2.8 ± 0.0 | 14.1 | 6.2 |

| YOLO26x-cls | 224 | 79.9 | 95.0 | 41.4 ± 0.9 | 3.8 ± 0.0 | 29.6 | 13.6 |

Siehe Dokumentation zur Pose-Schätzung für Anwendungsbeispiele mit diesen auf COCO trainierten Modellen, die eine vortrainierte Klasse, 'person', enthalten.

| Modell | Größe (Pixel) | mAPpose 50-95(e2e) | mAPpose 50(e2e) | Geschwindigkeit CPU ONNX (ms) | Geschwindigkeit T4 TensorRT10 (ms) | Parameter (M) | FLOPs (B) |

|---|---|---|---|---|---|---|---|

| YOLO26n-pose | 640 | 57.2 | 83.3 | 40.3 ± 0.5 | 1.8 ± 0.0 | 2.9 | 7.5 |

| YOLO26s-pose | 640 | 63.0 | 86.6 | 85.3 ± 0.9 | 2.7 ± 0.0 | 10.4 | 23.9 |

| YOLO26m-pose | 640 | 68.8 | 89.6 | 218.0 ± 1.5 | 5.0 ± 0.1 | 21.5 | 73.1 |

| YOLO26l-pose | 640 | 70.4 | 90.5 | 275.4 ± 2.4 | 6.5 ± 0.1 | 25.9 | 91.3 |

| YOLO26x-pose | 640 | 71.6 | 91.6 | 565.4 ± 3.0 | 12.2 ± 0.2 | 57.6 | 201.7 |

Siehe Dokumentation zur orientierten detect-Erkennung für Anwendungsbeispiele mit diesen Modellen, die auf DOTAv1 trainiert wurden und 15 vortrainierte Klassen umfassen.

| Modell | Größe (Pixel) | mAPtest 50-95(e2e) | mAPtest 50(e2e) | Geschwindigkeit CPU ONNX (ms) | Geschwindigkeit T4 TensorRT10 (ms) | Parameter (M) | FLOPs (B) |

|---|---|---|---|---|---|---|---|

| YOLO26n-obb | 1024 | 52.4 | 78.9 | 97.7 ± 0.9 | 2.8 ± 0.0 | 2.5 | 14.0 |

| YOLO26s-obb | 1024 | 54.8 | 80.9 | 218.0 ± 1.4 | 4.9 ± 0.1 | 9.8 | 55.1 |

| YOLO26m-obb | 1024 | 55.3 | 81.0 | 579.2 ± 3.8 | 10.2 ± 0.3 | 21.2 | 183.3 |

| YOLO26l-obb | 1024 | 56.2 | 81.6 | 735.6 ± 3.1 | 13.0 ± 0.2 | 25.6 | 230.0 |

| YOLO26x-obb | 1024 | 56.7 | 81.7 | 1485.7 ± 11.5 | 30.5 ± 0.9 | 57.6 | 516.5 |

Die Parameter- und FLOP-Werte gelten für das fusionierte Modell nach model.fuse(), das Conv- und BatchNorm-Schichten zusammenführt und den zusätzlichen One-to-Many-Erkennungskopf entfernt. Vorab trainierte Checkpoints behalten die vollständige Trainingsarchitektur bei und können höhere Werte aufweisen.

Anwendungsbeispiele

Dieser Abschnitt bietet einfache Beispiele für das Training und die Inferenz mit YOLO26. Für die vollständige Dokumentation zu diesen und weiteren Modi siehe die Dokumentationsseiten zu Predict, Train, Val und Export.

Beachten Sie, dass das folgende Beispiel für YOLO26 Detect-Modelle zur Objekterkennung gilt. Für weitere unterstützte Aufgaben siehe die Dokumentation zu Segment, Classify, OBB und Pose.

Beispiel

PyTorch vorab trainierte *.pt Modelle sowie Konfigurations- *.yaml Dateien können an die YOLO() Klasse, um eine Modellinstanz in Python zu erstellen:

from ultralytics import YOLO

# Load a COCO-pretrained YOLO26n model

model = YOLO("yolo26n.pt")

# Train the model on the COCO8 example dataset for 100 epochs

results = model.train(data="coco8.yaml", epochs=100, imgsz=640)

# Run inference with the YOLO26n model on the 'bus.jpg' image

results = model("path/to/bus.jpg")

Es stehen CLI-Befehle zur Verfügung, um die Modelle direkt auszuführen:

# Load a COCO-pretrained YOLO26n model and train it on the COCO8 example dataset for 100 epochs

yolo train model=yolo26n.pt data=coco8.yaml epochs=100 imgsz=640

# Load a COCO-pretrained YOLO26n model and run inference on the 'bus.jpg' image

yolo predict model=yolo26n.pt source=path/to/bus.jpg

Dual-Head-Architektur

YOLO26 verfügt über eine Dual-Head-Architektur, die Flexibilität für verschiedene Einsatzszenarien bietet:

- Eins-zu-Eins-Kopf (Standard)Erzeugt End-to-End-Vorhersagen ohne NMS und gibt aus.

(N, 300, 6)mit maximal 300 Erkennungen pro Bild. Dieser Kopf ist für schnelle Inferenz und vereinfachte Bereitstellung optimiert. - Eins-zu-Viele-Kopf: Erzeugt traditionelle YOLO , die NMS erfordern, und gibt aus

(N, nc + 4, 8400)wobeincist die Anzahl der Klassen. Dieser Kopf erreicht in der Regel eine etwas höhere Genauigkeit, allerdings auf Kosten zusätzlicher Verarbeitung.

Sie können während des Exports, der Vorhersage oder der Validierung zwischen den Köpfen wechseln:

from ultralytics import YOLO

model = YOLO("yolo26n.pt")

# Use one-to-one head (default, no NMS required)

results = model.predict("image.jpg") # inference

metrics = model.val(data="coco.yaml") # validation

model.export(format="onnx") # export

# Use one-to-many head (requires NMS)

results = model.predict("image.jpg", end2end=False) # inference

metrics = model.val(data="coco.yaml", end2end=False) # validation

model.export(format="onnx", end2end=False) # export

# Use one-to-one head (default, no NMS required)

yolo predict model=yolo26n.pt source=image.jpg

yolo val model=yolo26n.pt data=coco.yaml

yolo export model=yolo26n.pt format=onnx

# Use one-to-many head (requires NMS)

yolo predict model=yolo26n.pt source=image.jpg end2end=False

yolo val model=yolo26n.pt data=coco.yaml end2end=False

yolo export model=yolo26n.pt format=onnx end2end=False

Die Wahl hängt von Ihren Einsatzanforderungen ab: Verwenden Sie den Eins-zu-Eins-Kopf für maximale Geschwindigkeit und Einfachheit oder den Eins-zu-Viele-Kopf, wenn Genauigkeit oberste Priorität hat.

YOLOE-26: Open-Vocabulary Instanzsegmentierung

YOLOE-26 integriert die hochleistungsfähige YOLO26-Architektur mit den Open-Vocabulary-Funktionen der YOLOE-Serie. Es ermöglicht die Echtzeit-detect und segment jeder Objektklasse mittels Text-Prompts, visuellen Prompts oder eines Prompt-freien Modus für die Zero-Shot-Inferenz, wodurch die Einschränkungen des Trainings mit festen Kategorien effektiv aufgehoben werden.

Durch die Nutzung des NMS-freien, End-to-End-Designs von YOLO26 liefert YOLOE-26 eine schnelle Open-World-Inferenz. Dies macht es zu einer leistungsstarken Lösung für Edge-Anwendungen in dynamischen Umgebungen, in denen die interessierenden Objekte ein breites und sich entwickelndes Vokabular darstellen.

Performance

Siehe YOLOE Docs für Anwendungsbeispiele mit diesen Modellen, die auf den Datensätzen Objects365v1, GQA und Flickr30k trainiert wurden.

| Modell | Größe (Pixel) | Prompt-Typ | mAPminival 50-95(e2e) | mAPminival 50-95 | mAPr | mAPc | mAPf | Parameter (M) | FLOPs (B) |

|---|---|---|---|---|---|---|---|---|---|

| YOLOE-26n-seg | 640 | Text/Visuell | 23.7 / 20.9 | 24.7 / 21.9 | 20.5 / 17.6 | 24.1 / 22.3 | 26.1 / 22.4 | 4.8 | 6.0 |

| YOLOE-26s-seg | 640 | Text/Visuell | 29.9 / 27.1 | 30.8 / 28.6 | 23.9 / 25.1 | 29.6 / 27.8 | 33.0 / 29.9 | 13.1 | 21.7 |

| YOLOE-26m-seg | 640 | Text/Visuell | 35.4 / 31.3 | 35.4 / 33.9 | 31.1 / 33.4 | 34.7 / 34.0 | 36.9 / 33.8 | 27.9 | 70.1 |

| YOLOE-26l-seg | 640 | Text/Visuell | 36.8 / 33.7 | 37.8 / 36.3 | 35.1 / 37.6 | 37.6 / 36.2 | 38.5 / 36.1 | 32.3 | 88.3 |

| YOLOE-26x-seg | 640 | Text/Visuell | 39.5 / 36.2 | 40.6 / 38.5 | 37.4 / 35.3 | 40.9 / 38.8 | 41.0 / 38.8 | 69.9 | 196.7 |

Siehe YOLOE Docs für Anwendungsbeispiele mit diesen Modellen, die auf den Datensätzen Objects365v1, GQA und Flickr30k trainiert wurden.

| Modell | Größe (Pixel) | mAPminival 50-95(e2e) | mAPminival 50(e2e) | Parameter (M) | FLOPs (B) |

|---|---|---|---|---|---|

| YOLOE-26n-seg-pf | 640 | 16.6 | 22.7 | 6.5 | 15.8 |

| YOLOE-26s-seg-pf | 640 | 21.4 | 28.6 | 16.2 | 35.5 |

| YOLOE-26m-seg-pf | 640 | 25.7 | 33.6 | 36.2 | 122.1 |

| YOLOE-26l-seg-pf | 640 | 27.2 | 35.4 | 40.6 | 140.4 |

| YOLOE-26x-seg-pf | 640 | 29.9 | 38.7 | 86.3 | 314.4 |

Anwendungsbeispiel

YOLOE-26 unterstützt sowohl textbasierte als auch visuelle Prompts. Die Verwendung von Prompts ist unkompliziert – übergeben Sie diese einfach über den predict Methode, wie unten gezeigt, verwenden:

Beispiel

Text-Prompts ermöglichen es Ihnen, die Klassen, die Sie detect möchten, durch textuelle Beschreibungen zu spezifizieren. Der folgende Code zeigt, wie Sie YOLOE-26 verwenden können, um Personen und Busse in einem Bild zu detect:

from ultralytics import YOLO

# Initialize model

model = YOLO("yoloe-26l-seg.pt") # or select yoloe-26s/m-seg.pt for different sizes

# Set text prompt to detect person and bus. You only need to do this once after you load the model.

model.set_classes(["person", "bus"])

# Run detection on the given image

results = model.predict("path/to/image.jpg")

# Show results

results[0].show()

Visuelle Prompts ermöglichen es Ihnen, das Modell zu steuern, indem Sie ihm visuelle Beispiele der Zielklassen zeigen, anstatt sie im Text zu beschreiben.

import numpy as np

from ultralytics import YOLO

from ultralytics.models.yolo.yoloe import YOLOEVPSegPredictor

# Initialize model

model = YOLO("yoloe-26l-seg.pt")

# Define visual prompts using bounding boxes and their corresponding class IDs.

# Each box highlights an example of the object you want the model to detect.

visual_prompts = dict(

bboxes=np.array(

[

[221.52, 405.8, 344.98, 857.54], # Box enclosing person

[120, 425, 160, 445], # Box enclosing glasses

],

),

cls=np.array(

[

0, # ID to be assigned for person

1, # ID to be assigned for glasses

]

),

)

# Run inference on an image, using the provided visual prompts as guidance

results = model.predict(

"ultralytics/assets/bus.jpg",

visual_prompts=visual_prompts,

predictor=YOLOEVPSegPredictor,

)

# Show results

results[0].show()

YOLOE-26 umfasst prompt-freie Varianten, die mit einem integrierten Vokabular ausgestattet sind. Diese Modelle benötigen keine Prompts und funktionieren wie traditionelle YOLO-Modelle. Anstatt sich auf benutzerdefinierte Labels oder visuelle Beispiele zu verlassen, detect sie Objekte aus einer vordefinierten Liste von 4.585 Klassen, basierend auf dem Tag-Set, das vom Recognize Anything Model Plus (RAM++) verwendet wird.

from ultralytics import YOLO

# Initialize model

model = YOLO("yoloe-26l-seg-pf.pt")

# Run prediction. No prompts required.

results = model.predict("path/to/image.jpg")

# Show results

results[0].show()

Für einen tieferen Einblick in Prompting-Techniken, Training von Grund auf und vollständige Anwendungsbeispiele besuchen Sie die YOLOE-Dokumentation.

Zitate und Danksagungen

Ultralytics YOLO26 Veröffentlichung

Ultralytics hat keine formelle Forschungsarbeit für YOLO26 veröffentlicht, da sich die Modelle schnell weiterentwickeln. Stattdessen konzentrieren wir uns darauf, hochmoderne Modelle bereitzustellen und sie einfach zu bedienen. Die neuesten Updates zu YOLO-Funktionen, Architekturen und zur Verwendung finden Sie in unserem GitHub-Repository und in unserer Dokumentation.

Wenn Sie YOLO26 oder andere Ultralytics Software in Ihrer Arbeit verwenden, zitieren Sie diese bitte wie folgt:

@software{yolo26_ultralytics,

author = {Glenn Jocher and Jing Qiu},

title = {Ultralytics YOLO26},

version = {26.0.0},

year = {2026},

url = {https://github.com/ultralytics/ultralytics},

orcid = {0000-0001-5950-6979, 0000-0003-3783-7069},

license = {AGPL-3.0}

}

DOI ausstehend. YOLO26 ist unter AGPL-3.0- und Enterprise-Lizenzen verfügbar.

FAQ

Was sind die wichtigsten Verbesserungen in YOLO26 im Vergleich zu YOLO11?

- DFL-Entfernung: Vereinfacht den Export und erweitert die Edge-Kompatibilität

- End-to-End NMS-freie Inferenz: Eliminiert NMS für eine schnellere, einfachere Bereitstellung

- ProgLoss + STAL: Erhöht die Genauigkeit, insbesondere bei kleinen Objekten

- MuSGD-Optimizer: Kombiniert SGD und Muon (inspiriert von Moonshots Kimi K2) für stabileres, effizienteres Training.

- Bis zu 43 % schnellere CPU-Inferenz: Deutliche Leistungssteigerung für reine CPU-Geräte

Welche Aufgaben unterstützt YOLO26?

YOLO26 ist eine vereinheitlichte Modellfamilie, die eine End-to-End-Unterstützung für mehrere Computer-Vision-Aufgaben bietet:

- Objekterkennung

- Instanzsegmentierung

- Bildklassifizierung

- Pose-Schätzung

- Orientierte Objekterkennung (OBB)

Jede Größenvariante (n, s, m, l, x) unterstützt alle Aufgaben sowie Open-Vocabulary-Versionen über YOLOE-26.

Warum ist YOLO26 für den Edge-Einsatz optimiert?

YOLO26 bietet modernste Edge-Performance mit:

- Bis zu 43 % schnellere CPU-Inferenz

- Reduzierte Modellgröße und Speicherbedarf

- Architektur für Kompatibilität vereinfacht (ohne DFL, ohne NMS)

- Flexible Exportformate, darunter TensorRT, ONNX, CoreML, TFLite und OpenVINO

Wie fange ich mit YOLO26 an?

YOLO26-Modelle wurden am 14. Januar 2026 veröffentlicht und stehen zum Download bereit. Installieren oder aktualisieren Sie das ultralytics Paket und laden Sie ein Modell:

from ultralytics import YOLO

# Load a pretrained YOLO26 nano model

model = YOLO("yolo26n.pt")

# Run inference on an image

results = model("image.jpg")

Anweisungen zum Training, zur Validierung und zum Export finden Sie im Abschnitt Anwendungsbeispiele.