Conjunto de datos Caltech-101

El conjunto de datos Caltech-101 es un conjunto de datos ampliamente utilizado para tareas de reconocimiento de objetos, que contiene alrededor de 9,000 imágenes de 101 categorías de objetos. Las categorías se eligieron para reflejar una variedad de objetos del mundo real, y las imágenes en sí se seleccionaron y anotaron cuidadosamente para proporcionar un punto de referencia desafiante para los algoritmos de reconocimiento de objetos.

Ver: Cómo entrenar Clasificación de imágenes Modelo utilizando el conjunto de datos Caltech-256 con Ultralytics Platform

División automática de datos

El conjunto de datos Caltech-101, tal como se proporciona, no viene con divisiones predefinidas de entrenamiento/validación. Sin embargo, cuando utiliza los comandos de entrenamiento proporcionados en los ejemplos de uso a continuación, el marco de Ultralytics dividirá automáticamente el conjunto de datos por usted. La división predeterminada utilizada es del 80% para el conjunto de entrenamiento y del 20% para el conjunto de validación.

Características clave

- El conjunto de datos Caltech-101 comprende alrededor de 9,000 imágenes a color divididas en 101 categorías.

- Las categorías abarcan una amplia variedad de objetos, incluidos animales, vehículos, artículos para el hogar y personas.

- El número de imágenes por categoría varía, con aproximadamente 40 a 800 imágenes en cada categoría.

- Las imágenes son de tamaños variables, y la mayoría de las imágenes son de resolución media.

- Caltech-101 se utiliza ampliamente para el entrenamiento y las pruebas en el campo del aprendizaje automático, particularmente para las tareas de reconocimiento de objetos.

Estructura del conjunto de datos

A diferencia de muchos otros conjuntos de datos, el conjunto de datos Caltech-101 no se divide formalmente en conjuntos de entrenamiento y prueba. Los usuarios suelen crear sus propias divisiones según sus necesidades específicas. Sin embargo, una práctica común es utilizar un subconjunto aleatorio de imágenes para el entrenamiento (por ejemplo, 30 imágenes por categoría) y las imágenes restantes para la prueba.

Aplicaciones

El conjunto de datos Caltech-101 se utiliza ampliamente para entrenar y evaluar modelos de aprendizaje profundo en tareas de reconocimiento de objetos, como las redes neuronales convolucionales (CNN), las máquinas de vectores de soporte (SVM) y otros algoritmos de aprendizaje automático. Su amplia variedad de categorías e imágenes de alta calidad lo convierten en un excelente conjunto de datos para la investigación y el desarrollo en el campo del aprendizaje automático y la visión artificial.

Uso

Para entrenar un modelo YOLO en el conjunto de datos Caltech-101 durante 100 epochs, puedes utilizar los siguientes fragmentos de código. Para obtener una lista completa de los argumentos disponibles, consulta la página de Entrenamiento del modelo.

Ejemplo de entrenamiento

from ultralytics import YOLO

# Load a model

model = YOLO("yolo26n-cls.pt") # load a pretrained model (recommended for training)

# Train the model

results = model.train(data="caltech101", epochs=100, imgsz=416)

# Start training from a pretrained *.pt model

yolo classify train data=caltech101 model=yolo26n-cls.pt epochs=100 imgsz=416

sample_images y anotaciones

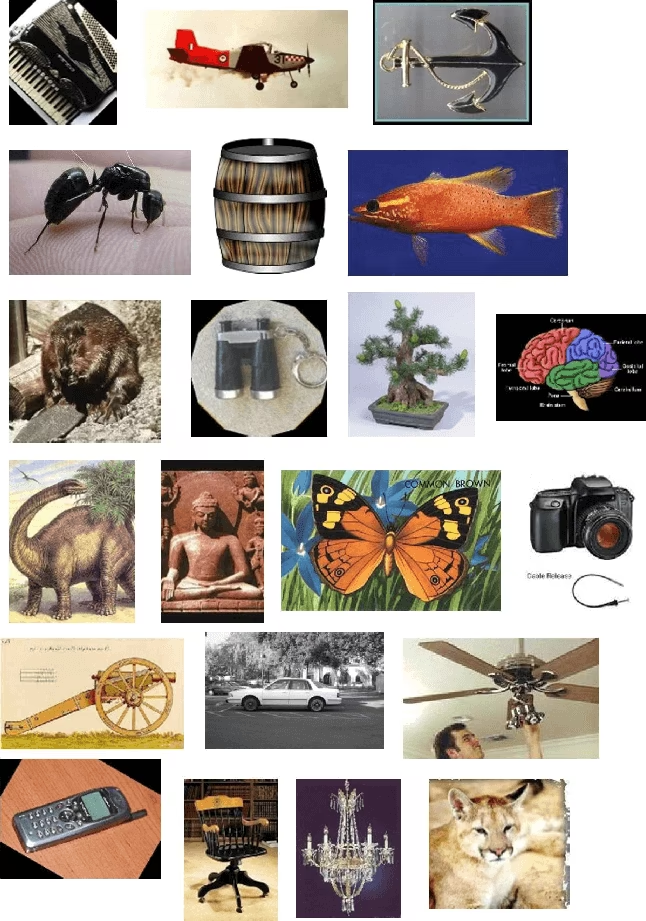

El conjunto de datos Caltech-101 contiene imágenes en color de alta calidad de varios objetos, lo que proporciona un conjunto de datos bien estructurado para las tareas de clasificación de imágenes. Aquí hay algunos ejemplos de imágenes del conjunto de datos:

El ejemplo muestra la variedad y complejidad de los objetos en el conjunto de datos Caltech-101, enfatizando la importancia de un conjunto de datos diverso para entrenar modelos robustos de reconocimiento de objetos.

Citas y agradecimientos

Si utiliza el conjunto de datos Caltech-101 en su trabajo de investigación o desarrollo, cite el siguiente artículo:

@article{fei2007learning,

title={Learning generative visual models from few training examples: An incremental Bayesian approach tested on 101 object categories},

author={Fei-Fei, Li and Fergus, Rob and Perona, Pietro},

journal={Computer vision and Image understanding},

volume={106},

number={1},

pages={59--70},

year={2007},

publisher={Elsevier}

}

Nos gustaría agradecer a Li Fei-Fei, Rob Fergus y Pietro Perona por crear y mantener el conjunto de datos Caltech-101 como un recurso valioso para la comunidad de investigación en aprendizaje automático y visión artificial. Para obtener más información sobre el conjunto de datos Caltech-101 y sus creadores, visita el sitio web del conjunto de datos Caltech-101.

Preguntas frecuentes

¿Para qué se utiliza el conjunto de datos Caltech-101 en el aprendizaje automático?

El conjunto de datos Caltech-101 es ampliamente utilizado en el aprendizaje automático para tareas de reconocimiento de objetos. Contiene alrededor de 9,000 imágenes en 101 categorías, lo que proporciona un punto de referencia desafiante para evaluar algoritmos de reconocimiento de objetos. Los investigadores lo aprovechan para entrenar y probar modelos, especialmente Redes Neuronales Convolucionales (CNN) y Máquinas de Vectores de Soporte (SVM), en visión artificial.

¿Cómo puedo entrenar un modelo Ultralytics YOLO en el conjunto de datos Caltech-101?

Para entrenar un modelo Ultralytics YOLO en el conjunto de datos Caltech-101, puedes utilizar los fragmentos de código proporcionados. Por ejemplo, para entrenar durante 100 epochs:

Ejemplo de entrenamiento

from ultralytics import YOLO

# Load a model

model = YOLO("yolo26n-cls.pt") # load a pretrained model (recommended for training)

# Train the model

results = model.train(data="caltech101", epochs=100, imgsz=416)

# Start training from a pretrained *.pt model

yolo classify train data=caltech101 model=yolo26n-cls.pt epochs=100 imgsz=416

Para obtener argumentos y opciones más detallados, consulta la página de Entrenamiento del modelo.

¿Cuáles son las características clave del conjunto de datos Caltech-101?

El conjunto de datos Caltech-101 incluye:

- Alrededor de 9,000 imágenes a color en 101 categorías.

- Categorías que cubren una amplia gama de objetos, incluyendo animales, vehículos y artículos para el hogar.

- Número variable de imágenes por categoría, normalmente entre 40 y 800.

- Tamaños de imagen variables, siendo la mayoría de resolución media.

Estas características la convierten en una excelente opción para entrenar y evaluar modelos de reconocimiento de objetos en el aprendizaje automático y la visión artificial.

¿Por qué debo citar el conjunto de datos Caltech-101 en mi investigación?

Citar el conjunto de datos Caltech-101 en su investigación reconoce las contribuciones de los creadores y proporciona una referencia para otros que puedan utilizar el conjunto de datos. La cita recomendada es:

@article{fei2007learning,

title={Learning generative visual models from few training examples: An incremental Bayesian approach tested on 101 object categories},

author={Fei-Fei, Li and Fergus, Rob and Perona, Pietro},

journal={Computer vision and Image understanding},

volume={106},

number={1},

pages={59--70},

year={2007},

publisher={Elsevier}

}

Citar ayuda a mantener la integridad del trabajo académico y ayuda a los compañeros a localizar el recurso original.

¿Puedo usar Ultralytics Platform para entrenar modelos con el conjunto de datos Caltech-101?

Sí, puede usar Ultralytics Platform para entrenar modelos con el conjunto de datos Caltech-101. Ultralytics Platform proporciona una plataforma intuitiva para gestionar conjuntos de datos, entrenar modelos y desplegarlos sin necesidad de una codificación extensa. Para una guía detallada, consulte la entrada del blog cómo entrenar sus modelos personalizados con Ultralytics Platform.