Inferenza Thread-Safe con modelli YOLO

L'esecuzione di modelli YOLO in un ambiente multi-thread richiede un'attenta considerazione per garantire la thread safety. Python threading Il modulo ti consente di eseguire diversi thread contemporaneamente, ma quando si tratta di utilizzare i modelli YOLO attraverso questi thread, ci sono importanti problemi di sicurezza di cui essere consapevoli. Questa pagina ti guiderà nella creazione di un'inferenza del modello YOLO thread-safe.

Guarda: Come eseguire l'inferenza thread-safe con i modelli Ultralytics YOLO in python | Multi-Threading 🚀

Comprensione del Threading in Python

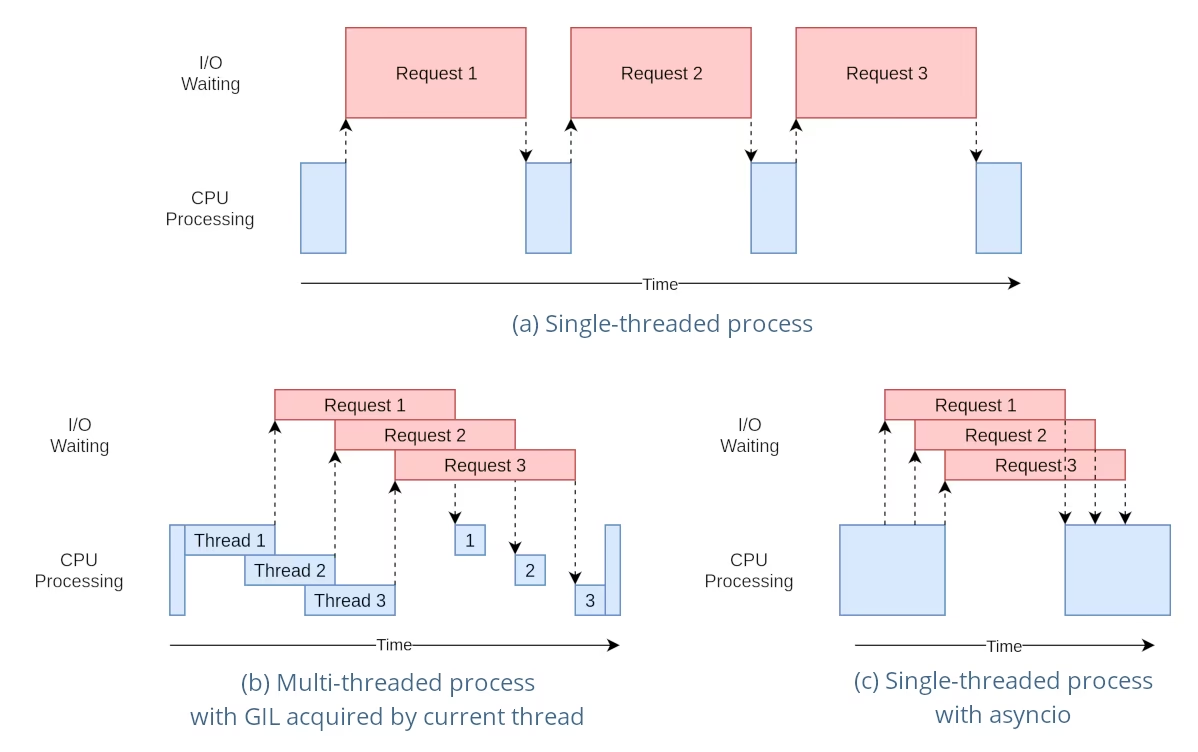

I thread Python sono una forma di parallelismo che consente al tuo programma di eseguire più operazioni contemporaneamente. Tuttavia, il Global Interpreter Lock (GIL) di Python implica che solo un thread può eseguire il bytecode Python alla volta.

Anche se questo può sembrare una limitazione, i thread possono comunque fornire concorrenza, specialmente per le operazioni I/O-bound o quando si utilizzano operazioni che rilasciano il GIL, come quelle eseguite dalle librerie C sottostanti di YOLO.

Il pericolo delle istanze di modello condivise

L'istanziazione di un modello YOLO al di fuori dei tuoi thread e la condivisione di questa istanza tra più thread può portare a race condition, in cui lo stato interno del modello viene modificato in modo incoerente a causa di accessi concorrenti. Questo è particolarmente problematico quando il modello o i suoi componenti detengono uno stato che non è progettato per essere thread-safe.

Esempio Non Thread-Safe: Singola Istanza di Modello

Quando si utilizzano i thread in python, è importante riconoscere i modelli che possono portare a problemi di concorrenza. Ecco cosa dovresti evitare: condividere una singola istanza del modello YOLO tra più thread.

# Unsafe: Sharing a single model instance across threads

from threading import Thread

from ultralytics import YOLO

# Instantiate the model outside the thread

shared_model = YOLO("yolo26n.pt")

def predict(image_path):

"""Predicts objects in an image using a preloaded YOLO model, take path string to image as argument."""

results = shared_model.predict(image_path)

# Process results

# Starting threads that share the same model instance

Thread(target=predict, args=("image1.jpg",)).start()

Thread(target=predict, args=("image2.jpg",)).start()

Nell'esempio sopra, il shared_model è utilizzato da più thread, il che può portare a risultati imprevedibili perché predict potrebbe essere eseguito simultaneamente da più thread.

Esempio Non Thread-Safe: Istanze di Modelli Multiple

Allo stesso modo, ecco un modello non sicuro con più istanze del modello YOLO:

# Unsafe: Sharing multiple model instances across threads can still lead to issues

from threading import Thread

from ultralytics import YOLO

# Instantiate multiple models outside the thread

shared_model_1 = YOLO("yolo26n_1.pt")

shared_model_2 = YOLO("yolo26n_2.pt")

def predict(model, image_path):

"""Runs prediction on an image using a specified YOLO model, returning the results."""

results = model.predict(image_path)

# Process results

# Starting threads with individual model instances

Thread(target=predict, args=(shared_model_1, "image1.jpg")).start()

Thread(target=predict, args=(shared_model_2, "image2.jpg")).start()

Anche se ci sono due istanze di modello separate, il rischio di problemi di concorrenza esiste ancora. Se l'implementazione interna di YOLO non è thread-safe, l'utilizzo di istanze separate potrebbe non impedire le race condition, soprattutto se queste istanze condividono risorse o stati sottostanti che non sono thread-local.

Inferenza thread-safe

Per eseguire l'inferenza thread-safe, è necessario istanziare un modello YOLO separato all'interno di ogni thread. Ciò garantisce che ogni thread abbia la propria istanza di modello isolata, eliminando il rischio di race condition.

Esempio Thread-Safe

Ecco come istanziare un modello YOLO all'interno di ogni thread per un'inferenza parallela sicura:

# Safe: Instantiating a single model inside each thread

from threading import Thread

from ultralytics import YOLO

def thread_safe_predict(image_path):

"""Predict on an image using a new YOLO model instance in a thread-safe manner; takes image path as input."""

local_model = YOLO("yolo26n.pt")

results = local_model.predict(image_path)

# Process results

# Starting threads that each have their own model instance

Thread(target=thread_safe_predict, args=("image1.jpg",)).start()

Thread(target=thread_safe_predict, args=("image2.jpg",)).start()

In questo esempio, ogni thread crea il proprio YOLO istanza. Questo impedisce a qualsiasi thread di interferire con lo stato del modello di un altro, garantendo così che ogni thread esegua l'inferenza in modo sicuro e senza interazioni impreviste con gli altri thread.

Utilizzo del decoratore ThreadingLocked

Ultralytics fornisce un ThreadingLocked decoratore che può essere utilizzato per garantire l'esecuzione thread-safe delle funzioni. Questo decoratore utilizza un blocco per garantire che un solo thread alla volta possa eseguire la funzione decorata.

from ultralytics import YOLO

from ultralytics.utils import ThreadingLocked

# Create a model instance

model = YOLO("yolo26n.pt")

# Decorate the predict method to make it thread-safe

@ThreadingLocked()

def thread_safe_predict(image_path):

"""Thread-safe prediction using a shared model instance."""

results = model.predict(image_path)

return results

# Now you can safely call this function from multiple threads

Il ThreadingLocked Il decoratore è particolarmente utile quando è necessario condividere un'istanza di modello tra thread, ma si vuole garantire che un solo thread possa accedervi alla volta. Questo approccio può far risparmiare memoria rispetto alla creazione di una nuova istanza di modello per ogni thread, ma può ridurre la concorrenza poiché i thread dovranno attendere che il blocco venga rilasciato.

Conclusione

Quando si utilizzano modelli YOLO con python threading, istanzia sempre i tuoi modelli all'interno del thread che li utilizzerà per garantire la thread safety. Questa pratica evita race condition e assicura che le tue attività di inferenza vengano eseguite in modo affidabile.

Per scenari più avanzati e per ottimizzare ulteriormente le prestazioni dell'inferenza multi-thread, considera l'utilizzo del parallelismo basato su processi con multiprocessing o sfruttando una coda di attività con processi worker dedicati.

FAQ

Come posso evitare race condition quando utilizzo modelli YOLO in un ambiente Python multi-thread?

Per prevenire race condition quando si utilizzano modelli Ultralytics YOLO in un ambiente Python multi-thread, istanziare un modello YOLO separato all'interno di ogni thread. Ciò garantisce che ogni thread abbia la propria istanza di modello isolata, evitando la modifica simultanea dello stato del modello.

Esempio:

from threading import Thread

from ultralytics import YOLO

def thread_safe_predict(image_path):

"""Predict on an image in a thread-safe manner."""

local_model = YOLO("yolo26n.pt")

results = local_model.predict(image_path)

# Process results

Thread(target=thread_safe_predict, args=("image1.jpg",)).start()

Thread(target=thread_safe_predict, args=("image2.jpg",)).start()

Per maggiori informazioni su come garantire la thread safety, visita la pagina Inferenza Thread-Safe con modelli YOLO.

Quali sono le migliori pratiche per eseguire l'inferenza del modello YOLO multi-thread in python?

Per eseguire in modo sicuro l'inferenza del modello YOLO multi-thread in Python, segui queste best practice:

- Istanziare i modelli YOLO all'interno di ciascun thread piuttosto che condividere una singola istanza del modello tra i thread.

- Utilizza

multiprocessingmodulo per l'elaborazione parallela per evitare problemi relativi al Global Interpreter Lock (GIL). - Rilascia il GIL utilizzando operazioni eseguite dalle librerie C sottostanti di YOLO.

- Considera l'utilizzo di

ThreadingLockeddecoratore per istanze di modelli condivisi quando la memoria è una preoccupazione.

Esempio di creazione di istanze del modello thread-safe:

from threading import Thread

from ultralytics import YOLO

def thread_safe_predict(image_path):

"""Runs inference in a thread-safe manner with a new YOLO model instance."""

model = YOLO("yolo26n.pt")

results = model.predict(image_path)

# Process results

# Initiate multiple threads

Thread(target=thread_safe_predict, args=("image1.jpg",)).start()

Thread(target=thread_safe_predict, args=("image2.jpg",)).start()

Per ulteriore contesto, fare riferimento alla sezione sull'Inferenza Thread-Safe.

Perché ogni thread dovrebbe avere la propria istanza del modello YOLO?

Ogni thread dovrebbe avere la propria istanza del modello YOLO per evitare race condition. Quando una singola istanza del modello è condivisa tra più thread, gli accessi concorrenti possono portare a comportamenti imprevedibili e modifiche dello stato interno del modello. Utilizzando istanze separate, si garantisce l'isolamento dei thread, rendendo le attività multi-thread affidabili e sicure.

Per una guida dettagliata, consultare le sezioni Esempio non thread-safe: istanza di modello singolo ed Esempio thread-safe.

In che modo il Global Interpreter Lock (GIL) di python influisce sull'inferenza del modello YOLO?

Il Global Interpreter Lock (GIL) di python consente a un solo thread di eseguire il bytecode Python alla volta, il che può limitare le prestazioni delle attività multi-threading vincolate alla CPU. Tuttavia, per le operazioni vincolate all'I/O o per i processi che utilizzano librerie che rilasciano il GIL, come le librerie C sottostanti di YOLO, è comunque possibile ottenere la concorrenza. Per prestazioni migliorate, considera l'utilizzo del parallelismo basato sui processi con il modulo multiprocessing di python. multiprocessing module.

Per maggiori informazioni sul threading in python, consulta la sezione Comprensione del Threading in Python.

È più sicuro utilizzare il parallelismo basato su processi invece del threading per l'inferenza del modello YOLO?

Sì, usando Python's multiprocessing Il modulo è più sicuro e spesso più efficiente per l'esecuzione parallela dell'inferenza del modello YOLO. Il parallelismo basato sui processi crea spazi di memoria separati, evitando il Global Interpreter Lock (GIL) e riducendo il rischio di problemi di concorrenza. Ogni processo opererà in modo indipendente con la propria istanza del modello YOLO.

Per ulteriori dettagli sul parallelismo basato sui processi con i modelli YOLO, fare riferimento alla pagina sull'Inferenza Thread-Safe.