Intel OpenVINO 내보내기

이 가이드에서는 YOLO26 모델을 OpenVINO 형식으로 내보내는 방법을 다룹니다. 이 형식은 최대 3배의 CPU 속도 향상을 제공하며, Intel GPU 및 NPU 하드웨어에서 YOLO 추론을 가속화할 수 있습니다.

OpenVINO(Open Visual Inference & Neural Network Optimization toolkit)는 AI 추론 모델을 최적화하고 배포하기 위한 포괄적인 툴킷입니다. 이름에 Visual이 포함되어 있지만 OpenVINO는 언어, 오디오, 시계열 등 다양한 추가 작업도 지원합니다.

참고: 더 빠른 추론을 위해 Ultralytics YOLO26을 Intel OpenVINO 형식으로 내보내는 방법 🚀

사용 예시

YOLO26n 모델을 OpenVINO 형식으로 내보내고 내보낸 모델로 추론을 실행합니다.

예시

from ultralytics import YOLO

# Load a YOLO26n PyTorch model

model = YOLO("yolo26n.pt")

# Export the model

model.export(format="openvino") # creates 'yolo26n_openvino_model/'

# Load the exported OpenVINO model

ov_model = YOLO("yolo26n_openvino_model/")

# Run inference

results = ov_model("https://ultralytics.com/images/bus.jpg")

# Run inference with specified device, available devices: ["intel:gpu", "intel:npu", "intel:cpu"]

results = ov_model("https://ultralytics.com/images/bus.jpg", device="intel:gpu")

# Export a YOLO26n PyTorch model to OpenVINO format

yolo export model=yolo26n.pt format=openvino # creates 'yolo26n_openvino_model/'

# Run inference with the exported model

yolo predict model=yolo26n_openvino_model source='https://ultralytics.com/images/bus.jpg'

# Run inference with specified device, available devices: ["intel:gpu", "intel:npu", "intel:cpu"]

yolo predict model=yolo26n_openvino_model source='https://ultralytics.com/images/bus.jpg' device="intel:gpu"

인수 내보내기

| 인수 | 유형 | 기본값 | 설명 |

|---|---|---|---|

format | str | 'openvino' | 다양한 배포 환경과의 호환성을 정의하는 내보낸 모델의 대상 형식입니다. |

imgsz | int 또는 tuple | 640 | 모델 입력에 대한 원하는 이미지 크기입니다. 정사각형 이미지의 경우 정수이거나 튜플일 수 있습니다. (height, width) 특정 크기의 경우. |

half | bool | False | FP16(반정밀도) 양자화를 활성화하여 모델 크기를 줄이고 지원되는 하드웨어에서 추론 속도를 높일 수 있습니다. |

int8 | bool | False | INT8 양자화를 활성화하여 모델을 더욱 압축하고 정확도 손실을 최소화하면서 추론 속도를 높입니다(주로 에지 장치용). |

dynamic | bool | False | 동적 입력 크기를 허용하여 다양한 이미지 크기를 처리하는 유연성을 향상시킵니다. |

nms | bool | False | 정확하고 효율적인 detect 후처리(post-processing)에 필수적인 Non-Maximum Suppression (NMS)을 추가합니다. |

batch | int | 1 | 내보내기 모델 배치 추론 크기 또는 내보내기 모델이 동시에 처리할 이미지의 최대 수를 지정합니다. predict mode. |

data | str | 'coco8.yaml' | 다음 경로: 데이터 세트 구성 파일(기본값: coco8.yaml), 양자화에 필수적입니다. |

fraction | float | 1.0 | INT8 양자화 보정에 사용할 데이터 세트의 비율을 지정합니다. 전체 데이터 세트의 하위 집합에서 보정할 수 있으므로 실험이나 리소스가 제한적일 때 유용합니다. INT8을 활성화한 상태에서 지정하지 않으면 전체 데이터 세트가 사용됩니다. |

내보내기 프로세스에 대한 자세한 내용은 내보내기에 대한 Ultralytics 문서 페이지를 참조하십시오.

경고

OpenVINO™는 대부분의 Intel® 프로세서와 호환되지만 최적의 성능을 보장하려면 다음 사항을 확인하십시오.

OpenVINO™ 지원 확인 Intel 호환성 목록을 사용하여 사용 중인 인텔® 칩이 OpenVINO™에서 공식적으로 지원되는지 확인하세요.

가속기 식별 Intel 하드웨어 가이드를 참조하여 프로세서에 통합 NPU(신경 처리 장치)가 포함되어 있는지 또는 GPU (통합 GPU)가 포함되어 있는지 확인합니다.

최신 드라이버 설치 칩이 NPU 또는 GPU 지원하지만 OpenVINO™가 이를 감지하지 못하는 경우, 관련 드라이버를 설치하거나 업데이트해야 할 수 있습니다. 드라이버 설치 지침에 따라 전체 가속을 활성화하세요.

이 세 단계를 따르면 Intel® 하드웨어에서 OpenVINO™가 최적으로 실행되도록 할 수 있습니다.

OpenVINO의 이점

- 성능: OpenVINO는 Intel CPU, 통합 및 외장 GPU, FPGA의 성능을 활용하여 고성능 추론을 제공합니다.

- 이기종 실행 지원: OpenVINO는 한 번 작성하여 지원되는 모든 Intel 하드웨어(CPU, GPU, FPGA, VPU 등)에 배포할 수 있는 API를 제공합니다.

- 모델 최적화 도구: OpenVINO는 PyTorch, TensorFlow, TensorFlow Lite, Keras, ONNX, PaddlePaddle 및 Caffe와 같은 널리 사용되는 딥 러닝 프레임워크에서 모델을 가져오고 변환하고 최적화하는 모델 최적화 도구를 제공합니다.

- 사용 편의성: 툴킷에는 툴킷의 다양한 측면을 가르치는 80개 이상의 튜토리얼 노트북(YOLOv8 최적화 포함)이 함께 제공됩니다.

OpenVINO 내보내기 구조

모델을 OpenVINO 형식으로 내보내면 다음 내용이 포함된 디렉터리가 생성됩니다.

- XML 파일: 네트워크 토폴로지를 설명합니다.

- BIN 파일: 가중치 및 편향 이진 데이터를 포함합니다.

- 매핑 파일: 원본 모델 출력 텐서를 OpenVINO 텐서 이름에 매핑하는 정보를 담고 있습니다.

이 파일들을 사용하여 OpenVINO Inference Engine으로 추론을 실행할 수 있습니다.

배포 시 OpenVINO 내보내기 사용

모델을 OpenVINO 형식으로 성공적으로 내보내면 추론을 실행하는 두 가지 주요 옵션이 있습니다.

다음을 사용하여

ultralytics패키지는 고급 API를 제공하고 OpenVINO Runtime을 래핑합니다.기본(native) 방식을 사용합니다.

openvino추론 동작에 대한 고급 또는 사용자 정의 제어를 위한 패키지입니다.

Ultralytics를 사용한 추론

Ultralytics 패키지를 사용하면 predict 메서드를 통해 내보낸 OpenVINO 모델을 사용하여 쉽게 추론을 실행할 수 있습니다. 대상 장치를 지정할 수도 있습니다(예:). intel:gpu, intel:npu, intel:cpu) 장치 인수를 사용하여 지정합니다.

from ultralytics import YOLO

# Load the exported OpenVINO model

ov_model = YOLO("yolo26n_openvino_model/") # the path of your exported OpenVINO model

# Run inference with the exported model

ov_model.predict(device="intel:gpu") # specify the device you want to run inference on

이 접근 방식은 추론 파이프라인을 완전히 제어할 필요가 없는 경우 빠른 프로토타입 제작 또는 배포에 이상적입니다.

OpenVINO Runtime을 사용한 추론

OpenVINO 런타임은 지원되는 모든 Intel 하드웨어에서 추론을 위한 통합 API를 제공합니다. 또한 Intel 하드웨어 전반에 걸친 로드 밸런싱 및 비동기 실행과 같은 고급 기능을 제공합니다. 추론 실행에 대한 자세한 내용은 YOLO26 노트북을 참조하십시오.

Runtime으로 모델을 올바르게 설정하고 사용하려면 XML 및 BIN 파일과 입력 크기, 정규화 스케일 팩터 등과 같은 애플리케이션별 설정이 필요합니다.

일반적으로 배포 애플리케이션에서 다음과 같은 단계를 수행합니다.

- 다음을 생성하여 OpenVINO를 초기화합니다.

core = Core(). - 다음을 사용하여 모델을 로드합니다.

core.read_model()메서드. - 다음을 사용하여 모델을 컴파일합니다.

core.compile_model()함수. - 입력(이미지, 텍스트, 오디오 등)을 준비합니다.

- 다음을 사용하여 추론을 실행합니다.

compiled_model(input_data).

자세한 단계 및 코드 스니펫은 OpenVINO 문서 또는 API 튜토리얼을 참조하십시오.

OpenVINO YOLO11 벤치마크

Ultralytics 팀은 다양한 모델 형식과 정밀도에서 YOLO11의 벤치마크를 수행하여 OpenVINO와 호환되는 다양한 Intel 장치에서 속도와 정확도를 평가했습니다.

참고

아래 벤치마킹 결과는 참고용이며 시스템의 정확한 하드웨어 및 소프트웨어 구성과 벤치마크 실행 시 시스템의 현재 작업량에 따라 다를 수 있습니다.

모든 벤치마크는 다음으로 실행됩니다. openvino python 패키지 버전 2025.1.0.

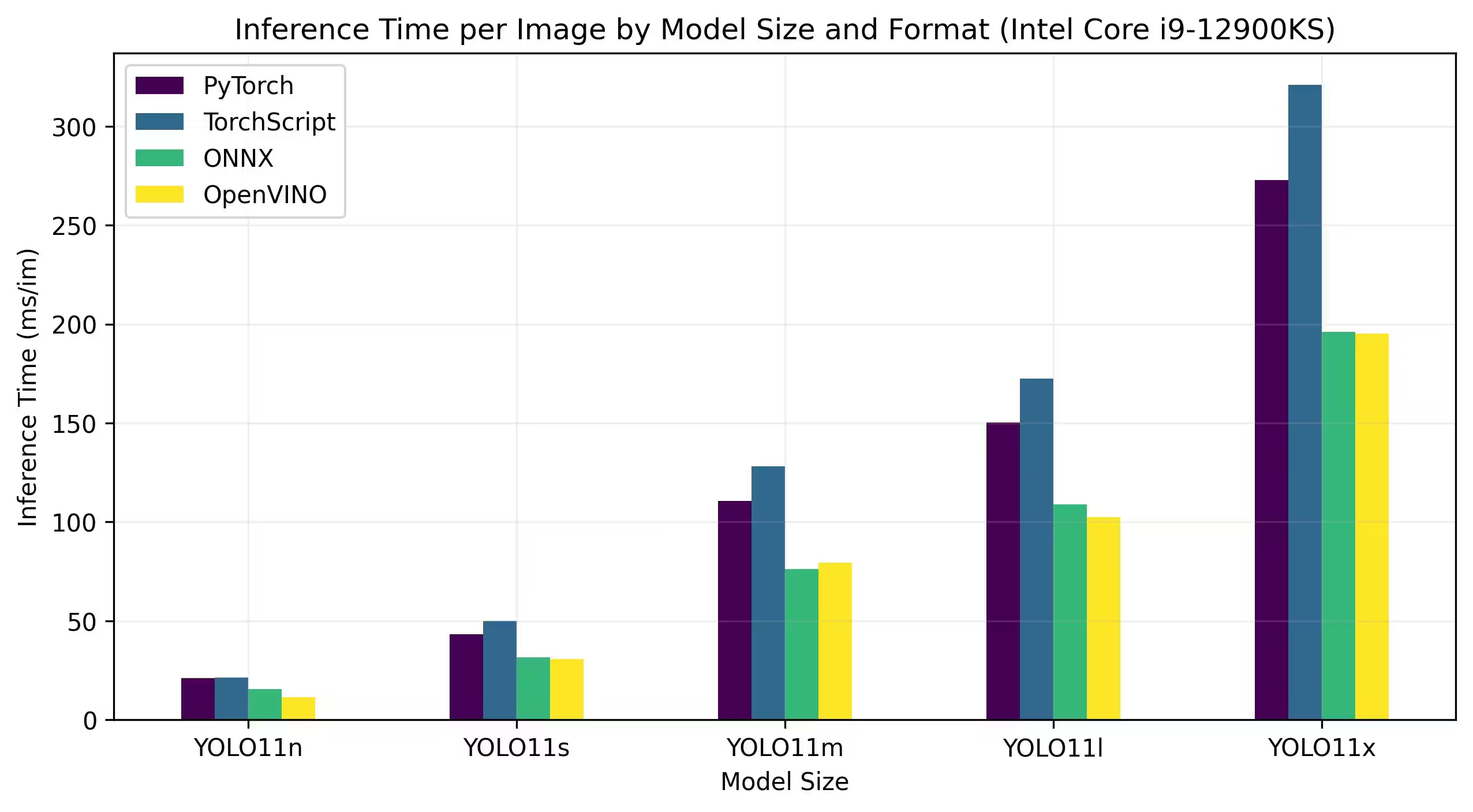

Intel Core CPU

Intel® Core® 시리즈는 Intel의 고성능 프로세서 제품군입니다. 이 라인업에는 Core i3(엔트리 레벨), Core i5(미드 레인지), Core i7(하이엔드) 및 Core i9(최고 성능)가 포함됩니다. 각 시리즈는 일상적인 작업에서 까다로운 전문 워크로드에 이르기까지 다양한 컴퓨팅 요구 사항과 예산을 충족합니다. 새로운 세대가 나올 때마다 성능, 에너지 효율성 및 기능이 향상됩니다.

아래 벤치마크는 FP32 정밀도로 12세대 Intel® Core® i9-12900KS CPU에서 실행됩니다.

자세한 벤치마크 결과

| 모델 | 형식 | 상태 | 크기(MB) | metrics/mAP50-95(B) | 추론 시간 (ms/im) |

|---|---|---|---|---|---|

| YOLO11n | PyTorch | ✅ | 5.4 | 0.5071 | 21.00 |

| YOLO11n | TorchScript | ✅ | 10.5 | 0.5077 | 21.39 |

| YOLO11n | ONNX | ✅ | 10.2 | 0.5077 | 15.55 |

| YOLO11n | OpenVINO | ✅ | 10.4 | 0.5077 | 11.49 |

| YOLO11s | PyTorch | ✅ | 18.4 | 0.5770 | 43.16 |

| YOLO11s | TorchScript | ✅ | 36.6 | 0.5781 | 50.06 |

| YOLO11s | ONNX | ✅ | 36.3 | 0.5781 | 31.53 |

| YOLO11s | OpenVINO | ✅ | 36.4 | 0.5781 | 30.82 |

| YOLO11m | PyTorch | ✅ | 38.8 | 0.6257 | 110.60 |

| YOLO11m | TorchScript | ✅ | 77.3 | 0.6306 | 128.09 |

| YOLO11m | ONNX | ✅ | 76.9 | 0.6306 | 76.06 |

| YOLO11m | OpenVINO | ✅ | 77.1 | 0.6306 | 79.38 |

| YOLO11l | PyTorch | ✅ | 49.0 | 0.6367 | 150.38 |

| YOLO11l | TorchScript | ✅ | 97.7 | 0.6408 | 172.57 |

| YOLO11l | ONNX | ✅ | 97.0 | 0.6408 | 108.91 |

| YOLO11l | OpenVINO | ✅ | 97.3 | 0.6408 | 102.30 |

| YOLO11x | PyTorch | ✅ | 109.3 | 0.6989 | 272.72 |

| YOLO11x | TorchScript | ✅ | 218.1 | 0.6900 | 320.86 |

| YOLO11x | ONNX | ✅ | 217.5 | 0.6900 | 196.20 |

| YOLO11x | OpenVINO | ✅ | 217.8 | 0.6900 | 195.32 |

Intel® Core™ Ultra

Intel® Core™ Ultra™ 시리즈는 게이머와 제작자부터 AI를 활용하는 전문가에 이르기까지 현대 사용자의 진화하는 요구 사항을 충족하도록 설계된 고성능 컴퓨팅의 새로운 기준을 제시합니다. 이 차세대 라인업은 기존의 CPU 시리즈 그 이상입니다. 강력한 CPU 코어, 통합된 고성능 GPU 기능, 단일 칩 내에 전용 신경 처리 장치(NPU)를 결합하여 다양하고 집중적인 컴퓨팅 워크로드에 대한 통합 솔루션을 제공합니다.

Intel® Core Ultra™ 아키텍처의 핵심은 기존 처리 작업, GPU 가속 워크로드 및 AI 기반 작업 전반에서 뛰어난 성능을 지원하는 하이브리드 설계입니다. NPU를 포함하면 온디바이스 AI 추론이 향상되어 광범위한 애플리케이션에서 더 빠르고 효율적인 머신 러닝 및 데이터 처리가 가능합니다.

Core Ultra™ 제품군은 다양한 성능 요구 사항에 맞춰 설계된 다양한 모델을 포함하며, 에너지 효율적인 설계부터 강력한 컴퓨팅 성능을 요구하는 랩톱 및 소형 폼 팩터에 이상적인 "H"로 표시된 고전력 변형 모델까지 다양하게 제공됩니다. 전체 라인업에서 사용자는 CPU, GPU 및 NPU 통합의 시너지 효과를 통해 뛰어난 효율성, 응답성 및 멀티태스킹 기능을 활용할 수 있습니다.

Intel의 지속적인 혁신의 일환으로 Core Ultra™ 시리즈는 미래 지향적인 컴퓨팅을 위한 새로운 표준을 제시합니다. 다양한 모델이 출시되어 있으며 앞으로 더 많은 모델이 출시될 예정인 이 시리즈는 차세대 지능형 AI 강화 장치를 위한 최첨단 솔루션을 제공하려는 Intel의 노력을 강조합니다.

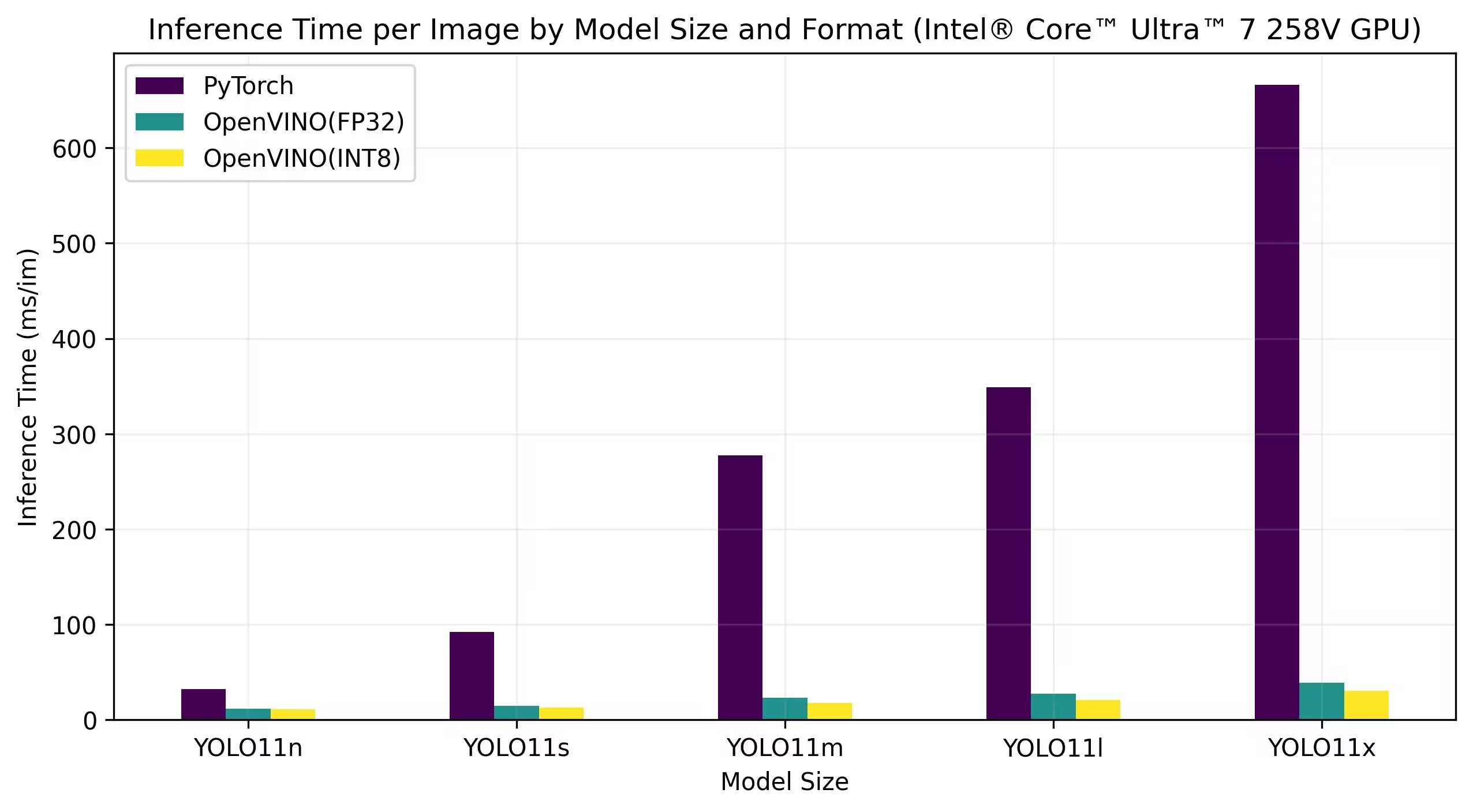

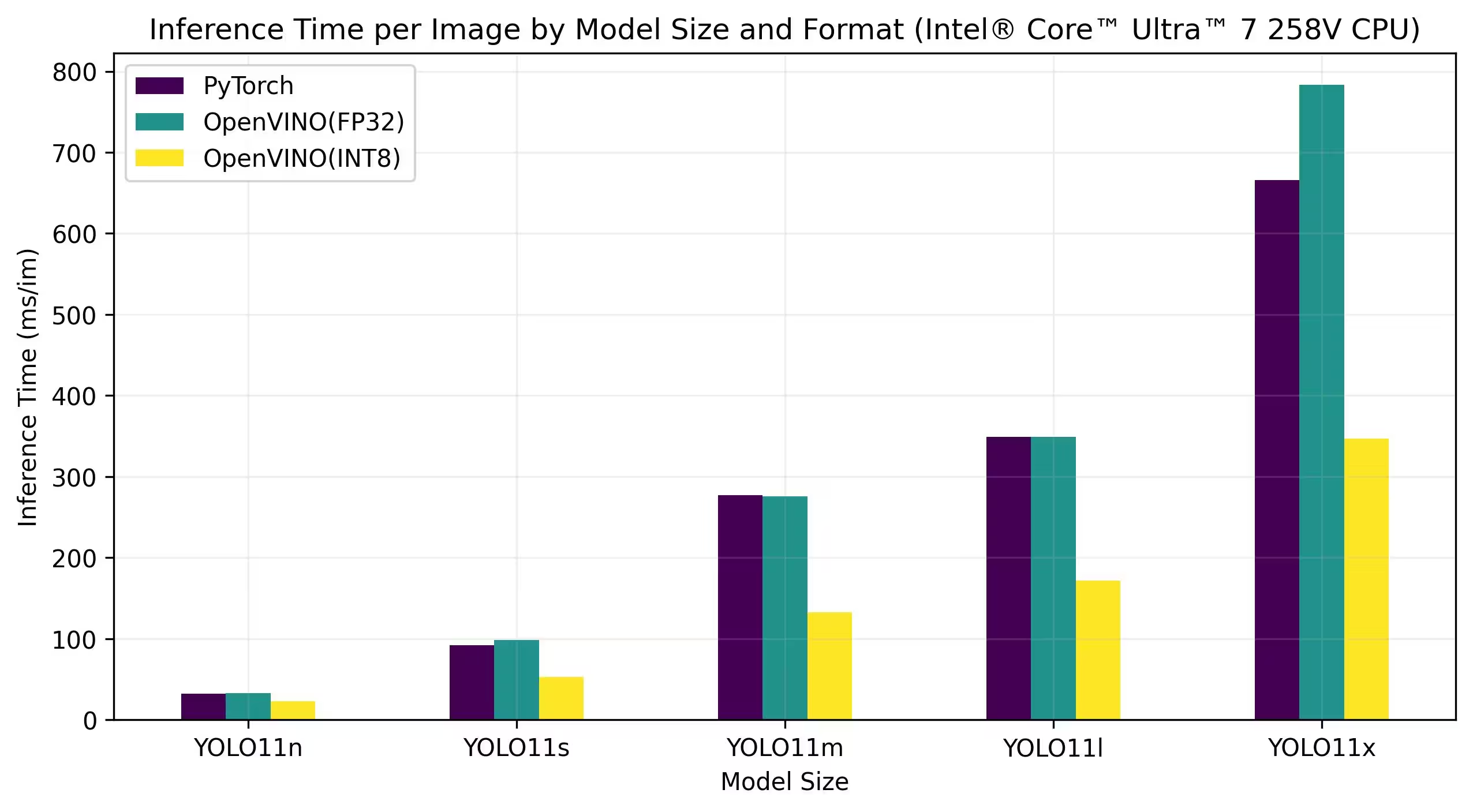

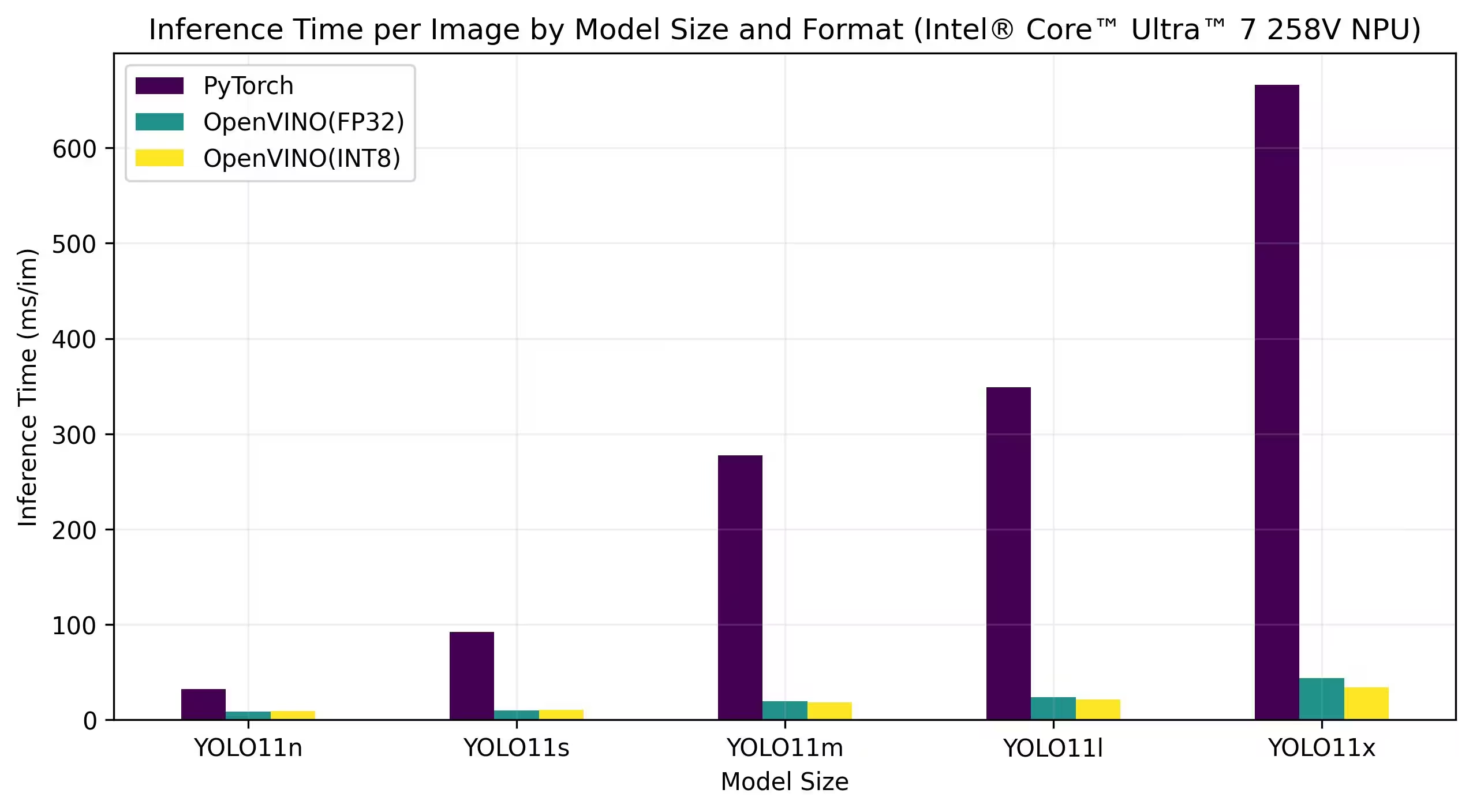

아래 벤치마크는 FP32 및 INT8 정밀도로 Intel® Core™ Ultra™ 7 258V 및 Intel® Core™ Ultra™ 7 265K에서 실행됩니다.

Intel® Core™ Ultra™ 7 258V

벤치마크

자세한 벤치마크 결과

| 모델 | 형식 | 정밀도 | 상태 | 크기(MB) | metrics/mAP50-95(B) | 추론 시간 (ms/im) |

|---|---|---|---|---|---|---|

| YOLO11n | PyTorch | FP32 | ✅ | 5.4 | 0.5052 | 32.27 |

| YOLO11n | OpenVINO | FP32 | ✅ | 10.4 | 0.5068 | 11.84 |

| YOLO11n | OpenVINO | INT8 | ✅ | 3.3 | 0.4969 | 11.24 |

| YOLO11s | PyTorch | FP32 | ✅ | 18.4 | 0.5776 | 92.09 |

| YOLO11s | OpenVINO | FP32 | ✅ | 36.4 | 0.5797 | 14.82 |

| YOLO11s | OpenVINO | INT8 | ✅ | 9.8 | 0.5751 | 12.88 |

| YOLO11m | PyTorch | FP32 | ✅ | 38.8 | 0.6262 | 277.24 |

| YOLO11m | OpenVINO | FP32 | ✅ | 77.1 | 0.6306 | 22.94 |

| YOLO11m | OpenVINO | INT8 | ✅ | 20.2 | 0.6126 | 17.85 |

| YOLO11l | PyTorch | FP32 | ✅ | 49.0 | 0.6361 | 348.97 |

| YOLO11l | OpenVINO | FP32 | ✅ | 97.3 | 0.6365 | 27.34 |

| YOLO11l | OpenVINO | INT8 | ✅ | 25.7 | 0.6242 | 20.83 |

| YOLO11x | PyTorch | FP32 | ✅ | 109.3 | 0.6984 | 666.07 |

| YOLO11x | OpenVINO | FP32 | ✅ | 217.8 | 0.6890 | 39.09 |

| YOLO11x | OpenVINO | INT8 | ✅ | 55.9 | 0.6856 | 30.60 |

자세한 벤치마크 결과

| 모델 | 형식 | 정밀도 | 상태 | 크기(MB) | metrics/mAP50-95(B) | 추론 시간 (ms/im) |

|---|---|---|---|---|---|---|

| YOLO11n | PyTorch | FP32 | ✅ | 5.4 | 0.5052 | 32.27 |

| YOLO11n | OpenVINO | FP32 | ✅ | 10.4 | 0.5077 | 32.55 |

| YOLO11n | OpenVINO | INT8 | ✅ | 3.3 | 0.4980 | 22.98 |

| YOLO11s | PyTorch | FP32 | ✅ | 18.4 | 0.5776 | 92.09 |

| YOLO11s | OpenVINO | FP32 | ✅ | 36.4 | 0.5782 | 98.38 |

| YOLO11s | OpenVINO | INT8 | ✅ | 9.8 | 0.5745 | 52.84 |

| YOLO11m | PyTorch | FP32 | ✅ | 38.8 | 0.6262 | 277.24 |

| YOLO11m | OpenVINO | FP32 | ✅ | 77.1 | 0.6307 | 275.74 |

| YOLO11m | OpenVINO | INT8 | ✅ | 20.2 | 0.6172 | 132.63 |

| YOLO11l | PyTorch | FP32 | ✅ | 49.0 | 0.6361 | 348.97 |

| YOLO11l | OpenVINO | FP32 | ✅ | 97.3 | 0.6361 | 348.97 |

| YOLO11l | OpenVINO | INT8 | ✅ | 25.7 | 0.6240 | 171.36 |

| YOLO11x | PyTorch | FP32 | ✅ | 109.3 | 0.6984 | 666.07 |

| YOLO11x | OpenVINO | FP32 | ✅ | 217.8 | 0.6900 | 783.16 |

| YOLO11x | OpenVINO | INT8 | ✅ | 55.9 | 0.6890 | 346.82 |

자세한 벤치마크 결과

| 모델 | 형식 | 정밀도 | 상태 | 크기(MB) | metrics/mAP50-95(B) | 추론 시간 (ms/im) |

|---|---|---|---|---|---|---|

| YOLO11n | PyTorch | FP32 | ✅ | 5.4 | 0.5052 | 32.27 |

| YOLO11n | OpenVINO | FP32 | ✅ | 10.4 | 0.5085 | 8.33 |

| YOLO11n | OpenVINO | INT8 | ✅ | 3.3 | 0.5019 | 8.91 |

| YOLO11s | PyTorch | FP32 | ✅ | 18.4 | 0.5776 | 92.09 |

| YOLO11s | OpenVINO | FP32 | ✅ | 36.4 | 0.5788 | 9.72 |

| YOLO11s | OpenVINO | INT8 | ✅ | 9.8 | 0.5710 | 10.58 |

| YOLO11m | PyTorch | FP32 | ✅ | 38.8 | 0.6262 | 277.24 |

| YOLO11m | OpenVINO | FP32 | ✅ | 77.1 | 0.6301 | 19.41 |

| YOLO11m | OpenVINO | INT8 | ✅ | 20.2 | 0.6124 | 18.26 |

| YOLO11l | PyTorch | FP32 | ✅ | 49.0 | 0.6361 | 348.97 |

| YOLO11l | OpenVINO | FP32 | ✅ | 97.3 | 0.6362 | 23.70 |

| YOLO11l | OpenVINO | INT8 | ✅ | 25.7 | 0.6240 | 21.40 |

| YOLO11x | PyTorch | FP32 | ✅ | 109.3 | 0.6984 | 666.07 |

| YOLO11x | OpenVINO | FP32 | ✅ | 217.8 | 0.6892 | 43.91 |

| YOLO11x | OpenVINO | INT8 | ✅ | 55.9 | 0.6890 | 34.04 |

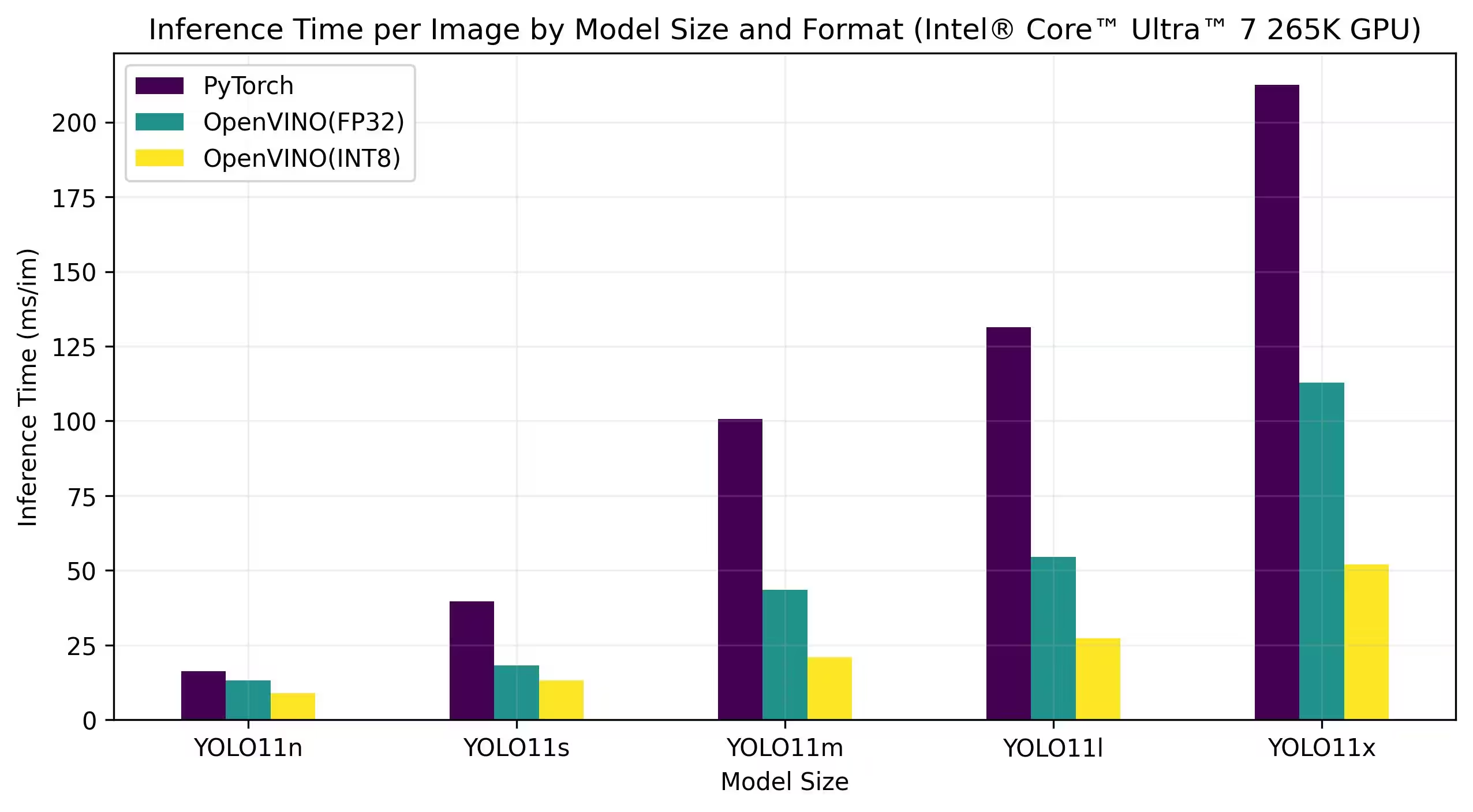

Intel® Core™ Ultra™ 7 265K

벤치마크

자세한 벤치마크 결과

| 모델 | 형식 | 정밀도 | 상태 | 크기(MB) | metrics/mAP50-95(B) | 추론 시간 (ms/im) |

|---|---|---|---|---|---|---|

| YOLO11n | PyTorch | FP32 | ✅ | 5.4 | 0.5072 | 16.29 |

| YOLO11n | OpenVINO | FP32 | ✅ | 10.4 | 0.5079 | 13.13 |

| YOLO11n | OpenVINO | INT8 | ✅ | 3.3 | 0.4976 | 8.86 |

| YOLO11s | PyTorch | FP32 | ✅ | 18.4 | 0.5771 | 39.61 |

| YOLO11s | OpenVINO | FP32 | ✅ | 36.4 | 0.5808 | 18.26 |

| YOLO11s | OpenVINO | INT8 | ✅ | 9.8 | 0.5726 | 13.24 |

| YOLO11m | PyTorch | FP32 | ✅ | 38.8 | 0.6258 | 100.65 |

| YOLO11m | OpenVINO | FP32 | ✅ | 77.1 | 0.6310 | 43.50 |

| YOLO11m | OpenVINO | INT8 | ✅ | 20.2 | 0.6137 | 20.90 |

| YOLO11l | PyTorch | FP32 | ✅ | 49.0 | 0.6367 | 131.37 |

| YOLO11l | OpenVINO | FP32 | ✅ | 97.3 | 0.6371 | 54.52 |

| YOLO11l | OpenVINO | INT8 | ✅ | 25.7 | 0.6226 | 27.36 |

| YOLO11x | PyTorch | FP32 | ✅ | 109.3 | 0.6990 | 212.45 |

| YOLO11x | OpenVINO | FP32 | ✅ | 217.8 | 0.6884 | 112.76 |

| YOLO11x | OpenVINO | INT8 | ✅ | 55.9 | 0.6900 | 52.06 |

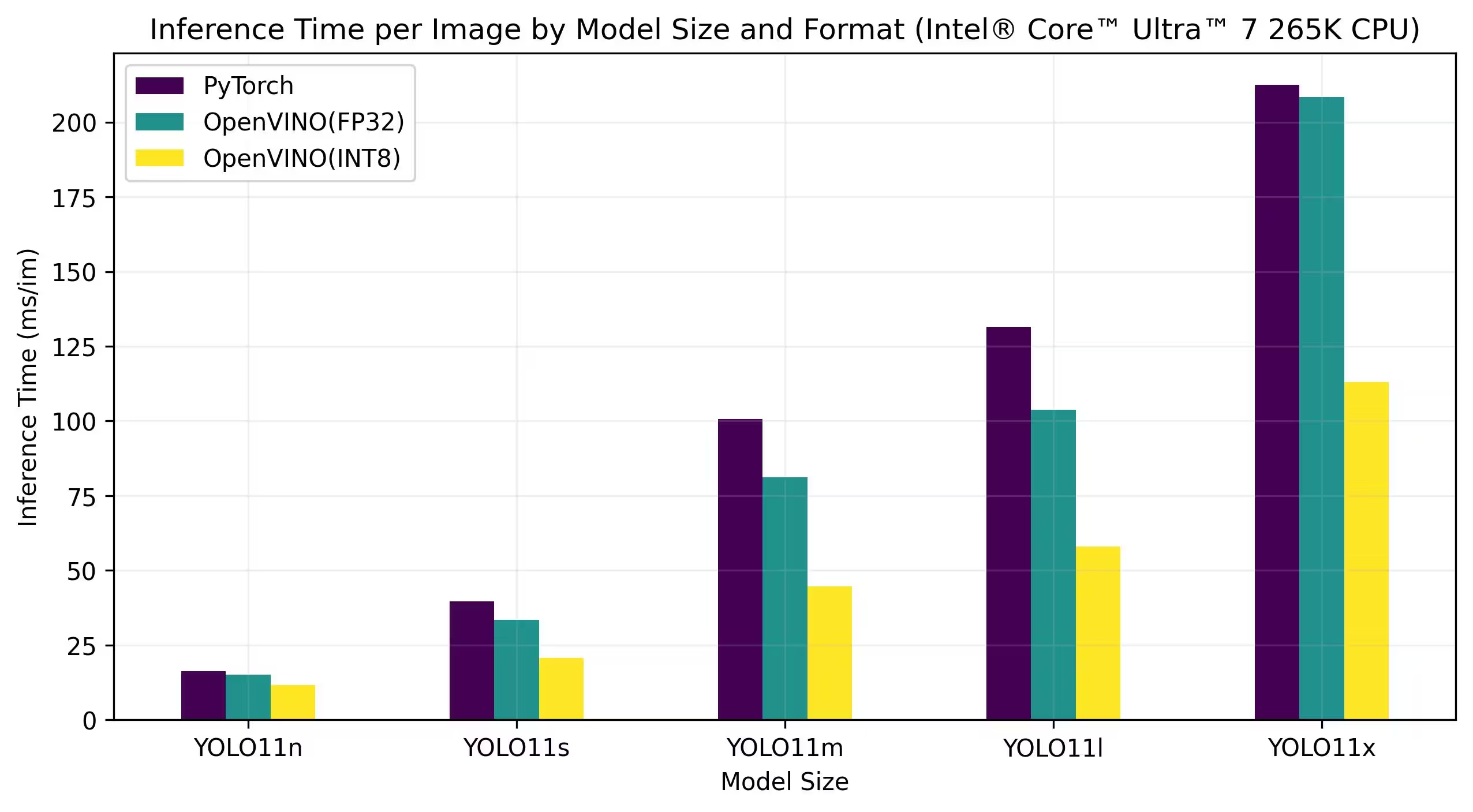

자세한 벤치마크 결과

| 모델 | 형식 | 정밀도 | 상태 | 크기(MB) | metrics/mAP50-95(B) | 추론 시간 (ms/im) |

|---|---|---|---|---|---|---|

| YOLO11n | PyTorch | FP32 | ✅ | 5.4 | 0.5072 | 16.29 |

| YOLO11n | OpenVINO | FP32 | ✅ | 10.4 | 0.5077 | 15.04 |

| YOLO11n | OpenVINO | INT8 | ✅ | 3.3 | 0.4980 | 11.60 |

| YOLO11s | PyTorch | FP32 | ✅ | 18.4 | 0.5771 | 39.61 |

| YOLO11s | OpenVINO | FP32 | ✅ | 36.4 | 0.5782 | 33.45 |

| YOLO11s | OpenVINO | INT8 | ✅ | 9.8 | 0.5745 | 20.64 |

| YOLO11m | PyTorch | FP32 | ✅ | 38.8 | 0.6258 | 100.65 |

| YOLO11m | OpenVINO | FP32 | ✅ | 77.1 | 0.6307 | 81.15 |

| YOLO11m | OpenVINO | INT8 | ✅ | 20.2 | 0.6172 | 44.63 |

| YOLO11l | PyTorch | FP32 | ✅ | 49.0 | 0.6367 | 131.37 |

| YOLO11l | OpenVINO | FP32 | ✅ | 97.3 | 0.6409 | 103.77 |

| YOLO11l | OpenVINO | INT8 | ✅ | 25.7 | 0.6240 | 58.00 |

| YOLO11x | PyTorch | FP32 | ✅ | 109.3 | 0.6990 | 212.45 |

| YOLO11x | OpenVINO | FP32 | ✅ | 217.8 | 0.6900 | 208.37 |

| YOLO11x | OpenVINO | INT8 | ✅ | 55.9 | 0.6897 | 113.04 |

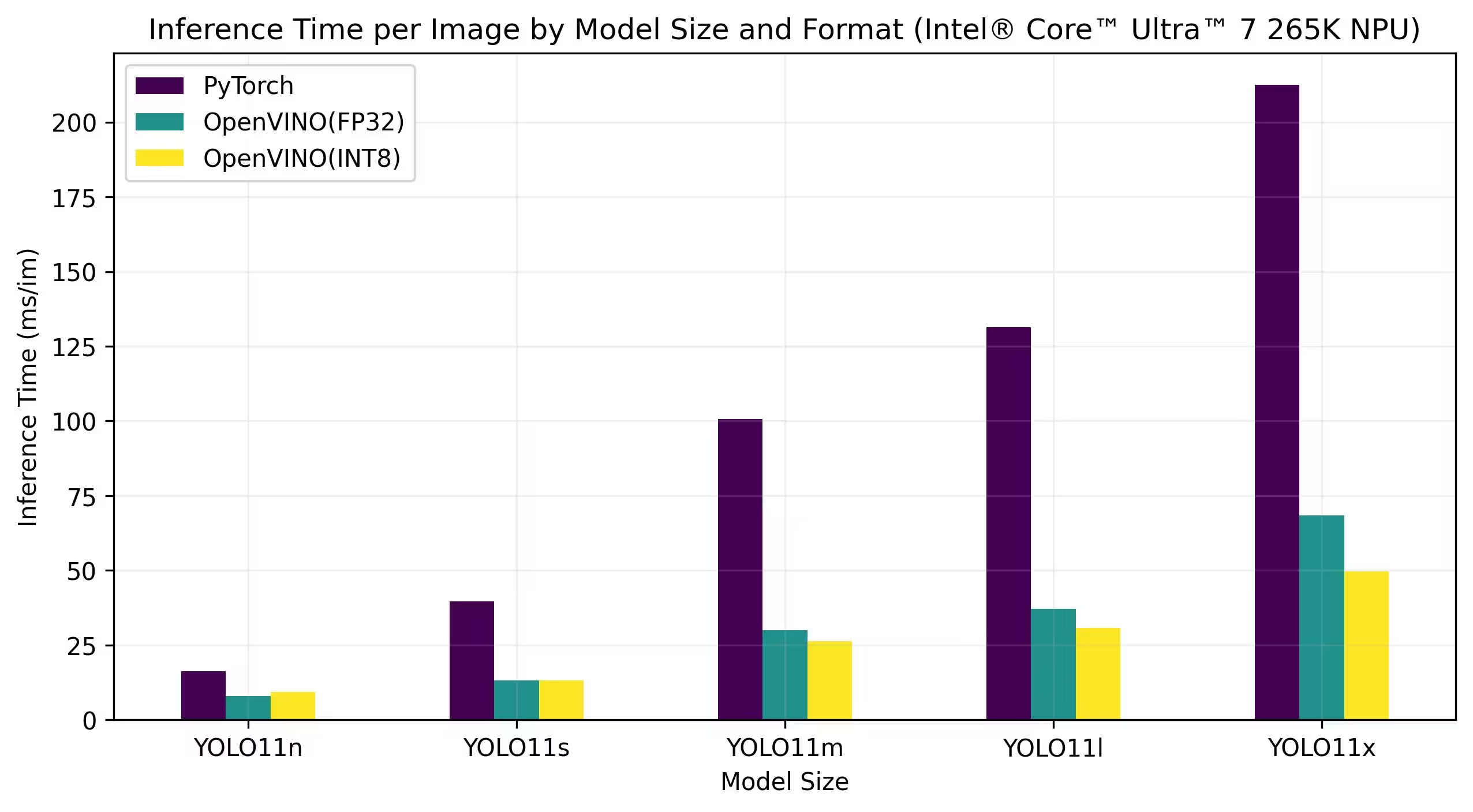

자세한 벤치마크 결과

| 모델 | 형식 | 정밀도 | 상태 | 크기(MB) | metrics/mAP50-95(B) | 추론 시간 (ms/im) |

|---|---|---|---|---|---|---|

| YOLO11n | PyTorch | FP32 | ✅ | 5.4 | 0.5072 | 16.29 |

| YOLO11n | OpenVINO | FP32 | ✅ | 10.4 | 0.5075 | 8.02 |

| YOLO11n | OpenVINO | INT8 | ✅ | 3.3 | 0.3656 | 9.28 |

| YOLO11s | PyTorch | FP32 | ✅ | 18.4 | 0.5771 | 39.61 |

| YOLO11s | OpenVINO | FP32 | ✅ | 36.4 | 0.5801 | 13.12 |

| YOLO11s | OpenVINO | INT8 | ✅ | 9.8 | 0.5686 | 13.12 |

| YOLO11m | PyTorch | FP32 | ✅ | 38.8 | 0.6258 | 100.65 |

| YOLO11m | OpenVINO | FP32 | ✅ | 77.1 | 0.6310 | 29.88 |

| YOLO11m | OpenVINO | INT8 | ✅ | 20.2 | 0.6111 | 26.32 |

| YOLO11l | PyTorch | FP32 | ✅ | 49.0 | 0.6367 | 131.37 |

| YOLO11l | OpenVINO | FP32 | ✅ | 97.3 | 0.6356 | 37.08 |

| YOLO11l | OpenVINO | INT8 | ✅ | 25.7 | 0.6245 | 30.81 |

| YOLO11x | PyTorch | FP32 | ✅ | 109.3 | 0.6990 | 212.45 |

| YOLO11x | OpenVINO | FP32 | ✅ | 217.8 | 0.6894 | 68.48 |

| YOLO11x | OpenVINO | INT8 | ✅ | 55.9 | 0.6417 | 49.76 |

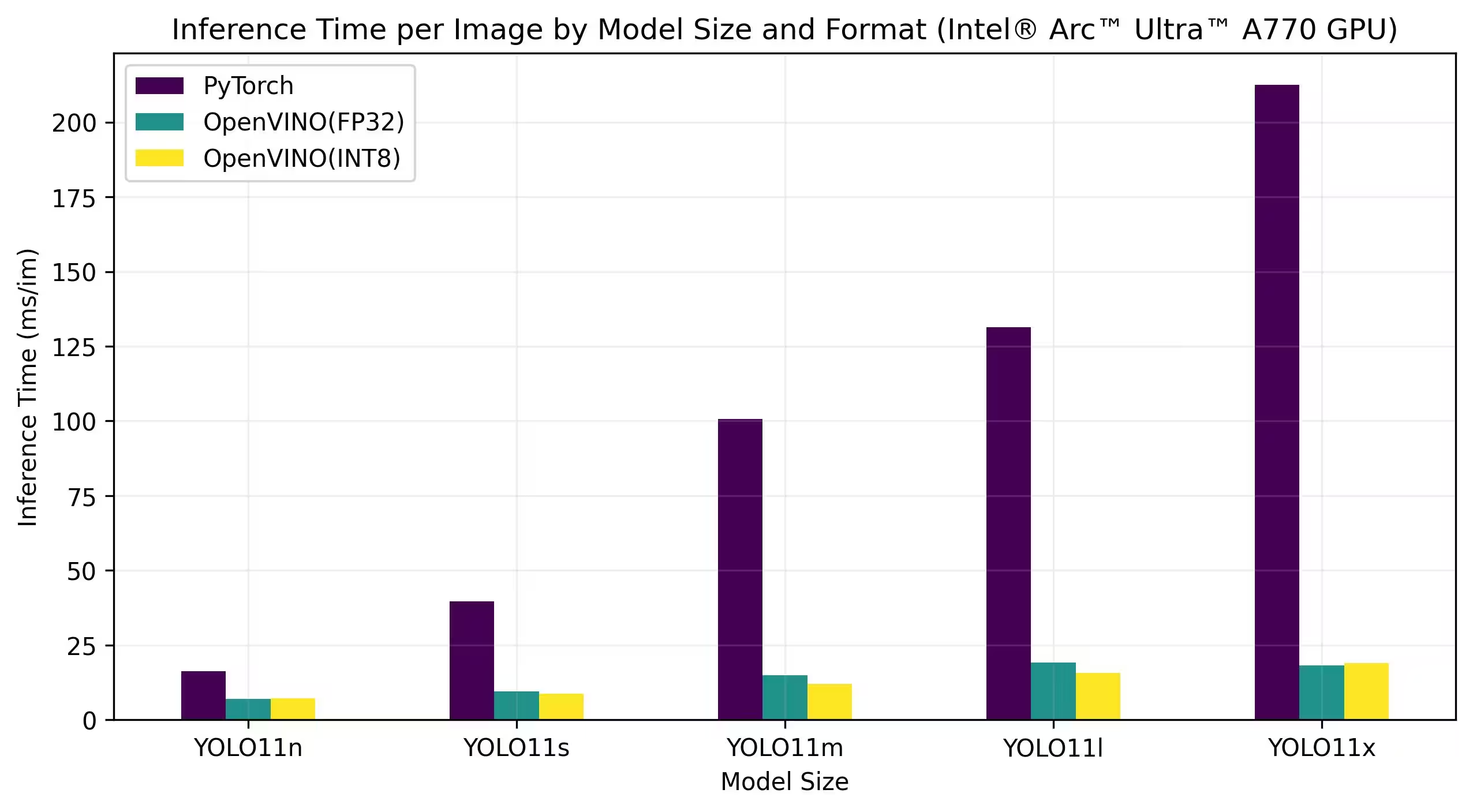

Intel® Arc GPU

Intel® Arc™은 고성능 게이밍, 콘텐츠 제작 및 AI 워크로드를 위해 설계된 Intel의 외장 그래픽 카드 제품군입니다. Arc 시리즈는 실시간 레이 트레이싱, AI 기반 그래픽 및 고해상도 게이밍을 지원하는 고급 GPU 아키텍처를 특징으로 합니다. 성능과 효율성에 중점을 둔 Intel® Arc™은 하드웨어 가속 AV1 인코딩 및 최신 그래픽 API 지원과 같은 고유한 기능을 제공하면서 다른 주요 GPU 브랜드와 경쟁하는 것을 목표로 합니다.

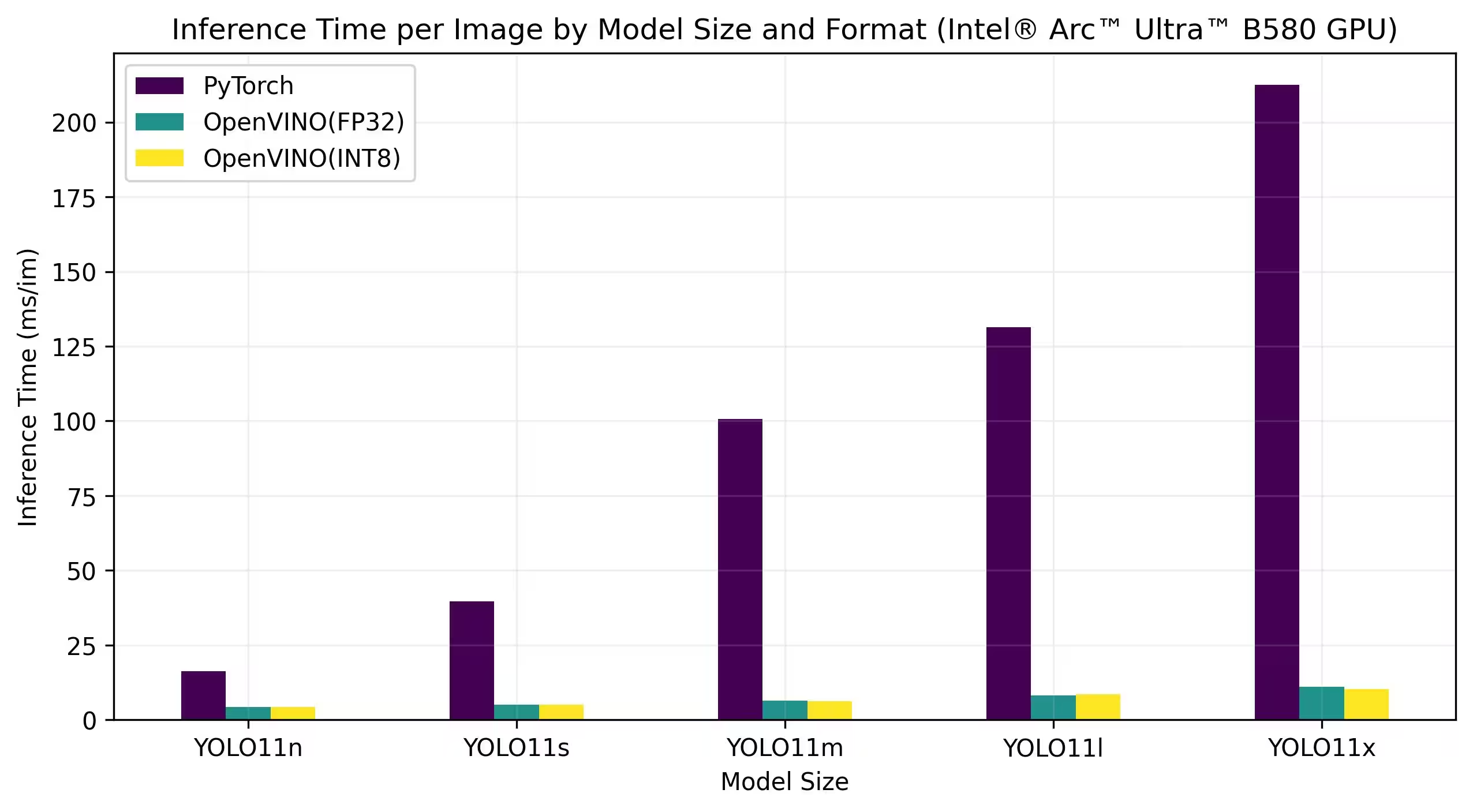

아래 벤치마크는 FP32 및 INT8 정밀도로 Intel Arc A770 및 Intel Arc B580에서 실행됩니다.

Intel Arc A770

자세한 벤치마크 결과

| 모델 | 형식 | 정밀도 | 상태 | 크기(MB) | metrics/mAP50-95(B) | 추론 시간 (ms/im) |

|---|---|---|---|---|---|---|

| YOLO11n | PyTorch | FP32 | ✅ | 5.4 | 0.5072 | 16.29 |

| YOLO11n | OpenVINO | FP32 | ✅ | 10.4 | 0.5073 | 6.98 |

| YOLO11n | OpenVINO | INT8 | ✅ | 3.3 | 0.4978 | 7.24 |

| YOLO11s | PyTorch | FP32 | ✅ | 18.4 | 0.5771 | 39.61 |

| YOLO11s | OpenVINO | FP32 | ✅ | 36.4 | 0.5798 | 9.41 |

| YOLO11s | OpenVINO | INT8 | ✅ | 9.8 | 0.5751 | 8.72 |

| YOLO11m | PyTorch | FP32 | ✅ | 38.8 | 0.6258 | 100.65 |

| YOLO11m | OpenVINO | FP32 | ✅ | 77.1 | 0.6311 | 14.88 |

| YOLO11m | OpenVINO | INT8 | ✅ | 20.2 | 0.6126 | 11.97 |

| YOLO11l | PyTorch | FP32 | ✅ | 49.0 | 0.6367 | 131.37 |

| YOLO11l | OpenVINO | FP32 | ✅ | 97.3 | 0.6364 | 19.17 |

| YOLO11l | OpenVINO | INT8 | ✅ | 25.7 | 0.6241 | 15.75 |

| YOLO11x | PyTorch | FP32 | ✅ | 109.3 | 0.6990 | 212.45 |

| YOLO11x | OpenVINO | FP32 | ✅ | 217.8 | 0.6888 | 18.13 |

| YOLO11x | OpenVINO | INT8 | ✅ | 55.9 | 0.6930 | 18.91 |

Intel Arc B580

자세한 벤치마크 결과

| 모델 | 형식 | 정밀도 | 상태 | 크기(MB) | metrics/mAP50-95(B) | 추론 시간 (ms/im) |

|---|---|---|---|---|---|---|

| YOLO11n | PyTorch | FP32 | ✅ | 5.4 | 0.5072 | 16.29 |

| YOLO11n | OpenVINO | FP32 | ✅ | 10.4 | 0.5072 | 4.27 |

| YOLO11n | OpenVINO | INT8 | ✅ | 3.3 | 0.4981 | 4.33 |

| YOLO11s | PyTorch | FP32 | ✅ | 18.4 | 0.5771 | 39.61 |

| YOLO11s | OpenVINO | FP32 | ✅ | 36.4 | 0.5789 | 5.04 |

| YOLO11s | OpenVINO | INT8 | ✅ | 9.8 | 0.5746 | 4.97 |

| YOLO11m | PyTorch | FP32 | ✅ | 38.8 | 0.6258 | 100.65 |

| YOLO11m | OpenVINO | FP32 | ✅ | 77.1 | 0.6306 | 6.45 |

| YOLO11m | OpenVINO | INT8 | ✅ | 20.2 | 0.6125 | 6.28 |

| YOLO11l | PyTorch | FP32 | ✅ | 49.0 | 0.6367 | 131.37 |

| YOLO11l | OpenVINO | FP32 | ✅ | 97.3 | 0.6360 | 8.23 |

| YOLO11l | OpenVINO | INT8 | ✅ | 25.7 | 0.6236 | 8.49 |

| YOLO11x | PyTorch | FP32 | ✅ | 109.3 | 0.6990 | 212.45 |

| YOLO11x | OpenVINO | FP32 | ✅ | 217.8 | 0.6889 | 11.10 |

| YOLO11x | OpenVINO | INT8 | ✅ | 55.9 | 0.6924 | 10.30 |

결과 재현하기

위의 Ultralytics 벤치마크를 모든 내보내기 형식에서 재현하려면 다음 코드를 실행하세요.

예시

from ultralytics import YOLO

# Load a YOLO11n PyTorch model

model = YOLO("yolo11n.pt")

# Benchmark YOLO11n speed and accuracy on the COCO128 dataset for all export formats

results = model.benchmark(data="coco128.yaml")

# Benchmark YOLO11n speed and accuracy on the COCO128 dataset for all export formats

yolo benchmark model=yolo11n.pt data=coco128.yaml

벤치마킹 결과는 시스템의 정확한 하드웨어 및 소프트웨어 구성과 벤치마크가 실행될 당시 시스템의 현재 워크로드에 따라 다를 수 있습니다. 가장 신뢰할 수 있는 결과를 얻으려면 많은 수의 이미지가 포함된 데이터 세트를 사용하십시오. 예: data='coco.yaml' (5000개의 검증 이미지).

결론

벤치마킹 결과는 YOLO11 모델을 OpenVINO 형식으로 내보낼 때의 이점을 명확하게 보여줍니다. 다양한 모델 및 하드웨어 플랫폼에서 OpenVINO 형식은 일관되게 유사한 정확도를 유지하면서 추론 속도 측면에서 다른 형식보다 뛰어난 성능을 보입니다.

벤치마크는 딥러닝 모델 배포 도구로서 OpenVINO의 효율성을 강조합니다. 모델을 OpenVINO 포맷으로 변환함으로써 개발자는 상당한 성능 향상을 달성하여 실제 애플리케이션에서 이러한 모델을 더 쉽게 배포할 수 있습니다.

OpenVINO 사용에 대한 자세한 정보 및 지침은 공식 OpenVINO 문서를 참조하십시오.

FAQ

YOLO26 모델을 OpenVINO 형식으로 어떻게 내보내나요?

YOLO26 모델을 OpenVINO 형식으로 내보내면 Intel 하드웨어에서 CPU 속도를 크게 향상시키고 GPU 및 NPU 가속을 활성화할 수 있습니다. 내보내려면 아래와 같이 Python 또는 CLI를 사용할 수 있습니다.

예시

from ultralytics import YOLO

# Load a YOLO26n PyTorch model

model = YOLO("yolo26n.pt")

# Export the model

model.export(format="openvino") # creates 'yolo26n_openvino_model/'

# Export a YOLO26n PyTorch model to OpenVINO format

yolo export model=yolo26n.pt format=openvino # creates 'yolo26n_openvino_model/'

자세한 내용은 내보내기 형식 문서를 참조하십시오.

YOLO26 모델과 OpenVINO를 함께 사용하면 어떤 이점이 있나요?

Intel의 OpenVINO 툴킷을 YOLO26 모델과 함께 사용하면 여러 가지 이점이 있습니다.

- 성능: CPU 추론에서 최대 3배의 속도 향상을 달성하고 Intel GPU 및 NPU를 활용하여 가속화합니다.

- 모델 최적화 도구: PyTorch, TensorFlow 및 ONNX와 같은 널리 사용되는 프레임워크의 모델을 변환, 최적화 및 실행합니다.

- 사용 편의성: YOLO26용을 포함하여 사용자가 시작하는 데 도움이 되는 80개 이상의 튜토리얼 노트북이 제공됩니다.

- 이종 실행: 통합 API를 통해 다양한 Intel 하드웨어에 모델을 배포합니다.

자세한 성능 비교는 벤치마크 섹션을 참조하십시오.

OpenVINO로 내보낸 YOLO26 모델을 사용하여 추론을 어떻게 실행할 수 있나요?

YOLO26n 모델을 OpenVINO 형식으로 내보낸 후 Python 또는 CLI를 사용하여 추론을 실행할 수 있습니다.

예시

from ultralytics import YOLO

# Load the exported OpenVINO model

ov_model = YOLO("yolo26n_openvino_model/")

# Run inference

results = ov_model("https://ultralytics.com/images/bus.jpg")

# Run inference with the exported model

yolo predict model=yolo26n_openvino_model source='https://ultralytics.com/images/bus.jpg'

자세한 내용은 예측 모드 문서를 참조하십시오.

OpenVINO 내보내기를 위해 다른 모델보다 Ultralytics YOLO26을 선택해야 하는 이유는 무엇인가요?

Ultralytics YOLO26은 높은 정확도와 속도로 실시간 객체 detect에 최적화되어 있습니다. 특히 OpenVINO와 결합하면 YOLO26은 다음과 같은 이점을 제공합니다.

- Intel CPU에서 최대 3배 속도 향상

- Intel GPU 및 NPU에 원활한 배포

- 다양한 내보내기 형식에서 일관되고 비교 가능한 정확도

자세한 성능 분석은 다양한 하드웨어에서 자세한 YOLO11 벤치마크를 확인하십시오.

PyTorch, ONNX, OpenVINO 등 다양한 형식으로 YOLO26 모델을 벤치마킹할 수 있나요?

예, PyTorch, TorchScript, ONNX, OpenVINO 등 다양한 형식의 YOLO26 모델을 벤치마킹할 수 있습니다. 선택한 데이터셋에서 벤치마크를 실행하려면 다음 코드 스니펫을 사용하세요:

예시

from ultralytics import YOLO

# Load a YOLO26n PyTorch model

model = YOLO("yolo26n.pt")

# Benchmark YOLO26n speed and [accuracy](https://www.ultralytics.com/glossary/accuracy) on the COCO8 dataset for all export formats

results = model.benchmark(data="coco8.yaml")

# Benchmark YOLO26n speed and accuracy on the COCO8 dataset for all export formats

yolo benchmark model=yolo26n.pt data=coco8.yaml

자세한 벤치마크 결과는 벤치마크 섹션 및 내보내기 형식 문서를 참조하십시오.