Exportação Intel OpenVINO

Neste guia, abordamos a exportação de modelos YOLO26 para o formato OpenVINO, que pode proporcionar até 3x de aceleração da CPU, bem como acelerar a inferência YOLO em hardware Intel GPU e NPU.

OpenVINO, abreviação de Open Visual Inference & Neural Network Optimization toolkit, é um kit de ferramentas abrangente para otimizar e implementar modelos de inferência de IA. Embora o nome contenha Visual, o OpenVINO também oferece suporte a várias tarefas adicionais, incluindo linguagem, áudio, séries temporais, etc.

Assista: Como Exportar Ultralytics YOLO26 para o Formato Intel OpenVINO para Inferência Mais Rápida 🚀

Exemplos de uso

Exporte um modelo YOLO26n para o formato OpenVINO e execute inferência com o modelo exportado.

Exemplo

from ultralytics import YOLO

# Load a YOLO26n PyTorch model

model = YOLO("yolo26n.pt")

# Export the model

model.export(format="openvino") # creates 'yolo26n_openvino_model/'

# Load the exported OpenVINO model

ov_model = YOLO("yolo26n_openvino_model/")

# Run inference

results = ov_model("https://ultralytics.com/images/bus.jpg")

# Run inference with specified device, available devices: ["intel:gpu", "intel:npu", "intel:cpu"]

results = ov_model("https://ultralytics.com/images/bus.jpg", device="intel:gpu")

# Export a YOLO26n PyTorch model to OpenVINO format

yolo export model=yolo26n.pt format=openvino # creates 'yolo26n_openvino_model/'

# Run inference with the exported model

yolo predict model=yolo26n_openvino_model source='https://ultralytics.com/images/bus.jpg'

# Run inference with specified device, available devices: ["intel:gpu", "intel:npu", "intel:cpu"]

yolo predict model=yolo26n_openvino_model source='https://ultralytics.com/images/bus.jpg' device="intel:gpu"

Argumentos de Exportação

| Argumento | Tipo | Padrão | Descrição |

|---|---|---|---|

format | str | 'openvino' | Formato de destino para o modelo exportado, definindo a compatibilidade com vários ambientes de implementação. |

imgsz | int ou tuple | 640 | Tamanho de imagem desejado para a entrada do modelo. Pode ser um inteiro para imagens quadradas ou uma tupla (height, width) para dimensões específicas. |

half | bool | False | Ativa a quantização FP16 (meia precisão), reduzindo o tamanho do modelo e potencialmente acelerando a inferência em hardware suportado. |

int8 | bool | False | Ativa a quantização INT8, comprimindo ainda mais o modelo e acelerando a inferência com perda mínima de precisão, principalmente para dispositivos de borda. |

dynamic | bool | False | Permite tamanhos de entrada dinâmicos, aumentando a flexibilidade no manuseio de diferentes dimensões de imagem. |

nms | bool | False | Adiciona Supressão Não Máxima (NMS), essencial para um pós-processamento de detecção preciso e eficiente. |

batch | int | 1 | Especifica o tamanho do lote de inferência do modelo de exportação ou o número máximo de imagens que o modelo exportado processará simultaneamente em predict modo. |

data | str | 'coco8.yaml' | Caminho para o conjunto de dados arquivo de configuração (padrão: coco8.yaml), essencial para a quantização. |

fraction | float | 1.0 | Especifica a fração do conjunto de dados a ser usada para a calibração da quantização INT8. Permite calibrar em um subconjunto do conjunto de dados completo, útil para experimentos ou quando os recursos são limitados. Se não for especificado com INT8 habilitado, o conjunto de dados completo será usado. |

Para mais detalhes sobre o processo de exportação, visite a página de documentação da Ultralytics sobre exportação.

Aviso

OpenVINO™ é compatível com a maioria dos processadores Intel®, mas para garantir um desempenho ideal:

Verifique o suporte do OpenVINO™. Verifique se o seu chip Intel® é oficialmente suportado pelo OpenVINO™ usando a lista de compatibilidade da Intel.

Identifique seu acelerador. Determine se o seu processador inclui uma NPU (Unidade de Processamento Neural) ou GPU (GPU integrada) consultando o guia de hardware da Intel.

Instale os drivers mais recentes. Se o seu chip suportar uma NPU ou GPU, mas o OpenVINO™ não a estiver a detetar, pode ser necessário instalar ou atualizar os drivers associados. Siga as instruções de instalação do driver para ativar a aceleração total.

Ao seguir estas três etapas, você pode garantir que o OpenVINO™ seja executado de forma otimizada em seu hardware Intel®.

Benefícios do OpenVINO

- Desempenho: O OpenVINO oferece inferência de alto desempenho utilizando o poder das CPUs Intel, GPUs integradas e discretas e FPGAs.

- Suporte para Execução Heterogênea: OpenVINO fornece uma API para escrever uma vez e implantar em qualquer hardware Intel suportado (CPU, GPU, FPGA, VPU, etc.).

- Otimizador de Modelo: O OpenVINO fornece um Otimizador de Modelo que importa, converte e otimiza modelos de frameworks populares de aprendizado profundo, como PyTorch, TensorFlow, TensorFlow Lite, Keras, ONNX, PaddlePaddle e Caffe.

- Facilidade de Uso: O toolkit vem com mais de 80 notebooks de tutoriais (incluindo otimização do YOLOv8) ensinando diferentes aspectos do toolkit.

Estrutura de Exportação OpenVINO

Ao exportar um modelo para o formato OpenVINO, o resultado é um diretório contendo o seguinte:

- Arquivo XML: Descreve a topologia da rede.

- Arquivo BIN: Contém os dados binários de pesos e biases.

- Arquivo de mapeamento: Contém o mapeamento dos tensores de saída do modelo original para os nomes dos tensores OpenVINO.

Você pode usar esses arquivos para executar a inferência com o OpenVINO Inference Engine.

Usando a Exportação OpenVINO na Implantação

Depois que seu modelo for exportado com sucesso para o formato OpenVINO, você terá duas opções principais para executar a inferência:

Use o comando

ultralyticspacote, que fornece uma API de alto nível e envolve o OpenVINO Runtime.Utilize o nativo

openvinopacote para um controlo mais avançado ou personalizado sobre o comportamento da inferência.

Inferência com Ultralytics

O pacote ultralytics permite que você execute facilmente a inferência usando o modelo OpenVINO exportado através do método predict. Você também pode especificar o dispositivo de destino (por exemplo, intel:gpu, intel:npu, intel:cpu) usando o argumento device.

from ultralytics import YOLO

# Load the exported OpenVINO model

ov_model = YOLO("yolo26n_openvino_model/") # the path of your exported OpenVINO model

# Run inference with the exported model

ov_model.predict(device="intel:gpu") # specify the device you want to run inference on

Esta abordagem é ideal para prototipagem rápida ou implantação quando você não precisa de controle total sobre o pipeline de inferência.

Inferência com OpenVINO Runtime

O OpenVINO Runtime oferece uma API unificada para inferência em todo o hardware Intel suportado. Ele também fornece recursos avançados, como balanceamento de carga em hardware Intel e execução assíncrona. Para mais informações sobre a execução de inferência, consulte os notebooks YOLO26.

Lembre-se de que você precisará dos arquivos XML e BIN, bem como de quaisquer configurações específicas do aplicativo, como tamanho da entrada, fator de escala para normalização, etc., para configurar e usar corretamente o modelo com o Runtime.

Na sua aplicação de implementação, você normalmente seguiria os seguintes passos:

- Inicialize o OpenVINO criando

core = Core(). - Carregue o modelo usando o

core.read_model()método. - Compile o modelo usando o

core.compile_model()função. - Prepare a entrada (imagem, texto, áudio, etc.).

- Executar inferência usando

compiled_model(input_data).

Para obter passos e trechos de código mais detalhados, consulte a documentação do OpenVINO ou o tutorial da API.

Benchmarks OpenVINO YOLO11

A equipe Ultralytics fez um benchmark do YOLO11 em vários formatos de modelo e precisão, avaliando a velocidade e a exatidão em diferentes dispositivos Intel compatíveis com OpenVINO.

Nota

Os resultados de benchmarking abaixo são para referência e podem variar com base na configuração exata de hardware e software de um sistema, bem como na carga de trabalho atual do sistema no momento em que os benchmarks são executados.

Todos os benchmarks executados com openvino Versão do pacote Python 2025.1.0.

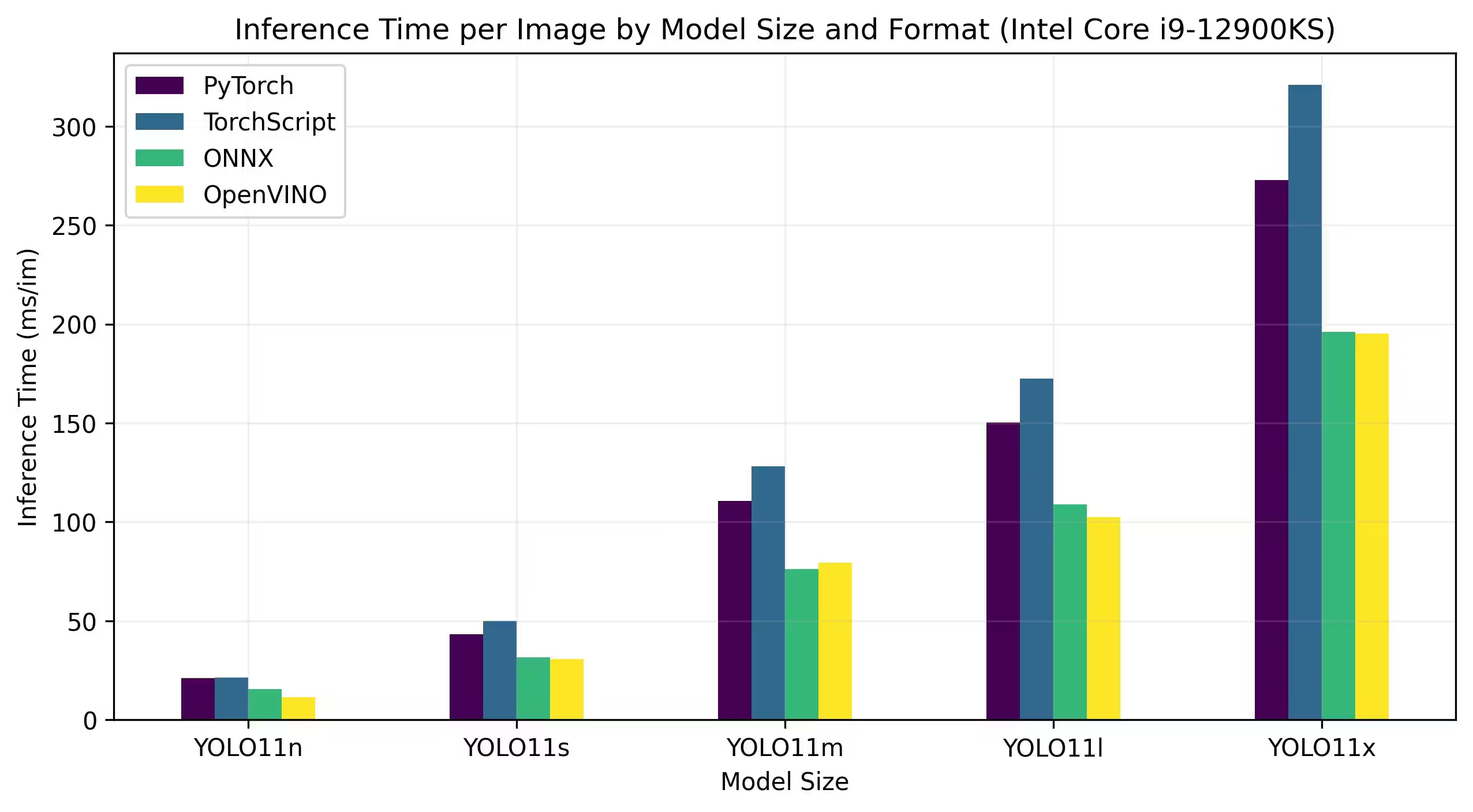

CPU Intel Core

A série Intel® Core® é uma gama de processadores de alto desempenho da Intel. A linha inclui Core i3 (nível de entrada), Core i5 (nível médio), Core i7 (nível superior) e Core i9 (desempenho extremo). Cada série atende a diferentes necessidades e orçamentos de computação, desde tarefas cotidianas até cargas de trabalho profissionais exigentes. A cada nova geração, são feitas melhorias no desempenho, eficiência energética e recursos.

Os benchmarks abaixo são executados numa CPU Intel® Core® i9-12900KS de 12ª geração com precisão FP32.

Resultados Detalhados de Benchmark

| Modelo | Formato | Status | Tamanho (MB) | metrics/mAP50-95(B) | Tempo de inferência (ms/im) |

|---|---|---|---|---|---|

| YOLO11n | PyTorch | ✅ | 5.4 | 0.5071 | 21.00 |

| YOLO11n | TorchScript | ✅ | 10.5 | 0.5077 | 21.39 |

| YOLO11n | ONNX | ✅ | 10.2 | 0.5077 | 15.55 |

| YOLO11n | OpenVINO | ✅ | 10.4 | 0.5077 | 11.49 |

| YOLO11s | PyTorch | ✅ | 18.4 | 0.5770 | 43.16 |

| YOLO11s | TorchScript | ✅ | 36.6 | 0.5781 | 50.06 |

| YOLO11s | ONNX | ✅ | 36.3 | 0.5781 | 31.53 |

| YOLO11s | OpenVINO | ✅ | 36.4 | 0.5781 | 30.82 |

| YOLO11m | PyTorch | ✅ | 38.8 | 0.6257 | 110.60 |

| YOLO11m | TorchScript | ✅ | 77.3 | 0.6306 | 128.09 |

| YOLO11m | ONNX | ✅ | 76.9 | 0.6306 | 76.06 |

| YOLO11m | OpenVINO | ✅ | 77.1 | 0.6306 | 79.38 |

| YOLO11l | PyTorch | ✅ | 49.0 | 0.6367 | 150.38 |

| YOLO11l | TorchScript | ✅ | 97.7 | 0.6408 | 172.57 |

| YOLO11l | ONNX | ✅ | 97.0 | 0.6408 | 108.91 |

| YOLO11l | OpenVINO | ✅ | 97.3 | 0.6408 | 102.30 |

| YOLO11x | PyTorch | ✅ | 109.3 | 0.6989 | 272.72 |

| YOLO11x | TorchScript | ✅ | 218.1 | 0.6900 | 320.86 |

| YOLO11x | ONNX | ✅ | 217.5 | 0.6900 | 196.20 |

| YOLO11x | OpenVINO | ✅ | 217.8 | 0.6900 | 195.32 |

Intel® Core™ Ultra

A série Intel® Core™ Ultra™ representa um novo marco na computação de alto desempenho, projetada para atender às demandas em evolução dos usuários modernos — de gamers e criadores a profissionais que aproveitam a IA. Esta linha de última geração é mais do que uma série de CPU tradicional; ela combina núcleos de CPU poderosos, recursos de GPU integrados de alto desempenho e uma Unidade de Processamento Neural (NPU) dedicada dentro de um único chip, oferecendo uma solução unificada para diversas e intensivas cargas de trabalho de computação.

No cerne da arquitetura Intel® Core Ultra™ está um design híbrido que permite um desempenho excecional em tarefas de processamento tradicionais, cargas de trabalho aceleradas por GPU e operações orientadas por IA. A inclusão da NPU melhora a inferência de IA no dispositivo, permitindo uma aprendizagem automática e um processamento de dados mais rápidos e eficientes numa vasta gama de aplicações.

A família Core Ultra™ inclui vários modelos adaptados para diferentes necessidades de desempenho, com opções que variam desde designs com baixo consumo de energia até variantes de alta potência marcadas pela designação "H" — ideal para laptops e formatos compactos que exigem grande poder de computação. Em toda a linha, os usuários se beneficiam da sinergia da integração de CPU, GPU e NPU, proporcionando eficiência, capacidade de resposta e recursos multitarefa notáveis.

Como parte da inovação contínua da Intel, a série Core Ultra™ estabelece um novo padrão para a computação preparada para o futuro. Com vários modelos disponíveis e mais no horizonte, esta série sublinha o compromisso da Intel em fornecer soluções de ponta para a próxima geração de dispositivos inteligentes e aprimorados por IA.

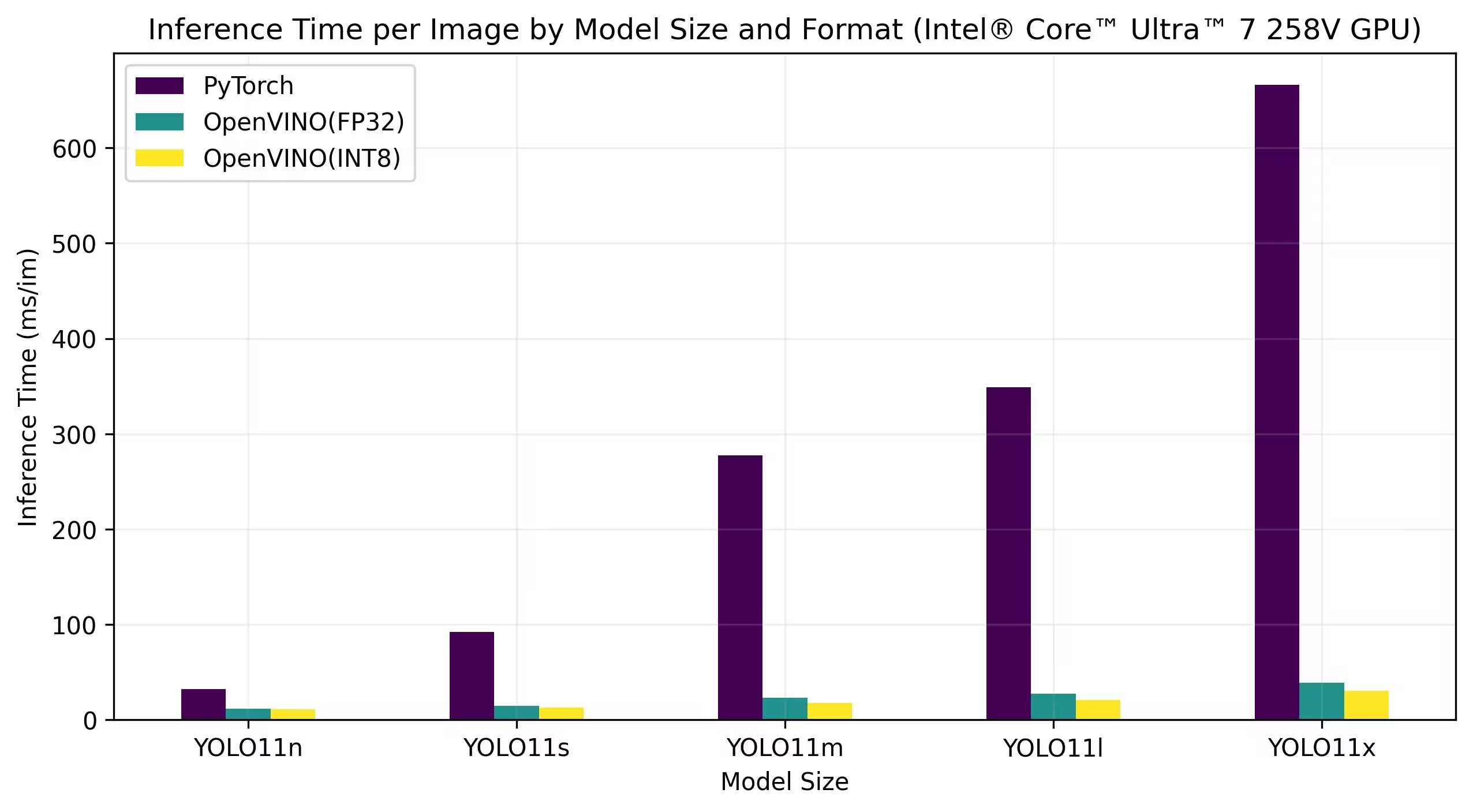

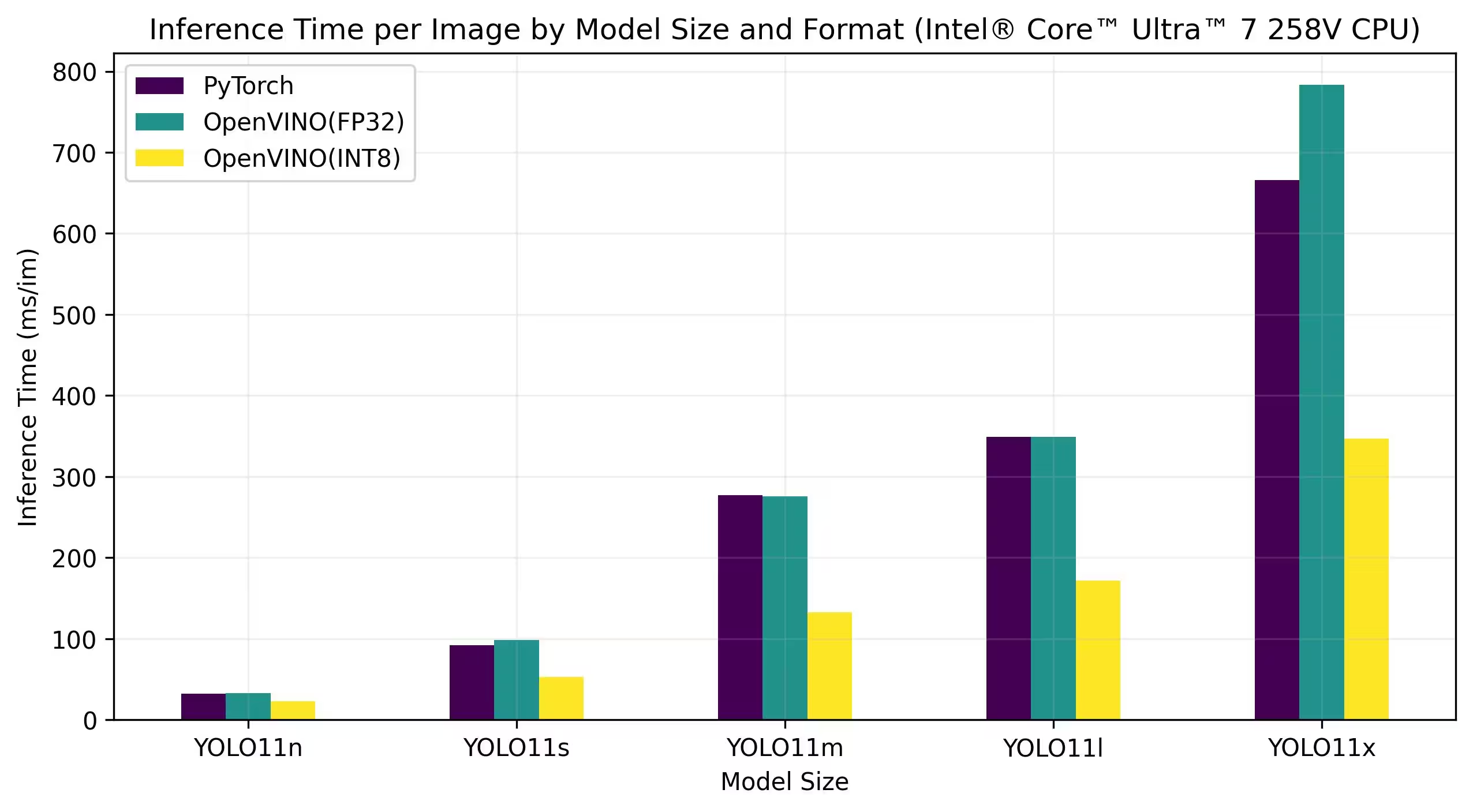

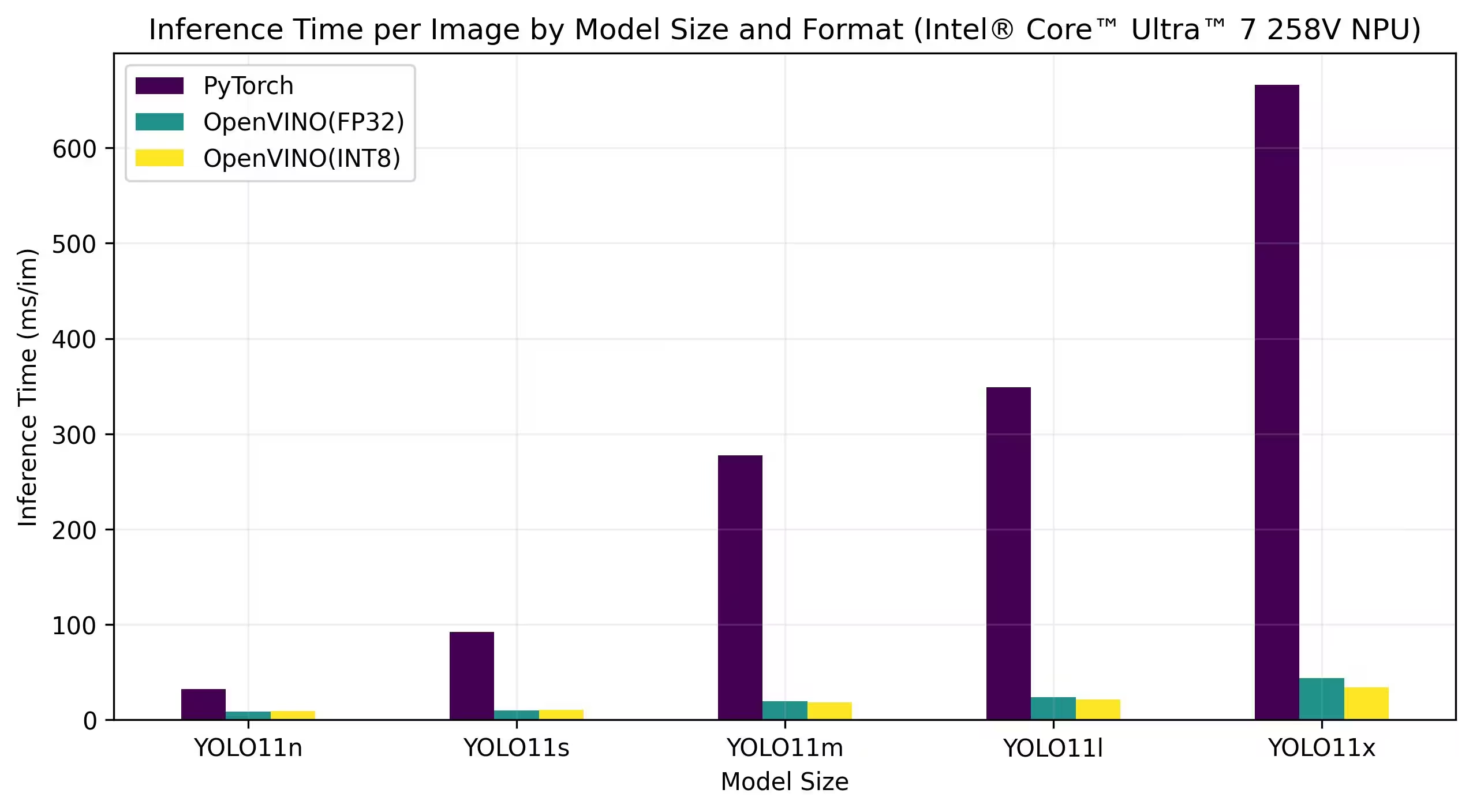

Os benchmarks abaixo são executados em Intel® Core™ Ultra™ 7 258V e Intel® Core™ Ultra™ 7 265K com precisão FP32 e INT8.

Intel® Core™ Ultra™ 7 258V

Benchmarks

Resultados Detalhados de Benchmark

| Modelo | Formato | Precisão | Status | Tamanho (MB) | metrics/mAP50-95(B) | Tempo de inferência (ms/im) |

|---|---|---|---|---|---|---|

| YOLO11n | PyTorch | FP32 | ✅ | 5.4 | 0.5052 | 32.27 |

| YOLO11n | OpenVINO | FP32 | ✅ | 10.4 | 0.5068 | 11.84 |

| YOLO11n | OpenVINO | INT8 | ✅ | 3.3 | 0.4969 | 11.24 |

| YOLO11s | PyTorch | FP32 | ✅ | 18.4 | 0.5776 | 92.09 |

| YOLO11s | OpenVINO | FP32 | ✅ | 36.4 | 0.5797 | 14.82 |

| YOLO11s | OpenVINO | INT8 | ✅ | 9.8 | 0.5751 | 12.88 |

| YOLO11m | PyTorch | FP32 | ✅ | 38.8 | 0.6262 | 277.24 |

| YOLO11m | OpenVINO | FP32 | ✅ | 77.1 | 0.6306 | 22.94 |

| YOLO11m | OpenVINO | INT8 | ✅ | 20.2 | 0.6126 | 17.85 |

| YOLO11l | PyTorch | FP32 | ✅ | 49.0 | 0.6361 | 348.97 |

| YOLO11l | OpenVINO | FP32 | ✅ | 97.3 | 0.6365 | 27.34 |

| YOLO11l | OpenVINO | INT8 | ✅ | 25.7 | 0.6242 | 20.83 |

| YOLO11x | PyTorch | FP32 | ✅ | 109.3 | 0.6984 | 666.07 |

| YOLO11x | OpenVINO | FP32 | ✅ | 217.8 | 0.6890 | 39.09 |

| YOLO11x | OpenVINO | INT8 | ✅ | 55.9 | 0.6856 | 30.60 |

Resultados Detalhados de Benchmark

| Modelo | Formato | Precisão | Status | Tamanho (MB) | metrics/mAP50-95(B) | Tempo de inferência (ms/im) |

|---|---|---|---|---|---|---|

| YOLO11n | PyTorch | FP32 | ✅ | 5.4 | 0.5052 | 32.27 |

| YOLO11n | OpenVINO | FP32 | ✅ | 10.4 | 0.5077 | 32.55 |

| YOLO11n | OpenVINO | INT8 | ✅ | 3.3 | 0.4980 | 22.98 |

| YOLO11s | PyTorch | FP32 | ✅ | 18.4 | 0.5776 | 92.09 |

| YOLO11s | OpenVINO | FP32 | ✅ | 36.4 | 0.5782 | 98.38 |

| YOLO11s | OpenVINO | INT8 | ✅ | 9.8 | 0.5745 | 52.84 |

| YOLO11m | PyTorch | FP32 | ✅ | 38.8 | 0.6262 | 277.24 |

| YOLO11m | OpenVINO | FP32 | ✅ | 77.1 | 0.6307 | 275.74 |

| YOLO11m | OpenVINO | INT8 | ✅ | 20.2 | 0.6172 | 132.63 |

| YOLO11l | PyTorch | FP32 | ✅ | 49.0 | 0.6361 | 348.97 |

| YOLO11l | OpenVINO | FP32 | ✅ | 97.3 | 0.6361 | 348.97 |

| YOLO11l | OpenVINO | INT8 | ✅ | 25.7 | 0.6240 | 171.36 |

| YOLO11x | PyTorch | FP32 | ✅ | 109.3 | 0.6984 | 666.07 |

| YOLO11x | OpenVINO | FP32 | ✅ | 217.8 | 0.6900 | 783.16 |

| YOLO11x | OpenVINO | INT8 | ✅ | 55.9 | 0.6890 | 346.82 |

Resultados Detalhados de Benchmark

| Modelo | Formato | Precisão | Status | Tamanho (MB) | metrics/mAP50-95(B) | Tempo de inferência (ms/im) |

|---|---|---|---|---|---|---|

| YOLO11n | PyTorch | FP32 | ✅ | 5.4 | 0.5052 | 32.27 |

| YOLO11n | OpenVINO | FP32 | ✅ | 10.4 | 0.5085 | 8.33 |

| YOLO11n | OpenVINO | INT8 | ✅ | 3.3 | 0.5019 | 8.91 |

| YOLO11s | PyTorch | FP32 | ✅ | 18.4 | 0.5776 | 92.09 |

| YOLO11s | OpenVINO | FP32 | ✅ | 36.4 | 0.5788 | 9.72 |

| YOLO11s | OpenVINO | INT8 | ✅ | 9.8 | 0.5710 | 10.58 |

| YOLO11m | PyTorch | FP32 | ✅ | 38.8 | 0.6262 | 277.24 |

| YOLO11m | OpenVINO | FP32 | ✅ | 77.1 | 0.6301 | 19.41 |

| YOLO11m | OpenVINO | INT8 | ✅ | 20.2 | 0.6124 | 18.26 |

| YOLO11l | PyTorch | FP32 | ✅ | 49.0 | 0.6361 | 348.97 |

| YOLO11l | OpenVINO | FP32 | ✅ | 97.3 | 0.6362 | 23.70 |

| YOLO11l | OpenVINO | INT8 | ✅ | 25.7 | 0.6240 | 21.40 |

| YOLO11x | PyTorch | FP32 | ✅ | 109.3 | 0.6984 | 666.07 |

| YOLO11x | OpenVINO | FP32 | ✅ | 217.8 | 0.6892 | 43.91 |

| YOLO11x | OpenVINO | INT8 | ✅ | 55.9 | 0.6890 | 34.04 |

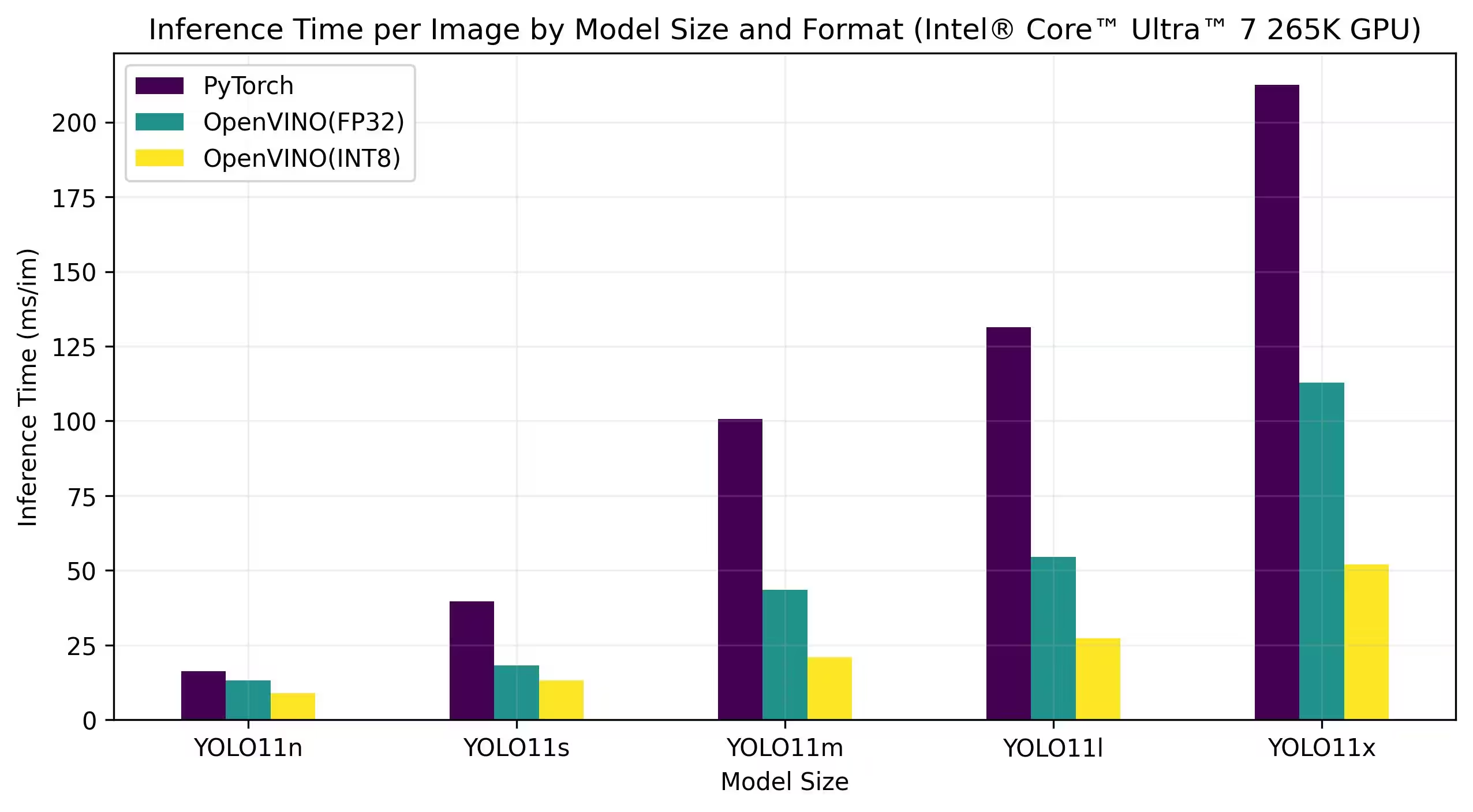

Intel® Core™ Ultra™ 7 265K

Benchmarks

Resultados Detalhados de Benchmark

| Modelo | Formato | Precisão | Status | Tamanho (MB) | metrics/mAP50-95(B) | Tempo de inferência (ms/im) |

|---|---|---|---|---|---|---|

| YOLO11n | PyTorch | FP32 | ✅ | 5.4 | 0.5072 | 16.29 |

| YOLO11n | OpenVINO | FP32 | ✅ | 10.4 | 0.5079 | 13.13 |

| YOLO11n | OpenVINO | INT8 | ✅ | 3.3 | 0.4976 | 8.86 |

| YOLO11s | PyTorch | FP32 | ✅ | 18.4 | 0.5771 | 39.61 |

| YOLO11s | OpenVINO | FP32 | ✅ | 36.4 | 0.5808 | 18.26 |

| YOLO11s | OpenVINO | INT8 | ✅ | 9.8 | 0.5726 | 13.24 |

| YOLO11m | PyTorch | FP32 | ✅ | 38.8 | 0.6258 | 100.65 |

| YOLO11m | OpenVINO | FP32 | ✅ | 77.1 | 0.6310 | 43.50 |

| YOLO11m | OpenVINO | INT8 | ✅ | 20.2 | 0.6137 | 20.90 |

| YOLO11l | PyTorch | FP32 | ✅ | 49.0 | 0.6367 | 131.37 |

| YOLO11l | OpenVINO | FP32 | ✅ | 97.3 | 0.6371 | 54.52 |

| YOLO11l | OpenVINO | INT8 | ✅ | 25.7 | 0.6226 | 27.36 |

| YOLO11x | PyTorch | FP32 | ✅ | 109.3 | 0.6990 | 212.45 |

| YOLO11x | OpenVINO | FP32 | ✅ | 217.8 | 0.6884 | 112.76 |

| YOLO11x | OpenVINO | INT8 | ✅ | 55.9 | 0.6900 | 52.06 |

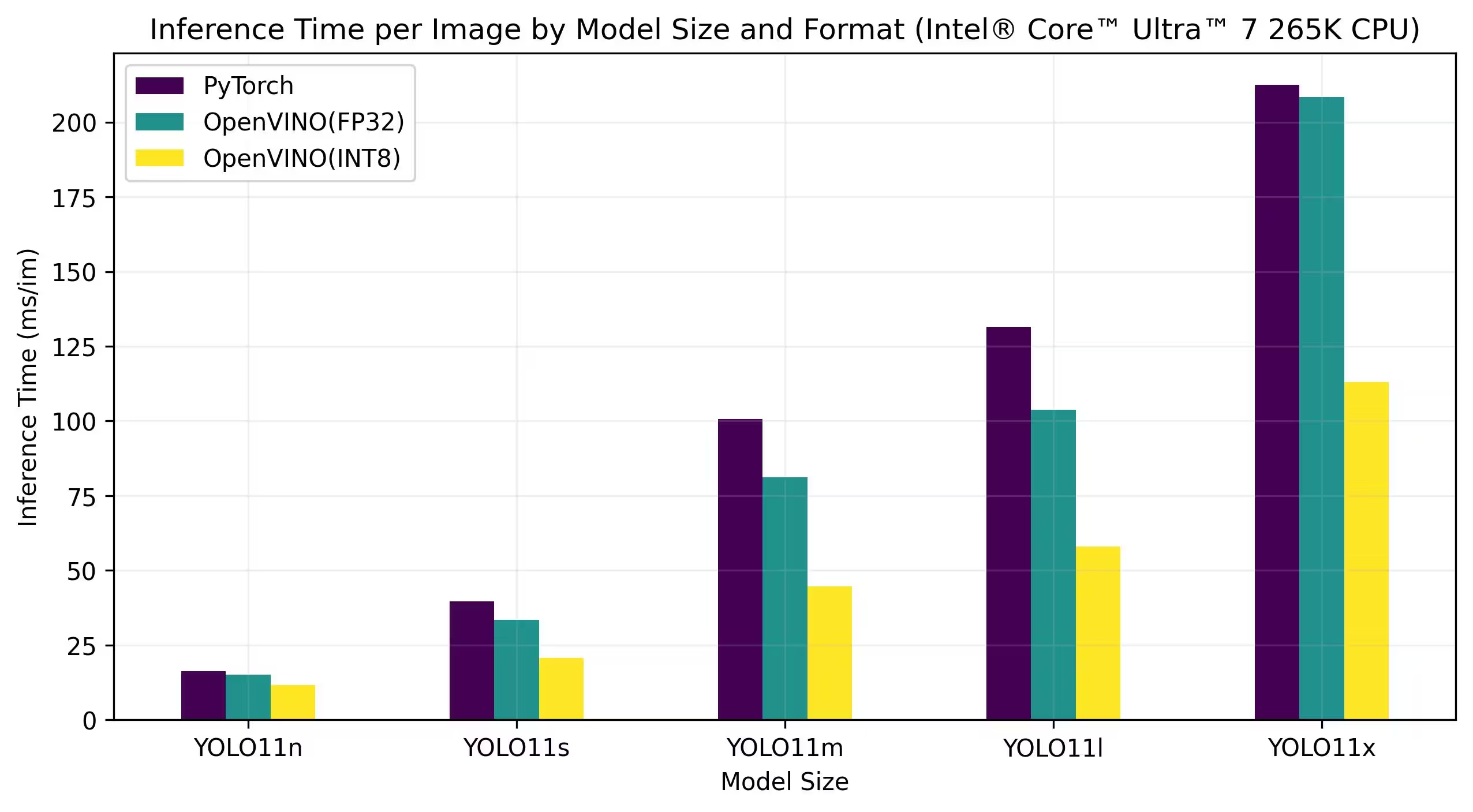

Resultados Detalhados de Benchmark

| Modelo | Formato | Precisão | Status | Tamanho (MB) | metrics/mAP50-95(B) | Tempo de inferência (ms/im) |

|---|---|---|---|---|---|---|

| YOLO11n | PyTorch | FP32 | ✅ | 5.4 | 0.5072 | 16.29 |

| YOLO11n | OpenVINO | FP32 | ✅ | 10.4 | 0.5077 | 15.04 |

| YOLO11n | OpenVINO | INT8 | ✅ | 3.3 | 0.4980 | 11.60 |

| YOLO11s | PyTorch | FP32 | ✅ | 18.4 | 0.5771 | 39.61 |

| YOLO11s | OpenVINO | FP32 | ✅ | 36.4 | 0.5782 | 33.45 |

| YOLO11s | OpenVINO | INT8 | ✅ | 9.8 | 0.5745 | 20.64 |

| YOLO11m | PyTorch | FP32 | ✅ | 38.8 | 0.6258 | 100.65 |

| YOLO11m | OpenVINO | FP32 | ✅ | 77.1 | 0.6307 | 81.15 |

| YOLO11m | OpenVINO | INT8 | ✅ | 20.2 | 0.6172 | 44.63 |

| YOLO11l | PyTorch | FP32 | ✅ | 49.0 | 0.6367 | 131.37 |

| YOLO11l | OpenVINO | FP32 | ✅ | 97.3 | 0.6409 | 103.77 |

| YOLO11l | OpenVINO | INT8 | ✅ | 25.7 | 0.6240 | 58.00 |

| YOLO11x | PyTorch | FP32 | ✅ | 109.3 | 0.6990 | 212.45 |

| YOLO11x | OpenVINO | FP32 | ✅ | 217.8 | 0.6900 | 208.37 |

| YOLO11x | OpenVINO | INT8 | ✅ | 55.9 | 0.6897 | 113.04 |

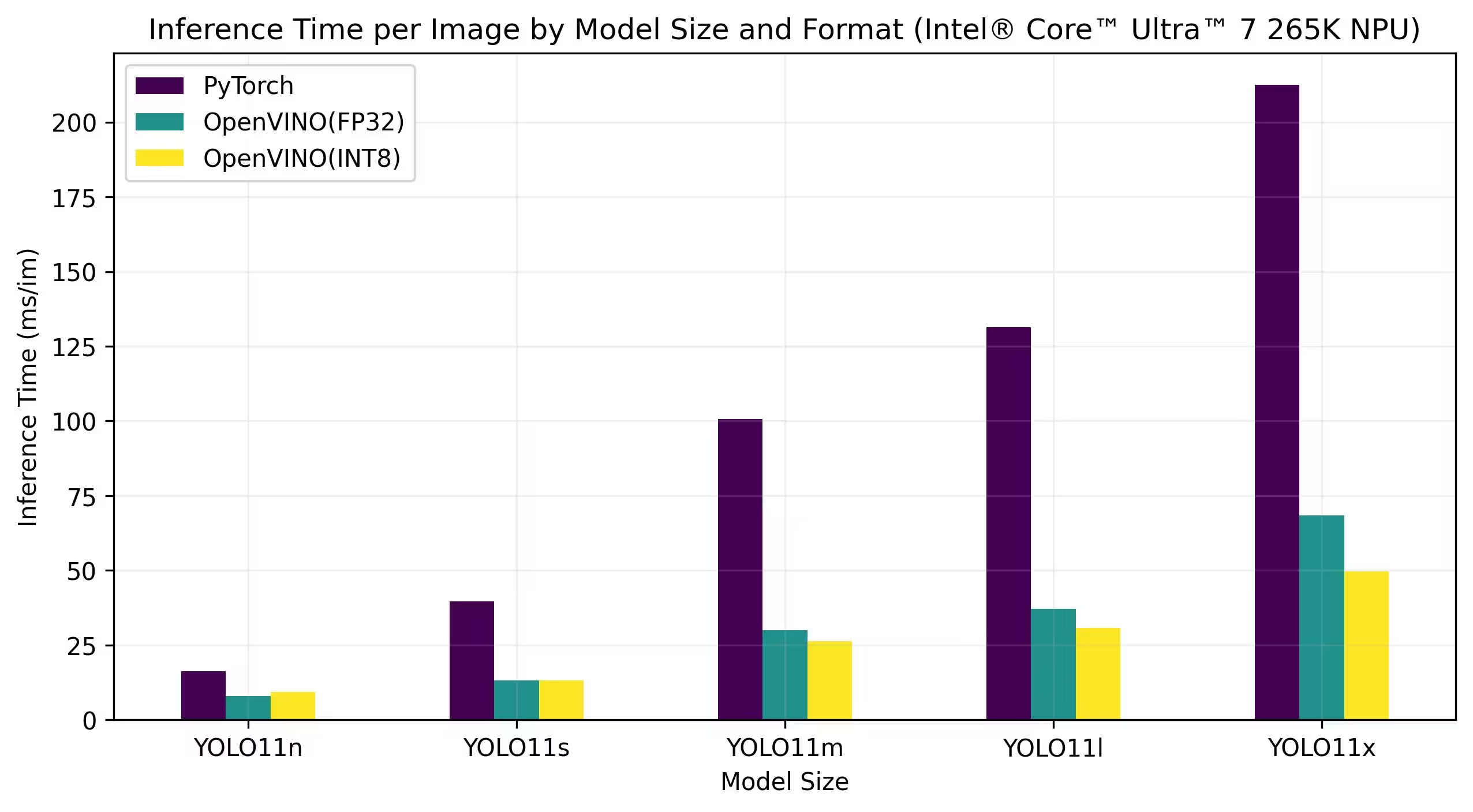

Resultados Detalhados de Benchmark

| Modelo | Formato | Precisão | Status | Tamanho (MB) | metrics/mAP50-95(B) | Tempo de inferência (ms/im) |

|---|---|---|---|---|---|---|

| YOLO11n | PyTorch | FP32 | ✅ | 5.4 | 0.5072 | 16.29 |

| YOLO11n | OpenVINO | FP32 | ✅ | 10.4 | 0.5075 | 8.02 |

| YOLO11n | OpenVINO | INT8 | ✅ | 3.3 | 0.3656 | 9.28 |

| YOLO11s | PyTorch | FP32 | ✅ | 18.4 | 0.5771 | 39.61 |

| YOLO11s | OpenVINO | FP32 | ✅ | 36.4 | 0.5801 | 13.12 |

| YOLO11s | OpenVINO | INT8 | ✅ | 9.8 | 0.5686 | 13.12 |

| YOLO11m | PyTorch | FP32 | ✅ | 38.8 | 0.6258 | 100.65 |

| YOLO11m | OpenVINO | FP32 | ✅ | 77.1 | 0.6310 | 29.88 |

| YOLO11m | OpenVINO | INT8 | ✅ | 20.2 | 0.6111 | 26.32 |

| YOLO11l | PyTorch | FP32 | ✅ | 49.0 | 0.6367 | 131.37 |

| YOLO11l | OpenVINO | FP32 | ✅ | 97.3 | 0.6356 | 37.08 |

| YOLO11l | OpenVINO | INT8 | ✅ | 25.7 | 0.6245 | 30.81 |

| YOLO11x | PyTorch | FP32 | ✅ | 109.3 | 0.6990 | 212.45 |

| YOLO11x | OpenVINO | FP32 | ✅ | 217.8 | 0.6894 | 68.48 |

| YOLO11x | OpenVINO | INT8 | ✅ | 55.9 | 0.6417 | 49.76 |

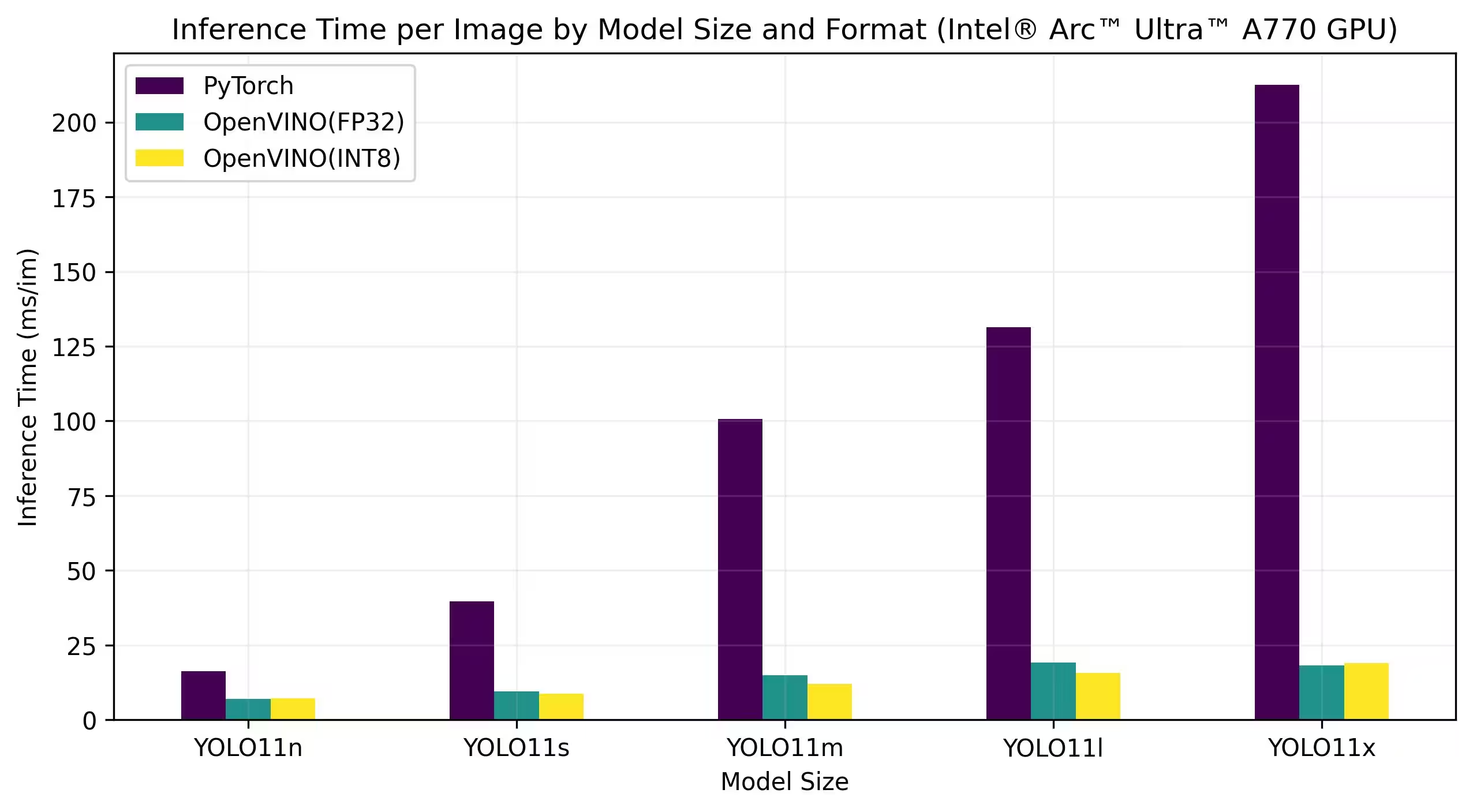

Intel® Arc GPU

Intel® Arc™ é a linha de placas gráficas discretas da Intel, projetada para jogos de alto desempenho, criação de conteúdo e cargas de trabalho de IA. A série Arc apresenta arquiteturas de GPU avançadas que suportam ray tracing em tempo real, gráficos aprimorados por IA e jogos em alta resolução. Com foco no desempenho e eficiência, a Intel® Arc™ tem como objetivo competir com outras marcas líderes de GPU, fornecendo recursos exclusivos, como codificação AV1 acelerada por hardware e suporte para as mais recentes APIs gráficas.

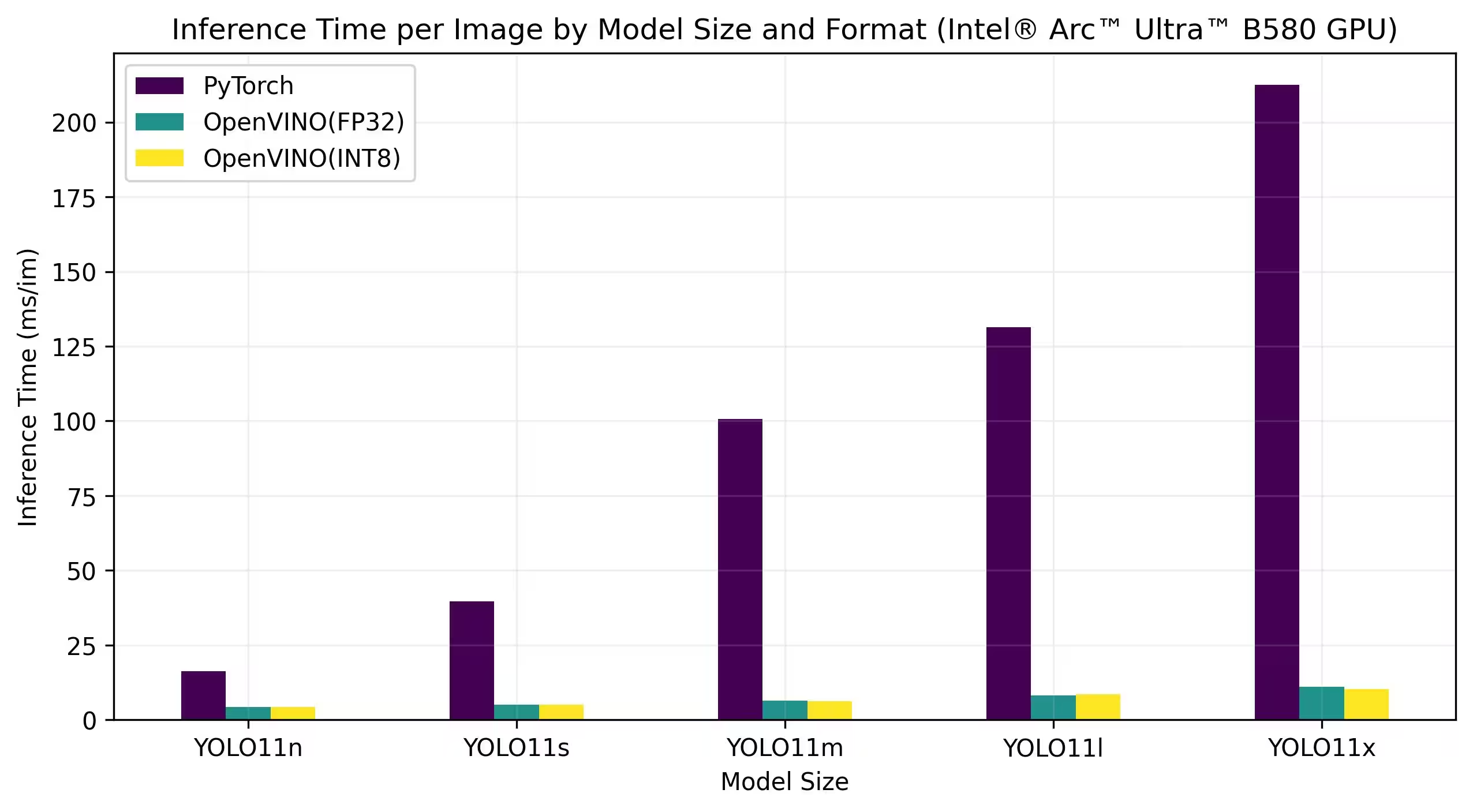

Os benchmarks abaixo são executados em Intel Arc A770 e Intel Arc B580 com precisão FP32 e INT8.

Intel Arc A770

Resultados Detalhados de Benchmark

| Modelo | Formato | Precisão | Status | Tamanho (MB) | metrics/mAP50-95(B) | Tempo de inferência (ms/im) |

|---|---|---|---|---|---|---|

| YOLO11n | PyTorch | FP32 | ✅ | 5.4 | 0.5072 | 16.29 |

| YOLO11n | OpenVINO | FP32 | ✅ | 10.4 | 0.5073 | 6.98 |

| YOLO11n | OpenVINO | INT8 | ✅ | 3.3 | 0.4978 | 7.24 |

| YOLO11s | PyTorch | FP32 | ✅ | 18.4 | 0.5771 | 39.61 |

| YOLO11s | OpenVINO | FP32 | ✅ | 36.4 | 0.5798 | 9.41 |

| YOLO11s | OpenVINO | INT8 | ✅ | 9.8 | 0.5751 | 8.72 |

| YOLO11m | PyTorch | FP32 | ✅ | 38.8 | 0.6258 | 100.65 |

| YOLO11m | OpenVINO | FP32 | ✅ | 77.1 | 0.6311 | 14.88 |

| YOLO11m | OpenVINO | INT8 | ✅ | 20.2 | 0.6126 | 11.97 |

| YOLO11l | PyTorch | FP32 | ✅ | 49.0 | 0.6367 | 131.37 |

| YOLO11l | OpenVINO | FP32 | ✅ | 97.3 | 0.6364 | 19.17 |

| YOLO11l | OpenVINO | INT8 | ✅ | 25.7 | 0.6241 | 15.75 |

| YOLO11x | PyTorch | FP32 | ✅ | 109.3 | 0.6990 | 212.45 |

| YOLO11x | OpenVINO | FP32 | ✅ | 217.8 | 0.6888 | 18.13 |

| YOLO11x | OpenVINO | INT8 | ✅ | 55.9 | 0.6930 | 18.91 |

Intel Arc B580

Resultados Detalhados de Benchmark

| Modelo | Formato | Precisão | Status | Tamanho (MB) | metrics/mAP50-95(B) | Tempo de inferência (ms/im) |

|---|---|---|---|---|---|---|

| YOLO11n | PyTorch | FP32 | ✅ | 5.4 | 0.5072 | 16.29 |

| YOLO11n | OpenVINO | FP32 | ✅ | 10.4 | 0.5072 | 4.27 |

| YOLO11n | OpenVINO | INT8 | ✅ | 3.3 | 0.4981 | 4.33 |

| YOLO11s | PyTorch | FP32 | ✅ | 18.4 | 0.5771 | 39.61 |

| YOLO11s | OpenVINO | FP32 | ✅ | 36.4 | 0.5789 | 5.04 |

| YOLO11s | OpenVINO | INT8 | ✅ | 9.8 | 0.5746 | 4.97 |

| YOLO11m | PyTorch | FP32 | ✅ | 38.8 | 0.6258 | 100.65 |

| YOLO11m | OpenVINO | FP32 | ✅ | 77.1 | 0.6306 | 6.45 |

| YOLO11m | OpenVINO | INT8 | ✅ | 20.2 | 0.6125 | 6.28 |

| YOLO11l | PyTorch | FP32 | ✅ | 49.0 | 0.6367 | 131.37 |

| YOLO11l | OpenVINO | FP32 | ✅ | 97.3 | 0.6360 | 8.23 |

| YOLO11l | OpenVINO | INT8 | ✅ | 25.7 | 0.6236 | 8.49 |

| YOLO11x | PyTorch | FP32 | ✅ | 109.3 | 0.6990 | 212.45 |

| YOLO11x | OpenVINO | FP32 | ✅ | 217.8 | 0.6889 | 11.10 |

| YOLO11x | OpenVINO | INT8 | ✅ | 55.9 | 0.6924 | 10.30 |

Reproduzir Nossos Resultados

Para reproduzir os benchmarks Ultralytics acima em todos os formatos de exportação, execute este código:

Exemplo

from ultralytics import YOLO

# Load a YOLO11n PyTorch model

model = YOLO("yolo11n.pt")

# Benchmark YOLO11n speed and accuracy on the COCO128 dataset for all export formats

results = model.benchmark(data="coco128.yaml")

# Benchmark YOLO11n speed and accuracy on the COCO128 dataset for all export formats

yolo benchmark model=yolo11n.pt data=coco128.yaml

Observe que os resultados de benchmarking podem variar com base na configuração exata de hardware e software de um sistema, bem como na carga de trabalho atual do sistema no momento em que os benchmarks são executados. Para obter os resultados mais confiáveis, use um conjunto de dados com um grande número de imagens, ou seja, data='coco.yaml' (5000 imagens de validação).

Conclusão

Os resultados de benchmarking demonstram claramente os benefícios de exportar o modelo YOLO11 para o formato OpenVINO. Em diferentes modelos e plataformas de hardware, o formato OpenVINO supera consistentemente outros formatos em termos de velocidade de inferência, mantendo uma precisão comparável.

Os benchmarks destacam a eficácia do OpenVINO como uma ferramenta para implantar modelos de deep learning. Ao converter modelos para o formato OpenVINO, os desenvolvedores podem obter melhorias significativas de desempenho, facilitando a implantação desses modelos em aplicações do mundo real.

Para obter informações e instruções mais detalhadas sobre como usar o OpenVINO, consulte a documentação oficial do OpenVINO.

FAQ

Como exporto modelos YOLO26 para o formato OpenVINO?

A exportação de modelos YOLO26 para o formato OpenVINO pode melhorar significativamente a velocidade da CPU e permitir acelerações de GPU e NPU em hardware Intel. Para exportar, você pode usar Python ou CLI, conforme mostrado abaixo:

Exemplo

from ultralytics import YOLO

# Load a YOLO26n PyTorch model

model = YOLO("yolo26n.pt")

# Export the model

model.export(format="openvino") # creates 'yolo26n_openvino_model/'

# Export a YOLO26n PyTorch model to OpenVINO format

yolo export model=yolo26n.pt format=openvino # creates 'yolo26n_openvino_model/'

Para obter mais informações, consulte a documentação de formatos de exportação.

Quais são os benefícios de usar OpenVINO com modelos YOLO26?

A utilização do toolkit OpenVINO da Intel com modelos YOLO26 oferece diversos benefícios:

- Desempenho: Alcance até 3x de aceleração na inferência da CPU e aproveite as GPUs e NPUs da Intel para aceleração.

- Otimizador de Modelo: Converta, otimize e execute modelos de frameworks populares como PyTorch, TensorFlow e ONNX.

- Facilidade de Uso: Mais de 80 notebooks tutoriais estão disponíveis para ajudar os usuários a começar, incluindo alguns para YOLO26.

- Execução Heterogênea: Implante modelos em vários hardwares Intel com uma API unificada.

Para comparações de desempenho detalhadas, visite a nossa seção de benchmarks.

Como posso executar inferência usando um modelo YOLO26 exportado para OpenVINO?

Após exportar um modelo YOLO26n para o formato OpenVINO, você pode executar inferência usando Python ou CLI:

Exemplo

from ultralytics import YOLO

# Load the exported OpenVINO model

ov_model = YOLO("yolo26n_openvino_model/")

# Run inference

results = ov_model("https://ultralytics.com/images/bus.jpg")

# Run inference with the exported model

yolo predict model=yolo26n_openvino_model source='https://ultralytics.com/images/bus.jpg'

Consulte nossa documentação do modo de previsão para obter mais detalhes.

Por que devo escolher Ultralytics YOLO26 em vez de outros modelos para exportação OpenVINO?

Ultralytics YOLO26 é otimizado para detecção de objetos em tempo real com alta precisão e velocidade. Especificamente, quando combinado com OpenVINO, o YOLO26 oferece:

- Aceleração de até 3x em CPUs Intel

- Implantação perfeita em GPUs e NPUs Intel

- Precisão consistente e comparável em vários formatos de exportação

Para uma análise de desempenho aprofundada, consulte nossos benchmarks YOLO11 detalhados em diferentes hardwares.

Posso fazer benchmark de modelos YOLO26 em diferentes formatos, como PyTorch, ONNX e OpenVINO?

Sim, você pode fazer benchmark de modelos YOLO26 em vários formatos, incluindo PyTorch, TorchScript, ONNX e OpenVINO. Use o seguinte trecho de código para executar benchmarks no conjunto de dados escolhido:

Exemplo

from ultralytics import YOLO

# Load a YOLO26n PyTorch model

model = YOLO("yolo26n.pt")

# Benchmark YOLO26n speed and [accuracy](https://www.ultralytics.com/glossary/accuracy) on the COCO8 dataset for all export formats

results = model.benchmark(data="coco8.yaml")

# Benchmark YOLO26n speed and accuracy on the COCO8 dataset for all export formats

yolo benchmark model=yolo26n.pt data=coco8.yaml

Para resultados de benchmark detalhados, consulte nossa seção de benchmarks e a documentação de formatos de exportação.