Простые утилиты

Параметр ultralytics пакет предоставляет различные утилиты для поддержки, улучшения и ускорения ваших рабочих процессов. Хотя доступно гораздо больше, это руководство освещает некоторые из наиболее полезных для разработчиков, служа практическим справочником для программирования с инструментами Ultralytics.

Смотреть: Утилиты Ultralytics | Автоматическая аннотация, API Explorer и преобразование набора данных

Данные

Автоматическая разметка / Аннотации

Аннотация набора данных - это ресурсоемкий и трудозатратный процесс. Если у вас есть модель обнаружения объектов Ultralytics YOLO, обученная на достаточном количестве данных, вы можете использовать ее с SAM для автоматической аннотации дополнительных данных в формате сегментации.

from ultralytics.data.annotator import auto_annotate

auto_annotate(

data="path/to/new/data",

det_model="yolo26n.pt",

sam_model="mobile_sam.pt",

device="cuda",

output_dir="path/to/save_labels",

)

Эта функция не возвращает никакого значения. Для получения более подробной информации:

- Смотрите справочный раздел для

annotator.auto_annotateдля получения дополнительной информации о том, как работает функция. - Используйте в сочетании с функцией

segments2boxesа также для генерации ограничивающих рамок обнаружения объектов.

Визуализация аннотаций набора данных

Эта функция визуализирует аннотации YOLO на изображении перед обучением, помогая выявлять и исправлять любые неправильные аннотации, которые могут привести к неверным результатам обнаружения. Она рисует ограничивающие рамки, помечает объекты названиями классов и регулирует цвет текста в зависимости от яркости фона для лучшей читаемости.

from ultralytics.data.utils import visualize_image_annotations

label_map = { # Define the label map with all annotated class labels.

0: "person",

1: "car",

}

# Visualize

visualize_image_annotations(

"path/to/image.jpg", # Input image path.

"path/to/annotations.txt", # Annotation file path for the image.

label_map,

)

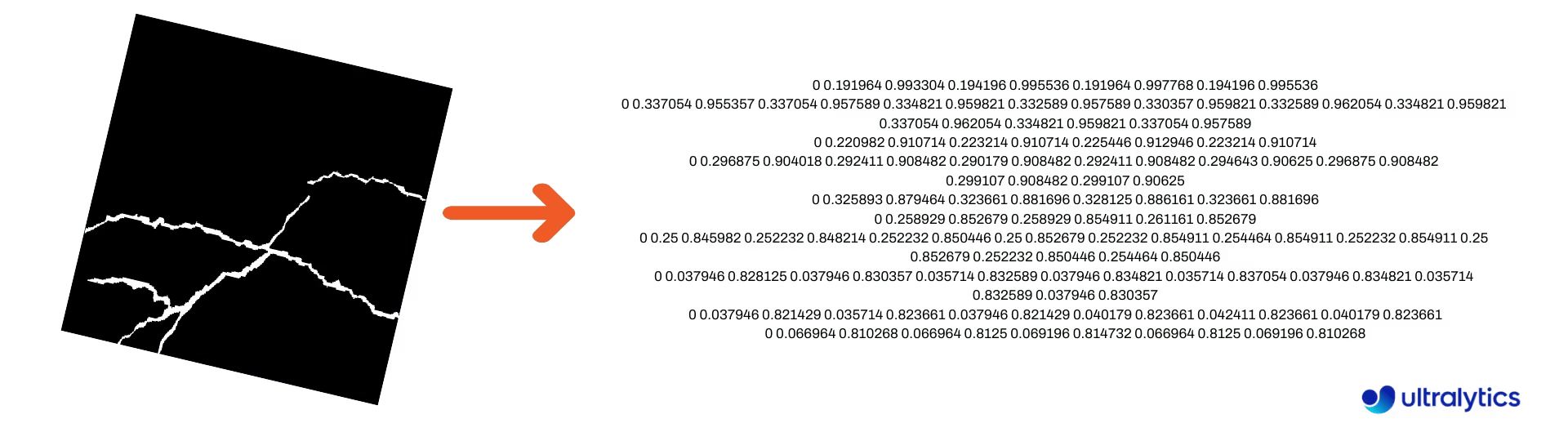

Преобразование масок сегментации в формат YOLO

Используйте это для преобразования набора данных изображений масок сегментации в формат сегментации Ultralytics YOLO. Эта функция принимает каталог, содержащий изображения масок в двоичном формате, и преобразует их в формат сегментации YOLO.

Преобразованные маски будут сохранены в указанном выходном каталоге.

from ultralytics.data.converter import convert_segment_masks_to_yolo_seg

# The classes here is the total classes in the dataset.

# for COCO dataset we have 80 classes.

convert_segment_masks_to_yolo_seg(masks_dir="path/to/masks_dir", output_dir="path/to/output_dir", classes=80)

Преобразование COCO в формат YOLO

Используйте это для преобразования COCO аннотации JSON в формат YOLO. Для наборов данных обнаружения объектов (bounding box) установите оба параметра use_segments и use_keypoints в False.

from ultralytics.data.converter import convert_coco

convert_coco(

"coco/annotations/",

use_segments=False,

use_keypoints=False,

cls91to80=True,

)

Для получения дополнительной информации о convert_coco функции, посетите справочную страницу.

Получение размеров ограничивающей рамки

import cv2

from ultralytics import YOLO

from ultralytics.utils.plotting import Annotator

model = YOLO("yolo26n.pt") # Load pretrain or fine-tune model

# Process the image

source = cv2.imread("path/to/image.jpg")

results = model(source)

# Extract results

annotator = Annotator(source, example=model.names)

for box in results[0].boxes.xyxy.cpu():

width, height, area = annotator.get_bbox_dimension(box)

print(f"Bounding Box Width {width.item()}, Height {height.item()}, Area {area.item()}")

Преобразование ограничивающих рамок в сегменты

С существующими x y w h данными bounding box, преобразуйте в сегменты, используя yolo_bbox2segment функции. Организуйте файлы для изображений и аннотаций следующим образом:

data

|__ images

├─ 001.jpg

├─ 002.jpg

├─ ..

└─ NNN.jpg

|__ labels

├─ 001.txt

├─ 002.txt

├─ ..

└─ NNN.txt

from ultralytics.data.converter import yolo_bbox2segment

yolo_bbox2segment(

im_dir="path/to/images",

save_dir=None, # saved to "labels-segment" in images directory

sam_model="sam_b.pt",

)

Посетите yolo_bbox2segment справочную страницу для получения дополнительной информации о функции.

Преобразование сегментов в ограничивающие рамки

Если у вас есть набор данных, который использует формат набора данных сегментации, вы можете легко преобразовать их в вертикальные (или горизонтальные) ограничивающие рамки (x y w h формат) с помощью этой функции.

import numpy as np

from ultralytics.utils.ops import segments2boxes

segments = np.array(

[

[805, 392, 797, 400, ..., 808, 714, 808, 392],

[115, 398, 113, 400, ..., 150, 400, 149, 298],

[267, 412, 265, 413, ..., 300, 413, 299, 412],

]

)

segments2boxes([s.reshape(-1, 2) for s in segments])

# >>> array([[ 741.66, 631.12, 133.31, 479.25],

# [ 146.81, 649.69, 185.62, 502.88],

# [ 281.81, 636.19, 118.12, 448.88]],

# dtype=float32) # xywh bounding boxes

Чтобы понять, как работает эта функция, посетите справочную страницу.

Утилиты

Сжатие изображений

Сжатие одного файла изображения до уменьшенного размера с сохранением пропорций и качества. Если входное изображение меньше максимального размера, его размер не будет изменен.

from pathlib import Path

from ultralytics.data.utils import compress_one_image

for f in Path("path/to/dataset").rglob("*.jpg"):

compress_one_image(f)

Автоматическое разделение набора данных

Автоматически разделить набор данных на train/val/test части и сохранить полученные части в autosplit_*.txt файлы. Эта функция использует случайную выборку, которая исключается при использовании fraction аргумента для обучения.

from ultralytics.data.split import autosplit

autosplit(

path="path/to/images",

weights=(0.9, 0.1, 0.0), # (train, validation, test) fractional splits

annotated_only=False, # split only images with annotation file when True

)

Смотрите Справочную страницу для получения дополнительной информации об этой функции.

Преобразование сегмент-полигона в бинарную маску

Преобразует один полигон (в виде списка) в бинарную маску указанного размера изображения. Полигон должен быть в виде [N, 2], где N это количество (x, y) точек, определяющих контур полигона.

Предупреждение

N должно всегда быть четным.

import numpy as np

from ultralytics.data.utils import polygon2mask

imgsz = (1080, 810)

polygon = np.array([805, 392, 797, 400, ..., 808, 714, 808, 392]) # (238, 2)

mask = polygon2mask(

imgsz, # tuple

[polygon], # input as list

color=255, # 8-bit binary

downsample_ratio=1,

)

Ограничивающие рамки

Экземпляры ограничивающей рамки (горизонтальной)

Для управления данными ограничивающего прямоугольника, Bboxes класс помогает преобразовывать форматы координат ограничивающих рамок, масштабировать размеры ограничивающих рамок, вычислять площади, включать смещения и многое другое.

import numpy as np

from ultralytics.utils.instance import Bboxes

boxes = Bboxes(

bboxes=np.array(

[

[22.878, 231.27, 804.98, 756.83],

[48.552, 398.56, 245.35, 902.71],

[669.47, 392.19, 809.72, 877.04],

[221.52, 405.8, 344.98, 857.54],

[0, 550.53, 63.01, 873.44],

[0.0584, 254.46, 32.561, 324.87],

]

),

format="xyxy",

)

boxes.areas()

# >>> array([ 4.1104e+05, 99216, 68000, 55772, 20347, 2288.5])

boxes.convert("xywh")

print(boxes.bboxes)

# >>> array(

# [[ 413.93, 494.05, 782.1, 525.56],

# [ 146.95, 650.63, 196.8, 504.15],

# [ 739.6, 634.62, 140.25, 484.85],

# [ 283.25, 631.67, 123.46, 451.74],

# [ 31.505, 711.99, 63.01, 322.91],

# [ 16.31, 289.67, 32.503, 70.41]]

# )

Смотрите Bboxes справочный раздел для получения дополнительных атрибутов и методов.

Совет

Многие из следующих функций (и не только) доступны через Bboxes класс, но если вы предпочитаете работать с функциями напрямую, смотрите следующие подразделы о том, как импортировать их независимо.

Масштабирование рамок

При масштабировании изображения вверх или вниз вы можете соответствующим образом масштабировать координаты ограничивающего прямоугольника, чтобы они совпадали, используя ultralytics.utils.ops.scale_boxes.

import cv2 as cv

import numpy as np

from ultralytics.utils.ops import scale_boxes

image = cv.imread("ultralytics/assets/bus.jpg")

h, w, c = image.shape

resized = cv.resize(image, None, (), fx=1.2, fy=1.2)

new_h, new_w, _ = resized.shape

xyxy_boxes = np.array(

[

[22.878, 231.27, 804.98, 756.83],

[48.552, 398.56, 245.35, 902.71],

[669.47, 392.19, 809.72, 877.04],

[221.52, 405.8, 344.98, 857.54],

[0, 550.53, 63.01, 873.44],

[0.0584, 254.46, 32.561, 324.87],

]

)

new_boxes = scale_boxes(

img1_shape=(h, w), # original image dimensions

boxes=xyxy_boxes, # boxes from original image

img0_shape=(new_h, new_w), # resized image dimensions (scale to)

ratio_pad=None,

padding=False,

xywh=False,

)

print(new_boxes)

# >>> array(

# [[ 27.454, 277.52, 965.98, 908.2],

# [ 58.262, 478.27, 294.42, 1083.3],

# [ 803.36, 470.63, 971.66, 1052.4],

# [ 265.82, 486.96, 413.98, 1029],

# [ 0, 660.64, 75.612, 1048.1],

# [ 0.0701, 305.35, 39.073, 389.84]]

# )

Преобразования формата ограничивающих рамок

XYXY → XYWH

Преобразует координаты ограничивающего прямоугольника из формата (x1, y1, x2, y2) в формат (x, y, ширина, высота), где (x1, y1) — верхний левый угол, а (x2, y2) — нижний правый угол.

import numpy as np

from ultralytics.utils.ops import xyxy2xywh

xyxy_boxes = np.array(

[

[22.878, 231.27, 804.98, 756.83],

[48.552, 398.56, 245.35, 902.71],

[669.47, 392.19, 809.72, 877.04],

[221.52, 405.8, 344.98, 857.54],

[0, 550.53, 63.01, 873.44],

[0.0584, 254.46, 32.561, 324.87],

]

)

xywh = xyxy2xywh(xyxy_boxes)

print(xywh)

# >>> array(

# [[ 413.93, 494.05, 782.1, 525.56],

# [ 146.95, 650.63, 196.8, 504.15],

# [ 739.6, 634.62, 140.25, 484.85],

# [ 283.25, 631.67, 123.46, 451.74],

# [ 31.505, 711.99, 63.01, 322.91],

# [ 16.31, 289.67, 32.503, 70.41]]

# )

Все преобразования ограничивающих рамок

from ultralytics.utils.ops import (

ltwh2xywh,

ltwh2xyxy,

xywh2ltwh, # xywh → top-left corner, w, h

xywh2xyxy,

xywhn2xyxy, # normalized → pixel

xyxy2ltwh, # xyxy → top-left corner, w, h

xyxy2xywhn, # pixel → normalized

)

for func in (ltwh2xywh, ltwh2xyxy, xywh2ltwh, xywh2xyxy, xywhn2xyxy, xyxy2ltwh, xyxy2xywhn):

print(help(func)) # print function docstrings

См. строку документации для каждой функции или посетите ultralytics.utils.ops справочную страницу чтобы узнать больше.

Построение графиков

Утилиты аннотаций

Ultralytics включает в себя Annotator класс для аннотирования различных типов данных. Лучше всего использовать с ограничивающие рамки обнаружения объектов, ключевые точки позыи ориентированные ограничивающие рамки.

Аннотация рамки

Примеры на python с использованием Ultralytics YOLO 🚀

import cv2 as cv

import numpy as np

from ultralytics.utils.plotting import Annotator, colors

names = {

0: "person",

5: "bus",

11: "stop sign",

}

image = cv.imread("ultralytics/assets/bus.jpg")

ann = Annotator(

image,

line_width=None, # default auto-size

font_size=None, # default auto-size

font="Arial.ttf", # must be ImageFont compatible

pil=False, # use PIL, otherwise uses OpenCV

)

xyxy_boxes = np.array(

[

[5, 22.878, 231.27, 804.98, 756.83], # class-idx x1 y1 x2 y2

[0, 48.552, 398.56, 245.35, 902.71],

[0, 669.47, 392.19, 809.72, 877.04],

[0, 221.52, 405.8, 344.98, 857.54],

[0, 0, 550.53, 63.01, 873.44],

[11, 0.0584, 254.46, 32.561, 324.87],

]

)

for nb, box in enumerate(xyxy_boxes):

c_idx, *box = box

label = f"{str(nb).zfill(2)}:{names.get(int(c_idx))}"

ann.box_label(box, label, color=colors(c_idx, bgr=True))

image_with_bboxes = ann.result()

import cv2 as cv

import numpy as np

from ultralytics.utils.plotting import Annotator, colors

obb_names = {10: "small vehicle"}

obb_image = cv.imread("datasets/dota8/images/train/P1142__1024__0___824.jpg")

obb_boxes = np.array(

[

[0, 635, 560, 919, 719, 1087, 420, 803, 261], # class-idx x1 y1 x2 y2 x3 y2 x4 y4

[0, 331, 19, 493, 260, 776, 70, 613, -171],

[9, 869, 161, 886, 147, 851, 101, 833, 115],

]

)

ann = Annotator(

obb_image,

line_width=None, # default auto-size

font_size=None, # default auto-size

font="Arial.ttf", # must be ImageFont compatible

pil=False, # use PIL, otherwise uses OpenCV

)

for obb in obb_boxes:

c_idx, *obb = obb

obb = np.array(obb).reshape(-1, 4, 2).squeeze()

label = f"{obb_names.get(int(c_idx))}"

ann.box_label(

obb,

label,

color=colors(c_idx, True),

)

image_with_obb = ann.result()

Имена можно использовать из model.names при работе с результатами обнаружения.

См. также Annotator Справочная страница для дополнительной информации.

Аннотация Ultralytics Sweep

Аннотация развертки с использованием утилит Ultralytics

import cv2

import numpy as np

from ultralytics import YOLO

from ultralytics.solutions.solutions import SolutionAnnotator

from ultralytics.utils.plotting import colors

# User defined video path and model file

cap = cv2.VideoCapture("path/to/video.mp4")

model = YOLO(model="yolo26s-seg.pt") # Model file, e.g., yolo26s.pt or yolo26m-seg.pt

if not cap.isOpened():

print("Error: Could not open video.")

exit()

# Initialize the video writer object.

w, h, fps = (int(cap.get(x)) for x in (cv2.CAP_PROP_FRAME_WIDTH, cv2.CAP_PROP_FRAME_HEIGHT, cv2.CAP_PROP_FPS))

video_writer = cv2.VideoWriter("ultralytics.avi", cv2.VideoWriter_fourcc(*"mp4v"), fps, (w, h))

masks = None # Initialize variable to store masks data

f = 0 # Initialize frame count variable for enabling mouse event.

line_x = w # Store width of line.

dragging = False # Initialize bool variable for line dragging.

classes = model.names # Store model classes names for plotting.

window_name = "Ultralytics Sweep Annotator"

def drag_line(event, x, _, flags, param):

"""Mouse callback function to enable dragging a vertical sweep line across the video frame."""

global line_x, dragging

if event == cv2.EVENT_LBUTTONDOWN or (flags & cv2.EVENT_FLAG_LBUTTON):

line_x = max(0, min(x, w))

dragging = True

while cap.isOpened(): # Loop over the video capture object.

ret, im0 = cap.read()

if not ret:

break

f = f + 1 # Increment frame count.

count = 0 # Re-initialize count variable on every frame for precise counts.

results = model.track(im0, persist=True)[0]

if f == 1:

cv2.namedWindow(window_name)

cv2.setMouseCallback(window_name, drag_line)

annotator = SolutionAnnotator(im0)

if results.boxes.is_track:

if results.masks is not None:

masks = [np.array(m, dtype=np.int32) for m in results.masks.xy]

boxes = results.boxes.xyxy.tolist()

track_ids = results.boxes.id.int().cpu().tolist()

clss = results.boxes.cls.cpu().tolist()

for mask, box, cls, t_id in zip(masks or [None] * len(boxes), boxes, clss, track_ids):

color = colors(t_id, True) # Assign different color to each tracked object.

label = f"{classes[cls]}:{t_id}"

if mask is not None and mask.size > 0:

if box[0] > line_x:

count += 1

cv2.polylines(im0, [mask], True, color, 2)

x, y = mask.min(axis=0)

(w_m, _), _ = cv2.getTextSize(label, cv2.FONT_HERSHEY_SIMPLEX, 0.5, 1)

cv2.rectangle(im0, (x, y - 20), (x + w_m, y), color, -1)

cv2.putText(im0, label, (x, y - 5), cv2.FONT_HERSHEY_SIMPLEX, 0.5, (255, 255, 255), 1)

else:

if box[0] > line_x:

count += 1

annotator.box_label(box=box, color=color, label=label)

# Generate draggable sweep line

annotator.sweep_annotator(line_x=line_x, line_y=h, label=f"COUNT:{count}")

cv2.imshow(window_name, im0)

video_writer.write(im0)

if cv2.waitKey(1) & 0xFF == ord("q"):

break

# Release the resources

cap.release()

video_writer.release()

cv2.destroyAllWindows()

Дополнительную информацию можно найти о sweep_annotator метод в нашем справочном разделе здесь.

Адаптивная аннотация метки

Предупреждение

Начиная с Ultralytics v8.3.167, circle_label и text_label были заменены унифицированной adaptive_label функцией. Теперь вы можете указать тип аннотации, используя shape аргумент:

- Прямоугольник:

annotator.adaptive_label(box, label=names[int(cls)], color=colors(cls, True), shape="rect") - Круг:

annotator.adaptive_label(box, label=names[int(cls)], color=colors(cls, True), shape="circle")

Смотреть: Подробное руководство по текстовым и круговым аннотациям с живыми демонстрациями на Python | Ultralytics Annotations 🚀

Адаптивная аннотация метки с использованием утилит Ultralytics

import cv2

from ultralytics import YOLO

from ultralytics.solutions.solutions import SolutionAnnotator

from ultralytics.utils.plotting import colors

model = YOLO("yolo26s.pt")

names = model.names

cap = cv2.VideoCapture("path/to/video.mp4")

w, h, fps = (int(cap.get(x)) for x in (cv2.CAP_PROP_FRAME_WIDTH, cv2.CAP_PROP_FRAME_HEIGHT, cv2.CAP_PROP_FPS))

writer = cv2.VideoWriter("Ultralytics circle annotation.avi", cv2.VideoWriter_fourcc(*"MJPG"), fps, (w, h))

while True:

ret, im0 = cap.read()

if not ret:

break

annotator = SolutionAnnotator(im0)

results = model.predict(im0)[0]

boxes = results.boxes.xyxy.cpu()

clss = results.boxes.cls.cpu().tolist()

for box, cls in zip(boxes, clss):

annotator.adaptive_label(box, label=names[int(cls)], color=colors(cls, True), shape="circle")

writer.write(im0)

cv2.imshow("Ultralytics circle annotation", im0)

if cv2.waitKey(1) & 0xFF == ord("q"):

break

writer.release()

cap.release()

cv2.destroyAllWindows()

import cv2

from ultralytics import YOLO

from ultralytics.solutions.solutions import SolutionAnnotator

from ultralytics.utils.plotting import colors

model = YOLO("yolo26s.pt")

names = model.names

cap = cv2.VideoCapture("path/to/video.mp4")

w, h, fps = (int(cap.get(x)) for x in (cv2.CAP_PROP_FRAME_WIDTH, cv2.CAP_PROP_FRAME_HEIGHT, cv2.CAP_PROP_FPS))

writer = cv2.VideoWriter("Ultralytics text annotation.avi", cv2.VideoWriter_fourcc(*"MJPG"), fps, (w, h))

while True:

ret, im0 = cap.read()

if not ret:

break

annotator = SolutionAnnotator(im0)

results = model.predict(im0)[0]

boxes = results.boxes.xyxy.cpu()

clss = results.boxes.cls.cpu().tolist()

for box, cls in zip(boxes, clss):

annotator.adaptive_label(box, label=names[int(cls)], color=colors(cls, True), shape="rect")

writer.write(im0)

cv2.imshow("Ultralytics text annotation", im0)

if cv2.waitKey(1) & 0xFF == ord("q"):

break

writer.release()

cap.release()

cv2.destroyAllWindows()

Смотрите SolutionAnnotator Справочная страница для дополнительной информации.

Разное

Профилирование кода

Проверьте продолжительность выполнения/обработки кода, используя with или в качестве декоратора.

from ultralytics.utils.ops import Profile

with Profile(device="cuda:0") as dt:

pass # operation to measure

print(dt)

# >>> "Elapsed time is 9.5367431640625e-07 s"

Форматы, поддерживаемые Ultralytics

Требуется программно использовать поддерживаемые форматы изображений или видео в Ultralytics? Используйте эти константы, если необходимо:

from ultralytics.data.utils import IMG_FORMATS, VID_FORMATS

print(IMG_FORMATS)

# {'avif', 'bmp', 'dng', 'heic', 'jp2', 'jpeg', 'jpeg2000', 'jpg', 'mpo', 'png', 'tif', 'tiff', 'webp'}

print(VID_FORMATS)

# {'asf', 'avi', 'gif', 'm4v', 'mkv', 'mov', 'mp4', 'mpeg', 'mpg', 'ts', 'wmv', 'webm'}

Сделать кратным

Вычислите ближайшее целое число к x который равномерно делится на y.

from ultralytics.utils.ops import make_divisible

make_divisible(7, 3)

# >>> 9

make_divisible(7, 2)

# >>> 8

Часто задаваемые вопросы

Какие утилиты включены в пакет Ultralytics для улучшения рабочих процессов машинного обучения?

Пакет Ultralytics включает в себя утилиты, предназначенные для оптимизации рабочих процессов машинного обучения. Ключевые утилиты включают автоматическую аннотацию для маркировки наборов данных, преобразование COCO в формат YOLO с помощью convert_coco, сжатие изображений и автоматическое разделение набора данных. Эти инструменты уменьшают ручной труд, обеспечивают согласованность и повышают эффективность обработки данных.

Как я могу использовать Ultralytics для автоматической разметки моего набора данных?

Если у вас есть предварительно обученная модель обнаружения объектов Ultralytics YOLO, вы можете использовать ее с моделью SAM для автоматической аннотации вашего набора данных в формате segment. Вот пример:

from ultralytics.data.annotator import auto_annotate

auto_annotate(

data="path/to/new/data",

det_model="yolo26n.pt",

sam_model="mobile_sam.pt",

device="cuda",

output_dir="path/to/save_labels",

)

Для получения более подробной информации обратитесь к разделу справки по auto_annotate.

Как преобразовать аннотации датасета COCO в формат YOLO в Ultralytics?

Чтобы преобразовать аннотации COCO JSON в формат YOLO для detect объектов, вы можете использовать convert_coco утилиту. Вот пример фрагмента кода:

from ultralytics.data.converter import convert_coco

convert_coco(

"coco/annotations/",

use_segments=False,

use_keypoints=False,

cls91to80=True,

)

Для получения дополнительной информации посетите справочную страницу convert_coco.

Какова цель YOLO Data Explorer в пакете Ultralytics?

Параметр YOLO Explorer — это мощный инструмент, представленный в 8.1.0 обновлении для улучшения понимания набора данных. Он позволяет использовать текстовые запросы для поиска экземпляров объектов в вашем наборе данных, что упрощает анализ и управление вашими данными. Этот инструмент предоставляет ценную информацию о составе и распределении набора данных, помогая улучшить обучение и производительность модели.

Как преобразовать ограничивающие рамки в сегменты в Ultralytics?

Чтобы преобразовать существующие данные ограничивающих рамок (в x y w h формате) в сегменты, вы можете использовать yolo_bbox2segment функцию. Убедитесь, что ваши файлы организованы с отдельными каталогами для изображений и меток.

from ultralytics.data.converter import yolo_bbox2segment

yolo_bbox2segment(

im_dir="path/to/images",

save_dir=None, # saved to "labels-segment" in the images directory

sam_model="sam_b.pt",

)

Для получения дополнительной информации посетите справочную страницу yolo_bbox2segment.