快速入门指南:Seeed Studio reCamera 结合 Ultralytics YOLO26

reCamera 在 YOLO Vision 2024 (YV24),Ultralytics 年度混合活动中被引入到 AI 社区。它主要为 边缘 AI 应用 而设计,提供强大的处理能力和轻松的部署。

凭借对多样化硬件配置和开源资源的支持,它成为在边缘进行创新计算机视觉解决方案原型开发和部署的理想平台。

为什么选择 reCamera?

reCamera 系列专为边缘 AI 应用而设计,旨在满足开发者和创新者的需求。以下是它脱颖而出的原因:

RISC-V驱动的性能:其核心是SG200X处理器,它基于RISC-V架构构建,为边缘AI任务提供卓越的性能,同时保持能源效率。它具有每秒执行1万亿次操作(1 TOPS)的能力,可以轻松处理实时对象检测等高要求的任务。

优化视频技术: 支持先进的视频压缩标准,包括 H.264 和 H.265,以减少存储和带宽需求,同时不牺牲质量。HDR 图像、3D 降噪和镜头校正等功能可确保即使在具有挑战性的环境中也能获得专业的视觉效果。

节能双重处理: SG200X 处理复杂的 AI 任务,而较小的 8 位微控制器管理更简单的操作以节省电量,这使得 reCamera 非常适合电池供电或低功耗设置。

模块化和可升级设计: reCamera 采用模块化结构构建,由三个主要组件组成:核心板、传感器板和底板。这种设计使开发人员可以轻松更换或升级组件,从而确保灵活性和面向未来的项目。

reCamera 的快速硬件设置

请按照reCamera 快速入门指南进行设备的初始设置,例如将设备连接到 WiFi 网络并访问 Node-RED Web UI,以快速预览检测结果。

使用预安装的 YOLO26 模型进行推理

reCamera 预装了四种 Ultralytics YOLO26 模型,您可以在 Node-RED 控制面板中直接选择您想要的模型。

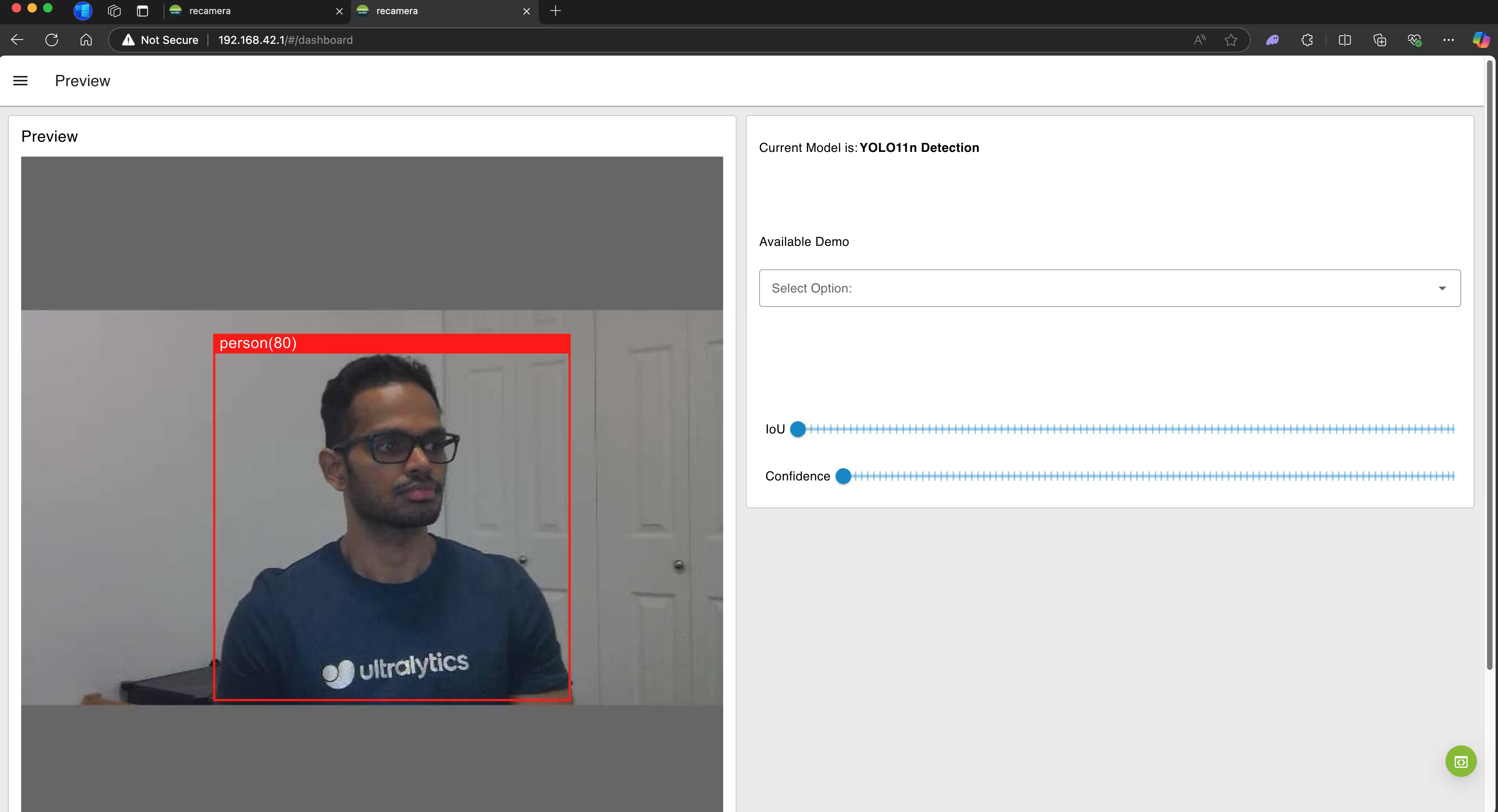

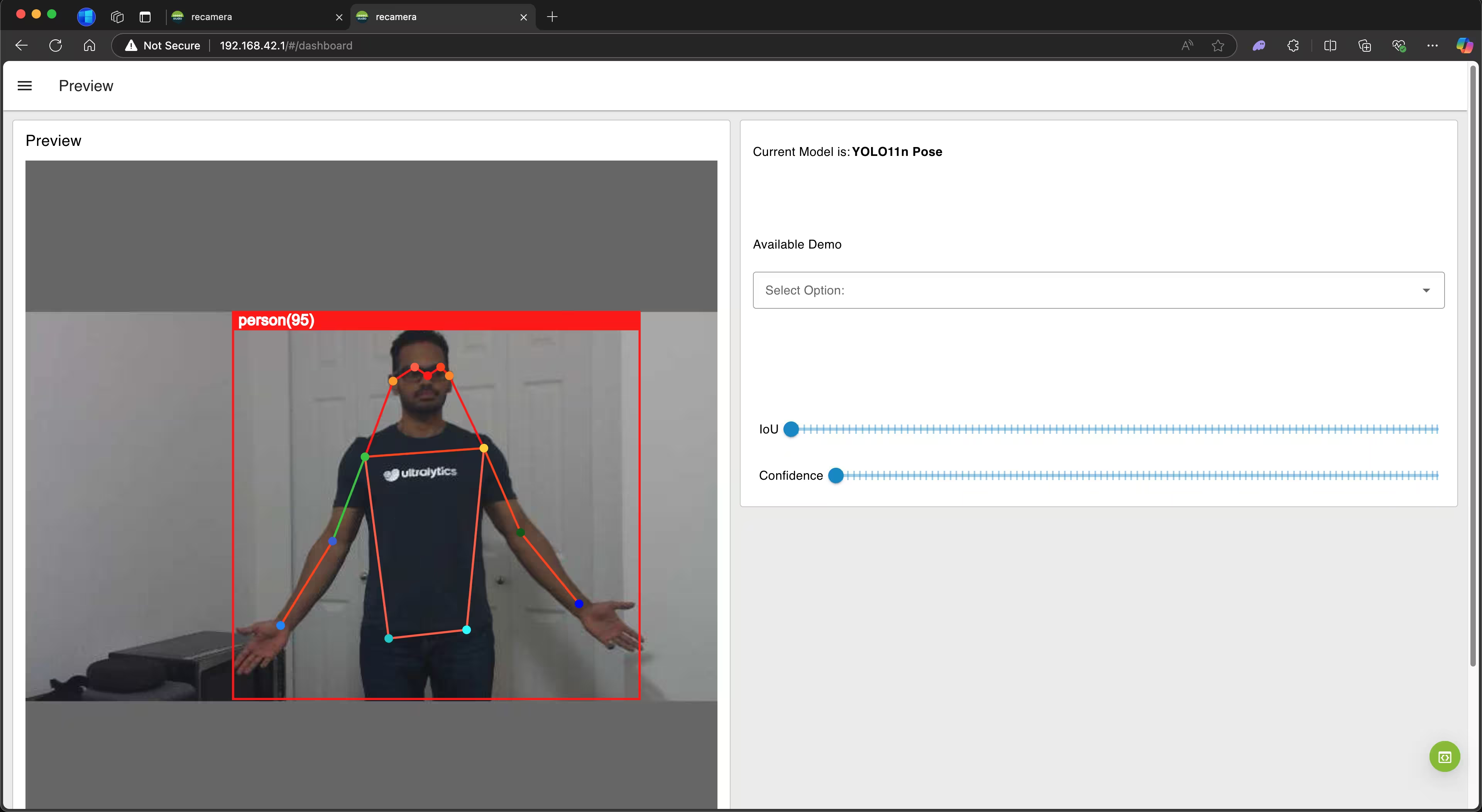

步骤 1:如果已将 reCamera 连接到网络,请在 Web 浏览器中输入 reCamera 的 IP 地址以打开 Node-RED 仪表板。如果已通过 USB 将 reCamera 连接到 PC,则可以输入 192.168.42.1。在这里您会看到 YOLO26n detect 模型默认已加载。

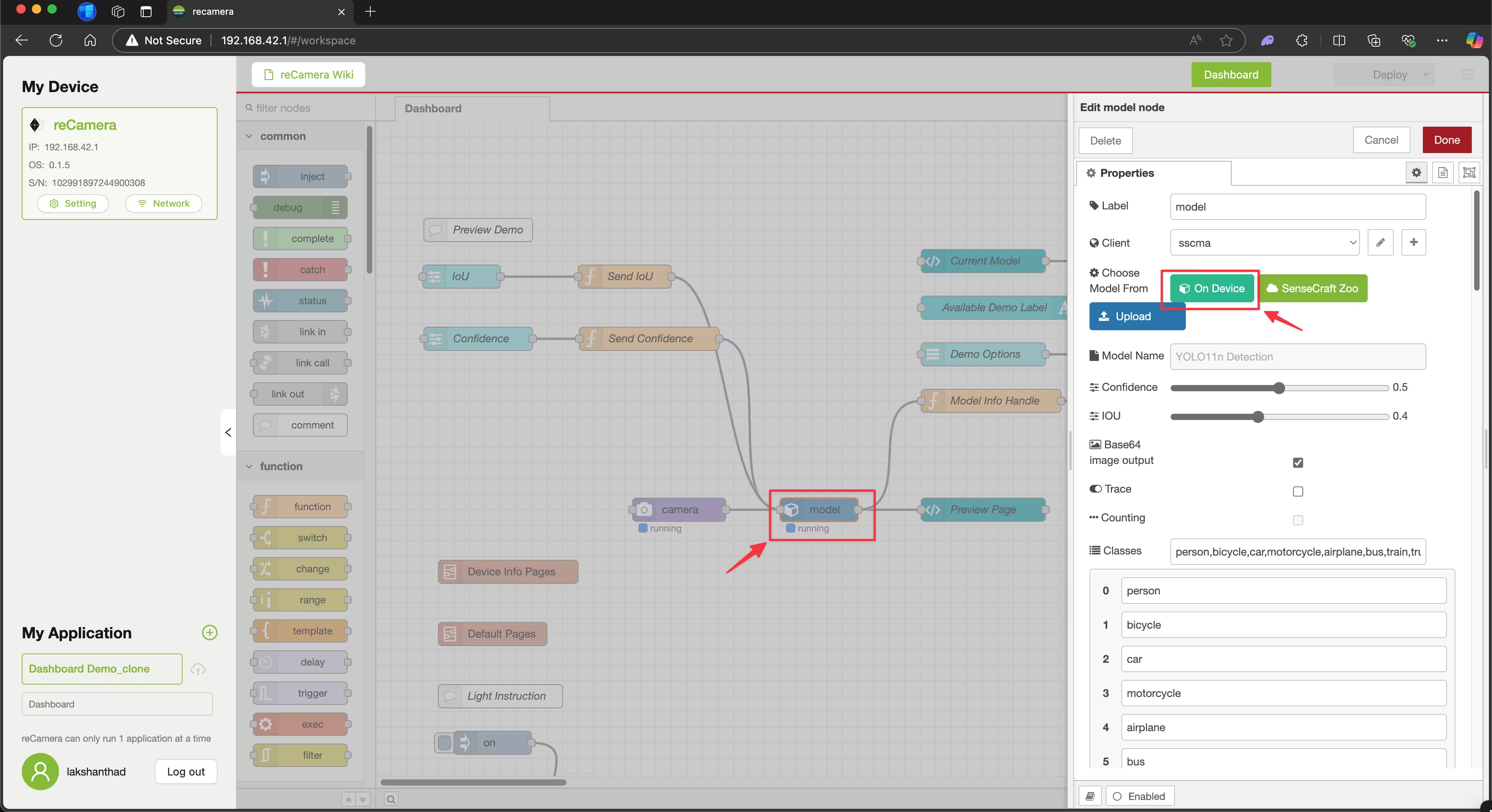

步骤 2:单击右下角的绿色圆圈以访问 Node-RED 流程编辑器。

步骤 3:点击 model 节点并单击 On Device.

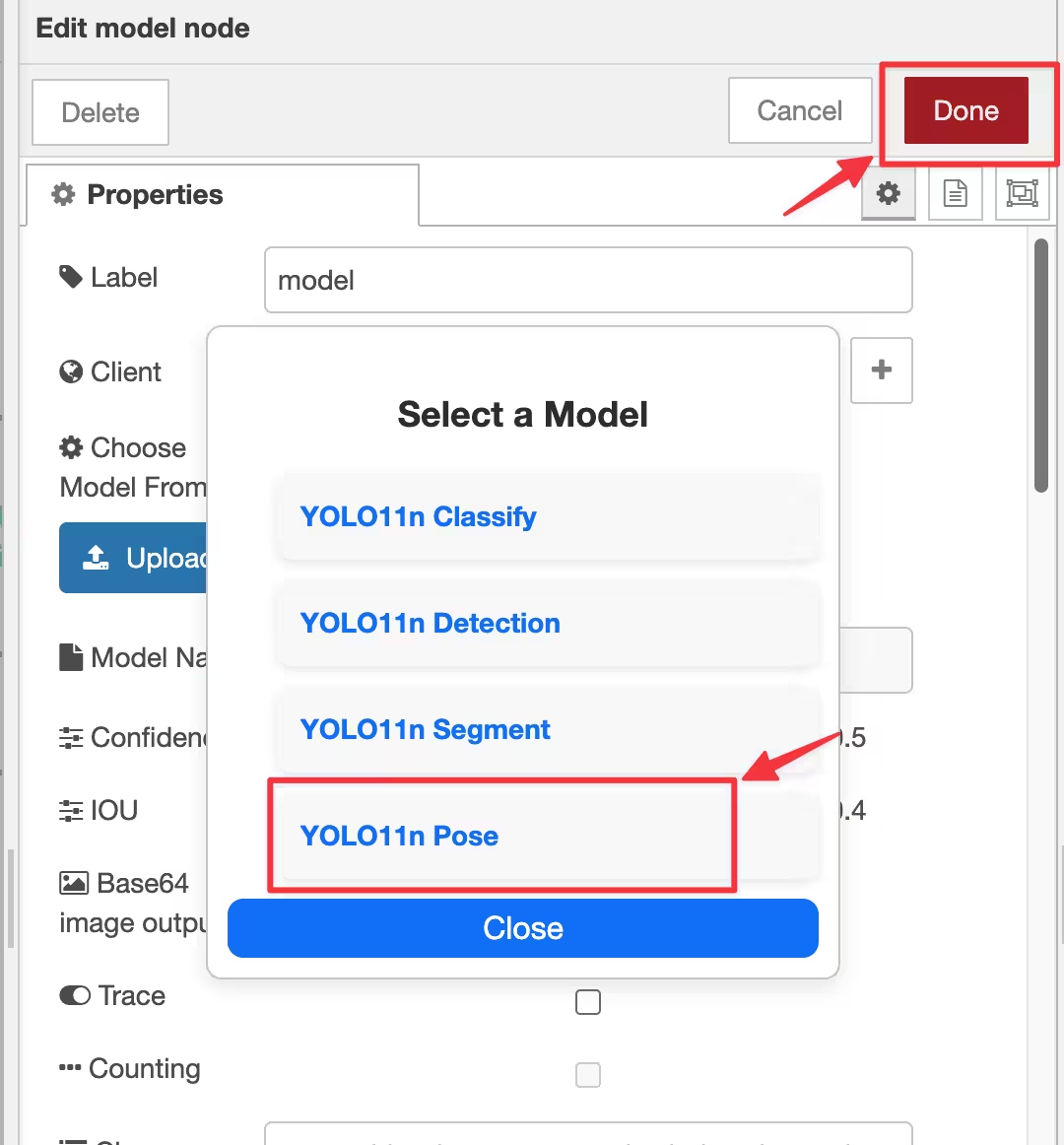

步骤 4:选择四种预装的 YOLO26n 模型之一并点击 Done。例如,这里我们将选择 YOLO26n Pose

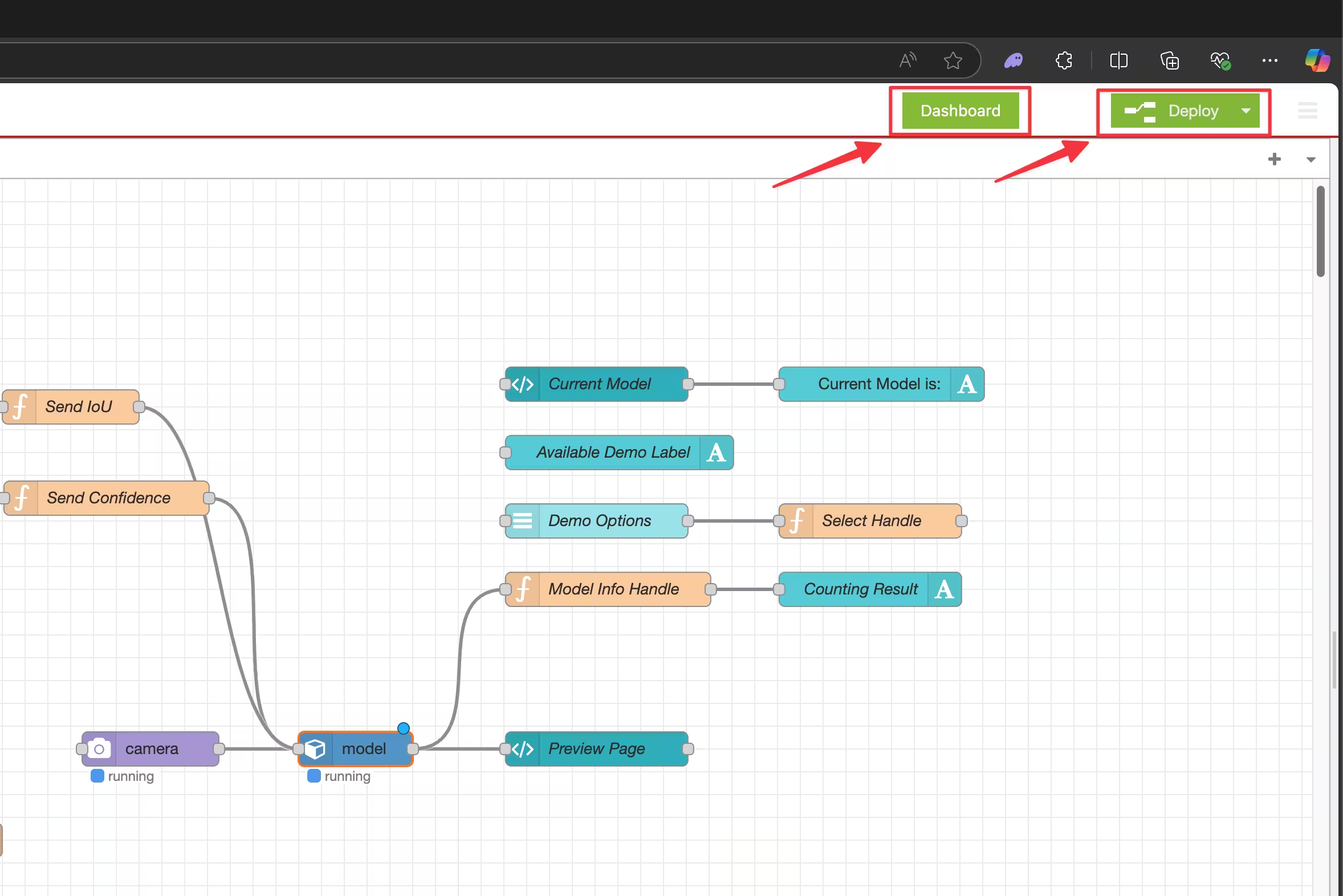

步骤 5:点击 Deploy 并在完成部署后,点击 Dashboard.

现在您将能够看到 YOLO26n 姿势估计 模型实际运行效果!

导出为 cvimodel:转换您的 YOLO26 模型

如果您想使用 自定义训练的 YOLO26 模型 与 reCamera 配合使用,请按照以下步骤操作。

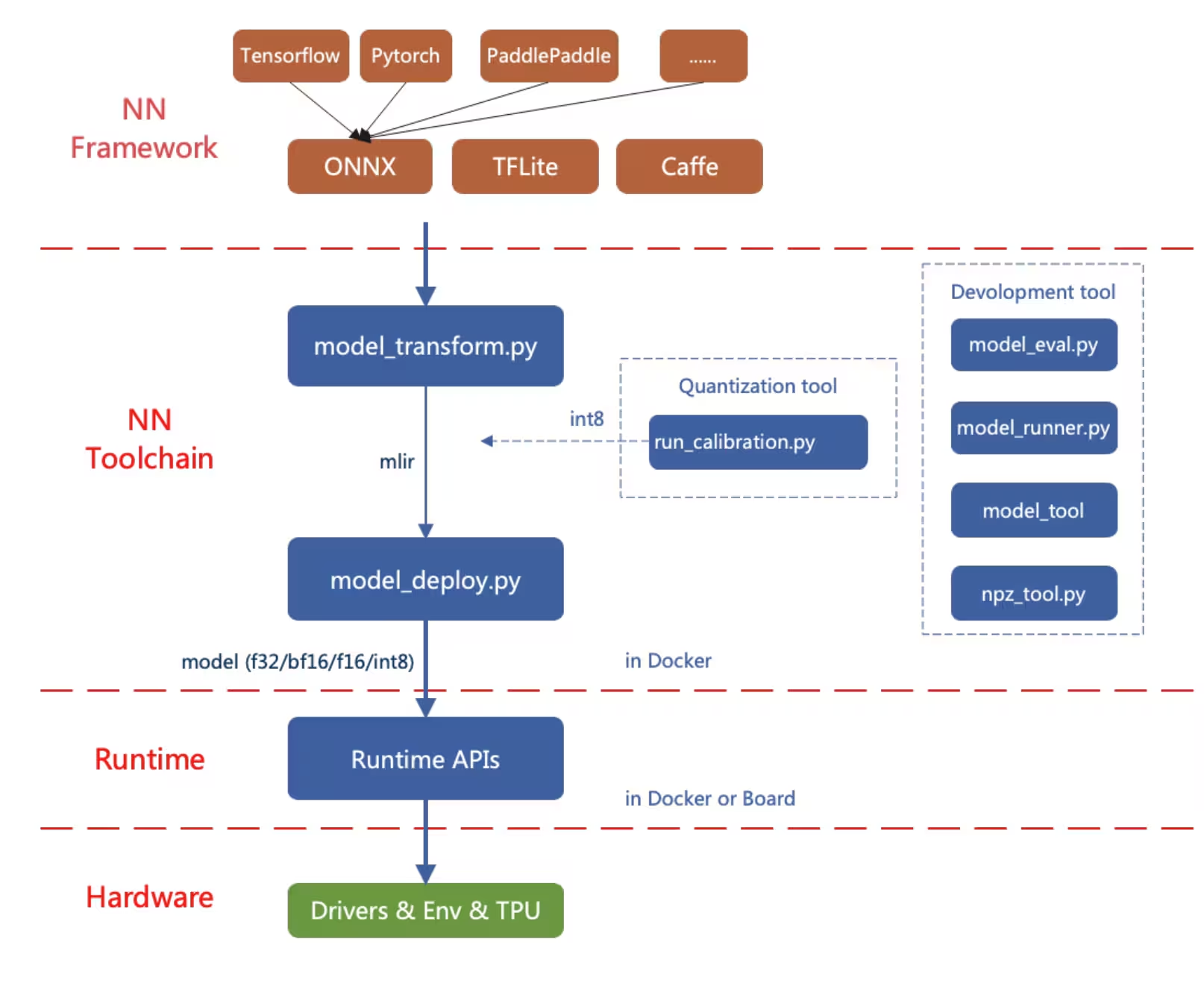

在这里,我们首先将一个 PyTorch 模型到 ONNX 然后将其转换为 MLIR 模型格式。最后, MLIR 将被转换为 cvimodel 在设备上运行推理。

导出到 ONNX

将 Ultralytics YOLO26 模型导出为 ONNX 模型格式。

安装

要安装所需的软件包,请运行:

安装

pip install ultralytics

有关安装过程的详细说明和最佳实践,请查阅我们的 Ultralytics 安装指南。在安装 YOLO26 所需的软件包时,如果您遇到任何困难,请查阅我们的 常见问题指南 以获取解决方案和提示。

用法

用法

from ultralytics import YOLO

# Load the YOLO26 model

model = YOLO("yolo26n.pt")

# Export the model to ONNX format

model.export(format="onnx", opset=14) # creates 'yolo26n.onnx'

# Export a YOLO26n PyTorch model to ONNX format

yolo export model=yolo26n.pt format=onnx opset=14 # creates 'yolo26n.onnx'

有关导出过程的更多详细信息,请访问Ultralytics 文档页面上的导出。

将 ONNX 导出为 MLIR 和 cvimodel

获得 ONNX 模型后,请参阅转换和量化 AI 模型页面,将 ONNX 模型转换为 MLIR,然后再转换为 cvimodel。

注意

我们正在积极努力将 reCamera 支持直接添加到 Ultralytics 包中,并且很快就会推出。在此期间,请查看我们的博客,了解更多关于将 Ultralytics YOLO 模型与 Seeed Studio 的 reCamera 集成的见解。

基准测试

即将推出。

reCamera 的实际应用

reCamera 先进的计算机视觉能力和模块化设计使其适用于广泛的实际场景,帮助开发者和企业轻松应对独特的挑战。

跌倒检测:reCamera专为安全和医疗保健应用设计,可以实时detect跌倒,非常适合老年护理、医院以及需要快速响应的工业环境。

个人防护设备检测:reCamera 可用于通过实时检测 PPE 合规性来确保工作场所安全。它有助于识别工人是否佩戴头盔、手套或其他安全装备,从而降低工业环境中的风险。

火灾检测: reCamera的实时处理能力使其成为工业和住宅区域火灾检测的绝佳选择,提供早期预警以防止潜在的灾难。

废物检测: 它还可以用于废物检测应用,使其成为环境监测和废物管理的绝佳工具。

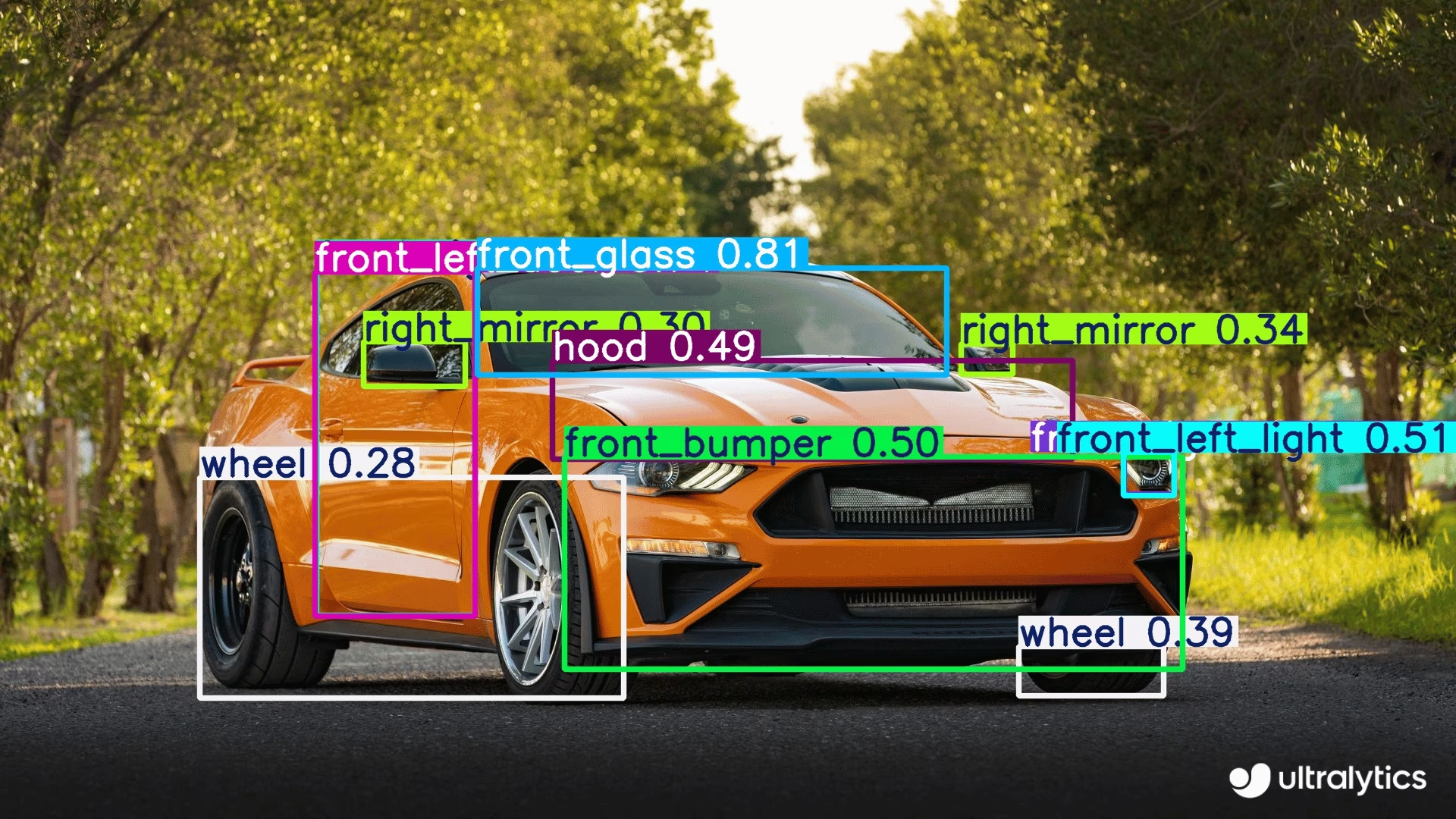

汽车零件检测: 在制造业和汽车工业中,它有助于检测和分析汽车零件,以进行质量控制、装配线监控和库存管理。

常见问题

如何首次安装和设置 reCamera?

要首次设置您的 reCamera,请按照以下步骤操作:

- 将 reCamera 连接到电源

- 使用 reCamera 快速入门指南 将其连接到您的 WiFi 网络

- 通过在 Web 浏览器中输入设备的 IP 地址来访问 Node-RED Web UI(或使用

192.168.42.1如果通过USB连接) - 通过控制面板界面立即开始使用预装的 YOLO26 模型

我可以使用自定义训练的 YOLO26 模型与 reCamera 配合使用吗?

是的,您可以使用自定义训练的 YOLO26 模型与 reCamera 配合使用。该过程包括:

- 使用以下命令将您的 PyTorch 模型导出为 ONNX 格式

model.export(format="onnx", opset=14) - 将 ONNX 模型转换为 MLIR 格式

- 将 MLIR 转换为 cvimodel 格式,以便在设备上进行推理

- 将转换后的模型加载到你的reCamera上

有关详细说明,请参阅 转换和量化 AI 模型 指南。

reCamera 与传统 IP 摄像头有何不同?

与需要外部硬件进行处理的传统 IP 摄像头不同,reCamera:

- 通过其 RISC-V SG200X 处理器将 AI 处理直接集成到设备上

- 提供 1 TOPS 的计算能力,适用于实时边缘 AI 应用

- 采用模块化设计,允许组件升级和定制

- 支持先进的视频技术,如 H.264/H.265 压缩、HDR 成像和 3D 降噪

- 预装了 Ultralytics YOLO26 模型,可立即使用

这些特性使得reCamera成为边缘AI应用的独立解决方案,无需额外的外部处理硬件。