Meituan YOLOv6

Überblick

Meituan YOLOv6, veröffentlicht im Jahr 2022, bietet ein starkes Gleichgewicht zwischen Geschwindigkeit und Genauigkeit, was es zu einer beliebten Wahl für Echtzeitanwendungen macht. Dieses Modell führt mehrere bemerkenswerte Verbesserungen an seiner Architektur und seinem Trainingsschema ein, darunter die Implementierung eines Bi-directional Concatenation (BiC)-Moduls, eine Anchor-Aided Training (AAT)-Strategie und ein verbessertes Backbone- und Neck-Design für hohe Genauigkeit auf dem COCO-Datensatz.

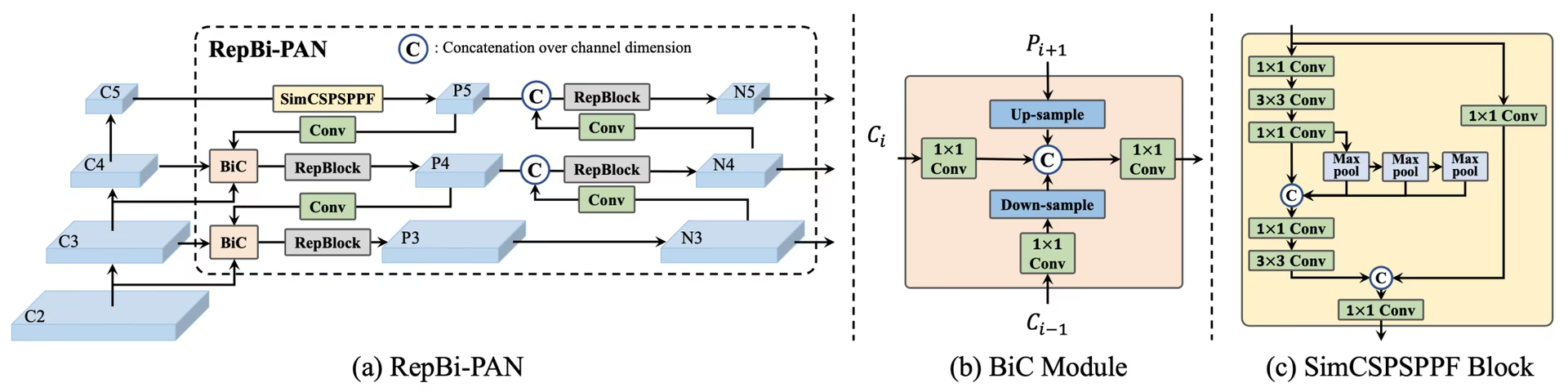

Übersicht über YOLOv6. Modellarchitekturdiagramm, das die neu gestalteten Netzwerkkomponenten und Trainingsstrategien zeigt, die zu erheblichen Leistungsverbesserungen geführt haben. (a) Der Neck von YOLOv6 (N und S sind dargestellt). Hinweis: Für M/L wird RepBlocks durch CSPStackRep ersetzt. (b) Die Struktur eines BiC-Moduls. (c) Ein SimCSPSPPF-Block. (Quelle), oder Auto-Modus mit angegebener Auslastungsfraktion (

Übersicht über YOLOv6. Modellarchitekturdiagramm, das die neu gestalteten Netzwerkkomponenten und Trainingsstrategien zeigt, die zu erheblichen Leistungsverbesserungen geführt haben. (a) Der Neck von YOLOv6 (N und S sind dargestellt). Hinweis: Für M/L wird RepBlocks durch CSPStackRep ersetzt. (b) Die Struktur eines BiC-Moduls. (c) Ein SimCSPSPPF-Block. (Quelle), oder Auto-Modus mit angegebener Auslastungsfraktion (

Hauptmerkmale

- Bidirektionales Concatenation (BiC) Modul: YOLOv6 führt ein BiC-Modul im Neck des Detektors ein, das Lokalisierungssignale verbessert und Leistungssteigerungen bei vernachlässigbarer Geschwindigkeitsminderung liefert.

- Anchor-Aided Training (AAT) Strategy: Dieses Modell schlägt AAT vor, um die Vorteile von sowohl ankerbasierten als auch ankerfreien Paradigmen zu nutzen, ohne die Inferenzeffizienz zu beeinträchtigen.

- Verbessertes Backbone- und Neck-Design: Durch die Vertiefung von YOLOv6 um eine weitere Stufe im Backbone und Neck erreichte dieses Modell bei seiner Veröffentlichung eine starke Leistung auf dem COCO-Datensatz bei hochauflösenden Eingaben.

- Selbst-Destillationsstrategie: Eine neue Selbst-Destillationsstrategie wird implementiert, um die Leistung kleinerer YOLOv6-Modelle zu steigern, indem der Hilfsregressionszweig während des Trainings verbessert und dieser bei der Inferenz entfernt wird, um einen deutlichen Geschwindigkeitsabfall zu vermeiden.

Leistungsmetriken

YOLOv6 bietet verschiedene vortrainierte Modelle mit unterschiedlichen Skalierungen:

- YOLOv6-N: 37,5 % AP auf COCO val2017 bei 1187 FPS mit NVIDIA T4 GPU.

- YOLOv6-S: 45,0 % AP bei 484 FPS.

- YOLOv6-M: 50,0 % AP bei 226 FPS.

- YOLOv6-L: 52,8 % AP bei 116 FPS.

- YOLOv6-L6: Spitzenpräzision in Echtzeit.

YOLOv6 bietet auch quantisierte Modelle für verschiedene Präzisionen sowie Modelle, die für mobile Plattformen optimiert sind.

Anwendungsbeispiele

Dieses Beispiel bietet einfache YOLOv6-Trainings- und Inferenzbeispiele. Für die vollständige Dokumentation zu diesen und weiteren Modi siehe die Dokumentationsseiten zu Predict, Train, Val und Export.

Beispiel

YOLOv6 *.yaml Dateien können an die YOLO() Klasse, um das entsprechende Modell in Python zu erstellen:

from ultralytics import YOLO

# Build a YOLOv6n model from scratch

model = YOLO("yolov6n.yaml")

# Display model information (optional)

model.info()

# Train the model on the COCO8 example dataset for 100 epochs

results = model.train(data="coco8.yaml", epochs=100, imgsz=640)

# Run inference with the YOLOv6n model on the 'bus.jpg' image

results = model("path/to/bus.jpg")

Es stehen CLI-Befehle zur Verfügung, um die Modelle direkt auszuführen:

# Build a YOLOv6n model from scratch and train it on the COCO8 example dataset for 100 epochs

yolo train model=yolov6n.yaml data=coco8.yaml epochs=100 imgsz=640

# Build a YOLOv6n model from scratch and run inference on the 'bus.jpg' image

yolo predict model=yolov6n.yaml source=path/to/bus.jpg

Unterstützte Aufgaben und Modi

Die YOLOv6-Reihe bietet eine Reihe von Modellen, die jeweils für hochleistungsfähige Objekterkennung optimiert sind. Diese Modelle decken unterschiedliche Rechenanforderungen und Genauigkeitsbedürfnisse ab, was sie vielseitig für eine Vielzahl von Anwendungen macht.

| Modell | Dateinamen | Aufgaben | Inferenz | Validierung | Training | Export |

|---|---|---|---|---|---|---|

| YOLOv6-N | yolov6n.yaml | Objekterkennung | ✅ | ✅ | ✅ | ✅ |

| YOLOv6-S | yolov6s.yaml | Objekterkennung | ✅ | ✅ | ✅ | ✅ |

| YOLOv6-M | yolov6m.yaml | Objekterkennung | ✅ | ✅ | ✅ | ✅ |

| YOLOv6-L | yolov6l.yaml | Objekterkennung | ✅ | ✅ | ✅ | ✅ |

| YOLOv6-X | yolov6x.yaml | Objekterkennung | ✅ | ✅ | ✅ | ✅ |

Diese Tabelle bietet einen detaillierten Überblick über die YOLOv6-Modellvarianten, hebt deren Fähigkeiten bei Objekterkennungsaufgaben hervor und zeigt ihre Kompatibilität mit verschiedenen Betriebsmodi wie Inferenz, Validierung, Training und Export. Diese umfassende Unterstützung stellt sicher, dass Benutzer die Fähigkeiten der YOLOv6-Modelle in einer Vielzahl von Objekterkennungsszenarien voll ausschöpfen können.

Zitate und Danksagungen

Wir möchten die Autoren für ihre bedeutenden Beiträge im Bereich der Echtzeit-Objekterkennung würdigen:

@misc{li2023yolov6,

title={YOLOv6 v3.0: A Full-Scale Reloading},

author={Chuyi Li and Lulu Li and Yifei Geng and Hongliang Jiang and Meng Cheng and Bo Zhang and Zaidan Ke and Xiaoming Xu and Xiangxiang Chu},

year={2023},

eprint={2301.05586},

archivePrefix={arXiv},

primaryClass={cs.CV}

}

Das Original-YOLOv6-Paper ist auf arXiv zu finden. Die Autoren haben ihre Arbeit öffentlich zugänglich gemacht, und die Codebasis kann auf GitHub abgerufen werden. Wir schätzen ihre Bemühungen, das Feld voranzubringen und ihre Arbeit der breiteren Gemeinschaft zugänglich zu machen.

FAQ

Was ist Meituan YOLOv6 und was macht es einzigartig?

Meituan YOLOv6, veröffentlicht im Jahr 2022, ist ein Objektdetektor, der Geschwindigkeit und Genauigkeit ausbalanciert und für Echtzeitanwendungen konzipiert wurde. Er weist bemerkenswerte architektonische Verbesserungen auf, wie das Bi-directional Concatenation (BiC)-Modul und eine Anchor-Aided Training (AAT)-Strategie. Diese Innovationen bieten erhebliche Leistungssteigerungen bei minimaler Geschwindigkeitsminderung, was YOLOv6 zu einer wettbewerbsfähigen Wahl für Objektdetektionsaufgaben macht.

Wie verbessert das Bi-directional Concatenation (BiC) Modul in YOLOv6 die Leistung?

Das Bi-directional Concatenation (BiC)-Modul in YOLOv6 verbessert die Lokalisierungssignale im Neck des Detektors und liefert Leistungsverbesserungen mit vernachlässigbaren Geschwindigkeitseinbußen. Dieses Modul kombiniert effektiv verschiedene Feature Maps und erhöht die Fähigkeit des Modells, Objekte präzise zu detecten. Weitere Details zu den Funktionen von YOLOv6 finden Sie im Abschnitt „Key Features“.

Wie kann ich ein YOLOv6-Modell mit Ultralytics trainieren?

Sie können ein YOLOv6-Modell mit Ultralytics und einfachen Python- oder CLI-Befehlen trainieren. Zum Beispiel:

Beispiel

from ultralytics import YOLO

# Build a YOLOv6n model from scratch

model = YOLO("yolov6n.yaml")

# Train the model on the COCO8 example dataset for 100 epochs

results = model.train(data="coco8.yaml", epochs=100, imgsz=640)

yolo train model=yolov6n.yaml data=coco8.yaml epochs=100 imgsz=640

Weitere Informationen finden Sie auf der Seite Trainieren.

Welche verschiedenen Versionen von YOLOv6 gibt es und welche Leistungsmetriken weisen sie auf?

YOLOv6 bietet mehrere Versionen, die jeweils für unterschiedliche Leistungsanforderungen optimiert sind:

- YOLOv6-N: 37,5 % AP bei 1187 FPS

- YOLOv6-S: 45,0 % AP bei 484 FPS

- YOLOv6-M: 50,0 % AP bei 226 FPS

- YOLOv6-L: 52.8% AP bei 116 FPS

- YOLOv6-L6: Spitzenpräzision in Echtzeitszenarien

Diese Modelle werden auf dem COCO-Dataset unter Verwendung einer NVIDIA T4 GPU evaluiert. Weitere Informationen zu Leistungsmetriken finden Sie im Abschnitt Leistungsmetriken.

Wie profitiert YOLOv6 von der Anchor-Aided Training (AAT)-Strategie?

Anchor-Aided Training (AAT) in YOLOv6 kombiniert Elemente von ankerbasierten und ankerfreien Ansätzen, wodurch die Detektionsfähigkeiten des Modells verbessert werden, ohne die Inferenz-Effizienz zu beeinträchtigen. Diese Strategie nutzt Anker während des Trainings, um Bounding-Box-Vorhersagen zu verbessern, was YOLOv6 bei verschiedenen Objektdetektionsaufgaben effektiv macht.

Welche Betriebsmodi werden von YOLOv6-Modellen in Ultralytics unterstützt?

YOLOv6 unterstützt verschiedene Betriebsmodi, darunter Inferenz, Validierung, Training und Export. Diese Flexibilität ermöglicht es Benutzern, die Fähigkeiten des Modells in verschiedenen Szenarien voll auszuschöpfen. Eine detaillierte Übersicht über jeden Modus finden Sie im Abschnitt „Supported Tasks and Modes“.