Objekterkennung

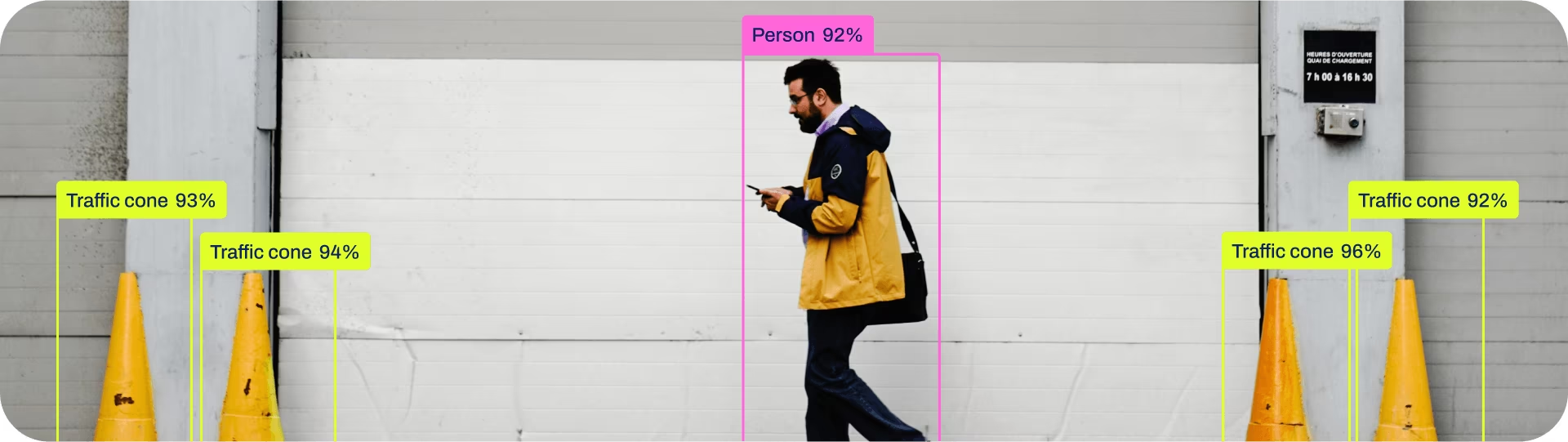

Objekterkennung ist eine Aufgabe, bei der die Position und Klasse von Objekten in einem Bild oder Videostream identifiziert werden.

Die Ausgabe eines Objektdetektors ist ein Satz von Begrenzungsrahmen, die die Objekte im Bild umschließen, zusammen mit Klassenbezeichnungen und Konfidenzwerten für jeden Rahmen. Die Objekterkennung ist eine gute Wahl, wenn Sie Objekte von Interesse in einer Szene identifizieren müssen, aber nicht genau wissen müssen, wo sich das Objekt befindet oder wie seine genaue Form ist.

Ansehen: Objekterkennung mit vortrainiertem Ultralytics YOLO Modell.

Tipp

YOLO26 Detect-Modelle sind die Standard-YOLO26-Modelle, d.h., yolo26n.pt, und sind vortrainiert auf COCO.

Modelle

Hier werden vortrainierte YOLO26 Detect-Modelle gezeigt. Detect-, Segment- und Pose-Modelle sind auf dem COCO-Datensatz vortrainiert, während Classify-Modelle auf dem ImageNet-Datensatz vortrainiert sind.

Modelle werden bei der ersten Verwendung automatisch vom neuesten Ultralytics Release heruntergeladen.

| Modell | Größe (Pixel) | mAPval 50-95 | mAPval 50-95(e2e) | Geschwindigkeit CPU ONNX (ms) | Geschwindigkeit T4 TensorRT10 (ms) | Parameter (M) | FLOPs (B) |

|---|---|---|---|---|---|---|---|

| YOLO26n | 640 | 40.9 | 40.1 | 38.9 ± 0.7 | 1.7 ± 0.0 | 2.4 | 5.4 |

| YOLO26s | 640 | 48.6 | 47.8 | 87.2 ± 0.9 | 2.5 ± 0.0 | 9.5 | 20.7 |

| YOLO26m | 640 | 53.1 | 52.5 | 220.0 ± 1.4 | 4.7 ± 0.1 | 20.4 | 68.2 |

| YOLO26l | 640 | 55.0 | 54.4 | 286.2 ± 2.0 | 6.2 ± 0.2 | 24.8 | 86.4 |

| YOLO26x | 640 | 57.5 | 56.9 | 525.8 ± 4.0 | 11.8 ± 0.2 | 55.7 | 193.9 |

- mAPval Werte gelten für Single-Model, Single-Scale auf COCO val2017 Datensatz.

Reproduzieren durchyolo val detect data=coco.yaml device=0 - Geschwindigkeit gemittelt über COCO-Validierungsbilder unter Verwendung eines Amazon EC2 P4d Instanz.

Reproduzieren durchyolo val detect data=coco.yaml batch=1 device=0|cpu

Trainieren

Trainieren Sie YOLO26n auf dem COCO8-Datensatz für 100 Epochen bei einer Bildgröße von 640. Eine vollständige Liste der verfügbaren Argumente finden Sie auf der Konfigurationsseite.

Beispiel

from ultralytics import YOLO

# Load a model

model = YOLO("yolo26n.yaml") # build a new model from YAML

model = YOLO("yolo26n.pt") # load a pretrained model (recommended for training)

model = YOLO("yolo26n.yaml").load("yolo26n.pt") # build from YAML and transfer weights

# Train the model

results = model.train(data="coco8.yaml", epochs=100, imgsz=640)

# Build a new model from YAML and start training from scratch

yolo detect train data=coco8.yaml model=yolo26n.yaml epochs=100 imgsz=640

# Start training from a pretrained *.pt model

yolo detect train data=coco8.yaml model=yolo26n.pt epochs=100 imgsz=640

# Build a new model from YAML, transfer pretrained weights to it and start training

yolo detect train data=coco8.yaml model=yolo26n.yaml pretrained=yolo26n.pt epochs=100 imgsz=640

Datensatzformat

Das YOLO-Erkennungsdatensatzformat finden Sie detailliert in der Datensatz-Anleitung. Um Ihren bestehenden Datensatz von anderen Formaten (wie COCO usw.) in das YOLO-Format zu konvertieren, verwenden Sie bitte das JSON2YOLO-Tool von Ultralytics.

Validieren

Trainiertes YOLO26n-Modell validieren Genauigkeit auf dem COCO8-Datensatz. Es sind keine Argumente erforderlich, da die model behält sein Training data und Argumente als Modellattribute.

Beispiel

from ultralytics import YOLO

# Load a model

model = YOLO("yolo26n.pt") # load an official model

model = YOLO("path/to/best.pt") # load a custom model

# Validate the model

metrics = model.val() # no arguments needed, dataset and settings remembered

metrics.box.map # map50-95

metrics.box.map50 # map50

metrics.box.map75 # map75

metrics.box.maps # a list containing mAP50-95 for each category

yolo detect val model=yolo26n.pt # val official model

yolo detect val model=path/to/best.pt # val custom model

Vorhersagen

Verwenden Sie ein trainiertes YOLO26n-Modell, um Inferenzen auf Bildern durchzuführen.

Beispiel

from ultralytics import YOLO

# Load a model

model = YOLO("yolo26n.pt") # load an official model

model = YOLO("path/to/best.pt") # load a custom model

# Predict with the model

results = model("https://ultralytics.com/images/bus.jpg") # predict on an image

# Access the results

for result in results:

xywh = result.boxes.xywh # center-x, center-y, width, height

xywhn = result.boxes.xywhn # normalized

xyxy = result.boxes.xyxy # top-left-x, top-left-y, bottom-right-x, bottom-right-y

xyxyn = result.boxes.xyxyn # normalized

names = [result.names[cls.item()] for cls in result.boxes.cls.int()] # class name of each box

confs = result.boxes.conf # confidence score of each box

yolo detect predict model=yolo26n.pt source='https://ultralytics.com/images/bus.jpg' # predict with official model

yolo detect predict model=path/to/best.pt source='https://ultralytics.com/images/bus.jpg' # predict with custom model

Vollständige predict Details zum Modus finden Sie auf der Vorhersagen Seite.

Export

Exportieren Sie ein YOLO26n-Modell in ein anderes Format wie ONNX, CoreML usw.

Beispiel

from ultralytics import YOLO

# Load a model

model = YOLO("yolo26n.pt") # load an official model

model = YOLO("path/to/best.pt") # load a custom-trained model

# Export the model

model.export(format="onnx")

yolo export model=yolo26n.pt format=onnx # export official model

yolo export model=path/to/best.pt format=onnx # export custom-trained model

Die verfügbaren YOLO26-Exportformate sind in der folgenden Tabelle aufgeführt. Sie können in jedes Format exportieren mit dem format Argument, d.h. format='onnx' oder format='engine'. Sie können direkt auf exportierten Modellen vorhersagen oder validieren, d.h., yolo predict model=yolo26n.onnx. Anwendungsbeispiele werden nach Abschluss des Exports für Ihr Modell angezeigt.

| Format | format Argument | Modell | Metadaten | Argumente |

|---|---|---|---|---|

| PyTorch | - | yolo26n.pt | ✅ | - |

| TorchScript | torchscript | yolo26n.torchscript | ✅ | imgsz, half, dynamic, optimize, nms, batch, device |

| ONNX | onnx | yolo26n.onnx | ✅ | imgsz, half, dynamic, simplify, opset, nms, batch, device |

| OpenVINO | openvino | yolo26n_openvino_model/ | ✅ | imgsz, half, dynamic, int8, nms, batch, data, fraction, device |

| TensorRT | engine | yolo26n.engine | ✅ | imgsz, half, dynamic, simplify, workspace, int8, nms, batch, data, fraction, device |

| CoreML | coreml | yolo26n.mlpackage | ✅ | imgsz, dynamic, half, int8, nms, batch, device |

| TF SavedModel | saved_model | yolo26n_saved_model/ | ✅ | imgsz, keras, int8, nms, batch, device |

| TF GraphDef | pb | yolo26n.pb | ❌ | imgsz, batch, device |

| TF Lite | tflite | yolo26n.tflite | ✅ | imgsz, half, int8, nms, batch, data, fraction, device |

| TF Edge TPU | edgetpu | yolo26n_edgetpu.tflite | ✅ | imgsz, device |

| TF.js | tfjs | yolo26n_web_model/ | ✅ | imgsz, half, int8, nms, batch, device |

| PaddlePaddle | paddle | yolo26n_paddle_model/ | ✅ | imgsz, batch, device |

| MNN | mnn | yolo26n.mnn | ✅ | imgsz, batch, int8, half, device |

| NCNN | ncnn | yolo26n_ncnn_model/ | ✅ | imgsz, half, batch, device |

| IMX500 | imx | yolo26n_imx_model/ | ✅ | imgsz, int8, data, fraction, device |

| RKNN | rknn | yolo26n_rknn_model/ | ✅ | imgsz, batch, name, device |

| ExecuTorch | executorch | yolo26n_executorch_model/ | ✅ | imgsz, device |

| Axelera | axelera | yolo26n_axelera_model/ | ✅ | imgsz, int8, data, fraction, device |

Vollständige export Details auf der Export Seite.

FAQ

Wie trainiere ich ein YOLO26-Modell auf meinem benutzerdefinierten Datensatz?

Das Training eines YOLO26-Modells auf einem benutzerdefinierten Datensatz umfasst einige Schritte:

- Datensatz vorbereiten: Stellen Sie sicher, dass sich Ihr Datensatz im YOLO-Format befindet. Anleitungen finden Sie in unserem Datensatz-Leitfaden.

- Modell laden: Verwenden Sie die Ultralytics YOLO-Bibliothek, um ein vortrainiertes Modell zu laden oder ein neues Modell aus einer yaml-Datei zu erstellen.

- Modell trainieren: Führen Sie die

trainMethode in python oder denyolo detect trainBefehl in der CLI aus.

Beispiel

from ultralytics import YOLO

# Load a pretrained model

model = YOLO("yolo26n.pt")

# Train the model on your custom dataset

model.train(data="my_custom_dataset.yaml", epochs=100, imgsz=640)

yolo detect train data=my_custom_dataset.yaml model=yolo26n.pt epochs=100 imgsz=640

Detaillierte Konfigurationsoptionen finden Sie auf der Seite Konfiguration.

Welche vortrainierten Modelle sind in YOLO26 verfügbar?

Ultralytics YOLO26 bietet verschiedene vortrainierte Modelle für Objekterkennung, Segmentierung und Posenschätzung. Diese Modelle sind auf dem COCO-Datensatz oder ImageNet für Klassifizierungsaufgaben vortrainiert. Hier sind einige der verfügbaren Modelle:

Eine detaillierte Liste und Leistungsmetriken finden Sie im Abschnitt Modelle.

Wie kann ich die Genauigkeit meines trainierten YOLO-Modells validieren?

Um die Genauigkeit Ihres trainierten YOLO26-Modells zu validieren, können Sie die .val() Methode in python oder den yolo detect val Befehl in der CLI. Dies liefert Metriken wie mAP50-95, mAP50 und weitere.

Beispiel

from ultralytics import YOLO

# Load the model

model = YOLO("path/to/best.pt")

# Validate the model

metrics = model.val()

print(metrics.box.map) # mAP50-95

yolo detect val model=path/to/best.pt

Weitere Informationen zur Validierung finden Sie auf der Seite Val.

In welche Formate kann ich ein YOLO26-Modell exportieren?

Ultralytics YOLO26 ermöglicht den Export von Modellen in verschiedene Formate wie ONNX, TensorRT, CoreML und weitere, um die Kompatibilität über verschiedene Plattformen und Geräte hinweg zu gewährleisten.

Beispiel

from ultralytics import YOLO

# Load the model

model = YOLO("yolo26n.pt")

# Export the model to ONNX format

model.export(format="onnx")

yolo export model=yolo26n.pt format=onnx

Eine vollständige Liste der unterstützten Formate und Anweisungen finden Sie auf der Seite Export.

Warum sollte ich Ultralytics YOLO26 für die Objekterkennung verwenden?

Ultralytics YOLO26 wurde entwickelt, um eine hochmoderne Leistung für Objekterkennung, Segmentierung und Posenschätzung zu bieten. Hier sind einige der wichtigsten Vorteile:

- Vortrainierte Modelle: Nutzen Sie Modelle, die auf populären Datensätzen wie COCO und ImageNet vortrainiert wurden, für eine schnellere Entwicklung.

- Hohe Genauigkeit: Erzielt beeindruckende mAP-Werte und gewährleistet eine zuverlässige Objekterkennung.

- Geschwindigkeit: Optimiert für Echtzeit-Inferenz und somit ideal für Anwendungen, die eine schnelle Verarbeitung erfordern.

- Flexibilität: Exportieren Sie Modelle in verschiedene Formate wie ONNX und TensorRT für den Einsatz auf verschiedenen Plattformen.

Entdecken Sie unseren Blog für Anwendungsfälle und Erfolgsgeschichten, die YOLO26 in Aktion zeigen.