Intel OpenVINO Export

In diesem Leitfaden behandeln wir den Export von YOLO26-Modellen in das OpenVINO-Format, das eine bis zu 3-fache CPU-Beschleunigung sowie die Beschleunigung der YOLO-Inferenz auf Intel GPU- und NPU-Hardware bieten kann.

OpenVINO, kurz für Open Visual Inference & Neural Network Optimization Toolkit, ist ein umfassendes Toolkit zur Optimierung und Bereitstellung von KI-Inferenzmodellen. Auch wenn der Name Visual enthält, unterstützt OpenVINO auch verschiedene zusätzliche Aufgaben wie Sprache, Audio, Zeitreihen usw.

Ansehen: Wie man Ultralytics YOLO26 in das Intel OpenVINO-Format für schnellere Inferenz exportiert 🚀

Anwendungsbeispiele

Exportieren Sie ein YOLO26n-Modell in das OpenVINO-Format und führen Sie die Inferenz mit dem exportierten Modell aus.

Beispiel

from ultralytics import YOLO

# Load a YOLO26n PyTorch model

model = YOLO("yolo26n.pt")

# Export the model

model.export(format="openvino") # creates 'yolo26n_openvino_model/'

# Load the exported OpenVINO model

ov_model = YOLO("yolo26n_openvino_model/")

# Run inference

results = ov_model("https://ultralytics.com/images/bus.jpg")

# Run inference with specified device, available devices: ["intel:gpu", "intel:npu", "intel:cpu"]

results = ov_model("https://ultralytics.com/images/bus.jpg", device="intel:gpu")

# Export a YOLO26n PyTorch model to OpenVINO format

yolo export model=yolo26n.pt format=openvino # creates 'yolo26n_openvino_model/'

# Run inference with the exported model

yolo predict model=yolo26n_openvino_model source='https://ultralytics.com/images/bus.jpg'

# Run inference with specified device, available devices: ["intel:gpu", "intel:npu", "intel:cpu"]

yolo predict model=yolo26n_openvino_model source='https://ultralytics.com/images/bus.jpg' device="intel:gpu"

Export-Argumente

| Argument | Typ | Standard | Beschreibung |

|---|---|---|---|

format | str | 'openvino' | Zielformat für das exportierte Modell, das die Kompatibilität mit verschiedenen Deployment-Umgebungen definiert. |

imgsz | int oder tuple | 640 | Gewünschte Bildgröße für die Modelleingabe. Kann eine ganze Zahl für quadratische Bilder oder ein Tupel (height, width) für bestimmte Abmessungen sein. |

half | bool | False | Aktiviert die FP16-Quantisierung (halbe Präzision), wodurch die Modellgröße reduziert und potenziell die Inferenz auf unterstützter Hardware beschleunigt wird. |

int8 | bool | False | Aktiviert die INT8-Quantisierung, wodurch das Modell weiter komprimiert und die Inferenz mit minimalem Genauigkeitsverlust beschleunigt wird, hauptsächlich für Edge-Geräte. |

dynamic | bool | False | Ermöglicht dynamische Eingabegrößen, wodurch die Flexibilität bei der Verarbeitung unterschiedlicher Bilddimensionen erhöht wird. |

nms | bool | False | Fügt Non-Maximum Suppression (NMS) hinzu, unerlässlich für eine genaue und effiziente Detektions-Nachbearbeitung. |

batch | int | 1 | Gibt die Batch-Inferenzgröße des Exportmodells oder die maximale Anzahl von Bildern an, die das exportierte Modell gleichzeitig verarbeitet predict Modus. |

data | str | 'coco8.yaml' | Pfad zu der Datensatz Konfigurationsdatei (Standard: coco8.yaml), die für die Quantisierung unerlässlich sind. |

fraction | float | 1.0 | Gibt den Bruchteil des Datensatzes an, der für die INT8-Quantisierungskalibrierung verwendet werden soll. Ermöglicht die Kalibrierung auf einer Teilmenge des vollständigen Datensatzes, was für Experimente oder bei begrenzten Ressourcen nützlich ist. Wenn nicht mit aktiviertem INT8 angegeben, wird der vollständige Datensatz verwendet. |

Weitere Informationen zum Exportprozess finden Sie auf der Ultralytics-Dokumentationsseite zum Exportieren.

Warnung

OpenVINO™ ist mit den meisten Intel®-Prozessoren kompatibel, aber um eine optimale Leistung zu gewährleisten:

OpenVINO™-Unterstützung überprüfen: Prüfen Sie, ob Ihr Intel®-Chip offiziell von OpenVINO™ unterstützt wird, mithilfe der Kompatibilitätsliste von Intel.

Identifizieren Sie Ihren Beschleuniger. Stellen Sie fest, ob Ihr Prozessor eine integrierte NPU (Neural Processing Unit) oder GPU (integrierte GPU) enthält, indem Sie Intels Hardware-Handbuch konsultieren.

Installieren Sie die neuesten Treiber. Wenn Ihr Chip eine NPU oder GPU unterstützt, diese aber von OpenVINO™ nicht erkannt wird, müssen Sie möglicherweise die zugehörigen Treiber installieren oder aktualisieren. Befolgen Sie die Anweisungen zur Treiberinstallation, um die volle Beschleunigung zu aktivieren.

Durch Befolgen dieser drei Schritte stellen Sie sicher, dass OpenVINO™ optimal auf Ihrer Intel®-Hardware läuft.

Vorteile von OpenVINO

- Performance: OpenVINO bietet hochleistungsfähige Inferenz, indem es die Leistung von Intel-CPUs, integrierten und diskreten GPUs und FPGAs nutzt.

- Unterstützung für heterogene Ausführung: OpenVINO bietet eine API, mit der man einmal schreiben und auf jeder unterstützten Intel Hardware (CPU, GPU, FPGA, VPU usw.) bereitstellen kann.

- Modelloptimierer: OpenVINO bietet einen Modelloptimierer, der Modelle aus gängigen Deep-Learning-Frameworks wie PyTorch, TensorFlow, TensorFlow Lite, Keras, ONNX, PaddlePaddle und Caffe importiert, konvertiert und optimiert.

- Einfache Bedienung: Das Toolkit enthält mehr als 80 Tutorial-Notebooks (einschließlich YOLOv8-Optimierung), die verschiedene Aspekte des Toolkits vermitteln.

OpenVINO Exportstruktur

Wenn Sie ein Modell in das OpenVINO-Format exportieren, resultiert dies in einem Verzeichnis mit folgendem Inhalt:

- XML-Datei: Beschreibt die Netzwerktopologie.

- BIN-Datei: Enthält die binären Daten für Gewichte und Biases.

- Mapping-Datei: Enthält die Zuordnung der ursprünglichen Modell-Output-Tensoren zu OpenVINO-Tensor-Namen.

Sie können diese Dateien verwenden, um Inferenz mit der OpenVINO Inference Engine auszuführen.

Verwendung des OpenVINO-Exports bei der Bereitstellung

Sobald Ihr Modell erfolgreich in das OpenVINO-Format exportiert wurde, haben Sie zwei Hauptoptionen für die Ausführung von Inferenz:

Verwenden Sie den

ultralyticspackage, das eine High-Level-API bereitstellt und die OpenVINO-Runtime umschließt.Verwenden Sie die native

openvinopackage für eine erweiterte oder angepasste Steuerung des Inferenzverhaltens.

Inferenz mit Ultralytics

Das Ultralytics-Paket ermöglicht es Ihnen, auf einfache Weise Inferenz mit dem exportierten OpenVINO-Modell über die Predict-Methode auszuführen. Sie können auch das Zielgerät angeben (z. B. intel:gpu, intel:npu, intel:cpu) mit dem Geräteargument.

from ultralytics import YOLO

# Load the exported OpenVINO model

ov_model = YOLO("yolo26n_openvino_model/") # the path of your exported OpenVINO model

# Run inference with the exported model

ov_model.predict(device="intel:gpu") # specify the device you want to run inference on

Dieser Ansatz ist ideal für schnelles Prototyping oder Deployment, wenn Sie keine vollständige Kontrolle über die Inferenzpipeline benötigen.

Inferenz mit OpenVINO Runtime

Die OpenVINO Runtime bietet eine einheitliche API für die Inferenz über alle unterstützten Intel-Hardware hinweg. Sie bietet auch erweiterte Funktionen wie Lastausgleich über Intel-Hardware und asynchrone Ausführung. Für weitere Informationen zur Ausführung der Inferenz siehe die YOLO26-Notebooks.

Denken Sie daran, dass Sie die XML- und BIN-Dateien sowie alle anwendungsspezifischen Einstellungen wie Eingabegröße, Skalierungsfaktor für die Normalisierung usw. benötigen, um das Modell mit der Runtime korrekt einzurichten und zu verwenden.

In Ihrer Bereitstellungsanwendung würden Sie typischerweise die folgenden Schritte durchführen:

- OpenVINO initialisieren durch Erstellen

core = Core(). - Laden Sie das Modell mit dem

core.read_model()Methode. - Modell kompilieren mit dem

core.compile_model()Funktion. - Bereiten Sie die Eingabe vor (Bild, Text, Audio usw.).

- Inferenz ausführen mit

compiled_model(input_data).

Weitere detaillierte Schritte und Code-Snippets finden Sie in der OpenVINO-Dokumentation oder im API-Tutorial.

OpenVINO YOLO11 Benchmarks

Das Ultralytics-Team hat YOLO11 über verschiedene Modellformate und Genauigkeit hinweg einem Benchmark unterzogen und dabei Geschwindigkeit und Präzision auf verschiedenen, mit OpenVINO kompatiblen Intel-Geräten bewertet.

Hinweis

Die folgenden Benchmark-Ergebnisse dienen als Referenz und können je nach der genauen Hardware- und Softwarekonfiguration eines Systems sowie der aktuellen Auslastung des Systems zum Zeitpunkt der Durchführung der Benchmarks variieren.

Alle Benchmarks werden ausgeführt mit openvino Python-Paketversion 2025.1.0.

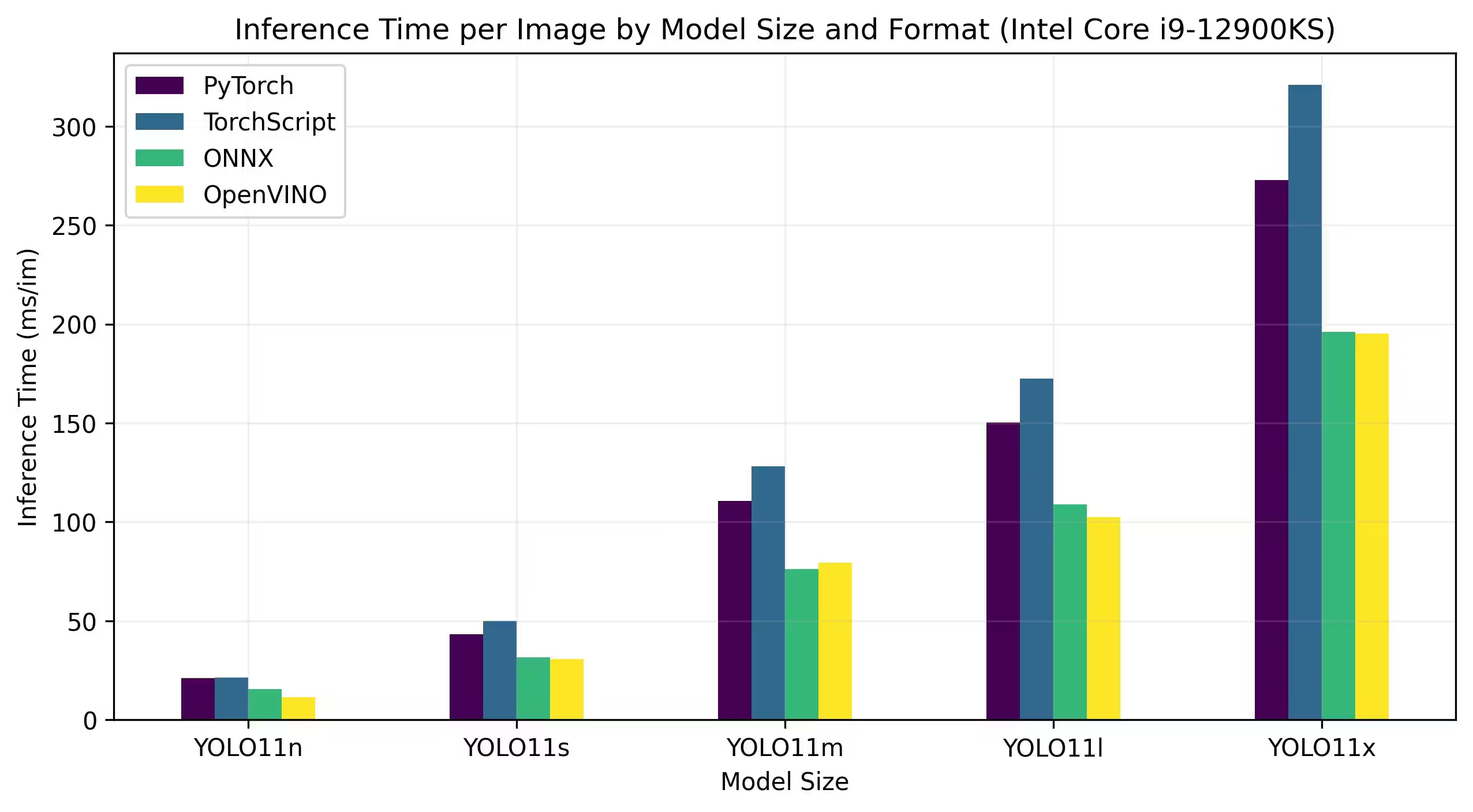

Intel Core CPU

Die Intel® Core®-Serie ist eine Reihe von Hochleistungsprozessoren von Intel. Die Produktreihe umfasst Core i3 (Einsteigerklasse), Core i5 (Mittelklasse), Core i7 (High-End) und Core i9 (extreme Leistung). Jede Serie ist auf unterschiedliche Rechenanforderungen und Budgets zugeschnitten, von alltäglichen Aufgaben bis hin zu anspruchsvollen professionellen Workloads. Mit jeder neuen Generation werden Verbesserungen in Bezug auf Leistung, Energieeffizienz und Funktionen erzielt.

Die folgenden Benchmarks laufen auf einer 12th Gen Intel® Core® i9-12900KS CPU mit FP32-Präzision.

Detaillierte Benchmark-Ergebnisse

| Modell | Format | Status | Größe (MB) | metrics/mAP50-95(B) | Inferenzzeit (ms/Bild) |

|---|---|---|---|---|---|

| YOLO11n | PyTorch | ✅ | 5.4 | 0.5071 | 21.00 |

| YOLO11n | TorchScript | ✅ | 10.5 | 0.5077 | 21.39 |

| YOLO11n | ONNX | ✅ | 10.2 | 0.5077 | 15.55 |

| YOLO11n | OpenVINO | ✅ | 10.4 | 0.5077 | 11.49 |

| YOLO11s | PyTorch | ✅ | 18.4 | 0.5770 | 43.16 |

| YOLO11s | TorchScript | ✅ | 36.6 | 0.5781 | 50.06 |

| YOLO11s | ONNX | ✅ | 36.3 | 0.5781 | 31.53 |

| YOLO11s | OpenVINO | ✅ | 36.4 | 0.5781 | 30.82 |

| YOLO11m | PyTorch | ✅ | 38.8 | 0.6257 | 110.60 |

| YOLO11m | TorchScript | ✅ | 77.3 | 0.6306 | 128.09 |

| YOLO11m | ONNX | ✅ | 76.9 | 0.6306 | 76.06 |

| YOLO11m | OpenVINO | ✅ | 77.1 | 0.6306 | 79.38 |

| YOLO11l | PyTorch | ✅ | 49.0 | 0.6367 | 150.38 |

| YOLO11l | TorchScript | ✅ | 97.7 | 0.6408 | 172.57 |

| YOLO11l | ONNX | ✅ | 97.0 | 0.6408 | 108.91 |

| YOLO11l | OpenVINO | ✅ | 97.3 | 0.6408 | 102.30 |

| YOLO11x | PyTorch | ✅ | 109.3 | 0.6989 | 272.72 |

| YOLO11x | TorchScript | ✅ | 218.1 | 0.6900 | 320.86 |

| YOLO11x | ONNX | ✅ | 217.5 | 0.6900 | 196.20 |

| YOLO11x | OpenVINO | ✅ | 217.8 | 0.6900 | 195.32 |

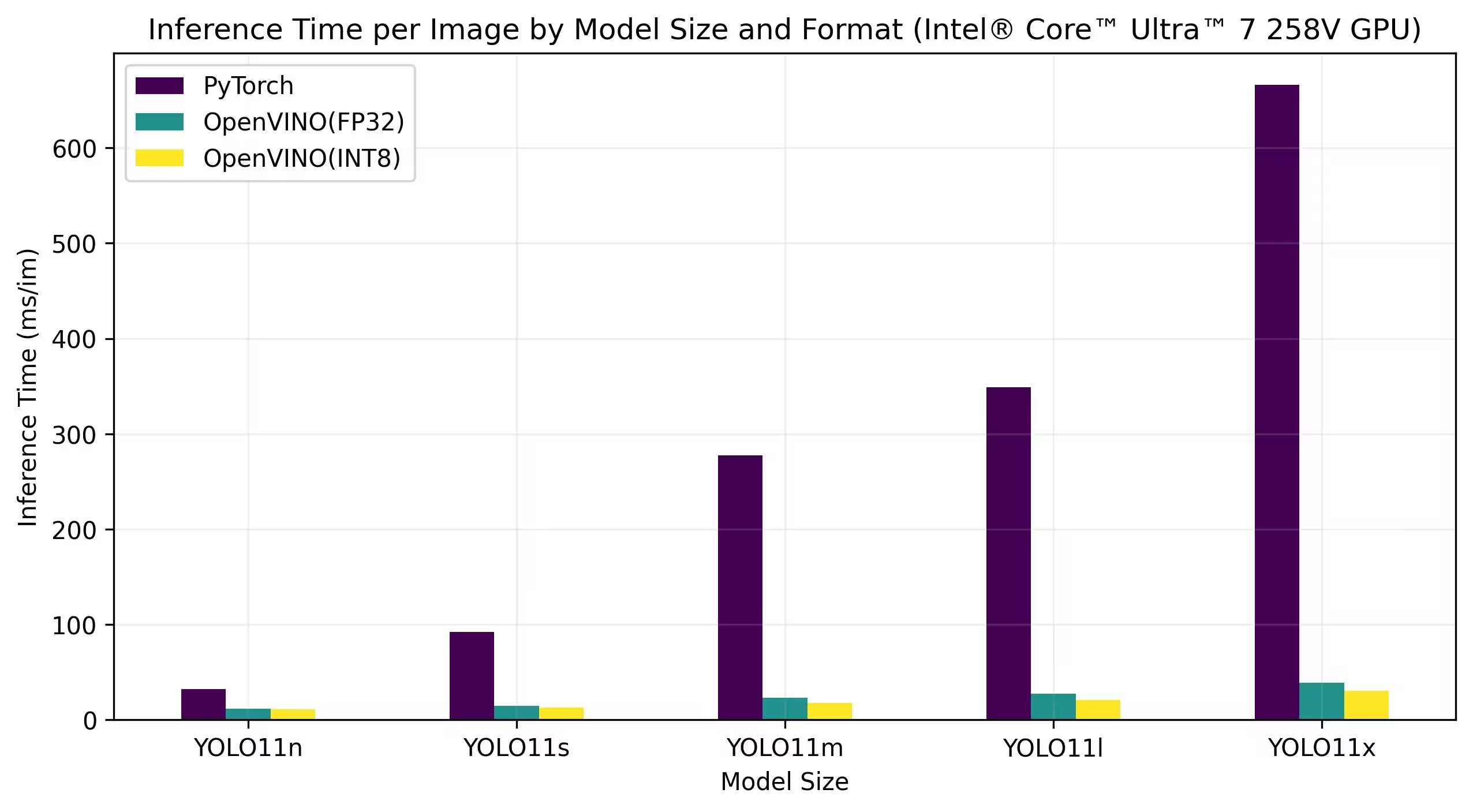

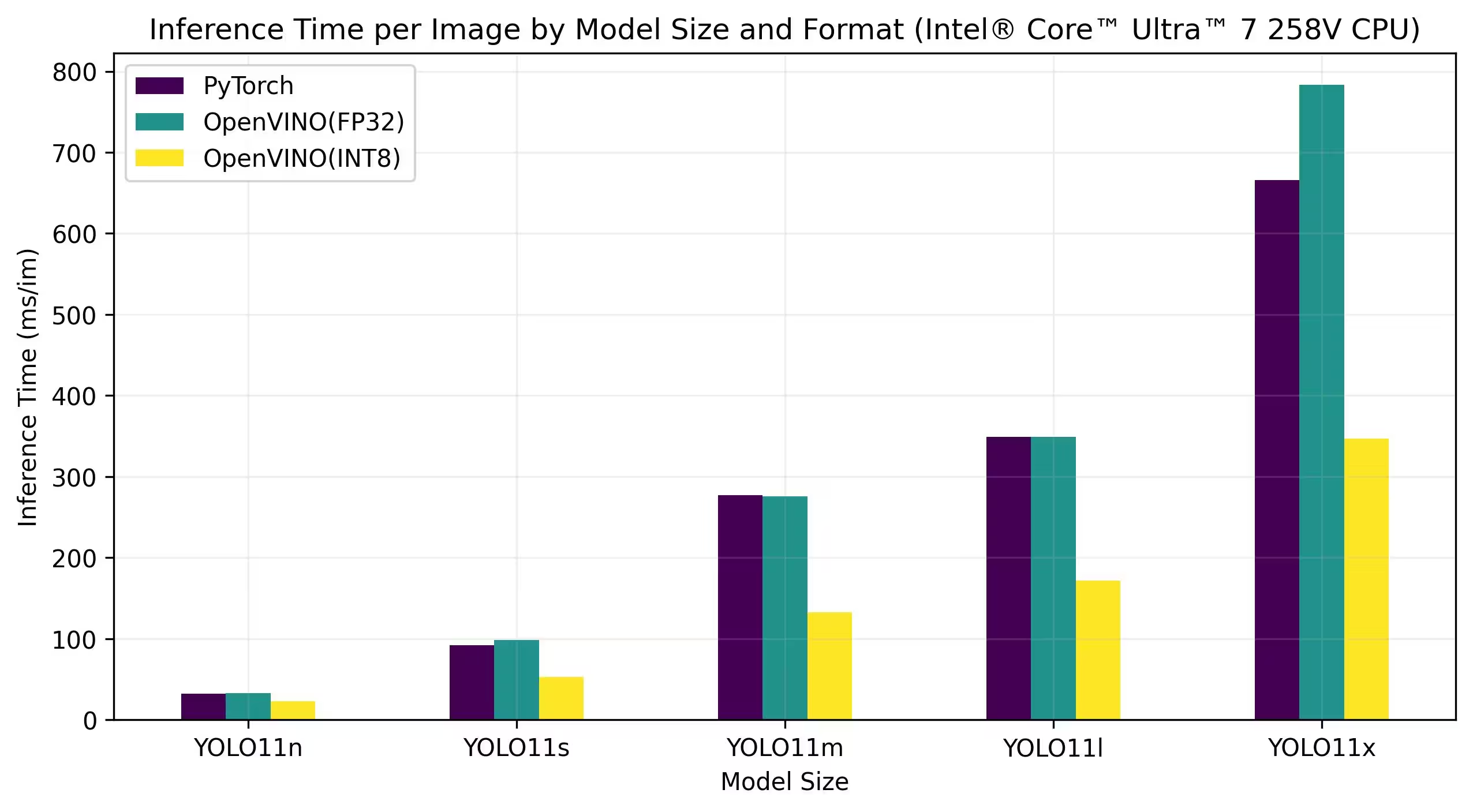

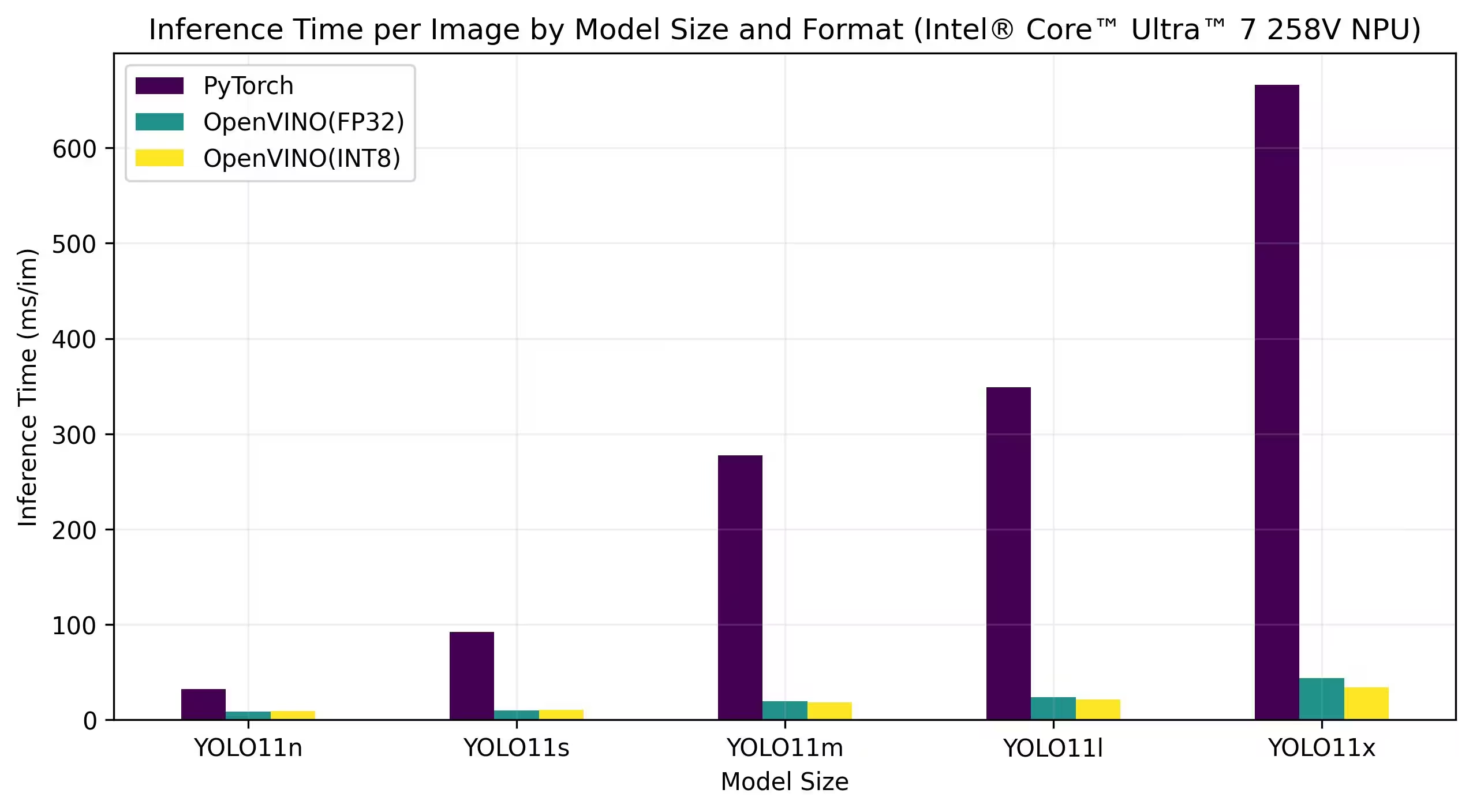

Intel® Core™ Ultra

Die Intel® Core™ Ultra™-Serie stellt einen neuen Maßstab im High-Performance-Computing dar, der entwickelt wurde, um die wachsenden Anforderungen moderner Benutzer zu erfüllen – von Gamern und Kreativen bis hin zu Fachleuten, die KI nutzen. Diese Next-Generation-Reihe ist mehr als eine traditionelle CPU-Serie; sie kombiniert leistungsstarke CPU-Kerne, integrierte High-Performance-GPU-Funktionen und eine dedizierte Neural Processing Unit (NPU) in einem einzigen Chip und bietet so eine einheitliche Lösung für vielfältige und intensive Computing-Workloads.

Das Herzstück der Intel® Core Ultra™-Architektur ist ein hybrides Design, das eine außergewöhnliche Leistung bei traditionellen Verarbeitungsaufgaben, GPU-beschleunigten Workloads und KI-gesteuerten Operationen ermöglicht. Die Integration der NPU verbessert die KI-Inferenz auf dem Gerät und ermöglicht ein schnelleres, effizienteres maschinelles Lernen und eine schnellere Datenverarbeitung in einer Vielzahl von Anwendungen.

Die Core Ultra™-Familie umfasst verschiedene Modelle, die auf unterschiedliche Leistungsanforderungen zugeschnitten sind, mit Optionen, die von energieeffizienten Designs bis hin zu Hochleistungs-Varianten mit der Bezeichnung "H" reichen—ideal für Laptops und kompakte Formfaktoren, die eine hohe Rechenleistung erfordern. Über die gesamte Produktpalette profitieren die Benutzer von der Synergie der CPU-, GPU- und NPU-Integration, die eine bemerkenswerte Effizienz, Reaktionsfähigkeit und Multitasking-Fähigkeiten bietet.

Als Teil der kontinuierlichen Innovation von Intel setzt die Core Ultra™-Serie einen neuen Standard für zukunftssicheres Computing. Mit mehreren verfügbaren Modellen und weiteren in Vorbereitung unterstreicht diese Serie das Engagement von Intel, modernste Lösungen für die nächste Generation intelligenter, KI-gestützter Geräte zu liefern.

Die untenstehenden Benchmarks laufen auf Intel® Core™ Ultra™ 7 258V und Intel® Core™ Ultra™ 7 265K mit FP32- und INT8-Präzision.

Intel® Core™ Ultra™ 7 258V

Benchmarks

Detaillierte Benchmark-Ergebnisse

| Modell | Format | Präzision | Status | Größe (MB) | metrics/mAP50-95(B) | Inferenzzeit (ms/Bild) |

|---|---|---|---|---|---|---|

| YOLO11n | PyTorch | FP32 | ✅ | 5.4 | 0.5052 | 32.27 |

| YOLO11n | OpenVINO | FP32 | ✅ | 10.4 | 0.5068 | 11.84 |

| YOLO11n | OpenVINO | INT8 | ✅ | 3.3 | 0.4969 | 11.24 |

| YOLO11s | PyTorch | FP32 | ✅ | 18.4 | 0.5776 | 92.09 |

| YOLO11s | OpenVINO | FP32 | ✅ | 36.4 | 0.5797 | 14.82 |

| YOLO11s | OpenVINO | INT8 | ✅ | 9.8 | 0.5751 | 12.88 |

| YOLO11m | PyTorch | FP32 | ✅ | 38.8 | 0.6262 | 277.24 |

| YOLO11m | OpenVINO | FP32 | ✅ | 77.1 | 0.6306 | 22.94 |

| YOLO11m | OpenVINO | INT8 | ✅ | 20.2 | 0.6126 | 17.85 |

| YOLO11l | PyTorch | FP32 | ✅ | 49.0 | 0.6361 | 348.97 |

| YOLO11l | OpenVINO | FP32 | ✅ | 97.3 | 0.6365 | 27.34 |

| YOLO11l | OpenVINO | INT8 | ✅ | 25.7 | 0.6242 | 20.83 |

| YOLO11x | PyTorch | FP32 | ✅ | 109.3 | 0.6984 | 666.07 |

| YOLO11x | OpenVINO | FP32 | ✅ | 217.8 | 0.6890 | 39.09 |

| YOLO11x | OpenVINO | INT8 | ✅ | 55.9 | 0.6856 | 30.60 |

Detaillierte Benchmark-Ergebnisse

| Modell | Format | Präzision | Status | Größe (MB) | metrics/mAP50-95(B) | Inferenzzeit (ms/Bild) |

|---|---|---|---|---|---|---|

| YOLO11n | PyTorch | FP32 | ✅ | 5.4 | 0.5052 | 32.27 |

| YOLO11n | OpenVINO | FP32 | ✅ | 10.4 | 0.5077 | 32.55 |

| YOLO11n | OpenVINO | INT8 | ✅ | 3.3 | 0.4980 | 22.98 |

| YOLO11s | PyTorch | FP32 | ✅ | 18.4 | 0.5776 | 92.09 |

| YOLO11s | OpenVINO | FP32 | ✅ | 36.4 | 0.5782 | 98.38 |

| YOLO11s | OpenVINO | INT8 | ✅ | 9.8 | 0.5745 | 52.84 |

| YOLO11m | PyTorch | FP32 | ✅ | 38.8 | 0.6262 | 277.24 |

| YOLO11m | OpenVINO | FP32 | ✅ | 77.1 | 0.6307 | 275.74 |

| YOLO11m | OpenVINO | INT8 | ✅ | 20.2 | 0.6172 | 132.63 |

| YOLO11l | PyTorch | FP32 | ✅ | 49.0 | 0.6361 | 348.97 |

| YOLO11l | OpenVINO | FP32 | ✅ | 97.3 | 0.6361 | 348.97 |

| YOLO11l | OpenVINO | INT8 | ✅ | 25.7 | 0.6240 | 171.36 |

| YOLO11x | PyTorch | FP32 | ✅ | 109.3 | 0.6984 | 666.07 |

| YOLO11x | OpenVINO | FP32 | ✅ | 217.8 | 0.6900 | 783.16 |

| YOLO11x | OpenVINO | INT8 | ✅ | 55.9 | 0.6890 | 346.82 |

Detaillierte Benchmark-Ergebnisse

| Modell | Format | Präzision | Status | Größe (MB) | metrics/mAP50-95(B) | Inferenzzeit (ms/Bild) |

|---|---|---|---|---|---|---|

| YOLO11n | PyTorch | FP32 | ✅ | 5.4 | 0.5052 | 32.27 |

| YOLO11n | OpenVINO | FP32 | ✅ | 10.4 | 0.5085 | 8.33 |

| YOLO11n | OpenVINO | INT8 | ✅ | 3.3 | 0.5019 | 8.91 |

| YOLO11s | PyTorch | FP32 | ✅ | 18.4 | 0.5776 | 92.09 |

| YOLO11s | OpenVINO | FP32 | ✅ | 36.4 | 0.5788 | 9.72 |

| YOLO11s | OpenVINO | INT8 | ✅ | 9.8 | 0.5710 | 10.58 |

| YOLO11m | PyTorch | FP32 | ✅ | 38.8 | 0.6262 | 277.24 |

| YOLO11m | OpenVINO | FP32 | ✅ | 77.1 | 0.6301 | 19.41 |

| YOLO11m | OpenVINO | INT8 | ✅ | 20.2 | 0.6124 | 18.26 |

| YOLO11l | PyTorch | FP32 | ✅ | 49.0 | 0.6361 | 348.97 |

| YOLO11l | OpenVINO | FP32 | ✅ | 97.3 | 0.6362 | 23.70 |

| YOLO11l | OpenVINO | INT8 | ✅ | 25.7 | 0.6240 | 21.40 |

| YOLO11x | PyTorch | FP32 | ✅ | 109.3 | 0.6984 | 666.07 |

| YOLO11x | OpenVINO | FP32 | ✅ | 217.8 | 0.6892 | 43.91 |

| YOLO11x | OpenVINO | INT8 | ✅ | 55.9 | 0.6890 | 34.04 |

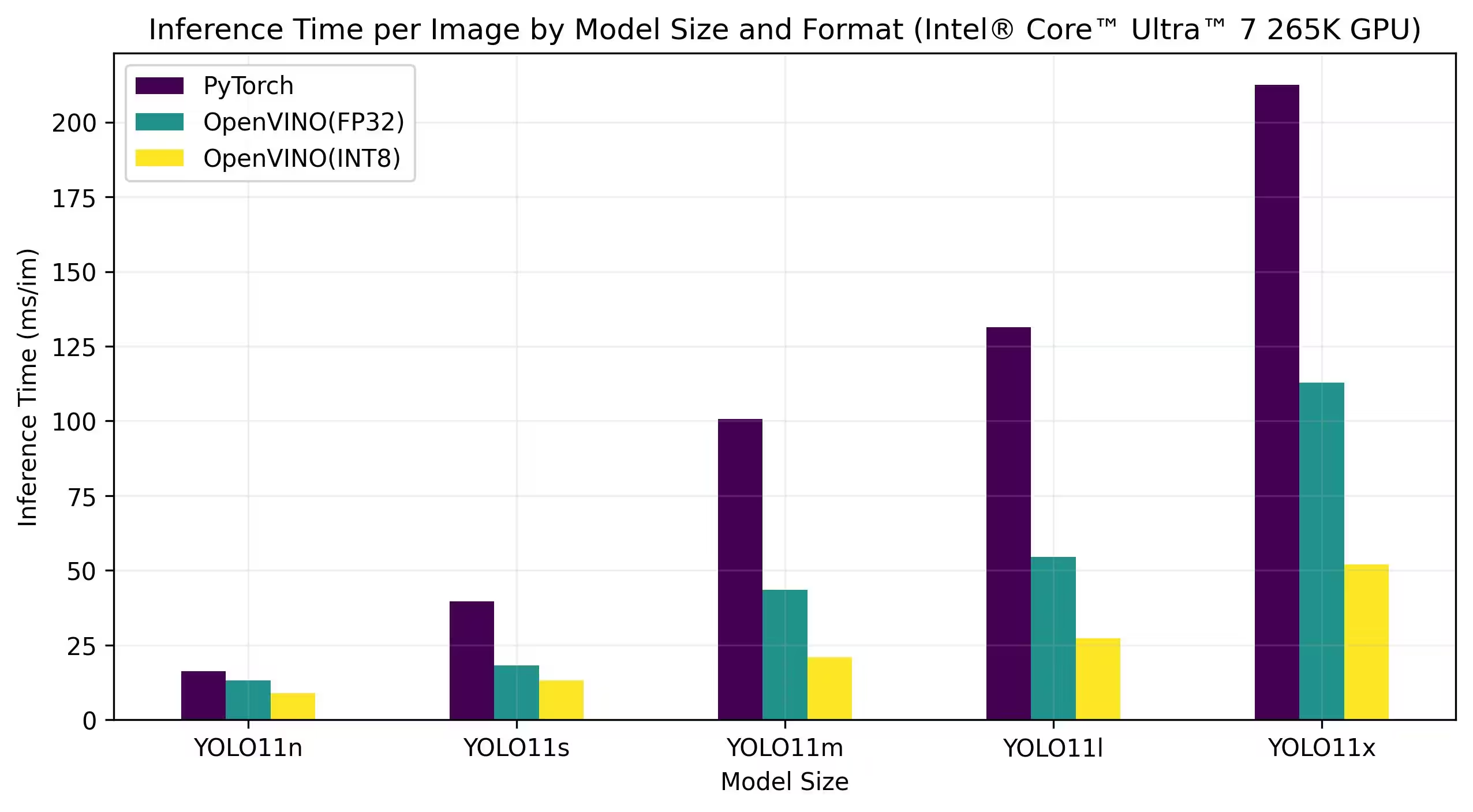

Intel® Core™ Ultra™ 7 265K

Benchmarks

Detaillierte Benchmark-Ergebnisse

| Modell | Format | Präzision | Status | Größe (MB) | metrics/mAP50-95(B) | Inferenzzeit (ms/Bild) |

|---|---|---|---|---|---|---|

| YOLO11n | PyTorch | FP32 | ✅ | 5.4 | 0.5072 | 16.29 |

| YOLO11n | OpenVINO | FP32 | ✅ | 10.4 | 0.5079 | 13.13 |

| YOLO11n | OpenVINO | INT8 | ✅ | 3.3 | 0.4976 | 8.86 |

| YOLO11s | PyTorch | FP32 | ✅ | 18.4 | 0.5771 | 39.61 |

| YOLO11s | OpenVINO | FP32 | ✅ | 36.4 | 0.5808 | 18.26 |

| YOLO11s | OpenVINO | INT8 | ✅ | 9.8 | 0.5726 | 13.24 |

| YOLO11m | PyTorch | FP32 | ✅ | 38.8 | 0.6258 | 100.65 |

| YOLO11m | OpenVINO | FP32 | ✅ | 77.1 | 0.6310 | 43.50 |

| YOLO11m | OpenVINO | INT8 | ✅ | 20.2 | 0.6137 | 20.90 |

| YOLO11l | PyTorch | FP32 | ✅ | 49.0 | 0.6367 | 131.37 |

| YOLO11l | OpenVINO | FP32 | ✅ | 97.3 | 0.6371 | 54.52 |

| YOLO11l | OpenVINO | INT8 | ✅ | 25.7 | 0.6226 | 27.36 |

| YOLO11x | PyTorch | FP32 | ✅ | 109.3 | 0.6990 | 212.45 |

| YOLO11x | OpenVINO | FP32 | ✅ | 217.8 | 0.6884 | 112.76 |

| YOLO11x | OpenVINO | INT8 | ✅ | 55.9 | 0.6900 | 52.06 |

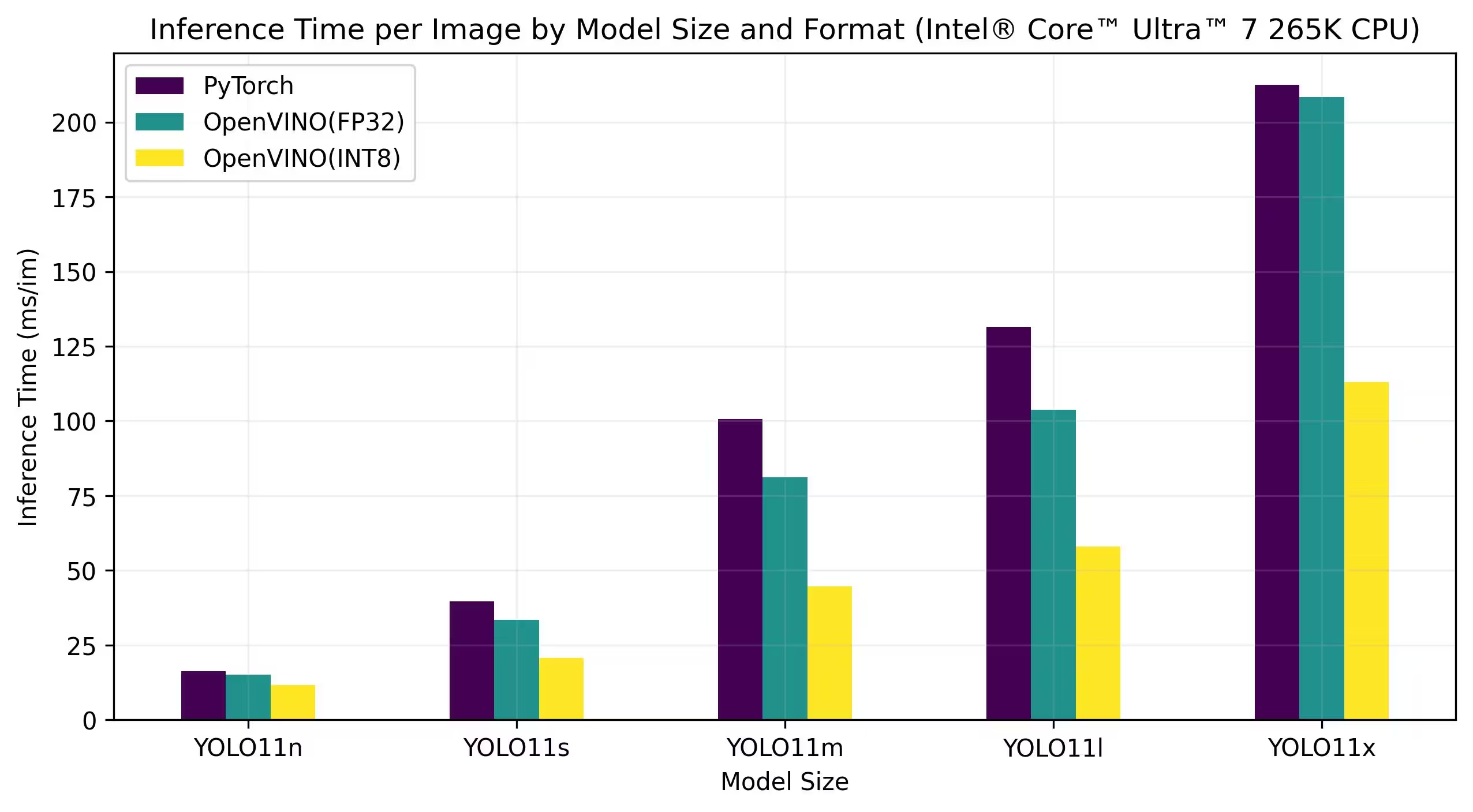

Detaillierte Benchmark-Ergebnisse

| Modell | Format | Präzision | Status | Größe (MB) | metrics/mAP50-95(B) | Inferenzzeit (ms/Bild) |

|---|---|---|---|---|---|---|

| YOLO11n | PyTorch | FP32 | ✅ | 5.4 | 0.5072 | 16.29 |

| YOLO11n | OpenVINO | FP32 | ✅ | 10.4 | 0.5077 | 15.04 |

| YOLO11n | OpenVINO | INT8 | ✅ | 3.3 | 0.4980 | 11.60 |

| YOLO11s | PyTorch | FP32 | ✅ | 18.4 | 0.5771 | 39.61 |

| YOLO11s | OpenVINO | FP32 | ✅ | 36.4 | 0.5782 | 33.45 |

| YOLO11s | OpenVINO | INT8 | ✅ | 9.8 | 0.5745 | 20.64 |

| YOLO11m | PyTorch | FP32 | ✅ | 38.8 | 0.6258 | 100.65 |

| YOLO11m | OpenVINO | FP32 | ✅ | 77.1 | 0.6307 | 81.15 |

| YOLO11m | OpenVINO | INT8 | ✅ | 20.2 | 0.6172 | 44.63 |

| YOLO11l | PyTorch | FP32 | ✅ | 49.0 | 0.6367 | 131.37 |

| YOLO11l | OpenVINO | FP32 | ✅ | 97.3 | 0.6409 | 103.77 |

| YOLO11l | OpenVINO | INT8 | ✅ | 25.7 | 0.6240 | 58.00 |

| YOLO11x | PyTorch | FP32 | ✅ | 109.3 | 0.6990 | 212.45 |

| YOLO11x | OpenVINO | FP32 | ✅ | 217.8 | 0.6900 | 208.37 |

| YOLO11x | OpenVINO | INT8 | ✅ | 55.9 | 0.6897 | 113.04 |

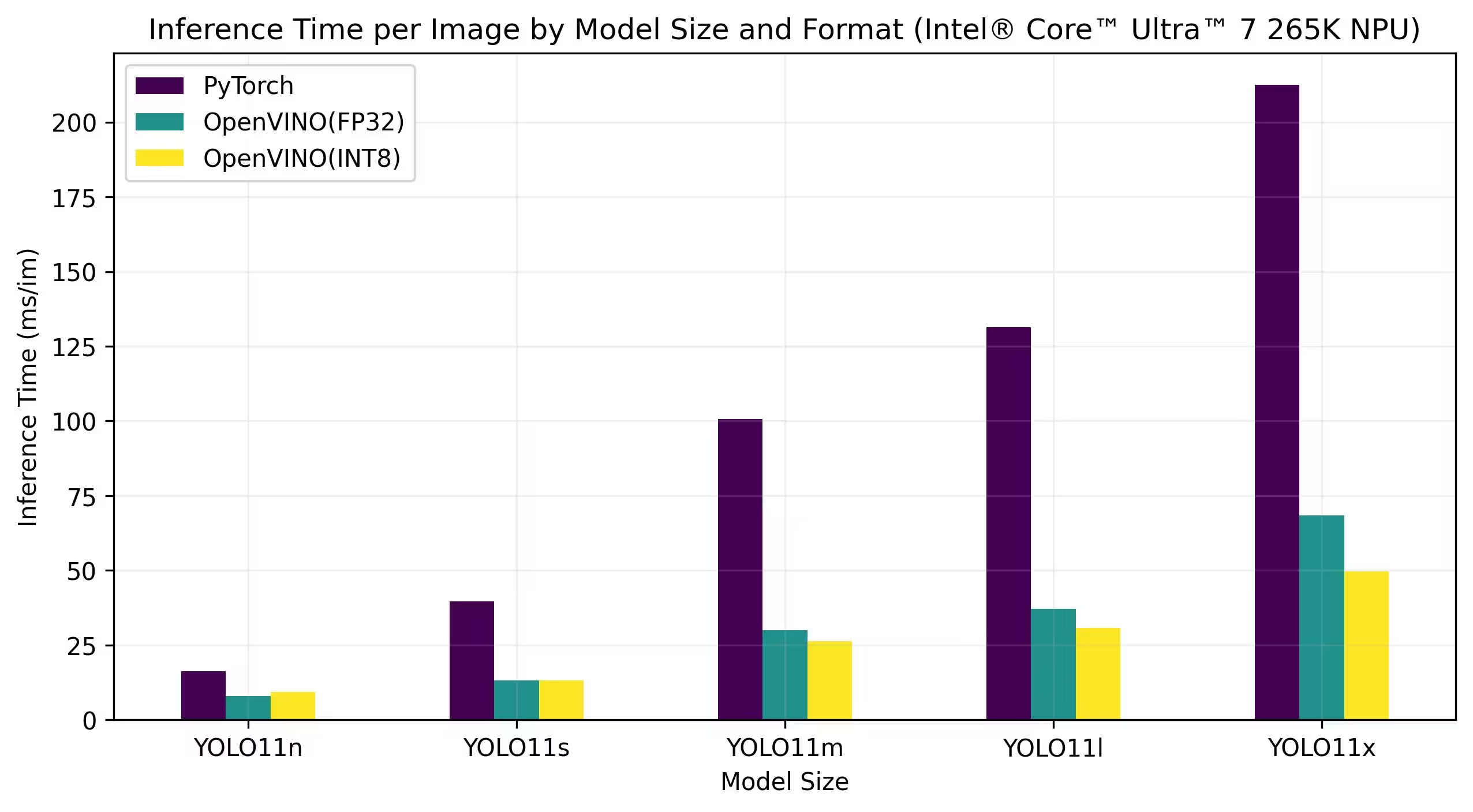

Detaillierte Benchmark-Ergebnisse

| Modell | Format | Präzision | Status | Größe (MB) | metrics/mAP50-95(B) | Inferenzzeit (ms/Bild) |

|---|---|---|---|---|---|---|

| YOLO11n | PyTorch | FP32 | ✅ | 5.4 | 0.5072 | 16.29 |

| YOLO11n | OpenVINO | FP32 | ✅ | 10.4 | 0.5075 | 8.02 |

| YOLO11n | OpenVINO | INT8 | ✅ | 3.3 | 0.3656 | 9.28 |

| YOLO11s | PyTorch | FP32 | ✅ | 18.4 | 0.5771 | 39.61 |

| YOLO11s | OpenVINO | FP32 | ✅ | 36.4 | 0.5801 | 13.12 |

| YOLO11s | OpenVINO | INT8 | ✅ | 9.8 | 0.5686 | 13.12 |

| YOLO11m | PyTorch | FP32 | ✅ | 38.8 | 0.6258 | 100.65 |

| YOLO11m | OpenVINO | FP32 | ✅ | 77.1 | 0.6310 | 29.88 |

| YOLO11m | OpenVINO | INT8 | ✅ | 20.2 | 0.6111 | 26.32 |

| YOLO11l | PyTorch | FP32 | ✅ | 49.0 | 0.6367 | 131.37 |

| YOLO11l | OpenVINO | FP32 | ✅ | 97.3 | 0.6356 | 37.08 |

| YOLO11l | OpenVINO | INT8 | ✅ | 25.7 | 0.6245 | 30.81 |

| YOLO11x | PyTorch | FP32 | ✅ | 109.3 | 0.6990 | 212.45 |

| YOLO11x | OpenVINO | FP32 | ✅ | 217.8 | 0.6894 | 68.48 |

| YOLO11x | OpenVINO | INT8 | ✅ | 55.9 | 0.6417 | 49.76 |

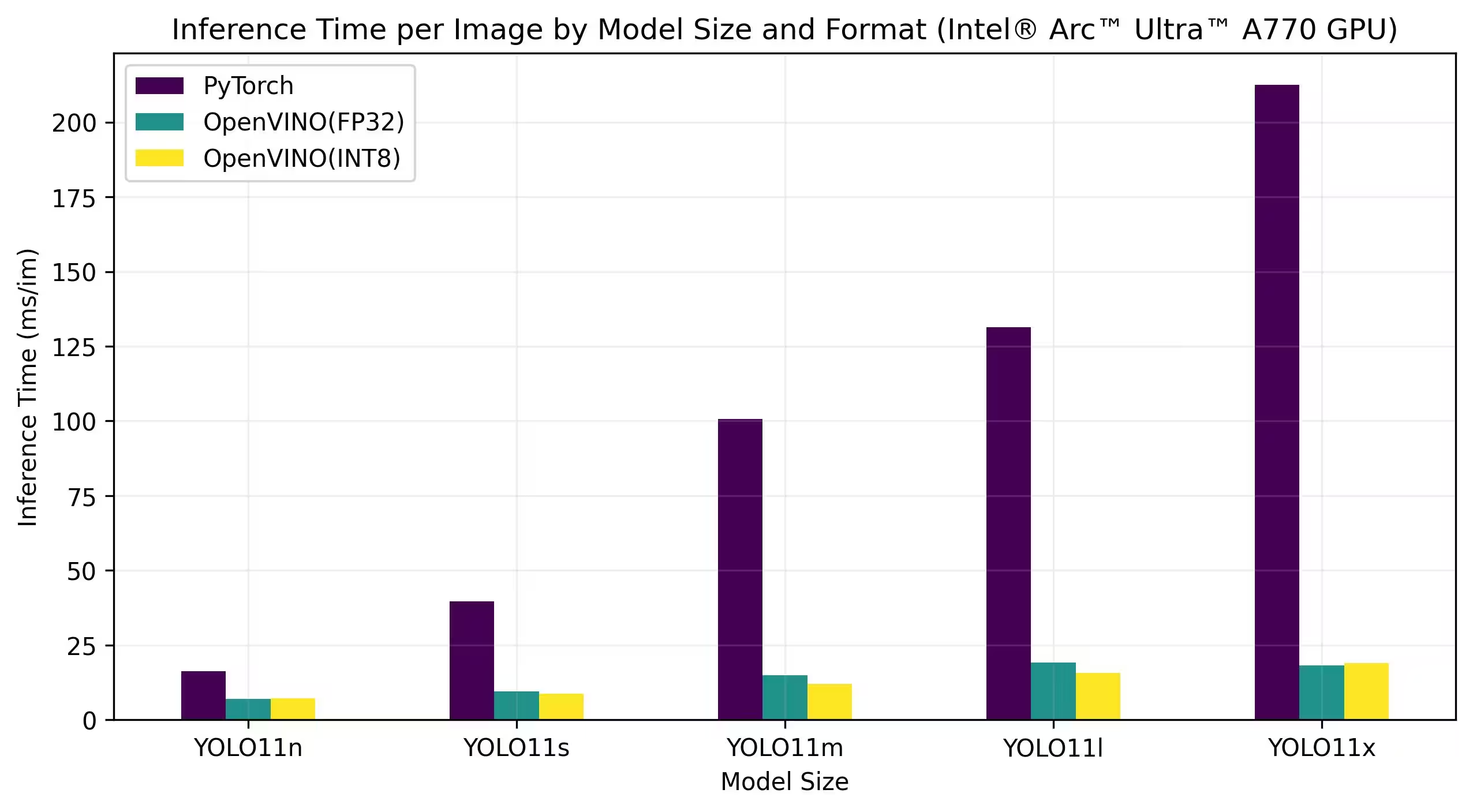

Intel® Arc GPU

Intel® Arc™ ist Intels Produktreihe diskreter Grafikkarten, die für hochleistungsfähiges Gaming, Content Creation und KI-Workloads entwickelt wurden. Die Arc-Serie verfügt über fortschrittliche GPU-Architekturen, die Echtzeit-Raytracing, KI-gestützte Grafiken und hochauflösendes Gaming unterstützen. Mit dem Fokus auf Leistung und Effizienz zielt Intel® Arc™ darauf ab, mit anderen führenden GPU-Marken zu konkurrieren und gleichzeitig einzigartige Funktionen wie hardwarebeschleunigte AV1-Codierung und Unterstützung für die neuesten Grafik-APIs zu bieten.

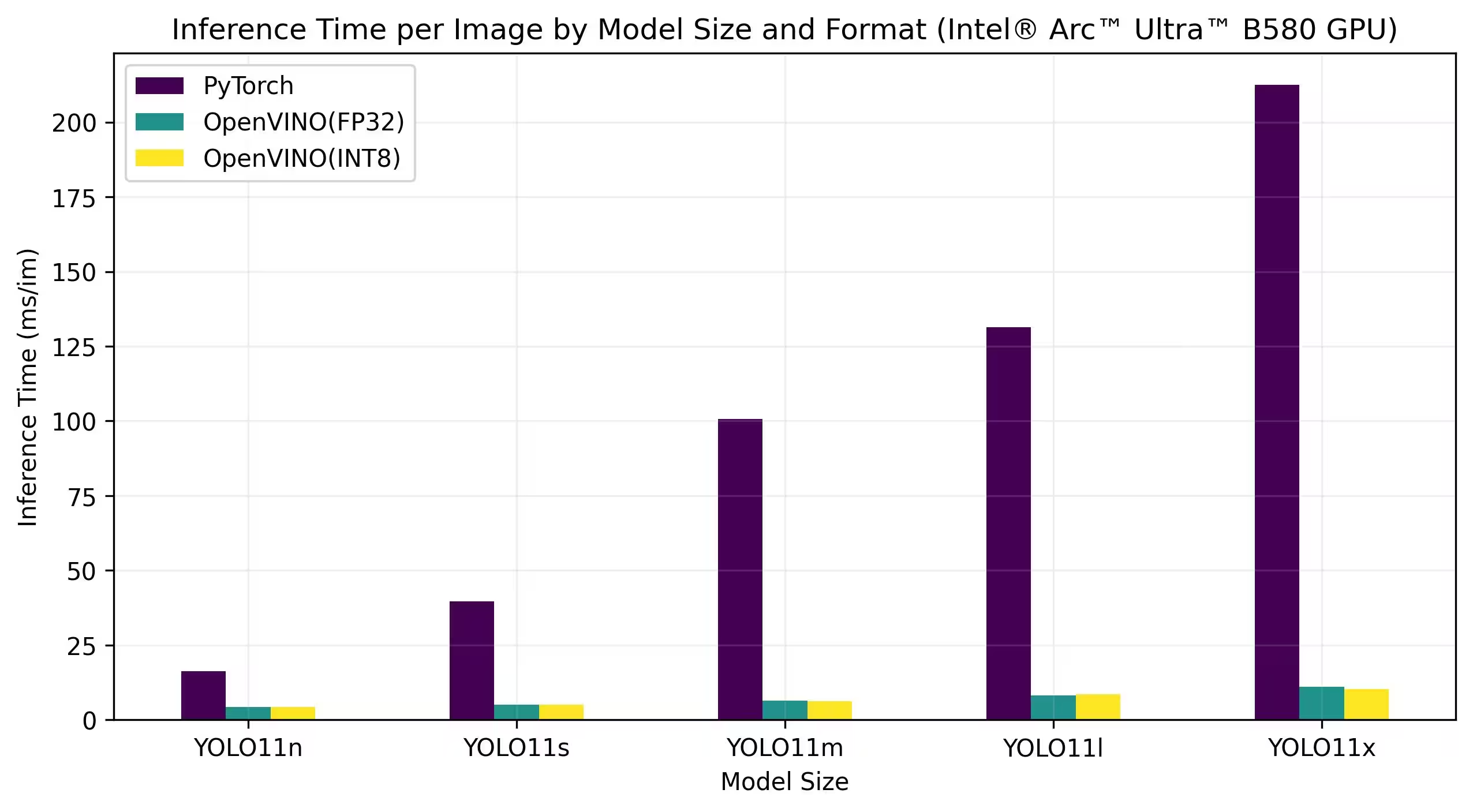

Die folgenden Benchmarks laufen auf Intel Arc A770 und Intel Arc B580 mit FP32- und INT8-Präzision.

Intel Arc A770

Detaillierte Benchmark-Ergebnisse

| Modell | Format | Präzision | Status | Größe (MB) | metrics/mAP50-95(B) | Inferenzzeit (ms/Bild) |

|---|---|---|---|---|---|---|

| YOLO11n | PyTorch | FP32 | ✅ | 5.4 | 0.5072 | 16.29 |

| YOLO11n | OpenVINO | FP32 | ✅ | 10.4 | 0.5073 | 6.98 |

| YOLO11n | OpenVINO | INT8 | ✅ | 3.3 | 0.4978 | 7.24 |

| YOLO11s | PyTorch | FP32 | ✅ | 18.4 | 0.5771 | 39.61 |

| YOLO11s | OpenVINO | FP32 | ✅ | 36.4 | 0.5798 | 9.41 |

| YOLO11s | OpenVINO | INT8 | ✅ | 9.8 | 0.5751 | 8.72 |

| YOLO11m | PyTorch | FP32 | ✅ | 38.8 | 0.6258 | 100.65 |

| YOLO11m | OpenVINO | FP32 | ✅ | 77.1 | 0.6311 | 14.88 |

| YOLO11m | OpenVINO | INT8 | ✅ | 20.2 | 0.6126 | 11.97 |

| YOLO11l | PyTorch | FP32 | ✅ | 49.0 | 0.6367 | 131.37 |

| YOLO11l | OpenVINO | FP32 | ✅ | 97.3 | 0.6364 | 19.17 |

| YOLO11l | OpenVINO | INT8 | ✅ | 25.7 | 0.6241 | 15.75 |

| YOLO11x | PyTorch | FP32 | ✅ | 109.3 | 0.6990 | 212.45 |

| YOLO11x | OpenVINO | FP32 | ✅ | 217.8 | 0.6888 | 18.13 |

| YOLO11x | OpenVINO | INT8 | ✅ | 55.9 | 0.6930 | 18.91 |

Intel Arc B580

Detaillierte Benchmark-Ergebnisse

| Modell | Format | Präzision | Status | Größe (MB) | metrics/mAP50-95(B) | Inferenzzeit (ms/Bild) |

|---|---|---|---|---|---|---|

| YOLO11n | PyTorch | FP32 | ✅ | 5.4 | 0.5072 | 16.29 |

| YOLO11n | OpenVINO | FP32 | ✅ | 10.4 | 0.5072 | 4.27 |

| YOLO11n | OpenVINO | INT8 | ✅ | 3.3 | 0.4981 | 4.33 |

| YOLO11s | PyTorch | FP32 | ✅ | 18.4 | 0.5771 | 39.61 |

| YOLO11s | OpenVINO | FP32 | ✅ | 36.4 | 0.5789 | 5.04 |

| YOLO11s | OpenVINO | INT8 | ✅ | 9.8 | 0.5746 | 4.97 |

| YOLO11m | PyTorch | FP32 | ✅ | 38.8 | 0.6258 | 100.65 |

| YOLO11m | OpenVINO | FP32 | ✅ | 77.1 | 0.6306 | 6.45 |

| YOLO11m | OpenVINO | INT8 | ✅ | 20.2 | 0.6125 | 6.28 |

| YOLO11l | PyTorch | FP32 | ✅ | 49.0 | 0.6367 | 131.37 |

| YOLO11l | OpenVINO | FP32 | ✅ | 97.3 | 0.6360 | 8.23 |

| YOLO11l | OpenVINO | INT8 | ✅ | 25.7 | 0.6236 | 8.49 |

| YOLO11x | PyTorch | FP32 | ✅ | 109.3 | 0.6990 | 212.45 |

| YOLO11x | OpenVINO | FP32 | ✅ | 217.8 | 0.6889 | 11.10 |

| YOLO11x | OpenVINO | INT8 | ✅ | 55.9 | 0.6924 | 10.30 |

Unsere Ergebnisse reproduzieren

Um die oben genannten Ultralytics-Benchmarks auf allen Export-Formaten zu reproduzieren, führen Sie diesen Code aus:

Beispiel

from ultralytics import YOLO

# Load a YOLO11n PyTorch model

model = YOLO("yolo11n.pt")

# Benchmark YOLO11n speed and accuracy on the COCO128 dataset for all export formats

results = model.benchmark(data="coco128.yaml")

# Benchmark YOLO11n speed and accuracy on the COCO128 dataset for all export formats

yolo benchmark model=yolo11n.pt data=coco128.yaml

Beachten Sie, dass die Ergebnisse der Benchmarks je nach der genauen Hardware- und Softwarekonfiguration eines Systems sowie der aktuellen Auslastung des Systems zum Zeitpunkt der Ausführung der Benchmarks variieren können. Für die zuverlässigsten Ergebnisse verwenden Sie einen Datensatz mit einer großen Anzahl von Bildern, d. h. data='coco.yaml' (5000 Validierungsbilder).

Fazit

Die Benchmarking-Ergebnisse demonstrieren deutlich die Vorteile des Exports des YOLO11-Modells in das OpenVINO-Format. Über verschiedene Modelle und Hardwareplattformen hinweg übertrifft das OpenVINO-Format andere Formate in Bezug auf die Inferenzgeschwindigkeit konstant und behält gleichzeitig eine vergleichbare Genauigkeit bei.

Die Benchmarks unterstreichen die Effektivität von OpenVINO als Werkzeug für die Bereitstellung von Deep-Learning-Modellen. Durch die Konvertierung von Modellen in das OpenVINO-Format können Entwickler signifikante Leistungsverbesserungen erzielen, wodurch es einfacher wird, diese Modelle in realen Anwendungen einzusetzen.

Für detailliertere Informationen und Anweisungen zur Verwendung von OpenVINO lesen Sie die offizielle OpenVINO-Dokumentation.

FAQ

Wie exportiere ich YOLO26-Modelle in das OpenVINO-Format?

Der Export von YOLO26-Modellen in das OpenVINO-Format kann die CPU-Geschwindigkeit erheblich steigern und GPU- und NPU-Beschleunigungen auf Intel-Hardware ermöglichen. Zum Export können Sie entweder Python oder die CLI verwenden, wie unten gezeigt:

Beispiel

from ultralytics import YOLO

# Load a YOLO26n PyTorch model

model = YOLO("yolo26n.pt")

# Export the model

model.export(format="openvino") # creates 'yolo26n_openvino_model/'

# Export a YOLO26n PyTorch model to OpenVINO format

yolo export model=yolo26n.pt format=openvino # creates 'yolo26n_openvino_model/'

Weitere Informationen finden Sie in der Dokumentation zu den Exportformaten.

Welche Vorteile bietet die Verwendung von OpenVINO mit YOLO26-Modellen?

Die Verwendung von Intels OpenVINO-Toolkit mit YOLO26-Modellen bietet mehrere Vorteile:

- Performance: Erreichen Sie bis zu 3x Beschleunigung bei der CPU-Inferenz und nutzen Sie Intel-GPUs und -NPUs zur Beschleunigung.

- Modelloptimierer: Konvertieren, optimieren und führen Sie Modelle aus gängigen Frameworks wie PyTorch, TensorFlow und ONNX aus.

- Benutzerfreundlichkeit: Über 80 Tutorial-Notebooks stehen zur Verfügung, um Benutzern den Einstieg zu erleichtern, einschließlich solcher für YOLO26.

- Heterogene Ausführung: Modelle auf verschiedener Intel-Hardware mit einer einheitlichen API bereitstellen.

Detaillierte Leistungsvergleiche finden Sie in unserem Benchmark-Abschnitt.

Wie kann ich die Inferenz mit einem nach OpenVINO exportierten YOLO26-Modell ausführen?

Nach dem Export eines YOLO26n-Modells in das OpenVINO-Format können Sie die Inferenz mit Python oder der CLI ausführen:

Beispiel

from ultralytics import YOLO

# Load the exported OpenVINO model

ov_model = YOLO("yolo26n_openvino_model/")

# Run inference

results = ov_model("https://ultralytics.com/images/bus.jpg")

# Run inference with the exported model

yolo predict model=yolo26n_openvino_model source='https://ultralytics.com/images/bus.jpg'

Weitere Informationen finden Sie in unserer Dokumentation zum Vorhersagemodus.

Warum sollte ich Ultralytics YOLO26 gegenüber anderen Modellen für den OpenVINO-Export wählen?

Ultralytics YOLO26 ist für die Echtzeit-Objekterkennung mit hoher Genauigkeit und Geschwindigkeit optimiert. Insbesondere in Kombination mit OpenVINO bietet YOLO26:

- Bis zu 3x schnellere Beschleunigung auf Intel CPUs

- Nahtlose Bereitstellung auf Intel GPUs und NPUs

- Konsistente und vergleichbare Genauigkeit über verschiedene Exportformate hinweg

Für eine detaillierte Leistungsanalyse lesen Sie unsere detaillierten YOLO11 Benchmarks auf verschiedener Hardware.

Kann ich YOLO26-Modelle auf verschiedenen Formaten wie PyTorch, ONNX und OpenVINO benchmarken?

Ja, Sie können YOLO26-Modelle in verschiedenen Formaten benchmarken, darunter PyTorch, TorchScript, ONNX und OpenVINO. Verwenden Sie den folgenden Codeausschnitt, um Benchmarks für den von Ihnen ausgewählten Datensatz auszuführen:

Beispiel

from ultralytics import YOLO

# Load a YOLO26n PyTorch model

model = YOLO("yolo26n.pt")

# Benchmark YOLO26n speed and [accuracy](https://www.ultralytics.com/glossary/accuracy) on the COCO8 dataset for all export formats

results = model.benchmark(data="coco8.yaml")

# Benchmark YOLO26n speed and accuracy on the COCO8 dataset for all export formats

yolo benchmark model=yolo26n.pt data=coco8.yaml

Detaillierte Benchmark-Ergebnisse finden Sie in unserem Benchmark-Abschnitt und in der Dokumentation zu den Exportformaten.