Guía de inicio rápido: Raspberry Pi con Ultralytics YOLO26

Esta guía completa proporciona un recorrido detallado para desplegar Ultralytics YOLO26 en dispositivos Raspberry Pi. Además, presenta puntos de referencia de rendimiento para demostrar las capacidades de YOLO26 en estos dispositivos pequeños y potentes.

Ver: Actualizaciones y mejoras de Raspberry Pi 5.

Nota

Esta guía se ha probado con Raspberry Pi 4 y Raspberry Pi 5 ejecutando la última versión de Raspberry Pi OS Bookworm (Debian 12). Se espera que el uso de esta guía para dispositivos Raspberry Pi más antiguos, como la Raspberry Pi 3, funcione siempre y cuando esté instalado el mismo Raspberry Pi OS Bookworm.

¿Qué es Raspberry Pi?

Raspberry Pi es una computadora de placa única, pequeña y asequible. Se ha vuelto popular para una amplia gama de proyectos y aplicaciones, desde la automatización del hogar para aficionados hasta usos industriales. Las placas Raspberry Pi son capaces de ejecutar una variedad de sistemas operativos y ofrecen pines GPIO (Entrada/Salida de Propósito General) que permiten una fácil integración con sensores, actuadores y otros componentes de hardware. Vienen en diferentes modelos con diferentes especificaciones, pero todos comparten la misma filosofía de diseño básico de ser de bajo costo, compactos y versátiles.

Comparación de la serie Raspberry Pi

| Raspberry Pi 3 | Raspberry Pi 4 | Raspberry Pi 5 | |

|---|---|---|---|

| CPU | Broadcom BCM2837, Cortex-A53 SoC de 64 bits | Broadcom BCM2711, Cortex-A72 SoC de 64 bits | Broadcom BCM2712, Cortex-A76 SoC de 64 bits |

| Frecuencia Máxima de la CPU | 1.4GHz | 1.8GHz | 2.4GHz |

| GPU | Videocore IV | Videocore VI | VideoCore VII |

| Frecuencia Máxima de la GPU | 400Mhz | 500Mhz | 800Mhz |

| Memoria | 1GB LPDDR2 SDRAM | 1GB, 2GB, 4GB, 8GB LPDDR4-3200 SDRAM | 4GB, 8GB LPDDR4X-4267 SDRAM |

| PCIe | N/A | N/A | 1xPCIe 2.0 Interface |

| Consumo Máximo de Energía | 2.5A@5V | 3A@5V | 5A@5V (PD habilitado) |

¿Qué es Raspberry Pi OS?

Raspberry Pi OS (anteriormente conocido como Raspbian) es un sistema operativo tipo Unix basado en la distribución Debian GNU/Linux para la familia Raspberry Pi de computadoras compactas de placa única distribuidas por la Raspberry Pi Foundation. Raspberry Pi OS está altamente optimizado para la Raspberry Pi con CPUs ARM y utiliza un entorno de escritorio LXDE modificado con el administrador de ventanas de apilamiento Openbox. Raspberry Pi OS está en desarrollo activo, con un énfasis en mejorar la estabilidad y el rendimiento de tantos paquetes de Debian como sea posible en Raspberry Pi.

Flashear Raspberry Pi OS a Raspberry Pi

Lo primero que debe hacer después de tener en sus manos una Raspberry Pi es grabar una tarjeta micro-SD con Raspberry Pi OS, insertarla en el dispositivo y arrancar el sistema operativo. Siga la detallada Documentación de inicio de Raspberry Pi para preparar su dispositivo para su primer uso.

Configurar Ultralytics

Existen dos formas de configurar el paquete Ultralytics en Raspberry Pi para construir su próximo proyecto de Visión Artificial. Puede utilizar cualquiera de ellas.

Comenzar con Docker

La forma más rápida de empezar con Ultralytics YOLO26 en Raspberry Pi es ejecutarlo con una imagen Docker precompilada para Raspberry Pi.

Ejecute el siguiente comando para extraer el contenedor Docker y ejecutarlo en Raspberry Pi. Esto se basa en la imagen Docker arm64v8/debian que contiene Debian 12 (Bookworm) en un entorno Python3.

t=ultralytics/ultralytics:latest-arm64

sudo docker pull $t && sudo docker run -it --ipc=host $t

Una vez hecho esto, salta a la sección Usar NCNN en Raspberry Pi.

Comenzar sin Docker

Instalar el paquete Ultralytics

Aquí instalaremos el paquete Ultralytics en la Raspberry Pi con dependencias opcionales para poder exportar los modelos PyTorch a otros formatos diferentes.

Actualizar la lista de paquetes, instalar pip y actualizar a la última versión

sudo apt update sudo apt install python3-pip -y pip install -U pipInstalar

ultralyticspaquete pip con dependencias opcionalespip install ultralytics[export]Reiniciar el dispositivo

sudo reboot

Utiliza NCNN en Raspberry Pi

De todos los formatos de exportación de modelos compatibles con Ultralytics, NCNN ofrece el mejor rendimiento de inferencia cuando se trabaja con dispositivos Raspberry Pi porque NCNN está altamente optimizado para plataformas móviles/integradas (como la arquitectura ARM).

Convertir el modelo a NCNN y ejecutar la inferencia

El modelo YOLO26n en formato PyTorch se convierte a NCNN para ejecutar la inferencia con el modelo exportado.

Ejemplo

from ultralytics import YOLO

# Load a YOLO26n PyTorch model

model = YOLO("yolo26n.pt")

# Export the model to NCNN format

model.export(format="ncnn") # creates 'yolo26n_ncnn_model'

# Load the exported NCNN model

ncnn_model = YOLO("yolo26n_ncnn_model")

# Run inference

results = ncnn_model("https://ultralytics.com/images/bus.jpg")

# Export a YOLO26n PyTorch model to NCNN format

yolo export model=yolo26n.pt format=ncnn # creates 'yolo26n_ncnn_model'

# Run inference with the exported model

yolo predict model='yolo26n_ncnn_model' source='https://ultralytics.com/images/bus.jpg'

Consejo

Para obtener más detalles sobre las opciones de exportación admitidas, visita la página de documentación de Ultralytics sobre las opciones de implementación.

Pruebas de rendimiento de Raspberry Pi 5 YOLO26

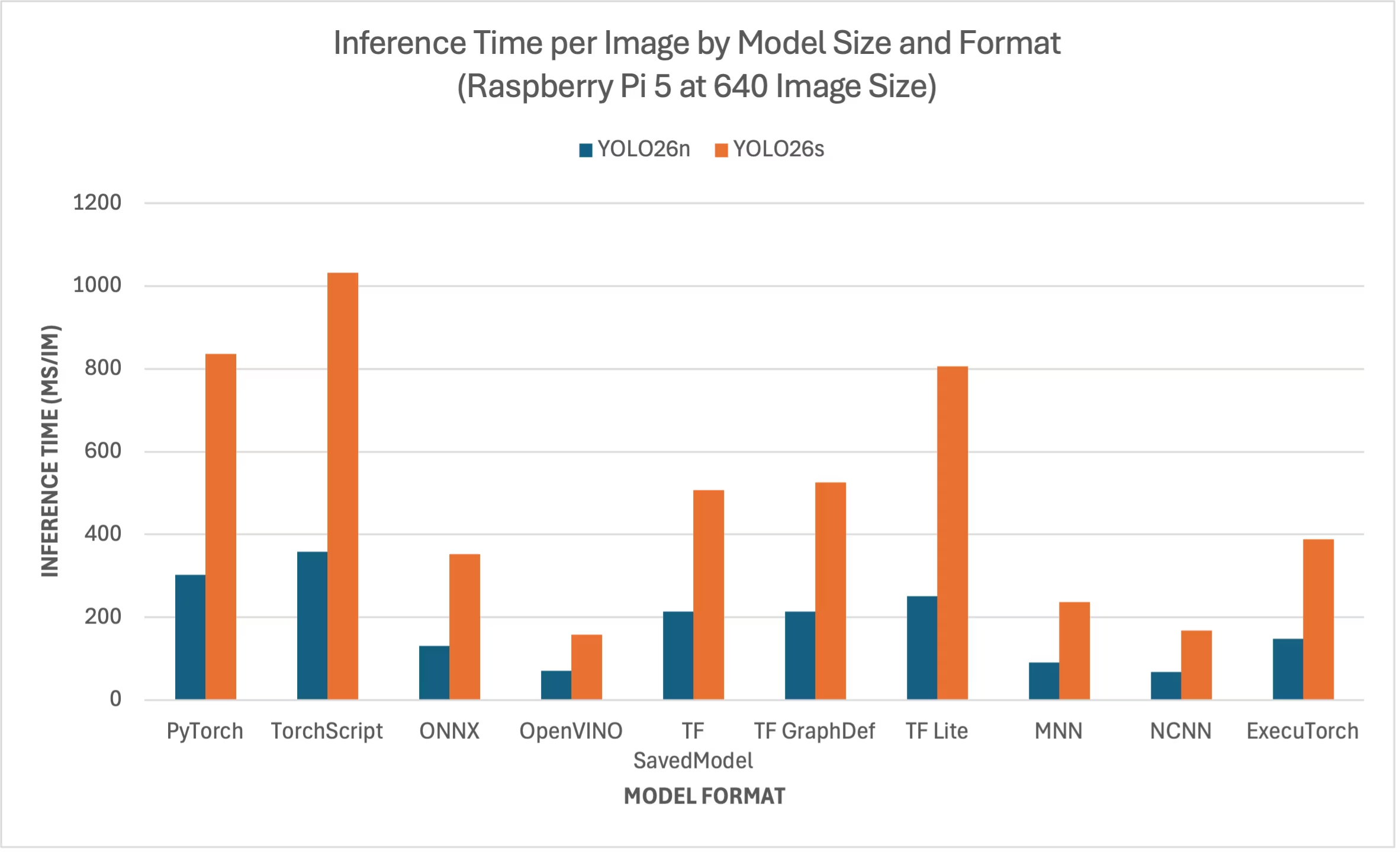

Ultralytics ejecutó las pruebas de rendimiento YOLO26 en diez formatos de modelo diferentes para medir la velocidad y la precisión: PyTorch, TorchScript, ONNX, OpenVINO, TF SavedModel, TF GraphDef, TF , MNN, NCNN y ExecuTorch. Las pruebas se ejecutaron en una Raspberry Pi 5 con precisión FP32 y un tamaño de imagen de entrada predeterminado de 640.

Gráfico comparativo

Solo hemos incluido pruebas de rendimiento para los modelos YOLO26n y YOLO26s, ya que los demás modelos son demasiado grandes para ejecutarse en las Raspberry Pi y no ofrecen un rendimiento adecuado.

Tabla de comparación detallada

La siguiente tabla muestra los resultados de referencia de dos modelos diferentes (YOLO26n, YOLO26s) en diez formatos diferentes (PyTorch, TorchScript, ONNX, OpenVINO, TF SavedModel, TF GraphDef, TF , MNN, NCNN, ExecuTorch), ejecutados en una Raspberry Pi 5, lo que nos proporciona el estado, el tamaño, la métrica mAP50(B) y el tiempo de inferencia para cada combinación.

Rendimiento

| Formato | Estado | Tamaño en disco (MB) | mAP50-95(B) | Tiempo de inferencia (ms/im) |

|---|---|---|---|---|

| PyTorch | ✅ | 5.3 | 0.4798 | 302.15 |

| TorchScript | ✅ | 9.8 | 0.4764 | 357.58 |

| ONNX | ✅ | 9.5 | 0.4764 | 130.33 |

| OpenVINO | ✅ | 9.6 | 0.4818 | 70.74 |

| TF SavedModel | ✅ | 24.6 | 0.4764 | 213.58 |

| TF GraphDef | ✅ | 9.5 | 0.4764 | 213.5 |

| TF Lite | ✅ | 9.9 | 0.4764 | 251.41 |

| MNN | ✅ | 9.4 | 0.4784 | 90.89 |

| NCNN | ✅ | 9.4 | 0.4805 | 67.69 |

| ExecuTorch | ✅ | 9.4 | 0.4764 | 148.36 |

| Formato | Estado | Tamaño en disco (MB) | mAP50-95(B) | Tiempo de inferencia (ms/im) |

|---|---|---|---|---|

| PyTorch | ✅ | 19.5 | 0.5740 | 836.54 |

| TorchScript | ✅ | 36.8 | 0.5665 | 1032.25 |

| ONNX | ✅ | 36.5 | 0.5665 | 351.96 |

| OpenVINO | ✅ | 36.7 | 0.5654 | 158.6 |

| TF SavedModel | ✅ | 92.2 | 0.5665 | 507.6 |

| TF GraphDef | ✅ | 36.5 | 0.5665 | 525.64 |

| TF Lite | ✅ | 36.9 | 0.5665 | 805.3 |

| MNN | ✅ | 36.4 | 0.5644 | 236.47 |

| NCNN | ✅ | 36.4 | 0.5697 | 168.47 |

| ExecuTorch | ✅ | 36.5 | 0.5665 | 388.72 |

Comparado con Ultralytics .4.1

Nota

El tiempo de inferencia no incluye el pre/post-procesamiento.

Reproducir nuestros resultados

Para reproducir los benchmarks de Ultralytics anteriores en todos los formatos de exportación, ejecuta este código:

Ejemplo

from ultralytics import YOLO

# Load a YOLO26n PyTorch model

model = YOLO("yolo26n.pt")

# Benchmark YOLO26n speed and accuracy on the COCO128 dataset for all export formats

results = model.benchmark(data="coco128.yaml", imgsz=640)

# Benchmark YOLO26n speed and accuracy on the COCO128 dataset for all export formats

yolo benchmark model=yolo26n.pt data=coco128.yaml imgsz=640

Tenga en cuenta que los resultados de los benchmarks pueden variar según la configuración exacta de hardware y software de un sistema, así como la carga de trabajo actual del sistema en el momento en que se ejecutan los benchmarks. Para obtener los resultados más fiables, utilice un conjunto de datos con un gran número de imágenes, p. ej., data='coco.yaml' (5000 imágenes de validación).

Utiliza la cámara Raspberry Pi

Al utilizar Raspberry Pi para proyectos de Visión por Computadora, puede ser esencial capturar transmisiones de video en tiempo real para realizar inferencias. El conector MIPI CSI integrado en la Raspberry Pi permite conectar módulos de cámara oficiales de Raspberry Pi. En esta guía, hemos utilizado un Módulo de Cámara Raspberry Pi 3 para capturar las transmisiones de video y realizar inferencias utilizando modelos YOLO26.

Consejo

Obtenga más información sobre los diferentes módulos de cámara que ofrece Raspberry Pi y también cómo empezar a utilizar los módulos de cámara de Raspberry Pi.

Nota

Raspberry Pi 5 utiliza conectores CSI más pequeños que Raspberry Pi 4 (15 pines frente a 22 pines), por lo que necesitará un cable adaptador de 15 pines a 22 pines para conectarse a una Raspberry Pi Camera.

Probar la cámara

Ejecute el siguiente comando después de conectar la cámara a la Raspberry Pi. Debería ver una transmisión de video en vivo desde la cámara durante unos 5 segundos.

rpicam-hello

Consejo

Más información sobre rpicam-hello uso en la documentación oficial de Raspberry Pi

Inferencia con Cámara

Existen 2 métodos para usar la cámara Raspberry Pi y ejecutar inferencias en modelos YOLO26.

Uso

Podemos usar picamera2 que viene preinstalado con Raspberry Pi OS para acceder a la cámara y ejecutar inferencias en modelos YOLO26.

Ejemplo

import cv2

from picamera2 import Picamera2

from ultralytics import YOLO

# Initialize the Picamera2

picam2 = Picamera2()

picam2.preview_configuration.main.size = (1280, 720)

picam2.preview_configuration.main.format = "RGB888"

picam2.preview_configuration.align()

picam2.configure("preview")

picam2.start()

# Load the YOLO26 model

model = YOLO("yolo26n.pt")

while True:

# Capture frame-by-frame

frame = picam2.capture_array()

# Run YOLO26 inference on the frame

results = model(frame)

# Visualize the results on the frame

annotated_frame = results[0].plot()

# Display the resulting frame

cv2.imshow("Camera", annotated_frame)

# Break the loop if 'q' is pressed

if cv2.waitKey(1) == ord("q"):

break

# Release resources and close windows

cv2.destroyAllWindows()

Necesitamos iniciar un flujo TCP con rpicam-vid de la cámara conectada, de modo que podamos usar esta URL de transmisión como entrada cuando realicemos la inferencia más adelante. Ejecute el siguiente comando para iniciar la transmisión TCP.

rpicam-vid -n -t 0 --inline --listen -o tcp://127.0.0.1:8888

Más información sobre rpicam-vid uso en la documentación oficial de Raspberry Pi

Ejemplo

from ultralytics import YOLO

# Load a YOLO26n PyTorch model

model = YOLO("yolo26n.pt")

# Run inference

results = model("tcp://127.0.0.1:8888")

yolo predict model=yolo26n.pt source="tcp://127.0.0.1:8888"

Consejo

Consulta nuestro documento sobre Fuentes de Inferencia si deseas cambiar el tipo de entrada de imagen/video

Prácticas recomendadas al usar Raspberry Pi

Hay un par de mejores prácticas a seguir para lograr el máximo rendimiento en Raspberry Pis que ejecutan YOLO26.

Use un SSD

Cuando se utiliza Raspberry Pi de forma continua 24x7, se recomienda utilizar un SSD para el sistema, ya que una tarjeta SD no podrá soportar escrituras continuas y podría averiarse. Con el conector PCIe integrado en la Raspberry Pi 5, ahora puede conectar SSD utilizando un adaptador como el NVMe Base para Raspberry Pi 5.

Flashear sin GUI

Al flashear Raspberry Pi OS, puede optar por no instalar el entorno de escritorio (Raspberry Pi OS Lite) y esto puede ahorrar un poco de RAM en el dispositivo, dejando más espacio para el procesamiento de visión artificial.

Overclock Raspberry Pi

Si desea un pequeño aumento de rendimiento al ejecutar modelos Ultralytics YOLO26 en Raspberry Pi 5, puede hacer overclocking a la CPU de su base de 2.4GHz a 2.9GHz y a la GPU de 800MHz a 1GHz. Si el sistema se vuelve inestable o falla, reduzca los valores de overclocking en incrementos de 100MHz. Asegure una refrigeración adecuada, ya que el overclocking aumenta la generación de calor y puede provocar una limitación térmica (thermal throttling).

a. Actualice el software

sudo apt update && sudo apt dist-upgradeb. Abrir para editar el archivo de configuración

sudo nano /boot/firmware/config.txtc. Agregue las siguientes líneas al final

arm_freq=3000 gpu_freq=1000 force_turbo=1d. Guarde y salga presionando CTRL + X, luego Y, y presione ENTER

e. Reinicia la Raspberry Pi

Próximos pasos

Ha configurado YOLO con éxito en su Raspberry Pi. Para más información y soporte, visite Ultralytics YOLO26 Docs y Kashmir World Foundation.

Agradecimientos y citas

Esta guía fue creada inicialmente por Daan Eeltink para Kashmir World Foundation, una organización dedicada al uso de YOLO para la conservación de especies en peligro de extinción. Reconocemos su trabajo pionero y su enfoque educativo en el ámbito de las tecnologías de detección de objetos.

Para obtener más información sobre las actividades de Kashmir World Foundation, puedes visitar su sitio web.

Preguntas frecuentes

¿Cómo configuro Ultralytics YOLO26 en una Raspberry Pi sin usar Docker?

Para configurar Ultralytics YOLO26 en una Raspberry Pi sin Docker, siga estos pasos:

- Actualice la lista de paquetes e instale

pip:sudo apt update sudo apt install python3-pip -y pip install -U pip - Instale el paquete Ultralytics con dependencias opcionales:

pip install ultralytics[export] - Reinicie el dispositivo para aplicar los cambios:

sudo reboot

Para obtener instrucciones detalladas, consulta la sección Comenzar sin Docker.

¿Por qué debería usar el formato NCNN de Ultralytics YOLO26 en Raspberry Pi para tareas de IA?

El formato NCNN de Ultralytics YOLO26 está altamente optimizado para plataformas móviles y embebidas, lo que lo hace ideal para ejecutar tareas de IA en dispositivos Raspberry Pi. NCNN maximiza el rendimiento de la inferencia al aprovechar la arquitectura ARM, proporcionando un procesamiento más rápido y eficiente en comparación con otros formatos. Para obtener más detalles sobre las opciones de exportación compatibles, visite la página de documentación de Ultralytics sobre opciones de despliegue.

¿Cómo puedo convertir un modelo YOLO26 al formato NCNN para usarlo en Raspberry Pi?

Puede convertir un modelo PyTorch YOLO26 al formato NCNN utilizando comandos Python o CLI:

Ejemplo

from ultralytics import YOLO

# Load a YOLO26n PyTorch model

model = YOLO("yolo26n.pt")

# Export the model to NCNN format

model.export(format="ncnn") # creates 'yolo26n_ncnn_model'

# Load the exported NCNN model

ncnn_model = YOLO("yolo26n_ncnn_model")

# Run inference

results = ncnn_model("https://ultralytics.com/images/bus.jpg")

# Export a YOLO26n PyTorch model to NCNN format

yolo export model=yolo26n.pt format=ncnn # creates 'yolo26n_ncnn_model'

# Run inference with the exported model

yolo predict model='yolo26n_ncnn_model' source='https://ultralytics.com/images/bus.jpg'

Para obtener más detalles, consulta la sección Usar NCNN en Raspberry Pi.

¿Cuáles son las diferencias de hardware entre Raspberry Pi 4 y Raspberry Pi 5 relevantes para ejecutar YOLO26?

Las principales diferencias incluyen:

- CPU: Raspberry Pi 4 utiliza Broadcom BCM2711, Cortex-A72 SoC de 64 bits, mientras que Raspberry Pi 5 utiliza Broadcom BCM2712, Cortex-A76 SoC de 64 bits.

- Frecuencia máxima de la CPU: Raspberry Pi 4 tiene una frecuencia máxima de 1,8 GHz, mientras que Raspberry Pi 5 alcanza los 2,4 GHz.

- Memoria: Raspberry Pi 4 ofrece hasta 8 GB de SDRAM LPDDR4-3200, mientras que Raspberry Pi 5 cuenta con SDRAM LPDDR4X-4267, disponible en variantes de 4 GB y 8 GB.

Estas mejoras contribuyen a mejores puntos de referencia de rendimiento para los modelos YOLO26 en Raspberry Pi 5 en comparación con Raspberry Pi 4. Consulte la tabla de Comparación de la serie Raspberry Pi para más detalles.

¿Cómo puedo configurar un módulo de cámara Raspberry Pi para que funcione con Ultralytics YOLO26?

Existen dos métodos para configurar una cámara Raspberry Pi para la inferencia con YOLO26:

Usando

picamera2:import cv2 from picamera2 import Picamera2 from ultralytics import YOLO picam2 = Picamera2() picam2.preview_configuration.main.size = (1280, 720) picam2.preview_configuration.main.format = "RGB888" picam2.preview_configuration.align() picam2.configure("preview") picam2.start() model = YOLO("yolo26n.pt") while True: frame = picam2.capture_array() results = model(frame) annotated_frame = results[0].plot() cv2.imshow("Camera", annotated_frame) if cv2.waitKey(1) == ord("q"): break cv2.destroyAllWindows()Usando un flujo TCP:

rpicam-vid -n -t 0 --inline --listen -o tcp://127.0.0.1:8888from ultralytics import YOLO model = YOLO("yolo26n.pt") results = model("tcp://127.0.0.1:8888")

Para obtener instrucciones de configuración detalladas, visita la sección Inferencia con cámara.