Mejores prácticas para la implementación de modelos

Introducción

El despliegue del modelo es el paso en un proyecto de visión artificial que lleva un modelo desde la fase de desarrollo a una aplicación del mundo real. Existen varias opciones de despliegue de modelos: el despliegue en la nube ofrece escalabilidad y facilidad de acceso, el despliegue en el borde reduce la latencia al acercar el modelo a la fuente de datos, y el despliegue local garantiza la privacidad y el control. La elección de la estrategia correcta depende de las necesidades de tu aplicación, equilibrando velocidad, seguridad y escalabilidad.

Ver: Cómo optimizar e implementar modelos de IA: Mejores prácticas, resolución de problemas y consideraciones de seguridad

También es importante seguir las mejores prácticas al implementar un modelo, ya que la implementación puede afectar significativamente la eficacia y la fiabilidad del rendimiento del modelo. En esta guía, nos centraremos en cómo asegurarnos de que la implementación de su modelo sea fluida, eficiente y segura.

Opciones de Implementación de Modelos

A menudo, una vez que un modelo es entrenado, evaluado y probado, necesita ser convertido a formatos específicos para ser desplegado eficazmente en varios entornos, como la nube, el edge o dispositivos locales.

Con YOLO26, puede exportar su modelo a varios formatos según sus necesidades de implementación. Por ejemplo, exportar YOLO26 a ONNX es sencillo e ideal para transferir modelos entre frameworks. Para explorar más opciones de integración y asegurar una implementación fluida en diferentes entornos, visite nuestro centro de integración de modelos.

Elegir un entorno de implementación

Elegir dónde implementar tu modelo de visión artificial depende de múltiples factores. Los diferentes entornos tienen beneficios y desafíos únicos, por lo que es esencial elegir el que mejor se adapte a tus necesidades.

Despliegue en la nube

El despliegue en la nube es ideal para aplicaciones que necesitan escalar rápidamente y manejar grandes cantidades de datos. Plataformas como AWS, Google Cloud y Azure facilitan la gestión de sus modelos desde el entrenamiento hasta el despliegue. Ofrecen servicios como AWS SageMaker, Google AI Platform y Azure Machine Learning para ayudarle durante todo el proceso.

Sin embargo, usar la nube puede ser costoso, especialmente con un alto uso de datos, y podría enfrentar problemas de latencia si sus usuarios están lejos de los centros de datos. Para administrar los costos y el rendimiento, es importante optimizar el uso de los recursos y garantizar el cumplimiento de las normas de privacidad de datos.

Implementación en el borde

La implementación en el borde funciona bien para aplicaciones que necesitan respuestas en tiempo real y baja latencia, particularmente en lugares con acceso a Internet limitado o nulo. La implementación de modelos en dispositivos de borde como teléfonos inteligentes o dispositivos IoT garantiza un procesamiento rápido y mantiene los datos locales, lo que mejora la privacidad. La implementación en el borde también ahorra ancho de banda debido a la reducción de datos enviados a la nube.

Sin embargo, los dispositivos periféricos a menudo tienen una potencia de procesamiento limitada, por lo que deberá optimizar sus modelos. Herramientas como TensorFlow Lite y NVIDIA Jetson pueden ayudar. A pesar de los beneficios, mantener y actualizar muchos dispositivos puede ser un desafío.

Implementación local

La implementación local es la mejor opción cuando la privacidad de los datos es fundamental o cuando no hay acceso a Internet o este no es confiable. Ejecutar modelos en servidores locales o equipos de escritorio le brinda control total y mantiene sus datos seguros. También puede reducir la latencia si el servidor está cerca del usuario.

Sin embargo, escalar localmente puede ser difícil y el mantenimiento puede llevar mucho tiempo. El uso de herramientas como Docker para la contenerización y Kubernetes para la administración puede ayudar a que las implementaciones locales sean más eficientes. Las actualizaciones y el mantenimiento regulares son necesarios para que todo funcione sin problemas.

Contenedores para una implementación optimizada

La contenerización es un enfoque potente que empaqueta su modelo y todas sus dependencias en una unidad estandarizada llamada contenedor. Esta técnica garantiza un rendimiento constante en diferentes entornos y simplifica el proceso de implementación.

Beneficios de usar Docker para la implementación de modelos

Docker se ha convertido en el estándar de la industria para la contenedorización en implementaciones de aprendizaje automático por varias razones:

- Consistencia del entorno: Los contenedores Docker encapsulan su modelo y todas sus dependencias, eliminando el problema de "funciona en mi máquina" al garantizar un comportamiento consistente en los entornos de desarrollo, prueba y producción.

- Aislamiento: Los contenedores aíslan las aplicaciones entre sí, evitando conflictos entre diferentes versiones de software o bibliotecas.

- Portabilidad: Los contenedores Docker pueden ejecutarse en cualquier sistema que admita Docker, lo que facilita la implementación de sus modelos en diferentes plataformas sin modificaciones.

- Escalabilidad: Los contenedores se pueden escalar o reducir fácilmente según la demanda, y las herramientas de orquestación como Kubernetes pueden automatizar este proceso.

- Control de Versiones: Las imágenes de Docker pueden ser versionadas, lo que le permite rastrear los cambios y volver a versiones anteriores si es necesario.

Implementación de Docker para la implementación de YOLO26

Para contenerizar su modelo YOLO26, puede crear un Dockerfile que especifique todas las dependencias y configuraciones necesarias. Aquí tiene un ejemplo básico:

FROM ultralytics/ultralytics:latest

WORKDIR /app

# Copy your model and any additional files

COPY ./models/yolo26.pt /app/models/

COPY ./scripts /app/scripts/

# Set up any environment variables

ENV MODEL_PATH=/app/models/yolo26.pt

# Command to run when the container starts

CMD ["python", "/app/scripts/predict.py"]

Este enfoque garantiza que la implementación de su modelo sea reproducible y coherente en diferentes entornos, lo que reduce significativamente el problema de "funciona en mi máquina" que a menudo afecta a los procesos de implementación.

Técnicas de Optimización de Modelos

La optimización de su modelo de visión artificial ayuda a que se ejecute de manera eficiente, especialmente cuando se implementa en entornos con recursos limitados, como los dispositivos edge. Aquí hay algunas técnicas clave para optimizar su modelo.

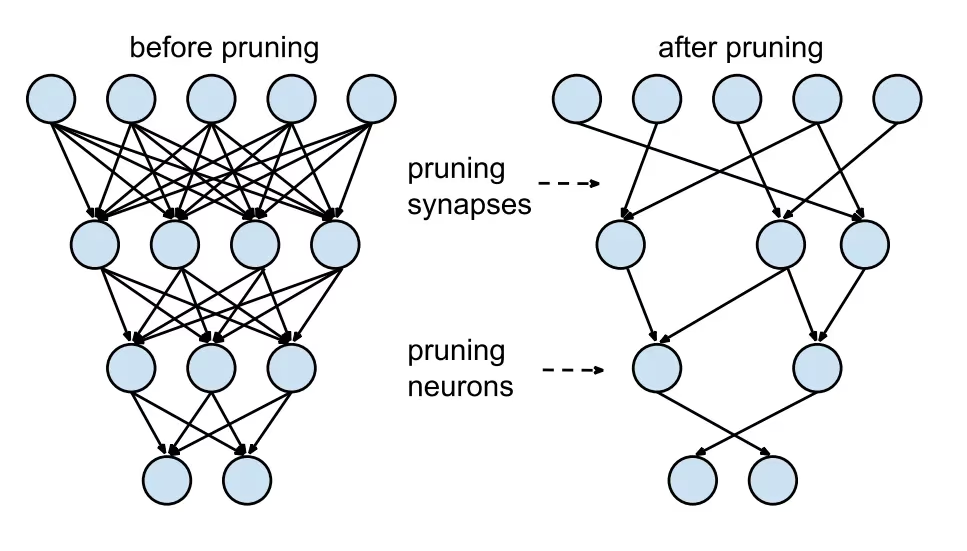

Poda de Modelos

La poda reduce el tamaño del modelo eliminando los pesos que contribuyen poco a la salida final. Hace que el modelo sea más pequeño y rápido sin afectar significativamente la precisión. La poda implica identificar y eliminar parámetros innecesarios, lo que resulta en un modelo más ligero que requiere menos potencia computacional. Es particularmente útil para implementar modelos en dispositivos con recursos limitados.

Cuantización de Modelos

La cuantización convierte los pesos y las activaciones del modelo de alta precisión (como floats de 32 bits) a menor precisión (como enteros de 8 bits). Al reducir el tamaño del modelo, se acelera la inferencia. El entrenamiento consciente de la cuantización (QAT) es un método donde el modelo se entrena teniendo en cuenta la cuantización, preservando la precisión mejor que la cuantización posterior al entrenamiento. Al manejar la cuantización durante la fase de entrenamiento, el modelo aprende a ajustarse a una menor precisión, manteniendo el rendimiento y reduciendo las demandas computacionales.

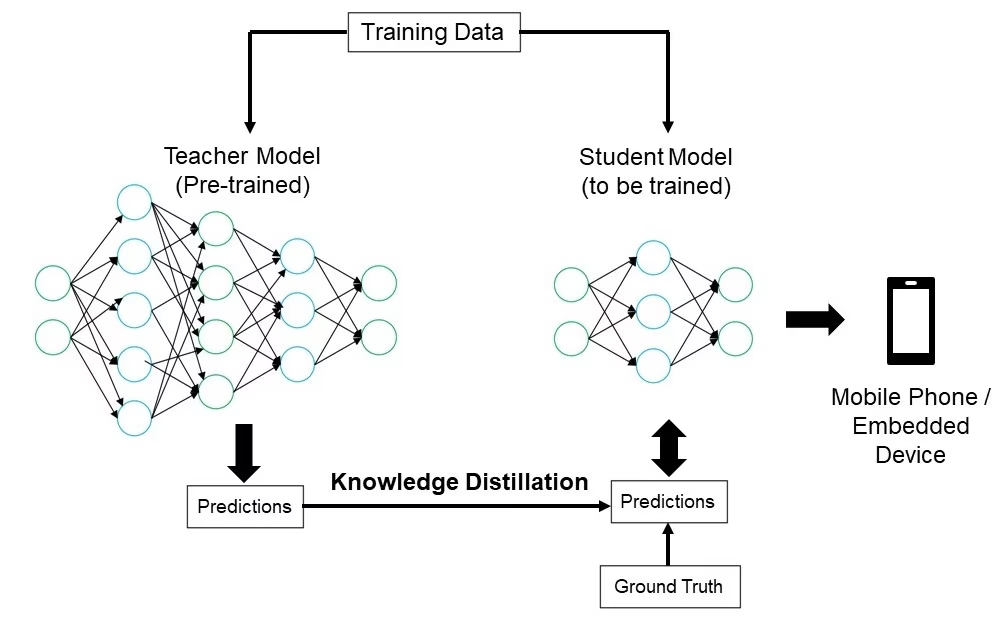

Destilación del Conocimiento

La destilación del conocimiento implica entrenar un modelo más pequeño y simple (el estudiante) para imitar las salidas de un modelo más grande y complejo (el profesor). El modelo estudiante aprende a aproximar las predicciones del profesor, lo que resulta en un modelo compacto que conserva gran parte de la precisión del profesor. Esta técnica es beneficiosa para crear modelos eficientes adecuados para su implementación en dispositivos periféricos con recursos limitados.

Solución de Problemas de Implementación

Puede enfrentarse a desafíos al implementar sus modelos de visión artificial, pero comprender los problemas y las soluciones comunes puede facilitar el proceso. Aquí tiene algunos consejos generales para la resolución de problemas y las mejores prácticas que le ayudarán a solucionar los problemas de implementación.

Su modelo es menos preciso después de la implementación

Experimentar una caída en la precisión de su modelo después de la implementación puede ser frustrante. Este problema puede deberse a varios factores. Aquí hay algunos pasos para ayudarle a identificar y resolver el problema:

- Verificar la consistencia de los datos: Compruebe que los datos que su modelo está procesando después de la implementación sean consistentes con los datos con los que fue entrenado. Las diferencias en la distribución, calidad o formato de los datos pueden afectar significativamente el rendimiento.

- Validar los pasos de preprocesamiento: Verifique que todos los pasos de preprocesamiento aplicados durante el entrenamiento también se apliquen de manera consistente durante la implementación. Esto incluye el cambio de tamaño de las imágenes, la normalización de los valores de los píxeles y otras transformaciones de datos.

- Evalúe el entorno del modelo: Asegúrese de que las configuraciones de hardware y software utilizadas durante la implementación coincidan con las utilizadas durante el entrenamiento. Las diferencias en las bibliotecas, las versiones y las capacidades de hardware pueden introducir discrepancias.

- Supervisar la inferencia del modelo: Registre las entradas y salidas en varias etapas del pipeline de inferencia para detectar cualquier anomalía. Puede ayudar a identificar problemas como la corrupción de datos o el manejo incorrecto de las salidas del modelo.

- Revisar la exportación y conversión del modelo: Vuelva a exportar el modelo y asegúrese de que el proceso de conversión mantenga la integridad de los pesos y la arquitectura del modelo.

- Pruebe con un conjunto de datos controlado: Implemente el modelo en un entorno de prueba con un conjunto de datos que controle y compare los resultados con la fase de entrenamiento. Puede identificar si el problema está en el entorno de implementación o en los datos.

Al implementar YOLO26, varios factores pueden afectar la precisión del modelo. La conversión de modelos a formatos como TensorRT implica optimizaciones como la cuantificación de pesos y la fusión de capas, lo que puede causar pequeñas pérdidas de precisión. El uso de FP16 (media precisión) en lugar de FP32 (precisión completa) puede acelerar la inferencia, pero puede introducir errores de precisión numérica. Además, las limitaciones de hardware, como las de la Jetson Nano, con menor número de núcleos CUDA y ancho de banda de memoria reducido, pueden afectar el rendimiento.

Las inferencias están tardando más de lo esperado

Al implementar modelos de aprendizaje automático, es importante que se ejecuten de manera eficiente. Si las inferencias tardan más de lo esperado, puede afectar la experiencia del usuario y la eficacia de su aplicación. Aquí hay algunos pasos para ayudarle a identificar y resolver el problema:

- Implemente ejecuciones de calentamiento: Las ejecuciones iniciales a menudo incluyen una sobrecarga de configuración, lo que puede sesgar las mediciones de latencia. Realice algunas inferencias de calentamiento antes de medir la latencia. Excluir estas ejecuciones iniciales proporciona una medición más precisa del rendimiento del modelo.

- Optimice el motor de inferencia: Verifique que el motor de inferencia esté completamente optimizado para su arquitectura de GPU específica. Utilice los controladores y las versiones de software más recientes adaptados a su hardware para garantizar el máximo rendimiento y compatibilidad.

- Utiliza Procesamiento Asíncrono: El procesamiento asíncrono puede ayudar a gestionar las cargas de trabajo de manera más eficiente. Utiliza técnicas de procesamiento asíncrono para manejar múltiples inferencias de forma concurrente, lo que puede ayudar a distribuir la carga y reducir los tiempos de espera.

- Perfilar la Tubería de Inferencia: Identificar los cuellos de botella en la tubería de inferencia puede ayudar a identificar la fuente de los retrasos. Utilice herramientas de creación de perfiles para analizar cada paso del proceso de inferencia, identificando y abordando cualquier etapa que cause retrasos significativos, como capas ineficientes o problemas de transferencia de datos.

- Utiliza la Precisión Adecuada: Usar una precisión mayor de la necesaria puede ralentizar los tiempos de inferencia. Experimenta con el uso de una precisión más baja, como FP16 (media precisión), en lugar de FP32 (precisión completa). Si bien FP16 puede reducir el tiempo de inferencia, también ten en cuenta que puede afectar la precisión del modelo.

Si se enfrenta a este problema al implementar YOLO26, considere que YOLO26 ofrece varios tamaños de modelo, como YOLO26n (nano) para dispositivos con menor capacidad de memoria y YOLO26x (extra-grande) para GPUs más potentes. Elegir la variante de modelo adecuada para su hardware puede ayudar a equilibrar el uso de memoria y el tiempo de procesamiento.

También ten en cuenta que el tamaño de las imágenes de entrada afecta directamente al uso de la memoria y al tiempo de procesamiento. Las resoluciones más bajas reducen el uso de memoria y aceleran la inferencia, mientras que las resoluciones más altas mejoran la precisión, pero requieren más memoria y potencia de procesamiento.

Consideraciones de seguridad en la implementación de modelos

Otro aspecto importante de la implementación es la seguridad. La seguridad de sus modelos implementados es fundamental para proteger los datos confidenciales y la propiedad intelectual. Aquí hay algunas prácticas recomendadas que puede seguir relacionadas con la implementación segura de modelos.

Transmisión Segura de Datos

Asegurarse de que los datos enviados entre clientes y servidores estén seguros es muy importante para evitar que sean interceptados o accedidos por partes no autorizadas. Puede utilizar protocolos de encriptación como TLS (Transport Layer Security) para encriptar los datos mientras se transmiten. Incluso si alguien intercepta los datos, no podrá leerlos. También puede utilizar el cifrado de extremo a extremo que protege los datos desde el origen hasta el destino, de modo que nadie intermedio pueda acceder a ellos.

Controles de acceso

Es fundamental controlar quién puede acceder a tu modelo y a sus datos para evitar usos no autorizados. Utiliza métodos de autenticación robustos para verificar la identidad de los usuarios o sistemas que intentan acceder al modelo, y considera la posibilidad de añadir seguridad adicional con la autenticación multifactor (MFA). Configura el control de acceso basado en roles (RBAC) para asignar permisos basados en los roles de los usuarios, de modo que las personas solo tengan acceso a lo que necesitan. Mantén registros de auditoría detallados para trackear todo el acceso y los cambios en el modelo y sus datos, y revisa estos registros periódicamente para detectar cualquier actividad sospechosa.

Ofuscación de Modelos

La protección de tu modelo contra la ingeniería inversa o el uso indebido se puede realizar mediante la ofuscación del modelo. Esto implica el cifrado de los parámetros del modelo, como los pesos y los sesgos en las redes neuronales, para dificultar que personas no autorizadas comprendan o alteren el modelo. También puedes ofuscar la arquitectura del modelo renombrando capas y parámetros o añadiendo capas ficticias, lo que dificulta a los atacantes realizar ingeniería inversa. También puedes servir el modelo en un entorno seguro, como un enclave seguro o utilizando un entorno de ejecución de confianza (TEE), lo que puede proporcionar una capa adicional de protección durante la inferencia.

Comparte ideas con tus compañeros

Ser parte de una comunidad de entusiastas de la visión artificial puede ayudarte a resolver problemas y aprender más rápido. Aquí tienes algunas formas de conectarte, obtener ayuda y compartir ideas.

Recursos de la comunidad

- Problemas de GitHub: Explore el repositorio de GitHub de YOLO26 y utilice la pestaña de Problemas para hacer preguntas, informar errores y sugerir nuevas características. La comunidad y los mantenedores están muy activos y listos para ayudar.

- Servidor de Discord de Ultralytics: Únete al servidor de Discord de Ultralytics para chatear con otros usuarios y desarrolladores, obtener soporte y compartir tus experiencias.

Documentación oficial

- Documentación de Ultralytics YOLO26: Visite la documentación oficial de YOLO26 para obtener guías detalladas y consejos útiles sobre varios proyectos de visión por computadora.

El uso de estos recursos te ayudará a resolver desafíos y a mantenerte al día con las últimas tendencias y prácticas en la comunidad de visión artificial.

Conclusión y Próximos Pasos

Repasamos algunas de las mejores prácticas a seguir al implementar modelos de visión artificial. Al proteger los datos, controlar el acceso y ofuscar los detalles del modelo, puede proteger la información confidencial y mantener sus modelos funcionando sin problemas. También analizamos cómo abordar problemas comunes como la reducción de la precisión y las inferencias lentas utilizando estrategias como ejecuciones de calentamiento, optimización de motores, procesamiento asíncrono, perfiles de canalizaciones y elección de la precisión adecuada.

Después de implementar tu modelo, el siguiente paso sería monitorear, mantener y documentar tu aplicación. El monitoreo regular ayuda a detectar y solucionar problemas rápidamente, el mantenimiento mantiene tus modelos actualizados y funcionales, y una buena documentación rastrea todos los cambios y actualizaciones. Estos pasos te ayudarán a alcanzar los objetivos de tu proyecto de visión artificial.

Preguntas frecuentes

¿Cuáles son las mejores prácticas para implementar un modelo de aprendizaje automático usando Ultralytics YOLO26?

El despliegue de un modelo de aprendizaje automático, particularmente con Ultralytics YOLO26, implica varias mejores prácticas para garantizar la eficiencia y la fiabilidad. Primero, elija el entorno de despliegue que se adapte a sus necesidades: nube, edge o local. Optimice su modelo mediante técnicas como la poda, la cuantificación y la destilación de conocimiento para un despliegue eficiente en entornos con recursos limitados. Considere utilizar la contenedorización con Docker para asegurar la consistencia entre diferentes entornos. Por último, asegúrese de que la consistencia de los datos y los pasos de preprocesamiento se alineen con la fase de entrenamiento para mantener el rendimiento. También puede consultar las opciones de despliegue de modelos para obtener directrices más detalladas.

¿Cómo puedo solucionar problemas comunes de implementación con modelos Ultralytics YOLO26?

La resolución de problemas de implementación se puede dividir en algunos pasos clave. Si la precisión de su modelo disminuye después de la implementación, verifique la coherencia de los datos, valide los pasos de preprocesamiento y asegúrese de que el entorno de hardware/software coincida con el que utilizó durante el entrenamiento. Para tiempos de inferencia lentos, realice ejecuciones de calentamiento, optimice su motor de inferencia, utilice el procesamiento asíncrono y perfile su canalización de inferencia. Consulte la solución de problemas de implementación para obtener una guía detallada sobre estas mejores prácticas.

¿Cómo la optimización de Ultralytics YOLO26 mejora el rendimiento del modelo en dispositivos edge?

La optimización de los modelos Ultralytics YOLO26 para dispositivos edge implica el uso de técnicas como la poda para reducir el tamaño del modelo, la cuantificación para convertir los pesos a menor precisión y la destilación de conocimiento para entrenar modelos más pequeños que imitan a los más grandes. Estas técnicas aseguran que el modelo se ejecute eficientemente en dispositivos con potencia computacional limitada. Herramientas como TensorFlow Lite y NVIDIA Jetson son particularmente útiles para estas optimizaciones. Obtenga más información sobre estas técnicas en nuestra sección sobre optimización de modelos.

¿Cuáles son las consideraciones de seguridad para implementar modelos de aprendizaje automático con Ultralytics YOLO26?

La seguridad es primordial al implementar modelos de aprendizaje automático. Asegure la transmisión segura de datos utilizando protocolos de cifrado como TLS. Implemente controles de acceso robustos, incluyendo autenticación fuerte y control de acceso basado en roles (RBAC). Las técnicas de ofuscación de modelos, como el cifrado de los parámetros del modelo y el servicio de modelos en un entorno seguro como un entorno de ejecución confiable (TEE), ofrecen protección adicional. Para conocer las prácticas detalladas, consulte las consideraciones de seguridad.

¿Cómo elijo el entorno de implementación adecuado para mi modelo Ultralytics YOLO26?

La selección del entorno de despliegue óptimo para su modelo Ultralytics YOLO26 depende de las necesidades específicas de su aplicación. El despliegue en la nube ofrece escalabilidad y facilidad de acceso, lo que lo hace ideal para aplicaciones con grandes volúmenes de datos. El despliegue en edge es el mejor para aplicaciones de baja latencia que requieren respuestas en tiempo real, utilizando herramientas como TensorFlow Lite. El despliegue local se adapta a escenarios que necesitan una estricta privacidad y control de los datos. Para una visión general completa de cada entorno, consulte nuestra sección sobre elección de un entorno de despliegue.