Détection d'objets

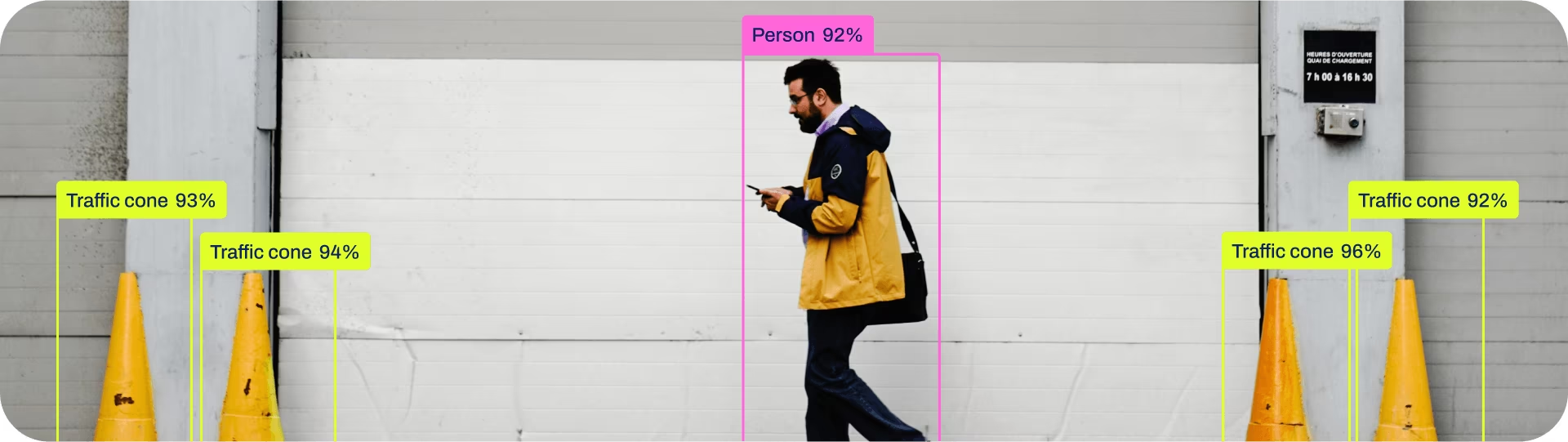

La détection d'objets est une tâche qui consiste à identifier l'emplacement et la classe des objets dans une image ou un flux vidéo.

Le résultat d'un détecteur d'objets est un ensemble de boîtes englobantes qui entourent les objets dans l'image, ainsi que les étiquettes de classe et les scores de confiance pour chaque boîte. La détection d'objets est un bon choix lorsque vous devez identifier des objets d'intérêt dans une scène, mais que vous n'avez pas besoin de connaître exactement l'emplacement de l'objet ou sa forme exacte.

Regarder : Détection d'objets avec un modèle YOLO Ultralytics pré-entraîné.

Astuce

Les modèles YOLO26 Detect sont les modèles YOLO26 par défaut, c'est-à-dire, yolo26n.pt, et sont pré-entraînés sur COCO.

Modèles

Les modèles Detect pré-entraînés de YOLO26 sont présentés ici. Les modèles Detect, Segment et Pose sont pré-entraînés sur le jeu de données COCO, tandis que les modèles Classify sont pré-entraînés sur le jeu de données ImageNet.

Les modèles sont téléchargés automatiquement à partir de la dernière version d'Ultralytics lors de la première utilisation.

| Modèle | Taille (pixels) | mAPval 50-95 | mAPval 50-95(e2e) | Vitesse CPU ONNX (ms) | Vitesse T4 TensorRT10 (ms) | paramètres (M) | FLOPs (B) |

|---|---|---|---|---|---|---|---|

| YOLO26n | 640 | 40.9 | 40.1 | 38.9 ± 0.7 | 1.7 ± 0.0 | 2.4 | 5.4 |

| YOLO26s | 640 | 48.6 | 47.8 | 87.2 ± 0.9 | 2.5 ± 0.0 | 9.5 | 20.7 |

| YOLO26m | 640 | 53.1 | 52.5 | 220.0 ± 1.4 | 4.7 ± 0.1 | 20.4 | 68.2 |

| YOLO26l | 640 | 55.0 | 54.4 | 286.2 ± 2.0 | 6.2 ± 0.2 | 24.8 | 86.4 |

| YOLO26x | 640 | 57.5 | 56.9 | 525.8 ± 4.0 | 11.8 ± 0.2 | 55.7 | 193.9 |

- mAPval Les valeurs COCO val2017 dataset.

Reproduire en utilisantyolo val detect data=coco.yaml device=0 - Vitesse moyennée sur les images COCO val en utilisant un instance Amazon EC2 P4d. instance.

Reproduire en utilisantyolo val detect data=coco.yaml batch=1 device=0|cpu

Entraîner

Entraînez YOLO26n sur le jeu de données COCO8 pendant 100 époques avec une taille d'image de 640. Pour une liste complète des arguments disponibles, consultez la page de Configuration.

Exemple

from ultralytics import YOLO

# Load a model

model = YOLO("yolo26n.yaml") # build a new model from YAML

model = YOLO("yolo26n.pt") # load a pretrained model (recommended for training)

model = YOLO("yolo26n.yaml").load("yolo26n.pt") # build from YAML and transfer weights

# Train the model

results = model.train(data="coco8.yaml", epochs=100, imgsz=640)

# Build a new model from YAML and start training from scratch

yolo detect train data=coco8.yaml model=yolo26n.yaml epochs=100 imgsz=640

# Start training from a pretrained *.pt model

yolo detect train data=coco8.yaml model=yolo26n.pt epochs=100 imgsz=640

# Build a new model from YAML, transfer pretrained weights to it and start training

yolo detect train data=coco8.yaml model=yolo26n.yaml pretrained=yolo26n.pt epochs=100 imgsz=640

Format du jeu de données

Le format de jeu de données de détection YOLO est décrit en détail dans le Guide des jeux de données. Pour convertir votre jeu de données existant d'autres formats (comme COCO, etc.) au format YOLO, veuillez utiliser l'outil JSON2YOLO d'Ultralytics.

Valider

Valider le modèle YOLO26n entraîné précision sur l'ensemble de données COCO8. Aucun argument n'est nécessaire car le model conserve son entraînement data et ses arguments en tant qu'attributs du modèle.

Exemple

from ultralytics import YOLO

# Load a model

model = YOLO("yolo26n.pt") # load an official model

model = YOLO("path/to/best.pt") # load a custom model

# Validate the model

metrics = model.val() # no arguments needed, dataset and settings remembered

metrics.box.map # map50-95

metrics.box.map50 # map50

metrics.box.map75 # map75

metrics.box.maps # a list containing mAP50-95 for each category

yolo detect val model=yolo26n.pt # val official model

yolo detect val model=path/to/best.pt # val custom model

Prédire

Utilisez un modèle YOLO26n entraîné pour exécuter des prédictions sur des images.

Exemple

from ultralytics import YOLO

# Load a model

model = YOLO("yolo26n.pt") # load an official model

model = YOLO("path/to/best.pt") # load a custom model

# Predict with the model

results = model("https://ultralytics.com/images/bus.jpg") # predict on an image

# Access the results

for result in results:

xywh = result.boxes.xywh # center-x, center-y, width, height

xywhn = result.boxes.xywhn # normalized

xyxy = result.boxes.xyxy # top-left-x, top-left-y, bottom-right-x, bottom-right-y

xyxyn = result.boxes.xyxyn # normalized

names = [result.names[cls.item()] for cls in result.boxes.cls.int()] # class name of each box

confs = result.boxes.conf # confidence score of each box

yolo detect predict model=yolo26n.pt source='https://ultralytics.com/images/bus.jpg' # predict with official model

yolo detect predict model=path/to/best.pt source='https://ultralytics.com/images/bus.jpg' # predict with custom model

Voir tous les predict détails du mode dans la Prédire page.

Exporter

Exportez un modèle YOLO26n vers un format différent comme ONNX, CoreML, etc.

Exemple

from ultralytics import YOLO

# Load a model

model = YOLO("yolo26n.pt") # load an official model

model = YOLO("path/to/best.pt") # load a custom-trained model

# Export the model

model.export(format="onnx")

yolo export model=yolo26n.pt format=onnx # export official model

yolo export model=path/to/best.pt format=onnx # export custom-trained model

Les formats d'exportation YOLO26 disponibles sont présentés dans le tableau ci-dessous. Vous pouvez exporter vers n'importe quel format en utilisant le format argument, c'est-à-dire format='onnx' ou format='engine'. Vous pouvez prédire ou valider directement sur les modèles exportés, c'est-à-dire, yolo predict model=yolo26n.onnx. Des exemples d'utilisation sont présentés pour votre modèle une fois l'exportation terminée.

| Format | format Argument | Modèle | Métadonnées | Arguments |

|---|---|---|---|---|

| PyTorch | - | yolo26n.pt | ✅ | - |

| TorchScript | torchscript | yolo26n.torchscript | ✅ | imgsz, half, dynamic, optimize, nms, batch, device |

| ONNX | onnx | yolo26n.onnx | ✅ | imgsz, half, dynamic, simplify, opset, nms, batch, device |

| OpenVINO | openvino | yolo26n_openvino_model/ | ✅ | imgsz, half, dynamic, int8, nms, batch, data, fraction, device |

| TensorRT | engine | yolo26n.engine | ✅ | imgsz, half, dynamic, simplify, workspace, int8, nms, batch, data, fraction, device |

| CoreML | coreml | yolo26n.mlpackage | ✅ | imgsz, dynamic, half, int8, nms, batch, device |

| TF SavedModel | saved_model | yolo26n_saved_model/ | ✅ | imgsz, keras, int8, nms, batch, device |

| TF GraphDef | pb | yolo26n.pb | ❌ | imgsz, batch, device |

| TF Lite | tflite | yolo26n.tflite | ✅ | imgsz, half, int8, nms, batch, data, fraction, device |

| TF Edge TPU | edgetpu | yolo26n_edgetpu.tflite | ✅ | imgsz, device |

| TF.js | tfjs | yolo26n_web_model/ | ✅ | imgsz, half, int8, nms, batch, device |

| PaddlePaddle | paddle | yolo26n_paddle_model/ | ✅ | imgsz, batch, device |

| MNN | mnn | yolo26n.mnn | ✅ | imgsz, batch, int8, half, device |

| NCNN | ncnn | yolo26n_ncnn_model/ | ✅ | imgsz, half, batch, device |

| IMX500 | imx | yolo26n_imx_model/ | ✅ | imgsz, int8, data, fraction, device |

| RKNN | rknn | yolo26n_rknn_model/ | ✅ | imgsz, batch, name, device |

| ExecuTorch | executorch | yolo26n_executorch_model/ | ✅ | imgsz, device |

| Axelera | axelera | yolo26n_axelera_model/ | ✅ | imgsz, int8, data, fraction, device |

Voir tous les export détails dans la section Exporter page.

FAQ

Comment entraîner un modèle YOLO26 sur mon jeu de données personnalisé ?

L'entraînement d'un modèle YOLO26 sur un jeu de données personnalisé implique plusieurs étapes :

- Préparer le jeu de données : Assurez-vous que votre jeu de données est au format YOLO. Pour obtenir de l'aide, consultez notre Guide sur les jeux de données.

- Charger le modèle : Utilisez la bibliothèque Ultralytics YOLO pour charger un modèle pré-entraîné ou créer un nouveau modèle à partir d'un fichier yaml.

- Entraîner le modèle: Exécuter la méthode

traindans python ou la commandeyolo detect traindans la CLI.

Exemple

from ultralytics import YOLO

# Load a pretrained model

model = YOLO("yolo26n.pt")

# Train the model on your custom dataset

model.train(data="my_custom_dataset.yaml", epochs=100, imgsz=640)

yolo detect train data=my_custom_dataset.yaml model=yolo26n.pt epochs=100 imgsz=640

Pour des options de configuration détaillées, consultez la page Configuration.

Quels modèles pré-entraînés sont disponibles dans YOLO26 ?

Ultralytics YOLO26 propose divers modèles pré-entraînés pour la détection d'objets, la segmentation et l'estimation de pose. Ces modèles sont pré-entraînés sur le jeu de données COCO ou ImageNet pour les tâches de classification. Voici quelques-uns des modèles disponibles :

Pour une liste détaillée et des mesures de performance, consultez la section Modèles.

Comment puis-je valider la précision de mon modèle YOLO entraîné ?

Pour valider la précision de votre modèle YOLO26 entraîné, vous pouvez utiliser le .val() dans python ou la commande yolo detect val commande dans la CLI. Cela fournira des métriques telles que mAP50-95, mAP50, et plus encore.

Exemple

from ultralytics import YOLO

# Load the model

model = YOLO("path/to/best.pt")

# Validate the model

metrics = model.val()

print(metrics.box.map) # mAP50-95

yolo detect val model=path/to/best.pt

Pour plus de détails sur la validation, consultez la page Val.

Vers quels formats puis-je exporter un modèle YOLO26 ?

Ultralytics YOLO26 permet d'exporter des modèles vers divers formats tels que ONNX, TensorRT, CoreML, et d'autres, afin d'assurer la compatibilité entre différentes plateformes et appareils.

Exemple

from ultralytics import YOLO

# Load the model

model = YOLO("yolo26n.pt")

# Export the model to ONNX format

model.export(format="onnx")

yolo export model=yolo26n.pt format=onnx

Consultez la liste complète des formats pris en charge et les instructions sur la page Export.

Pourquoi devrais-je utiliser Ultralytics YOLO26 pour la détection d'objets ?

Ultralytics YOLO26 est conçu pour offrir des performances de pointe en matière de détection d'objets, de segmentation et d'estimation de pose. Voici quelques avantages clés :

- Modèles pré-entraînés : Utilisez des modèles pré-entraînés sur des ensembles de données populaires comme COCO et ImageNet pour un développement plus rapide.

- Haute précision : Atteint des scores de mAP impressionnants, assurant une detect d’objets fiable.

- Vitesse : Optimisé pour l'inférence en temps réel, ce qui le rend idéal pour les applications nécessitant un traitement rapide.

- Flexibilité : Exportez les modèles vers différents formats tels que ONNX et TensorRT pour un déploiement sur plusieurs plateformes.

Explorez notre Blog pour découvrir des cas d'utilisation et des réussites présentant YOLO26 en action.