Dataset COCO

Il COCO (Common Objects in Context) dataset è un dataset su larga scala per object detection, segmentazione e captioning. È progettato per incoraggiare la ricerca su un'ampia varietà di categorie di oggetti ed è comunemente utilizzato per il benchmarking di modelli di computer vision. È un dataset essenziale per ricercatori e sviluppatori che lavorano su attività di object detection, segmentazione e stima della posa.

Guarda: Panoramica del dataset COCO di Ultralytics

Modelli pre-addestrati COCO

| Modello | dimensione (pixel) | mAPval 50-95 | mAPval 50-95(e2e) | Velocità CPU ONNX (ms) | Velocità T4 TensorRT10 (ms) | parametri (M) | FLOPs (B) |

|---|---|---|---|---|---|---|---|

| YOLO26n | 640 | 40.9 | 40.1 | 38.9 ± 0.7 | 1.7 ± 0.0 | 2.4 | 5.4 |

| YOLO26s | 640 | 48.6 | 47.8 | 87.2 ± 0.9 | 2.5 ± 0.0 | 9.5 | 20.7 |

| YOLO26m | 640 | 53.1 | 52.5 | 220.0 ± 1.4 | 4.7 ± 0.1 | 20.4 | 68.2 |

| YOLO26l | 640 | 55.0 | 54.4 | 286.2 ± 2.0 | 6.2 ± 0.2 | 24.8 | 86.4 |

| YOLO26x | 640 | 57.5 | 56.9 | 525.8 ± 4.0 | 11.8 ± 0.2 | 55.7 | 193.9 |

Caratteristiche principali

- COCO contiene 330.000 immagini, di cui 200.000 immagini con annotazioni per attività di object detection, segmentazione e captioning.

- Il dataset comprende 80 categorie di oggetti, inclusi oggetti comuni come auto, biciclette e animali, nonché categorie più specifiche come ombrelli, borse e attrezzature sportive.

- Le annotazioni includono i riquadri di delimitazione degli oggetti, le maschere di segmentazione e le didascalie per ogni immagine.

- COCO fornisce metriche di valutazione standardizzate come la precisione media media (mAP) per l'object detection e il richiamo medio medio (mAR) per le attività di segmentazione, rendendolo adatto per confrontare le prestazioni del modello.

Struttura del set di dati

Il dataset COCO è suddiviso in tre sottoinsiemi:

- Train2017: Questo sottoinsieme contiene 118.000 immagini per l'addestramento di modelli di rilevamento di oggetti, segmentazione e didascalie.

- Val2017: Questo sottoinsieme ha 5.000 immagini utilizzate per scopi di convalida durante l'addestramento del modello.

- Test2017: Questo sottoinsieme è costituito da 20.000 immagini utilizzate per il test e il benchmarking dei modelli addestrati. Le annotazioni ground truth per questo sottoinsieme non sono disponibili pubblicamente e i risultati vengono inviati al server di valutazione COCO per la valutazione delle prestazioni.

Applicazioni

Il dataset COCO è ampiamente utilizzato per l'addestramento e la valutazione di modelli di deep learning nell'object detection (come Ultralytics YOLO, Faster R-CNN e SSD), nella segmentation di istanze (come Mask R-CNN) e nella keypoint detection (come OpenPose). L'insieme diversificato di categorie di oggetti del dataset, l'elevato numero di immagini annotate e le metriche di valutazione standardizzate lo rendono una risorsa essenziale per i ricercatori e i professionisti della computer vision.

YAML del set di dati

Un file YAML (Yet Another Markup Language) viene utilizzato per definire la configurazione del dataset. Contiene informazioni sui percorsi, le classi e altre informazioni rilevanti del dataset. Nel caso del dataset COCO, il coco.yaml file è mantenuto in https://github.com/ultralytics/ultralytics/blob/main/ultralytics/cfg/datasets/coco.yaml.

ultralytics/cfg/datasets/coco.yaml

# Ultralytics 🚀 AGPL-3.0 License - https://ultralytics.com/license

# COCO 2017 dataset https://cocodataset.org by Microsoft

# Documentation: https://docs.ultralytics.com/datasets/detect/coco/

# Example usage: yolo train data=coco.yaml

# parent

# ├── ultralytics

# └── datasets

# └── coco ← downloads here (20.1 GB)

# Train/val/test sets as 1) dir: path/to/imgs, 2) file: path/to/imgs.txt, or 3) list: [path/to/imgs1, path/to/imgs2, ..]

path: coco # dataset root dir

train: train2017.txt # train images (relative to 'path') 118287 images

val: val2017.txt # val images (relative to 'path') 5000 images

test: test-dev2017.txt # 20288 of 40670 images, submit to https://competitions.codalab.org/competitions/20794

# Classes

names:

0: person

1: bicycle

2: car

3: motorcycle

4: airplane

5: bus

6: train

7: truck

8: boat

9: traffic light

10: fire hydrant

11: stop sign

12: parking meter

13: bench

14: bird

15: cat

16: dog

17: horse

18: sheep

19: cow

20: elephant

21: bear

22: zebra

23: giraffe

24: backpack

25: umbrella

26: handbag

27: tie

28: suitcase

29: frisbee

30: skis

31: snowboard

32: sports ball

33: kite

34: baseball bat

35: baseball glove

36: skateboard

37: surfboard

38: tennis racket

39: bottle

40: wine glass

41: cup

42: fork

43: knife

44: spoon

45: bowl

46: banana

47: apple

48: sandwich

49: orange

50: broccoli

51: carrot

52: hot dog

53: pizza

54: donut

55: cake

56: chair

57: couch

58: potted plant

59: bed

60: dining table

61: toilet

62: tv

63: laptop

64: mouse

65: remote

66: keyboard

67: cell phone

68: microwave

69: oven

70: toaster

71: sink

72: refrigerator

73: book

74: clock

75: vase

76: scissors

77: teddy bear

78: hair drier

79: toothbrush

# Download script/URL (optional)

download: |

from pathlib import Path

from ultralytics.utils import ASSETS_URL

from ultralytics.utils.downloads import download

# Download labels

segments = True # segment or box labels

dir = Path(yaml["path"]) # dataset root dir

urls = [ASSETS_URL + ("/coco2017labels-segments.zip" if segments else "/coco2017labels.zip")] # labels

download(urls, dir=dir.parent)

# Download data

urls = [

"http://images.cocodataset.org/zips/train2017.zip", # 19G, 118k images

"http://images.cocodataset.org/zips/val2017.zip", # 1G, 5k images

"http://images.cocodataset.org/zips/test2017.zip", # 7G, 41k images (optional)

]

download(urls, dir=dir / "images", threads=3)

Utilizzo

Per addestrare un modello YOLO26n sul dataset COCO per 100 epoche con una dimensione dell'immagine di 640, è possibile utilizzare i seguenti frammenti di codice. Per un elenco completo degli argomenti disponibili, fare riferimento alla pagina di Addestramento del modello.

Esempio di addestramento

from ultralytics import YOLO

# Load a model

model = YOLO("yolo26n.pt") # load a pretrained model (recommended for training)

# Train the model

results = model.train(data="coco.yaml", epochs=100, imgsz=640)

# Start training from a pretrained *.pt model

yolo detect train data=coco.yaml model=yolo26n.pt epochs=100 imgsz=640

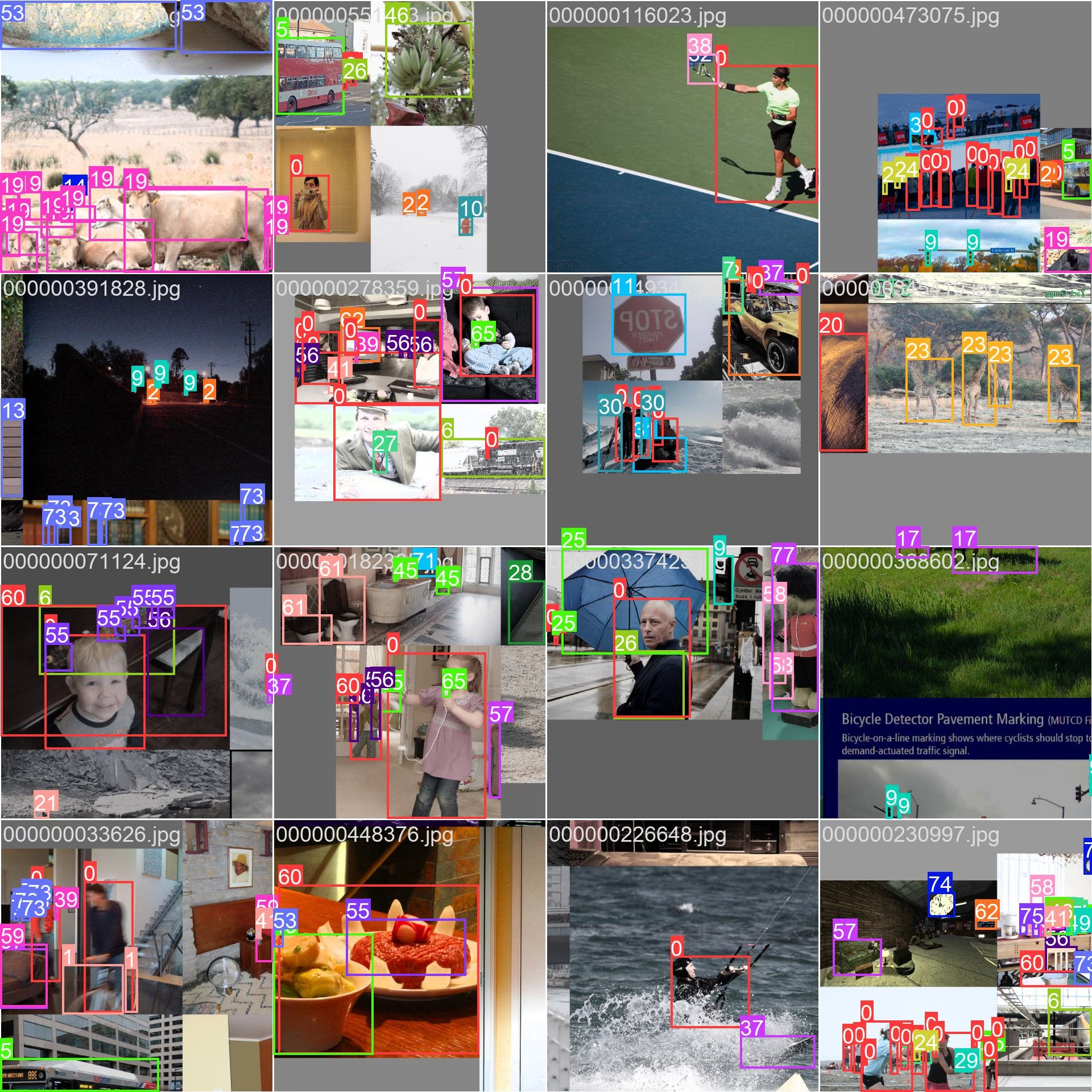

Immagini di esempio e annotazioni

Il dataset COCO contiene un insieme diversificato di immagini con varie categorie di oggetti e scene complesse. Ecco alcuni esempi di immagini dal dataset, insieme alle loro annotazioni corrispondenti:

- Immagine mosaicata: questa immagine mostra un batch di addestramento composto da immagini del dataset mosaicato. Il mosaicing è una tecnica utilizzata durante l'addestramento che combina più immagini in un'unica immagine per aumentare la varietà di oggetti e scene all'interno di ogni batch di addestramento. Ciò contribuisce a migliorare la capacità del modello di generalizzare a diverse dimensioni degli oggetti, proporzioni e contesti.

L'esempio mostra la varietà e la complessità delle immagini nel dataset COCO e i vantaggi dell'utilizzo del mosaicing durante il processo di addestramento.

Citazioni e ringraziamenti

Se utilizzi il dataset COCO nel tuo lavoro di ricerca o sviluppo, cita il seguente articolo:

@misc{lin2015microsoft,

title={Microsoft COCO: Common Objects in Context},

author={Tsung-Yi Lin and Michael Maire and Serge Belongie and Lubomir Bourdev and Ross Girshick and James Hays and Pietro Perona and Deva Ramanan and C. Lawrence Zitnick and Piotr Dollár},

year={2015},

eprint={1405.0312},

archivePrefix={arXiv},

primaryClass={cs.CV}

}

Desideriamo ringraziare il COCO Consortium per aver creato e mantenuto questa preziosa risorsa per la community di computer vision. Per ulteriori informazioni sul dataset COCO e sui suoi creatori, visitare il sito web del dataset COCO.

FAQ

Cos'è il dataset COCO e perché è importante per la computer vision?

Il dataset COCO (Common Objects in Context) è un dataset su larga scala utilizzato per l'object detection, la segmentazione e il captioning. Contiene 330.000 immagini con annotazioni dettagliate per 80 categorie di oggetti, rendendolo essenziale per il benchmarking e l'addestramento di modelli di computer vision. I ricercatori utilizzano COCO grazie alle sue diverse categorie e alle metriche di valutazione standardizzate come la mean Average Precision (mAP).

Come posso addestrare un modello YOLO utilizzando il dataset COCO?

Per addestrare un modello YOLO26 utilizzando il dataset COCO, è possibile utilizzare i seguenti frammenti di codice:

Esempio di addestramento

from ultralytics import YOLO

# Load a model

model = YOLO("yolo26n.pt") # load a pretrained model (recommended for training)

# Train the model

results = model.train(data="coco.yaml", epochs=100, imgsz=640)

# Start training from a pretrained *.pt model

yolo detect train data=coco.yaml model=yolo26n.pt epochs=100 imgsz=640

Fare riferimento alla pagina di training per maggiori dettagli sugli argomenti disponibili.

Quali sono le caratteristiche principali del dataset COCO?

Il dataset COCO include:

- 330.000 immagini, di cui 200.000 annotate per il rilevamento di oggetti, la segmentazione e la didascalia.

- 80 categorie di oggetti che vanno da oggetti comuni come auto e animali a oggetti specifici come borse e attrezzature sportive.

- Metriche di valutazione standardizzate per l'object detection (mAP) e la segmentazione (mean Average Recall, mAR).

- Tecnica di Mosaicing nei batch di addestramento per migliorare la generalizzazione del modello attraverso varie dimensioni e contesti degli oggetti.

Dove posso trovare modelli YOLO26 pre-addestrati sul dataset COCO?

I modelli YOLO26 pre-addestrati sul dataset COCO possono essere scaricati dai link forniti nella documentazione. Esempi includono:

Questi modelli variano in termini di dimensioni, mAP e velocità di inferenza, offrendo opzioni per diverse esigenze di performance e risorse.

Come è strutturato il dataset COCO e come posso utilizzarlo?

Il dataset COCO è suddiviso in tre sottoinsiemi:

- Train2017: 118.000 immagini per l'addestramento.

- Val2017: 5.000 immagini per la convalida durante l'addestramento.

- Test2017: 20.000 immagini per il benchmarking dei modelli addestrati. I risultati devono essere inviati al server di valutazione COCO per la valutazione delle prestazioni.

Il file di configurazione YAML del dataset è disponibile su coco.yaml, che definisce percorsi, classi e dettagli del dataset.