Dataset COCO128

Introduzione

Ultralytics COCO128 è un piccolo ma versatile dataset di object detection composto dalle prime 128 immagini del set COCO train 2017. Questo dataset è ideale per testare ed eseguire il debug di modelli di object detection o per sperimentare nuovi approcci di detection. Con 128 immagini, è abbastanza piccolo da essere facilmente gestibile, ma abbastanza diversificato da testare le pipeline di addestramento per gli errori e fungere da controllo di integrità prima di addestrare dataset più grandi.

Guarda: Panoramica del dataset COCO di Ultralytics

Questo dataset è destinato all'uso con Piattaforma Ultralytics e YOLO26.

YAML del set di dati

Un file YAML (Yet Another Markup Language) viene utilizzato per definire la configurazione del dataset. Contiene informazioni sui percorsi, le classi e altre informazioni rilevanti del dataset. Nel caso del dataset COCO128, il coco128.yaml file è mantenuto in https://github.com/ultralytics/ultralytics/blob/main/ultralytics/cfg/datasets/coco128.yaml.

ultralytics/cfg/datasets/coco128.yaml

# Ultralytics 🚀 AGPL-3.0 License - https://ultralytics.com/license

# COCO128 dataset https://www.kaggle.com/datasets/ultralytics/coco128 (first 128 images from COCO train2017) by Ultralytics

# Documentation: https://docs.ultralytics.com/datasets/detect/coco/

# Example usage: yolo train data=coco128.yaml

# parent

# ├── ultralytics

# └── datasets

# └── coco128 ← downloads here (7 MB)

# Train/val/test sets as 1) dir: path/to/imgs, 2) file: path/to/imgs.txt, or 3) list: [path/to/imgs1, path/to/imgs2, ..]

path: coco128 # dataset root dir

train: images/train2017 # train images (relative to 'path') 128 images

val: images/train2017 # val images (relative to 'path') 128 images

test: # test images (optional)

# Classes

names:

0: person

1: bicycle

2: car

3: motorcycle

4: airplane

5: bus

6: train

7: truck

8: boat

9: traffic light

10: fire hydrant

11: stop sign

12: parking meter

13: bench

14: bird

15: cat

16: dog

17: horse

18: sheep

19: cow

20: elephant

21: bear

22: zebra

23: giraffe

24: backpack

25: umbrella

26: handbag

27: tie

28: suitcase

29: frisbee

30: skis

31: snowboard

32: sports ball

33: kite

34: baseball bat

35: baseball glove

36: skateboard

37: surfboard

38: tennis racket

39: bottle

40: wine glass

41: cup

42: fork

43: knife

44: spoon

45: bowl

46: banana

47: apple

48: sandwich

49: orange

50: broccoli

51: carrot

52: hot dog

53: pizza

54: donut

55: cake

56: chair

57: couch

58: potted plant

59: bed

60: dining table

61: toilet

62: tv

63: laptop

64: mouse

65: remote

66: keyboard

67: cell phone

68: microwave

69: oven

70: toaster

71: sink

72: refrigerator

73: book

74: clock

75: vase

76: scissors

77: teddy bear

78: hair drier

79: toothbrush

# Download script/URL (optional)

download: https://github.com/ultralytics/assets/releases/download/v0.0.0/coco128.zip

Utilizzo

Per addestrare un modello YOLO26n sul dataset COCO128 per 100 epoche con una dimensione dell'immagine di 640, è possibile utilizzare i seguenti snippet di codice. Per un elenco completo degli argomenti disponibili, fare riferimento alla pagina di addestramento del modello.

Esempio di addestramento

from ultralytics import YOLO

# Load a model

model = YOLO("yolo26n.pt") # load a pretrained model (recommended for training)

# Train the model

results = model.train(data="coco128.yaml", epochs=100, imgsz=640)

# Start training from a pretrained *.pt model

yolo detect train data=coco128.yaml model=yolo26n.pt epochs=100 imgsz=640

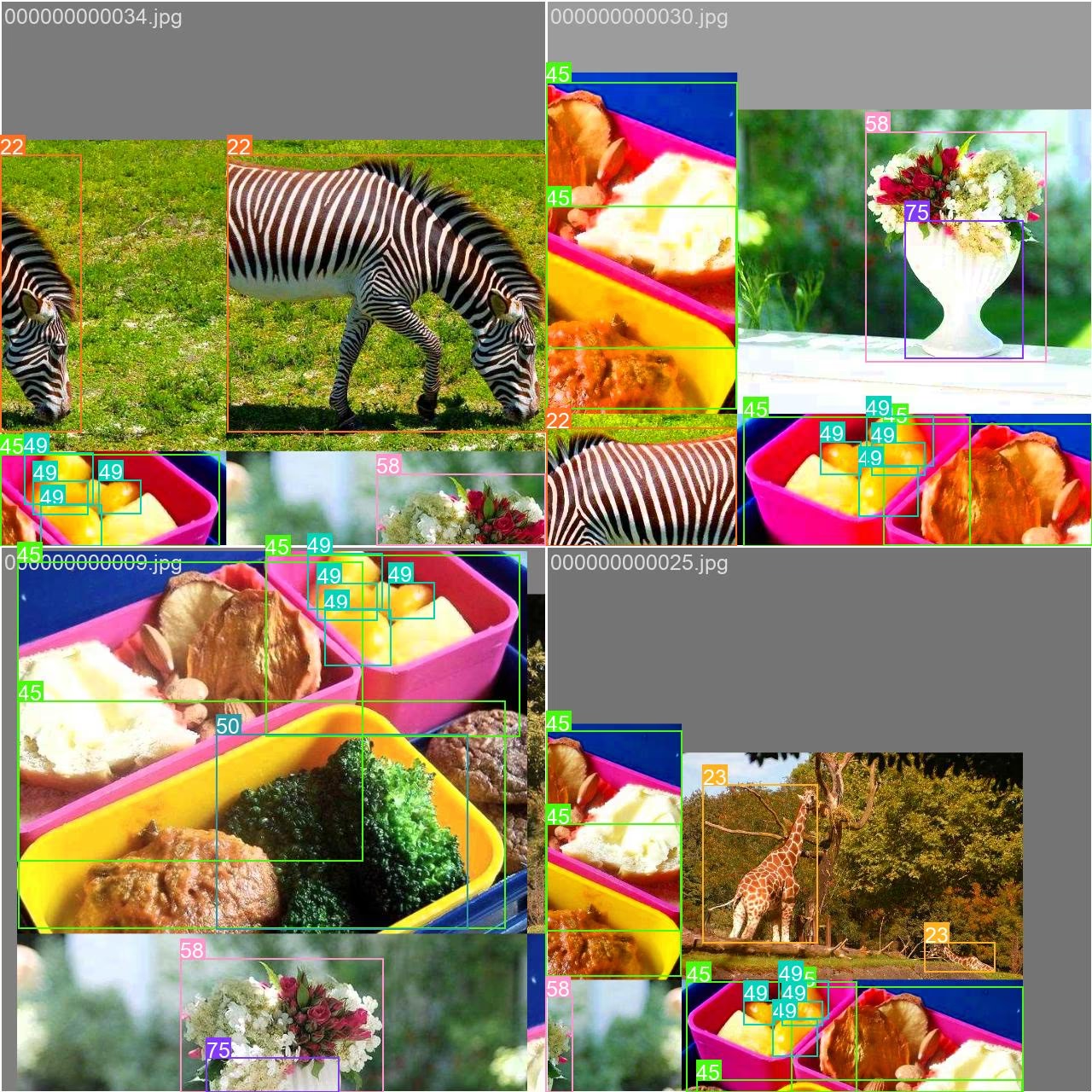

Immagini di esempio e annotazioni

Ecco alcuni esempi di immagini dal dataset COCO128, insieme alle relative annotazioni:

- Immagine mosaicata: questa immagine mostra un batch di addestramento composto da immagini del dataset mosaicato. Il mosaicing è una tecnica utilizzata durante l'addestramento che combina più immagini in un'unica immagine per aumentare la varietà di oggetti e scene all'interno di ogni batch di addestramento. Ciò contribuisce a migliorare la capacità del modello di generalizzare a diverse dimensioni degli oggetti, proporzioni e contesti.

L'esempio mostra la varietà e la complessità delle immagini nel dataset COCO128 e i vantaggi dell'utilizzo del mosaicing durante il processo di addestramento.

Citazioni e ringraziamenti

Se utilizzi il dataset COCO nel tuo lavoro di ricerca o sviluppo, cita il seguente articolo:

@misc{lin2015microsoft,

title={Microsoft COCO: Common Objects in Context},

author={Tsung-Yi Lin and Michael Maire and Serge Belongie and Lubomir Bourdev and Ross Girshick and James Hays and Pietro Perona and Deva Ramanan and C. Lawrence Zitnick and Piotr Dollár},

year={2015},

eprint={1405.0312},

archivePrefix={arXiv},

primaryClass={cs.CV}

}

Desideriamo ringraziare il COCO Consortium per aver creato e mantenuto questa preziosa risorsa per la community di computer vision. Per ulteriori informazioni sul dataset COCO e sui suoi creatori, visitare il sito web del dataset COCO.

FAQ

A cosa serve il dataset COCO128 di Ultralytics?

Il dataset Ultralytics COCO128 è un sottoinsieme compatto contenente le prime 128 immagini del dataset COCO train 2017. Viene utilizzato principalmente per testare ed eseguire il debug di modelli di object detection, sperimentare nuovi approcci di detect e convalidare le pipeline di addestramento prima di passare a dataset più grandi. Le sue dimensioni contenute lo rendono perfetto per iterazioni rapide, pur fornendo una diversità sufficiente per essere un caso di test significativo.

Come si addestra un modello YOLO26 utilizzando il dataset COCO128?

Per addestrare un modello YOLO26 sul dataset COCO128, è possibile utilizzare comandi Python o CLI. Ecco come:

Esempio di addestramento

from ultralytics import YOLO

# Load a pretrained model

model = YOLO("yolo26n.pt")

# Train the model

results = model.train(data="coco128.yaml", epochs=100, imgsz=640)

yolo detect train data=coco128.yaml model=yolo26n.pt epochs=100 imgsz=640

Per ulteriori opzioni e parametri di training, consultare la documentazione sul Training.

Quali sono i vantaggi dell'utilizzo dell'aumento tramite mosaico con COCO128?

L'augmentation a mosaico, come mostrato nelle sample_images, combina più immagini di training in un'unica immagine composita. Questa tecnica offre diversi vantaggi durante il training con COCO128:

- Aumenta la varietà di oggetti e contesti all'interno di ogni batch di addestramento

- Migliora la generalizzazione del modello su diverse dimensioni degli oggetti e proporzioni

- Migliora le prestazioni di rilevamento per oggetti a varie scale

- Massimizza l'utilità di un piccolo dataset creando campioni di addestramento più diversificati

Questa tecnica è particolarmente preziosa per set di dati più piccoli come COCO128, aiutando i modelli ad apprendere caratteristiche più robuste da dati limitati.

Come si confronta COCO128 con altre varianti del dataset COCO?

COCO128 (128 immagini) si colloca tra COCO8 (8 immagini) e il dataset COCO completo (oltre 118.000 immagini) in termini di dimensioni:

- COCO8: Contiene solo 8 immagini (4 di training, 4 di validazione), ideale per test rapidi e debugging

- COCO128: Contiene 128 immagini, bilanciate tra dimensione e diversità

- COCO completo: Contiene oltre 118.000 immagini di training: completo ma ad alta intensità di risorse

COCO128 offre un buon compromesso, offrendo più diversità rispetto a COCO8 pur rimanendo molto più gestibile rispetto al dataset COCO completo per la sperimentazione e lo sviluppo iniziale del modello.

Posso usare COCO128 per attività diverse dall'object detection?

Sebbene COCO128 sia progettato principalmente per l'object detection, le annotazioni del dataset possono essere adattate per altri task di computer vision:

- Segmentazione di istanza: Utilizzo delle maschere di segmentazione fornite nelle annotazioni

- Rilevamento dei keypoint: Per immagini contenenti persone con annotazioni dei keypoint

- Transfer learning: Come punto di partenza per la messa a punto di modelli per attività personalizzate

Per attività specializzate come la segmentation, si consiglia di utilizzare varianti specifiche come COCO8-seg che includono le annotazioni appropriate.