Impara a Esportare nel Formato TFLite Edge TPU dal Modello YOLO26

Distribuire modelli di computer vision su dispositivi con potenza di calcolo limitata, come sistemi mobili o embedded, può essere complicato. L'utilizzo di un formato di modello ottimizzato per prestazioni più veloci semplifica il processo. Il formato del modello TensorFlow LiteEdge TPU o TFLite Edge TPU è progettato per utilizzare una potenza minima fornendo al contempo prestazioni veloci per le reti neurali.

La funzionalità di esportazione nel formato TFLite Edge TPU consente di ottimizzare i modelli Ultralytics YOLO26 per inferenze ad alta velocità e basso consumo. In questa guida, ti accompagneremo nella conversione dei tuoi modelli nel formato TFLite Edge TPU, rendendo più semplice per i tuoi modelli ottenere buone prestazioni su vari dispositivi mobili ed embedded.

Perché dovresti esportare in TFLite Edge TPU?

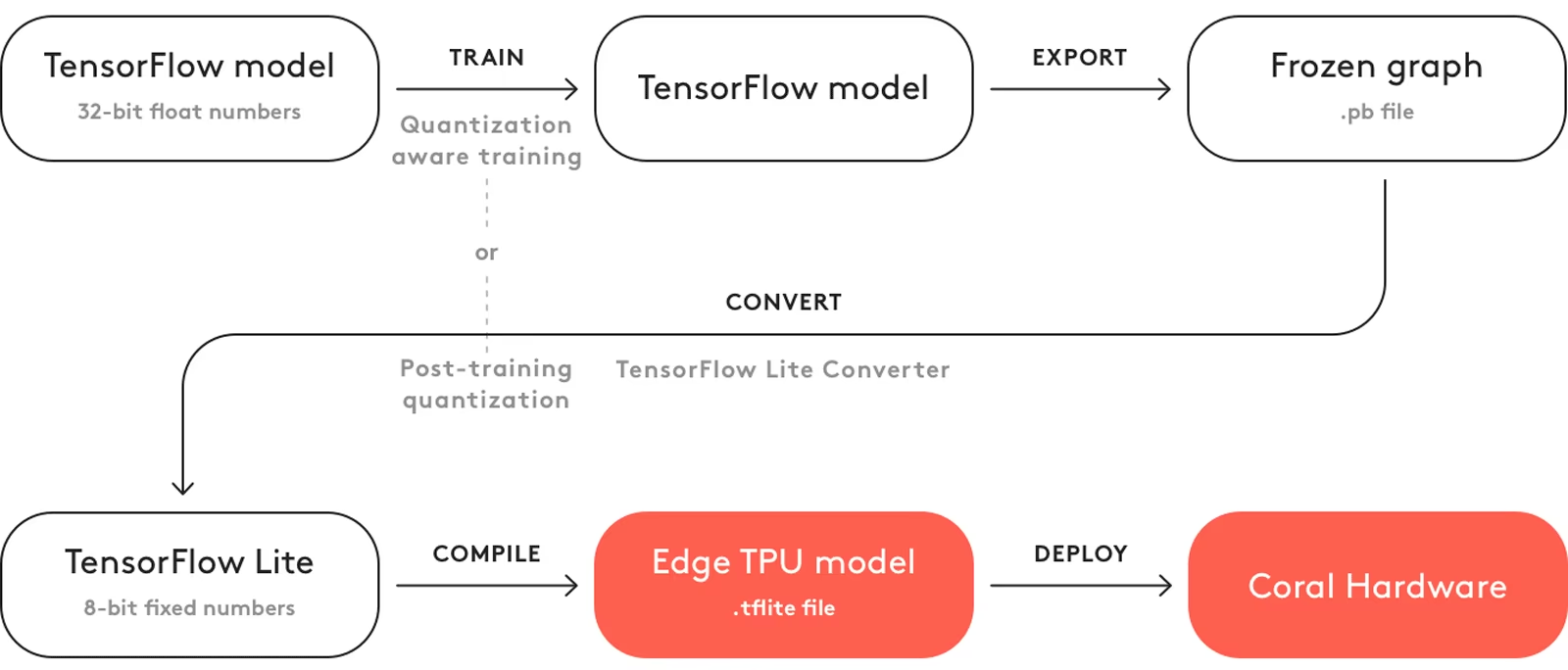

L'esportazione di modelli in TensorFlow Edge TPU rende le attività di machine learning veloci ed efficienti. Questa tecnologia è adatta per applicazioni con potenza, risorse di calcolo e connettività limitate. L'Edge TPU è un acceleratore hardware di Google. Accelera i modelli TensorFlow Lite sui dispositivi edge. L'immagine seguente mostra un esempio del processo coinvolto.

L'Edge TPU funziona con modelli quantizzati. La quantizzazione rende i modelli più piccoli e veloci senza perdere molta precisione. È ideale per le risorse limitate dell'edge computing, consentendo alle applicazioni di rispondere rapidamente riducendo la latenza e consentendo una rapida elaborazione dei dati in locale, senza dipendenza dal cloud. L'elaborazione locale mantiene inoltre i dati degli utenti privati e sicuri poiché non vengono inviati a un server remoto.

Caratteristiche Principali di TFLite Edge TPU

Ecco le caratteristiche principali che rendono TFLite Edge TPU un'ottima scelta di formato modello per gli sviluppatori:

Prestazioni ottimizzate su dispositivi Edge: La TFLite Edge TPU raggiunge prestazioni di rete neurale ad alta velocità attraverso la quantizzazione, l'ottimizzazione del modello, l'accelerazione hardware e l'ottimizzazione del compilatore. La sua architettura minimalista contribuisce alle sue dimensioni ridotte e all'efficienza dei costi.

Elevata velocità di calcolo: TFLite Edge TPU combina accelerazione hardware specializzata ed esecuzione runtime efficiente per ottenere un'elevata velocità di calcolo. È adatto per la distribuzione di modelli di machine learning con severi requisiti di prestazioni su dispositivi edge.

Calcoli di matrici efficienti: TensorFlow Edge TPU è ottimizzato per le operazioni di matrici, che sono cruciali per i calcoli delle reti neurali. Questa efficienza è fondamentale nei modelli di machine learning, in particolare quelli che richiedono numerose e complesse moltiplicazioni e trasformazioni di matrici.

Opzioni di implementazione con TFLite Edge TPU

Prima di addentrarci su come esportare i modelli YOLO26 nel formato TFLite Edge TPU, cerchiamo di capire dove vengono solitamente utilizzati i modelli TFLite Edge TPU.

TFLite Edge TPU offre diverse opzioni di implementazione per i modelli di machine learning, tra cui:

Distribuzione On-Device: I modelli TensorFlow Edge TPU possono essere distribuiti direttamente su dispositivi mobili e embedded. La distribuzione on-device consente ai modelli di essere eseguiti direttamente sull'hardware, eliminando la necessità di connettività cloud, incorporando il modello nel bundle dell'applicazione o scaricandolo su richiesta.

Edge Computing con Cloud TensorFlow TPU: In scenari in cui i dispositivi edge hanno capacità di elaborazione limitate, TensorFlow Edge TPU può scaricare le attività di inferenza su server cloud dotati di TPU.

Distribuzione ibrida: Un approccio ibrido combina la distribuzione sul dispositivo e sul cloud e offre una soluzione versatile e scalabile per la distribuzione di modelli di machine learning. I vantaggi includono l'elaborazione sul dispositivo per risposte rapide e il cloud computing per calcoli più complessi.

Esportazione di Modelli YOLO26 in TFLite Edge TPU

È possibile espandere la compatibilità del modello e la flessibilità di deployment convertendo i modelli YOLO26 in TensorFlow Edge TPU.

Installazione

Per installare il pacchetto richiesto, esegui:

Installazione

# Install the required package for YOLO26

pip install ultralytics

Per istruzioni dettagliate e best practice relative al processo di installazione, consulta la nostra guida all'installazione di Ultralytics. Durante l'installazione dei pacchetti richiesti per YOLO26, se riscontri difficoltà, consulta la nostra guida ai problemi comuni per soluzioni e suggerimenti.

Utilizzo

Tutti i modelli Ultralytics YOLO26 sono progettati per supportare l'esportazione out-of-the-box, rendendo facile integrarli nel flusso di lavoro di deployment preferito. È possibile visualizzare l'elenco completo dei formati di esportazione e delle opzioni di configurazione supportati per scegliere la configurazione migliore per la propria applicazione.

Utilizzo

from ultralytics import YOLO

# Load the YOLO26 model

model = YOLO("yolo26n.pt")

# Export the model to TFLite Edge TPU format

model.export(format="edgetpu") # creates 'yolo26n_full_integer_quant_edgetpu.tflite'

# Load the exported TFLite Edge TPU model

edgetpu_model = YOLO("yolo26n_full_integer_quant_edgetpu.tflite")

# Run inference

results = edgetpu_model("https://ultralytics.com/images/bus.jpg")

# Export a YOLO26n PyTorch model to TFLite Edge TPU format

yolo export model=yolo26n.pt format=edgetpu # creates 'yolo26n_full_integer_quant_edgetpu.tflite'

# Run inference with the exported model

yolo predict model=yolo26n_full_integer_quant_edgetpu.tflite source='https://ultralytics.com/images/bus.jpg'

Argomenti di esportazione

| Argomento | Tipo | Predefinito | Descrizione |

|---|---|---|---|

format | str | 'edgetpu' | Formato di destinazione per il modello esportato, che definisce la compatibilità con vari ambienti di distribuzione. |

imgsz | int oppure tuple | 640 | Dimensione dell'immagine desiderata per l'input del modello. Può essere un numero intero per immagini quadrate o una tupla (height, width) per dimensioni specifiche. |

device | str | None | Specifica il dispositivo per l'esportazione: CPU (device=cpu). |

Suggerimento

Assicurati di utilizzare una macchina x86 Linux quando esporti in EdgeTPU.

Per maggiori dettagli sul processo di esportazione, visita la pagina della documentazione di Ultralytics sull'esportazione.

Deployment di Modelli YOLO26 TFLite Edge TPU Esportati

Dopo aver esportato con successo i tuoi modelli Ultralytics YOLO26 nel formato TFLite Edge TPU, puoi ora effettuarne il deployment. Il primo passo principale e raccomandato per eseguire un modello TFLite Edge TPU è utilizzare il metodo YOLO("model_edgetpu.tflite"), come descritto nel precedente snippet di codice di utilizzo.

Tuttavia, per istruzioni approfondite sull'implementazione dei tuoi modelli TFLite Edge TPU, dai un'occhiata alle seguenti risorse:

Coral Edge TPU su Raspberry Pi con Ultralytics YOLO26: Scopri come integrare le Coral Edge TPU con Raspberry Pi per capacità di machine learning migliorate.

Esempi di codice: Accedi a esempi pratici di distribuzione di TensorFlow Edge TPU per dare il via ai tuoi progetti.

Esecuzione dell'inferenza sull'Edge TPU con python: Scopri come utilizzare l'API python di TensorFlow Lite per le applicazioni Edge TPU, incluse le linee guida per la configurazione e l'utilizzo.

Riepilogo

In questa guida, abbiamo imparato come esportare i modelli Ultralytics YOLO26 nel formato TFLite Edge TPU. Seguendo i passaggi sopra menzionati, puoi aumentare la velocità e la potenza delle tue applicazioni di visione artificiale.

Per ulteriori dettagli sull'utilizzo, visita il sito web ufficiale di Edge TPU.

Inoltre, per maggiori informazioni su altre integrazioni Ultralytics YOLO26, visita la nostra pagina della guida all'integrazione. Lì scoprirai risorse e approfondimenti preziosi.

FAQ

Come si esporta un modello YOLO26 nel formato TFLite Edge TPU?

Per esportare un modello YOLO26 nel formato TFLite Edge TPU, puoi seguire questi passaggi:

Utilizzo

from ultralytics import YOLO

# Load the YOLO26 model

model = YOLO("yolo26n.pt")

# Export the model to TFLite Edge TPU format

model.export(format="edgetpu") # creates 'yolo26n_full_integer_quant_edgetpu.tflite'

# Load the exported TFLite Edge TPU model

edgetpu_model = YOLO("yolo26n_full_integer_quant_edgetpu.tflite")

# Run inference

results = edgetpu_model("https://ultralytics.com/images/bus.jpg")

# Export a YOLO26n PyTorch model to TFLite Edge TPU format

yolo export model=yolo26n.pt format=edgetpu # creates 'yolo26n_full_integer_quant_edgetpu.tflite'

# Run inference with the exported model

yolo predict model=yolo26n_full_integer_quant_edgetpu.tflite source='https://ultralytics.com/images/bus.jpg'

Per dettagli completi sull'esportazione di modelli in altri formati, consulta la nostra guida all'esportazione.

Quali sono i vantaggi dell'esportazione dei modelli YOLO26 in TFLite Edge TPU?

L'esportazione dei modelli YOLO26 in TFLite Edge TPU offre numerosi vantaggi:

- Prestazioni ottimizzate: Ottieni prestazioni elevate della rete neurale con un consumo energetico minimo.

- Latenza ridotta: Elaborazione rapida dei dati locali senza la necessità di dipendenza dal cloud.

- Maggiore privacy: L'elaborazione locale mantiene i dati dell'utente privati e sicuri.

Questo lo rende ideale per le applicazioni nell'edge computing, dove i dispositivi hanno risorse energetiche e computazionali limitate. Scopri di più sul perché dovresti esportare.

Posso distribuire modelli TFLite Edge TPU su dispositivi mobili e embedded?

Sì, i modelli TensorFlow Lite Edge TPU possono essere implementati direttamente su dispositivi mobili e embedded. Questo approccio di implementazione consente ai modelli di essere eseguiti direttamente sull'hardware, offrendo un'inferenza più rapida ed efficiente. Per esempi di integrazione, consulta la nostra guida sull'implementazione di Coral Edge TPU su Raspberry Pi.

Quali sono alcuni casi d'uso comuni per i modelli TFLite Edge TPU?

Casi d'uso comuni per i modelli TFLite Edge TPU includono:

- Telecamere intelligenti: Miglioramento dell'analisi di immagini e video in tempo reale.

- Dispositivi IoT: Abilitazione della domotica e dell'automazione industriale.

- Sanità: Accelerazione dell'imaging medico e della diagnostica.

- Vendita al dettaglio: Miglioramento della gestione dell'inventario e dell'analisi del comportamento dei clienti.

Queste applicazioni beneficiano delle elevate prestazioni e del basso consumo energetico dei modelli TFLite Edge TPU. Scopri di più sugli scenari di utilizzo.

Come posso risolvere i problemi durante l'esportazione o la distribuzione di modelli TFLite Edge TPU?

Se riscontri problemi durante l'esportazione o la distribuzione di modelli TFLite Edge TPU, consulta la nostra guida Problemi comuni per suggerimenti sulla risoluzione dei problemi. Questa guida tratta i problemi comuni e le soluzioni per aiutarti a garantire un funzionamento regolare. Per ulteriore supporto, visita il nostro Centro assistenza.