Esportazione Intel OpenVINO

In questa guida, trattiamo l'esportazione dei modelli YOLO26 nel formato OpenVINO, che può fornire un aumento della velocità della CPU fino a 3 volte, nonché accelerare l'inferenza YOLO su hardware GPU e NPU Intel.

OpenVINO, abbreviazione di Open Visual Inference & Neural Network Optimization toolkit, è un toolkit completo per l'ottimizzazione e la distribuzione di modelli di inferenza AI. Anche se il nome contiene Visual, OpenVINO supporta anche varie attività aggiuntive tra cui linguaggio, audio, serie temporali, ecc.

Guarda: Come esportare Ultralytics YOLO26 nel formato Intel OpenVINO per un'inferenza più rapida 🚀

Esempi di utilizzo

Esporta un modello YOLO26n nel formato OpenVINO ed esegui l'inferenza con il modello esportato.

Esempio

from ultralytics import YOLO

# Load a YOLO26n PyTorch model

model = YOLO("yolo26n.pt")

# Export the model

model.export(format="openvino") # creates 'yolo26n_openvino_model/'

# Load the exported OpenVINO model

ov_model = YOLO("yolo26n_openvino_model/")

# Run inference

results = ov_model("https://ultralytics.com/images/bus.jpg")

# Run inference with specified device, available devices: ["intel:gpu", "intel:npu", "intel:cpu"]

results = ov_model("https://ultralytics.com/images/bus.jpg", device="intel:gpu")

# Export a YOLO26n PyTorch model to OpenVINO format

yolo export model=yolo26n.pt format=openvino # creates 'yolo26n_openvino_model/'

# Run inference with the exported model

yolo predict model=yolo26n_openvino_model source='https://ultralytics.com/images/bus.jpg'

# Run inference with specified device, available devices: ["intel:gpu", "intel:npu", "intel:cpu"]

yolo predict model=yolo26n_openvino_model source='https://ultralytics.com/images/bus.jpg' device="intel:gpu"

Argomenti di esportazione

| Argomento | Tipo | Predefinito | Descrizione |

|---|---|---|---|

format | str | 'openvino' | Formato di destinazione per il modello esportato, che definisce la compatibilità con vari ambienti di distribuzione. |

imgsz | int oppure tuple | 640 | Dimensione dell'immagine desiderata per l'input del modello. Può essere un numero intero per immagini quadrate o una tupla (height, width) per dimensioni specifiche. |

half | bool | False | Abilita la quantizzazione FP16 (mezza precisione), riducendo le dimensioni del modello e potenzialmente accelerando l'inferenza su hardware supportato. |

int8 | bool | False | Attiva la quantizzazione INT8, comprimendo ulteriormente il modello e accelerando l'inferenza con una perdita di accuratezza minima, principalmente per i dispositivi edge. |

dynamic | bool | False | Consente dimensioni di input dinamiche, migliorando la flessibilità nella gestione di diverse dimensioni delle immagini. |

nms | bool | False | Aggiunge la Non-Maximum Suppression (NMS), essenziale per una post-elaborazione del detect accurata ed efficiente. |

batch | int | 1 | Specifica la dimensione del batch di inferenza del modello di esportazione o il numero massimo di immagini che il modello esportato elaborerà contemporaneamente in modalità predict . |

data | str | 'coco8.yaml' | Percorso del dataset file di configurazione (predefinito: coco8.yaml), essenziale per la quantizzazione. |

fraction | float | 1.0 | Specifica la frazione del dataset da utilizzare per la calibrazione della quantizzazione INT8. Consente la calibrazione su un sottoinsieme del dataset completo, utile per esperimenti o quando le risorse sono limitate. Se non specificato con INT8 abilitato, verrà utilizzato l'intero dataset. |

Per maggiori dettagli sul processo di esportazione, visita la pagina della documentazione di Ultralytics sull'esportazione.

Attenzione

OpenVINO™ è compatibile con la maggior parte dei processori Intel®, ma per garantire prestazioni ottimali:

Verifica il supporto di OpenVINO™ Verifica se il tuo chip Intel® è ufficialmente supportato da OpenVINO™ utilizzando l'elenco di compatibilità di Intel.

Identifica il tuo acceleratore. Determina se il tuo processore include una NPU (Neural Processing Unit) o una GPU integrata (GPU integrata) consultando la guida hardware di Intel.

Installa i driver più recenti. Se il tuo chip supporta una NPU o una GPU ma OpenVINO™ non la rileva, potrebbe essere necessario installare o aggiornare i driver associati. Segui le istruzioni per l'installazione dei driver per abilitare l'accelerazione completa.

Seguendo questi tre passaggi, puoi assicurarti che OpenVINO™ funzioni in modo ottimale sull'hardware Intel®.

Vantaggi di OpenVINO

- Prestazioni: OpenVINO offre inferenze ad alte prestazioni sfruttando la potenza di CPU Intel, GPU integrate e discrete e FPGA.

- Supporto per l'esecuzione eterogenea: OpenVINO fornisce un'API per scrivere una sola volta ed eseguire il deployment su qualsiasi hardware Intel supportato (CPU, GPU, FPGA, VPU, ecc.).

- Ottimizzatore di modelli: OpenVINO fornisce un ottimizzatore di modelli che importa, converte e ottimizza modelli da framework di deep learning popolari come PyTorch, TensorFlow, TensorFlow Lite, Keras, ONNX, PaddlePaddle e Caffe.

- Facilità d'uso: Il toolkit include più di 80 notebook tutorial (inclusa l'ottimizzazione di YOLOv8) che insegnano diversi aspetti del toolkit.

Struttura di esportazione OpenVINO

Quando si esporta un modello in formato OpenVINO, si ottiene una directory contenente quanto segue:

- File XML: Descrive la topologia della rete.

- File BIN: Contiene i dati binari di pesi e bias.

- File di mapping: Contiene il mapping dei tensor di output del modello originale ai nomi dei tensor OpenVINO.

È possibile utilizzare questi file per eseguire l'inferenza con OpenVINO Inference Engine.

Utilizzo dell'esportazione OpenVINO nel deployment

Una volta che il modello è stato esportato con successo nel formato OpenVINO, hai due opzioni principali per eseguire l'inferenza:

Utilizzare il

ultralyticspacchetto, che fornisce un'API di alto livello e racchiude OpenVINO Runtime.Utilizzare il nativo

openvinopacchetto per un controllo più avanzato o personalizzato sul comportamento dell'inferenza.

Inferenza con Ultralytics

Il pacchetto ultralytics consente di eseguire facilmente l'inferenza utilizzando il modello OpenVINO esportato tramite il metodo predict. È inoltre possibile specificare il dispositivo di destinazione (ad esempio, intel:gpu, intel:npu, intel:cpu) usando l'argomento device.

from ultralytics import YOLO

# Load the exported OpenVINO model

ov_model = YOLO("yolo26n_openvino_model/") # the path of your exported OpenVINO model

# Run inference with the exported model

ov_model.predict(device="intel:gpu") # specify the device you want to run inference on

Questo approccio è ideale per la prototipazione rapida o la distribuzione quando non è necessario il pieno controllo sulla pipeline di inferenza.

Inferenza con OpenVINO Runtime

Il runtime OpenVINO fornisce un'API unificata per l'inferenza su tutto l'hardware Intel supportato. Offre anche funzionalità avanzate come il bilanciamento del carico su hardware Intel e l'esecuzione asincrona. Per maggiori informazioni sull'esecuzione dell'inferenza, fai riferimento ai notebook YOLO26.

Ricorda, avrai bisogno dei file XML e BIN, nonché di qualsiasi impostazione specifica dell'applicazione come la dimensione dell'input, il fattore di scala per la normalizzazione, ecc., per configurare e utilizzare correttamente il modello con il Runtime.

Nella tua applicazione di deployment, in genere faresti i seguenti passaggi:

- Inizializza OpenVINO creando

core = Core(). - Carica il modello usando il

core.read_model()metodo. - Compila il modello usando la

core.compile_model()funzione. - Prepara l'input (immagine, testo, audio, ecc.).

- Esegui l'inferenza usando

compiled_model(input_data).

Per passaggi più dettagliati e frammenti di codice, consulta la documentazione di OpenVINO o il tutorial API.

Benchmark OpenVINO YOLO11

Il team Ultralytics ha eseguito il benchmark di YOLO11 su vari formati di modello e precisione, valutando velocità e accuratezza su diversi dispositivi Intel compatibili con OpenVINO.

Nota

I risultati di benchmarking riportati di seguito sono forniti a titolo di riferimento e possono variare in base alla configurazione hardware e software specifica di un sistema, nonché al carico di lavoro corrente del sistema al momento dell'esecuzione dei benchmark.

Tutti i benchmark sono eseguiti con openvino versione del pacchetto python 2025.1.0.

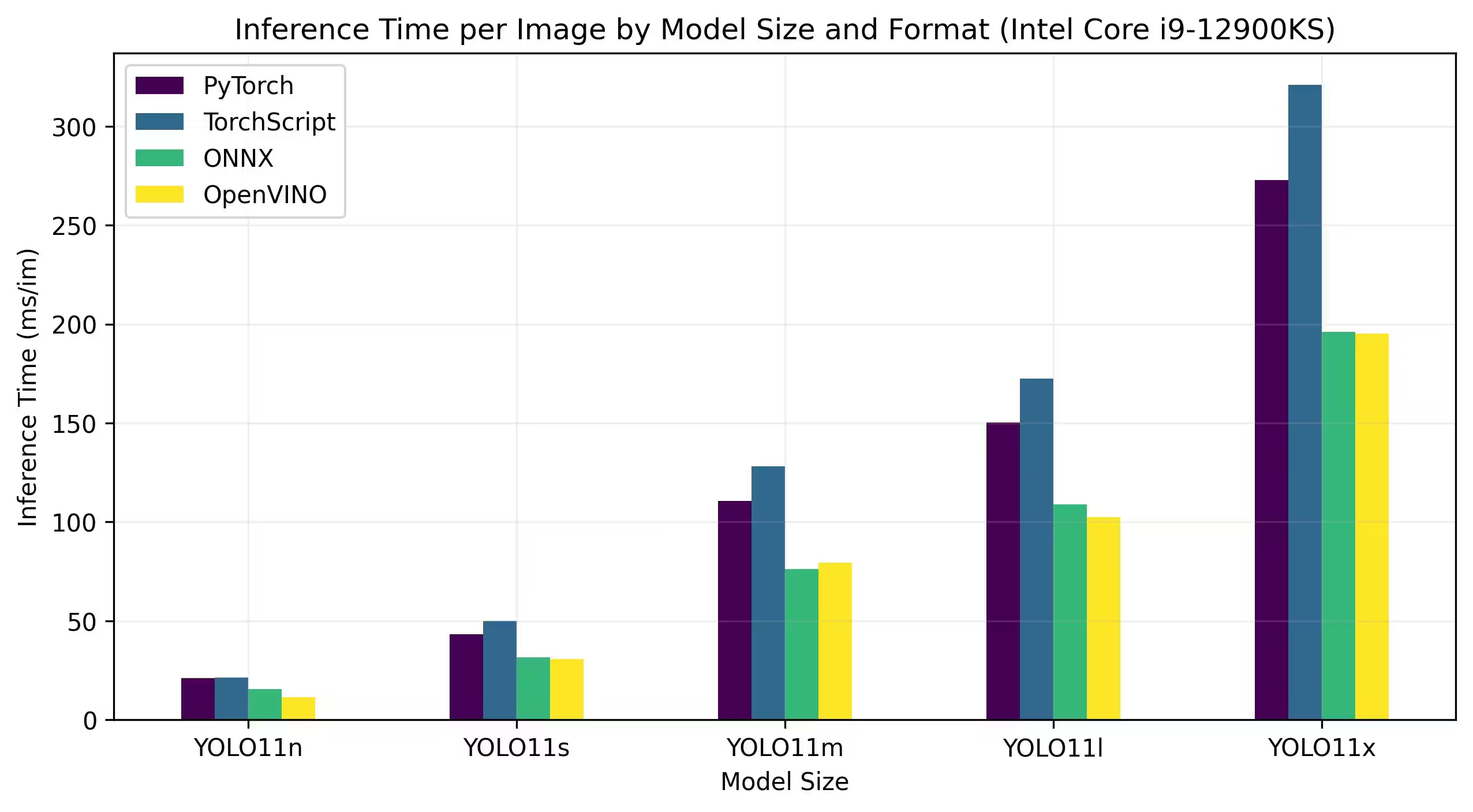

Intel Core CPU

La serie Intel® Core® è una gamma di processori ad alte prestazioni di Intel. La linea include Core i3 (entry-level), Core i5 (mid-range), Core i7 (high-end) e Core i9 (prestazioni estreme). Ogni serie soddisfa diverse esigenze di calcolo e budget, dalle attività quotidiane ai carichi di lavoro professionali più impegnativi. Con ogni nuova generazione, vengono apportati miglioramenti a prestazioni, efficienza energetica e funzionalità.

I benchmark seguenti vengono eseguiti su CPU Intel® Core® i9-12900KS di 12a generazione con precisione FP32.

Risultati Dettagliati del Benchmark

| Modello | Formato | Stato | Dimensione (MB) | metrics/mAP50-95(B) | Tempo di inferenza (ms/im) |

|---|---|---|---|---|---|

| YOLO11n | PyTorch | ✅ | 5.4 | 0.5071 | 21.00 |

| YOLO11n | TorchScript | ✅ | 10.5 | 0.5077 | 21.39 |

| YOLO11n | ONNX | ✅ | 10.2 | 0.5077 | 15.55 |

| YOLO11n | OpenVINO | ✅ | 10.4 | 0.5077 | 11.49 |

| YOLO11s | PyTorch | ✅ | 18.4 | 0.5770 | 43.16 |

| YOLO11s | TorchScript | ✅ | 36.6 | 0.5781 | 50.06 |

| YOLO11s | ONNX | ✅ | 36.3 | 0.5781 | 31.53 |

| YOLO11s | OpenVINO | ✅ | 36.4 | 0.5781 | 30.82 |

| YOLO11m | PyTorch | ✅ | 38.8 | 0.6257 | 110.60 |

| YOLO11m | TorchScript | ✅ | 77.3 | 0.6306 | 128.09 |

| YOLO11m | ONNX | ✅ | 76.9 | 0.6306 | 76.06 |

| YOLO11m | OpenVINO | ✅ | 77.1 | 0.6306 | 79.38 |

| YOLO11l | PyTorch | ✅ | 49.0 | 0.6367 | 150.38 |

| YOLO11l | TorchScript | ✅ | 97.7 | 0.6408 | 172.57 |

| YOLO11l | ONNX | ✅ | 97.0 | 0.6408 | 108.91 |

| YOLO11l | OpenVINO | ✅ | 97.3 | 0.6408 | 102.30 |

| YOLO11x | PyTorch | ✅ | 109.3 | 0.6989 | 272.72 |

| YOLO11x | TorchScript | ✅ | 218.1 | 0.6900 | 320.86 |

| YOLO11x | ONNX | ✅ | 217.5 | 0.6900 | 196.20 |

| YOLO11x | OpenVINO | ✅ | 217.8 | 0.6900 | 195.32 |

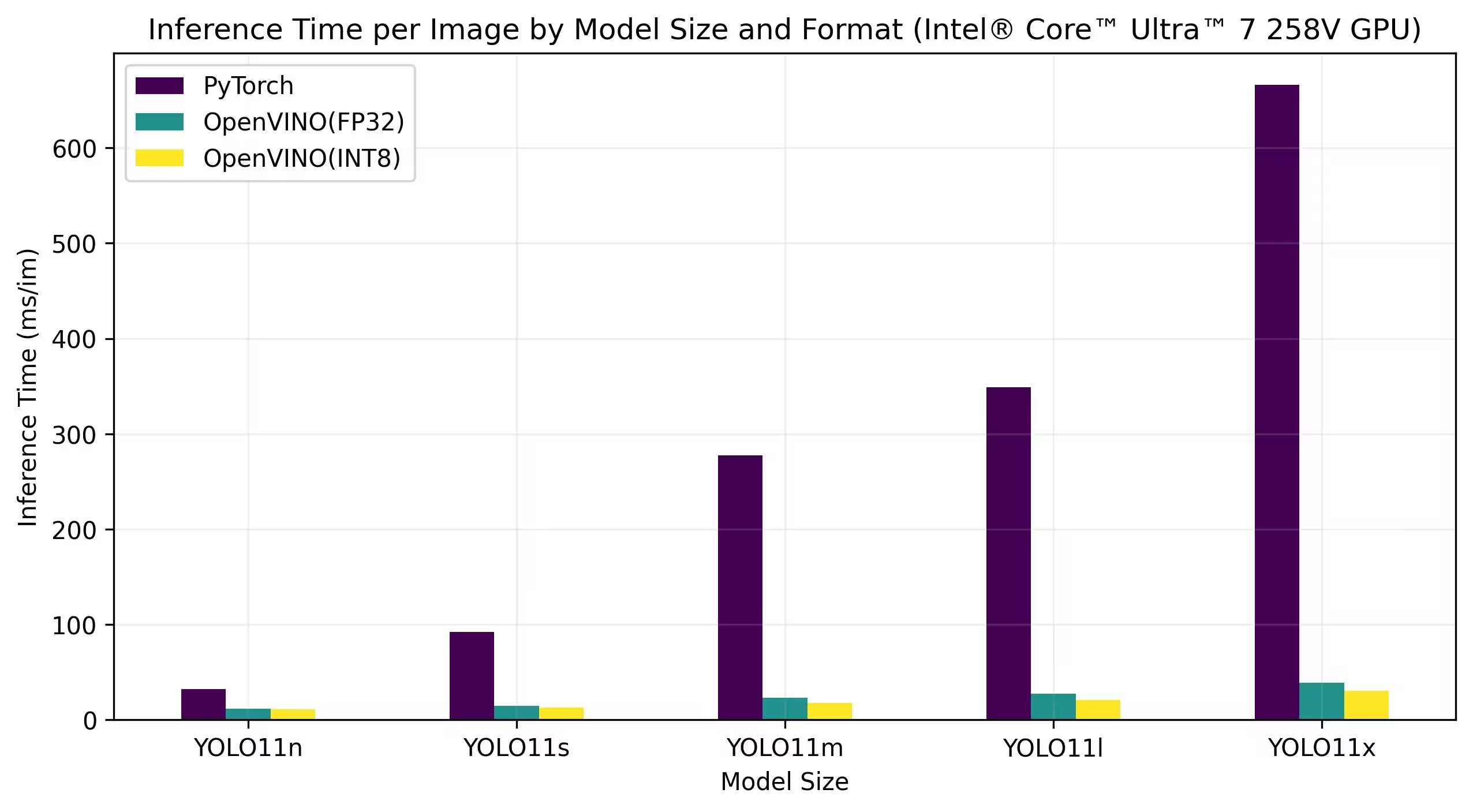

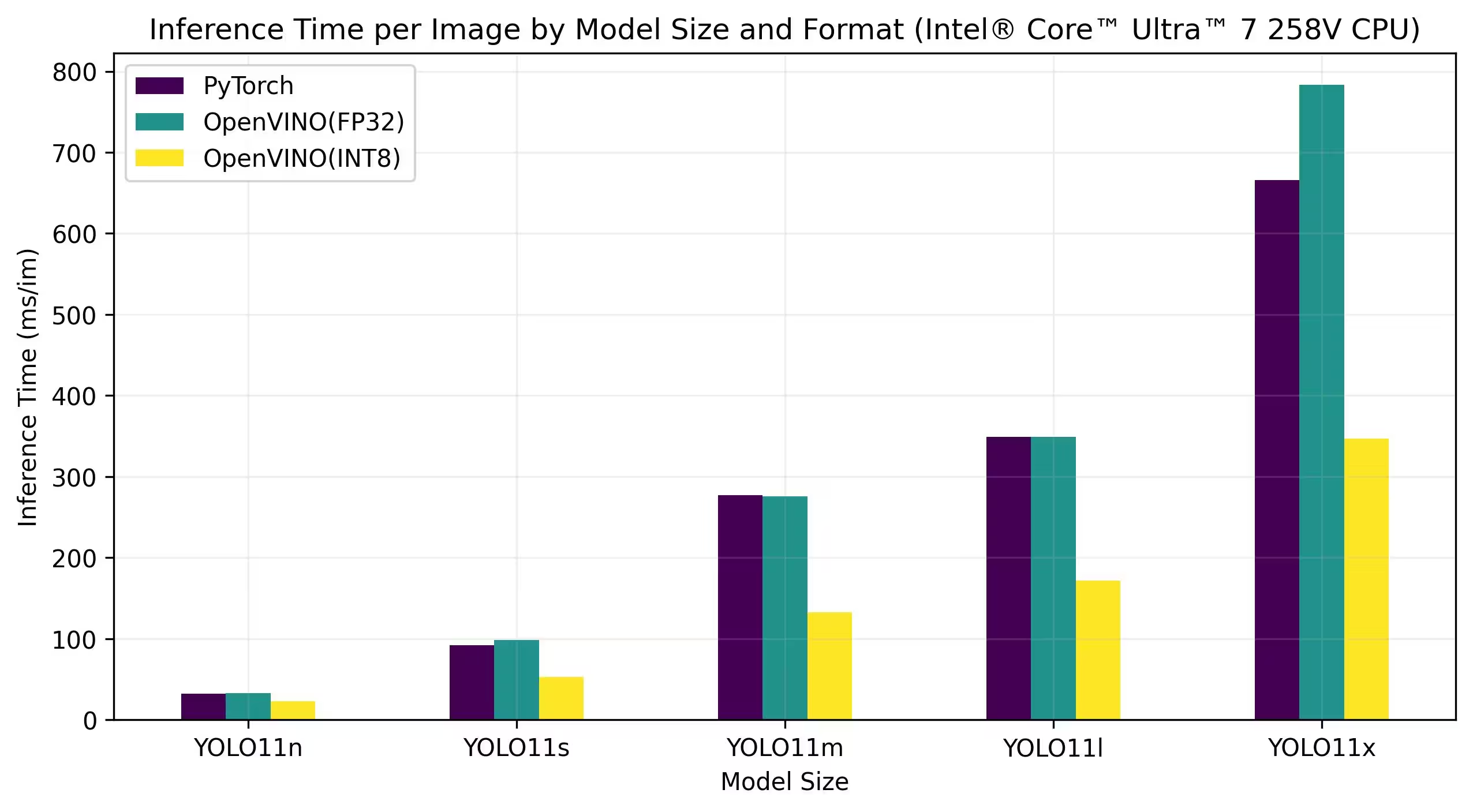

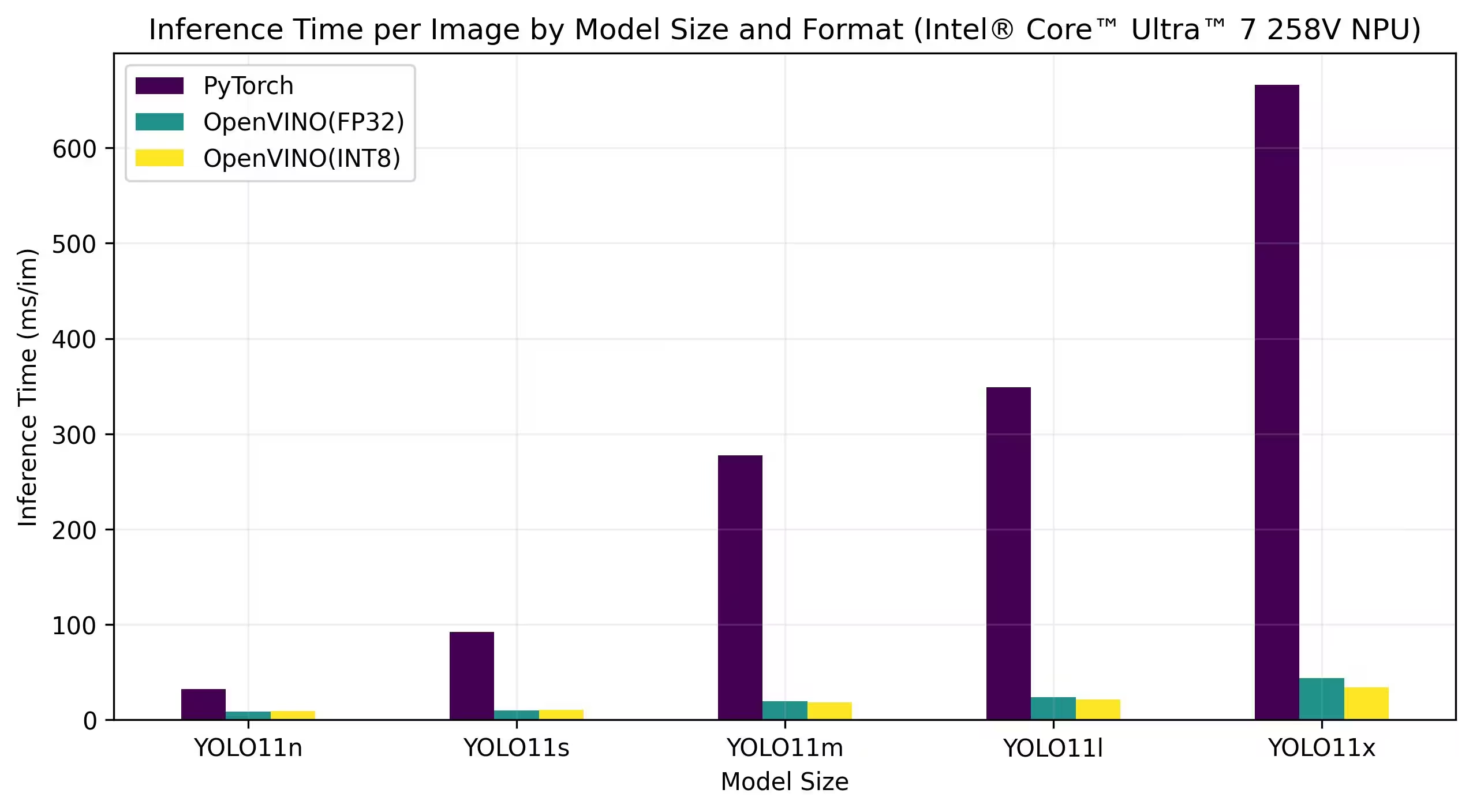

Intel® Core™ Ultra

La serie Intel® Core™ Ultra™ rappresenta un nuovo punto di riferimento nel calcolo ad alte prestazioni, progettata per soddisfare le esigenze in evoluzione degli utenti moderni, dai giocatori e creatori ai professionisti che sfruttano l'AI. Questa linea di nuova generazione è più di una tradizionale serie di CPU; combina potenti core CPU, funzionalità GPU integrate ad alte prestazioni e una Neural Processing Unit (NPU) dedicata all'interno di un singolo chip, offrendo una soluzione unificata per carichi di lavoro di calcolo diversi e intensivi.

Al cuore dell'architettura Intel® Core Ultra™ c'è un design ibrido che consente prestazioni eccezionali in tutte le attività di elaborazione tradizionali, i carichi di lavoro accelerati da GPU e le operazioni guidate dall'AI. L'inclusione della NPU migliora l'inferenza AI sul dispositivo, consentendo un apprendimento automatico e un'elaborazione dei dati più rapidi ed efficienti in un'ampia gamma di applicazioni.

La famiglia Core Ultra™ include vari modelli progettati per diverse esigenze di prestazioni, con opzioni che vanno dai design a efficienza energetica alle varianti ad alta potenza contrassegnate dalla designazione "H", ideali per laptop e fattori di forma compatti che richiedono una seria potenza di calcolo. In tutta la gamma, gli utenti beneficiano della sinergia dell'integrazione di CPU, GPU e NPU, offrendo efficienza, reattività e capacità multitasking straordinarie.

Come parte della continua innovazione di Intel, la serie Core Ultra™ stabilisce un nuovo standard per il computing del futuro. Con diversi modelli disponibili e altri in arrivo, questa serie sottolinea l'impegno di Intel nel fornire soluzioni all'avanguardia per la prossima generazione di dispositivi intelligenti potenziati dall'AI.

I benchmark seguenti vengono eseguiti su Intel® Core™ Ultra™ 7 258V e Intel® Core™ Ultra™ 7 265K con precisione FP32 e INT8.

Intel® Core™ Ultra™ 7 258V

Benchmark

Risultati Dettagliati del Benchmark

| Modello | Formato | Precisione | Stato | Dimensione (MB) | metrics/mAP50-95(B) | Tempo di inferenza (ms/im) |

|---|---|---|---|---|---|---|

| YOLO11n | PyTorch | FP32 | ✅ | 5.4 | 0.5052 | 32.27 |

| YOLO11n | OpenVINO | FP32 | ✅ | 10.4 | 0.5068 | 11.84 |

| YOLO11n | OpenVINO | INT8 | ✅ | 3.3 | 0.4969 | 11.24 |

| YOLO11s | PyTorch | FP32 | ✅ | 18.4 | 0.5776 | 92.09 |

| YOLO11s | OpenVINO | FP32 | ✅ | 36.4 | 0.5797 | 14.82 |

| YOLO11s | OpenVINO | INT8 | ✅ | 9.8 | 0.5751 | 12.88 |

| YOLO11m | PyTorch | FP32 | ✅ | 38.8 | 0.6262 | 277.24 |

| YOLO11m | OpenVINO | FP32 | ✅ | 77.1 | 0.6306 | 22.94 |

| YOLO11m | OpenVINO | INT8 | ✅ | 20.2 | 0.6126 | 17.85 |

| YOLO11l | PyTorch | FP32 | ✅ | 49.0 | 0.6361 | 348.97 |

| YOLO11l | OpenVINO | FP32 | ✅ | 97.3 | 0.6365 | 27.34 |

| YOLO11l | OpenVINO | INT8 | ✅ | 25.7 | 0.6242 | 20.83 |

| YOLO11x | PyTorch | FP32 | ✅ | 109.3 | 0.6984 | 666.07 |

| YOLO11x | OpenVINO | FP32 | ✅ | 217.8 | 0.6890 | 39.09 |

| YOLO11x | OpenVINO | INT8 | ✅ | 55.9 | 0.6856 | 30.60 |

Risultati Dettagliati del Benchmark

| Modello | Formato | Precisione | Stato | Dimensione (MB) | metrics/mAP50-95(B) | Tempo di inferenza (ms/im) |

|---|---|---|---|---|---|---|

| YOLO11n | PyTorch | FP32 | ✅ | 5.4 | 0.5052 | 32.27 |

| YOLO11n | OpenVINO | FP32 | ✅ | 10.4 | 0.5077 | 32.55 |

| YOLO11n | OpenVINO | INT8 | ✅ | 3.3 | 0.4980 | 22.98 |

| YOLO11s | PyTorch | FP32 | ✅ | 18.4 | 0.5776 | 92.09 |

| YOLO11s | OpenVINO | FP32 | ✅ | 36.4 | 0.5782 | 98.38 |

| YOLO11s | OpenVINO | INT8 | ✅ | 9.8 | 0.5745 | 52.84 |

| YOLO11m | PyTorch | FP32 | ✅ | 38.8 | 0.6262 | 277.24 |

| YOLO11m | OpenVINO | FP32 | ✅ | 77.1 | 0.6307 | 275.74 |

| YOLO11m | OpenVINO | INT8 | ✅ | 20.2 | 0.6172 | 132.63 |

| YOLO11l | PyTorch | FP32 | ✅ | 49.0 | 0.6361 | 348.97 |

| YOLO11l | OpenVINO | FP32 | ✅ | 97.3 | 0.6361 | 348.97 |

| YOLO11l | OpenVINO | INT8 | ✅ | 25.7 | 0.6240 | 171.36 |

| YOLO11x | PyTorch | FP32 | ✅ | 109.3 | 0.6984 | 666.07 |

| YOLO11x | OpenVINO | FP32 | ✅ | 217.8 | 0.6900 | 783.16 |

| YOLO11x | OpenVINO | INT8 | ✅ | 55.9 | 0.6890 | 346.82 |

Risultati Dettagliati del Benchmark

| Modello | Formato | Precisione | Stato | Dimensione (MB) | metrics/mAP50-95(B) | Tempo di inferenza (ms/im) |

|---|---|---|---|---|---|---|

| YOLO11n | PyTorch | FP32 | ✅ | 5.4 | 0.5052 | 32.27 |

| YOLO11n | OpenVINO | FP32 | ✅ | 10.4 | 0.5085 | 8.33 |

| YOLO11n | OpenVINO | INT8 | ✅ | 3.3 | 0.5019 | 8.91 |

| YOLO11s | PyTorch | FP32 | ✅ | 18.4 | 0.5776 | 92.09 |

| YOLO11s | OpenVINO | FP32 | ✅ | 36.4 | 0.5788 | 9.72 |

| YOLO11s | OpenVINO | INT8 | ✅ | 9.8 | 0.5710 | 10.58 |

| YOLO11m | PyTorch | FP32 | ✅ | 38.8 | 0.6262 | 277.24 |

| YOLO11m | OpenVINO | FP32 | ✅ | 77.1 | 0.6301 | 19.41 |

| YOLO11m | OpenVINO | INT8 | ✅ | 20.2 | 0.6124 | 18.26 |

| YOLO11l | PyTorch | FP32 | ✅ | 49.0 | 0.6361 | 348.97 |

| YOLO11l | OpenVINO | FP32 | ✅ | 97.3 | 0.6362 | 23.70 |

| YOLO11l | OpenVINO | INT8 | ✅ | 25.7 | 0.6240 | 21.40 |

| YOLO11x | PyTorch | FP32 | ✅ | 109.3 | 0.6984 | 666.07 |

| YOLO11x | OpenVINO | FP32 | ✅ | 217.8 | 0.6892 | 43.91 |

| YOLO11x | OpenVINO | INT8 | ✅ | 55.9 | 0.6890 | 34.04 |

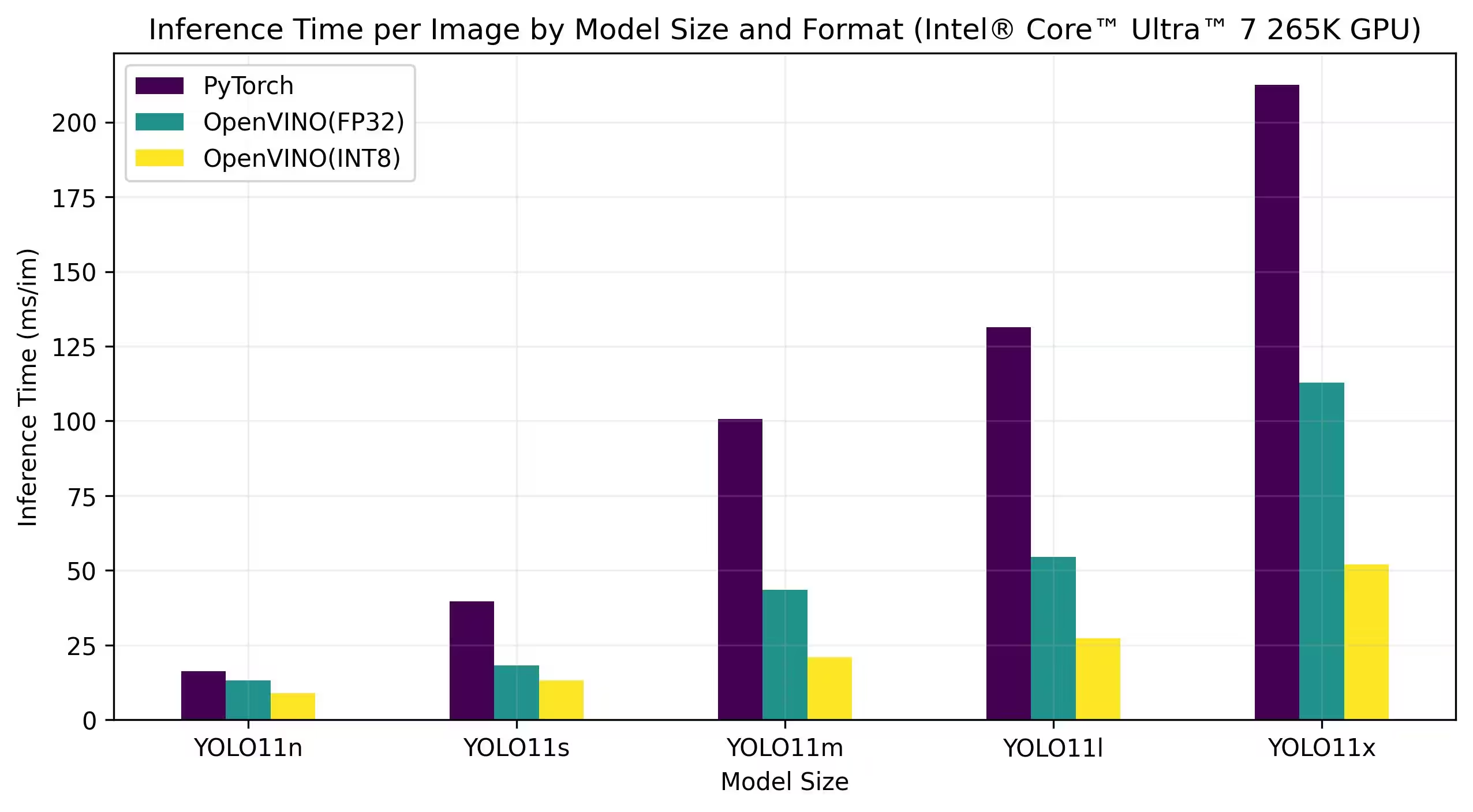

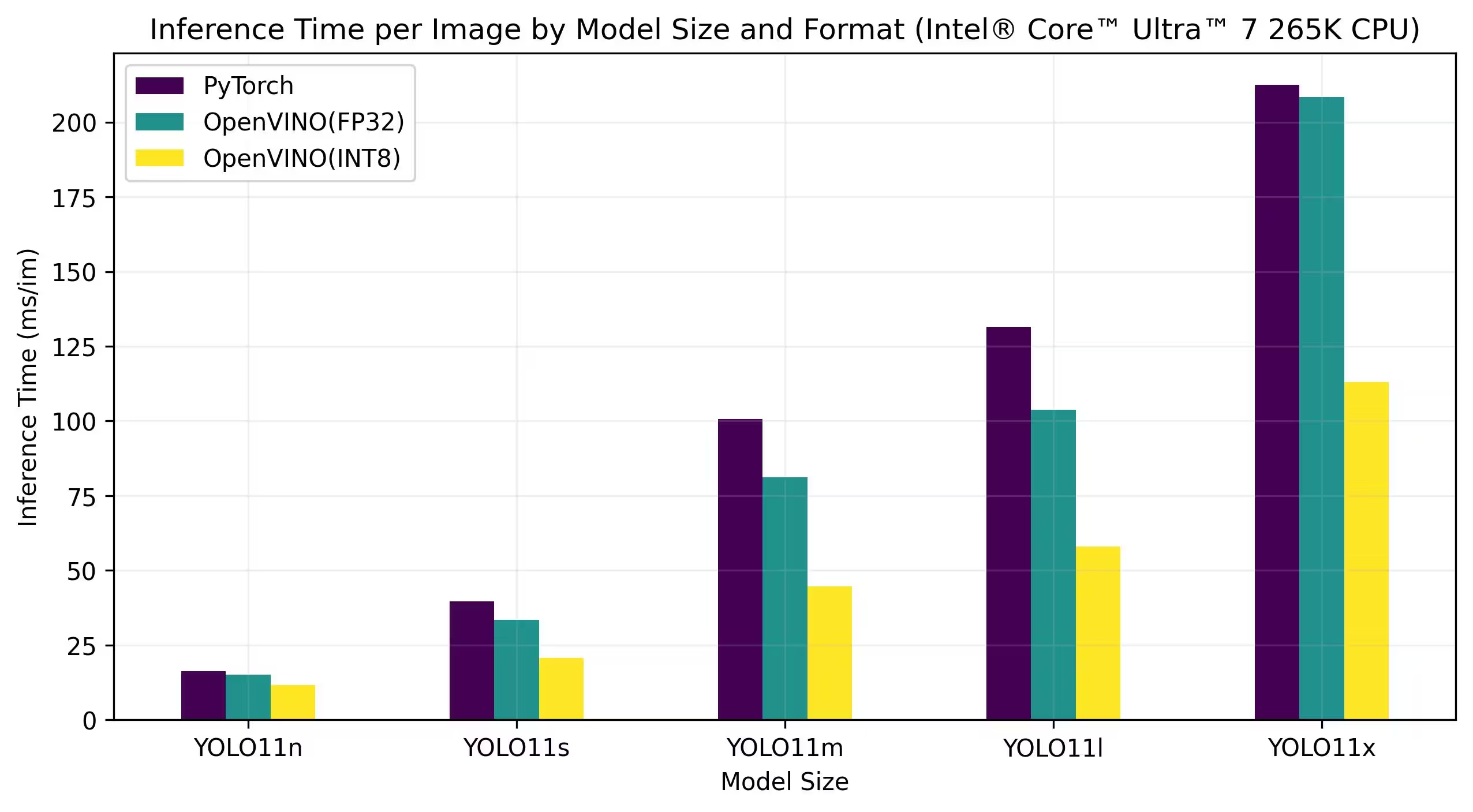

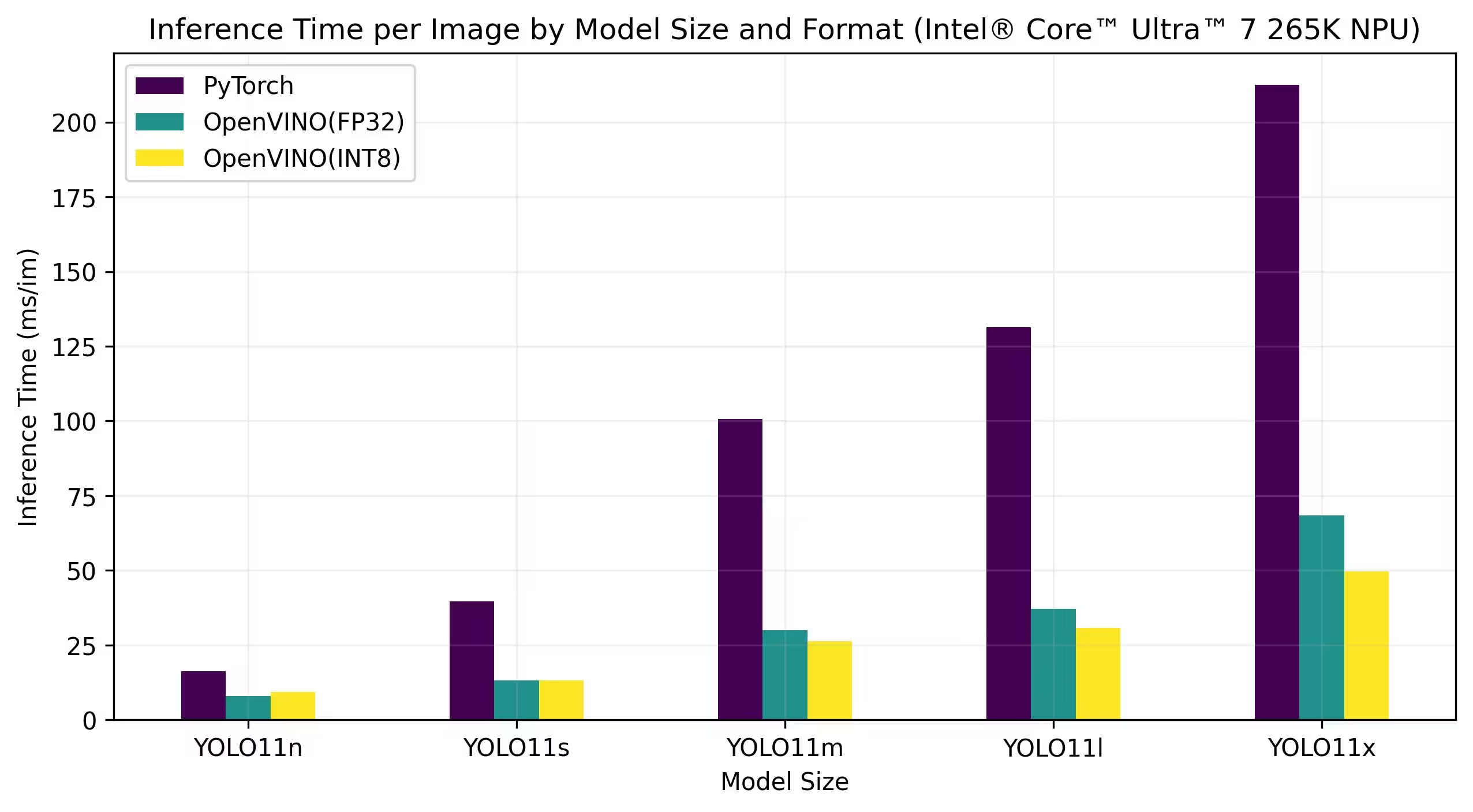

Intel® Core™ Ultra™ 7 265K

Benchmark

Risultati Dettagliati del Benchmark

| Modello | Formato | Precisione | Stato | Dimensione (MB) | metrics/mAP50-95(B) | Tempo di inferenza (ms/im) |

|---|---|---|---|---|---|---|

| YOLO11n | PyTorch | FP32 | ✅ | 5.4 | 0.5072 | 16.29 |

| YOLO11n | OpenVINO | FP32 | ✅ | 10.4 | 0.5079 | 13.13 |

| YOLO11n | OpenVINO | INT8 | ✅ | 3.3 | 0.4976 | 8.86 |

| YOLO11s | PyTorch | FP32 | ✅ | 18.4 | 0.5771 | 39.61 |

| YOLO11s | OpenVINO | FP32 | ✅ | 36.4 | 0.5808 | 18.26 |

| YOLO11s | OpenVINO | INT8 | ✅ | 9.8 | 0.5726 | 13.24 |

| YOLO11m | PyTorch | FP32 | ✅ | 38.8 | 0.6258 | 100.65 |

| YOLO11m | OpenVINO | FP32 | ✅ | 77.1 | 0.6310 | 43.50 |

| YOLO11m | OpenVINO | INT8 | ✅ | 20.2 | 0.6137 | 20.90 |

| YOLO11l | PyTorch | FP32 | ✅ | 49.0 | 0.6367 | 131.37 |

| YOLO11l | OpenVINO | FP32 | ✅ | 97.3 | 0.6371 | 54.52 |

| YOLO11l | OpenVINO | INT8 | ✅ | 25.7 | 0.6226 | 27.36 |

| YOLO11x | PyTorch | FP32 | ✅ | 109.3 | 0.6990 | 212.45 |

| YOLO11x | OpenVINO | FP32 | ✅ | 217.8 | 0.6884 | 112.76 |

| YOLO11x | OpenVINO | INT8 | ✅ | 55.9 | 0.6900 | 52.06 |

Risultati Dettagliati del Benchmark

| Modello | Formato | Precisione | Stato | Dimensione (MB) | metrics/mAP50-95(B) | Tempo di inferenza (ms/im) |

|---|---|---|---|---|---|---|

| YOLO11n | PyTorch | FP32 | ✅ | 5.4 | 0.5072 | 16.29 |

| YOLO11n | OpenVINO | FP32 | ✅ | 10.4 | 0.5077 | 15.04 |

| YOLO11n | OpenVINO | INT8 | ✅ | 3.3 | 0.4980 | 11.60 |

| YOLO11s | PyTorch | FP32 | ✅ | 18.4 | 0.5771 | 39.61 |

| YOLO11s | OpenVINO | FP32 | ✅ | 36.4 | 0.5782 | 33.45 |

| YOLO11s | OpenVINO | INT8 | ✅ | 9.8 | 0.5745 | 20.64 |

| YOLO11m | PyTorch | FP32 | ✅ | 38.8 | 0.6258 | 100.65 |

| YOLO11m | OpenVINO | FP32 | ✅ | 77.1 | 0.6307 | 81.15 |

| YOLO11m | OpenVINO | INT8 | ✅ | 20.2 | 0.6172 | 44.63 |

| YOLO11l | PyTorch | FP32 | ✅ | 49.0 | 0.6367 | 131.37 |

| YOLO11l | OpenVINO | FP32 | ✅ | 97.3 | 0.6409 | 103.77 |

| YOLO11l | OpenVINO | INT8 | ✅ | 25.7 | 0.6240 | 58.00 |

| YOLO11x | PyTorch | FP32 | ✅ | 109.3 | 0.6990 | 212.45 |

| YOLO11x | OpenVINO | FP32 | ✅ | 217.8 | 0.6900 | 208.37 |

| YOLO11x | OpenVINO | INT8 | ✅ | 55.9 | 0.6897 | 113.04 |

Risultati Dettagliati del Benchmark

| Modello | Formato | Precisione | Stato | Dimensione (MB) | metrics/mAP50-95(B) | Tempo di inferenza (ms/im) |

|---|---|---|---|---|---|---|

| YOLO11n | PyTorch | FP32 | ✅ | 5.4 | 0.5072 | 16.29 |

| YOLO11n | OpenVINO | FP32 | ✅ | 10.4 | 0.5075 | 8.02 |

| YOLO11n | OpenVINO | INT8 | ✅ | 3.3 | 0.3656 | 9.28 |

| YOLO11s | PyTorch | FP32 | ✅ | 18.4 | 0.5771 | 39.61 |

| YOLO11s | OpenVINO | FP32 | ✅ | 36.4 | 0.5801 | 13.12 |

| YOLO11s | OpenVINO | INT8 | ✅ | 9.8 | 0.5686 | 13.12 |

| YOLO11m | PyTorch | FP32 | ✅ | 38.8 | 0.6258 | 100.65 |

| YOLO11m | OpenVINO | FP32 | ✅ | 77.1 | 0.6310 | 29.88 |

| YOLO11m | OpenVINO | INT8 | ✅ | 20.2 | 0.6111 | 26.32 |

| YOLO11l | PyTorch | FP32 | ✅ | 49.0 | 0.6367 | 131.37 |

| YOLO11l | OpenVINO | FP32 | ✅ | 97.3 | 0.6356 | 37.08 |

| YOLO11l | OpenVINO | INT8 | ✅ | 25.7 | 0.6245 | 30.81 |

| YOLO11x | PyTorch | FP32 | ✅ | 109.3 | 0.6990 | 212.45 |

| YOLO11x | OpenVINO | FP32 | ✅ | 217.8 | 0.6894 | 68.48 |

| YOLO11x | OpenVINO | INT8 | ✅ | 55.9 | 0.6417 | 49.76 |

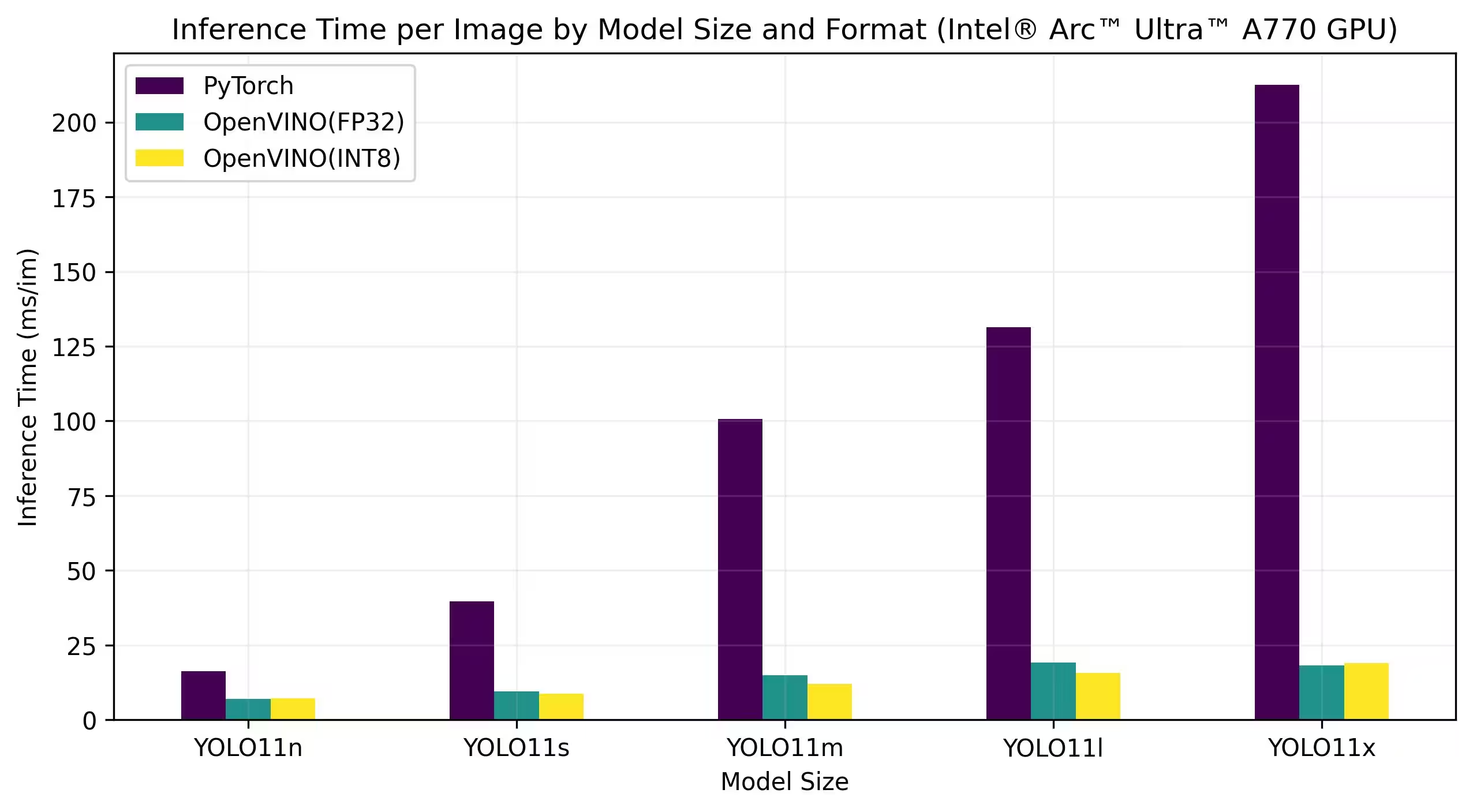

GPU Intel® Arc

Intel® Arc™ è la linea di schede grafiche discrete di Intel progettata per gaming ad alte prestazioni, creazione di contenuti e carichi di lavoro di IA. La serie Arc presenta architetture GPU avanzate che supportano il ray tracing in tempo reale, grafica potenziata dall'IA e gaming ad alta risoluzione. Con un focus su prestazioni ed efficienza, Intel® Arc™ mira a competere con altri marchi leader di GPU, fornendo al contempo funzionalità uniche come la codifica AV1 accelerata via hardware e il supporto per le più recenti API grafiche.

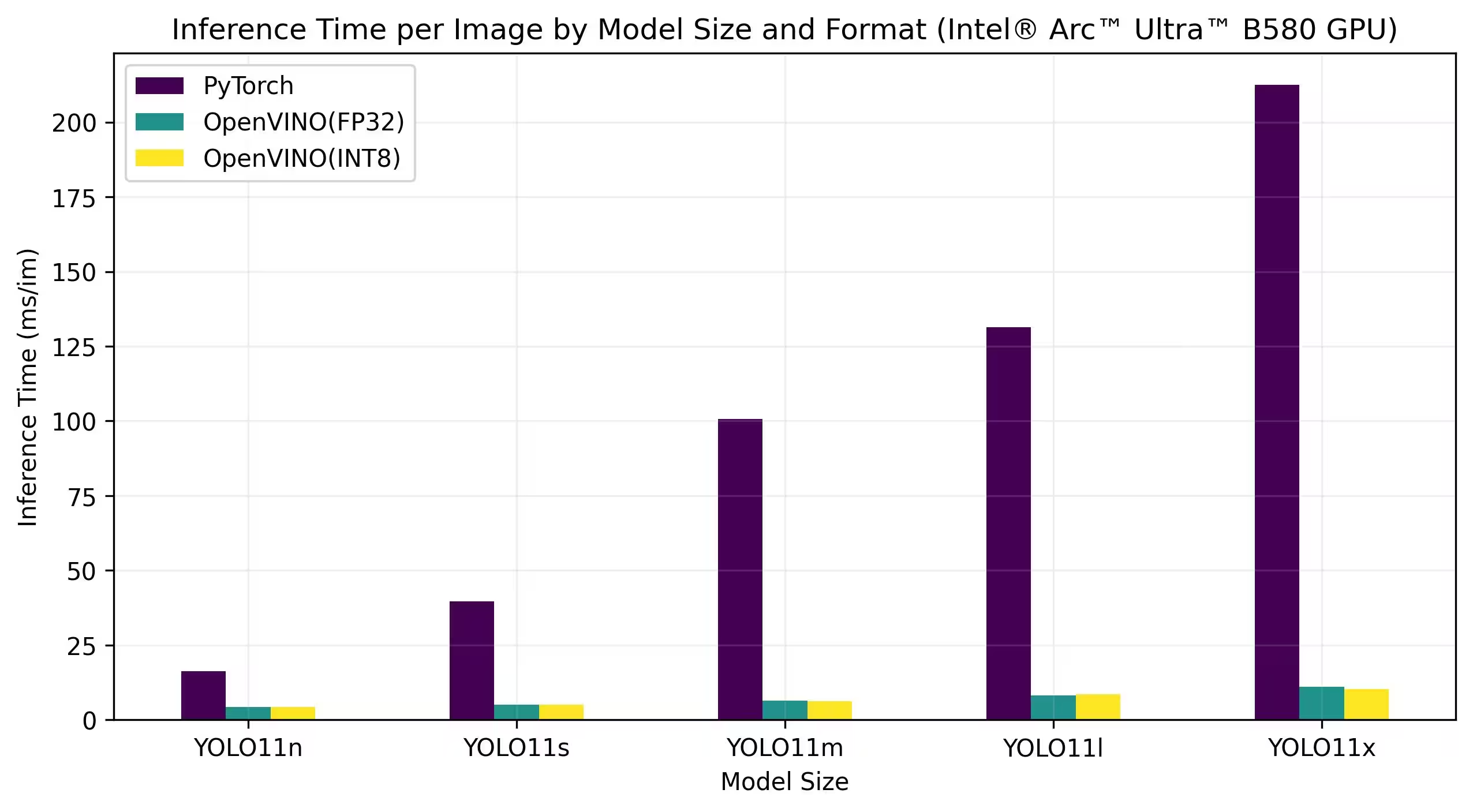

I benchmark seguenti vengono eseguiti su Intel Arc A770 e Intel Arc B580 con precisione FP32 e INT8.

Intel Arc A770

Risultati Dettagliati del Benchmark

| Modello | Formato | Precisione | Stato | Dimensione (MB) | metrics/mAP50-95(B) | Tempo di inferenza (ms/im) |

|---|---|---|---|---|---|---|

| YOLO11n | PyTorch | FP32 | ✅ | 5.4 | 0.5072 | 16.29 |

| YOLO11n | OpenVINO | FP32 | ✅ | 10.4 | 0.5073 | 6.98 |

| YOLO11n | OpenVINO | INT8 | ✅ | 3.3 | 0.4978 | 7.24 |

| YOLO11s | PyTorch | FP32 | ✅ | 18.4 | 0.5771 | 39.61 |

| YOLO11s | OpenVINO | FP32 | ✅ | 36.4 | 0.5798 | 9.41 |

| YOLO11s | OpenVINO | INT8 | ✅ | 9.8 | 0.5751 | 8.72 |

| YOLO11m | PyTorch | FP32 | ✅ | 38.8 | 0.6258 | 100.65 |

| YOLO11m | OpenVINO | FP32 | ✅ | 77.1 | 0.6311 | 14.88 |

| YOLO11m | OpenVINO | INT8 | ✅ | 20.2 | 0.6126 | 11.97 |

| YOLO11l | PyTorch | FP32 | ✅ | 49.0 | 0.6367 | 131.37 |

| YOLO11l | OpenVINO | FP32 | ✅ | 97.3 | 0.6364 | 19.17 |

| YOLO11l | OpenVINO | INT8 | ✅ | 25.7 | 0.6241 | 15.75 |

| YOLO11x | PyTorch | FP32 | ✅ | 109.3 | 0.6990 | 212.45 |

| YOLO11x | OpenVINO | FP32 | ✅ | 217.8 | 0.6888 | 18.13 |

| YOLO11x | OpenVINO | INT8 | ✅ | 55.9 | 0.6930 | 18.91 |

Intel Arc B580

Risultati Dettagliati del Benchmark

| Modello | Formato | Precisione | Stato | Dimensione (MB) | metrics/mAP50-95(B) | Tempo di inferenza (ms/im) |

|---|---|---|---|---|---|---|

| YOLO11n | PyTorch | FP32 | ✅ | 5.4 | 0.5072 | 16.29 |

| YOLO11n | OpenVINO | FP32 | ✅ | 10.4 | 0.5072 | 4.27 |

| YOLO11n | OpenVINO | INT8 | ✅ | 3.3 | 0.4981 | 4.33 |

| YOLO11s | PyTorch | FP32 | ✅ | 18.4 | 0.5771 | 39.61 |

| YOLO11s | OpenVINO | FP32 | ✅ | 36.4 | 0.5789 | 5.04 |

| YOLO11s | OpenVINO | INT8 | ✅ | 9.8 | 0.5746 | 4.97 |

| YOLO11m | PyTorch | FP32 | ✅ | 38.8 | 0.6258 | 100.65 |

| YOLO11m | OpenVINO | FP32 | ✅ | 77.1 | 0.6306 | 6.45 |

| YOLO11m | OpenVINO | INT8 | ✅ | 20.2 | 0.6125 | 6.28 |

| YOLO11l | PyTorch | FP32 | ✅ | 49.0 | 0.6367 | 131.37 |

| YOLO11l | OpenVINO | FP32 | ✅ | 97.3 | 0.6360 | 8.23 |

| YOLO11l | OpenVINO | INT8 | ✅ | 25.7 | 0.6236 | 8.49 |

| YOLO11x | PyTorch | FP32 | ✅ | 109.3 | 0.6990 | 212.45 |

| YOLO11x | OpenVINO | FP32 | ✅ | 217.8 | 0.6889 | 11.10 |

| YOLO11x | OpenVINO | INT8 | ✅ | 55.9 | 0.6924 | 10.30 |

Riproduci i nostri risultati

Per riprodurre i benchmark Ultralytics di cui sopra su tutti i formati di esportazione, eseguire questo codice:

Esempio

from ultralytics import YOLO

# Load a YOLO11n PyTorch model

model = YOLO("yolo11n.pt")

# Benchmark YOLO11n speed and accuracy on the COCO128 dataset for all export formats

results = model.benchmark(data="coco128.yaml")

# Benchmark YOLO11n speed and accuracy on the COCO128 dataset for all export formats

yolo benchmark model=yolo11n.pt data=coco128.yaml

Si noti che i risultati dei benchmark possono variare in base alla configurazione hardware e software esatta di un sistema, nonché al carico di lavoro corrente del sistema al momento dell'esecuzione dei benchmark. Per ottenere risultati più affidabili, utilizzare un dataset con un numero elevato di immagini, ad esempio data='coco.yaml' (5000 immagini val).

Conclusione

I risultati del benchmarking dimostrano chiaramente i vantaggi dell'esportazione del modello YOLO11 nel formato OpenVINO. Tra diversi modelli e piattaforme hardware, il formato OpenVINO supera costantemente gli altri formati in termini di velocità di inferenza, pur mantenendo un'accuratezza comparabile.

I benchmark sottolineano l'efficacia di OpenVINO come strumento per la distribuzione di modelli di deep learning. Convertendo i modelli nel formato OpenVINO, gli sviluppatori possono ottenere miglioramenti significativi delle prestazioni, semplificando la distribuzione di questi modelli in applicazioni reali.

Per informazioni più dettagliate e istruzioni sull'utilizzo di OpenVINO, consultare la documentazione ufficiale di OpenVINO.

FAQ

Come si esportano i modelli YOLO26 nel formato OpenVINO?

L'esportazione dei modelli YOLO26 nel formato OpenVINO può migliorare significativamente la velocità della CPU e abilitare le accelerazioni GPU e NPU sull'hardware Intel. Per l'esportazione, puoi utilizzare python o CLI come mostrato di seguito:

Esempio

from ultralytics import YOLO

# Load a YOLO26n PyTorch model

model = YOLO("yolo26n.pt")

# Export the model

model.export(format="openvino") # creates 'yolo26n_openvino_model/'

# Export a YOLO26n PyTorch model to OpenVINO format

yolo export model=yolo26n.pt format=openvino # creates 'yolo26n_openvino_model/'

Per ulteriori informazioni, consultare la documentazione sui formati di esportazione.

Quali sono i vantaggi dell'utilizzo di OpenVINO con i modelli YOLO26?

L'utilizzo del toolkit OpenVINO di Intel con i modelli YOLO26 offre numerosi vantaggi:

- Prestazioni: Ottieni un aumento di velocità fino a 3 volte sull'inferenza della CPU e sfrutta le GPU e le NPU Intel per l'accelerazione.

- Ottimizzatore di modelli: Converti, ottimizza ed esegui modelli da framework diffusi come PyTorch, TensorFlow e ONNX.

- Facilità d'uso: Sono disponibili oltre 80 notebook tutorial per aiutare gli utenti a iniziare, inclusi quelli per YOLO26.

- Esecuzione eterogenea: Distribuisci modelli su vari hardware Intel con un'API unificata.

Per confronti dettagliati delle prestazioni, visita la nostra sezione benchmark.

Come posso eseguire l'inferenza utilizzando un modello YOLO26 esportato in OpenVINO?

Dopo aver esportato un modello YOLO26n nel formato OpenVINO, puoi eseguire l'inferenza utilizzando python o CLI:

Esempio

from ultralytics import YOLO

# Load the exported OpenVINO model

ov_model = YOLO("yolo26n_openvino_model/")

# Run inference

results = ov_model("https://ultralytics.com/images/bus.jpg")

# Run inference with the exported model

yolo predict model=yolo26n_openvino_model source='https://ultralytics.com/images/bus.jpg'

Consulta la nostra documentazione sulla modalità di previsione per maggiori dettagli.

Perché dovrei scegliere Ultralytics YOLO26 rispetto ad altri modelli per l'esportazione in OpenVINO?

Ultralytics YOLO26 è ottimizzato per il rilevamento di oggetti in tempo reale con elevata precisione e velocità. In particolare, se combinato con OpenVINO, YOLO26 offre:

- Aumento di velocità fino a 3 volte sulle CPU Intel

- Distribuzione fluida su GPU e NPU Intel

- Accuratezza coerente e comparabile tra vari formati di esportazione

Per un'analisi approfondita delle prestazioni, consulta i nostri benchmark dettagliati di YOLO11 su diversi hardware.

Posso eseguire il benchmark dei modelli YOLO26 su diversi formati come PyTorch, ONNX e OpenVINO?

Sì, è possibile eseguire benchmark dei modelli YOLO26 in vari formati, tra cui PyTorch, TorchScript, ONNX e OpenVINO. Utilizzare il seguente frammento di codice per eseguire benchmark sul set di dati scelto:

Esempio

from ultralytics import YOLO

# Load a YOLO26n PyTorch model

model = YOLO("yolo26n.pt")

# Benchmark YOLO26n speed and [accuracy](https://www.ultralytics.com/glossary/accuracy) on the COCO8 dataset for all export formats

results = model.benchmark(data="coco8.yaml")

# Benchmark YOLO26n speed and accuracy on the COCO8 dataset for all export formats

yolo benchmark model=yolo26n.pt data=coco8.yaml

Per risultati di benchmark dettagliati, consulta la nostra sezione benchmark e la documentazione sui formati di esportazione.