アノテーションされたコンピュータビジョンデータのためのデータ前処理テクニック

はじめに

コンピュータビジョンプロジェクトの目標を定義し、データを収集してアノテーションを付けた後、次のステップは、アノテーションが付けられたデータを前処理し、モデルトレーニングの準備をすることです。クリーンで一貫性のあるデータは、パフォーマンスの高いモデルを作成するために不可欠です。

見る: データの前処理と拡張を使用して、現実世界のシナリオでモデルの精度を向上させる方法 🚀

前処理は、コンピュータビジョンプロジェクトのワークフローにおけるステップであり、画像のリサイズ、ピクセル値の正規化、データセットの拡張、データのトレーニング、検証、テストセットへの分割が含まれます。データをクリーンにするための重要なテクニックとベストプラクティスを探りましょう!

データ前処理の重要性

すでに多くの考慮事項を念頭に置いてデータを注意深く収集し、アノテーションを付けていますが、コンピュータービジョンプロジェクトにおいてデータの前処理がこれほど重要なのはなぜでしょうか。データの前処理は、計算負荷を軽減し、モデルのパフォーマンスを向上させるために、データをトレーニングに適した形式にすることです。以下は、前処理で対処する生データにおける一般的な問題点です。

- ノイズ: データ内の無関係またはランダムな変動。

- 非一貫性: 画像サイズ、形式、および品質のばらつき。

- 不均衡: データセット内のクラスまたはカテゴリの不均等な分布。

データ前処理テクニック

データの前処理における最初で最も重要なステップの1つは、サイズ変更です。一部のモデルは可変入力サイズを処理するように設計されていますが、多くのモデルは一貫した入力サイズを必要とします。画像サイズを変更すると、画像が均一になり、計算の複雑さが軽減されます。

画像のリサイズ

画像のリサイズには、次の方法を使用できます。

- バイリニア補間: 最も近い4つのピクセル値の加重平均を取ることにより、ピクセル値を滑らかにします。

- 最近傍法: 平均化せずに最も近いピクセル値を割り当てるため、画像がブロック状になりますが、計算が高速になります。

サイズ変更をより簡単なタスクにするために、次のツールを使用できます。

- OpenCV: 画像処理のための広範な機能を備えた、一般的なコンピュータビジョンライブラリ。

- PIL (Pillow): 画像ファイルを開き、操作し、保存するためのpythonイメージングライブラリ。

YOLO26では、モデルトレーニング中の「imgsz」パラメータにより、柔軟な入力サイズに対応できます。640などの特定のサイズに設定すると、モデルは入力画像の最大辺が640ピクセルになるようにリサイズし、元の縦横比を維持します。

モデルとデータセットの具体的なニーズを評価することで、リサイズが必要な前処理ステップであるか、またはモデルがさまざまなサイズの画像を効率的に処理できるかを判断できます。

ピクセル値の正規化

別の前処理手法は正規化です。正規化は、ピクセル値を標準範囲にスケーリングし、トレーニング中のより高速な収束を助け、モデルのパフォーマンスを向上させます。一般的な正規化手法を以下に示します。

- Min-Maxスケーリング:ピクセル値を0〜1の範囲にスケーリングします。

- Zスコア正規化:ピクセル値をその平均と標準偏差に基づいてスケールします。

YOLO26では、モデルトレーニング中の前処理パイプラインの一部として、正規化がシームレスに処理されます。YOLO26は、RGBへの変換、ピクセル値の[0, 1]範囲へのスケーリング、事前定義された平均値と標準偏差値を使用した正規化など、いくつかの前処理ステップを自動的に実行します。

データセットの分割

データをクレンジングしたら、データセットを分割する準備が整います。データをトレーニング、検証、テストの各セットに分割することで、モデルの汎化性能を評価するために、未知のデータでモデルを評価できるようになります。一般的な分割は、トレーニングに70%、検証に20%、テストに10%です。データの分割には、scikit-learnやTensorFlowなどのさまざまなツールやライブラリを使用できます。

データセットを分割する際は、次の点を考慮してください。

- データ分布の維持: クラスのデータ分布が、学習、検証、およびテストセット全体で維持されていることを確認します。

- データリークの回避:通常、データ拡張はデータセットの分割後に行われます。データ拡張およびその他の前処理は、検証セットまたはテストセットからの情報がモデルのトレーニングに影響を与えないように、トレーニングセットにのみ適用する必要があります。

- クラスのバランス調整: 不均衡なデータセットに対しては、トレーニングセット内で少数派クラスをオーバーサンプリングしたり、多数派クラスをアンダーサンプリングするなどの手法を検討してください。

データ拡張とは何ですか?

最も一般的に議論されるデータ前処理ステップは、データ拡張です。データ拡張は、画像の修正版を作成することにより、データセットのサイズを人工的に増加させます。データを拡張することにより、過学習を軽減し、モデルの汎化能力を向上させることができます。

データ拡張のその他の利点を以下に示します。

- より堅牢なデータセットを作成する:データ拡張により、モデルは入力データの変動や歪みに対してより堅牢になります。これには、照明、向き、スケールの変化が含まれます。

- 費用対効果が高い:データ拡張は、新しいデータを収集してラベル付けすることなく、トレーニングデータの量を増やすための費用対効果の高い方法です。

- データの有効活用:あらゆる利用可能なデータポイントを最大限に活用し、新たなバリエーションを創出する。

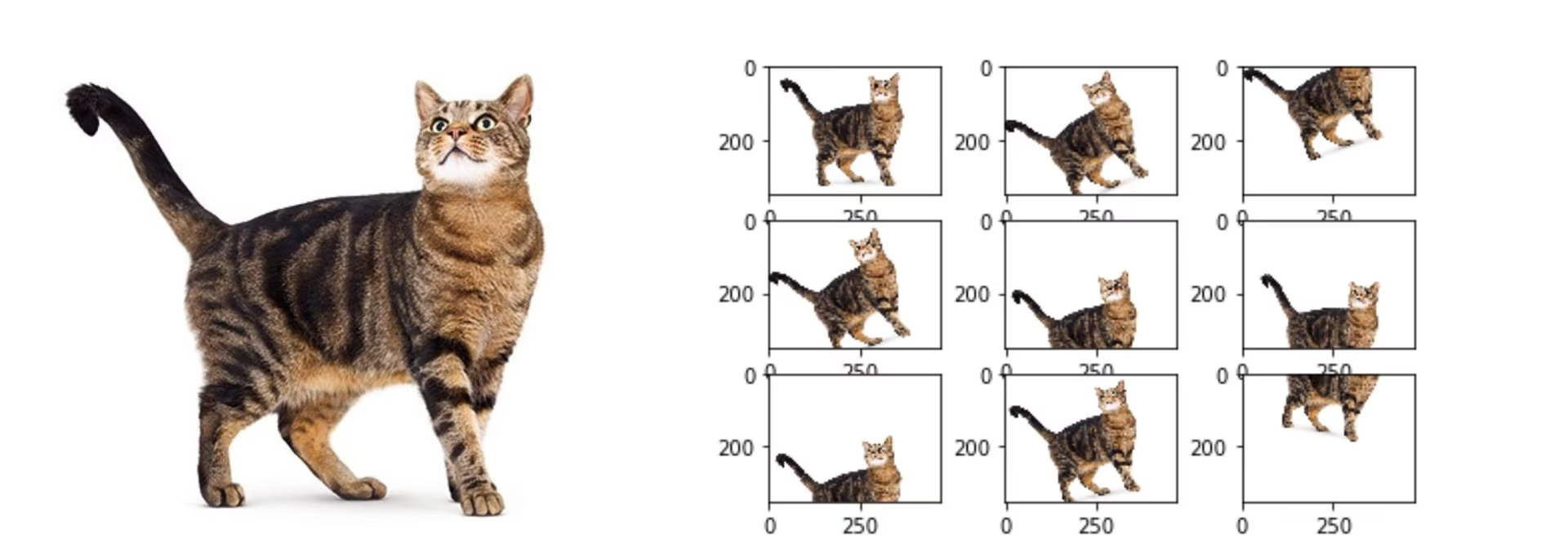

データ拡張手法

一般的なデータ拡張手法には、反転、回転、スケーリング、色の調整などがあります。 Albumentations、Imgaug、TensorFlowのImageDataGeneratorなどのライブラリは、これらの拡張を生成できます。

YOLO26では、データセット設定ファイルである.yamlファイルを変更することで、カスタムデータセットを拡張できます。このファイルに、データをどのように拡張するかを指定するパラメータを含む拡張セクションを追加できます。

The Ultralytics YOLO26リポジトリは、幅広いデータ拡張をサポートしています。以下のような様々な変換を適用できます。

- ランダムクロップ

- 反転:画像を水平または垂直に反転できます。

- 回転:画像は特定の角度で回転できます。

- 歪み

また、これらの拡張手法の強度を特定のパラメータで調整して、より多様なデータを生成できます。

前処理のケーススタディ

YOLO26を使用して交通画像内の様々な種類の車両をdetectし、classifyするモデルを開発するプロジェクトを考えてみましょう。交通画像を収集し、バウンディングボックスとラベルでアノテーションを行いました。

このプロジェクトにおける各前処理ステップは以下のようになります。

- 画像のリサイズ: YOLO26は柔軟な入力サイズを扱い、リサイズを自動的に実行するため、手動でのリサイズは不要です。モデルはトレーニング中に指定された「imgsz」パラメータに従って画像サイズを調整します。

- ピクセル値の正規化: YOLO26は前処理中にピクセル値を自動的に0から1の範囲に正規化するため、これは不要です。

- データセットの分割: scikit-learnなどのツールを使用して、データセットをトレーニングセット(70%)、検証セット(20%)、およびテストセット(10%)に分割します。

- Data Augmentation: データセット構成ファイル(.yaml)を修正して、ランダムクロップ、水平反転、明るさ調整などのデータ拡張テクニックを含めます。

これらの手順により、データセットに潜在的な問題がないように準備され、探索的データ分析(EDA)の準備が整います。

探索的データ分析手法

データセットを前処理および拡張した後、次のステップは探索的データ分析を通じて洞察を得ることです。EDA は、統計的手法と視覚化ツールを使用して、データ内のパターンと分布を理解します。クラスの不均衡や外れ値などの問題を特定し、さらなるデータの前処理やモデルトレーニングの調整について、情報に基づいた意思決定を行うことができます。

統計的EDA手法

統計的手法は、平均、中央値、標準偏差、範囲などの基本的な指標を計算することから始まることがよくあります。これらの指標は、ピクセル強度分布など、画像データセットの特性をすばやく把握するのに役立ちます。これらの基本的な統計を理解することで、データの全体的な品質と特性を把握し、早期に異常を発見できます。

視覚的なEDAテクニック

画像データセットのEDA(探索的データ分析)では、可視化が重要です。たとえば、クラスの不均衡分析もEDAの重要な側面です。これは、特定のクラスがデータセットで過小評価されていないかを判断するのに役立ちます。棒グラフを使用してさまざまな画像クラスまたはカテゴリの分布を可視化すると、不均衡をすばやく明らかにできます。同様に、外れ値は、ピクセル強度または特徴分布の異常を強調する箱ひげ図などの可視化ツールを使用して識別できます。外れ値検出は、異常なデータポイントが結果を歪めるのを防ぎます。

可視化のための一般的なツール:

- ヒストグラムと箱ひげ図: ピクセル値の分布を理解し、外れ値を特定するのに役立ちます。

- 散布図: 画像の特徴やアノテーション間の関係を調査するのに役立ちます。

- ヒートマップ:画像内のピクセル強度や注釈付き特徴の空間分布を視覚化するのに効果的です。

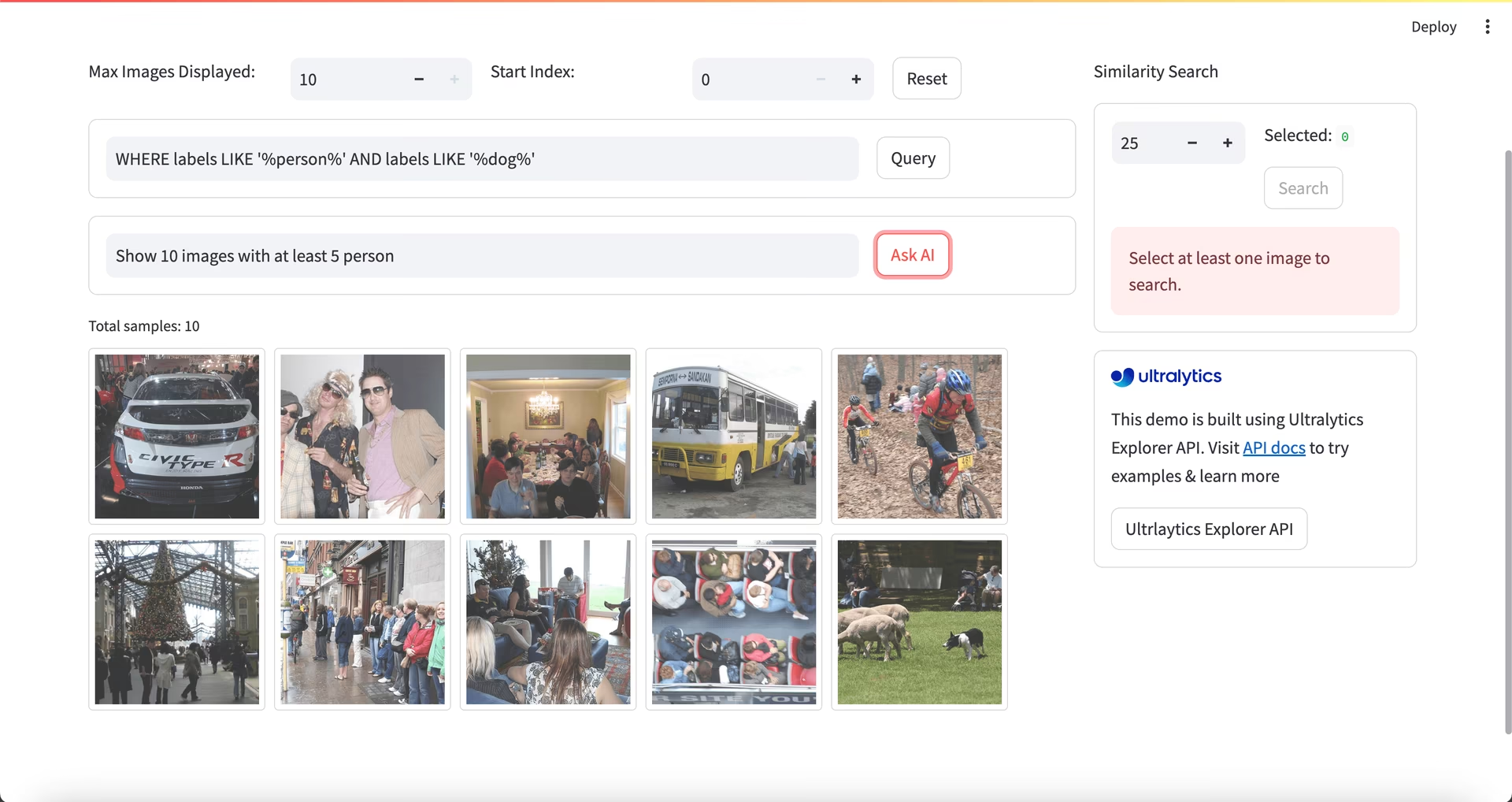

EDA 向けの Ultralytics Explorer の使用

コミュニティノート

〜の時点で ultralytics>=8.3.10、Ultralytics Explorerのサポートは非推奨になりました。同様の(そして拡張された)データセット探索機能は、以下で利用できます。 Ultralytics Platform.

EDAのより高度なアプローチとしては、Ultralytics Explorerツールを使用できます。このツールは、コンピュータビジョンデータセットを探索するための堅牢な機能を提供します。セマンティック検索、SQLクエリ、ベクター類似性検索をサポートすることにより、データの分析と理解が容易になります。Ultralytics Explorerを使用すると、データセットの埋め込みを作成して類似の画像を見つけたり、SQLクエリを実行して詳細な分析を行ったり、セマンティック検索を実行したりできます。これらはすべて、ユーザーフレンドリーなグラフィカルインターフェイスを通じて行えます。

お問い合わせと接続

他のコンピュータビジョン愛好家とプロジェクトについて話し合うことで、さまざまな視点から新しいアイデアを得ることができます。学習、トラブルシューティング、ネットワークを構築するための優れた方法をいくつかご紹介します。

コミュニティと繋がるためのチャネル

- GitHub Issues: YOLO26のGitHubリポジトリにアクセスし、Issuesタブを使用して質問を投稿したり、バグを報告したり、機能を提案したりしてください。コミュニティとメンテナーが、直面するあらゆる問題の解決をサポートします。

- Ultralytics Discordサーバー: Ultralytics Discordサーバーに参加して、他のユーザーや開発者と繋がり、サポートを受けたり、知識を共有したり、アイデアを出し合ったりしましょう。

公式ドキュメント

- Ultralytics YOLO26ドキュメンテーション: 多数のコンピュータビジョンタスクやプロジェクトに関する詳細なガイドと貴重な洞察については、公式YOLO26ドキュメンテーションを参照してください。

データセットの準備ができました!

適切にサイズ変更、正規化、および拡張されたデータは、ノイズを減らし、一般化を改善することにより、モデルのパフォーマンスを向上させます。このガイドで概説されている前処理の手法とベストプラクティスに従うことで、堅牢なデータセットを作成できます。前処理済みのデータセットが準備できたら、プロジェクトの次のステップに自信を持って進むことができます。

よくある質問

コンピュータビジョンプロジェクトにおけるデータ前処理の重要性は何ですか?

データの前処理は、データがクリーンで一貫性があり、モデルのトレーニングに最適な形式であることを保証するため、コンピュータビジョンプロジェクトにおいて不可欠です。生データにおけるノイズ、不整合、不均衡などの問題に対処することで、サイズ変更、正規化、拡張、データセットの分割などの前処理ステップは、計算負荷を軽減し、モデルの性能を向上させるのに役立ちます。詳細については、コンピュータビジョンプロジェクトのステップをご覧ください。

データ拡張に Ultralytics YOLO を使用するにはどうすればよいですか?

Ultralytics YOLO26でのデータ拡張には、データセット設定ファイル(.yaml)を変更する必要があります。このファイルでは、ランダムクロップ、水平フリップ、明るさ調整など、様々な拡張手法を指定できます。これは、こちらで説明されているトレーニング設定を使用して効果的に行うことができます。データ拡張は、より堅牢なデータセットを作成し、過学習を減らし、モデルの汎化能力を向上させるのに役立ちます。

コンピュータビジョンデータに最適なデータ正規化手法は何ですか?

正規化は、トレーニング中の収束を速め、パフォーマンスを向上させるために、ピクセル値を標準範囲に調整します。一般的な手法は次のとおりです。

- Min-Maxスケーリング:ピクセル値を0〜1の範囲にスケーリングします。

- Zスコア正規化:ピクセル値をその平均と標準偏差に基づいてスケールします。

YOLO26では、RGBへの変換やピクセル値のスケーリングを含め、正規化が自動的に処理されます。詳細については、モデルトレーニングセクションをご覧ください。

アノテーション済みのデータセットをトレーニング用に分割するにはどうすればよいですか?

データセットを分割するには、一般的に、トレーニング用に70%、検証用に20%、テスト用に10%に分割します。これらの分割全体でクラスのデータ分布を維持し、トレーニングセットでのみ拡張を実行して、データのリークを回避することが重要です。効率的なデータセット分割には、scikit-learnやTensorFlowなどのツールを使用します。詳細なガイドについては、データセットの準備を参照してください。

YOLO26で手動リサイズなしに様々な画像サイズを扱えますか?

はい、Ultralytics YOLO26は、モデルトレーニング中の「imgsz」パラメータを通じて様々な画像サイズを処理できます。このパラメータにより、アスペクト比を維持しながら、画像の最大辺が指定されたサイズ(例:640ピクセル)に一致するようにリサイズされます。より柔軟な入力処理と自動調整については、モデルトレーニングセクションをご確認ください。