Ultralytics YOLO26

概要

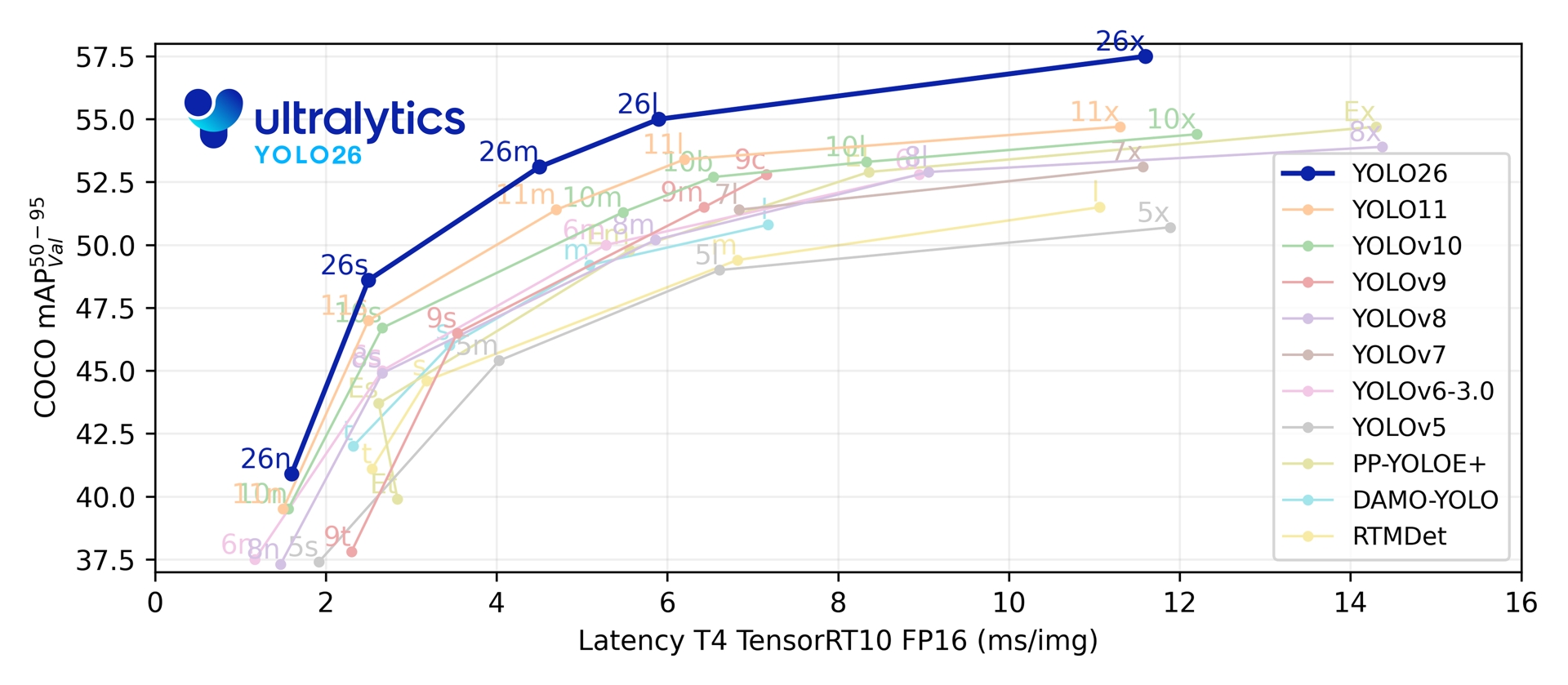

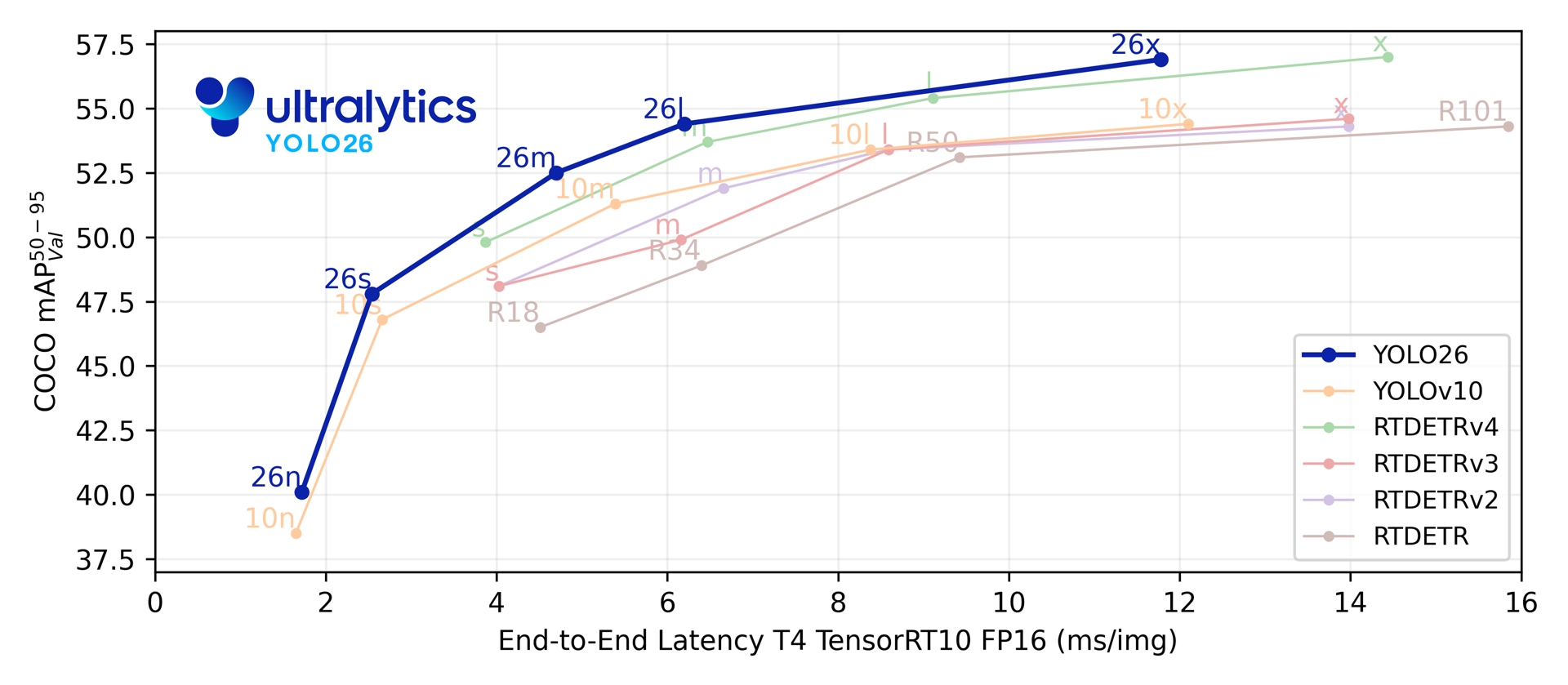

Ultralytics YOLO26は、リアルタイムオブジェクト検出器であるYOLOシリーズの最新の進化版であり、エッジおよび低電力デバイス向けにゼロから設計されています。不要な複雑さを排除し、的を絞ったイノベーションを統合することで、より高速、軽量、かつアクセスしやすい展開を実現する、合理化された設計を導入しています。

Ultralytics をお試しください

Ultralytics Platform上でYOLO26モデルを直接探索・実行する。

YOLO26のアーキテクチャは、3つのコア原則に基づいて設計されています。

- シンプルさ: YOLO26はネイティブなエンドツーエンドモデルであり、非最大抑制 (NMS) を必要とせずに直接予測を生成します。この後処理ステップを排除することで、推論はより高速、軽量になり、実世界のシステムへのデプロイが容易になります。この画期的なアプローチは、清華大学のAo Wang氏によってYOLOv10で初めて開拓され、YOLO26でさらに進化しました。

- 展開効率: エンドツーエンド設計により、パイプライン全体のステージが削減され、統合が大幅に簡素化され、遅延が減少し、多様な環境での展開がより堅牢になります。

- トレーニングの革新: YOLO26は、Moonshot AIのKimi K2におけるLLMトレーニングのブレークスルーに触発された、SGDとMuonのハイブリッドであるMuSGDオプティマイザを導入します。このオプティマイザは、安定性の向上と収束の高速化をもたらし、言語モデルからの最適化の進歩をコンピュータビジョンに転用します。

- タスク固有の最適化: YOLO26は、Segmentationのためのセマンティックセグメンテーション損失とマルチスケールプロトモジュール、高精度なPose推定のための残差対数尤度推定(RLE)、およびOBBにおける境界問題を解決するための角度損失を伴う最適化されたデコードなど、特殊なタスク向けに的を絞った改善を導入しています。

これらのイノベーションにより、小型オブジェクトでより高い精度を達成し、シームレスな展開を提供し、CPUで最大43%高速に動作するモデルファミリーが実現しました。これにより、YOLO26は、リソースが制約された環境にとって、これまでで最も実用的で展開可能なYOLOモデルの1つとなっています。

主な特徴

DFLの削除

Distribution Focal Loss (DFL) モジュールは効果的であるものの、エクスポートを複雑にし、ハードウェア互換性を制限することがよくありました。YOLO26はDFLを完全に削除し、推論を簡素化し、エッジおよび低電力デバイスのサポートを拡大します。エンドツーエンドのNMSフリー推論

NMSを個別の後処理ステップとして利用する従来の検出器とは異なり、YOLO26はネイティブなエンドツーエンドです。予測が直接生成されるため、レイテンシが削減され、本番システムへの統合がより高速、軽量、かつ信頼性の高いものになります。ProgLoss + STAL

改善された損失関数はdetect精度を向上させ、IoT、ロボティクス、航空画像、その他のエッジアプリケーションにとって重要な要件である小物体認識において顕著な改善が見られます。MuSGDオプティマイザ

SGDとMuonを組み合わせた新しいハイブリッドオプティマイザ。Moonshot AIのKimi K2に触発され、MuSGDはLLMトレーニングからの高度な最適化手法をコンピュータビジョンに導入し、より安定したトレーニングと高速な収束を可能にします。最大43%高速なCPU推論

エッジコンピューティング向けに特別に最適化されたYOLO26は、大幅に高速なCPU推論を実現し、GPUを搭載しないデバイスでもリアルタイムパフォーマンスを保証します。インスタンスセグメンテーションの強化

モデルの収束を改善するためのセマンティックセグメンテーション損失と、優れたマスク品質のためにマルチスケール情報を活用するアップグレードされたプロトモジュールを導入しています。高精度姿勢推定

Residual Log-Likelihood Estimation (RLE) を統合し、より正確なキーポイント局所化を実現し、推論速度向上のためにデコードプロセスを最適化します。洗練されたobbデコーディング

特殊な角度損失を導入して正方形オブジェクトのdetect精度を向上させ、境界の不連続性の問題を解決するためにobbデコーディングを最適化します。

サポートされているタスクとモード

YOLO26は、以前のUltralytics YOLOリリースによって確立された多用途なモデル範囲を基盤とし、様々なコンピュータービジョンタスクにおいて強化されたサポートを提供します。

| モデル | ファイル名 | タスク | 推論 | 検証 | 学習 | エクスポート |

|---|---|---|---|---|---|---|

| YOLO26 | yolo26n.pt yolo26s.pt yolo26m.pt yolo26l.pt yolo26x.pt | 検出 | ✅ | ✅ | ✅ | ✅ |

| YOLO26-seg | yolo26n-seg.pt yolo26s-seg.pt yolo26m-seg.pt yolo26l-seg.pt yolo26x-seg.pt | インスタンスセグメンテーション | ✅ | ✅ | ✅ | ✅ |

| YOLO26-pose | yolo26n-pose.pt yolo26s-pose.pt yolo26m-pose.pt yolo26l-pose.pt yolo26x-pose.pt | ポーズ/キーポイント | ✅ | ✅ | ✅ | ✅ |

| YOLO26-obb | yolo26n-obb.pt yolo26s-obb.pt yolo26m-obb.pt yolo26l-obb.pt yolo26x-obb.pt | 傾斜検出 | ✅ | ✅ | ✅ | ✅ |

| YOLO26-cls | yolo26n-cls.pt yolo26s-cls.pt yolo26m-cls.pt yolo26l-cls.pt yolo26x-cls.pt | 分類 | ✅ | ✅ | ✅ | ✅ |

この統一されたフレームワークにより、YOLO26は、リアルタイム検出、セグメンテーション、分類、姿勢推定、および方向指定されたオブジェクト検出に適用可能となり、トレーニング、検証、推論、およびエクスポートのすべてをサポートします。

パフォーマンス指標

パフォーマンス

検出ドキュメントで、80の事前学習済みクラスを含むCOCOでトレーニングされたこれらのモデルの使用例をご覧ください。

| モデル | サイズ (ピクセル) | mAPval 50-95 | mAPval 50-95(e2e) | 速度 CPU ONNX (ms) | 速度 T4 TensorRT10 (ms) | params (M) | FLOPs (B) |

|---|---|---|---|---|---|---|---|

| YOLO26n | 640 | 40.9 | 40.1 | 38.9 ± 0.7 | 1.7 ± 0.0 | 2.4 | 5.4 |

| YOLO26s | 640 | 48.6 | 47.8 | 87.2 ± 0.9 | 2.5 ± 0.0 | 9.5 | 20.7 |

| YOLO26m | 640 | 53.1 | 52.5 | 220.0 ± 1.4 | 4.7 ± 0.1 | 20.4 | 68.2 |

| YOLO26l | 640 | 55.0 | 54.4 | 286.2 ± 2.0 | 6.2 ± 0.2 | 24.8 | 86.4 |

| YOLO26x | 640 | 57.5 | 56.9 | 525.8 ± 4.0 | 11.8 ± 0.2 | 55.7 | 193.9 |

セグメンテーションドキュメントで、80の事前学習済みクラスを含むCOCOでトレーニングされたこれらのモデルの使用例をご覧ください。

| モデル | サイズ (ピクセル) | mAPbox 50-95(e2e) | mAPmask 50-95(e2e) | 速度 CPU ONNX (ms) | 速度 T4 TensorRT10 (ms) | params (M) | FLOPs (B) |

|---|---|---|---|---|---|---|---|

| YOLO26n-seg | 640 | 39.6 | 33.9 | 53.3 ± 0.5 | 2.1 ± 0.0 | 2.7 | 9.1 |

| YOLO26s-seg | 640 | 47.3 | 40.0 | 118.4 ± 0.9 | 3.3 ± 0.0 | 10.4 | 34.2 |

| YOLO26m-seg | 640 | 52.5 | 44.1 | 328.2 ± 2.4 | 6.7 ± 0.1 | 23.6 | 121.5 |

| YOLO26l-seg | 640 | 54.4 | 45.5 | 387.0 ± 3.7 | 8.0 ± 0.1 | 28.0 | 139.8 |

| YOLO26x-seg | 640 | 56.5 | 47.0 | 787.0 ± 6.8 | 16.4 ± 0.1 | 62.8 | 313.5 |

分類ドキュメントで、1000の事前学習済みクラスを含むImageNetでトレーニングされたこれらのモデルの使用例をご覧ください。

| モデル | サイズ (ピクセル) | acc top1 | acc top5 | 速度 CPU ONNX (ms) | 速度 T4 TensorRT10 (ms) | params (M) | FLOPs (B) at 224 |

|---|---|---|---|---|---|---|---|

| YOLO26n-cls | 224 | 71.4 | 90.1 | 5.0 ± 0.3 | 1.1 ± 0.0 | 2.8 | 0.5 |

| YOLO26s-cls | 224 | 76.0 | 92.9 | 7.9 ± 0.2 | 1.3 ± 0.0 | 6.7 | 1.6 |

| YOLO26m-cls | 224 | 78.1 | 94.2 | 17.2 ± 0.4 | 2.0 ± 0.0 | 11.6 | 4.9 |

| YOLO26l-cls | 224 | 79.0 | 94.6 | 23.2 ± 0.3 | 2.8 ± 0.0 | 14.1 | 6.2 |

| YOLO26x-cls | 224 | 79.9 | 95.0 | 41.4 ± 0.9 | 3.8 ± 0.0 | 29.6 | 13.6 |

COCOでトレーニングされ、1つの事前学習済みクラス「person」を含むこれらのモデルの使用例については、ポーズ推定ドキュメントを参照してください。

| モデル | サイズ (ピクセル) | mAPpose 50-95(e2e) | mAPpose 50(e2e) | 速度 CPU ONNX (ms) | 速度 T4 TensorRT10 (ms) | params (M) | FLOPs (B) |

|---|---|---|---|---|---|---|---|

| YOLO26n-pose | 640 | 57.2 | 83.3 | 40.3 ± 0.5 | 1.8 ± 0.0 | 2.9 | 7.5 |

| YOLO26s-pose | 640 | 63.0 | 86.6 | 85.3 ± 0.9 | 2.7 ± 0.0 | 10.4 | 23.9 |

| YOLO26m-pose | 640 | 68.8 | 89.6 | 218.0 ± 1.5 | 5.0 ± 0.1 | 21.5 | 73.1 |

| YOLO26l-pose | 640 | 70.4 | 90.5 | 275.4 ± 2.4 | 6.5 ± 0.1 | 25.9 | 91.3 |

| YOLO26x-pose | 640 | 71.6 | 91.6 | 565.4 ± 3.0 | 12.2 ± 0.2 | 57.6 | 201.7 |

指向性検出ドキュメントで、15の事前学習済みクラスを含むDOTAv1でトレーニングされたこれらのモデルの使用例をご覧ください。

| モデル | サイズ (ピクセル) | mAPtest 50-95(e2e) | mAPtest 50(e2e) | 速度 CPU ONNX (ms) | 速度 T4 TensorRT10 (ms) | params (M) | FLOPs (B) |

|---|---|---|---|---|---|---|---|

| YOLO26n-obb | 1024 | 52.4 | 78.9 | 97.7 ± 0.9 | 2.8 ± 0.0 | 2.5 | 14.0 |

| YOLO26s-obb | 1024 | 54.8 | 80.9 | 218.0 ± 1.4 | 4.9 ± 0.1 | 9.8 | 55.1 |

| YOLO26m-obb | 1024 | 55.3 | 81.0 | 579.2 ± 3.8 | 10.2 ± 0.3 | 21.2 | 183.3 |

| YOLO26l-obb | 1024 | 56.2 | 81.6 | 735.6 ± 3.1 | 13.0 ± 0.2 | 25.6 | 230.0 |

| YOLO26x-obb | 1024 | 56.7 | 81.7 | 1485.7 ± 11.5 | 30.5 ± 0.9 | 57.6 | 516.5 |

パラメータ数とFLOPs値は、融合後のモデルに対するものです。 model.fuse()これはConv層とBatchNorm層を統合し、補助的な1対多検出ヘッドを削除したものです。事前学習済みチェックポイントは完全な学習アーキテクチャを保持しており、より高いカウントを示す可能性があります。

使用例

このセクションでは、YOLO26のトレーニングと推論の簡単な例を提供します。これらのモードやその他のモードに関する完全なドキュメントについては、Predict、Train、Val、およびExportのドキュメントページを参照してください。

以下の例は、物体detect用のYOLO26 Detectモデルに関するものです。追加でサポートされているタスクについては、Segment、Classify、OBB、およびPoseのドキュメントを参照してください。

例

PyTorch 学習済み *.pt モデルおよび構成 *.yaml filesを以下に渡すことができます。 YOLO() pythonでモデルインスタンスを作成するためのclass:

from ultralytics import YOLO

# Load a COCO-pretrained YOLO26n model

model = YOLO("yolo26n.pt")

# Train the model on the COCO8 example dataset for 100 epochs

results = model.train(data="coco8.yaml", epochs=100, imgsz=640)

# Run inference with the YOLO26n model on the 'bus.jpg' image

results = model("path/to/bus.jpg")

CLIコマンドは、モデルを直接実行するために利用できます。

# Load a COCO-pretrained YOLO26n model and train it on the COCO8 example dataset for 100 epochs

yolo train model=yolo26n.pt data=coco8.yaml epochs=100 imgsz=640

# Load a COCO-pretrained YOLO26n model and run inference on the 'bus.jpg' image

yolo predict model=yolo26n.pt source=path/to/bus.jpg

デュアルヘッドアーキテクチャ

YOLO26はデュアルヘッドアーキテクチャを採用しており、様々な導入シナリオに対応する柔軟性を提供します:

- 1対1ヘッド(デフォルト):NMSなしでエンドツーエンドの予測を生成し、出力する

(N, 300, 6)1画像あたり最大300回の検出が可能です。このヘッドは高速推論と簡素化されたデプロイメントに最適化されています。 - 一対多ヘッド:YOLO 生成し、NMS 必要とし、出力する

(N, nc + 4, 8400)場所:ncクラス数である。このヘッドは通常、追加の処理コストを払う代わりに、わずかに高い精度を達成する。

エクスポート、予測、または検証中にヘッドを切り替えることができます:

from ultralytics import YOLO

model = YOLO("yolo26n.pt")

# Use one-to-one head (default, no NMS required)

results = model.predict("image.jpg") # inference

metrics = model.val(data="coco.yaml") # validation

model.export(format="onnx") # export

# Use one-to-many head (requires NMS)

results = model.predict("image.jpg", end2end=False) # inference

metrics = model.val(data="coco.yaml", end2end=False) # validation

model.export(format="onnx", end2end=False) # export

# Use one-to-one head (default, no NMS required)

yolo predict model=yolo26n.pt source=image.jpg

yolo val model=yolo26n.pt data=coco.yaml

yolo export model=yolo26n.pt format=onnx

# Use one-to-many head (requires NMS)

yolo predict model=yolo26n.pt source=image.jpg end2end=False

yolo val model=yolo26n.pt data=coco.yaml end2end=False

yolo export model=yolo26n.pt format=onnx end2end=False

選択はデプロイ要件によって異なります:最高速度と簡便性を求める場合は1対1ヘッドを、精度を最優先とする場合は1対多ヘッドを使用してください。

YOLOE-26: オープンボキャブラリーインスタンスセグメンテーション

YOLOE-26は、高性能なYOLO26アーキテクチャとYOLOEシリーズのオープンボキャブラリー機能を統合しています。これにより、テキストプロンプト、ビジュアルプロンプト、またはゼロショット推論のためのプロンプトフリーモードを使用して、あらゆるオブジェクトクラスのリアルタイムdetectおよびsegmentを可能にし、固定カテゴリトレーニングの制約を効果的に取り除きます。

YOLO26のNMSフリーのエンドツーエンド設計を活用することで、YOLOE-26は高速なオープンワールド推論を実現します。これにより、関心のあるオブジェクトが広範かつ進化するボキャブラリーを表現する動的な環境におけるエッジアプリケーション向けの強力なソリューションとなります。

パフォーマンス

Objects365v1、GQA、およびFlickr30kデータセットでトレーニングされたこれらのモデルの使用例については、YOLOEドキュメントを参照してください。

| モデル | サイズ (ピクセル) | プロンプトタイプ | mAPminival 50-95(e2e) | mAPminival 50-95 | mAPr | mAPc | mAPf | params (M) | FLOPs (B) |

|---|---|---|---|---|---|---|---|---|---|

| YOLOE-26n-seg | 640 | テキスト/ビジュアル | 23.7 / 20.9 | 24.7 / 21.9 | 20.5 / 17.6 | 24.1 / 22.3 | 26.1 / 22.4 | 4.8 | 6.0 |

| YOLOE-26s-seg | 640 | テキスト/ビジュアル | 29.9 / 27.1 | 30.8 / 28.6 | 23.9 / 25.1 | 29.6 / 27.8 | 33.0 / 29.9 | 13.1 | 21.7 |

| YOLOE-26m-seg | 640 | テキスト/ビジュアル | 35.4 / 31.3 | 35.4 / 33.9 | 31.1 / 33.4 | 34.7 / 34.0 | 36.9 / 33.8 | 27.9 | 70.1 |

| YOLOE-26l-seg | 640 | テキスト/ビジュアル | 36.8 / 33.7 | 37.8 / 36.3 | 35.1 / 37.6 | 37.6 / 36.2 | 38.5 / 36.1 | 32.3 | 88.3 |

| YOLOE-26x-seg | 640 | テキスト/ビジュアル | 39.5 / 36.2 | 40.6 / 38.5 | 37.4 / 35.3 | 40.9 / 38.8 | 41.0 / 38.8 | 69.9 | 196.7 |

Objects365v1、GQA、およびFlickr30kデータセットでトレーニングされたこれらのモデルの使用例については、YOLOEドキュメントを参照してください。

| モデル | サイズ (ピクセル) | mAPminival 50-95(e2e) | mAPminival 50(e2e) | params (M) | FLOPs (B) |

|---|---|---|---|---|---|

| YOLOE-26n-seg-pf | 640 | 16.6 | 22.7 | 6.5 | 15.8 |

| YOLOE-26s-seg-pf | 640 | 21.4 | 28.6 | 16.2 | 35.5 |

| YOLOE-26m-seg-pf | 640 | 25.7 | 33.6 | 36.2 | 122.1 |

| YOLOE-26l-seg-pf | 640 | 27.2 | 35.4 | 40.6 | 140.4 |

| YOLOE-26x-seg-pf | 640 | 29.9 | 38.7 | 86.3 | 314.4 |

使用例

YOLOE-26は、テキストベースとビジュアルベースの両方のプロンプトをサポートしています。プロンプトの使用は簡単で、単にそれらを介して渡すだけです predict メソッドを以下に示します。

例

テキストプロンプトを使用すると、テキストによる記述を通じて検出したいクラスを指定できます。以下のコードは、YOLOE-26を使用して画像内の人物とバスをdetectする方法を示しています。

from ultralytics import YOLO

# Initialize model

model = YOLO("yoloe-26l-seg.pt") # or select yoloe-26s/m-seg.pt for different sizes

# Set text prompt to detect person and bus. You only need to do this once after you load the model.

model.set_classes(["person", "bus"])

# Run detection on the given image

results = model.predict("path/to/image.jpg")

# Show results

results[0].show()

ビジュアルプロンプトを使用すると、テキストで記述する代わりに、ターゲットクラスのビジュアルな例を示すことでモデルをガイドできます。

import numpy as np

from ultralytics import YOLO

from ultralytics.models.yolo.yoloe import YOLOEVPSegPredictor

# Initialize model

model = YOLO("yoloe-26l-seg.pt")

# Define visual prompts using bounding boxes and their corresponding class IDs.

# Each box highlights an example of the object you want the model to detect.

visual_prompts = dict(

bboxes=np.array(

[

[221.52, 405.8, 344.98, 857.54], # Box enclosing person

[120, 425, 160, 445], # Box enclosing glasses

],

),

cls=np.array(

[

0, # ID to be assigned for person

1, # ID to be assigned for glasses

]

),

)

# Run inference on an image, using the provided visual prompts as guidance

results = model.predict(

"ultralytics/assets/bus.jpg",

visual_prompts=visual_prompts,

predictor=YOLOEVPSegPredictor,

)

# Show results

results[0].show()

YOLOE-26には、組み込みの語彙を持つプロンプトフリーのバリアントが含まれています。これらのモデルはプロンプトを必要とせず、従来のYOLOモデルのように機能します。ユーザーが提供するラベルや視覚的な例に依存する代わりに、4,585のクラスからなる事前定義されたリストからオブジェクトをdetectします。これは、Recognize Anything Model Plus (RAM++)が使用するタグセットに基づいています。

from ultralytics import YOLO

# Initialize model

model = YOLO("yoloe-26l-seg-pf.pt")

# Run prediction. No prompts required.

results = model.predict("path/to/image.jpg")

# Show results

results[0].show()

プロンプト技術、ゼロからのトレーニング、および完全な使用例について深く掘り下げるには、YOLOEドキュメンテーションをご覧ください。

引用と謝辞

Ultralytics YOLO26の公開

Ultralyticsは、モデルの急速な進化のため、YOLO26に関する正式な研究論文を公開していません。代わりに、最先端のモデルを提供し、使いやすくすることに重点を置いています。YOLOの機能、アーキテクチャ、および使用方法に関する最新のアップデートについては、GitHubリポジトリおよびドキュメントをご覧ください。

YOLO26またはその他のUltralyticsソフトウェアをあなたの研究で使用する場合は、次のように引用してください。

@software{yolo26_ultralytics,

author = {Glenn Jocher and Jing Qiu},

title = {Ultralytics YOLO26},

version = {26.0.0},

year = {2026},

url = {https://github.com/ultralytics/ultralytics},

orcid = {0000-0001-5950-6979, 0000-0003-3783-7069},

license = {AGPL-3.0}

}

DOIは保留中です。YOLO26は、AGPL-3.0およびEnterpriseライセンスの下で利用可能です。

よくある質問

YOLO11と比較して、YOLO26の主な改善点は何ですか?

- DFL削除:エクスポートを簡素化し、エッジ互換性を拡張します

- エンドツーエンドのNMSフリー推論: NMSを排除し、より高速でシンプルなデプロイメントを実現

- ProgLoss + STAL:特に小さなオブジェクトの精度を向上

- MuSGDオプティマイザ: SGDとMuon(MoonshotのKimi K2に触発)を組み合わせ、より安定した効率的なトレーニングを実現

- 最大43%高速なCPU推論:CPUのみのデバイスのパフォーマンスが大幅に向上

YOLO26はどのようなタスクをサポートしていますか?

YOLO26は統一されたモデルファミリーであり、複数のコンピュータービジョンタスクに対してエンドツーエンドのサポートを提供します。

各サイズバリアント(n、s、m、l、x)はすべてのタスクをサポートし、さらにYOLOE-26を介したオープンボキャブラリーバージョンもサポートします。

YOLO26がエッジ展開に最適化されているのはなぜですか?

YOLO26は、以下により最先端のエッジパフォーマンスを提供します。

- 最大43%高速なCPU推論

- モデルサイズとメモリフットプリントの削減

- 互換性のためにアーキテクチャを簡素化(DFLなし、NMSなし)

- TensorRT、ONNX、CoreML、TFLite、OpenVINOを含む柔軟なエクスポート形式

YOLO26を始めるにはどうすればよいですか?

YOLO26モデルは2026年1月14日にリリースされ、ダウンロード可能です。をインストールまたは更新してください ultralytics パッケージをインストールし、モデルをロードします。

from ultralytics import YOLO

# Load a pretrained YOLO26 nano model

model = YOLO("yolo26n.pt")

# Run inference on an image

results = model("image.jpg")

トレーニング、検証、およびエクスポートの手順については、使用例セクションを参照してください。