클라우드 트레이닝

Ultralytics Platform 클라우드 학습은 클라우드 GPU에서 원클릭 학습을 제공하여 복잡한 설정 없이 모델 학습에 접근 가능하게 합니다. 실시간 메트릭 스트리밍 및 자동 체크포인트 저장 기능을 통해 YOLO 모델을 학습시키세요.

graph LR

A[Configure] --> B[Start Training]

B --> C[Provision GPU]

C --> D[Download Dataset]

D --> E[Train]

E --> F[Stream Metrics]

F --> G[Save Checkpoints]

G --> H[Complete]

style A fill:#2196F3,color:#fff

style B fill:#FF9800,color:#fff

style E fill:#9C27B0,color:#fff

style H fill:#4CAF50,color:#fff훈련 대화

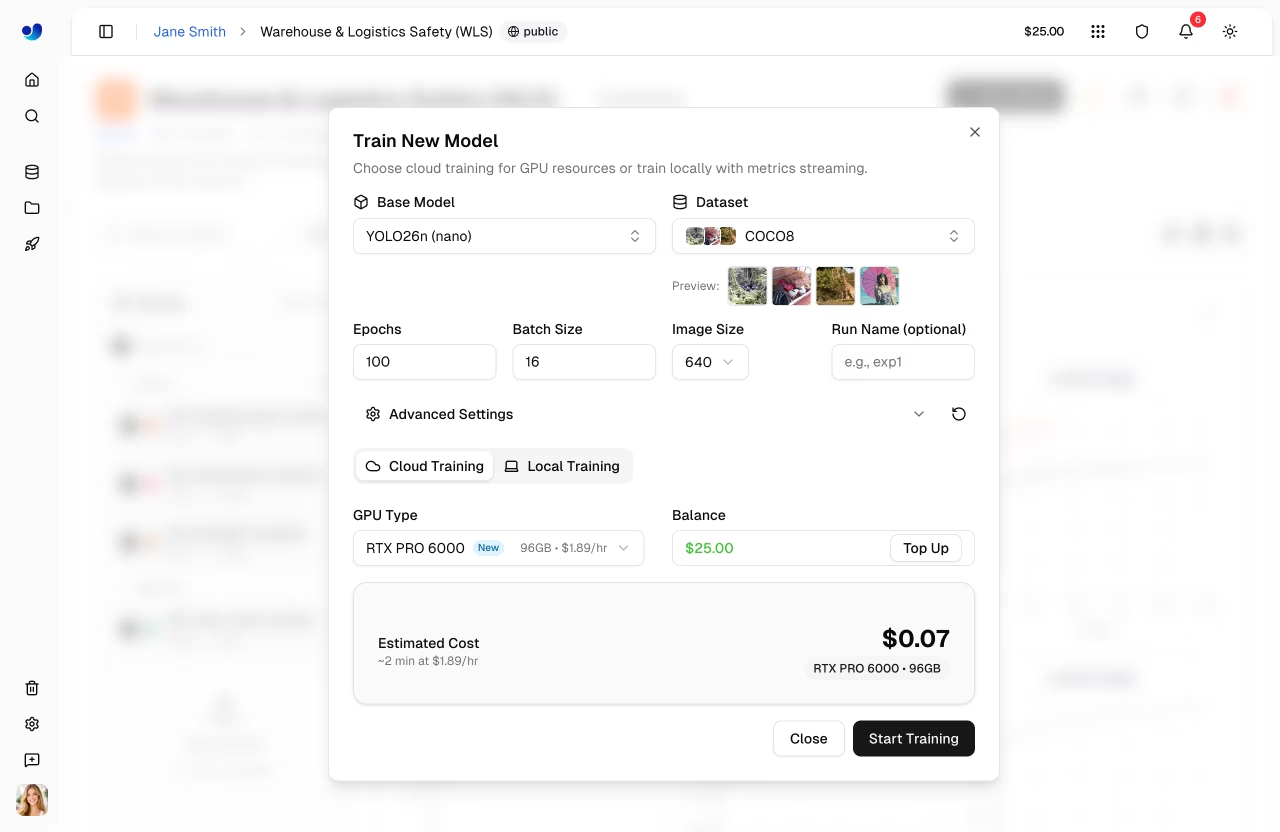

플랫폼 UI에서 훈련을 시작하려면 프로젝트 페이지(또는 데이터셋 페이지에서 훈련 )에서 새 모델을 클릭하세요. 훈련 대화 상자에는 클라우드 훈련과 로컬 훈련이라는 두 개의 탭이 있습니다.

1단계: 기본 모델 선택

공식 YOLO26 모델 또는 직접 훈련한 모델 중에서 선택하세요:

| 범주 | 설명 |

|---|---|

| 공식 | 모든 25개의 YOLO26 모델 (5가지 크기 × 5가지 작업) |

| 귀하의 모델들 | 미세 조정을 위한 완성된 모델들 |

공식 모델은 작업 유형(검출, 분할, 포즈, OBB, 분류)별로 구성되며, 크기는 nano부터 xlarge까지 다양합니다.

2단계: 데이터셋 선택

훈련할 데이터셋을 선택하세요 ( 데이터셋 참조):

| 옵션 | 설명 |

|---|---|

| 공식 | Ultralytics의 선별된 데이터셋 |

| 내 데이터셋 | 업로드한 데이터셋 |

데이터셋 요구사항

데이터셋은 다음 형식이어야 합니다. ready 훈련 분할에 최소 1장의 이미지, 검증 또는 테스트 분할에 1장의 이미지, 그리고 최소 1장의 라벨링된 이미지를 포함하는 상태.

작업 불일치

모델 작업(예: detect)이 데이터셋 작업(예: segment)과 일치하지 않을 경우 작업 불일치 경고가 표시됩니다. 작업이 불일치하는 상태로 진행하면 훈련이 실패합니다. 작업 가이드에 설명된 대로 모델과 데이터셋 모두 동일한 작업 유형을 사용하도록 하십시오.

3단계: 매개변수 구성

핵심 훈련 매개변수 설정:

| 파라미터 | 설명 | 기본값 |

|---|---|---|

| 에포크 | 학습 반복 횟수 | 100 |

| 배치 크기 | 반복당 샘플 수 | 16 |

| 이미지 크기 | 입력 해상도 (320/416/512/640/1280 드롭다운, 또는 YAML 편집기에서 32-4096) | 640 |

| 실행 이름 | 훈련 실행에 대한 선택적 이름 | 자동 |

단계 4: 고급 설정 (선택 사항)

고급 설정을 확장하여 그룹별로 분류된 40개 이상의 훈련 매개변수를 포함한 전체 YAML 기반 매개변수 편집기에 접근하세요( 구성 참조 참조):

| 그룹 | 파라미터 |

|---|---|

| 학습률 | lr0, lrf, 모멘텀, 가중치 감쇠, 워밍업 에포크, 워밍업 모멘텀, 워밍업 바이어스 학습률 |

| 최적화기 | SGD, MuSGD, Adam, AdamW, NAdam, RAdam, RMSProp, Adamax |

| 손실 중량 | 박스, 클래스, dfl, 포즈, 코브지, 라벨 스무딩 |

| 색상 증강 | hsv_h, hsv_s, hsv_v |

| 기하학적 증강. | 각도, 변환, 크기 조정, 전단, 투시도 |

| 플립 & 믹스 증강. | 뒤집기, 뒤집기, 모자이크, 뒤섞기, 복사_붙여넣기 |

| 훈련 통제 | 인내, 씨앗, 결정론적, 앰프, cos_lr, close_mosaic, save_period |

| 데이터세트 | 분수, 동결, 단일_클래스, 사각형, 다중_스케일, 재개 |

매개변수는 작업 인식형입니다(예: copy_paste segment 대해서만 표시됩니다. pose/kobj (포즈 작업 전용). A 수정됨 값이 기본값과 다를 때 배지가 표시되며, 리셋 버튼으로 모든 값을 기본값으로 되돌릴 수 있습니다.

예시: 소규모 데이터셋을 위한 튜닝 증강

For small datasets (<1000 images), increase augmentation to reduce overfitting:

mosaic: 1.0 # Keep mosaic on

mixup: 0.3 # Add mixup blending

copy_paste: 0.3 # Add copy-paste (segment only)

fliplr: 0.5 # Horizontal flip

degrees: 10.0 # Slight rotation

scale: 0.9 # Aggressive scaling

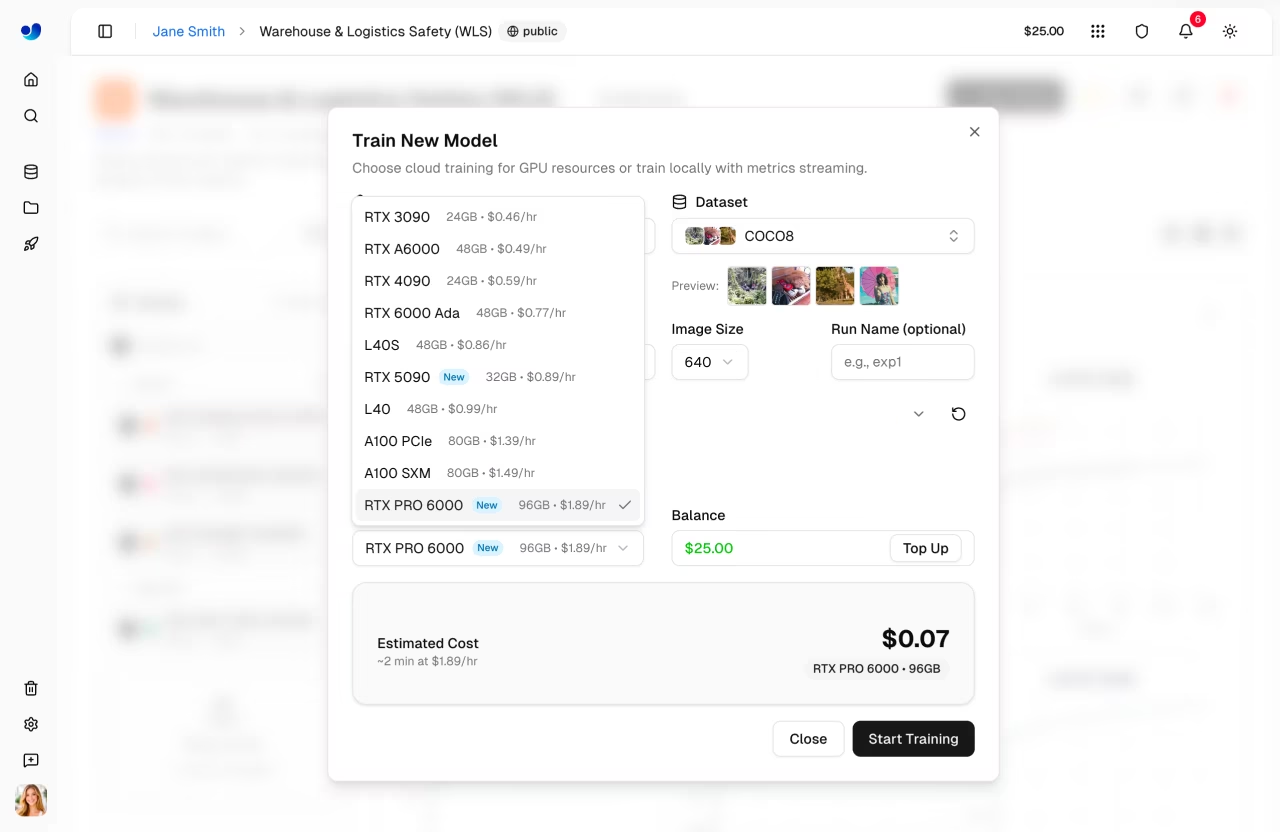

5단계: GPU 선택 GPU 클라우드 탭)

Ultralytics GPU 를 선택하세요:

| GPU | VRAM | 시간당 비용 |

|---|---|---|

| RTX 2000 Ada | 16 GB | $0.24 |

| RTX A4500 | 20 GB | $0.24 |

| RTX A5000 | 24 GB | $0.26 |

| RTX 4000 Ada | 20 GB | $0.38 |

| L4 | 24 GB | $0.39 |

| A40 | 48 GB | $0.40 |

| RTX 3090 | 24 GB | $0.46 |

| RTX A6000 | 48 GB | $0.49 |

| RTX 4090 | 24 GB | $0.59 |

| RTX 6000 Ada | 48 GB | $0.77 |

| L40S | 48 GB | $0.86 |

| RTX 5090 | 32 GB | $0.89 |

| L40 | 48 GB | $0.99 |

| A100 PCIe | 80 GB | $1.39 |

| A100 SXM | 80 GB | $1.49 |

| RTX PRO 6000 | 96 GB | $1.89 |

| H100 PCIe | 80 GB | $2.39 |

| H100 SXM | 80 GB | $2.69 |

| H100 NVL | 94 GB | $3.07 |

| H200 NVL | 143 GB | $3.39 |

| H200 SXM | 141 GB | $3.59 |

| B200 | 180 GB | $4.99 |

GPU 선택

- RTX PRO 6000: 96GB 블랙웰 세대, 대부분의 작업에 권장되는 기본 설정

- A100 SXM: 대량 배치 작업이나 대형 모델에 필수적입니다.

- H100/H200: 시간에 민감한 훈련을 위한 최대 성능

- B200: 최첨단 워크로드를 위한 NVIDIA 아키텍처

대화 상자에는 현재 잔액 과 충전 버튼이 표시됩니다. 예상 비용과 소요 시간은 설정된 구성(모델 크기, 데이터셋 이미지 수, 에포크 수, GPU )을 기반으로 계산됩니다.

6단계: 훈련 시작

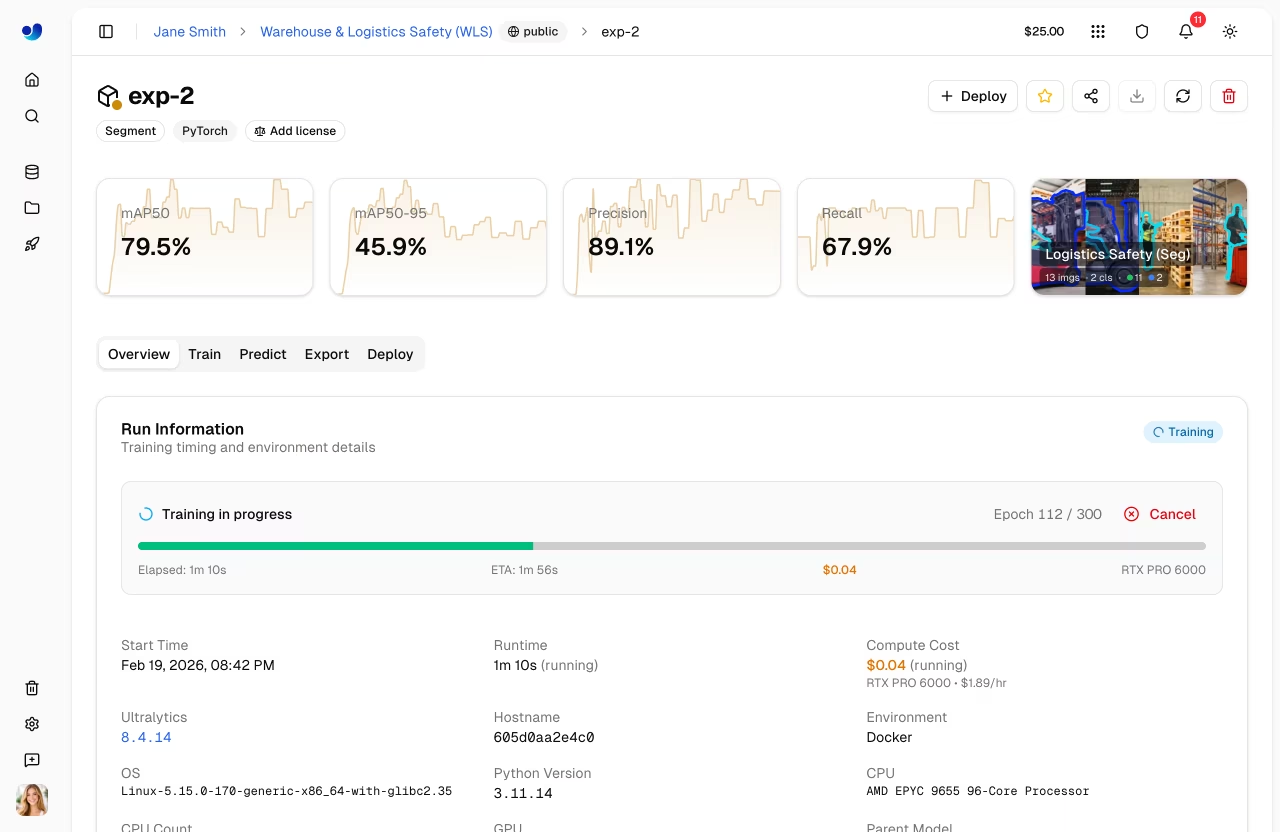

훈련 시작을 클릭하여 작업을 시작하세요. 플랫폼은 다음과 같습니다:

- GPU 인스턴스를 프로비저닝합니다.

- 데이터셋을 다운로드합니다.

- 훈련을 시작합니다.

- 메트릭을 실시간으로 스트리밍합니다.

교육 직무 수명 주기

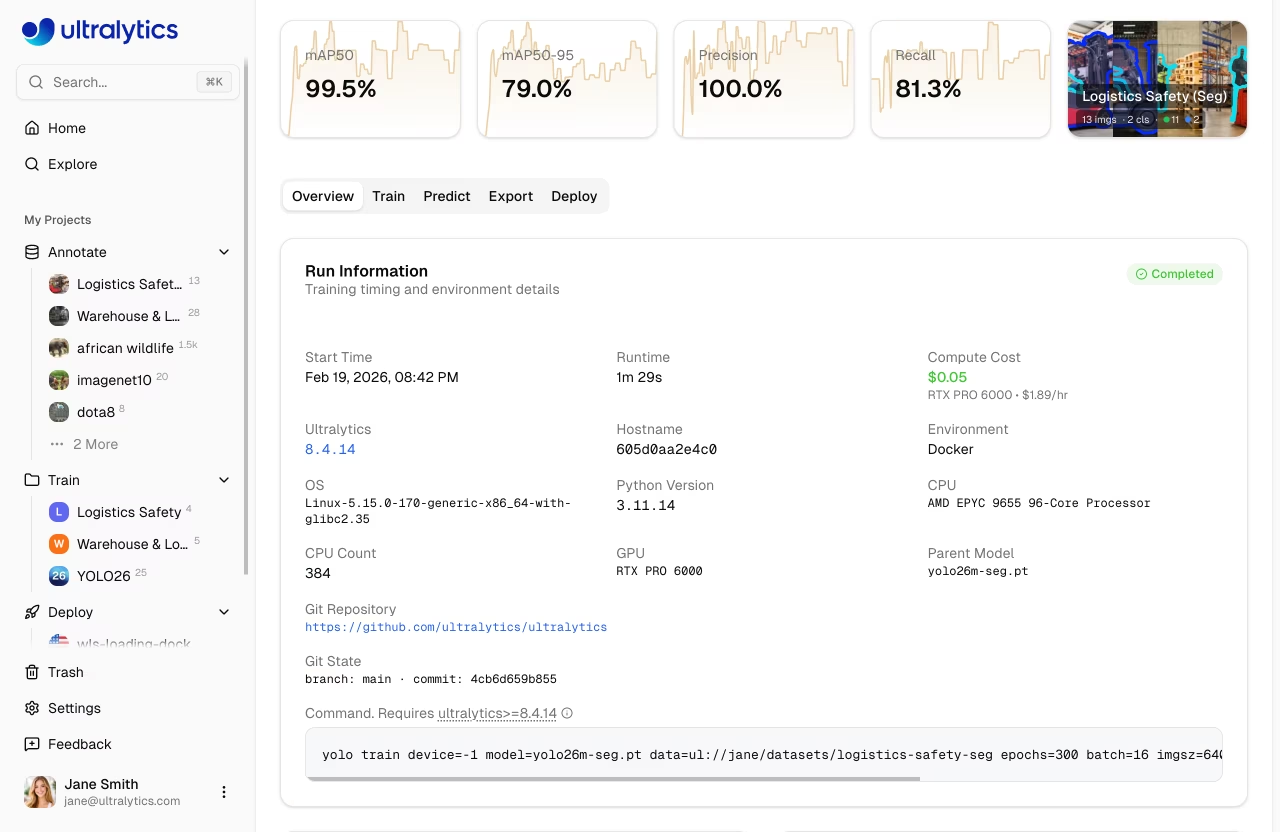

훈련 작업은 다음 상태를 거쳐 진행됩니다:

| 상태 | 설명 |

|---|---|

| 보류 중 | 작업 제출됨, GPU 대기 중 |

| 시작 | GPU , 데이터셋 및 모델 다운로드 중 |

| 달리기 | 훈련 진행 중, 지표 실시간 스트리밍 |

| 완료됨 | 훈련이 성공적으로 완료되었습니다. |

| 실패함 | 훈련 실패 (자세한 내용은 콘솔 로그 참조) |

| 취소됨 | 사용자에 의해 훈련이 취소되었습니다. |

무료 크레딧

신규 계정 가입 시 가입 크레딧을 제공합니다 — 개인 이메일은 $5, 회사 이메일은 $25입니다. 설정 > 결제에서 잔액을 확인하세요.

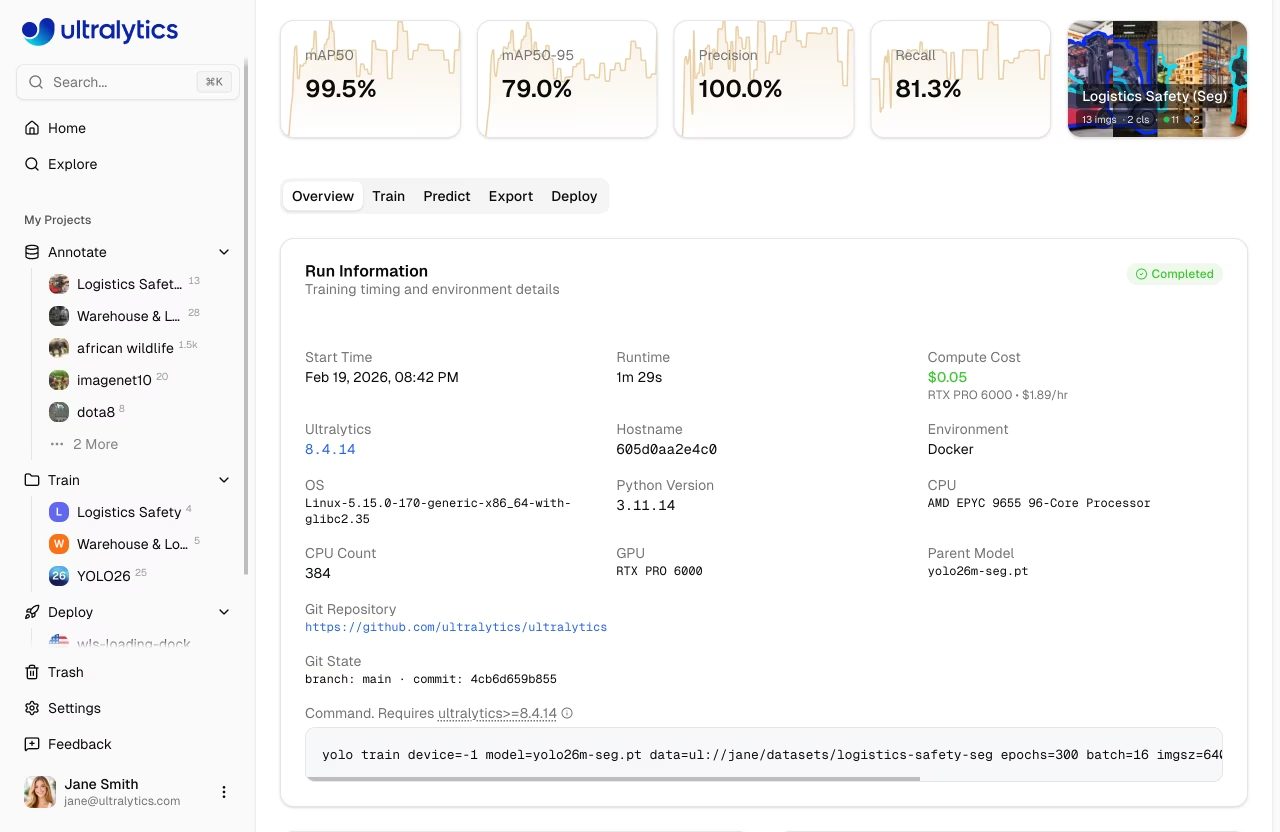

훈련 모니터링

모델 페이지의 '훈련' 탭에서 실시간 훈련 진행 상황을 확인하세요:

차트 하위 탭

| 지표 | 설명 |

|---|---|

| 손실 | 훈련 및 검증 손실 |

| mAP | 평균 정밀도 |

| 정밀도 | 정확한 양성 예측 |

| 재현율 | detect된 실제 값 |

콘솔 하위 탭

ANSI 색상 지원, 진행률 표시줄 및 오류 감지 기능을 갖춘 실시간 콘솔 출력.

시스템 하위 탭

실시간 GPU , 메모리, 온도, CPU 및 디스크 사용량.

체크포인트

체크포인트는 자동으로 저장됩니다:

- 모든 에포크: 최신 가중치 저장

- 최고 모델: 가장 높은 mAP 체크포인트 보존

- 최종 모델: 훈련 완료 시점의 가중치

학습 취소

모델 페이지에서 '훈련 취소'를 클릭하여 실행 중인 작업을 중지하십시오:

- 컴퓨팅 인스턴스가 종료되었습니다.

- 크레딧 청구가 중단됩니다

- 그 시점까지 저장된 체크포인트는 보존됩니다

원격 훈련

graph LR

A[Local GPU] --> B[Train]

B --> C[ultralytics Package]

C --> D[Stream Metrics]

D --> E[Platform Dashboard]

style A fill:#FF9800,color:#fff

style C fill:#2196F3,color:#fff

style E fill:#4CAF50,color:#fff자체 하드웨어에서 훈련하면서 플랫폼으로 메트릭을 스트리밍하세요.

패키지 버전 요구 사항

플랫폼 통합에는 ultralytics>= 8.4.14 버전이 필요합니다. 하위 버전은 플랫폼과 호환되지 않습니다.

pip install -U ultralytics

API 키 설정

- 가다

Settings > Profile(API 키 섹션) - 새 키 생성(또는 로컬 훈련 탭을 열면 플랫폼이 자동으로 생성함)

- 환경 변수 설정:

export ULTRALYTICS_API_KEY="your_api_key"

스트리밍으로 학습

다음을 사용하여 project 및 name 메트릭 스트리밍 매개변수:

yolo train model=yolo26n.pt data=coco.yaml epochs=100 \

project=username/my-project name=experiment-1

from ultralytics import YOLO

model = YOLO("yolo26n.pt")

model.train(

data="coco.yaml",

epochs=100,

project="username/my-project",

name="experiment-1",

)

훈련 대화 상자의 '로컬 훈련' 탭에는 API 키, 선택된 매개변수 및 고급 인수가 포함된 사전 구성된 명령이 표시됩니다.

플랫폼 데이터셋 사용

플랫폼에 저장된 데이터셋을 사용하여 ul:// URI 형식:

yolo train model=yolo26n.pt data=ul://username/datasets/my-dataset epochs=100 \

project=username/my-project name=exp1

from ultralytics import YOLO

model = YOLO("yolo26n.pt")

model.train(

data="ul://username/datasets/my-dataset",

epochs=100,

project="username/my-project",

name="exp1",

)

에 지정되어 있습니다. ul:// URI 형식은 데이터셋을 자동으로 다운로드하고 구성합니다. 모델은 플랫폼에서 데이터셋에 자동으로 연결됩니다(자세한 내용은 참조). 플랫폼 데이터셋 사용)입니다.

결제

훈련 비용은 GPU 사용량에 따라 달라집니다:

비용 추정

훈련 시작 전에 플랫폼은 다음을 통해 총 비용을 추정합니다:

- 데이터셋 크기, 모델 복잡도, 이미지 크기, 배치 크기 및 GPU 기반으로 에포크당 소요 시간(초) 추정

- 에포크당 초 수에 에포크 수를 곱한 후 시작 오버헤드를 더하여 총 훈련 시간을 계산합니다.

- 총 훈련 시간에 GPU 시간당 요금을 곱하여 예상 비용을 계산합니다.

비용에 영향을 미치는 요소:

| 요인 | 영향 |

|---|---|

| 데이터셋 크기 | 이미지 수가 많을수록 훈련 시간이 길어짐 (기준: RTX 4090에서 이미지 1000장당 약 2.8초 소요) |

| 모델 크기 | 더 큰 모델(m, l, x)은 (n, s)보다 느리게 학습합니다. |

| 에포크 수 | 훈련 시간에 대한 직접적인 배율 |

| 이미지 크기 | 이미지 크기가 클수록 계산량이 증가합니다: 320px=0.25배, 640px=1.0배(기준값), 1280px=4.0배 |

| 배치 크기 | 더 큰 배치 처리량이 더 효율적입니다(배치 32 = 약 0.85배 시간, 배치 8 = 약 1.2배 시간, 기준 배치 16 대비). |

| GPU | 더 빠른 GPU는 훈련 시간을 단축합니다(예: H100 SXM = RTX 4090 대비 약 3.4배 빠른 속도) |

| 스타트업 간접비 | 예를 들어 초기화, 데이터 다운로드 및 예열에 최대 5분 소요 (데이터셋 크기에 따라 달라짐) |

비용 예시

추정

비용 추정은 대략적인 수치이며 여러 요인에 따라 달라집니다. 훈련 대화 상자는 훈련을 시작하기 전에 실시간으로 추정치를 표시합니다.

| 시나리오 | GPU | 예상 비용 |

|---|---|---|

| 500개의 이미지, YOLO26n, 50 에포크 | RTX 4090 | ~$0.50 |

| 1000개의 이미지, YOLO26n, 100 에포크 | RTX PRO 6000 | ~$5 |

| 5000개의 이미지, YOLO26s, 100 에포크 | H100 SXM | ~23달러 |

청구 흐름

graph LR

A[Estimate Cost] --> B[Balance Check]

B --> C[Train]

C --> D[Charge Actual Runtime]

style A fill:#2196F3,color:#fff

style B fill:#FF9800,color:#fff

style C fill:#9C27B0,color:#fff

style D fill:#4CAF50,color:#fff클라우드 교육 청구 절차:

- 추정: 교육 시작 전 계산된 비용

- 잔액 확인: 실행 전에 사용 가능한 크레딧을 확인합니다

- 트레인: 작업이 선택된 컴퓨팅 리소스에서 실행됩니다

- 요금: 최종 비용은 실제 사용 시간에 따라 결정됩니다

소비자 보호

청구는 취소된 부분 실행을 포함하여 실제 컴퓨팅 사용량을 추적합니다.

결제 방법

| 메서드 | 설명 |

|---|---|

| 계정 잔액 | 선불 크레딧 |

| 작업별 결제 | 작업 완료 시 청구 |

최소 잔액

훈련 시작에는 양의 잔액과 예상 작업 비용에 충분한 크레딧이 필요합니다.

학습 비용 보기

학습 후 청구 탭에서 상세 비용을 확인할 수 있습니다:

- 에포크별 비용 분석

- 총 GPU 사용 시간

- 비용 보고서 다운로드

학습 팁

올바른 모델 크기 선택

| 모델 | 파라미터 | 최적 용도 |

|---|---|---|

| YOLO26n | 2.4M | 실시간, 엣지 디바이스 |

| YOLO26s | 9.5M | 균형 잡힌 속도/정확도 |

| YOLO26m | 20.4M | 더 높은 정확도 |

| YOLO26l | 24.8M | 운영 환경 정확도 |

| YOLO26x | 55.7M | 최대 정확도 |

학습 시간 최적화

비용 절감 전략

- 작게 시작하세요: 예산 GPU 10~20 에포크로 테스트하여 데이터셋과 구성 설정이 제대로 작동하는지 GPU

- 적절한 GPU 사용: RTX PRO 6000은 대부분의 작업 부하를 잘 처리합니다

- 데이터셋 검증: 훈련에 투자하기 전에 라벨링 문제를 수정하십시오

- 조기 모니터링: 손실이 정체되면 훈련을 중단하세요 — 사용한 컴퓨팅 시간에 대해서만 비용을 지불합니다

문제 해결

| 이슈 | 솔루션 |

|---|---|

| 학습이 0%에서 멈춤 | 데이터셋 형식을 확인하고 다시 시도하십시오 |

| 메모리 부족 | 배치 크기를 줄이거나 더 큰 GPU 사용 |

| 낮은 정확도 | 에포크를 늘리고 데이터 품질 확인 |

| 학습 속도 저하 | 더 빠른 GPU 고려 |

| 작업 불일치 오류 | 모델과 데이터셋 작업이 일치하도록 하십시오 |

FAQ

학습은 얼마나 걸리나요?

학습 시간은 다음 요소에 따라 달라집니다:

- 데이터셋 크기

- 모델 크기

- 에포크 수

- 선택된 GPU

일반적인 시간 (이미지 1000개, 100 에포크):

| 모델 | RTX PRO 6000 | A100 |

|---|---|---|

| YOLO26n | 20 최소값 | 20 최소값 |

| YOLO26m | 40 최소값 | 40 최소값 |

| YOLO26x | 80 최소값 | 80 최소값 |

밤새 학습할 수 있나요?

예, 훈련은 완료될 때까지 계속됩니다. 훈련이 완료되면 알림을 받게 됩니다. 에포크 기반 훈련을 위해 계정에 충분한 잔액이 있는지 확인하세요.

크레딧이 부족하면 어떻게 되나요?

훈련은 현재 에포크가 끝날 때 일시 중지됩니다. 체크포인트가 저장되며, 크레딧을 추가한 후 다시 시작할 수 있습니다.

사용자 지정 학습 인수를 사용할 수 있나요?

예, 훈련 대화 상자의 고급 설정 섹션을 확장하면 40개 이상의 구성 가능한 매개변수를 지원하는 YAML 편집기에 접근할 수 있습니다. 비기본값은 클라우드 및 로컬 훈련 명령어 모두에 포함됩니다.

데이터셋 페이지에서 훈련할 수 있나요?

예, 데이터셋 페이지의 '훈련' 버튼을 누르면 데이터셋이 미리 선택되고 잠긴 상태로 훈련 대화 상자가 열립니다. 이후 프로젝트와 모델을 선택하여 훈련을 시작할 수 있습니다.

학습 파라미터 참조

| 파라미터 | 유형 | 기본값 | 범위 | 설명 |

|---|---|---|---|---|

epochs | 정수 | 100 | 1-10000 | 학습 에포크 수 |

batch | 정수 | 16 | 1-512 | 배치 크기 |

imgsz | 정수 | 640 | 32-4096 | 입력 이미지 크기 |

patience | 정수 | 100 | 1-1000 | 조기 종료 인내 값 |

seed | 정수 | 0 | 0-2147483647 | 재현성을 위한 난수 시드 |

deterministic | bool | 진실 | - | 결정론적 훈련 모드 |

amp | bool | 진실 | - | 자동 혼합 정밀도 |

close_mosaic | 정수 | 10 | 0-50 | 최종 N 에포크에서 모자이크 비활성화 |

save_period | 정수 | -1 | -1-100 | N 에포크마다 체크포인트 저장 |

workers | 정수 | 8 | 0-64 | 데이터 로더 워커 수 |

cache | 선택 | 거짓 | 램/디스크/거짓 | 캐시 이미지 |

| 파라미터 | 유형 | 기본값 | 범위 | 설명 |

|---|---|---|---|---|

lr0 | 부동 소수점 | 0.01 | 0.0001-0.1 | 초기 학습률 |

lrf | 부동 소수점 | 0.01 | 0.01-1.0 | 최종 LR 계수 |

momentum | 부동 소수점 | 0.937 | 0.6-0.98 | SGD 모멘텀 |

weight_decay | 부동 소수점 | 0.0005 | 0.0-0.001 | L2 정규화 |

warmup_epochs | 부동 소수점 | 3.0 | 0-5 | Warmup epochs |

warmup_momentum | 부동 소수점 | 0.8 | 0.5-0.95 | 워밍업 모멘텀 |

warmup_bias_lr | 부동 소수점 | 0.1 | 0.0-0.2 | 워밍업 편향 LR |

cos_lr | bool | False | - | 코사인 LR 스케줄러 |

| 파라미터 | 유형 | 기본값 | 범위 | 설명 |

|---|---|---|---|---|

hsv_h | 부동 소수점 | 0.015 | 0.0-0.1 | HSV 색조 증강 |

hsv_s | 부동 소수점 | 0.7 | 0.0-1.0 | HSV 채도 |

hsv_v | 부동 소수점 | 0.4 | 0.0-1.0 | HSV 값 |

degrees | 부동 소수점 | 0.0 | -45-45 | 회전 각도 |

translate | 부동 소수점 | 0.1 | 0.0-1.0 | 변환 비율 |

scale | 부동 소수점 | 0.5 | 0.0-1.0 | 스케일 계수 |

shear | 부동 소수점 | 0.0 | -10-10 | 전단 각도 |

perspective | 부동 소수점 | 0.0 | 0.0-0.001 | 시점 변환 |

fliplr | 부동 소수점 | 0.5 | 0.0-1.0 | 수평 뒤집기 확률 |

flipud | 부동 소수점 | 0.0 | 0.0-1.0 | 수직 뒤집기 확률 |

mosaic | 부동 소수점 | 1.0 | 0.0-1.0 | 모자이크 증강 |

mixup | 부동 소수점 | 0.0 | 0.0-1.0 | MixUp 증강 |

copy_paste | 부동 소수점 | 0.0 | 0.0-1.0 | 복사-붙여넣기 (segment) |

| 파라미터 | 유형 | 기본값 | 범위 | 설명 |

|---|---|---|---|---|

fraction | 부동 소수점 | 1.0 | 0.1-1.0 | 사용할 데이터 세트의 비율 |

freeze | 정수 | null | 0-100 | 동결할 레이어 수 |

single_cls | bool | False | - | 모든 클래스를 하나의 클래스로 취급하십시오 |

rect | bool | False | - | 직사각형 훈련 |

multi_scale | 부동 소수점 | 0.0 | 0.0-1.0 | 다중 규모 훈련 범위 |

val | bool | 진실 | - | 훈련 중 검증 실행 |

resume | bool | False | - | 체크포인트에서 훈련 재개 |

| 값 | 설명 |

|---|---|

auto | 자동 선택 (기본값) |

SGD | 확률적 경사 하강법 |

MuSGD | 뮤온 SGD |

Adam | Adam 옵티마이저 |

AdamW | 가중치 감소를 사용한 Adam |

NAdam | 나담 최적화기 |

RAdam | RAdam 최적화기 |

RMSProp | RMSProp 최적화기 |

Adamax | 아다맥스 최적화기 |

| 파라미터 | 유형 | 기본값 | 범위 | 설명 |

|---|---|---|---|---|

box | 부동 소수점 | 7.5 | 1-50 | Box 손실 가중치 |

cls | 부동 소수점 | 0.5 | 0.2-4 | 분류 손실 무게 |

dfl | 부동 소수점 | 1.5 | 0.4-6 | 분포 초점 손실 |

pose | 부동 소수점 | 12.0 | 1-50 | 포즈로 체중 감량 (포즈만) |

kobj | 부동 소수점 | 1.0 | 0.5-10 | 키포인트 객체성(자세) |

label_smoothing | 부동 소수점 | 0.0 | 0.0-0.1 | 라벨 평활화 계수 |

작업별 매개변수

일부 매개변수는 특정 작업에만 적용됩니다:

- 탐지 작업만 (detect, segment, 자세 추정, OBB — classify 아님):

box,dfl,degrees,translate,shear,perspective,mosaic,mixup,close_mosaic - 세그먼트만:

copy_paste - 포즈만:

pose(손실 가중치),kobj(키포인트 객체성)