Ultralytics YOLO26

개요

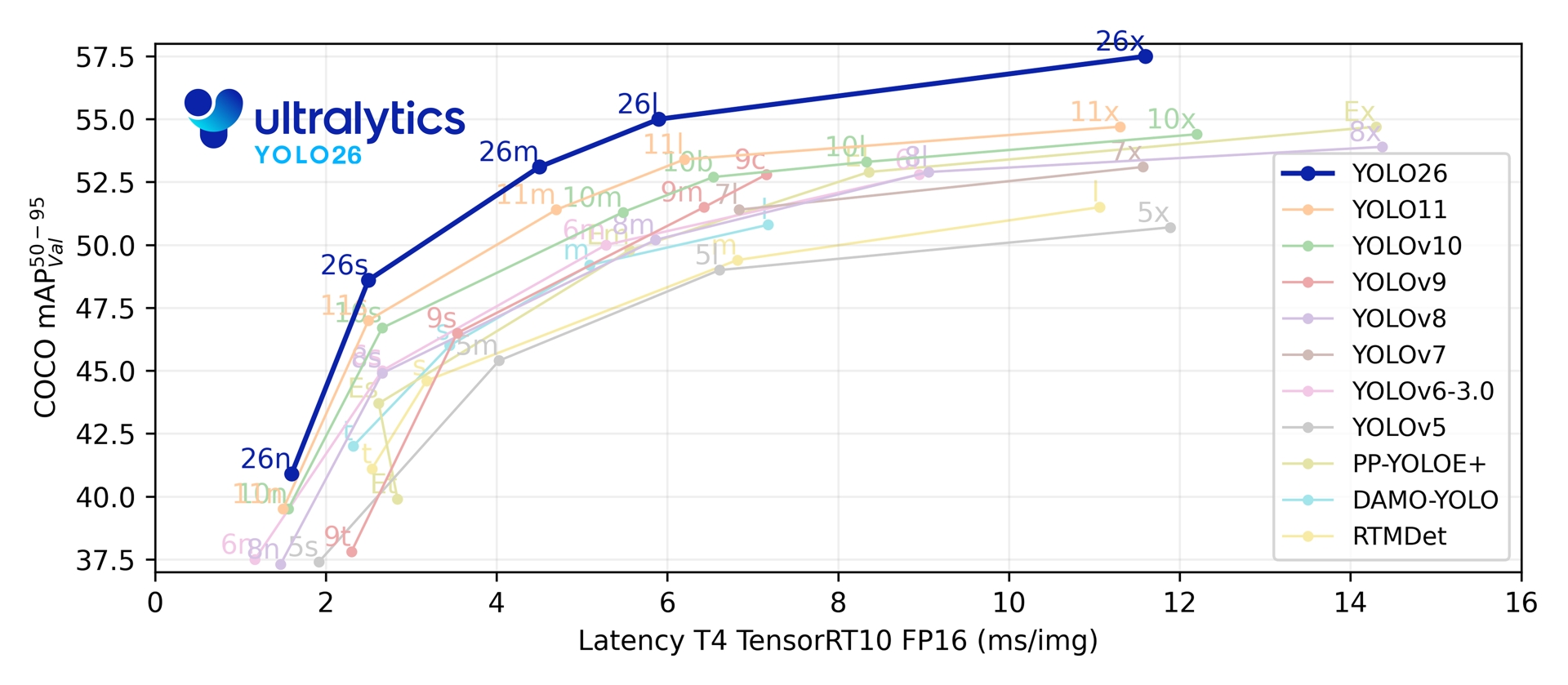

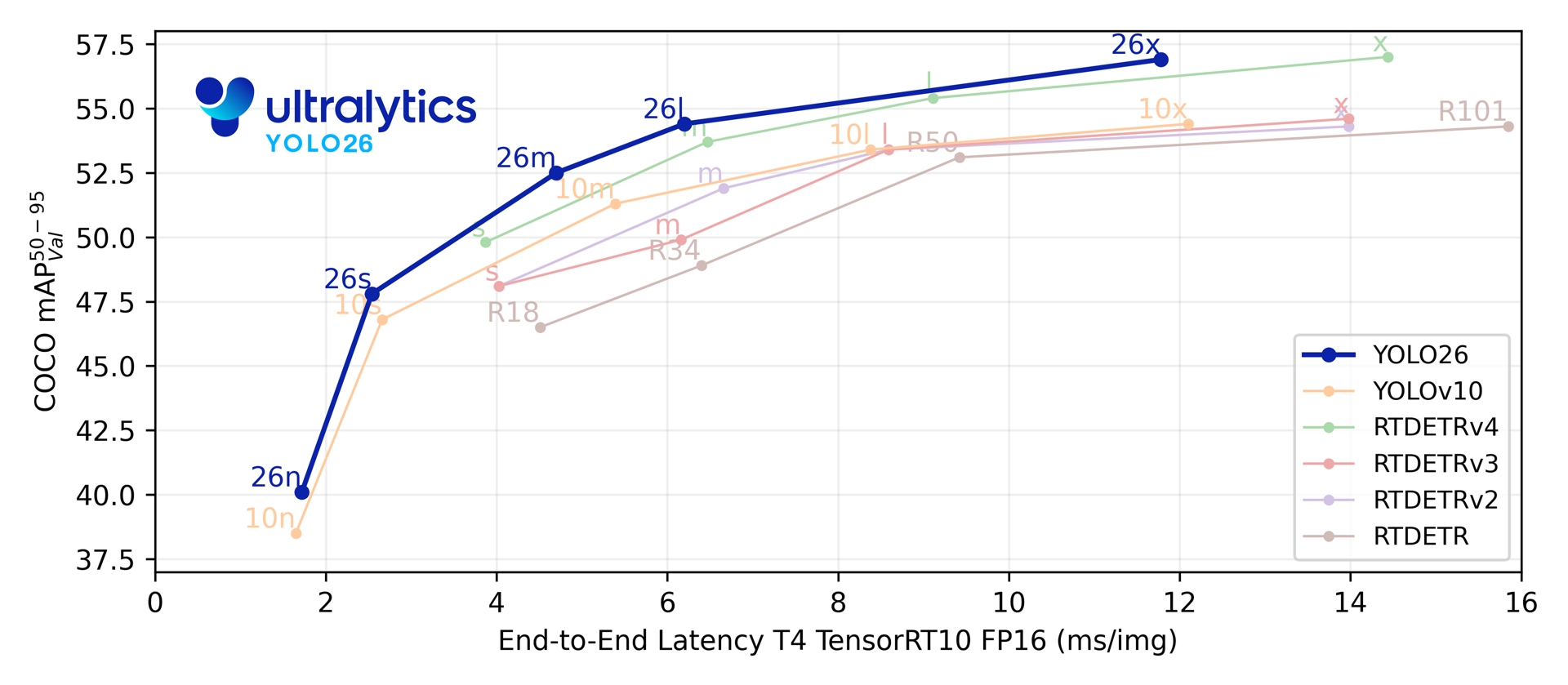

Ultralytics YOLO26은 실시간 객체 감지기인 YOLO 시리즈의 최신 진화 버전으로, 엣지 및 저전력 장치를 위해 처음부터 엔지니어링되었습니다. 불필요한 복잡성을 제거하고 대상 혁신을 통합하여 더 빠르고 가벼우며 접근성이 뛰어난 배포를 제공하는 간소화된 디자인을 도입했습니다.

Ultralytics 체험해 보세요

Ultralytics 플랫폼에서 YOLO26 모델을 직접 탐색하고 실행하세요.

YOLO26의 아키텍처는 세 가지 핵심 원칙에 따라 설계되었습니다.

- 단순성: YOLO26은 NMS(non-maximum suppression) 없이 직접 예측을 생성하는 네이티브 종단 간 모델입니다. 이 후처리 단계를 제거함으로써 추론이 더 빠르고 가벼워지며 실제 시스템에 배포하기가 더 쉬워집니다. 이 획기적인 접근 방식은 칭화대학교의 Ao Wang이 YOLOv10에서 처음 개척했으며, YOLO26에서 더욱 발전되었습니다.

- 배포 효율성: 엔드 투 엔드 설계는 파이프라인의 전체 단계를 줄여 통합을 획기적으로 단순화하고 대기 시간을 줄이며 다양한 환경에서 배포를 더욱 강력하게 만듭니다.

- 훈련 혁신: YOLO26은 MuSGD 옵티마이저를 도입합니다. 이는 Moonshot AI의 Kimi K2 LLM 훈련의 혁신에서 영감을 받은 SGD와 Muon의 하이브리드입니다. 이 옵티마이저는 향상된 안정성과 더 빠른 수렴을 제공하며, 언어 모델의 최적화 발전을 컴퓨터 비전으로 이전합니다.

- 작업별 최적화: YOLO26은 Segmentation을 위한 의미론적 분할 손실 및 다중 스케일 프로토 모듈, 고정밀 Pose 추정을 위한 잔차 로그-우도 추정(RLE), 그리고 OBB의 경계 문제를 해결하기 위한 각도 손실을 사용한 최적화된 디코딩을 포함하여 특수 작업에 대한 맞춤형 개선 사항을 도입합니다.

이러한 혁신은 소형 객체에서 더 높은 정확도를 달성하고 원활한 배포를 제공하며 CPU에서 최대 43% 더 빠르게 실행되는 모델 제품군을 제공하여 YOLO26을 리소스가 제한된 환경에서 가장 실용적이고 배포 가능한 YOLO 모델 중 하나로 만듭니다.

주요 기능

DFL 제거

분포 초점 손실(DFL) 모듈은 효과적이기는 하지만 내보내기가 복잡하고 하드웨어 호환성이 제한되는 경우가 많습니다. YOLO26은 DFL을 완전히 제거하여 추론을 간소화하고 에지 및 저전력 디바이스에 대한 지원을 확대합니다.종단 간 NMS-Free 추론

NMS를 별도의 후처리 단계로 사용하는 기존 detect 모델과 달리, YOLO26은 네이티브 종단 간 모델입니다. 예측이 직접 생성되어 지연 시간을 줄이고 프로덕션 시스템으로의 통합을 더 빠르고, 가볍고, 안정적으로 만듭니다.ProgLoss + STAL

향상된 손실 기능으로 감지 정확도가 향상되어 IoT, 로봇 공학, 항공 이미지 및 기타 에지 애플리케이션의 핵심 요구 사항인 작은 물체 인식이 눈에 띄게 개선되었습니다.MuSGD Optimizer

SGD와 Muon을 결합한 새로운 하이브리드 Optimizer입니다. Moonshot AI의 Kimi K2에서 영감을 받아, MuSGD는 LLM 훈련의 고급 최적화 방법을 컴퓨터 비전에 도입하여 더 안정적인 훈련과 더 빠른 수렴을 가능하게 합니다.최대 43% 빨라진 CPU 추론

특히 엣지 컴퓨팅에 최적화된 YOLO26은 훨씬 빠른 CPU 추론을 제공하여 GPU가 없는 디바이스에서도 실시간 성능을 보장합니다.인스턴스 분할 개선 사항

모델 수렴을 개선하기 위한 의미론적 분할 손실과 우수한 마스크 품질을 위해 다중 스케일 정보를 활용하는 업그레이드된 프로토 모듈을 도입합니다.정밀 자세 추정

은 잔차 로그 가능도 추정 (RLE)을 통합하여 더 정확한 키포인트 위치를 파악하고, 추론 속도 향상을 위해 디코딩 과정을 최적화합니다.정제된 OBB 디코딩

사각형 객체에 대한 탐지 정확도를 향상시키기 위해 특수한 각도 손실 함수를 도입하고, 경계 불연속성 문제를 해결하기 위해 OBB 디코딩을 최적화합니다.

지원되는 작업 및 모드

YOLO26은 이전 Ultralytics YOLO 릴리스에서 확립된 다재다능한 모델 범위를 기반으로 하며, 다양한 컴퓨터 비전 작업에 걸쳐 향상된 지원을 제공합니다.

| 모델 | 파일 이름 | 작업 | 추론 | 검증 | 훈련 | 내보내기 |

|---|---|---|---|---|---|---|

| YOLO26 | yolo26n.pt yolo26s.pt yolo26m.pt yolo26l.pt yolo26x.pt | 객체 탐지 | ✅ | ✅ | ✅ | ✅ |

| YOLO26-seg | yolo26n-seg.pt yolo26s-seg.pt yolo26m-seg.pt yolo26l-seg.pt yolo26x-seg.pt | 인스턴스 분할 | ✅ | ✅ | ✅ | ✅ |

| YOLO26-pose | yolo26n-pose.pt yolo26s-pose.pt yolo26m-pose.pt yolo26l-pose.pt yolo26x-pose.pt | 포즈/키포인트 | ✅ | ✅ | ✅ | ✅ |

| YOLO26-obb | yolo26n-obb.pt yolo26s-obb.pt yolo26m-obb.pt yolo26l-obb.pt yolo26x-obb.pt | 방향 감지 | ✅ | ✅ | ✅ | ✅ |

| YOLO26-cls | yolo26n-cls.pt yolo26s-cls.pt yolo26m-cls.pt yolo26l-cls.pt yolo26x-cls.pt | 분류 | ✅ | ✅ | ✅ | ✅ |

이 통합 프레임워크는 YOLO26이 실시간 감지, 분할, 분류, 포즈 추정 및 방향 객체 감지 전반에 걸쳐 적용 가능하도록 보장하며, 이 모든 것이 훈련, 유효성 검사, 추론 및 내보내기를 지원합니다.

성능 지표

성능

COCO에서 훈련된 이 모델들의 사용 예시(80개의 사전 훈련된 클래스 포함)는 Detection 문서를 참조하십시오.

| 모델 | 크기 (픽셀) | mAPval 50-95 | mAPval 50-95(e2e) | 속도 CPU ONNX (ms) | 속도 T4 TensorRT10 (ms) | 파라미터 (M) | FLOPs (B) |

|---|---|---|---|---|---|---|---|

| YOLO26n | 640 | 40.9 | 40.1 | 38.9 ± 0.7 | 1.7 ± 0.0 | 2.4 | 5.4 |

| YOLO26s | 640 | 48.6 | 47.8 | 87.2 ± 0.9 | 2.5 ± 0.0 | 9.5 | 20.7 |

| YOLO26m | 640 | 53.1 | 52.5 | 220.0 ± 1.4 | 4.7 ± 0.1 | 20.4 | 68.2 |

| YOLO26l | 640 | 55.0 | 54.4 | 286.2 ± 2.0 | 6.2 ± 0.2 | 24.8 | 86.4 |

| YOLO26x | 640 | 57.5 | 56.9 | 525.8 ± 4.0 | 11.8 ± 0.2 | 55.7 | 193.9 |

80개의 사전 학습된 클래스를 포함하는 COCO로 학습된 이 모델들의 사용 예시는 세그멘테이션 문서를 참조하십시오.

| 모델 | 크기 (픽셀) | mAPbox 50-95(e2e) | mAPmask 50-95(e2e) | 속도 CPU ONNX (ms) | 속도 T4 TensorRT10 (ms) | 파라미터 (M) | FLOPs (B) |

|---|---|---|---|---|---|---|---|

| YOLO26n-seg | 640 | 39.6 | 33.9 | 53.3 ± 0.5 | 2.1 ± 0.0 | 2.7 | 9.1 |

| YOLO26s-seg | 640 | 47.3 | 40.0 | 118.4 ± 0.9 | 3.3 ± 0.0 | 10.4 | 34.2 |

| YOLO26m-seg | 640 | 52.5 | 44.1 | 328.2 ± 2.4 | 6.7 ± 0.1 | 23.6 | 121.5 |

| YOLO26l-seg | 640 | 54.4 | 45.5 | 387.0 ± 3.7 | 8.0 ± 0.1 | 28.0 | 139.8 |

| YOLO26x-seg | 640 | 56.5 | 47.0 | 787.0 ± 6.8 | 16.4 ± 0.1 | 62.8 | 313.5 |

1000개의 사전 학습된 클래스를 포함하는 ImageNet으로 학습된 이 모델들의 사용 예시는 분류 문서를 참조하십시오.

| 모델 | 크기 (픽셀) | acc top1 | acc top5 | 속도 CPU ONNX (ms) | 속도 T4 TensorRT10 (ms) | 파라미터 (M) | FLOPs (B) at 224 |

|---|---|---|---|---|---|---|---|

| YOLO26n-cls | 224 | 71.4 | 90.1 | 5.0 ± 0.3 | 1.1 ± 0.0 | 2.8 | 0.5 |

| YOLO26s-cls | 224 | 76.0 | 92.9 | 7.9 ± 0.2 | 1.3 ± 0.0 | 6.7 | 1.6 |

| YOLO26m-cls | 224 | 78.1 | 94.2 | 17.2 ± 0.4 | 2.0 ± 0.0 | 11.6 | 4.9 |

| YOLO26l-cls | 224 | 79.0 | 94.6 | 23.2 ± 0.3 | 2.8 ± 0.0 | 14.1 | 6.2 |

| YOLO26x-cls | 224 | 79.9 | 95.0 | 41.4 ± 0.9 | 3.8 ± 0.0 | 29.6 | 13.6 |

자세 추정 문서에서 COCO로 학습된 이 모델들의 사용 예시를 확인하세요. 여기에는 '사람'이라는 사전 학습된 클래스 1개가 포함됩니다.

| 모델 | 크기 (픽셀) | mAPpose 50-95(e2e) | mAPpose 50(e2e) | 속도 CPU ONNX (ms) | 속도 T4 TensorRT10 (ms) | 파라미터 (M) | FLOPs (B) |

|---|---|---|---|---|---|---|---|

| YOLO26n-pose | 640 | 57.2 | 83.3 | 40.3 ± 0.5 | 1.8 ± 0.0 | 2.9 | 7.5 |

| YOLO26s-pose | 640 | 63.0 | 86.6 | 85.3 ± 0.9 | 2.7 ± 0.0 | 10.4 | 23.9 |

| YOLO26m-pose | 640 | 68.8 | 89.6 | 218.0 ± 1.5 | 5.0 ± 0.1 | 21.5 | 73.1 |

| YOLO26l-pose | 640 | 70.4 | 90.5 | 275.4 ± 2.4 | 6.5 ± 0.1 | 25.9 | 91.3 |

| YOLO26x-pose | 640 | 71.6 | 91.6 | 565.4 ± 3.0 | 12.2 ± 0.2 | 57.6 | 201.7 |

15개의 사전 학습된 클래스를 포함하는 DOTAv1으로 학습된 이 모델들의 사용 예시는 지향성 감지 문서를 참조하십시오.

| 모델 | 크기 (픽셀) | mAPtest 50-95(e2e) | mAPtest 50(e2e) | 속도 CPU ONNX (ms) | 속도 T4 TensorRT10 (ms) | 파라미터 (M) | FLOPs (B) |

|---|---|---|---|---|---|---|---|

| YOLO26n-obb | 1024 | 52.4 | 78.9 | 97.7 ± 0.9 | 2.8 ± 0.0 | 2.5 | 14.0 |

| YOLO26s-obb | 1024 | 54.8 | 80.9 | 218.0 ± 1.4 | 4.9 ± 0.1 | 9.8 | 55.1 |

| YOLO26m-obb | 1024 | 55.3 | 81.0 | 579.2 ± 3.8 | 10.2 ± 0.3 | 21.2 | 183.3 |

| YOLO26l-obb | 1024 | 56.2 | 81.6 | 735.6 ± 3.1 | 13.0 ± 0.2 | 25.6 | 230.0 |

| YOLO26x-obb | 1024 | 56.7 | 81.7 | 1485.7 ± 11.5 | 30.5 ± 0.9 | 57.6 | 516.5 |

매개변수 및 FLOPs 값은 융합 모델 이후의 값입니다. model.fuse()이는 Conv 및 BatchNorm 레이어를 병합하고 보조적인 일대다 탐지 헤드를 제거합니다. 사전 훈련된 체크포인트는 전체 훈련 아키텍처를 유지하며 더 높은 카운트를 보일 수 있습니다.

사용 예시

이 섹션에서는 간단한 YOLO26 학습 및 추론 예시를 제공합니다. 이러한 모드 및 기타 모드에 대한 전체 문서는 예측, 학습, 검증 및 내보내기 문서 페이지를 참조하십시오.

아래 예시는 객체 detect를 위한 YOLO26 Detect 모델에 대한 것임을 참고하십시오. 추가로 지원되는 작업에 대해서는 Segment, Classify, OBB 및 Pose 문서를 참조하십시오.

예시

PyTorch 사전 훈련된 *.pt 모델과 구성 *.yaml 파일을 다음으로 전달하여 YOLO() Python에서 모델 인스턴스를 생성할 수 있습니다:

from ultralytics import YOLO

# Load a COCO-pretrained YOLO26n model

model = YOLO("yolo26n.pt")

# Train the model on the COCO8 example dataset for 100 epochs

results = model.train(data="coco8.yaml", epochs=100, imgsz=640)

# Run inference with the YOLO26n model on the 'bus.jpg' image

results = model("path/to/bus.jpg")

모델을 직접 실행하는 데 사용할 수 있는 CLI 명령은 다음과 같습니다.

# Load a COCO-pretrained YOLO26n model and train it on the COCO8 example dataset for 100 epochs

yolo train model=yolo26n.pt data=coco8.yaml epochs=100 imgsz=640

# Load a COCO-pretrained YOLO26n model and run inference on the 'bus.jpg' image

yolo predict model=yolo26n.pt source=path/to/bus.jpg

듀얼 헤드 아키텍처

YOLO26은 다양한 배포 시나리오에 유연성을 제공하는 듀얼 헤드 아키텍처를 특징으로 합니다:

- 일대일 헤드 (기본값): NMS 없이 종단 간 예측을 생성하며, 출력합니다.

(N, 300, 6)이미지당 최대 300개의 탐지 결과를 제공합니다. 이 헤드는 빠른 추론과 간소화된 배포를 위해 최적화되었습니다. - 일대다 헤드전통적인 YOLO 생성하며 NMS 필요하며, 출력하는

(N, nc + 4, 8400)여기서nc클래스 수입니다. 이 헤드는 일반적으로 추가 처리 비용을 대가로 약간 더 높은 정확도를 달성합니다.

내보내기, 예측 또는 검증 중에 헤드를 전환할 수 있습니다:

from ultralytics import YOLO

model = YOLO("yolo26n.pt")

# Use one-to-one head (default, no NMS required)

results = model.predict("image.jpg") # inference

metrics = model.val(data="coco.yaml") # validation

model.export(format="onnx") # export

# Use one-to-many head (requires NMS)

results = model.predict("image.jpg", end2end=False) # inference

metrics = model.val(data="coco.yaml", end2end=False) # validation

model.export(format="onnx", end2end=False) # export

# Use one-to-one head (default, no NMS required)

yolo predict model=yolo26n.pt source=image.jpg

yolo val model=yolo26n.pt data=coco.yaml

yolo export model=yolo26n.pt format=onnx

# Use one-to-many head (requires NMS)

yolo predict model=yolo26n.pt source=image.jpg end2end=False

yolo val model=yolo26n.pt data=coco.yaml end2end=False

yolo export model=yolo26n.pt format=onnx end2end=False

선택은 배포 요구사항에 따라 달라집니다: 최대 속도와 단순성을 원한다면 일대일 헤드를, 정확성이 최우선이라면 일대다 헤드를 사용하십시오.

YOLOE-26: 개방형 어휘 인스턴스 분할

YOLOE-26은 고성능 YOLO26 아키텍처를 YOLOE 시리즈의 개방형 어휘(open-vocabulary) 기능과 통합합니다. 이를 통해 텍스트 프롬프트, 시각적 프롬프트 또는 제로샷 추론을 위한 프롬프트 없는 모드를 사용하여 모든 객체 클래스의 실시간 detect 및 segment를 가능하게 하며, 고정된 카테고리 학습의 제약을 효과적으로 제거합니다.

YOLO26의 NMS-free, 종단 간(end-to-end) 설계를 활용하여 YOLOE-26은 빠른 개방형 세계(open-world) 추론을 제공합니다. 이는 관심 객체가 광범위하고 진화하는 어휘를 나타내는 동적 환경의 엣지 애플리케이션을 위한 강력한 솔루션입니다.

성능

Objects365v1, GQA 및 Flickr30k 데이터셋으로 학습된 이 모델들의 사용 예시는 YOLOE 문서를 참조하십시오.

| 모델 | 크기 (픽셀) | 프롬프트 유형 | mAPminival 50-95(e2e) | mAPminival 50-95 | mAPr | mAPc | mAPf | 파라미터 (M) | FLOPs (B) |

|---|---|---|---|---|---|---|---|---|---|

| YOLOE-26n-seg | 640 | 텍스트/시각적 | 23.7 / 20.9 | 24.7 / 21.9 | 20.5 / 17.6 | 24.1 / 22.3 | 26.1 / 22.4 | 4.8 | 6.0 |

| YOLOE-26s-seg | 640 | 텍스트/시각적 | 29.9 / 27.1 | 30.8 / 28.6 | 23.9 / 25.1 | 29.6 / 27.8 | 33.0 / 29.9 | 13.1 | 21.7 |

| YOLOE-26m-seg | 640 | 텍스트/시각적 | 35.4 / 31.3 | 35.4 / 33.9 | 31.1 / 33.4 | 34.7 / 34.0 | 36.9 / 33.8 | 27.9 | 70.1 |

| YOLOE-26l-seg | 640 | 텍스트/시각적 | 36.8 / 33.7 | 37.8 / 36.3 | 35.1 / 37.6 | 37.6 / 36.2 | 38.5 / 36.1 | 32.3 | 88.3 |

| YOLOE-26x-seg | 640 | 텍스트/시각적 | 39.5 / 36.2 | 40.6 / 38.5 | 37.4 / 35.3 | 40.9 / 38.8 | 41.0 / 38.8 | 69.9 | 196.7 |

Objects365v1, GQA 및 Flickr30k 데이터셋으로 학습된 이 모델들의 사용 예시는 YOLOE 문서를 참조하십시오.

| 모델 | 크기 (픽셀) | mAPminival 50-95(e2e) | mAPminival 50(e2e) | 파라미터 (M) | FLOPs (B) |

|---|---|---|---|---|---|

| YOLOE-26n-seg-pf | 640 | 16.6 | 22.7 | 6.5 | 15.8 |

| YOLOE-26s-seg-pf | 640 | 21.4 | 28.6 | 16.2 | 35.5 |

| YOLOE-26m-seg-pf | 640 | 25.7 | 33.6 | 36.2 | 122.1 |

| YOLOE-26l-seg-pf | 640 | 27.2 | 35.4 | 40.6 | 140.4 |

| YOLOE-26x-seg-pf | 640 | 29.9 | 38.7 | 86.3 | 314.4 |

사용 예시

YOLOE-26은 텍스트 기반 및 시각적 프롬프팅을 모두 지원합니다. 프롬프트 사용은 간단합니다. 다음을 통해 전달하기만 하면 됩니다. predict 메서드는 아래와 같습니다.

예시

텍스트 프롬프트를 사용하면 텍스트 설명을 통해 detect하려는 클래스를 지정할 수 있습니다. 다음 코드는 YOLOE-26을 사용하여 이미지에서 사람과 버스를 detect하는 방법을 보여줍니다.

from ultralytics import YOLO

# Initialize model

model = YOLO("yoloe-26l-seg.pt") # or select yoloe-26s/m-seg.pt for different sizes

# Set text prompt to detect person and bus. You only need to do this once after you load the model.

model.set_classes(["person", "bus"])

# Run detection on the given image

results = model.predict("path/to/image.jpg")

# Show results

results[0].show()

시각적 프롬프트를 통해 텍스트로 설명하는 대신 대상 클래스의 시각적 예제를 보여줌으로써 모델을 안내할 수 있습니다.

import numpy as np

from ultralytics import YOLO

from ultralytics.models.yolo.yoloe import YOLOEVPSegPredictor

# Initialize model

model = YOLO("yoloe-26l-seg.pt")

# Define visual prompts using bounding boxes and their corresponding class IDs.

# Each box highlights an example of the object you want the model to detect.

visual_prompts = dict(

bboxes=np.array(

[

[221.52, 405.8, 344.98, 857.54], # Box enclosing person

[120, 425, 160, 445], # Box enclosing glasses

],

),

cls=np.array(

[

0, # ID to be assigned for person

1, # ID to be assigned for glasses

]

),

)

# Run inference on an image, using the provided visual prompts as guidance

results = model.predict(

"ultralytics/assets/bus.jpg",

visual_prompts=visual_prompts,

predictor=YOLOEVPSegPredictor,

)

# Show results

results[0].show()

YOLOE-26은 내장된 어휘를 포함하는 프롬프트 없는 변형을 제공합니다. 이 모델들은 어떠한 프롬프트도 필요로 하지 않으며 기존 YOLO 모델처럼 작동합니다. 사용자가 제공하는 레이블이나 시각적 예시에 의존하는 대신, Recognize Anything Model Plus (RAM++)에서 사용되는 태그 세트를 기반으로 사전 정의된 4,585개 클래스 목록에서 객체를 detect합니다.

from ultralytics import YOLO

# Initialize model

model = YOLO("yoloe-26l-seg-pf.pt")

# Run prediction. No prompts required.

results = model.predict("path/to/image.jpg")

# Show results

results[0].show()

프롬프팅 기술, 처음부터 훈련하는 방법, 전체 사용 예시에 대해 자세히 알아보려면 YOLOE 문서를 방문하십시오.

인용 및 감사의 말씀

Ultralytics YOLO26 발표

Ultralytics는 모델의 빠른 변화로 인해 YOLO26에 대한 공식 연구 논문을 발표하지 않았습니다. 대신 최첨단 모델을 제공하고 사용하기 쉽게 만드는 데 집중하고 있습니다. YOLO 기능, 아키텍처 및 사용법에 대한 최신 업데이트는 GitHub 저장소 및 문서를 참조하십시오.

YOLO26 또는 다른 Ultralytics 소프트웨어를 사용하는 경우 다음과 같이 인용해 주십시오.

@software{yolo26_ultralytics,

author = {Glenn Jocher and Jing Qiu},

title = {Ultralytics YOLO26},

version = {26.0.0},

year = {2026},

url = {https://github.com/ultralytics/ultralytics},

orcid = {0000-0001-5950-6979, 0000-0003-3783-7069},

license = {AGPL-3.0}

}

DOI는 보류 중입니다. YOLO26은 AGPL-3.0 및 Enterprise 라이선스 하에 사용할 수 있습니다.

FAQ

YOLO26은 YOLO11과 비교하여 어떤 주요 개선 사항이 있습니까?

- DFL 제거: 내보내기를 간소화하고 엣지 호환성을 확장합니다.

- End-to-End NMS-Free 추론: NMS를 제거하여 더 빠르고 간단한 배포를 가능하게 합니다.

- ProgLoss + STAL: 특히 작은 객체에서 정확도를 향상시킵니다.

- MuSGD Optimizer: SGD와 Muon을 결합하여 (Moonshot의 Kimi K2에서 영감) 더 안정적이고 효율적인 훈련을 제공합니다.

- 최대 43% 더 빠른 CPU 추론: CPU 전용 장치에 대한 주요 성능 향상

YOLO26은 어떤 작업을 지원합니까?

YOLO26은 통합 모델 제품군으로, 다양한 컴퓨터 비전 작업에 대한 엔드투엔드 지원을 제공합니다:

각 크기 변형(n, s, m, l, x)은 모든 작업을 지원하며, 또한 YOLOE-26을 통한 개방형 어휘 버전을 지원합니다.

YOLO26은 왜 엣지 배포에 최적화되어 있습니까?

YOLO26은 다음을 통해 최첨단 엣지 성능을 제공합니다.

- 최대 43% 더 빠른 CPU 추론

- 모델 크기 및 메모리 공간 축소

- 호환성을 위해 간소화된 아키텍처 (DFL 없음, NMS 없음)

- TensorRT, ONNX, CoreML, TFLite 및 OpenVINO를 포함한 유연한 내보내기 형식

YOLO26을 어떻게 시작할 수 있습니까?

YOLO26 모델은 2026년 1월 14일에 출시되었으며 다운로드할 수 있습니다. 다음을 설치하거나 업데이트하십시오. ultralytics 패키지를 설치하고 모델을 로드하십시오:

from ultralytics import YOLO

# Load a pretrained YOLO26 nano model

model = YOLO("yolo26n.pt")

# Run inference on an image

results = model("image.jpg")

훈련, 검증 및 내보내기 지침은 사용 예시 섹션을 참조하십시오.