YOLOE: Visão em Tempo Real de Qualquer Coisa

Introdução

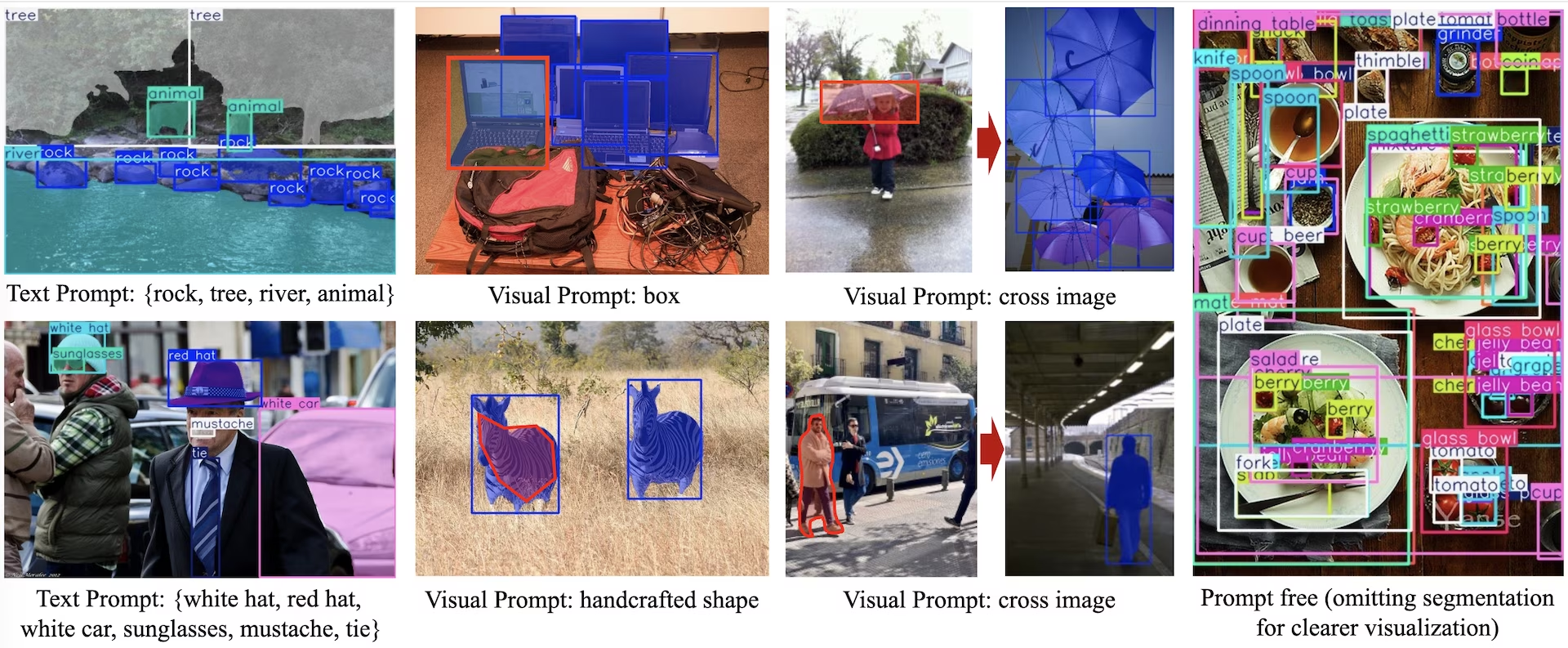

YOLOE (Real-Time Seeing Anything) é um novo avanço em modelos YOLO de zero-shot e promptáveis, projetados para vocabulário aberto detecção e segmentação. Ao contrário dos modelos YOLO anteriores, limitados a categorias fixas, o YOLOE usa prompts de texto, imagem ou vocabulário interno, permitindo a detecção em tempo real de qualquer classe de objeto. Construído sobre o YOLOv10 e inspirado no YOLO-World, o YOLOE alcança desempenho de última geração de zero-shot com impacto mínimo na velocidade e precisão.

Assista: Como usar o YOLOE com o pacote Python Ultralytics: Vocabulário Aberto e Visão de Qualquer Coisa em Tempo Real 🚀

Comparado com os modelos YOLO anteriores, o YOLOE aumenta significativamente a eficiência e a precisão. Ele melhora em +3.5 AP em relação ao YOLO-Worldv2 no LVIS, usando apenas um terço dos recursos de treinamento e alcançando velocidades de inferência 1,4 vezes mais rápidas. Ajustado no COCO, o YOLOE-v8-large supera o YOLOv8-L em 0.1 mAP, usando quase 4 vezes menos tempo de treinamento. Isso demonstra o equilíbrio excepcional do YOLOE entre precisão, eficiência e versatilidade. As seções abaixo exploram a arquitetura do YOLOE, comparações de benchmark e integração com o framework Ultralytics.

Visão Geral da Arquitetura

O YOLOE retém a estrutura YOLO padrão—um backbone convolucional (por exemplo, CSP-Darknet) para extração de características, um neck (por exemplo, PAN-FPN) para fusão multi-escala e um head de detecção desacoplado e sem âncoras (como no YOLOv8/YOLO11) que prevê a objetividade, as classes e as caixas de forma independente. O YOLOE introduz três novos módulos que permitem a detecção de vocabulário aberto:

Alinhamento Região-Texto Re-parametrizável (RepRTA): Suporta detecção com prompts de texto refinando embeddings de texto (por exemplo, do CLIP) através de uma pequena rede auxiliar. Na inferência, esta rede é integrada ao modelo principal, garantindo zero overhead. Assim, o YOLOE detecta objetos arbitrariamente rotulados com texto (por exemplo, um "semáforo" não visto) sem penalidades de tempo de execução.

Codificador de Prompt Visual Ativado Semanticamente (SAVPE): Permite a detecção visualmente solicitada através de um ramo de incorporação leve. Dado uma imagem de referência, o SAVPE codifica recursos semânticos e de ativação, condicionando o modelo a detectar objetos visualmente semelhantes — uma capacidade de detecção one-shot útil para logotipos ou partes específicas.

Contraste de Prompt de Região Preguiçosa (LRPC): No modo sem prompt, o YOLOE executa o reconhecimento de conjunto aberto usando embeddings internos treinados em grandes vocabulários (mais de 1200 categorias de LVIS e Objects365). Sem prompts ou codificadores externos, o YOLOE identifica objetos por meio de pesquisa de similaridade de embedding, lidando eficientemente com grandes espaços de rótulos na inferência.

Além disso, o YOLOE integra segmentação de instância em tempo real, estendendo o cabeçalho de detecção com um branch de previsão de máscara (semelhante ao YOLACT ou YOLOv8-Seg), adicionando uma sobrecarga mínima.

Crucialmente, os módulos de mundo aberto do YOLOE não introduzem custo de inferência quando usados como um YOLO regular de conjunto fechado. Após o treinamento, os parâmetros do YOLOE podem ser reparametrizados em um cabeçalho YOLO padrão, preservando FLOPs e velocidade idênticos (por exemplo, correspondendo exatamente ao YOLO11).

Modelos Disponíveis, Tarefas Suportadas e Modos de Operação

Esta seção detalha os modelos disponíveis com seus pesos pré-treinados específicos, as tarefas que eles suportam e sua compatibilidade com vários modos de operação, como Inferência, Validação, Treinamento e Exportação, denotados por ✅ para modos suportados e ❌ para modos não suportados.

Modelos de Prompt de Texto/Visual

| Tipo de Modelo | Pesos Pré-treinados | Tarefas Suportadas | Inferência | Validação | Treinamento | Exportar |

|---|---|---|---|---|---|---|

| YOLOE-11S | yoloe-11s-seg.pt | Segmentação de Instância | ✅ | ✅ | ✅ | ✅ |

| YOLOE-11M | yoloe-11m-seg.pt | Segmentação de Instância | ✅ | ✅ | ✅ | ✅ |

| YOLOE-11L | yoloe-11l-seg.pt | Segmentação de Instância | ✅ | ✅ | ✅ | ✅ |

| YOLOE-v8S | yoloe-v8s-seg.pt | Segmentação de Instância | ✅ | ✅ | ✅ | ✅ |

| YOLOE-v8M | yoloe-v8m-seg.pt | Segmentação de Instância | ✅ | ✅ | ✅ | ✅ |

| YOLOE-v8L | yoloe-v8l-seg.pt | Segmentação de Instância | ✅ | ✅ | ✅ | ✅ |

| YOLOE-26N | yoloe-26n-seg.pt | Segmentação de Instância | ✅ | ✅ | ✅ | ✅ |

| YOLOE-26S | yoloe-26s-seg.pt | Segmentação de Instância | ✅ | ✅ | ✅ | ✅ |

| YOLOE-26M | yoloe-26m-seg.pt | Segmentação de Instância | ✅ | ✅ | ✅ | ✅ |

| YOLOE-26L | yoloe-26l-seg.pt | Segmentação de Instância | ✅ | ✅ | ✅ | ✅ |

| YOLOE-26X | yoloe-26x-seg.pt | Segmentação de Instância | ✅ | ✅ | ✅ | ✅ |

Modelos Livres de Prompt

| Tipo de Modelo | Pesos Pré-treinados | Tarefas Suportadas | Inferência | Validação | Treinamento | Exportar |

|---|---|---|---|---|---|---|

| YOLOE-11S-PF | yoloe-11s-seg-pf.pt | Segmentação de Instância | ✅ | ✅ | ✅ | ✅ |

| YOLOE-11M-PF | yoloe-11m-seg-pf.pt | Segmentação de Instância | ✅ | ✅ | ✅ | ✅ |

| YOLOE-11L-PF | yoloe-11l-seg-pf.pt | Segmentação de Instância | ✅ | ✅ | ✅ | ✅ |

| YOLOE-v8S-PF | yoloe-v8s-seg-pf.pt | Segmentação de Instância | ✅ | ✅ | ✅ | ✅ |

| YOLOE-v8M-PF | yoloe-v8m-seg-pf.pt | Segmentação de Instância | ✅ | ✅ | ✅ | ✅ |

| YOLOE-v8L-PF | yoloe-v8l-seg-pf.pt | Segmentação de Instância | ✅ | ✅ | ✅ | ✅ |

| YOLOE-26N-PF | yoloe-26n-seg-pf.pt | Segmentação de Instância | ✅ | ✅ | ✅ | ✅ |

| YOLOE-26S-PF | yoloe-26s-seg-pf.pt | Segmentação de Instância | ✅ | ✅ | ✅ | ✅ |

| YOLOE-26M-PF | yoloe-26m-seg-pf.pt | Segmentação de Instância | ✅ | ✅ | ✅ | ✅ |

| YOLOE-26L-PF | yoloe-26l-seg-pf.pt | Segmentação de Instância | ✅ | ✅ | ✅ | ✅ |

| YOLOE-26X-PF | yoloe-26x-seg-pf.pt | Segmentação de Instância | ✅ | ✅ | ✅ | ✅ |

Desempenho do YOLOE-26

Para benchmarks de desempenho detalhados dos modelos YOLOE-26, consulte a Documentação do YOLO26.

Exemplos de uso

Os modelos YOLOE são fáceis de integrar em seus aplicativos Python. A Ultralytics fornece uma API Python e comandos CLI fáceis de usar para otimizar o desenvolvimento.

Uso do Treino

Ajuste Fino em dataset personalizado

Você pode ajustar qualquer modelo YOLOE pré-treinado em seu conjunto de dados YOLO personalizado para tarefas de detecção e segmentação de instâncias.

Assista: Como Treinar o YOLOE no Dataset de Segmentação de Peças de Carro | Modelo de Vocabulário Aberto, Predição e Exportação 🚀

Exemplo

Segmentação de instâncias

O ajuste fino de um checkpoint YOLOE pré-treinado geralmente segue o procedimento padrão de treinamento YOLO. A principal diferença é passar explicitamente YOLOEPESegTrainer como o trainer parâmetro para model.train():

from ultralytics import YOLOE

from ultralytics.models.yolo.yoloe import YOLOEPESegTrainer

model = YOLOE("yoloe-26s-seg.pt")

# Fine-tune on your segmentation dataset

results = model.train(

data="coco128-seg.yaml", # Segmentation dataset

epochs=80,

patience=10,

trainer=YOLOEPESegTrainer, # <- Important: use segmentation trainer

)

A deteção de objetos

Todos os modelos YOLOE pré-treinados realizam segmentação de instâncias por padrão. Para usar esses checkpoints pré-treinados para treinar um modelo de detecção, inicialize um modelo de detecção do zero usando a configuração YAML e, em seguida, carregue o checkpoint de segmentação pré-treinado da mesma escala. Observe que usamos YOLOEPETrainer em vez de YOLOEPESegTrainer já que estamos treinando um modelo de detecção:

from ultralytics import YOLOE

from ultralytics.models.yolo.yoloe import YOLOEPETrainer

# Initialize a detection model from a config

model = YOLOE("yoloe-26s.yaml")

# Load weights from a pretrained segmentation checkpoint (same scale)

model.load("yoloe-26s-seg.pt")

# Fine-tune on your detection dataset

results = model.train(

data="coco128.yaml", # Detection dataset

epochs=80,

patience=10,

trainer=YOLOEPETrainer, # <- Important: use detection trainer

)

O linear probing ajusta apenas o branch de classificação, congelando o restante do modelo. Essa abordagem é útil ao trabalhar com dados limitados, pois evita o overfitting, aproveitando os recursos aprendidos anteriormente e adaptando apenas o cabeçalho de classificação.

Segmentação de instâncias

from ultralytics import YOLOE

from ultralytics.models.yolo.yoloe import YOLOEPESegTrainer

# Load a pretrained segmentation model

model = YOLOE("yoloe-26s-seg.pt")

# Identify the head layer index

head_index = len(model.model.model) - 1

# Freeze all backbone and neck layers (i.e., everything before the head)

freeze = [str(i) for i in range(0, head_index)]

# Freeze parts of the segmentation head, keeping only the classification branch trainable

for name, child in model.model.model[-1].named_children():

if "cv3" not in name:

freeze.append(f"{head_index}.{name}")

# Freeze detection branch components

freeze.extend(

[

f"{head_index}.cv3.0.0",

f"{head_index}.cv3.0.1",

f"{head_index}.cv3.1.0",

f"{head_index}.cv3.1.1",

f"{head_index}.cv3.2.0",

f"{head_index}.cv3.2.1",

]

)

# Train only the classification branch

results = model.train(

data="coco128-seg.yaml", # Segmentation dataset

epochs=80,

patience=10,

trainer=YOLOEPESegTrainer, # <- Important: use segmentation trainer

freeze=freeze,

)

A deteção de objetos

Para a tarefa de detecção de objetos, o processo de treinamento é quase o mesmo do exemplo de segmentação de instâncias acima, mas usamos YOLOEPETrainer em vez de YOLOEPESegTrainere inicializamos o modelo de detecção de objetos usando o YAML e, em seguida, carregamos os pesos do checkpoint de segmentação de instâncias pré-treinado.

from ultralytics import YOLOE

from ultralytics.models.yolo.yoloe import YOLOEPETrainer

# Initialize a detection model from a config

model = YOLOE("yoloe-26s.yaml")

# Load weights from a pretrained segmentation checkpoint (same scale)

model.load("yoloe-26s-seg.pt")

# Identify the head layer index

head_index = len(model.model.model) - 1

# Freeze all backbone and neck layers (i.e., everything before the head)

freeze = [str(i) for i in range(0, head_index)]

# Freeze parts of the segmentation head, keeping only the classification branch trainable

for name, child in model.model.model[-1].named_children():

if "cv3" not in name:

freeze.append(f"{head_index}.{name}")

# Freeze detection branch components

freeze.extend(

[

f"{head_index}.cv3.0.0",

f"{head_index}.cv3.0.1",

f"{head_index}.cv3.1.0",

f"{head_index}.cv3.1.1",

f"{head_index}.cv3.2.0",

f"{head_index}.cv3.2.1",

]

)

# Train only the classification branch

results = model.train(

data="coco128.yaml", # Detection dataset

epochs=80,

patience=10,

trainer=YOLOEPETrainer, # <- Important: use detection trainer

freeze=freeze,

)

Uso da Predição

O YOLOE suporta prompts baseados em texto e visuais. Usar prompts é simples—basta passá-los através do predict método, conforme mostrado abaixo:

Exemplo

Os prompts de texto permitem que você especifique as classes que deseja detect através de descrições textuais. O código a seguir mostra como você pode usar o YOLOE para detect pessoas e ônibus em uma imagem:

from ultralytics import YOLOE

# Initialize a YOLOE model

model = YOLOE("yoloe-26l-seg.pt") # or yoloe-26s/m-seg.pt for different sizes

# Set text prompt to detect person and bus. You only need to do this once after you load the model.

model.set_classes(["person", "bus"])

# Run detection on the given image

results = model.predict("path/to/image.jpg")

# Show results

results[0].show()

Os prompts visuais permitem que você guie o modelo mostrando exemplos visuais das classes-alvo, em vez de descrevê-las em texto.

O visual_prompts argumento recebe um dicionário com duas chaves: bboxes e cls. Cada caixa delimitadora em bboxes deve envolver bem um exemplo do objeto que você deseja que o modelo detecte, e a entrada correspondente em cls especifica o rótulo de classe para essa caixa. Este emparelhamento diz ao modelo: "É assim que a classe X se parece—agora encontre mais como ela".

IDs de classe (cls) em visual_prompts são usados para associar cada bounding box a uma categoria específica dentro do seu prompt. Eles não são rótulos fixos, mas identificadores temporários que você atribui a cada exemplo. O único requisito é que os IDs de classe devem ser sequenciais, começando em 0. Isso ajuda o modelo a associar corretamente cada caixa à sua respectiva classe.

Você pode fornecer prompts visuais diretamente dentro da mesma imagem na qual deseja executar a inferência. Por exemplo:

import numpy as np

from ultralytics import YOLOE

from ultralytics.models.yolo.yoloe import YOLOEVPSegPredictor

# Initialize a YOLOE model

model = YOLOE("yoloe-26l-seg.pt")

# Define visual prompts using bounding boxes and their corresponding class IDs.

# Each box highlights an example of the object you want the model to detect.

visual_prompts = dict(

bboxes=np.array(

[

[221.52, 405.8, 344.98, 857.54], # Box enclosing person

[120, 425, 160, 445], # Box enclosing glasses

],

),

cls=np.array(

[

0, # ID to be assigned for person

1, # ID to be assigned for glasses

]

),

)

# Run inference on an image, using the provided visual prompts as guidance

results = model.predict(

"ultralytics/assets/bus.jpg",

visual_prompts=visual_prompts,

predictor=YOLOEVPSegPredictor,

)

# Show results

results[0].show()

Ou você pode fornecer exemplos de uma imagem de referência separada usando o refer_image argumento. Nesse caso, o bboxes e cls em visual_prompts deve descrever objetos na imagem de referência, não na imagem de destino em que você está fazendo previsões:

Nota

Se source é um vídeo ou stream, o modelo usa automaticamente o primeiro frame como refer_image. Isso significa que seu visual_prompts são aplicados a esse frame inicial para ajudar o modelo a entender o que procurar no resto do vídeo. Alternativamente, você pode passar explicitamente qualquer frame específico como o refer_image para controlar quais exemplos visuais o modelo usa como referência.

import numpy as np

from ultralytics import YOLOE

from ultralytics.models.yolo.yoloe import YOLOEVPSegPredictor

# Initialize a YOLOE model

model = YOLOE("yoloe-26l-seg.pt")

# Define visual prompts based on a separate reference image

visual_prompts = dict(

bboxes=np.array([[221.52, 405.8, 344.98, 857.54]]), # Box enclosing person

cls=np.array([0]), # ID to be assigned for person

)

# Run prediction on a different image, using reference image to guide what to look for

results = model.predict(

"ultralytics/assets/zidane.jpg", # Target image for detection

refer_image="ultralytics/assets/bus.jpg", # Reference image used to get visual prompts

visual_prompts=visual_prompts,

predictor=YOLOEVPSegPredictor,

)

# Show results

results[0].show()

Usando refer_image também define as classes permanentemente, para que você possa executar previsões sem ter que fornecer os mesmos prompts visuais novamente, e exportar o modelo, mantendo a capacidade de ainda detectar as mesmas classes após a exportação:

# After making prediction with `refer_image`, you can run predictions without passing visual_prompts again and still get the same classes back

results = model("ultralytics/assets/bus.jpg")

# Or export it to a different format while retaining the classes

model.export(format="onnx")

Você também pode passar várias imagens de destino para executar a previsão:

import numpy as np

from ultralytics import YOLOE

from ultralytics.models.yolo.yoloe import YOLOEVPSegPredictor

# Initialize a YOLOE model

model = YOLOE("yoloe-26l-seg.pt")

# Define visual prompts using bounding boxes and their corresponding class IDs.

# Each box highlights an example of the object you want the model to detect.

visual_prompts = dict(

bboxes=[

np.array(

[

[221.52, 405.8, 344.98, 857.54], # Box enclosing person

[120, 425, 160, 445], # Box enclosing glasses

],

),

np.array([[150, 200, 1150, 700]]),

],

cls=[

np.array(

[

0, # ID to be assigned for person

1, # ID to be assigned for glasses

]

),

np.array([0]),

],

)

# Run inference on multiple images, using the provided visual prompts as guidance

results = model.predict(

["ultralytics/assets/bus.jpg", "ultralytics/assets/zidane.jpg"],

visual_prompts=visual_prompts,

predictor=YOLOEVPSegPredictor,

)

# Show results

results[0].show()

O YOLOE também inclui variantes sem prompt que vêm com um vocabulário integrado. Esses modelos não exigem nenhum prompt e funcionam como modelos YOLO tradicionais. Em vez de depender de rótulos fornecidos pelo usuário ou exemplos visuais, eles detectam objetos de uma lista predefinida de 4.585 classes com base no conjunto de tags usado pelo Recognize Anything Model Plus (RAM++).

from ultralytics import YOLOE

# Initialize a YOLOE model

model = YOLOE("yoloe-26l-seg-pf.pt")

# Run prediction. No prompts required.

results = model.predict("path/to/image.jpg")

# Show results

results[0].show()

Uso da Validação

A validação do modelo num conjunto de dados é simplificada da seguinte forma:

Exemplo

from ultralytics import YOLOE

# Create a YOLOE model

model = YOLOE("yoloe-26l-seg.pt") # or yoloe-26s/m-seg.pt for different sizes

# Conduct model validation on the COCO128-seg example dataset

metrics = model.val(data="coco128-seg.yaml")

Por predefinição, utiliza o conjunto de dados fornecido para extrair incorporações visuais para cada categoria.

from ultralytics import YOLOE

# Create a YOLOE model

model = YOLOE("yoloe-26l-seg.pt") # or yoloe-26s/m-seg.pt for different sizes

# Conduct model validation on the COCO128-seg example dataset

metrics = model.val(data="coco128-seg.yaml", load_vp=True)

Alternativamente, podemos usar outro conjunto de dados como um conjunto de dados de referência para extrair embeddings visuais para cada categoria. Observe que este conjunto de dados de referência deve ter exatamente as mesmas categorias que o conjunto de dados fornecido.

from ultralytics import YOLOE

# Create a YOLOE model

model = YOLOE("yoloe-26l-seg.pt") # or select yoloe-26s/m-seg.pt for different sizes

# Conduct model validation on the COCO128-seg example dataset

metrics = model.val(data="coco128-seg.yaml", load_vp=True, refer_data="coco.yaml")

from ultralytics import YOLOE

# Create a YOLOE model

model = YOLOE("yoloe-26l-seg-pf.pt") # or yoloe-26s/m-seg-pf.pt for different sizes

# Conduct model validation on the COCO128-seg example dataset

metrics = model.val(data="coco128-seg.yaml", single_cls=True)

Utilização da Exportação

O processo de exportação é semelhante a outros modelos YOLO, com a flexibilidade adicional de lidar com prompts de texto e visuais:

Exemplo

from ultralytics import YOLOE

# Select yoloe-26s/m-seg.pt for different sizes

model = YOLOE("yoloe-26l-seg.pt")

# Configure the set_classes() before exporting the model

model.set_classes(["person", "bus"])

export_model = model.export(format="onnx")

model = YOLOE(export_model)

# Run detection on the given image

results = model.predict("path/to/image.jpg")

# Show results

results[0].show()

Treinar Modelos Oficiais

Preparar conjuntos de dados

Nota

O treinamento de modelos YOLOE oficiais precisa de anotações de segment para dados de treinamento, aqui está o script fornecido pela equipe oficial que converte conjuntos de dados em segment anotações, alimentado por Modelos SAM2.1. Ou você pode baixar diretamente o Processed Segment Annotations na tabela a seguir fornecida pela equipe oficial.

- Dados de treino

| Conjunto de dados | Tipo | Amostras | Boxes | Anotações de Detecção Brutas | Anotações de Segmentos Processados |

|---|---|---|---|---|---|

| Objects365v1 | Detecção | 609k | 9621k | objects365_train.json | objects365_train_segm.json |

| GQA | Grounding | 621k | 3681k | final_mixed_train_no_coco.json | final_mixed_train_no_coco_segm.json |

| Flickr30k | Grounding | 149k | 641k | final_flickr_separateGT_train.json | final_flickr_separateGT_train_segm.json |

- Dados de validação

| Conjunto de dados | Tipo | Ficheiros de Anotação |

|---|---|---|

| LVIS minival | Detecção | minival.txt |

Iniciando o treinamento do zero

Nota

Visual Prompt os modelos são ajustados com base em modelos bem treinados Text Prompt modelos.

Exemplo

from ultralytics import YOLOE

from ultralytics.models.yolo.yoloe import YOLOESegTrainerFromScratch

# Option 1: Use Python dictionary

data = dict(

train=dict(

yolo_data=["Objects365.yaml"],

grounding_data=[

dict(

img_path="flickr/full_images/",

json_file="flickr/annotations/final_flickr_separateGT_train_segm.json",

),

dict(

img_path="mixed_grounding/gqa/images",

json_file="mixed_grounding/annotations/final_mixed_train_no_coco_segm.json",

),

],

),

val=dict(yolo_data=["lvis.yaml"]),

)

# Option 2: Use YAML file (yoloe_data.yaml)

# train:

# yolo_data:

# - Objects365.yaml

# grounding_data:

# - img_path: flickr/full_images/

# json_file: flickr/annotations/final_flickr_separateGT_train_segm.json

# - img_path: mixed_grounding/gqa/images

# json_file: mixed_grounding/annotations/final_mixed_train_no_coco_segm.json

# val:

# yolo_data:

# - lvis.yaml

model = YOLOE("yoloe-26l-seg.yaml")

model.train(

data=data, # or data="yoloe_data.yaml" if using YAML file

batch=128,

epochs=30,

close_mosaic=2,

optimizer="AdamW",

lr0=2e-3,

warmup_bias_lr=0.0,

weight_decay=0.025,

momentum=0.9,

workers=4,

trainer=YOLOESegTrainerFromScratch,

device="0,1,2,3,4,5,6,7",

)

Já que apenas o SAVPE O módulo precisa ser atualizado durante o treinamento.

Converta o modelo Text-prompt bem treinado em modelo de detecção e adote um pipeline de detecção com menor custo de treinamento.

Observe que esta etapa é opcional, você também pode começar diretamente pela segmentação.

from ultralytics import YOLOE

from ultralytics.utils.patches import torch_load

det_model = YOLOE("yoloe-26l.yaml")

state = torch_load("yoloe-26l-seg.pt")

det_model.load(state["model"])

det_model.save("yoloe-26l-seg-det.pt")

Começar o treinamento:

from ultralytics import YOLOE

from ultralytics.models.yolo.yoloe import YOLOESegVPTrainer

data = dict(

train=dict(

yolo_data=["Objects365.yaml"],

grounding_data=[

dict(

img_path="flickr/full_images/",

json_file="flickr/annotations/final_flickr_separateGT_train_segm.json",

),

dict(

img_path="mixed_grounding/gqa/images",

json_file="mixed_grounding/annotations/final_mixed_train_no_coco_segm.json",

),

],

),

val=dict(yolo_data=["lvis.yaml"]),

)

model = YOLOE("yoloe-26l-seg.pt")

# replace to yoloe-26l-seg-det.pt if converted to detection model

# model = YOLOE("yoloe-26l-seg-det.pt")

# freeze every layer except of the savpe module.

head_index = len(model.model.model) - 1

freeze = list(range(0, head_index))

for name, child in model.model.model[-1].named_children():

if "savpe" not in name:

freeze.append(f"{head_index}.{name}")

model.train(

data=data,

batch=128,

epochs=2,

close_mosaic=2,

optimizer="AdamW",

lr0=16e-3,

warmup_bias_lr=0.0,

weight_decay=0.025,

momentum=0.9,

workers=4,

trainer=YOLOESegVPTrainer, # use YOLOEVPTrainer if converted to detection model

device="0,1,2,3,4,5,6,7",

freeze=freeze,

)

Converter de volta para o modelo de segmentação após o treinamento. Necessário apenas se você converteu o modelo de segmentação para o modelo de detecção antes do treinamento.

from copy import deepcopy

from ultralytics import YOLOE

model = YOLOE("yoloe-26l-seg.yaml")

model.load("yoloe-26l-seg.pt")

vp_model = YOLOE("yoloe-11l-vp.pt")

model.model.model[-1].savpe = deepcopy(vp_model.model.model[-1].savpe)

model.eval()

model.save("yoloe-26l-seg.pt")

Semelhante ao treinamento com prompts visuais, para o modelo sem prompts, apenas a incorporação especializada do prompt precisa ser atualizada durante o treinamento. Converta o modelo de prompt de texto bem treinado em modelo de detecção e adote o pipeline de detecção com menor custo de treinamento. Observe que esta etapa é opcional, você também pode começar diretamente pela segmentação.

from ultralytics import YOLOE

from ultralytics.utils.patches import torch_load

det_model = YOLOE("yoloe-26l.yaml")

state = torch_load("yoloe-26l-seg.pt")

det_model.load(state["model"])

det_model.save("yoloe-26l-seg-det.pt")

from ultralytics import YOLOE

data = dict(

train=dict(

yolo_data=["Objects365.yaml"],

grounding_data=[

dict(

img_path="flickr/full_images/",

json_file="flickr/annotations/final_flickr_separateGT_train_segm.json",

),

dict(

img_path="mixed_grounding/gqa/images",

json_file="mixed_grounding/annotations/final_mixed_train_no_coco_segm.json",

),

],

),

val=dict(yolo_data=["lvis.yaml"]),

)

model = YOLOE("yoloe-26l-seg.pt")

# replace to yoloe-26l-seg-det.pt if converted to detection model

# model = YOLOE("yoloe-26l-seg-det.pt")

# freeze layers.

head_index = len(model.model.model) - 1

freeze = [str(f) for f in range(0, head_index)]

for name, child in model.model.model[-1].named_children():

if "cv3" not in name:

freeze.append(f"{head_index}.{name}")

freeze.extend(

[

f"{head_index}.cv3.0.0",

f"{head_index}.cv3.0.1",

f"{head_index}.cv3.1.0",

f"{head_index}.cv3.1.1",

f"{head_index}.cv3.2.0",

f"{head_index}.cv3.2.1",

]

)

model.train(

data=data,

batch=128,

epochs=1,

close_mosaic=1,

optimizer="AdamW",

lr0=2e-3,

warmup_bias_lr=0.0,

weight_decay=0.025,

momentum=0.9,

workers=4,

trainer=YOLOEPEFreeTrainer,

device="0,1,2,3,4,5,6,7",

freeze=freeze,

single_cls=True, # this is needed

)

Converter de volta para o modelo de segmentação após o treinamento. Necessário apenas se você converteu o modelo de segmentação para o modelo de detecção antes do treinamento.

from copy import deepcopy

from ultralytics import YOLOE

model = YOLOE("yoloe-26l-seg.pt")

model.eval()

pf_model = YOLOE("yoloe-26l-seg-pf.pt")

names = ["object"]

tpe = model.get_text_pe(names)

model.set_classes(names, tpe)

model.model.model[-1].fuse(model.model.pe)

model.model.model[-1].cv3[0][2] = deepcopy(pf_model.model.model[-1].cv3[0][2]).requires_grad_(True)

model.model.model[-1].cv3[1][2] = deepcopy(pf_model.model.model[-1].cv3[1][2]).requires_grad_(True)

model.model.model[-1].cv3[2][2] = deepcopy(pf_model.model.model[-1].cv3[2][2]).requires_grad_(True)

del model.model.pe

model.save("yoloe-26l-seg-pf.pt")

Comparação de Desempenho do YOLOE

YOLOE iguala ou excede a precisão dos modelos YOLO de conjunto fechado em benchmarks padrão como COCO e LVIS, sem comprometer a velocidade ou o tamanho do modelo. A tabela abaixo compara YOLOE-L (construído sobre YOLO11) e YOLOE26-L (construído sobre YOLO26) em relação aos modelos de conjunto fechado correspondentes:

| Modelo | COCO mAP50-95 | LVIS mAP50-95 | Velocidade de Inferência (T4) | Parâmetros | GFLOPs (640px) |

|---|---|---|---|---|---|

| YOLOv8-L (conjunto fechado) | 52.9% | - | 9.06 ms (110 FPS) | 43.7 M | 165.2 B |

| YOLO11-L (conjunto fechado) | 53.5% | - | 6,2 ms (161 FPS) | 26.2 M | 86.9 B |

| YOLOE-L (vocabulário aberto) | 52.6% | 35.2% | 6,2 ms (161 FPS) | 26.2 M | 86.9 B† |

| YOLOE26-L (vocabulário aberto) | - | 36.8% | 6,2 ms (161 FPS) | 32.3 M | 88,3 B† |

†YOLOE-L compartilha a arquitetura do YOLO11-L e YOLOE26-L compartilha a arquitetura do YOLO26-L, resultando em velocidade de inferência e GFLOPs semelhantes.

YOLOE26-L alcança 36,8% de mAP LVIS com 32,3M parâmetros e 88,3B FLOPs, processando imagens de 640×640 em 6,2 ms (161 FPS) em GPU T4. Isso representa uma melhoria em relação ao 35,2% de mAP LVIS do YOLOE-L, mantendo a mesma velocidade de inferência. Crucialmente, os módulos de vocabulário aberto do YOLOE não incorrem em custo de inferência, demonstrando um design de "no free lunch trade-off".

Para tarefas zero-shot, o YOLOE26 supera significativamente os detectores de vocabulário aberto anteriores: no LVIS, o YOLOE26-S alcança 29,9% de mAP, superando o YOLO-World-S em +11,4 AP, enquanto o YOLOE26-L alcança 36,8% de mAP, excedendo o YOLO-World-L em +10,0 AP. O YOLOE26 mantém uma inferência eficiente a 161 FPS em GPU T4, ideal para aplicações de vocabulário aberto em tempo real.

Nota

Condições de benchmark: Os resultados do YOLOE são de modelos pré-treinados em Objects365, GoldG e LVIS, e depois ajustados ou avaliados no COCO. A ligeira vantagem de mAP do YOLOE sobre o YOLOv8 provém de um pré-treinamento extensivo. Sem este treinamento de vocabulário aberto, o YOLOE se iguala a modelos YOLO de tamanho semelhante, afirmando sua precisão SOTA e flexibilidade em mundo aberto sem penalidades de desempenho.

Comparação com Modelos Anteriores

O YOLOE introduz avanços notáveis em relação aos modelos YOLO anteriores e aos detectores de vocabulário aberto:

YOLOE vs YOLOv5: YOLOv5 oferecia um bom equilíbrio entre velocidade e precisão, mas exigia um novo treino para novas classes e usava cabeças baseadas em âncoras. Em contraste, o YOLOE é sem âncoras e deteta dinamicamente novas classes. O YOLOE, com base nas melhorias do YOLOv8, alcança maior precisão (52,6% vs. ~50% de mAP do YOLOv5 no COCO) e integra a segmentação de instâncias, ao contrário do YOLOv5.

YOLOE vs YOLOv8: O YOLOE estende a arquitetura redesenhada do YOLOv8, alcançando precisão semelhante ou superior (52,6% de mAP com ~26M de parâmetros vs. 52,9% do YOLOv8-L com ~44M de parâmetros). Reduz significativamente o tempo de treino devido a um pré-treino mais forte. O principal avanço é a capacidade de mundo aberto do YOLOE, detetando objetos não vistos (por exemplo, "trotinete pássaro" ou "símbolo da paz") através de prompts, ao contrário do design de conjunto fechado do YOLOv8.

YOLOE vs YOLO11: YOLO11 melhora o YOLOv8 com maior eficiência e menos parâmetros (redução de ~22%). O YOLOE herda estes ganhos diretamente, correspondendo à velocidade de inferência e à contagem de parâmetros do YOLO11 (~26M de parâmetros), enquanto adiciona deteção e segmentação de vocabulário aberto. Em cenários de conjunto fechado, o YOLOE é equivalente ao YOLO11, mas crucialmente adiciona adaptabilidade para detetar classes não vistas, alcançando YOLO11 + capacidade de mundo aberto sem comprometer a velocidade.

YOLOE26 vs YOLOE (baseado em YOLO11): O YOLOE26 é construído sobre a arquitetura do YOLO26, herdando seu design end-to-end sem NMS para uma inferência mais rápida. No LVIS, o YOLOE26-L alcança 36,8% de mAP, melhorando em relação aos 35,2% de mAP do YOLOE-L. O YOLOE26 oferece todas as cinco escalas de modelo (N/S/M/L/X) em comparação com as três do YOLOE (S/M/L), proporcionando mais flexibilidade para diferentes cenários de implantação.

YOLOE26 vs detectores de vocabulário aberto anteriores: Modelos de vocabulário aberto anteriores (GLIP, OWL-ViT, YOLO-World) dependiam fortemente de transformers de visão-linguagem, resultando em inferência lenta. No LVIS, o YOLOE26-S alcança 29,9% de mAP (+11,4 AP sobre o YOLO-World-S) e o YOLOE26-L alcança 36,8% de mAP (+10,0 AP sobre o YOLO-World-L), mantendo a inferência em tempo real a 161 FPS em GPU T4. Em comparação com abordagens baseadas em transformers (por exemplo, GLIP), o YOLOE26 oferece inferência ordens de magnitude mais rápida, preenchendo efetivamente a lacuna de precisão-eficiência na detecção de conjunto aberto.

Em resumo, YOLOE e YOLOE26 mantêm a renomada velocidade e eficiência do YOLO, superam os predecessores em precisão, integram segmentação e introduzem uma poderosa detecção de mundo aberto. O YOLOE26 avança ainda mais a arquitetura com inferência end-to-end sem NMS do YOLO26, tornando-o ideal para aplicações de vocabulário aberto em tempo real.

Casos de Uso e Aplicações

A detecção e segmentação de vocabulário aberto do YOLOE permitem diversas aplicações além dos modelos tradicionais de classe fixa:

Detecção de Objetos em Mundo Aberto: Ideal para cenários dinâmicos como robótica, onde robôs reconhecem objetos nunca vistos antes usando prompts, ou sistemas de segurança que se adaptam rapidamente a novas ameaças (por exemplo, itens perigosos) sem retreinamento.

Detecção Few-Shot e One-Shot: Usando prompts visuais (SAVPE), o YOLOE aprende rapidamente novos objetos a partir de imagens de referência únicas — perfeito para inspeção industrial (identificando peças ou defeitos instantaneamente) ou vigilância personalizada, permitindo buscas visuais com configuração mínima.

Reconhecimento de Vocabulário Grande e Long-Tail: Equipado com um vocabulário de mais de 1000 classes, o YOLOE destaca-se em tarefas como monitorização da biodiversidade (detetando espécies raras), coleções de museus, inventário de retalho ou e-commerce, identificando de forma fiável muitas classes sem treino extensivo por classe.

Detecção e Segmentação Interativas: YOLOE suporta aplicações interativas em tempo real, como recuperação de vídeo/imagem pesquisável, realidade aumentada (AR) e edição de imagem intuitiva, impulsionadas por entradas naturais (texto ou prompts visuais). Os usuários podem isolar, identificar ou editar objetos dinamicamente com precisão usando máscaras de segmentação.

Rotulagem e Bootstrapping Automatizados de Dados: O YOLOE facilita a criação rápida de conjuntos de dados, fornecendo bounding boxes iniciais e anotações de segmentação, reduzindo significativamente os esforços de rotulagem humana. Particularmente valioso em análises de grandes coleções de mídia, onde pode auto-identificar objetos presentes, auxiliando na construção de modelos especializados mais rapidamente.

Segmentação para Qualquer Objeto: Estende as capacidades de segmentação para objetos arbitrários através de prompts—particularmente benéfico para imagens médicas, microscopia ou análise de imagens de satélite, identificando e segmentando estruturas com precisão automaticamente, sem modelos pré-treinados especializados. Ao contrário de modelos como SAM, o YOLOE reconhece e segmenta objetos automaticamente e simultaneamente, auxiliando em tarefas como criação de conteúdo ou compreensão de cena.

Em todos esses casos de uso, a principal vantagem do YOLOE é a versatilidade, fornecendo um modelo unificado para detecção, reconhecimento e segmentação em cenários dinâmicos. Sua eficiência garante desempenho em tempo real em dispositivos com recursos limitados, ideal para robótica, direção autônoma, defesa e muito mais.

Dica

Escolha o modo do YOLOE com base nas suas necessidades:

- Modo de conjunto fechado: Para tarefas de classe fixa (velocidade e precisão máximas).

- Modo com prompt: Adicione novos objetos rapidamente através de prompts de texto ou visuais.

- Modo de conjunto aberto sem prompt: Detecção geral em várias categorias (ideal para catalogação e descoberta).

Frequentemente, combinar modos — como descoberta sem prompt seguida de prompts direcionados — aproveita todo o potencial do YOLOE.

Treino e Inferência

O YOLOE integra-se perfeitamente com a API Python Ultralytics e a CLI, de forma semelhante a outros modelos YOLO (YOLOv8, YOLO-World). Veja como começar rapidamente:

Treino e inferência com YOLOE

from ultralytics import YOLO

# Load pretrained YOLOE model and train on custom data

model = YOLO("yoloe-26s-seg.pt")

model.train(data="path/to/data.yaml", epochs=50, imgsz=640)

# Run inference using text prompts ("person", "bus")

model.set_classes(["person", "bus"])

results = model.predict(source="test_images/street.jpg")

results[0].save() # save annotated output

Aqui, o YOLOE se comporta como um detector padrão por padrão, mas muda facilmente para a detecção solicitada especificando classes (set_classes). Os resultados contêm caixas delimitadoras, máscaras e rótulos.

# Training YOLOE on custom dataset

yolo train model=yoloe-26s-seg.pt data=path/to/data.yaml epochs=50 imgsz=640

# Inference with text prompts

yolo predict model=yoloe-26s-seg.pt source="test_images/street.jpg" classes="person,bus"

Prompts da CLI (classes) orienta o YOLOE de forma semelhante ao set_classes. O visual prompting (consultas baseadas em imagem) requer atualmente a API Python.

Outras Tarefas Suportadas

- Validação: Avalie a precisão facilmente com

model.val()ouyolo val. - Exportar: Exportar modelos YOLOE (

model.export()) para ONNX, TensorRT, etc., facilitando a implantação. - Rastreamento: O YOLOE suporta o rastreamento de objetos (

yolo track) quando integrado, útil para rastrear classes solicitadas em vídeos.

Nota

YOLOE inclui automaticamente máscaras de segmentação nos resultados da inferência (results[0].masks), simplificando tarefas com precisão de pixel, como extração ou medição de objetos, sem a necessidade de modelos separados.

Começando

Configure rapidamente o YOLOE com Ultralytics seguindo estes passos:

Instalação: Instale ou atualize o pacote Ultralytics:

pip install -U ultralyticsBaixar Pesos YOLOE: Modelos YOLOE pré-treinados (por exemplo, YOLOE-v8-S/L, variantes YOLOE-11) estão disponíveis nos lançamentos do YOLOE no GitHub. Basta baixar o seu desejado

.ptarquivo para carregar na classe YOLO da Ultralytics.Requisitos de Hardware:

- Inferência: GPU recomendada (NVIDIA com ≥4-8GB VRAM). Modelos pequenos rodam eficientemente em GPUs de borda (por exemplo, Jetson) ou CPUs em resoluções mais baixas. Para inferência de alto desempenho em estações de trabalho compactas, consulte nosso guia NVIDIA DGX Spark.

- Treinamento: O ajuste fino do YOLOE em dados personalizados normalmente requer apenas uma GPU. O extenso pré-treinamento de vocabulário aberto (LVIS/Objects365) usado pelos autores exigiu computação substancial (8× GPUs RTX 4090).

Configuração: As configurações do YOLOE usam arquivos YAML Ultralytics padrão. Configurações padrão (por exemplo,

yoloe-26s-seg.yaml) normalmente são suficientes, mas você pode modificar o backbone, as classes ou o tamanho da imagem conforme necessário.Executando o YOLOE:

- Inferência rápida (sem prompt):

yolo predict model=yoloe-26s-seg-pf.pt source="image.jpg" Detecção com prompt (exemplo de prompt de texto):

from ultralytics import YOLO model = YOLO("yoloe-26s-seg.pt") model.set_classes(["bowl", "apple"]) results = model.predict("kitchen.jpg") results[0].save()

- Inferência rápida (sem prompt):

Dicas de Integração:

- Nomes de classe: As saídas padrão do YOLOE usam categorias LVIS; use

set_classes()para especificar seus próprios rótulos. - Velocidade: O YOLOE não tem sobrecarga, a menos que use prompts. Os prompts de texto têm um impacto mínimo; os prompts visuais um pouco mais.

- NMS: O YOLOE utiliza automaticamente

agnostic_nms=Truedurante a previsão, mesclando caixas sobrepostas entre classes. Isso evita detecções duplicadas quando o mesmo objeto corresponde a várias categorias no grande vocabulário do YOLOE (mais de 1200 classes LVIS). Você pode substituir isso passandoagnostic_nms=Falseexplicitamente. - Inferência em lote: Suportado diretamente (

model.predict([img1, img2])). Para prompts específicos da imagem, execute as imagens individualmente.

- Nomes de classe: As saídas padrão do YOLOE usam categorias LVIS; use

A documentação da Ultralytics fornece recursos adicionais. O YOLOE permite que você explore facilmente poderosas capacidades de mundo aberto dentro do ecossistema YOLO familiar.

Dica

Dica Profissional: Para maximizar a precisão zero-shot do YOLOE, ajuste a partir dos checkpoints fornecidos em vez de treinar do zero. Use palavras de prompt alinhadas com rótulos de treinamento comuns (consulte as categorias LVIS) para melhorar a precisão da detecção.

Citações e Agradecimentos

Se o YOLOE contribuiu para sua pesquisa ou projeto, cite o artigo original de Ao Wang, Lihao Liu, Hui Chen, Zijia Lin, Jungong Han e Guiguang Ding da Universidade de Tsinghua:

@misc{wang2025yoloerealtimeseeing,

title={YOLOE: Real-Time Seeing Anything},

author={Ao Wang and Lihao Liu and Hui Chen and Zijia Lin and Jungong Han and Guiguang Ding},

year={2025},

eprint={2503.07465},

archivePrefix={arXiv},

primaryClass={cs.CV},

url={https://arxiv.org/abs/2503.07465},

}

Para mais informações, o artigo original do YOLOE está disponível no arXiv. O código fonte do projeto e recursos adicionais podem ser acedidos através do repositório GitHub.

FAQ

Como o YOLOE difere do YOLO-World?

Embora tanto o YOLOE quanto o YOLO-World permitam a detecção de vocabulário aberto, o YOLOE oferece várias vantagens. O YOLOE alcança +3,5 AP de maior precisão no LVIS, usando 3× menos recursos de treinamento e rodando 1,4× mais rápido do que o YOLO-Worldv2. O YOLOE também oferece suporte a três modos de prompting (texto, visual e vocabulário interno), enquanto o YOLO-World se concentra principalmente em prompts de texto. Além disso, o YOLOE inclui recursos integrados de segmentação de instâncias, fornecendo máscaras com precisão de pixel para objetos detectados, sem sobrecarga adicional.

Posso usar o YOLOE como um modelo YOLO regular?

Sim, o YOLOE pode funcionar exatamente como um modelo YOLO padrão, sem perda de desempenho. Quando usado no modo de conjunto fechado (sem prompts), os módulos de vocabulário aberto do YOLOE são reparametrizados no cabeçalho de deteção padrão, resultando em velocidade e precisão idênticas aos modelos YOLO11 equivalentes. Isso torna o YOLOE extremamente versátil - você pode usá-lo como um detetor tradicional para velocidade máxima e, em seguida, mudar para o modo de vocabulário aberto apenas quando necessário.

Que tipos de prompts posso usar com o YOLOE?

O YOLOE suporta três tipos de prompts:

- Text prompts: Especifique as classes de objetos usando linguagem natural (por exemplo, "pessoa", "semáforo", "scooter de pássaros")

- Prompts visuais: Forneça imagens de referência dos objetos que deseja detetar

- Vocabulário interno: Use o vocabulário interno do YOLOE de mais de 1200 categorias sem prompts externos

Essa flexibilidade permite que você adapte o YOLOE a vários cenários sem retreinar o modelo, tornando-o particularmente útil para ambientes dinâmicos onde os requisitos de detecção mudam frequentemente.

Como o YOLOE lida com a segmentação de instâncias?

O YOLOE integra a segmentação de instâncias diretamente em sua arquitetura, estendendo o cabeçalho de detecção com um ramo de previsão de máscara. Esta abordagem é semelhante ao YOLOv8-Seg, mas funciona para qualquer classe de objeto solicitada. As máscaras de segmentação são automaticamente incluídas nos resultados da inferência e podem ser acessadas através de results[0].masks. Essa abordagem unificada elimina a necessidade de modelos separados de detecção e segmentação, simplificando os fluxos de trabalho para aplicações que exigem limites de objetos com precisão de pixels.

Como o YOLOE lida com a inferência com prompts personalizados?

Semelhante ao YOLO-World, o YOLOE suporta uma estratégia de "prompt-then-detect" que utiliza um vocabulário offline para aumentar a eficiência. Prompts personalizados, como legendas ou categorias de objetos específicos, são pré-codificados e armazenados como embeddings de vocabulário offline. Essa abordagem agiliza o processo de detecção sem exigir retreino. Você pode definir dinamicamente esses prompts dentro do modelo para adaptá-lo a tarefas de detecção específicas:

from ultralytics import YOLO

# Initialize a YOLOE model

model = YOLO("yoloe-26s-seg.pt")

# Define custom classes

model.set_classes(["person", "bus"])

# Execute prediction on an image

results = model.predict("path/to/image.jpg")

# Show results

results[0].show()