YOLOv7: Bag-of-Freebies Treinável

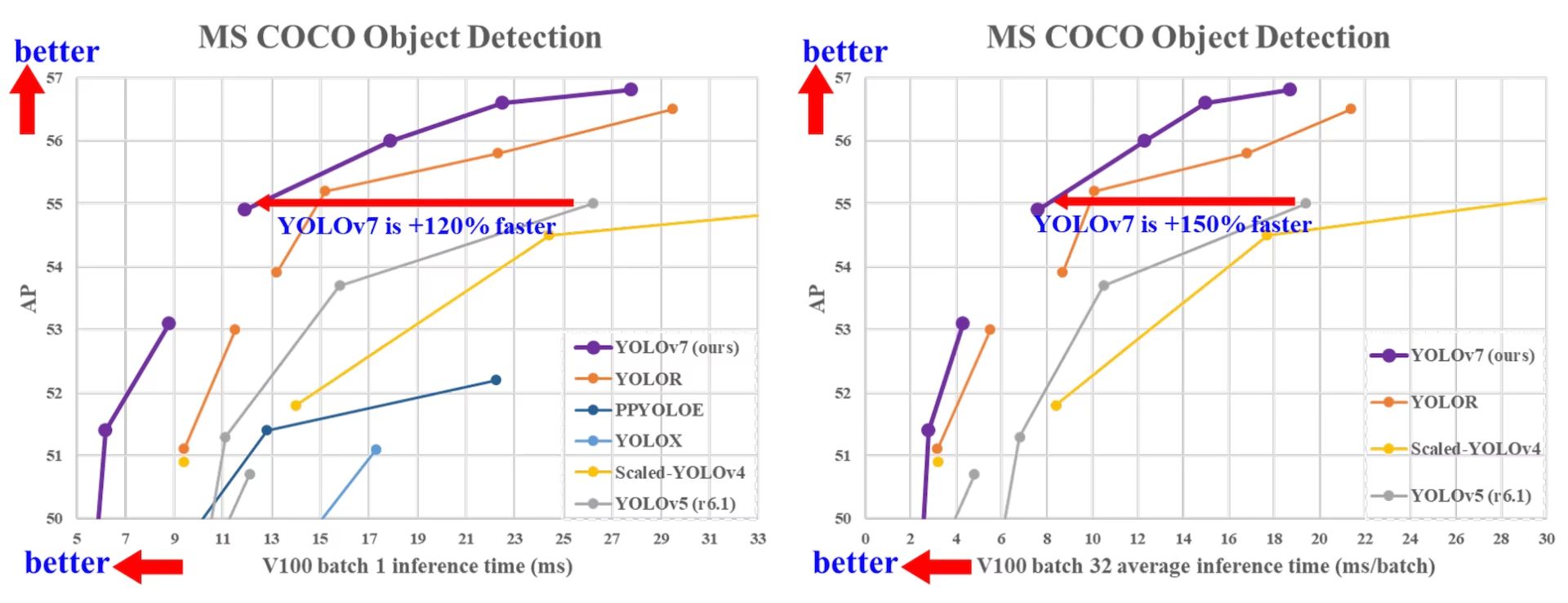

O YOLOv7, lançado em julho de 2022, foi um avanço significativo na detecção de objetos em tempo real em seu lançamento. Ele alcançou 56,8% AP em GPU V100, estabelecendo novos benchmarks quando introduzido. O YOLOv7 superou detectores de objetos contemporâneos como YOLOR, YOLOX, Scaled-YOLOv4 e YOLOv5 em velocidade e precisão. O modelo é treinado no dataset MS COCO do zero, sem usar outros datasets ou pesos pré-treinados. O código-fonte do YOLOv7 está disponível no GitHub. Observe que modelos mais recentes como YOLO11 e YOLO26 alcançaram desde então maior precisão com eficiência aprimorada.

Comparação de detectores de objetos SOTA

A partir dos resultados na tabela de comparação do YOLO, sabemos que o método proposto tem a melhor relação velocidade-precisão de forma abrangente. Se compararmos o YOLOv7-tiny-SiLU com o YOLOv5-N (r6.1), nosso método é 127 fps mais rápido e 10,7% mais preciso em AP. Além disso, o YOLOv7 tem 51,4% de AP a uma taxa de quadros de 161 fps, enquanto o PPYOLOE-L com o mesmo AP tem apenas 78 fps de taxa de quadros. Em termos de uso de parâmetros, o YOLOv7 é 41% menor que o PPYOLOE-L.

Se compararmos YOLOv7-X com velocidade de inferência de 114 fps com YOLOv5-L (r6.1) com velocidade de inferência de 99 fps, YOLOv7-X pode melhorar o AP em 3,9%. Se YOLOv7-X for comparado com YOLOv5-X (r6.1) de escala semelhante, a velocidade de inferência de YOLOv7-X é 31 fps mais rápida. Além disso, em termos de quantidade de parâmetros e computação, YOLOv7-X reduz 22% dos parâmetros e 8% da computação em comparação com YOLOv5-X (r6.1), mas melhora o AP em 2,2% (Fonte).

Desempenho

| Modelo | Parâmetros (M) | FLOPs (G) | Tamanho (pixels) | FPS | APteste / val 50-95 | APteste 50 | APteste 75 | APteste S | APteste M | APteste L |

|---|---|---|---|---|---|---|---|---|---|---|

| YOLOX-S | 9.0 | 26.8 | 640 | 102 | 40.5% / 40.5% | - | - | - | - | - |

| YOLOX-M | 25.3 | 73.8 | 640 | 81 | 47.2% / 46.9% | - | - | - | - | - |

| YOLOX-L | 54.2 | 155.6 | 640 | 69 | 50.1% / 49.7% | - | - | - | - | - |

| YOLOX-X | 99.1 | 281.9 | 640 | 58 | 51.5% / 51.1% | - | - | - | - | - |

| PPYOLOE-S | 7.9 | 17.4 | 640 | 208 | 43.1% / 42.7% | 60.5% | 46.6% | 23.2% | 46.4% | 56.9% |

| PPYOLOE-M | 23.4 | 49.9 | 640 | 123 | 48.9% / 48.6% | 66.5% | 53.0% | 28.6% | 52.9% | 63.8% |

| PPYOLOE-L | 52.2 | 110.1 | 640 | 78 | 51.4% / 50.9% | 68.9% | 55.6% | 31.4% | 55.3% | 66.1% |

| PPYOLOE-X | 98.4 | 206.6 | 640 | 45 | 52.2% / 51.9% | 69.9% | 56.5% | 33.3% | 56.3% | 66.4% |

| YOLOv5-N (r6.1) | 1.9 | 4.5 | 640 | 159 | - / 28.0% | - | - | - | - | - |

| YOLOv5-S (r6.1) | 7.2 | 16.5 | 640 | 156 | - / 37.4% | - | - | - | - | - |

| YOLOv5-M (r6.1) | 21.2 | 49.0 | 640 | 122 | - / 45.4% | - | - | - | - | - |

| YOLOv5-L (r6.1) | 46.5 | 109.1 | 640 | 99 | - / 49.0% | - | - | - | - | - |

| YOLOv5-X (r6.1) | 86.7 | 205.7 | 640 | 83 | - / 50.7% | - | - | - | - | - |

| YOLOR-CSP | 52.9 | 120.4 | 640 | 106 | 51.1% / 50.8% | 69.6% | 55.7% | 31.7% | 55.3% | 64.7% |

| YOLOR-CSP-X | 96.9 | 226.8 | 640 | 87 | 53.0% / 52.7% | 71.4% | 57.9% | 33.7% | 57.1% | 66.8% |

| YOLOv7-tiny-SiLU | 6.2 | 13.8 | 640 | 286 | 38.7% / 38.7% | 56.7% | 41.7% | 18.8% | 42.4% | 51.9% |

| YOLOv7 | 36.9 | 104.7 | 640 | 161 | 51.4% / 51.2% | 69.7% | 55.9% | 31.8% | 55.5% | 65.0% |

| YOLOv7-X | 71.3 | 189.9 | 640 | 114 | 53.1% / 52.9% | 71.2% | 57.8% | 33.8% | 57.1% | 67.4% |

| YOLOv5-N6 (r6.1) | 3.2 | 18.4 | 1280 | 123 | - / 36.0% | - | - | - | - | - |

| YOLOv5-S6 (r6.1) | 12.6 | 67.2 | 1280 | 122 | - / 44.8% | - | - | - | - | - |

| YOLOv5-M6 (r6.1) | 35.7 | 200.0 | 1280 | 90 | - / 51.3% | - | - | - | - | - |

| YOLOv5-L6 (r6.1) | 76.8 | 445.6 | 1280 | 63 | - / 53.7% | - | - | - | - | - |

| YOLOv5-X6 (r6.1) | 140.7 | 839.2 | 1280 | 38 | - / 55.0% | - | - | - | - | - |

| YOLOR-P6 | 37.2 | 325.6 | 1280 | 76 | 53.9% / 53.5% | 71.4% | 58.9% | 36.1% | 57.7% | 65.6% |

| YOLOR-W6 | 79.8 | 453.2 | 1280 | 66 | 55.2% / 54.8% | 72.7% | 60.5% | 37.7% | 59.1% | 67.1% |

| YOLOR-E6 | 115.8 | 683.2 | 1280 | 45 | 55.8% / 55.7% | 73.4% | 61.1% | 38.4% | 59.7% | 67.7% |

| YOLOR-D6 | 151.7 | 935.6 | 1280 | 34 | 56.5% / 56.1% | 74.1% | 61.9% | 38.9% | 60.4% | 68.7% |

| YOLOv7-W6 | 70.4 | 360.0 | 1280 | 84 | 54.9% / 54.6% | 72.6% | 60.1% | 37.3% | 58.7% | 67.1% |

| YOLOv7-E6 | 97.2 | 515.2 | 1280 | 56 | 56.0% / 55.9% | 73.5% | 61.2% | 38.0% | 59.9% | 68.4% |

| YOLOv7-D6 | 154.7 | 806.8 | 1280 | 44 | 56.6% / 56.3% | 74.0% | 61.8% | 38.8% | 60.1% | 69.5% |

| YOLOv7-E6E | 151.7 | 843.2 | 1280 | 36 | 56.8% / 56.8% | 74.4% | 62.1% | 39.3% | 60.5% | 69.0% |

Visão geral

A detecção de objetos em tempo real é um componente importante em muitos sistemas de visão computacional, incluindo rastreamento multi-objeto, direção autónoma, robótica e análise de imagem médica. Nos últimos anos, o desenvolvimento da detecção de objetos em tempo real tem-se concentrado na conceção de arquiteturas eficientes e na melhoria da velocidade de inferência de várias CPUs, GPUs e unidades de processamento neural (NPUs). O YOLOv7 suporta dispositivos móveis GPU e GPU, desde a borda até à nuvem.

Ao contrário dos detetores de objetos em tempo real tradicionais que se concentram na otimização da arquitetura, o YOLOv7 introduz um foco na otimização do processo de treino. Isto inclui módulos e métodos de otimização projetados para melhorar a precisão da deteção de objetos sem aumentar o custo de inferência, um conceito conhecido como "trainable bag-of-freebies".

Principais Características

YOLOv7 introduz vários recursos principais:

Re-parametrização do Modelo: YOLOv7 propõe um modelo re-parametrizado planejado, que é uma estratégia aplicável a camadas em diferentes redes com o conceito de caminho de propagação de gradiente.

Atribuição Dinâmica de Rótulos: O treinamento do modelo com múltiplas camadas de saída apresenta um novo problema: "Como atribuir alvos dinâmicos para as saídas de diferentes ramificações?" Para resolver este problema, o YOLOv7 introduz um novo método de atribuição de rótulos chamado atribuição de rótulos guiada de forma grossa a refinada.

Escalonamento Extendido e Composto: YOLOv7 propõe métodos de "escalonamento estendido e composto" para o detector de objetos em tempo real que pode utilizar parâmetros e computação de forma eficaz.

Eficiência: O método proposto pelo YOLOv7 pode efetivamente reduzir cerca de 40% dos parâmetros e 50% da computação do detector de objetos em tempo real de última geração, e tem velocidade de inferência mais rápida e maior precisão de detecção.

Exemplos de uso

Até o momento da redação, a Ultralytics suporta apenas a inferência ONNX e TensorRT para YOLOv7.

Exportação ONNX

Para usar o modelo YOLOv7 ONNX com Ultralytics:

(Opcional) Instale o Ultralytics e exporte um modelo ONNX para ter as dependências necessárias instaladas automaticamente:

pip install ultralytics yolo export model=yolo26n.pt format=onnxExporte o modelo YOLOv7 desejado usando o exportador no repositório YOLOv7:

git clone https://github.com/WongKinYiu/yolov7 cd yolov7 python export.py --weights yolov7-tiny.pt --grid --end2end --simplify --topk-all 100 --iou-thres 0.65 --conf-thres 0.35 --img-size 640 640 --max-wh 640Modifique o gráfico do modelo ONNX para ser compatível com Ultralytics usando o seguinte script:

import numpy as np import onnx from onnx import helper, numpy_helper # Load the ONNX model model_path = "yolov7/yolov7-tiny.onnx" # Replace with your model path model = onnx.load(model_path) graph = model.graph # Fix input shape to batch size 1 input_shape = graph.input[0].type.tensor_type.shape input_shape.dim[0].dim_value = 1 # Define the output of the original model original_output_name = graph.output[0].name # Create slicing nodes sliced_output_name = f"{original_output_name}_sliced" # Define initializers for slicing (remove the first value) start = numpy_helper.from_array(np.array([1], dtype=np.int64), name="slice_start") end = numpy_helper.from_array(np.array([7], dtype=np.int64), name="slice_end") axes = numpy_helper.from_array(np.array([1], dtype=np.int64), name="slice_axes") steps = numpy_helper.from_array(np.array([1], dtype=np.int64), name="slice_steps") graph.initializer.extend([start, end, axes, steps]) slice_node = helper.make_node( "Slice", inputs=[original_output_name, "slice_start", "slice_end", "slice_axes", "slice_steps"], outputs=[sliced_output_name], name="SliceNode", ) graph.node.append(slice_node) # Define segment slicing seg1_start = numpy_helper.from_array(np.array([0], dtype=np.int64), name="seg1_start") seg1_end = numpy_helper.from_array(np.array([4], dtype=np.int64), name="seg1_end") seg2_start = numpy_helper.from_array(np.array([4], dtype=np.int64), name="seg2_start") seg2_end = numpy_helper.from_array(np.array([5], dtype=np.int64), name="seg2_end") seg3_start = numpy_helper.from_array(np.array([5], dtype=np.int64), name="seg3_start") seg3_end = numpy_helper.from_array(np.array([6], dtype=np.int64), name="seg3_end") graph.initializer.extend([seg1_start, seg1_end, seg2_start, seg2_end, seg3_start, seg3_end]) # Create intermediate tensors for segments segment_1_name = f"{sliced_output_name}_segment1" segment_2_name = f"{sliced_output_name}_segment2" segment_3_name = f"{sliced_output_name}_segment3" # Add segment slicing nodes graph.node.extend( [ helper.make_node( "Slice", inputs=[sliced_output_name, "seg1_start", "seg1_end", "slice_axes", "slice_steps"], outputs=[segment_1_name], name="SliceSegment1", ), helper.make_node( "Slice", inputs=[sliced_output_name, "seg2_start", "seg2_end", "slice_axes", "slice_steps"], outputs=[segment_2_name], name="SliceSegment2", ), helper.make_node( "Slice", inputs=[sliced_output_name, "seg3_start", "seg3_end", "slice_axes", "slice_steps"], outputs=[segment_3_name], name="SliceSegment3", ), ] ) # Concatenate the segments concat_output_name = f"{sliced_output_name}_concat" concat_node = helper.make_node( "Concat", inputs=[segment_1_name, segment_3_name, segment_2_name], outputs=[concat_output_name], axis=1, name="ConcatSwapped", ) graph.node.append(concat_node) # Reshape to [1, -1, 6] reshape_shape = numpy_helper.from_array(np.array([1, -1, 6], dtype=np.int64), name="reshape_shape") graph.initializer.append(reshape_shape) final_output_name = f"{concat_output_name}_batched" reshape_node = helper.make_node( "Reshape", inputs=[concat_output_name, "reshape_shape"], outputs=[final_output_name], name="AddBatchDimension", ) graph.node.append(reshape_node) # Get the shape of the reshaped tensor shape_node_name = f"{final_output_name}_shape" shape_node = helper.make_node( "Shape", inputs=[final_output_name], outputs=[shape_node_name], name="GetShapeDim", ) graph.node.append(shape_node) # Extract the second dimension dim_1_index = numpy_helper.from_array(np.array([1], dtype=np.int64), name="dim_1_index") graph.initializer.append(dim_1_index) second_dim_name = f"{final_output_name}_dim1" gather_node = helper.make_node( "Gather", inputs=[shape_node_name, "dim_1_index"], outputs=[second_dim_name], name="GatherSecondDim", ) graph.node.append(gather_node) # Subtract from 100 to determine how many values to pad target_size = numpy_helper.from_array(np.array([100], dtype=np.int64), name="target_size") graph.initializer.append(target_size) pad_size_name = f"{second_dim_name}_padsize" sub_node = helper.make_node( "Sub", inputs=["target_size", second_dim_name], outputs=[pad_size_name], name="CalculatePadSize", ) graph.node.append(sub_node) # Build the [2, 3] pad array: # 1st row -> [0, 0, 0] (no padding at the start of any dim) # 2nd row -> [0, pad_size, 0] (pad only at the end of the second dim) pad_starts = numpy_helper.from_array(np.array([0, 0, 0], dtype=np.int64), name="pad_starts") graph.initializer.append(pad_starts) zero_scalar = numpy_helper.from_array(np.array([0], dtype=np.int64), name="zero_scalar") graph.initializer.append(zero_scalar) pad_ends_name = "pad_ends" concat_pad_ends_node = helper.make_node( "Concat", inputs=["zero_scalar", pad_size_name, "zero_scalar"], outputs=[pad_ends_name], axis=0, name="ConcatPadEnds", ) graph.node.append(concat_pad_ends_node) pad_values_name = "pad_values" concat_pad_node = helper.make_node( "Concat", inputs=["pad_starts", pad_ends_name], outputs=[pad_values_name], axis=0, name="ConcatPadStartsEnds", ) graph.node.append(concat_pad_node) # Create Pad operator to pad with zeros pad_output_name = f"{final_output_name}_padded" pad_constant_value = numpy_helper.from_array( np.array([0.0], dtype=np.float32), name="pad_constant_value", ) graph.initializer.append(pad_constant_value) pad_node = helper.make_node( "Pad", inputs=[final_output_name, pad_values_name, "pad_constant_value"], outputs=[pad_output_name], mode="constant", name="PadToFixedSize", ) graph.node.append(pad_node) # Update the graph's final output to [1, 100, 6] new_output_type = onnx.helper.make_tensor_type_proto( elem_type=graph.output[0].type.tensor_type.elem_type, shape=[1, 100, 6] ) new_output = onnx.helper.make_value_info(name=pad_output_name, type_proto=new_output_type) # Replace the old output with the new one graph.output.pop() graph.output.extend([new_output]) # Save the modified model onnx.save(model, "yolov7-ultralytics.onnx")Em seguida, você pode carregar o modelo ONNX modificado e executar a inferência com ele no Ultralytics normalmente:

from ultralytics import ASSETS, YOLO model = YOLO("yolov7-ultralytics.onnx", task="detect") results = model(ASSETS / "bus.jpg")

Exportação TensorRT

Siga os passos 1-2 na seção Exportação ONNX.

Instale o

TensorRTPacote Python:pip install tensorrtExecute o seguinte script para converter o modelo ONNX modificado para o motor TensorRT:

from ultralytics.utils.export import export_engine export_engine("yolov7-ultralytics.onnx", half=True)Carregue e execute o modelo no Ultralytics:

from ultralytics import ASSETS, YOLO model = YOLO("yolov7-ultralytics.engine", task="detect") results = model(ASSETS / "bus.jpg")

Citações e Agradecimentos

Gostaríamos de agradecer aos autores do YOLOv7 pelas suas contribuições significativas no campo da deteção de objetos em tempo real:

@article{wang2022yolov7,

title={YOLOv7: Trainable bag-of-freebies sets new state-of-the-art for real-time object detectors},

author={Wang, Chien-Yao and Bochkovskiy, Alexey and Liao, Hong-Yuan Mark},

journal={arXiv preprint arXiv:2207.02696},

year={2022}

}

O artigo original do YOLOv7 pode ser encontrado no arXiv. Os autores disponibilizaram seu trabalho publicamente, e o código pode ser acessado no GitHub. Agradecemos seus esforços em avançar o campo e tornar seu trabalho acessível à comunidade em geral.

FAQ

O que é o YOLOv7 e por que ele é considerado um avanço na detecção de objetos em tempo real?

O YOLOv7, lançado em julho de 2022, foi um modelo significativo de detecção de objetos em tempo real que alcançou excelente velocidade e precisão em seu lançamento. Ele superou modelos contemporâneos como YOLOX, YOLOv5 e PPYOLOE tanto no uso de parâmetros quanto na velocidade de inferência. As características distintivas do YOLOv7 incluem sua re-parametrização de modelo e atribuição dinâmica de rótulos, que otimizam seu desempenho sem aumentar os custos de inferência. Para mais detalhes técnicos sobre sua arquitetura e métricas de comparação com outros detectores de objetos de última geração, consulte o artigo do YOLOv7.

Como o YOLOv7 melhora os modelos YOLO anteriores, como YOLOv4 e YOLOv5?

YOLOv7 introduz várias inovações, incluindo reparametrização de modelo e atribuição dinâmica de rótulos, que aprimoram o processo de treinamento e melhoram a precisão da inferência. Comparado ao YOLOv5, YOLOv7 aumenta significativamente a velocidade e a precisão. Por exemplo, YOLOv7-X melhora a precisão em 2,2% e reduz os parâmetros em 22% em comparação com YOLOv5-X. Comparações detalhadas podem ser encontradas na tabela de desempenho Comparação do YOLOv7 com detectores de objetos SOTA.

Posso usar YOLOv7 com as ferramentas e plataformas Ultralytics?

Atualmente, a Ultralytics suporta apenas a inferência ONNX e TensorRT do YOLOv7. Para executar a versão exportada ONNX e TensorRT do YOLOv7 com a Ultralytics, consulte a seção Exemplos de Uso.

Como treino um modelo YOLOv7 personalizado usando meu conjunto de dados?

Para instalar e treinar um modelo YOLOv7 personalizado, siga estes passos:

- Clone o repositório YOLOv7:

git clone https://github.com/WongKinYiu/yolov7 - Navegue até o diretório clonado e instale as dependências:

cd yolov7 pip install -r requirements.txt Prepare seu conjunto de dados e configure os parâmetros do modelo de acordo com as instruções de uso fornecidas no repositório. Para obter mais orientações, visite o repositório YOLOv7 no GitHub para obter as informações e atualizações mais recentes.

Após o treinamento, você pode exportar o modelo para ONNX ou TensorRT para uso em Ultralytics, conforme mostrado em Exemplos de Uso.

Quais são os principais recursos e otimizações introduzidas no YOLOv7?

YOLOv7 oferece vários recursos importantes que revolucionam a detecção de objetos em tempo real:

- Re-parametrização do Modelo: Melhora o desempenho do modelo otimizando os caminhos de propagação do gradiente.

- Atribuição Dinâmica de Rótulos: Utiliza um método guiado de forma grosseira a precisa para atribuir alvos dinâmicos para saídas em diferentes ramificações, melhorando a precisão.

- Escalonamento Estendido e Composto: Utiliza eficientemente parâmetros e computação para escalar o modelo para várias aplicações em tempo real.

- Eficiência: Reduz a contagem de parâmetros em 40% e a computação em 50% em comparação com outros modelos de ponta, ao mesmo tempo que alcança velocidades de inferência mais rápidas.

Para mais detalhes sobre estas funcionalidades, consulte a secção Visão Geral do YOLOv7.