Xuất Intel OpenVINO

Trong hướng dẫn này, chúng tôi đề cập đến việc xuất các mô hình YOLO26 sang định dạng OpenVINO, có thể tăng tốc độ CPU lên tới 3 lần, cũng như tăng tốc suy luận YOLO trên phần cứng GPU và NPU của Intel.

OpenVINO, viết tắt của bộ công cụ Open Visual Inference & Neural Network Optimization, là một bộ công cụ toàn diện để tối ưu hóa và triển khai các mô hình suy luận AI. Mặc dù tên có chứa Visual, OpenVINO cũng hỗ trợ nhiều tác vụ bổ sung khác nhau bao gồm ngôn ngữ, âm thanh, chuỗi thời gian, v.v.

Xem: Cách xuất Ultralytics YOLO26 sang định dạng Intel OpenVINO để suy luận nhanh hơn 🚀

Ví dụ sử dụng

Xuất một mô hình YOLO26n sang định dạng OpenVINO và chạy suy luận với mô hình đã xuất.

Ví dụ

from ultralytics import YOLO

# Load a YOLO26n PyTorch model

model = YOLO("yolo26n.pt")

# Export the model

model.export(format="openvino") # creates 'yolo26n_openvino_model/'

# Load the exported OpenVINO model

ov_model = YOLO("yolo26n_openvino_model/")

# Run inference

results = ov_model("https://ultralytics.com/images/bus.jpg")

# Run inference with specified device, available devices: ["intel:gpu", "intel:npu", "intel:cpu"]

results = ov_model("https://ultralytics.com/images/bus.jpg", device="intel:gpu")

# Export a YOLO26n PyTorch model to OpenVINO format

yolo export model=yolo26n.pt format=openvino # creates 'yolo26n_openvino_model/'

# Run inference with the exported model

yolo predict model=yolo26n_openvino_model source='https://ultralytics.com/images/bus.jpg'

# Run inference with specified device, available devices: ["intel:gpu", "intel:npu", "intel:cpu"]

yolo predict model=yolo26n_openvino_model source='https://ultralytics.com/images/bus.jpg' device="intel:gpu"

Các đối số xuất

| Đối số | Loại | Mặc định | Mô tả |

|---|---|---|---|

format | str | 'openvino' | Dạng mục tiêu cho mô hình được xuất, xác định khả năng tương thích với các môi trường triển khai khác nhau. |

imgsz | int hoặc tuple | 640 | Kích thước hình ảnh mong muốn cho đầu vào của mô hình. Có thể là một số nguyên cho hình ảnh vuông hoặc một bộ giá trị (height, width) cho các kích thước cụ thể. |

half | bool | False | Cho phép lượng tử hóa FP16 (nửa độ chính xác), giảm kích thước mô hình và có khả năng tăng tốc độ suy luận trên phần cứng được hỗ trợ. |

int8 | bool | False | Kích hoạt lượng tử hóa INT8, nén thêm mô hình và tăng tốc độ suy luận với mức giảm độ chính xác tối thiểu, chủ yếu dành cho các thiết bị biên. |

dynamic | bool | False | Cho phép kích thước đầu vào động, tăng cường tính linh hoạt trong việc xử lý các kích thước hình ảnh khác nhau. |

nms | bool | False | Thêm Non-Maximum Suppression (NMS), cần thiết cho quá trình hậu xử lý detect chính xác và hiệu quả. |

batch | int | 1 | Chỉ định kích thước suy luận theo lô của mô hình xuất hoặc số lượng hình ảnh tối đa mà mô hình đã xuất sẽ xử lý đồng thời ở chế độ predict chế độ. |

data | str | 'coco8.yaml' | Đường dẫn đến tập dữ liệu tệp cấu hình (mặc định: coco8.yaml), cần thiết cho lượng tử hóa. |

fraction | float | 1.0 | Chỉ định tỷ lệ phần trăm của tập dữ liệu được sử dụng để hiệu chỉnh lượng tử hóa INT8. Cho phép hiệu chỉnh trên một tập hợp con của toàn bộ tập dữ liệu, hữu ích cho các thử nghiệm hoặc khi tài nguyên bị hạn chế. Nếu không được chỉ định khi bật INT8, toàn bộ tập dữ liệu sẽ được sử dụng. |

Để biết thêm chi tiết về quy trình xuất, hãy truy cập trang tài liệu Ultralytics về xuất.

Cảnh báo

OpenVINO™ tương thích với hầu hết các bộ xử lý Intel®, nhưng để đảm bảo hiệu suất tối ưu:

Xác minh hỗ trợ OpenVINO™: Kiểm tra xem chip Intel® của bạn có được OpenVINO™ chính thức hỗ trợ hay không bằng cách sử dụng danh sách tương thích của Intel.

Xác định bộ tăng tốc của bạn: Xác định xem bộ xử lý của bạn có bao gồm NPU tích hợp (Bộ xử lý thần kinh) hay GPU (GPU tích hợp) hay không bằng cách tham khảo hướng dẫn phần cứng của Intel.

Cài đặt trình điều khiển mới nhất: Nếu chip của bạn hỗ trợ NPU hoặc GPU nhưng OpenVINO™ không phát hiện được, bạn có thể cần cài đặt hoặc cập nhật các trình điều khiển liên quan. Làm theo hướng dẫn cài đặt trình điều khiển để bật tăng tốc hoàn toàn.

Bằng cách thực hiện theo ba bước này, bạn có thể đảm bảo OpenVINO™ chạy tối ưu trên phần cứng Intel® của bạn.

Lợi ích của OpenVINO

- Hiệu năng: OpenVINO mang lại khả năng suy luận hiệu năng cao bằng cách sử dụng sức mạnh của CPU Intel, GPU tích hợp và rời, và FPGA.

- Hỗ trợ thực thi không đồng nhất: OpenVINO cung cấp một API để viết một lần và triển khai trên mọi phần cứng Intel được hỗ trợ (CPU, GPU, FPGA, VPU, v.v.).

- Trình tối ưu hóa mô hình: OpenVINO cung cấp Trình tối ưu hóa mô hình để nhập, chuyển đổi và tối ưu hóa các mô hình từ các framework học sâu phổ biến như PyTorch, TensorFlow, TensorFlow Lite, Keras, ONNX, PaddlePaddle và Caffe.

- Dễ sử dụng: Bộ công cụ đi kèm với hơn 80 notebook hướng dẫn (bao gồm tối ưu hóa YOLOv8) hướng dẫn các khía cạnh khác nhau của bộ công cụ.

Cấu trúc Xuất OpenVINO

Khi bạn xuất một mô hình sang định dạng OpenVINO, nó sẽ tạo ra một thư mục chứa các thành phần sau:

- Tệp XML: Mô tả cấu trúc liên kết mạng.

- Tệp BIN: Chứa dữ liệu nhị phân về trọng số và độ chệch.

- Tệp ánh xạ: Chứa ánh xạ của các tensor đầu ra mô hình gốc tới tên tensor OpenVINO.

Bạn có thể sử dụng các tệp này để chạy suy luận với OpenVINO Inference Engine.

Sử dụng Xuất OpenVINO trong Triển khai

Sau khi mô hình của bạn được xuất thành công sang định dạng OpenVINO, bạn có hai tùy chọn chính để chạy inference:

Sử dụng

ultralyticsgói, cung cấp API cấp cao và bao gồm OpenVINO Runtime.Sử dụng gốc

openvinogói để kiểm soát nâng cao hoặc tùy chỉnh hơn đối với hành vi suy luận.

Suy luận với Ultralytics

Gói ultralytics cho phép bạn dễ dàng chạy suy luận bằng mô hình OpenVINO đã xuất thông qua phương thức predict. Bạn cũng có thể chỉ định thiết bị đích (ví dụ: intel:gpu, intel:npu, intel:cpu) bằng cách sử dụng đối số device.

from ultralytics import YOLO

# Load the exported OpenVINO model

ov_model = YOLO("yolo26n_openvino_model/") # the path of your exported OpenVINO model

# Run inference with the exported model

ov_model.predict(device="intel:gpu") # specify the device you want to run inference on

Cách tiếp cận này lý tưởng cho việc tạo mẫu hoặc triển khai nhanh chóng khi bạn không cần toàn quyền kiểm soát quy trình suy luận.

Suy luận với OpenVINO Runtime

OpenVINO Runtime cung cấp một API thống nhất để suy luận trên tất cả phần cứng Intel được hỗ trợ. Nó cũng cung cấp các khả năng nâng cao như cân bằng tải trên phần cứng Intel và thực thi không đồng bộ. Để biết thêm thông tin về việc chạy suy luận, hãy tham khảo các sổ tay YOLO26.

Hãy nhớ rằng, bạn sẽ cần các tệp XML và BIN cũng như bất kỳ cài đặt dành riêng cho ứng dụng nào như kích thước đầu vào, hệ số tỷ lệ để chuẩn hóa, v.v., để thiết lập và sử dụng mô hình một cách chính xác với Runtime.

Trong ứng dụng triển khai của bạn, bạn thường sẽ thực hiện các bước sau:

- Khởi tạo OpenVINO bằng cách tạo

core = Core(). - Tải mô hình bằng

core.read_model()phương thức. - Biên dịch mô hình bằng cách sử dụng

core.compile_model()function. - Chuẩn bị dữ liệu đầu vào (ảnh, văn bản, âm thanh, v.v.).

- Chạy suy luận bằng

compiled_model(input_data).

Để biết thêm các bước chi tiết và đoạn mã, hãy tham khảo tài liệu OpenVINO hoặc hướng dẫn API.

Điểm chuẩn OpenVINO YOLO11

Nhóm Ultralytics đã đánh giá YOLO11 trên nhiều định dạng mô hình và độ chính xác, đánh giá tốc độ và độ chính xác trên các thiết bị Intel khác nhau tương thích với OpenVINO.

Lưu ý

Các kết quả đánh giá hiệu năng dưới đây chỉ mang tính tham khảo và có thể thay đổi tùy thuộc vào cấu hình phần cứng và phần mềm chính xác của một hệ thống, cũng như khối lượng công việc hiện tại của hệ thống tại thời điểm chạy đánh giá.

Tất cả các điểm chuẩn chạy với openvino Phiên bản gói Python 2025.1.0.

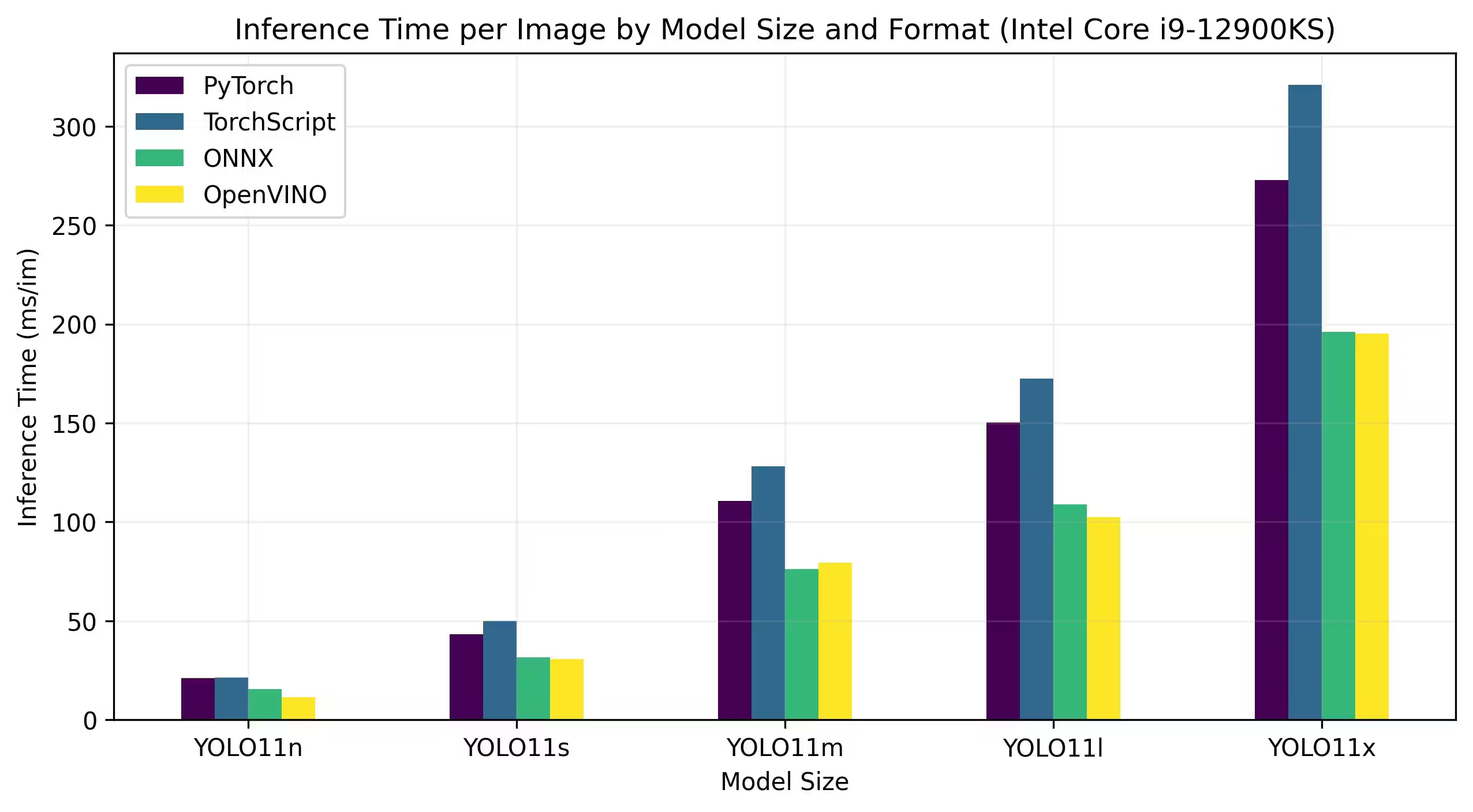

Intel Core CPU

Intel® Core® series là một dòng bộ xử lý hiệu năng cao của Intel. Dòng sản phẩm này bao gồm Core i3 (cấp thấp), Core i5 (tầm trung), Core i7 (cao cấp) và Core i9 (hiệu năng cực cao). Mỗi series phục vụ cho các nhu cầu và ngân sách điện toán khác nhau, từ các tác vụ hàng ngày đến khối lượng công việc chuyên nghiệp đòi hỏi khắt khe. Với mỗi thế hệ mới, những cải tiến được thực hiện đối với hiệu suất, hiệu quả năng lượng và các tính năng.

Các điểm chuẩn dưới đây chạy trên CPU Intel® Core® i9-12900KS thế hệ thứ 12 ở độ chính xác FP32.

Kết quả Điểm chuẩn Chi tiết

| Mô hình | Định dạng | Trạng thái | Kích thước (MB) | chỉ số/mAP50-95(B) | Thời gian suy luận (ms/ảnh) |

|---|---|---|---|---|---|

| YOLO11n | PyTorch | ✅ | 5.4 | 0.5071 | 21.00 |

| YOLO11n | TorchScript | ✅ | 10.5 | 0.5077 | 21.39 |

| YOLO11n | ONNX | ✅ | 10.2 | 0.5077 | 15.55 |

| YOLO11n | OpenVINO | ✅ | 10.4 | 0.5077 | 11.49 |

| YOLO11s | PyTorch | ✅ | 18.4 | 0.5770 | 43.16 |

| YOLO11s | TorchScript | ✅ | 36.6 | 0.5781 | 50.06 |

| YOLO11s | ONNX | ✅ | 36.3 | 0.5781 | 31.53 |

| YOLO11s | OpenVINO | ✅ | 36.4 | 0.5781 | 30.82 |

| YOLO11m | PyTorch | ✅ | 38.8 | 0.6257 | 110.60 |

| YOLO11m | TorchScript | ✅ | 77.3 | 0.6306 | 128.09 |

| YOLO11m | ONNX | ✅ | 76.9 | 0.6306 | 76.06 |

| YOLO11m | OpenVINO | ✅ | 77.1 | 0.6306 | 79.38 |

| YOLO11l | PyTorch | ✅ | 49.0 | 0.6367 | 150.38 |

| YOLO11l | TorchScript | ✅ | 97.7 | 0.6408 | 172.57 |

| YOLO11l | ONNX | ✅ | 97.0 | 0.6408 | 108.91 |

| YOLO11l | OpenVINO | ✅ | 97.3 | 0.6408 | 102.30 |

| YOLO11x | PyTorch | ✅ | 109.3 | 0.6989 | 272.72 |

| YOLO11x | TorchScript | ✅ | 218.1 | 0.6900 | 320.86 |

| YOLO11x | ONNX | ✅ | 217.5 | 0.6900 | 196.20 |

| YOLO11x | OpenVINO | ✅ | 217.8 | 0.6900 | 195.32 |

Intel® Core™ Ultra

Dòng Intel® Core™ Ultra™ đại diện cho một chuẩn mực mới trong điện toán hiệu năng cao, được thiết kế để đáp ứng nhu cầu ngày càng tăng của người dùng hiện đại — từ game thủ và nhà sáng tạo đến các chuyên gia tận dụng AI. Dòng sản phẩm thế hệ tiếp theo này không chỉ là một dòng CPU truyền thống; nó kết hợp các lõi CPU mạnh mẽ, khả năng GPU hiệu năng cao tích hợp và Bộ xử lý thần kinh (NPU) chuyên dụng trong một chip duy nhất, cung cấp một giải pháp thống nhất cho các khối lượng công việc điện toán đa dạng và chuyên sâu.

Trọng tâm của kiến trúc Intel® Core Ultra™ là thiết kế kết hợp cho phép hiệu suất vượt trội trên các tác vụ xử lý truyền thống, khối lượng công việc được tăng tốc bằng GPU và các hoạt động dựa trên AI. Việc bao gồm NPU tăng cường suy luận AI trên thiết bị, cho phép máy học và xử lý dữ liệu nhanh hơn, hiệu quả hơn trên một loạt các ứng dụng.

Dòng Core Ultra™ bao gồm nhiều kiểu máy khác nhau được thiết kế riêng cho các nhu cầu hiệu suất khác nhau, với các tùy chọn từ thiết kế tiết kiệm năng lượng đến các biến thể công suất cao được đánh dấu bằng ký hiệu "H"—lý tưởng cho máy tính xách tay và các yếu tố hình thức nhỏ gọn đòi hỏi sức mạnh tính toán nghiêm túc. Trong toàn bộ dòng sản phẩm, người dùng được hưởng lợi từ sự kết hợp giữa CPU, GPU và tích hợp NPU, mang lại hiệu quả, khả năng phản hồi và khả năng đa nhiệm vượt trội.

Là một phần trong quá trình đổi mới liên tục của Intel, dòng Core Ultra™ đặt ra một tiêu chuẩn mới cho điện toán sẵn sàng cho tương lai. Với nhiều mẫu máy có sẵn và nhiều mẫu khác sắp ra mắt, dòng sản phẩm này nhấn mạnh cam kết của Intel trong việc cung cấp các giải pháp tiên tiến cho thế hệ thiết bị thông minh, tăng cường AI tiếp theo.

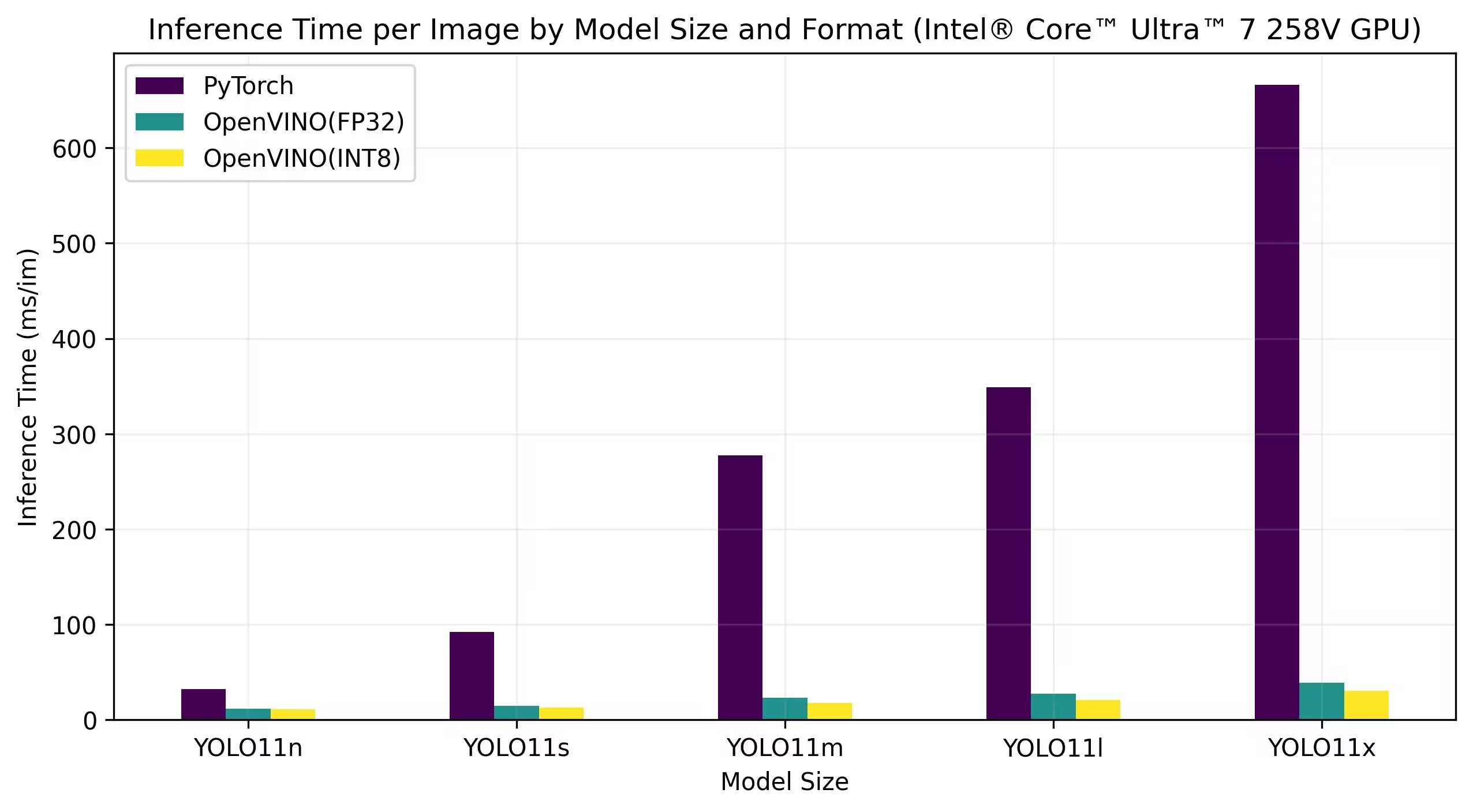

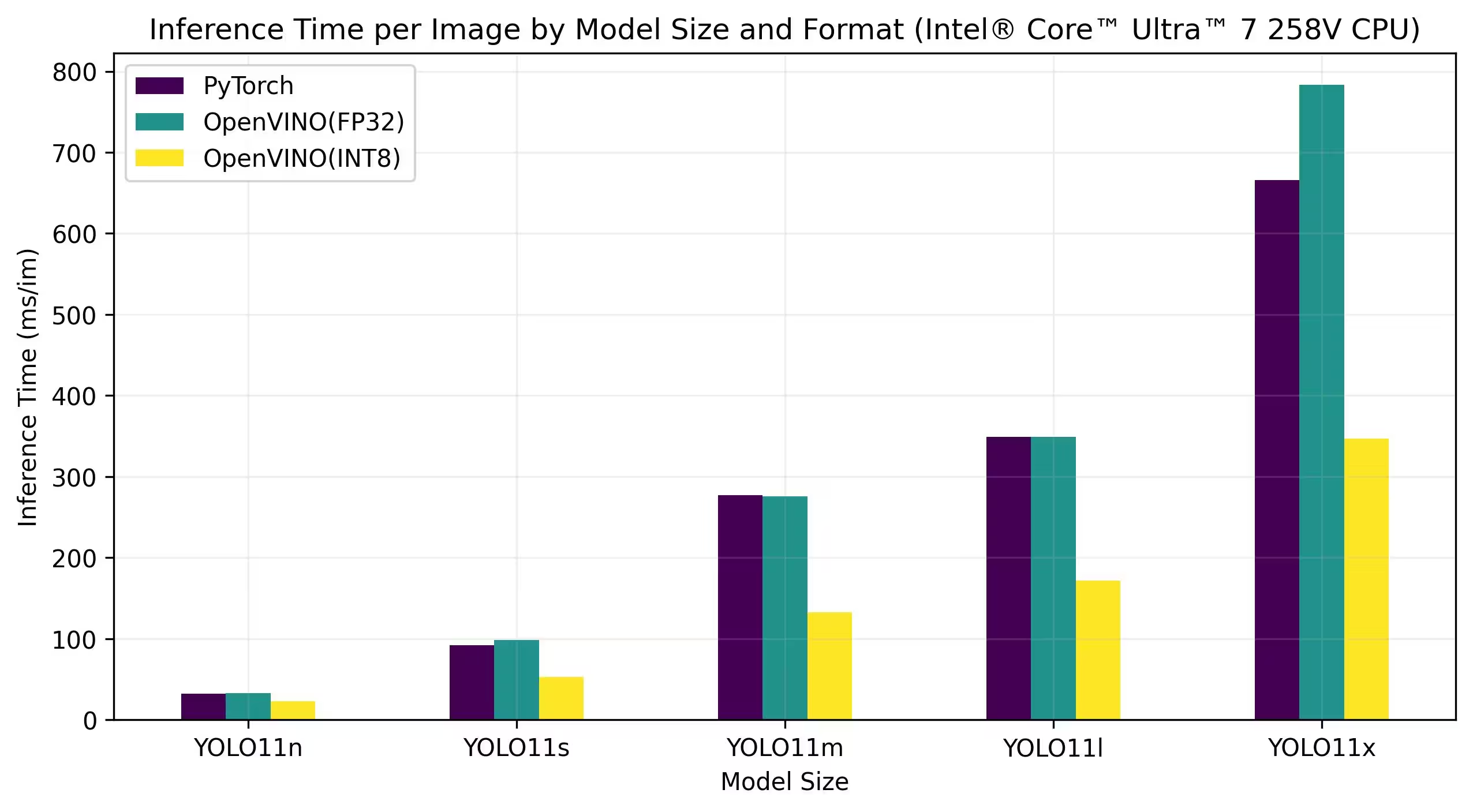

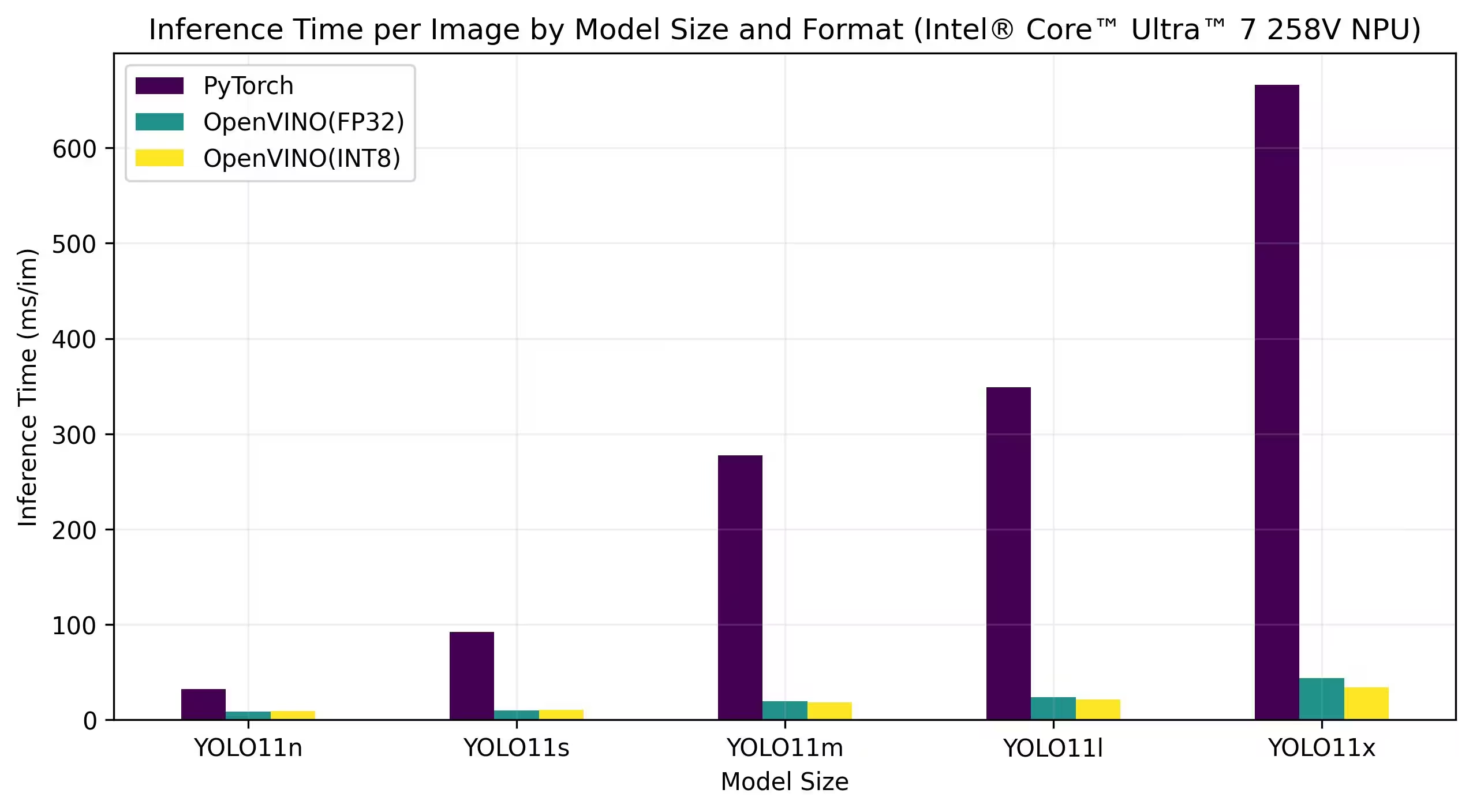

Điểm chuẩn dưới đây chạy trên Intel® Core™ Ultra™ 7 258V và Intel® Core™ Ultra™ 7 265K ở độ chính xác FP32 và INT8.

Intel® Core™ Ultra™ 7 258V

Điểm chuẩn

Kết quả Điểm chuẩn Chi tiết

| Mô hình | Định dạng | Độ chính xác | Trạng thái | Kích thước (MB) | chỉ số/mAP50-95(B) | Thời gian suy luận (ms/ảnh) |

|---|---|---|---|---|---|---|

| YOLO11n | PyTorch | FP32 | ✅ | 5.4 | 0.5052 | 32.27 |

| YOLO11n | OpenVINO | FP32 | ✅ | 10.4 | 0.5068 | 11.84 |

| YOLO11n | OpenVINO | INT8 | ✅ | 3.3 | 0.4969 | 11.24 |

| YOLO11s | PyTorch | FP32 | ✅ | 18.4 | 0.5776 | 92.09 |

| YOLO11s | OpenVINO | FP32 | ✅ | 36.4 | 0.5797 | 14.82 |

| YOLO11s | OpenVINO | INT8 | ✅ | 9.8 | 0.5751 | 12.88 |

| YOLO11m | PyTorch | FP32 | ✅ | 38.8 | 0.6262 | 277.24 |

| YOLO11m | OpenVINO | FP32 | ✅ | 77.1 | 0.6306 | 22.94 |

| YOLO11m | OpenVINO | INT8 | ✅ | 20.2 | 0.6126 | 17.85 |

| YOLO11l | PyTorch | FP32 | ✅ | 49.0 | 0.6361 | 348.97 |

| YOLO11l | OpenVINO | FP32 | ✅ | 97.3 | 0.6365 | 27.34 |

| YOLO11l | OpenVINO | INT8 | ✅ | 25.7 | 0.6242 | 20.83 |

| YOLO11x | PyTorch | FP32 | ✅ | 109.3 | 0.6984 | 666.07 |

| YOLO11x | OpenVINO | FP32 | ✅ | 217.8 | 0.6890 | 39.09 |

| YOLO11x | OpenVINO | INT8 | ✅ | 55.9 | 0.6856 | 30.60 |

Kết quả Điểm chuẩn Chi tiết

| Mô hình | Định dạng | Độ chính xác | Trạng thái | Kích thước (MB) | chỉ số/mAP50-95(B) | Thời gian suy luận (ms/ảnh) |

|---|---|---|---|---|---|---|

| YOLO11n | PyTorch | FP32 | ✅ | 5.4 | 0.5052 | 32.27 |

| YOLO11n | OpenVINO | FP32 | ✅ | 10.4 | 0.5077 | 32.55 |

| YOLO11n | OpenVINO | INT8 | ✅ | 3.3 | 0.4980 | 22.98 |

| YOLO11s | PyTorch | FP32 | ✅ | 18.4 | 0.5776 | 92.09 |

| YOLO11s | OpenVINO | FP32 | ✅ | 36.4 | 0.5782 | 98.38 |

| YOLO11s | OpenVINO | INT8 | ✅ | 9.8 | 0.5745 | 52.84 |

| YOLO11m | PyTorch | FP32 | ✅ | 38.8 | 0.6262 | 277.24 |

| YOLO11m | OpenVINO | FP32 | ✅ | 77.1 | 0.6307 | 275.74 |

| YOLO11m | OpenVINO | INT8 | ✅ | 20.2 | 0.6172 | 132.63 |

| YOLO11l | PyTorch | FP32 | ✅ | 49.0 | 0.6361 | 348.97 |

| YOLO11l | OpenVINO | FP32 | ✅ | 97.3 | 0.6361 | 348.97 |

| YOLO11l | OpenVINO | INT8 | ✅ | 25.7 | 0.6240 | 171.36 |

| YOLO11x | PyTorch | FP32 | ✅ | 109.3 | 0.6984 | 666.07 |

| YOLO11x | OpenVINO | FP32 | ✅ | 217.8 | 0.6900 | 783.16 |

| YOLO11x | OpenVINO | INT8 | ✅ | 55.9 | 0.6890 | 346.82 |

Kết quả Điểm chuẩn Chi tiết

| Mô hình | Định dạng | Độ chính xác | Trạng thái | Kích thước (MB) | chỉ số/mAP50-95(B) | Thời gian suy luận (ms/ảnh) |

|---|---|---|---|---|---|---|

| YOLO11n | PyTorch | FP32 | ✅ | 5.4 | 0.5052 | 32.27 |

| YOLO11n | OpenVINO | FP32 | ✅ | 10.4 | 0.5085 | 8.33 |

| YOLO11n | OpenVINO | INT8 | ✅ | 3.3 | 0.5019 | 8.91 |

| YOLO11s | PyTorch | FP32 | ✅ | 18.4 | 0.5776 | 92.09 |

| YOLO11s | OpenVINO | FP32 | ✅ | 36.4 | 0.5788 | 9.72 |

| YOLO11s | OpenVINO | INT8 | ✅ | 9.8 | 0.5710 | 10.58 |

| YOLO11m | PyTorch | FP32 | ✅ | 38.8 | 0.6262 | 277.24 |

| YOLO11m | OpenVINO | FP32 | ✅ | 77.1 | 0.6301 | 19.41 |

| YOLO11m | OpenVINO | INT8 | ✅ | 20.2 | 0.6124 | 18.26 |

| YOLO11l | PyTorch | FP32 | ✅ | 49.0 | 0.6361 | 348.97 |

| YOLO11l | OpenVINO | FP32 | ✅ | 97.3 | 0.6362 | 23.70 |

| YOLO11l | OpenVINO | INT8 | ✅ | 25.7 | 0.6240 | 21.40 |

| YOLO11x | PyTorch | FP32 | ✅ | 109.3 | 0.6984 | 666.07 |

| YOLO11x | OpenVINO | FP32 | ✅ | 217.8 | 0.6892 | 43.91 |

| YOLO11x | OpenVINO | INT8 | ✅ | 55.9 | 0.6890 | 34.04 |

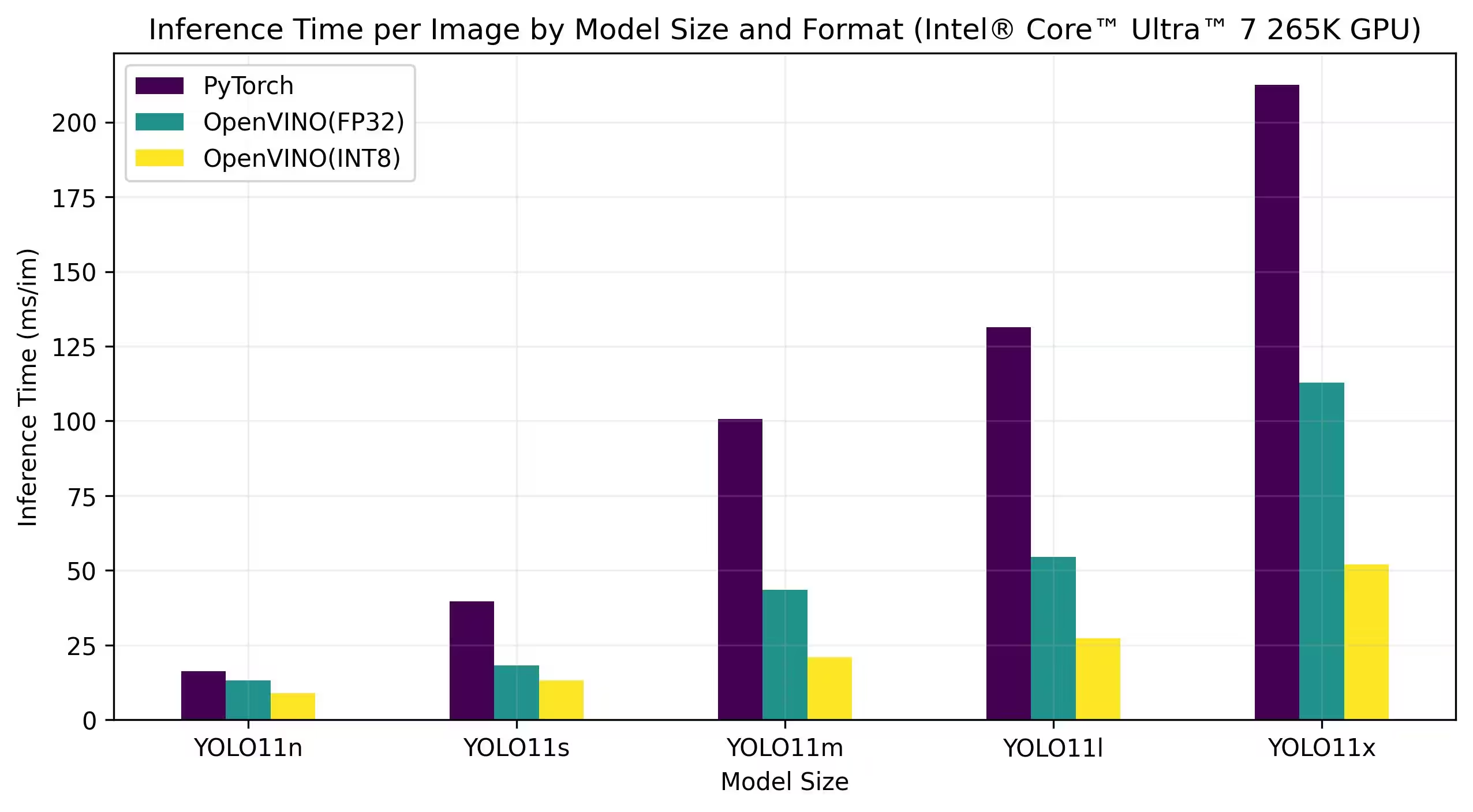

Intel® Core™ Ultra™ 7 265K

Điểm chuẩn

Kết quả Điểm chuẩn Chi tiết

| Mô hình | Định dạng | Độ chính xác | Trạng thái | Kích thước (MB) | chỉ số/mAP50-95(B) | Thời gian suy luận (ms/ảnh) |

|---|---|---|---|---|---|---|

| YOLO11n | PyTorch | FP32 | ✅ | 5.4 | 0.5072 | 16.29 |

| YOLO11n | OpenVINO | FP32 | ✅ | 10.4 | 0.5079 | 13.13 |

| YOLO11n | OpenVINO | INT8 | ✅ | 3.3 | 0.4976 | 8.86 |

| YOLO11s | PyTorch | FP32 | ✅ | 18.4 | 0.5771 | 39.61 |

| YOLO11s | OpenVINO | FP32 | ✅ | 36.4 | 0.5808 | 18.26 |

| YOLO11s | OpenVINO | INT8 | ✅ | 9.8 | 0.5726 | 13.24 |

| YOLO11m | PyTorch | FP32 | ✅ | 38.8 | 0.6258 | 100.65 |

| YOLO11m | OpenVINO | FP32 | ✅ | 77.1 | 0.6310 | 43.50 |

| YOLO11m | OpenVINO | INT8 | ✅ | 20.2 | 0.6137 | 20.90 |

| YOLO11l | PyTorch | FP32 | ✅ | 49.0 | 0.6367 | 131.37 |

| YOLO11l | OpenVINO | FP32 | ✅ | 97.3 | 0.6371 | 54.52 |

| YOLO11l | OpenVINO | INT8 | ✅ | 25.7 | 0.6226 | 27.36 |

| YOLO11x | PyTorch | FP32 | ✅ | 109.3 | 0.6990 | 212.45 |

| YOLO11x | OpenVINO | FP32 | ✅ | 217.8 | 0.6884 | 112.76 |

| YOLO11x | OpenVINO | INT8 | ✅ | 55.9 | 0.6900 | 52.06 |

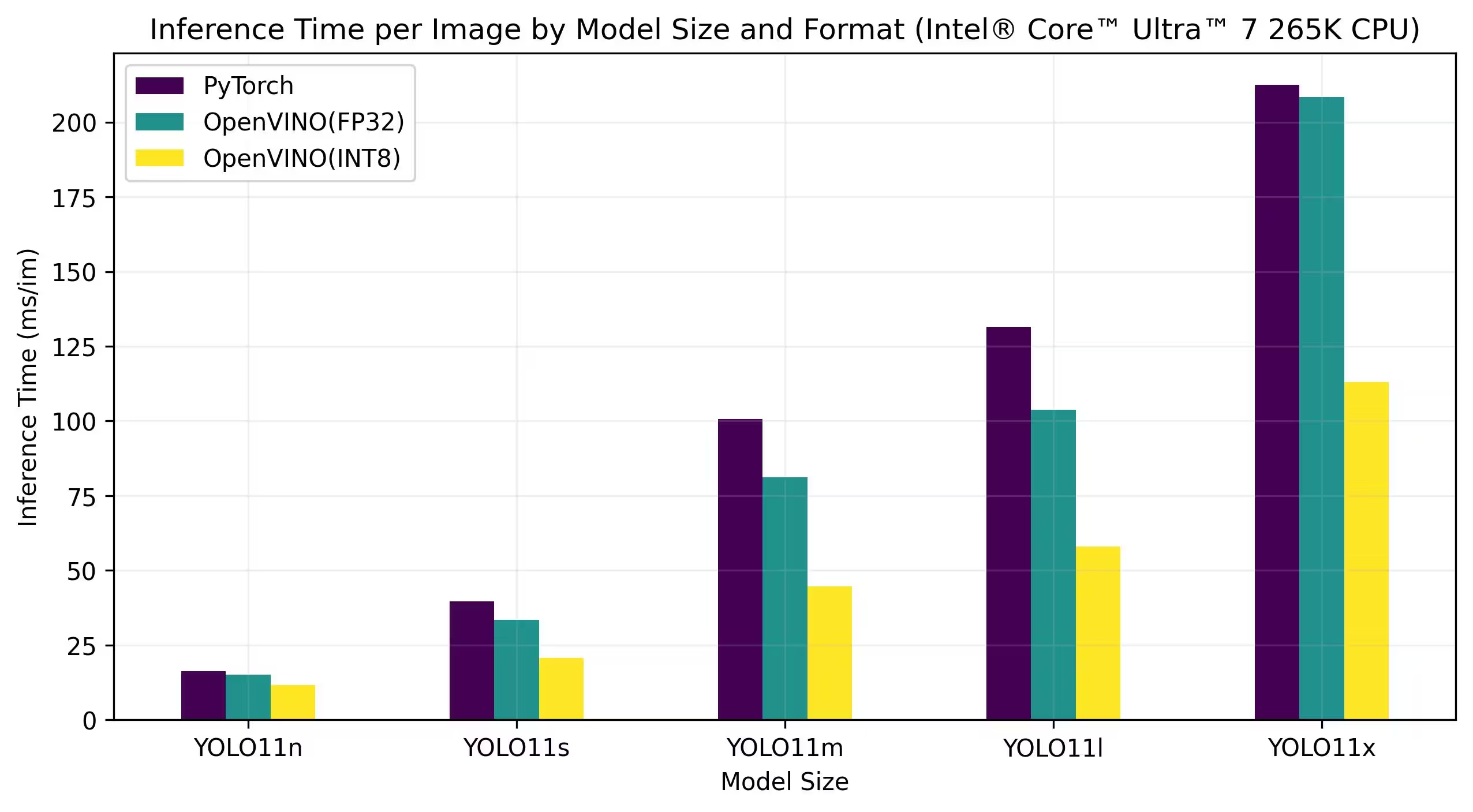

Kết quả Điểm chuẩn Chi tiết

| Mô hình | Định dạng | Độ chính xác | Trạng thái | Kích thước (MB) | chỉ số/mAP50-95(B) | Thời gian suy luận (ms/ảnh) |

|---|---|---|---|---|---|---|

| YOLO11n | PyTorch | FP32 | ✅ | 5.4 | 0.5072 | 16.29 |

| YOLO11n | OpenVINO | FP32 | ✅ | 10.4 | 0.5077 | 15.04 |

| YOLO11n | OpenVINO | INT8 | ✅ | 3.3 | 0.4980 | 11.60 |

| YOLO11s | PyTorch | FP32 | ✅ | 18.4 | 0.5771 | 39.61 |

| YOLO11s | OpenVINO | FP32 | ✅ | 36.4 | 0.5782 | 33.45 |

| YOLO11s | OpenVINO | INT8 | ✅ | 9.8 | 0.5745 | 20.64 |

| YOLO11m | PyTorch | FP32 | ✅ | 38.8 | 0.6258 | 100.65 |

| YOLO11m | OpenVINO | FP32 | ✅ | 77.1 | 0.6307 | 81.15 |

| YOLO11m | OpenVINO | INT8 | ✅ | 20.2 | 0.6172 | 44.63 |

| YOLO11l | PyTorch | FP32 | ✅ | 49.0 | 0.6367 | 131.37 |

| YOLO11l | OpenVINO | FP32 | ✅ | 97.3 | 0.6409 | 103.77 |

| YOLO11l | OpenVINO | INT8 | ✅ | 25.7 | 0.6240 | 58.00 |

| YOLO11x | PyTorch | FP32 | ✅ | 109.3 | 0.6990 | 212.45 |

| YOLO11x | OpenVINO | FP32 | ✅ | 217.8 | 0.6900 | 208.37 |

| YOLO11x | OpenVINO | INT8 | ✅ | 55.9 | 0.6897 | 113.04 |

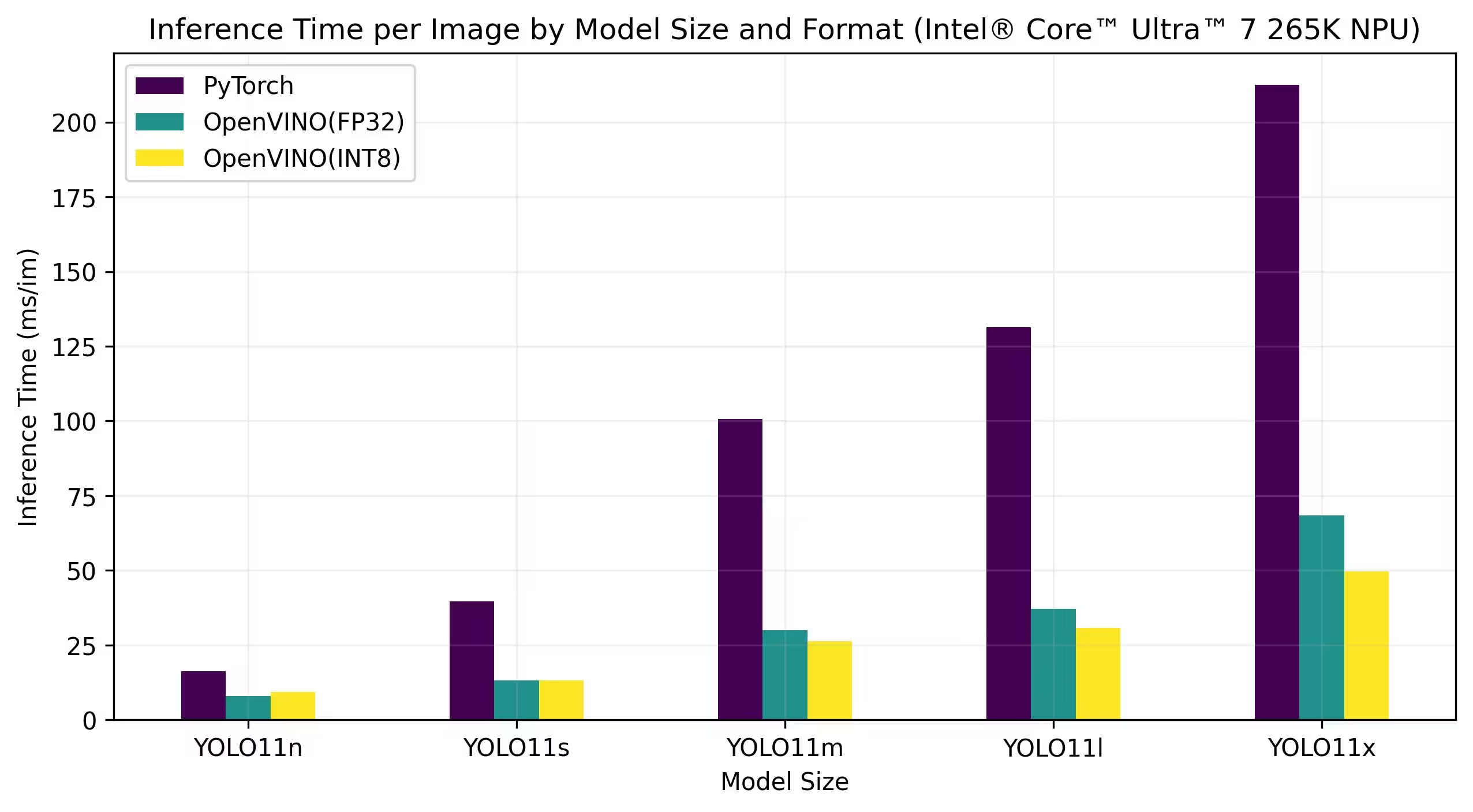

Kết quả Điểm chuẩn Chi tiết

| Mô hình | Định dạng | Độ chính xác | Trạng thái | Kích thước (MB) | chỉ số/mAP50-95(B) | Thời gian suy luận (ms/ảnh) |

|---|---|---|---|---|---|---|

| YOLO11n | PyTorch | FP32 | ✅ | 5.4 | 0.5072 | 16.29 |

| YOLO11n | OpenVINO | FP32 | ✅ | 10.4 | 0.5075 | 8.02 |

| YOLO11n | OpenVINO | INT8 | ✅ | 3.3 | 0.3656 | 9.28 |

| YOLO11s | PyTorch | FP32 | ✅ | 18.4 | 0.5771 | 39.61 |

| YOLO11s | OpenVINO | FP32 | ✅ | 36.4 | 0.5801 | 13.12 |

| YOLO11s | OpenVINO | INT8 | ✅ | 9.8 | 0.5686 | 13.12 |

| YOLO11m | PyTorch | FP32 | ✅ | 38.8 | 0.6258 | 100.65 |

| YOLO11m | OpenVINO | FP32 | ✅ | 77.1 | 0.6310 | 29.88 |

| YOLO11m | OpenVINO | INT8 | ✅ | 20.2 | 0.6111 | 26.32 |

| YOLO11l | PyTorch | FP32 | ✅ | 49.0 | 0.6367 | 131.37 |

| YOLO11l | OpenVINO | FP32 | ✅ | 97.3 | 0.6356 | 37.08 |

| YOLO11l | OpenVINO | INT8 | ✅ | 25.7 | 0.6245 | 30.81 |

| YOLO11x | PyTorch | FP32 | ✅ | 109.3 | 0.6990 | 212.45 |

| YOLO11x | OpenVINO | FP32 | ✅ | 217.8 | 0.6894 | 68.48 |

| YOLO11x | OpenVINO | INT8 | ✅ | 55.9 | 0.6417 | 49.76 |

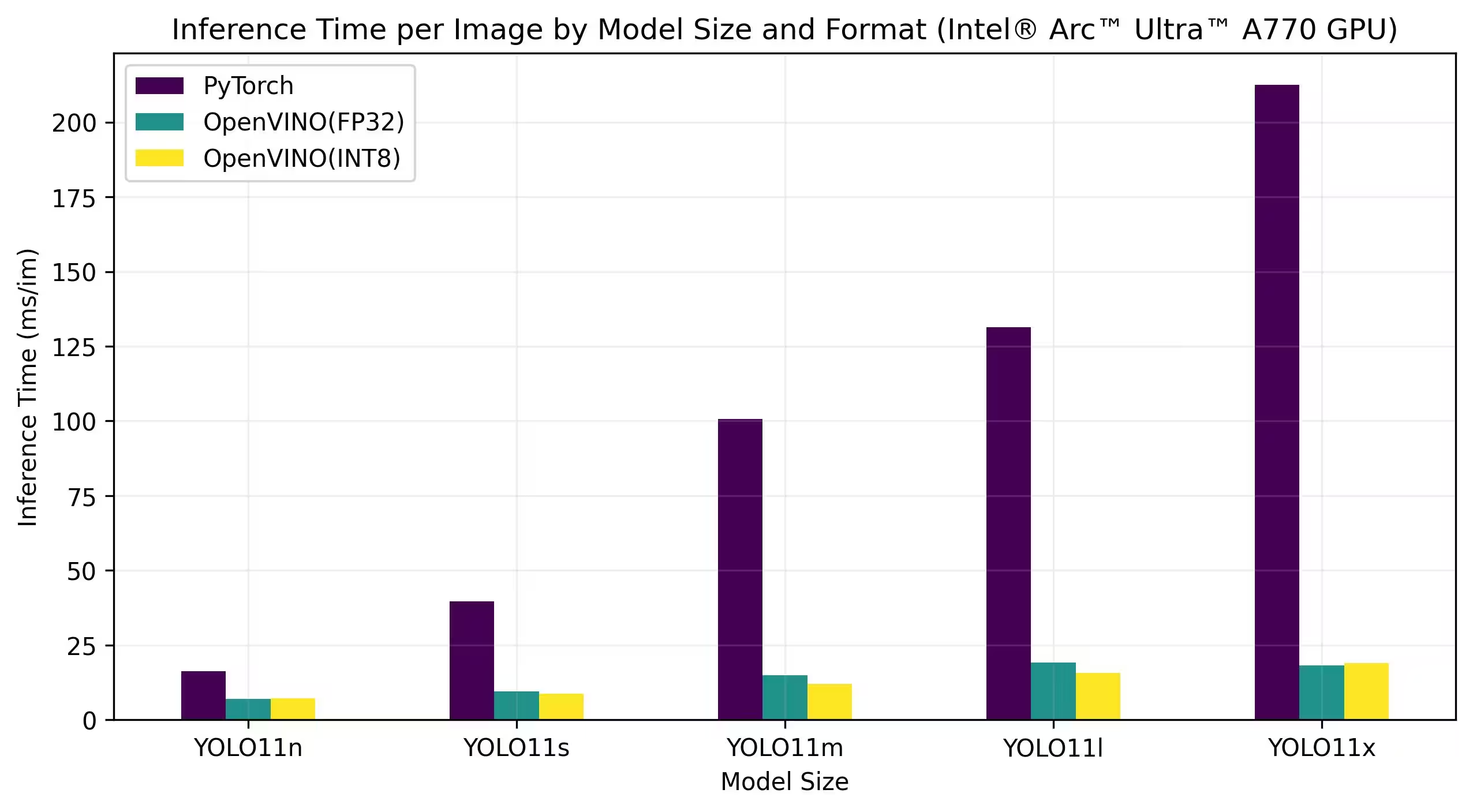

Intel® Arc GPU

Intel® Arc™ là dòng card đồ họa rời của Intel được thiết kế cho các tác vụ chơi game hiệu năng cao, sáng tạo nội dung và AI. Dòng Arc có kiến trúc GPU tiên tiến, hỗ trợ dò tia theo thời gian thực, đồ họa tăng cường AI và chơi game độ phân giải cao. Với trọng tâm là hiệu năng và hiệu quả, Intel® Arc™ hướng đến cạnh tranh với các thương hiệu GPU hàng đầu khác, đồng thời cung cấp các tính năng độc đáo như mã hóa AV1 được tăng tốc phần cứng và hỗ trợ các API đồ họa mới nhất.

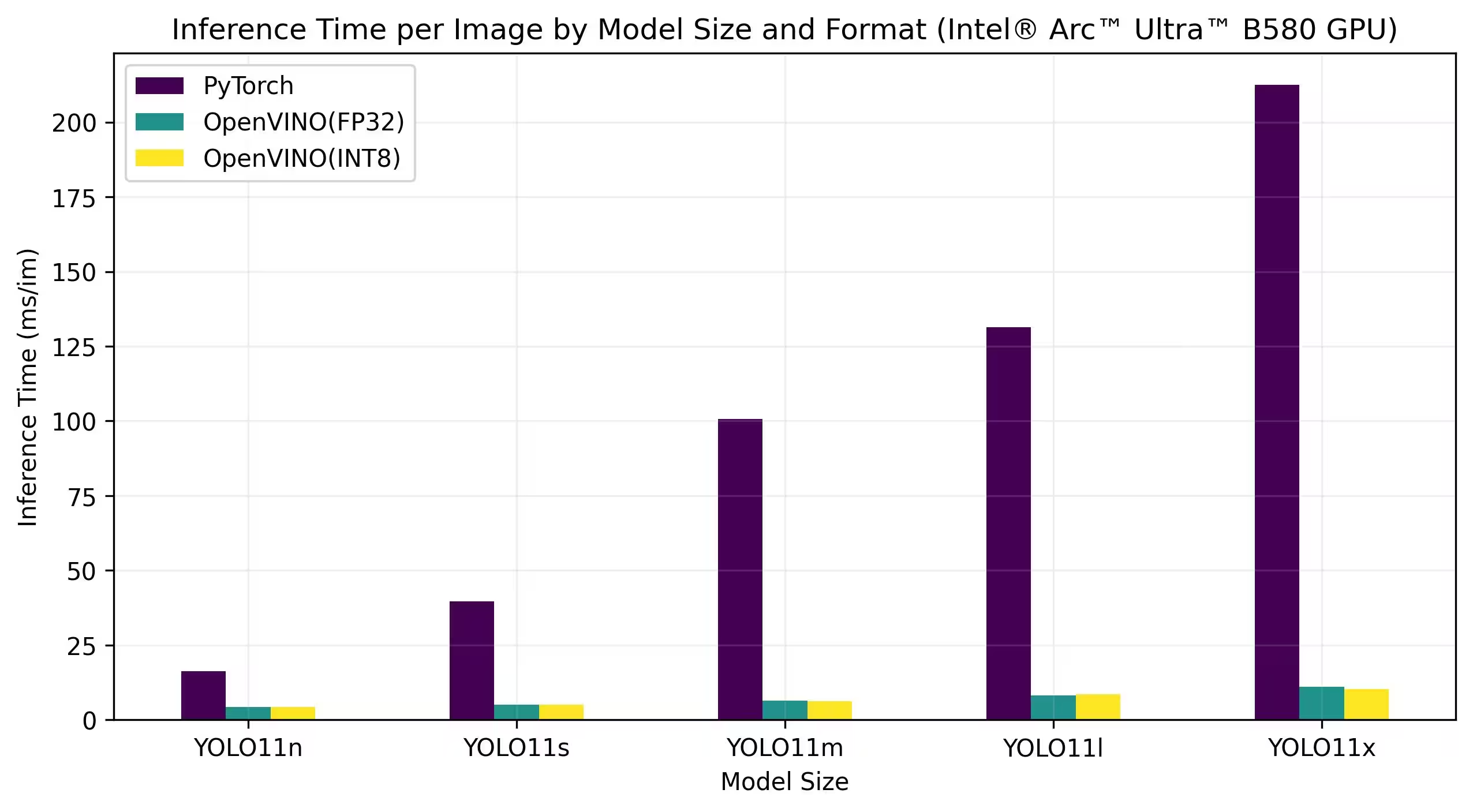

Các điểm chuẩn dưới đây chạy trên Intel Arc A770 và Intel Arc B580 ở độ chính xác FP32 và INT8.

Intel Arc A770

Kết quả Điểm chuẩn Chi tiết

| Mô hình | Định dạng | Độ chính xác | Trạng thái | Kích thước (MB) | chỉ số/mAP50-95(B) | Thời gian suy luận (ms/ảnh) |

|---|---|---|---|---|---|---|

| YOLO11n | PyTorch | FP32 | ✅ | 5.4 | 0.5072 | 16.29 |

| YOLO11n | OpenVINO | FP32 | ✅ | 10.4 | 0.5073 | 6.98 |

| YOLO11n | OpenVINO | INT8 | ✅ | 3.3 | 0.4978 | 7.24 |

| YOLO11s | PyTorch | FP32 | ✅ | 18.4 | 0.5771 | 39.61 |

| YOLO11s | OpenVINO | FP32 | ✅ | 36.4 | 0.5798 | 9.41 |

| YOLO11s | OpenVINO | INT8 | ✅ | 9.8 | 0.5751 | 8.72 |

| YOLO11m | PyTorch | FP32 | ✅ | 38.8 | 0.6258 | 100.65 |

| YOLO11m | OpenVINO | FP32 | ✅ | 77.1 | 0.6311 | 14.88 |

| YOLO11m | OpenVINO | INT8 | ✅ | 20.2 | 0.6126 | 11.97 |

| YOLO11l | PyTorch | FP32 | ✅ | 49.0 | 0.6367 | 131.37 |

| YOLO11l | OpenVINO | FP32 | ✅ | 97.3 | 0.6364 | 19.17 |

| YOLO11l | OpenVINO | INT8 | ✅ | 25.7 | 0.6241 | 15.75 |

| YOLO11x | PyTorch | FP32 | ✅ | 109.3 | 0.6990 | 212.45 |

| YOLO11x | OpenVINO | FP32 | ✅ | 217.8 | 0.6888 | 18.13 |

| YOLO11x | OpenVINO | INT8 | ✅ | 55.9 | 0.6930 | 18.91 |

Intel Arc B580

Kết quả Điểm chuẩn Chi tiết

| Mô hình | Định dạng | Độ chính xác | Trạng thái | Kích thước (MB) | chỉ số/mAP50-95(B) | Thời gian suy luận (ms/ảnh) |

|---|---|---|---|---|---|---|

| YOLO11n | PyTorch | FP32 | ✅ | 5.4 | 0.5072 | 16.29 |

| YOLO11n | OpenVINO | FP32 | ✅ | 10.4 | 0.5072 | 4.27 |

| YOLO11n | OpenVINO | INT8 | ✅ | 3.3 | 0.4981 | 4.33 |

| YOLO11s | PyTorch | FP32 | ✅ | 18.4 | 0.5771 | 39.61 |

| YOLO11s | OpenVINO | FP32 | ✅ | 36.4 | 0.5789 | 5.04 |

| YOLO11s | OpenVINO | INT8 | ✅ | 9.8 | 0.5746 | 4.97 |

| YOLO11m | PyTorch | FP32 | ✅ | 38.8 | 0.6258 | 100.65 |

| YOLO11m | OpenVINO | FP32 | ✅ | 77.1 | 0.6306 | 6.45 |

| YOLO11m | OpenVINO | INT8 | ✅ | 20.2 | 0.6125 | 6.28 |

| YOLO11l | PyTorch | FP32 | ✅ | 49.0 | 0.6367 | 131.37 |

| YOLO11l | OpenVINO | FP32 | ✅ | 97.3 | 0.6360 | 8.23 |

| YOLO11l | OpenVINO | INT8 | ✅ | 25.7 | 0.6236 | 8.49 |

| YOLO11x | PyTorch | FP32 | ✅ | 109.3 | 0.6990 | 212.45 |

| YOLO11x | OpenVINO | FP32 | ✅ | 217.8 | 0.6889 | 11.10 |

| YOLO11x | OpenVINO | INT8 | ✅ | 55.9 | 0.6924 | 10.30 |

Tái tạo Kết quả của Chúng tôi

Để tái tạo các điểm chuẩn Ultralytics ở trên trên tất cả các định dạng xuất, hãy chạy đoạn mã này:

Ví dụ

from ultralytics import YOLO

# Load a YOLO11n PyTorch model

model = YOLO("yolo11n.pt")

# Benchmark YOLO11n speed and accuracy on the COCO128 dataset for all export formats

results = model.benchmark(data="coco128.yaml")

# Benchmark YOLO11n speed and accuracy on the COCO128 dataset for all export formats

yolo benchmark model=yolo11n.pt data=coco128.yaml

Xin lưu ý rằng kết quả đánh giá hiệu năng có thể khác nhau tùy thuộc vào cấu hình phần cứng và phần mềm chính xác của hệ thống, cũng như khối lượng công việc hiện tại của hệ thống tại thời điểm chạy đánh giá. Để có kết quả đáng tin cậy nhất, hãy sử dụng bộ dữ liệu có số lượng lớn hình ảnh, ví dụ: data='coco.yaml' (5000 ảnh val).

Kết luận

Kết quả đánh giá cho thấy rõ lợi ích của việc xuất mô hình YOLO11 sang định dạng OpenVINO. Trên các mô hình và nền tảng phần cứng khác nhau, định dạng OpenVINO luôn vượt trội so với các định dạng khác về tốc độ suy luận trong khi vẫn duy trì độ chính xác tương đương.

Các đánh giá hiệu năng nhấn mạnh tính hiệu quả của OpenVINO như một công cụ để triển khai các mô hình học sâu. Bằng cách chuyển đổi các mô hình sang định dạng OpenVINO, các nhà phát triển có thể đạt được những cải tiến đáng kể về hiệu suất, giúp dễ dàng triển khai các mô hình này trong các ứng dụng thực tế.

Để biết thêm thông tin chi tiết và hướng dẫn về cách sử dụng OpenVINO, hãy tham khảo tài liệu chính thức của OpenVINO.

Câu hỏi thường gặp

Làm cách nào để xuất các mô hình YOLO26 sang định dạng OpenVINO?

Việc xuất các mô hình YOLO26 sang định dạng OpenVINO có thể tăng đáng kể tốc độ CPU và cho phép tăng tốc GPU và NPU trên phần cứng Intel. Để xuất, bạn có thể sử dụng Python hoặc CLI như minh họa dưới đây:

Ví dụ

from ultralytics import YOLO

# Load a YOLO26n PyTorch model

model = YOLO("yolo26n.pt")

# Export the model

model.export(format="openvino") # creates 'yolo26n_openvino_model/'

# Export a YOLO26n PyTorch model to OpenVINO format

yolo export model=yolo26n.pt format=openvino # creates 'yolo26n_openvino_model/'

Để biết thêm thông tin, hãy tham khảo tài liệu về các định dạng xuất.

Lợi ích của việc sử dụng OpenVINO với các mô hình YOLO26 là gì?

Việc sử dụng bộ công cụ OpenVINO của Intel với các mô hình YOLO26 mang lại một số lợi ích:

- Hiệu năng: Đạt được tốc độ nhanh hơn tới 3 lần trên suy luận CPU và tận dụng GPU và NPU của Intel để tăng tốc.

- Trình tối ưu hóa mô hình: Chuyển đổi, tối ưu hóa và thực thi các mô hình từ các framework phổ biến như PyTorch, TensorFlow và ONNX.

- Dễ sử dụng: Hơn 80 sổ tay hướng dẫn có sẵn để giúp người dùng bắt đầu, bao gồm cả những sổ tay dành cho YOLO26.

- Thực thi không đồng nhất: Triển khai các mô hình trên nhiều phần cứng Intel khác nhau với một API thống nhất.

Để so sánh hiệu suất chi tiết, hãy truy cập phần đánh giá của chúng tôi.

Làm cách nào để chạy suy luận bằng mô hình YOLO26 đã xuất sang OpenVINO?

Sau khi xuất một mô hình YOLO26n sang định dạng OpenVINO, bạn có thể chạy suy luận bằng Python hoặc CLI:

Ví dụ

from ultralytics import YOLO

# Load the exported OpenVINO model

ov_model = YOLO("yolo26n_openvino_model/")

# Run inference

results = ov_model("https://ultralytics.com/images/bus.jpg")

# Run inference with the exported model

yolo predict model=yolo26n_openvino_model source='https://ultralytics.com/images/bus.jpg'

Tham khảo tài liệu về chế độ predict của chúng tôi để biết thêm chi tiết.

Tại sao tôi nên chọn Ultralytics YOLO26 thay vì các mô hình khác để xuất sang OpenVINO?

Ultralytics YOLO26 được tối ưu hóa để detect đối tượng theo thời gian thực với độ chính xác và tốc độ cao. Cụ thể, khi kết hợp với OpenVINO, YOLO26 cung cấp:

- Tăng tốc lên đến 3 lần trên CPU Intel

- Triển khai liền mạch trên GPU và NPU của Intel

- Độ chính xác nhất quán và có thể so sánh được trên các định dạng xuất khác nhau

Để phân tích hiệu suất chuyên sâu, hãy xem điểm chuẩn YOLO11 chi tiết của chúng tôi trên các phần cứng khác nhau.

Tôi có thể đánh giá hiệu năng các mô hình YOLO26 trên các định dạng khác nhau như PyTorch, ONNX và OpenVINO không?

Có, bạn có thể đánh giá hiệu năng các mô hình YOLO26 ở nhiều định dạng khác nhau bao gồm PyTorch, TorchScript, ONNX và OpenVINO. Sử dụng đoạn mã sau để chạy đánh giá hiệu năng trên tập dữ liệu đã chọn của bạn:

Ví dụ

from ultralytics import YOLO

# Load a YOLO26n PyTorch model

model = YOLO("yolo26n.pt")

# Benchmark YOLO26n speed and [accuracy](https://www.ultralytics.com/glossary/accuracy) on the COCO8 dataset for all export formats

results = model.benchmark(data="coco8.yaml")

# Benchmark YOLO26n speed and accuracy on the COCO8 dataset for all export formats

yolo benchmark model=yolo26n.pt data=coco8.yaml

Để biết kết quả đánh giá chi tiết, hãy tham khảo phần đánh giá và tài liệu về các định dạng xuất của chúng tôi.