云端训练

Ultralytics Platform 云训练提供云端GPU上的一键式训练,使模型训练无需复杂设置即可进行。训练YOLO模型时,可享受实时指标流和自动检查点保存功能。

graph LR

A[Configure] --> B[Start Training]

B --> C[Provision GPU]

C --> D[Download Dataset]

D --> E[Train]

E --> F[Stream Metrics]

F --> G[Save Checkpoints]

G --> H[Complete]

style A fill:#2196F3,color:#fff

style B fill:#FF9800,color:#fff

style E fill:#9C27B0,color:#fff

style H fill:#4CAF50,color:#fff训练对话

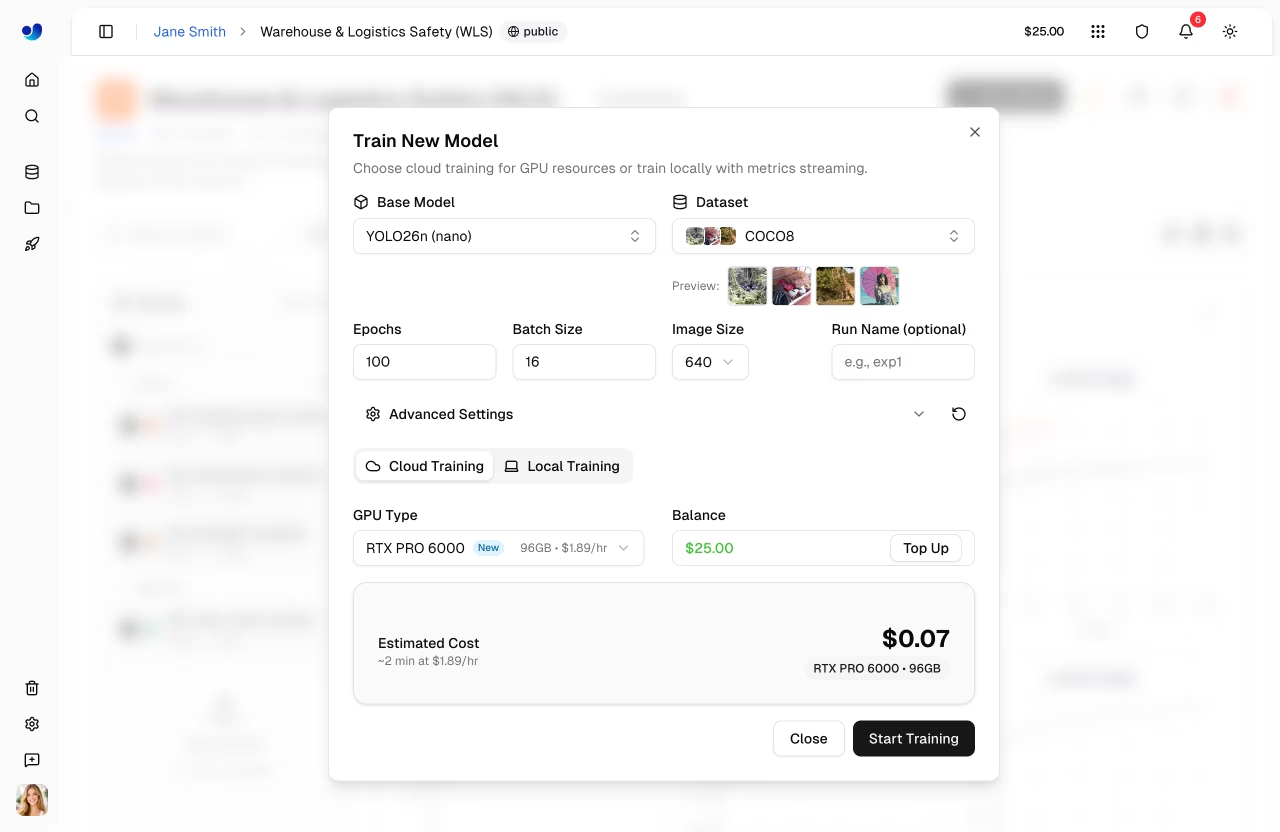

从平台界面开始训练:在任意项目页面点击“新建模型”(或从数据集页面开始训练)。训练对话框包含两个选项卡:云端训练和本地训练。

步骤1:选择基础模型

从官方YOLO26模型或您自己训练的模型中选择:

| 类别 | 描述 |

|---|---|

| 官方 | 全部25个YOLO26模型(5种尺寸×5项任务) |

| 您的模型 | 用于微调的已完成模型 |

官方模型按任务类型(检测、分割、 姿势估计, 旋转框检测、分类),尺寸从nano到xlarge不等。

步骤 2:选择数据集

选择用于训练的数据集(参见数据集):

| 选项 | 描述 |

|---|---|

| 官方 | Ultralytics精选数据集 |

| 您的数据集 | 您已上传的数据集 |

数据集要求

数据集必须为 ready 状态:训练集至少包含1张图像,验证集或测试集至少包含1张图像,且至少包含1张标注图像。

任务错配

若模型任务(例如detect)与数据集任务(例如segment)不匹配,将出现任务不匹配警告。若继续执行不匹配的任务,训练将失败。请确保模型和数据集使用相同的任务类型,具体请参阅任务指南。

步骤3:配置参数

设置核心训练参数:

| 参数 | 描述 | 默认值 |

|---|---|---|

| 训练轮次 | 训练迭代次数 | 100 |

| 批量大小 | 每次迭代的样本数 | 16 |

| 图像大小 | 输入分辨率(320/416/512/640/1280 下拉菜单,或在 YAML 编辑器中为 32-4096) | 640 |

| 运行名称 | 训练跑的可选名称 | auto |

步骤4:高级设置(可选)

展开高级设置以访问完整的基于YAML的参数编辑器,其中包含40多个按组分类的训练参数(参见配置参考):

| 集团 | 参数 |

|---|---|

| 学习率 | lr0, lrf, 动量, 权重衰减, 预热 epoch, 预热动量, 预热偏置学习率 |

| 优化器 | SGD, MuSGD,Adam,AdamW, N亚当, R亚当, RMSProp, Adamax |

| 损失重量 | 盒子, 类, 深度学习框架,姿势估计, 关键帧对象, 标签平滑 |

| 色彩增强 | hsv_h, hsv_s, hsv_v |

| 几何增强。 | 角度、平移、缩放、剪切、透视 |

| 翻转与混合增强。 | 翻转,翻转器,马赛克,混搭,复制粘贴 |

| 训练控制 | 耐心, 种子, 确定性, 放大器, cos_lr, 闭合马赛克, 保存周期 |

| 数据集 | 分数,冻结,单类,矩形,多尺度,恢复 |

参数具有任务感知能力(例如, copy_paste 仅显示segment 段任务, pose/kobj 仅用于姿势估计 )。 修改 当值与默认值不同时会显示标记,您可通过重置按钮将所有设置恢复为默认值。

示例:小数据集的调优增强

For small datasets (<1000 images), increase augmentation to reduce overfitting:

mosaic: 1.0 # Keep mosaic on

mixup: 0.3 # Add mixup blending

copy_paste: 0.3 # Add copy-paste (segment only)

fliplr: 0.5 # Horizontal flip

degrees: 10.0 # Slight rotation

scale: 0.9 # Aggressive scaling

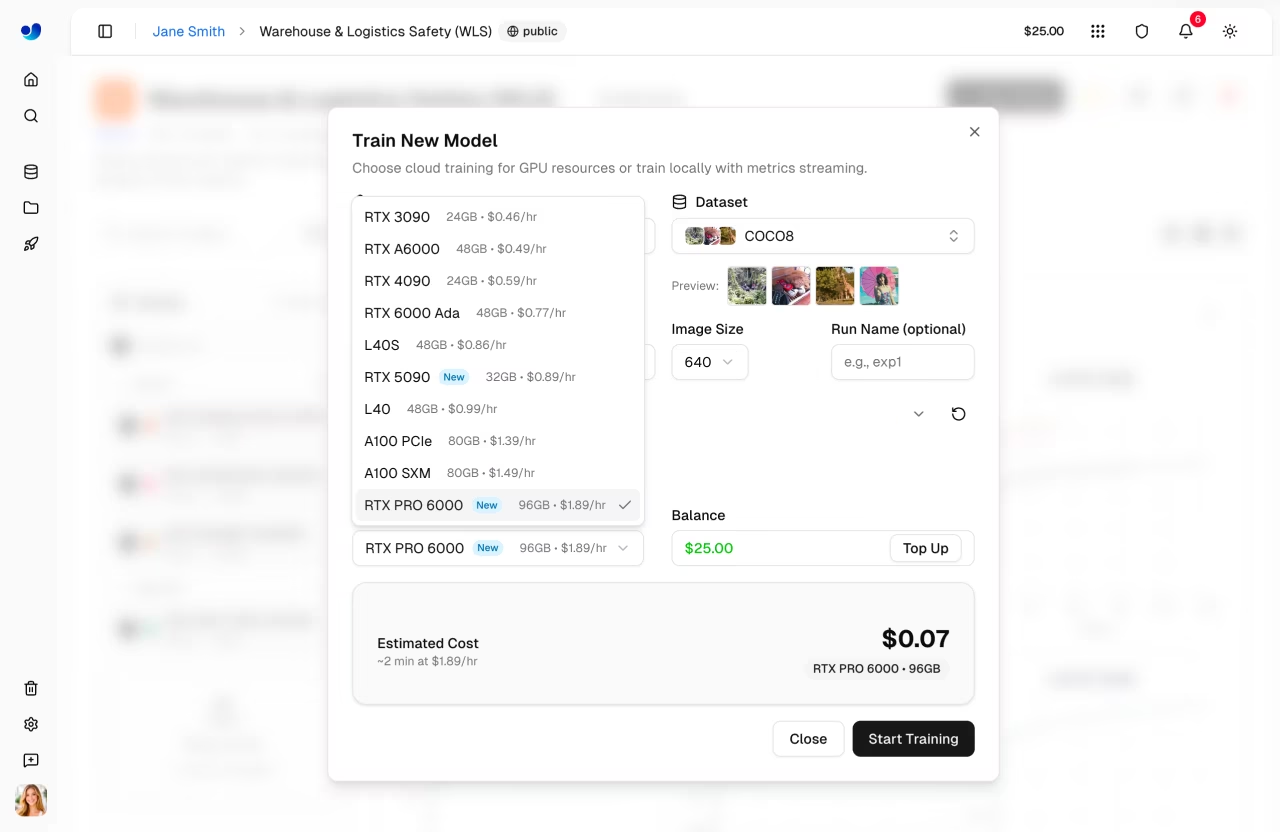

步骤5:GPU 云选项卡)

Ultralytics GPU :

| GPU | 显存 | 每小时费用 |

|---|---|---|

| RTX 2000 Ada | 16 GB | $0.24 |

| RTX A4500 | 20 GB | $0.24 |

| RTX A5000 | 24 GB | $0.26 |

| RTX 4000 Ada | 20 GB | $0.38 |

| L4 | 24 GB | $0.39 |

| A40 | 48 GB | $0.40 |

| RTX 3090 | 24 GB | $0.46 |

| RTX A6000 | 48 GB | $0.49 |

| RTX 4090 | 24 GB | $0.59 |

| RTX 6000 Ada | 48 GB | $0.77 |

| L40S | 48 GB | $0.86 |

| RTX 5090 | 32 GB | $0.89 |

| L40 | 48 GB | $0.99 |

| A100 PCIe | 80 GB | $1.39 |

| A100 SXM | 80 GB | $1.49 |

| RTX PRO 6000 | 96 GB | $1.89 |

| H100 PCIe | 80 GB | $2.39 |

| H100 SXM | 80 GB | $2.69 |

| H100 NVL | 94 GB | $3.07 |

| H200 NVL | 143 GB | $3.39 |

| H200 SXM | 141 GB | $3.59 |

| B200 | 180 GB | $4.99 |

GPU 选择

- RTX PRO 6000:96 GB Blackwell 架构,适用于多数任务的推荐默认配置

- A100 SXM:适用于大批量生产或大型模型

- H100/H200:为时间敏感型训练提供最高性能

- B200:NVIDIA Blackwell架构,专为尖端工作负载打造

对话框显示您的当前余额和一个充值按钮。系统将根据您的配置(模型规模、数据集图像数量、训练轮数、GPU )计算出预估费用和训练时长。

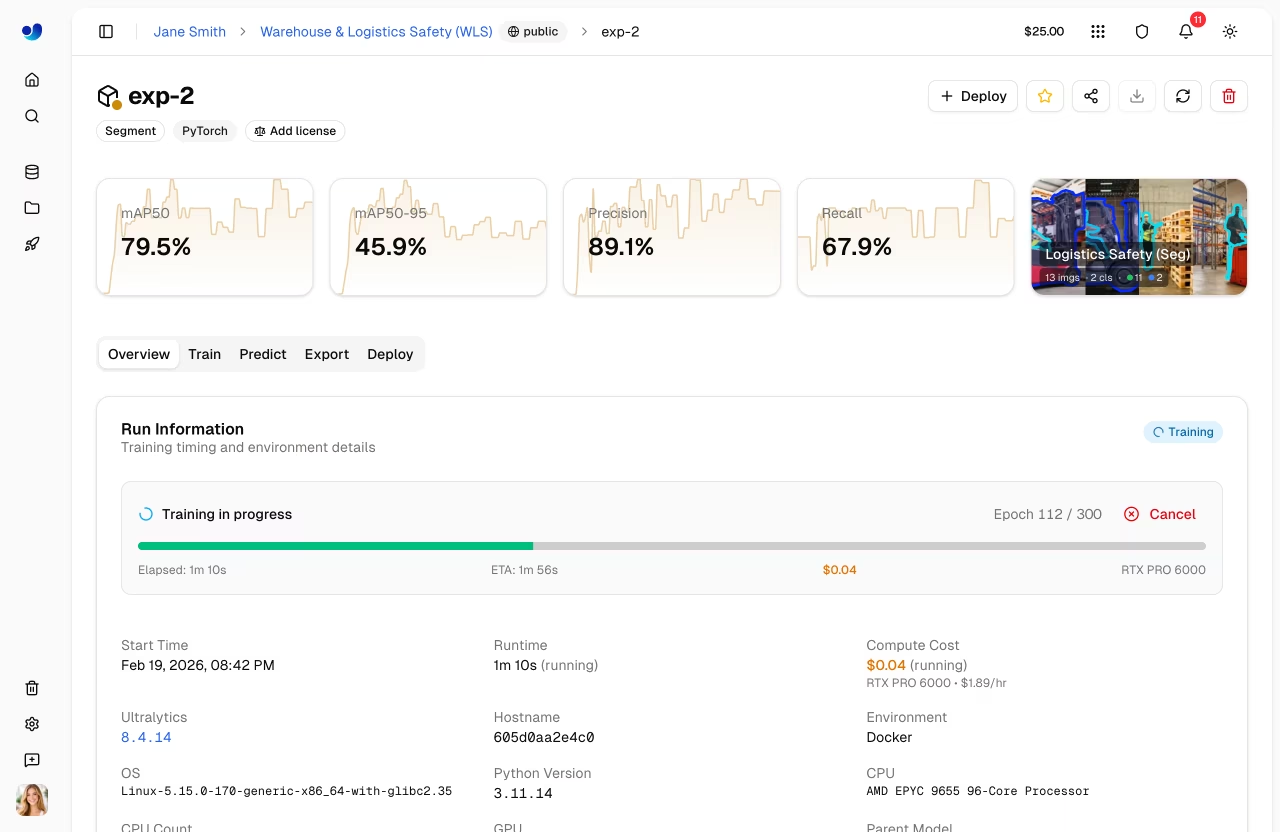

步骤6:开始训练

点击 开始训练 以启动您的任务。平台将:

- 调配一个 GPU 实例

- 下载您的数据集

- 开始训练

- 实时传输指标

培训岗位生命周期

培训任务将依次经历以下状态:

| 状态 | 描述 |

|---|---|

| 待定 | 任务已提交,正在等待GPU |

| 开始 | GPU ,正在下载数据集和模型 |

| 奔跑 | 训练进行中,指标实时流式传输 |

| 已完成 | 培训圆满结束 |

| 失败 | 训练失败(详情请查看控制台日志) |

| 取消 | 培训被用户取消 |

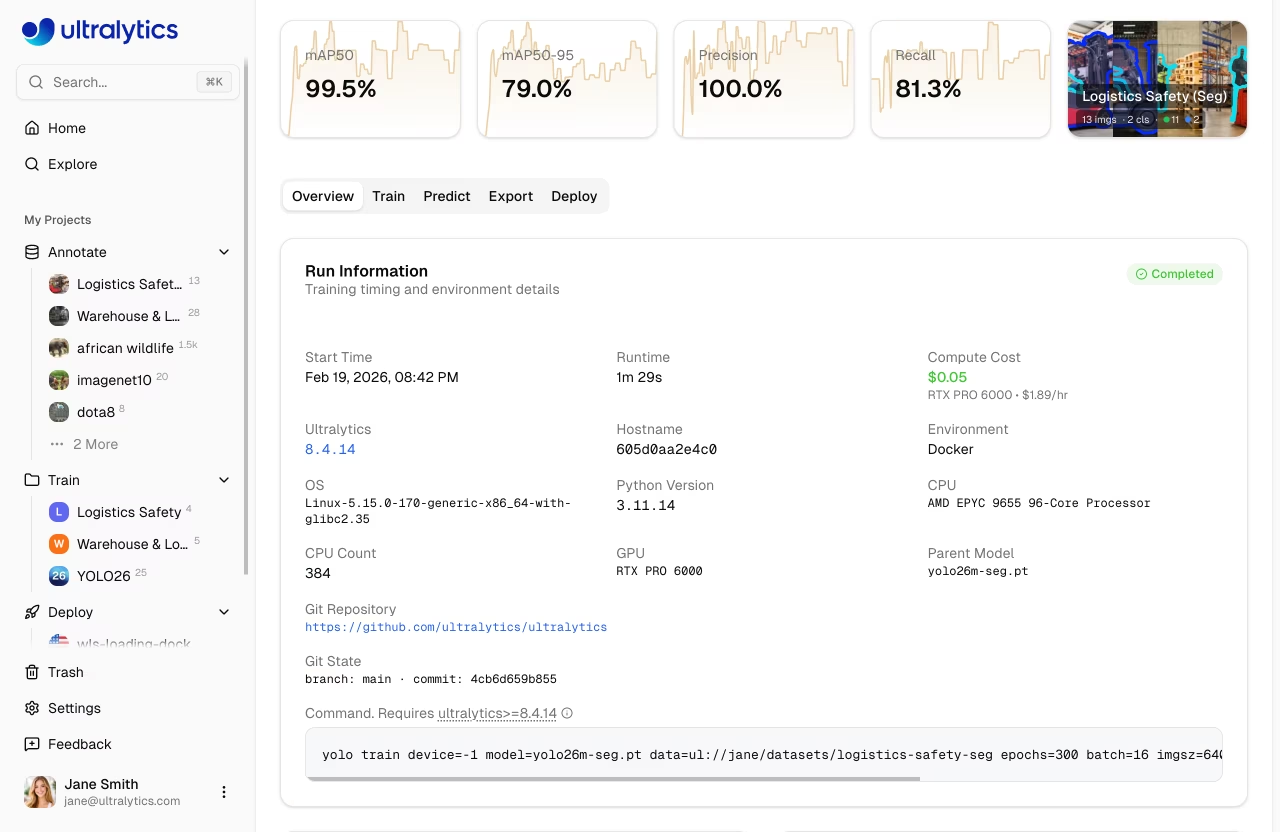

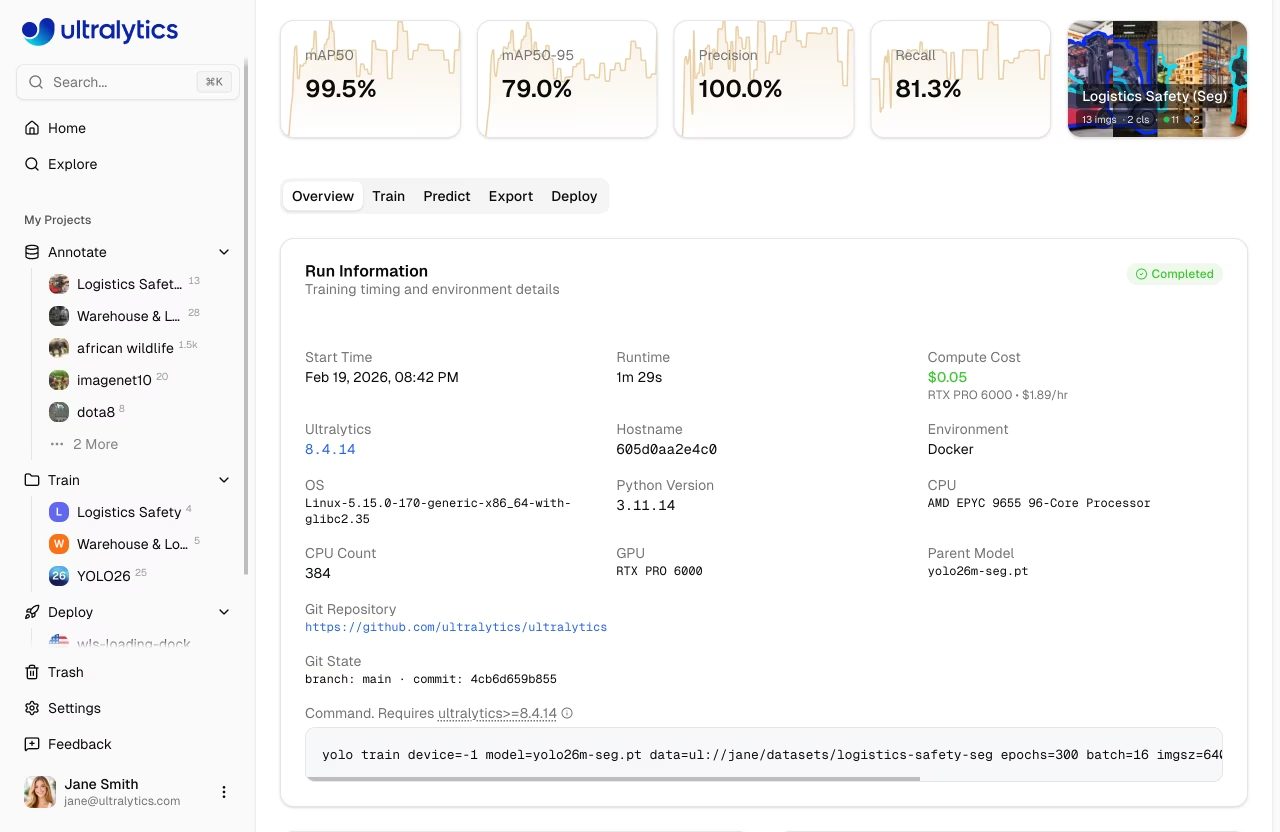

监控训练

在模型页面的“训练”选项卡中查看实时训练进度:

图表子标签页

| 指标 | 描述 |

|---|---|

| 损失 | 训练和验证损失 |

| mAP | 平均精度均值 |

| 精确度 | 正确正向预测 |

| 召回率 | 检测到的真实值 |

控制台子标签页

实时控制台输出,支持ANSI颜色、进度条和错误检测。

系统子标签页

实时GPU 、内存、温度、CPU磁盘使用情况。

检查点

检查点自动保存:

- 每个 epoch:保存最新权重

- 最佳模型:保留 mAP 最高的检查点

- 最终模型:训练完成时的权重

取消训练

在模型页面上点击“取消训练”以停止正在运行的任务:

- 计算实例已终止

- 积分停止计费

- 截至该点的检查点均被保留

远程训练

graph LR

A[Local GPU] --> B[Train]

B --> C[ultralytics Package]

C --> D[Stream Metrics]

D --> E[Platform Dashboard]

style A fill:#FF9800,color:#fff

style C fill:#2196F3,color:#fff

style E fill:#4CAF50,color:#fff在自有硬件上进行训练,同时将指标流式传输至平台。

软件包版本要求

平台集成需要ultralytics版本≥8.4.14。较低版本将无法与平台兼容。

pip install -U ultralytics

设置API密钥

- 前往

Settings > Profile(API密钥部分) - 创建新密钥(或当您打开本地训练选项卡时,平台会自动创建一个)

- 设置环境变量:

export ULTRALYTICS_API_KEY="your_api_key"

使用流式传输进行训练

使用 project 和 name 用于流式传输指标的参数:

yolo train model=yolo26n.pt data=coco.yaml epochs=100 \

project=username/my-project name=experiment-1

from ultralytics import YOLO

model = YOLO("yolo26n.pt")

model.train(

data="coco.yaml",

epochs=100,

project="username/my-project",

name="experiment-1",

)

培训对话框中的“本地培训”选项卡显示了一个预配置的命令,其中包含您的API密钥、已选参数以及高级参数。

使用平台数据集

使用平台上存储的数据集进行训练 ul:// URI格式:

yolo train model=yolo26n.pt data=ul://username/datasets/my-dataset epochs=100 \

project=username/my-project name=exp1

from ultralytics import YOLO

model = YOLO("yolo26n.pt")

model.train(

data="ul://username/datasets/my-dataset",

epochs=100,

project="username/my-project",

name="exp1",

)

字段 ul:// URI格式会自动下载并配置您的数据集。模型将自动与平台上的数据集建立关联(详见 使用平台数据集)。

账单

训练成本基于 GPU 使用情况:

成本估算

在培训开始前,平台通过以下方式估算总成本:

- 根据数据集规模、模型复杂度、图像尺寸、批量大小及GPU 估算每个时段所需秒数

- 通过将每个 epoch 的秒数乘以 epoch 总数,再加上启动开销,计算总训练时间。

- 通过将总培训时长乘以GPU每小时费率来计算预估成本

影响成本的因素:

| 因子 | 影响 |

|---|---|

| 数据集大小 | 更多图像 = 更长的训练时间(基准值:RTX 4090 每 1000 张图像约需 2.8 秒计算时间) |

| 模型大小 | 较大型号(m、l、x)的训练速度慢于(n、s)型号。 |

| epoch数 | 训练时间的直接乘数 |

| 图像大小 | 更大的imgsz会增加计算量:320像素=0.25倍,640像素=1.0倍(基准值),1280像素=4.0倍 |

| 批量大小 | 较大批次更高效(批次32耗时约为基准批次16的0.85倍,批次8耗时约为基准批次16的1.2倍) |

| GPU | 更快的GPU可缩短训练时间(例如:H100 SXM比RTX 4090快约3.4倍) |

| 初创企业运营成本 | 初始化实例、数据下载及预热最多需5分钟(随数据集规模增加而延长) |

费用示例

估计值

成本估算仅为近似值,且受多种因素影响。训练对话框会在您开始训练前显示实时估算结果。

| 场景 | GPU | 预估成本 |

|---|---|---|

| 500张图像,YOLO26n模型,50个 epoch | RTX 4090 | ~0.50美元 |

| 1000张图像,YOLO26n模型,100个 epoch | RTX PRO 6000 | ~5美元 |

| 5000张图像,YOLO26s模型,100个 epoch | H100 SXM | ~23美元 |

计费流程

graph LR

A[Estimate Cost] --> B[Balance Check]

B --> C[Train]

C --> D[Charge Actual Runtime]

style A fill:#2196F3,color:#fff

style B fill:#FF9800,color:#fff

style C fill:#9C27B0,color:#fff

style D fill:#4CAF50,color:#fff云培训计费流程:

- 估算:培训开始前计算的成本

- 余额检查:启动前将核查可用信用额度

- 任务在选定的计算节点上运行

- 计费方式:最终费用基于实际运行时间计算

消费者保护

计费系统追踪实际计算使用情况,包括被取消的部分运行任务。

支付方式

| 方法 | 描述 |

|---|---|

| 账户余额 | 预加载积分 |

| 按任务付费 | 任务完成后收费 |

最低余额

开始培训需要账户余额为正且有足够的积分来支付预计的工作费用。

查看训练成本

训练完成后,在账单选项卡中查看详细费用:

- 每周期费用明细

- 总计 GPU 时间

- 下载费用报告

训练技巧

选择合适的模型大小

| 模型 | 参数 | 最适合 |

|---|---|---|

| YOLO26n | 2.4M | 实时、边缘设备 |

| YOLO26s | 9.5M | 平衡的速度/精度 |

| YOLO26m | 20.4M | 更高精度 |

| YOLO26l | 24.8M | 生产级精度 |

| YOLO26x | 55.7M | 最大精度 |

优化训练时间

节省成本的策略

- 从小处着手:在预算有限的GPU 上进行10-20个 epoch的测试GPU 验证数据集和配置是否有效。

- 选用合适的GPU:RTX PRO 6000可高效处理多数工作负载

- 验证数据集:在投入训练前解决标注问题

- 及时监控:若损失趋于平稳则取消训练——您仅需为实际使用的计算时间付费

故障排除

| 问题 | 解决方案 |

|---|---|

| 训练停滞在0% | 检查数据集格式,重试 |

| 内存不足 | 减小批次大小或使用更大的 GPU |

| 精度不佳 | 增加周期数,检查数据质量 |

| 训练缓慢 | 考虑更快的 GPU |

| 任务不匹配错误 | 确保模型与数据集任务匹配 |

常见问题

训练需要多长时间?

训练时间取决于:

- 数据集大小

- 模型大小

- 训练轮次

- 所选 GPU

典型时间(1000张图像,100个epoch):

| 模型 | RTX PRO 6000 | A100 |

|---|---|---|

| YOLO26n | 20分钟 | 20分钟 |

| YOLO26m | 40分钟 | 40分钟 |

| YOLO26x | 80分钟 | 80分钟 |

我可以通宵训练吗?

是的,训练将持续到完成。训练完成后您将收到通知。请确保您的账户有足够的余额进行基于 epoch 的训练。

如果我的积分用完了怎么办?

训练将在当前 epoch 结束时暂停。您的检查点已保存,充值后即可恢复。

我可以使用自定义训练参数吗?

是的,在训练对话框中展开“高级设置”部分,即可访问包含40多个可配置参数的YAML编辑器。非默认值同时适用于云端和本地训练命令。

我可以在数据集页面上进行训练吗?

是的,数据集页面上的“训练”按钮会打开训练对话框,此时数据集已被预先选中并锁定。随后您只需选择项目和模型即可开始训练。

训练参数参考

| 参数 | 类型 | 默认值 | 范围 | 描述 |

|---|---|---|---|---|

epochs | 整型 | 100 | 1-10000 | 训练轮次(epoch)数量 |

batch | 整型 | 16 | 1-512 | 批次大小 |

imgsz | 整型 | 640 | 32-4096 | 输入图像尺寸 |

patience | 整型 | 100 | 1-1000 | 提前停止耐心值 |

seed | 整型 | 0 | 0-2147483647 | 随机种子用于可重复性 |

deterministic | 布尔值 | 真实 | - | 确定性训练模式 |

amp | 布尔值 | 真实 | - | 自动混合精度 |

close_mosaic | 整型 | 10 | 0-50 | 在最后 N 个 epoch 中禁用马赛克 |

save_period | 整型 | -1 | -1-100 | 每隔N个 epoch保存检查点 |

workers | 整型 | 8 | 0-64 | 数据加载器工作进程数 |

cache | 选择 | false | 内存盘/磁盘/false | 缓存图像 |

| 参数 | 类型 | 默认值 | 范围 | 描述 |

|---|---|---|---|---|

lr0 | 浮点数 | 0.01 | 0.0001-0.1 | 初始学习率 |

lrf | 浮点数 | 0.01 | 0.01-1.0 | 最终学习率因子 |

momentum | 浮点数 | 0.937 | 0.6-0.98 | SGD 动量 |

weight_decay | 浮点数 | 0.0005 | 0.0-0.001 | L2 正则化 |

warmup_epochs | 浮点数 | 3.0 | 0-5 | 预热 epochs |

warmup_momentum | 浮点数 | 0.8 | 0.5-0.95 | 热身势头 |

warmup_bias_lr | 浮点数 | 0.1 | 0.0-0.2 | 预热偏差 LR |

cos_lr | 布尔值 | 否 | - | 余弦学习率调度器 |

| 参数 | 类型 | 默认值 | 范围 | 描述 |

|---|---|---|---|---|

hsv_h | 浮点数 | 0.015 | 0.0-0.1 | HSV 色相增强 |

hsv_s | 浮点数 | 0.7 | 0.0-1.0 | HSV 饱和度 |

hsv_v | 浮点数 | 0.4 | 0.0-1.0 | HSV 明度 |

degrees | 浮点数 | 0.0 | -45-45 | 旋转角度 |

translate | 浮点数 | 0.1 | 0.0-1.0 | 平移分数 |

scale | 浮点数 | 0.5 | 0.0-1.0 | 缩放因子 |

shear | 浮点数 | 0.0 | -10-10 | 剪切度 |

perspective | 浮点数 | 0.0 | 0.0-0.001 | 视角变换 |

fliplr | 浮点数 | 0.5 | 0.0-1.0 | 水平翻转概率 |

flipud | 浮点数 | 0.0 | 0.0-1.0 | 垂直翻转概率 |

mosaic | 浮点数 | 1.0 | 0.0-1.0 | Mosaic 数据增强 |

mixup | 浮点数 | 0.0 | 0.0-1.0 | MixUp 数据增强 |

copy_paste | 浮点数 | 0.0 | 0.0-1.0 | 复制粘贴 (segment) |

| 参数 | 类型 | 默认值 | 范围 | 描述 |

|---|---|---|---|---|

fraction | 浮点数 | 1.0 | 0.1-1.0 | 要使用的数据集比例 |

freeze | 整型 | null | 0-100 | 冻结层数 |

single_cls | 布尔值 | 否 | - | 将所有类视为一个类 |

rect | 布尔值 | 否 | - | 矩形训练 |

multi_scale | 浮点数 | 0.0 | 0.0-1.0 | 多尺度训练场 |

val | 布尔值 | 真实 | - | 在训练期间运行验证 |

resume | 布尔值 | 否 | - | 从检查点继续训练 |

| 值 | 描述 |

|---|---|

auto | 自动选择 (默认) |

SGD | 随机梯度下降 |

MuSGD | μ子SGD |

Adam | Adam 优化器 |

AdamW | 带权重衰减的 Adam |

NAdam | NAdam优化器 |

RAdam | RAdam优化器 |

RMSProp | RMSProp优化器 |

Adamax | Adamax优化器 |

| 参数 | 类型 | 默认值 | 范围 | 描述 |

|---|---|---|---|---|

box | 浮点数 | 7.5 | 1-50 | 框损失权重 |

cls | 浮点数 | 0.5 | 0.2-4 | 分类损失权重 |

dfl | 浮点数 | 1.5 | 0.4-6 | 分布焦点损失 |

pose | 浮点数 | 12.0 | 1-50 | 姿势估计 (姿势估计 ) |

kobj | 浮点数 | 1.0 | 0.5-10 | 关键点物体性(姿势估计) |

label_smoothing | 浮点数 | 0.0 | 0.0-0.1 | 标签平滑因子 |

任务特定参数

某些参数仅适用于特定任务:

- 仅检测任务 (detect、segment、姿势估计、旋转框检测 classify):

box,dfl,degrees,translate,shear,perspective,mosaic,mixup,close_mosaic - 仅分段:

copy_paste - 姿势估计:

pose(损失权重),kobj(关键点目标性)