اقتصاص الكائنات باستخدام Ultralytics YOLO26

ما هو اقتصاص الأجسام؟

يتضمن اقتصاص الكائنات باستخدام Ultralytics YOLO26 عزل واستخراج كائنات محددة تم detectها من صورة أو فيديو. تُستخدم قدرات نموذج YOLO26 لتحديد الكائنات وتعيين حدودها بدقة، مما يتيح اقتصاصًا دقيقًا لمزيد من التحليل أو المعالجة.

شاهد: اقتصاص الكائنات باستخدام Ultralytics YOLO

مزايا اقتصاص الكائنات

- تحليل مركز: تسهل YOLO26 اقتصاص الكائنات المستهدف، مما يسمح بفحص أو معالجة متعمقة للعناصر الفردية داخل المشهد.

- حجم بيانات مخفض: من خلال استخراج الكائنات ذات الصلة فقط، يساعد اقتصاص الكائنات في تقليل حجم البيانات، مما يجعله فعالاً للتخزين أو الإرسال أو المهام الحسابية اللاحقة.

- دقة محسنة: تضمن دقة الكشف (detect) عن الكائنات في YOLO26 أن تحافظ الكائنات المقتطعة على علاقاتها المكانية، مما يحافظ على سلامة المعلومات المرئية للتحليل التفصيلي.

مرئيات

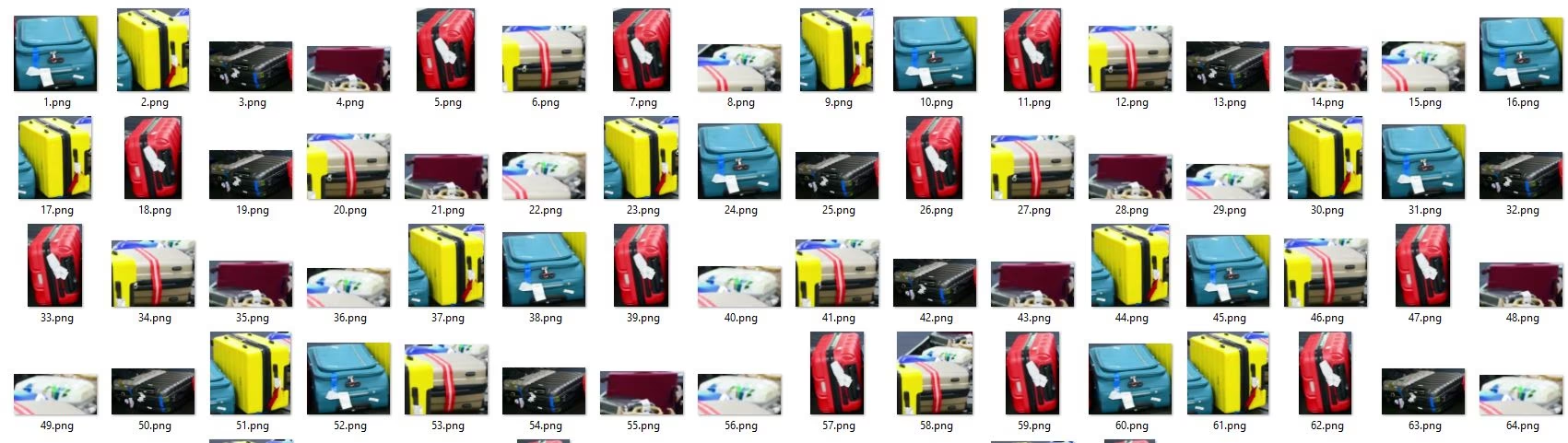

| أمتعة المطار |

|---|

|

| اقتصاص الحقائب على حزام النقل في المطار باستخدام Ultralytics YOLO26 |

اقتصاص الكائنات باستخدام Ultralytics YOLO

# Crop the objects

yolo solutions crop show=True

# Pass a source video

yolo solutions crop source="path/to/video.mp4"

# Crop specific classes

yolo solutions crop classes="[0, 2]"

import cv2

from ultralytics import solutions

cap = cv2.VideoCapture("path/to/video.mp4")

assert cap.isOpened(), "Error reading video file"

# Initialize object cropper

cropper = solutions.ObjectCropper(

show=True, # display the output

model="yolo26n.pt", # model for object cropping, e.g., yolo26x.pt.

classes=[0, 2], # crop specific classes such as person and car with the COCO pretrained model.

# conf=0.5, # adjust confidence threshold for the objects.

# crop_dir="cropped-detections", # set the directory name for cropped detections

)

# Process video

while cap.isOpened():

success, im0 = cap.read()

if not success:

print("Video frame is empty or processing is complete.")

break

results = cropper(im0)

# print(results) # access the output

cap.release()

cv2.destroyAllWindows() # destroy all opened windows

عندما تقوم بتوفير الخيار crop_dir وسيطة، تتم كتابة كل كائن تم اقتصاصه في هذا المجلد بأسماء ملفات تتضمن اسم الصورة المصدر والفئة. هذا يجعل من السهل فحص عمليات الكشف أو إنشاء مجموعات بيانات لاحقة دون كتابة تعليمات برمجية إضافية.

ObjectCropper الوسائط

إليك جدول مع ObjectCropper arguments:

| الوسيطة | النوع | افتراضي | الوصف |

|---|---|---|---|

model | str | None | مسار إلى ملف نموذج Ultralytics YOLO. |

crop_dir | str | 'cropped-detections' | اسم الدليل لتخزين الاكتشافات التي تم اقتصاصها. |

علاوة على ذلك، تتوفر وسائط التصور التالية للاستخدام:

| الوسيطة | النوع | افتراضي | الوصف |

|---|---|---|---|

show | bool | False | إذا True، يعرض الصور أو مقاطع الفيديو المشروحة في نافذة. مفيد للحصول على تعليقات مرئية فورية أثناء التطوير أو الاختبار. |

line_width | int or None | None | يحدد عرض خطوط مربعات الإحاطة. إذا None، يتم تعديل عرض الخط تلقائيًا بناءً على حجم الصورة. يوفر تخصيصًا مرئيًا للوضوح. |

الأسئلة الشائعة

ما هو اقتصاص الكائنات في Ultralytics YOLO26 وكيف يعمل؟

يتضمن اقتصاص الكائنات باستخدام Ultralytics YOLO26 عزل واستخراج كائنات محددة من صورة أو فيديو بناءً على قدرات الكشف (detect) الخاصة بـ YOLO26. تتيح هذه العملية تحليلًا مركزًا، وتقليل حجم البيانات، ودقة محسنة من خلال الاستفادة من YOLO26 لتحديد الكائنات بدقة عالية واقتصاصها وفقًا لذلك. للحصول على دليل تفصيلي، ارجع إلى مثال اقتصاص الكائنات.

لماذا يجب علي استخدام Ultralytics YOLO26 لاقتصاص الكائنات بدلاً من الحلول الأخرى؟

تتميز Ultralytics YOLO26 بدقتها وسرعتها وسهولة استخدامها. إنها تتيح الكشف (detect) الدقيق والمفصل عن الكائنات واقتصاصها، وهو أمر ضروري لـ التحليل المركز والتطبيقات التي تتطلب سلامة بيانات عالية. علاوة على ذلك، تتكامل YOLO26 بسلاسة مع أدوات مثل OpenVINO و TensorRT لعمليات النشر التي تتطلب إمكانات في الوقت الفعلي وتحسينًا على أجهزة متنوعة. استكشف الفوائد في دليل تصدير النموذج.

كيف يمكنني تقليل حجم بيانات مجموعة البيانات الخاصة بي باستخدام قص الكائنات؟

باستخدام Ultralytics YOLO26 لاقتصاص الكائنات ذات الصلة فقط من صورك أو مقاطع الفيديو الخاصة بك، يمكنك تقليل حجم البيانات بشكل كبير، مما يجعلها أكثر كفاءة للتخزين والمعالجة. تتضمن هذه العملية تدريب النموذج على detect كائنات محددة ثم استخدام النتائج لاقتصاص هذه الأجزاء وحفظها فقط. لمزيد من المعلومات حول استغلال قدرات Ultralytics YOLO26، قم بزيارة دليل البدء السريع الخاص بنا.

هل يمكنني استخدام Ultralytics YOLO26 لتحليل الفيديو في الوقت الفعلي واقتصاص الكائنات؟

نعم، يمكن لـ Ultralytics YOLO26 معالجة تدفقات الفيديو في الوقت الفعلي لـ detect واقتصاص الكائنات ديناميكيًا. إن قدرات الاستدلال عالية السرعة للنموذج تجعله مثاليًا للتطبيقات في الوقت الفعلي مثل المراقبة، وتحليل الرياضة، وأنظمة الفحص الآلي. اطلع على أوضاع الـ tracking والتنبؤ لفهم كيفية تنفيذ المعالجة في الوقت الفعلي.

ما هي متطلبات الأجهزة لتشغيل YOLO26 بكفاءة لاقتصاص الكائنات؟

تم تحسين Ultralytics YOLO26 لبيئات الـ CPU والـ GPU على حد سواء، ولكن لتحقيق الأداء الأمثل، خاصة للاستدلال في الوقت الفعلي أو بكميات كبيرة، يوصى باستخدام GPU مخصص (مثل NVIDIA Tesla، سلسلة RTX). للنشر على الأجهزة خفيفة الوزن، فكر في استخدام CoreML لنظام iOS أو TFLite لنظام Android. يمكن العثور على مزيد من التفاصيل حول الأجهزة والتنسيقات المدعومة في خيارات نشر النموذج لدينا.