Schnellstartanleitung: NVIDIA DGX Spark mit Ultralytics YOLO26

Dieser umfassende Leitfaden bietet eine detaillierte Anleitung zur Bereitstellung von Ultralytics YOLO26 auf NVIDIA DGX Spark, NVIDIAs kompaktem Desktop-KI-Supercomputer. Zusätzlich werden Leistungs-Benchmarks vorgestellt, um die Fähigkeiten von YOLO26 auf diesem leistungsstarken System zu demonstrieren.

Hinweis

Dieser Leitfaden wurde mit der NVIDIA DGX Spark Founders Edition getestet, die DGX OS basierend auf Ubuntu ausführt. Es wird erwartet, dass er mit den neuesten DGX OS-Versionen funktioniert.

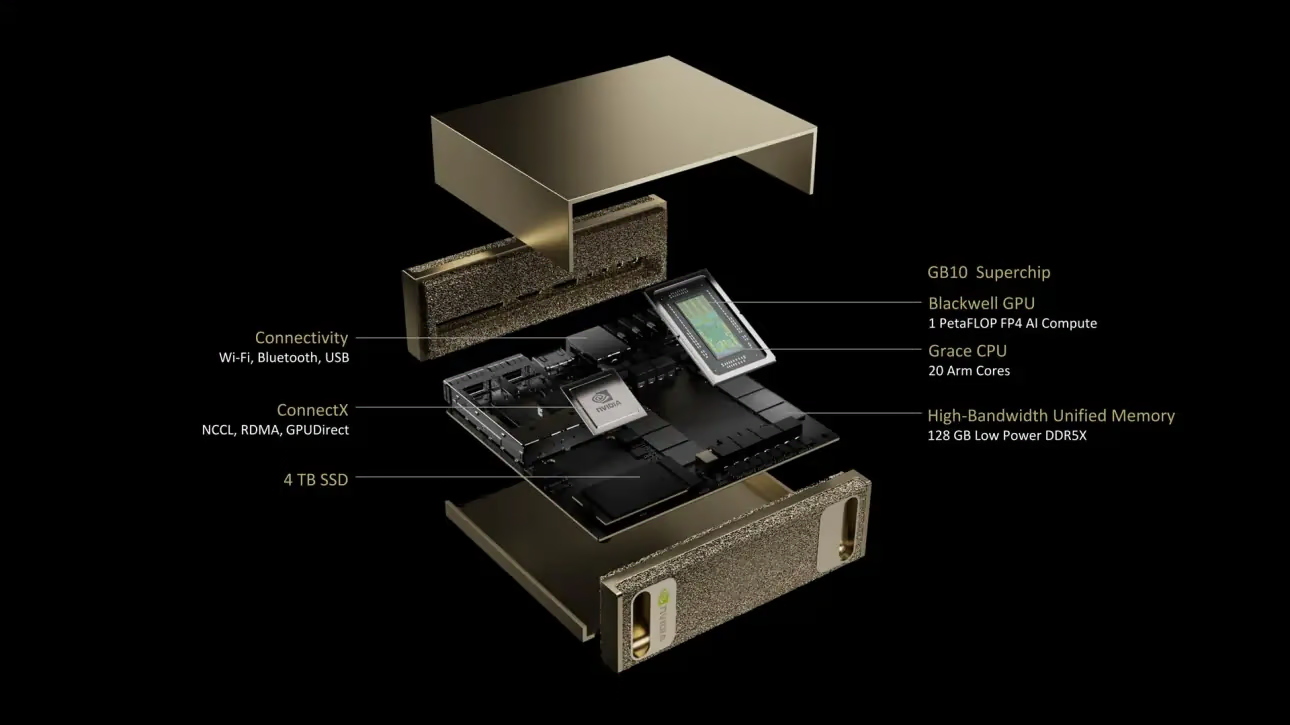

Was ist NVIDIA DGX Spark?

NVIDIA DGX Spark ist ein kompakter Desktop-KI-Supercomputer, der vom NVIDIA GB10 Grace Blackwell Superchip angetrieben wird. Er liefert bis zu 1 PetaFLOP KI-Rechenleistung mit FP4-Präzision, was ihn ideal für Entwickler, Forscher und Datenwissenschaftler macht, die leistungsstarke KI-Funktionen in einem Desktop-Formfaktor benötigen.

Wichtige Spezifikationen

| Spezifikation | Details |

|---|---|

| KI-Leistung | Bis zu 1 PFLOP (FP4) |

| GPU | NVIDIA Blackwell Architektur mit Tensor Cores der 5. Generation, RT Cores der 4. Generation |

| CPU | 20-Kern Arm-Prozessor (10 Cortex-X925 + 10 Cortex-A725) |

| Arbeitsspeicher | 128 GB LPDDR5x vereinheitlichter Systemspeicher, 256-Bit-Schnittstelle, 4266 MHz, 273 GB/s Bandbreite |

| Speicher | 1 TB oder 4 TB NVMe M.2 mit Selbstverschlüsselung |

| Netzwerk | 1x RJ-45 (10 GbE), ConnectX-7 Smart NIC, Wi-Fi 7, Bluetooth 5.4 |

| Konnektivität | 4x USB Type-C, 1x HDMI 2.1a, HDMI Mehrkanal-Audio |

| Videoverarbeitung | 1x NVENC, 1x NVDEC |

DGX OS

NVIDIA DGX OS ist eine angepasste Linux-Distribution, die eine stabile, getestete und unterstützte Betriebssystemgrundlage zum Ausführen von KI-, Machine-Learning- und Analyseanwendungen auf DGX-Systemen bietet. Es umfasst:

- Eine robuste Linux-Grundlage, optimiert für KI-Workloads

- Vorkonfigurierte Treiber und Systemeinstellungen für NVIDIA-Hardware

- Sicherheitsupdates und Systemwartungsfunktionen

- Kompatibilität mit dem breiteren NVIDIA-Software-Ökosystem

DGX OS folgt einem regelmäßigen Release-Zeitplan, wobei Updates typischerweise zweimal pro Jahr (etwa im Februar und August) bereitgestellt werden und zusätzliche Sicherheitspatches zwischen den Haupt-Releases zur Verfügung gestellt werden.

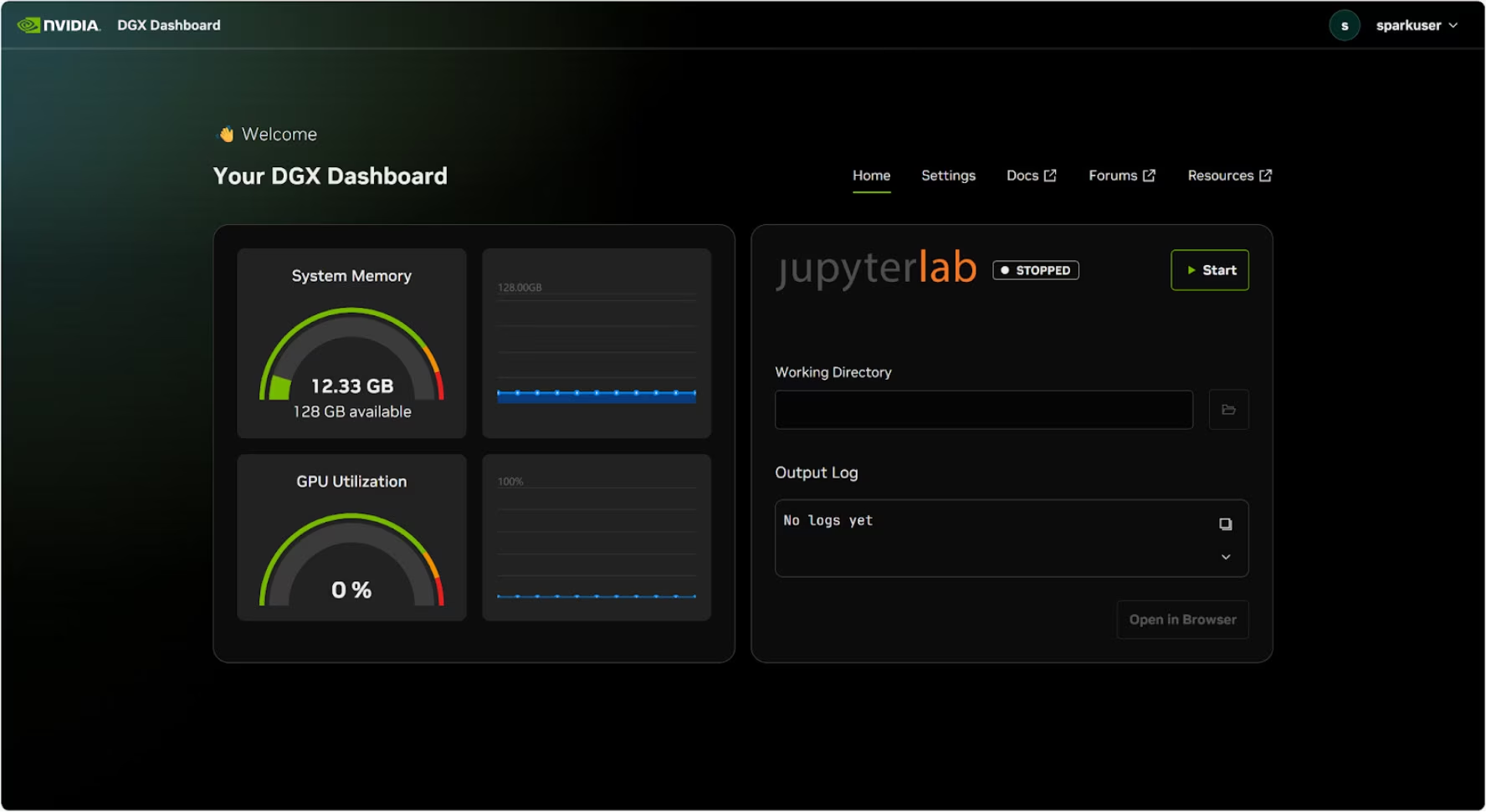

DGX Dashboard

DGX Spark verfügt über ein integriertes DGX Dashboard, das Folgendes bietet:

- Echtzeit-Systemüberwachung: Übersicht über die aktuellen Betriebsmetriken des Systems

- System-Updates: Möglichkeit, Updates direkt über das Dashboard anzuwenden

- Systemeinstellungen: Gerätenamen und andere Konfigurationen ändern

- Integriertes JupyterLab: Zugriff auf lokale Jupyter Notebooks für die Entwicklung

Zugriff auf das Dashboard

Klicken Sie auf die Schaltfläche „Anwendungen anzeigen“ in der unteren linken Ecke des Ubuntu-Desktops und wählen Sie dann „DGX Dashboard“ aus, um es in Ihrem Browser zu öffnen.

# Open an SSH tunnel

ssh -L 11000:localhost:11000 username@spark-abcd.local

# Then open in browser

# http://localhost:11000

Nach der Verbindung mit NVIDIA Sync klicken Sie auf die Schaltfläche „DGX Dashboard“, um das Dashboard unter zu öffnen http://localhost:11000.

Integriertes JupyterLab

Das Dashboard enthält eine integrierte JupyterLab-Instanz, die beim Start automatisch eine virtuelle Umgebung erstellt und empfohlene Pakete installiert. Jedem Benutzerkonto wird ein dedizierter Port für den JupyterLab-Zugriff zugewiesen.

Schnellstart mit Docker

Der schnellste Weg, um mit Ultralytics YOLO26 auf NVIDIA DGX Spark zu beginnen, ist die Verwendung vorgefertigter Docker-Images. Das gleiche Docker-Image, das Jetson AGX Thor (JetPack 7.0) unterstützt, funktioniert auf DGX Spark mit DGX OS.

t=ultralytics/ultralytics:latest-nvidia-arm64

sudo docker pull $t && sudo docker run -it --ipc=host --runtime=nvidia --gpus all $t

Danach fahren Sie fort mit dem Abschnitt „TensorRT auf NVIDIA DGX Spark verwenden“.

Starten Sie mit der nativen Installation

Für eine native Installation ohne Docker befolgen Sie diese Schritte.

Ultralytics-Paket installieren

Hier installieren wir das Ultralytics-Paket auf DGX Spark mit optionalen Abhängigkeiten, damit wir die PyTorch-Modelle in verschiedene andere Formate exportieren können. Wir werden uns hauptsächlich auf NVIDIA TensorRT-Exporte konzentrieren, da TensorRT sicherstellt, dass wir die maximale Leistung aus dem DGX Spark herausholen können.

Paketliste aktualisieren, pip installieren und auf die neueste Version aktualisieren

sudo apt update sudo apt install python3-pip -y pip install -U pipInstallieren

ultralyticspip-Paket mit optionalen Abhängigkeitenpip install ultralytics[export]Gerät neu starten

sudo reboot

PyTorch und Torchvision installieren

Die oben genannte Ultralytics-Installation wird Torch und Torchvision installieren. Diese über pip installierten Pakete sind jedoch möglicherweise nicht vollständig für die ARM64-Architektur des DGX Spark mit CUDA 13 optimiert. Daher empfehlen wir die Installation der CUDA 13-kompatiblen Versionen:

pip install torch torchvision --index-url https://download.pytorch.org/whl/cu130

Info

Beim Ausführen von PyTorch 2.9.1 auf NVIDIA DGX Spark kann Folgendes auftreten: UserWarning bei der Initialisierung von CUDA (z. B. beim Ausführen von yolo checks, yolo predict, usw.):

UserWarning: Found GPU0 NVIDIA GB10 which is of cuda capability 12.1.

Minimum and Maximum cuda capability supported by this version of PyTorch is (8.0) - (12.0)

Diese Warnung kann bedenkenlos ignoriert werden. Um dies dauerhaft zu beheben, wurde ein Fix im PyTorch PR #164590 eingereicht, der in der PyTorch 2.10-Version enthalten sein wird.

Installieren onnxruntime-gpu

Die onnxruntime-gpu Das in PyPI gehostete Paket hat keine aarch64 Binärdateien für ARM64-Systeme. Daher müssen wir dieses Paket manuell installieren. Dieses Paket wird für einige der Exporte benötigt.

Hier werden wir herunterladen und installieren onnxruntime-gpu 1.24.0 mit Python3.12 Unterstützung.

pip install https://github.com/ultralytics/assets/releases/download/v0.0.0/onnxruntime_gpu-1.24.0-cp312-cp312-linux_aarch64.whl

TensorRT auf NVIDIA DGX Spark verwenden

Unter allen von Ultralytics unterstützten Modell-Exportformaten bietet TensorRT die höchste Inferenzleistung auf NVIDIA DGX Spark, was es zu unserer Top-Empfehlung für Bereitstellungen macht. Installationsanweisungen und fortgeschrittene Nutzung finden Sie in unserem dedizierten TensorRT-Integrationsleitfaden.

Modell in TensorRT konvertieren und Inferenz ausführen

Das YOLO26n-Modell im PyTorch-Format wird in TensorRT konvertiert, um die Inferenz mit dem exportierten Modell auszuführen.

Beispiel

from ultralytics import YOLO

# Load a YOLO26n PyTorch model

model = YOLO("yolo26n.pt")

# Export the model to TensorRT

model.export(format="engine") # creates 'yolo26n.engine'

# Load the exported TensorRT model

trt_model = YOLO("yolo26n.engine")

# Run inference

results = trt_model("https://ultralytics.com/images/bus.jpg")

# Export a YOLO26n PyTorch model to TensorRT format

yolo export model=yolo26n.pt format=engine # creates 'yolo26n.engine'

# Run inference with the exported model

yolo predict model=yolo26n.engine source='https://ultralytics.com/images/bus.jpg'

Hinweis

Besuchen Sie die Export-Seite, um auf zusätzliche Argumente beim Exportieren von Modellen in verschiedene Modellformate zuzugreifen.

NVIDIA DGX Spark YOLO11 Benchmarks

YOLO11-Benchmarks wurden vom Ultralytics-Team für mehrere Modellformate durchgeführt, um Geschwindigkeit und Genauigkeit zu messen: PyTorch, TorchScript, ONNX, OpenVINO, TensorRT, TF SavedModel, TF GraphDef, TF Lite, MNN, NCNN, ExecuTorch. Die Benchmarks wurden auf NVIDIA DGX Spark mit FP32-Präzision und einer Standardeingabebildgröße von 640 durchgeführt.

Detaillierte Vergleichstabelle

Die folgende Tabelle zeigt die Benchmark-Ergebnisse für fünf verschiedene Modelle (YOLO11n, YOLO11s, YOLO11m, YOLO11l, YOLO11x) über mehrere Formate hinweg, einschließlich Status, Größe, mAP50-95(B)-Metrik und Inferenzzeit für jede Kombination.

Performance

| Format | Status | Größe auf der Festplatte (MB) | mAP50-95(B) | Inferenzzeit (ms/Bild) |

|---|---|---|---|---|

| PyTorch | ✅ | 5.4 | 0.5071 | 2.67 |

| TorchScript | ✅ | 10.5 | 0.5083 | 2.62 |

| ONNX | ✅ | 10.2 | 0.5074 | 5.92 |

| OpenVINO | ✅ | 10.4 | 0.5058 | 14.95 |

| TensorRT (FP32) | ✅ | 12.8 | 0.5085 | 1.95 |

| TensorRT (FP16) | ✅ | 7.0 | 0.5068 | 1.01 |

| TensorRT (INT8) | ✅ | 18.6 | 0.4880 | 1.62 |

| TF SavedModel | ✅ | 25.7 | 0.5076 | 36.39 |

| TF GraphDef | ✅ | 10.3 | 0.5076 | 41.06 |

| TF Lite | ✅ | 10.3 | 0.5075 | 64.36 |

| MNN | ✅ | 10.1 | 0.5075 | 12.14 |

| NCNN | ✅ | 10.2 | 0.5041 | 12.31 |

| ExecuTorch | ✅ | 10.2 | 0.5075 | 27.61 |

| Format | Status | Größe auf der Festplatte (MB) | mAP50-95(B) | Inferenzzeit (ms/Bild) |

|---|---|---|---|---|

| PyTorch | ✅ | 18.4 | 0.5767 | 5.38 |

| TorchScript | ✅ | 36.5 | 0.5781 | 5.48 |

| ONNX | ✅ | 36.3 | 0.5784 | 8.17 |

| OpenVINO | ✅ | 36.4 | 0.5809 | 27.12 |

| TensorRT (FP32) | ✅ | 39.8 | 0.5783 | 3.59 |

| TensorRT (FP16) | ✅ | 20.1 | 0.5800 | 1.85 |

| TensorRT (INT8) | ✅ | 17.5 | 0.5664 | 1.88 |

| TF SavedModel | ✅ | 90.8 | 0.5782 | 66.63 |

| TF GraphDef | ✅ | 36.3 | 0.5782 | 71.67 |

| TF Lite | ✅ | 36.3 | 0.5782 | 187.36 |

| MNN | ✅ | 36.2 | 0.5775 | 27.05 |

| NCNN | ✅ | 36.2 | 0.5806 | 26.26 |

| ExecuTorch | ✅ | 36.2 | 0.5782 | 54.73 |

| Format | Status | Größe auf der Festplatte (MB) | mAP50-95(B) | Inferenzzeit (ms/Bild) |

|---|---|---|---|---|

| PyTorch | ✅ | 38.8 | 0.6254 | 11.14 |

| TorchScript | ✅ | 77.3 | 0.6304 | 12.00 |

| ONNX | ✅ | 76.9 | 0.6304 | 13.83 |

| OpenVINO | ✅ | 77.1 | 0.6284 | 62.44 |

| TensorRT (FP32) | ✅ | 79.9 | 0.6305 | 6.96 |

| TensorRT (FP16) | ✅ | 40.6 | 0.6313 | 3.14 |

| TensorRT (INT8) | ✅ | 26.6 | 0.6204 | 3.30 |

| TF SavedModel | ✅ | 192.4 | 0.6306 | 139.85 |

| TF GraphDef | ✅ | 76.9 | 0.6306 | 146.76 |

| TF Lite | ✅ | 76.9 | 0.6306 | 568.18 |

| MNN | ✅ | 76.8 | 0.6306 | 67.67 |

| NCNN | ✅ | 76.8 | 0.6308 | 60.49 |

| ExecuTorch | ✅ | 76.9 | 0.6306 | 120.37 |

| Format | Status | Größe auf der Festplatte (MB) | mAP50-95(B) | Inferenzzeit (ms/Bild) |

|---|---|---|---|---|

| PyTorch | ✅ | 49.0 | 0.6366 | 13.95 |

| TorchScript | ✅ | 97.6 | 0.6399 | 15.67 |

| ONNX | ✅ | 97.0 | 0.6399 | 16.62 |

| OpenVINO | ✅ | 97.3 | 0.6377 | 78.80 |

| TensorRT (FP32) | ✅ | 99.2 | 0.6407 | 8.86 |

| TensorRT (FP16) | ✅ | 50.8 | 0.6350 | 3.85 |

| TensorRT (INT8) | ✅ | 32.5 | 0.6224 | 4.52 |

| TF SavedModel | ✅ | 242.7 | 0.6409 | 187.45 |

| TF GraphDef | ✅ | 97.0 | 0.6409 | 193.92 |

| TF Lite | ✅ | 97.0 | 0.6409 | 728.61 |

| MNN | ✅ | 96.9 | 0.6369 | 85.21 |

| NCNN | ✅ | 96.9 | 0.6373 | 77.62 |

| ExecuTorch | ✅ | 97.0 | 0.6409 | 153.56 |

| Format | Status | Größe auf der Festplatte (MB) | mAP50-95(B) | Inferenzzeit (ms/Bild) |

|---|---|---|---|---|

| PyTorch | ✅ | 109.3 | 0.6992 | 23.19 |

| TorchScript | ✅ | 218.1 | 0.6900 | 25.75 |

| ONNX | ✅ | 217.5 | 0.6900 | 27.43 |

| OpenVINO | ✅ | 217.8 | 0.6872 | 149.44 |

| TensorRT (FP32) | ✅ | 222.7 | 0.6902 | 13.87 |

| TensorRT (FP16) | ✅ | 111.1 | 0.6883 | 6.19 |

| TensorRT (INT8) | ✅ | 62.9 | 0.6793 | 6.62 |

| TF SavedModel | ✅ | 543.9 | 0.6900 | 335.10 |

| TF GraphDef | ✅ | 217.5 | 0.6900 | 348.86 |

| TF Lite | ✅ | 217.5 | 0.6900 | 1578.66 |

| MNN | ✅ | 217.3 | 0.6874 | 168.95 |

| NCNN | ✅ | 217.4 | 0.6901 | 132.13 |

| ExecuTorch | ✅ | 217.4 | 0.6900 | 297.17 |

Benchmarked mit Ultralytics 8.3.249

Unsere Ergebnisse reproduzieren

Um die oben genannten Ultralytics-Benchmarks auf allen Export-Formaten zu reproduzieren, führen Sie diesen Code aus:

Beispiel

from ultralytics import YOLO

# Load a YOLO26n PyTorch model

model = YOLO("yolo26n.pt")

# Benchmark YOLO26n speed and accuracy on the COCO128 dataset for all export formats

results = model.benchmark(data="coco128.yaml", imgsz=640)

# Benchmark YOLO26n speed and accuracy on the COCO128 dataset for all export formats

yolo benchmark model=yolo26n.pt data=coco128.yaml imgsz=640

Beachten Sie, dass die Benchmarking-Ergebnisse je nach genauer Hardware- und Softwarekonfiguration eines Systems sowie der aktuellen Systemauslastung zum Zeitpunkt der Benchmark-Ausführung variieren können. Für die zuverlässigsten Ergebnisse verwenden Sie einen Datensatz mit einer großen Anzahl von Bildern, z. B. data='coco.yaml' (5000 Validierungsbilder).

Best Practices für NVIDIA DGX Spark

Bei der Verwendung von NVIDIA DGX Spark gibt es einige Best Practices, die befolgt werden sollten, um die maximale Leistung beim Ausführen von YOLO26 zu erzielen.

Systemleistung überwachen

Verwenden Sie die Überwachungstools von NVIDIA, um die GPU- und CPU-Auslastung zu tracken:

nvidia-smiSpeichernutzung optimieren

Mit 128 GB Unified Memory kann DGX Spark große Batch-Größen und Modelle verarbeiten. Erwägen Sie eine Erhöhung der Batch-Größe für einen verbesserten Durchsatz:

from ultralytics import YOLO model = YOLO("yolo26n.engine") results = model.predict(source="path/to/images", batch=16)TensorRT mit FP16 oder INT8 verwenden

Für beste Leistung exportieren Sie Modelle mit FP16- oder INT8-Präzision:

yolo export model=yolo26n.pt format=engine half=True # FP16 yolo export model=yolo26n.pt format=engine int8=True # INT8

System-Updates (Founders Edition)

Die Aktualisierung Ihrer DGX Spark Founders Edition ist entscheidend für Leistung und Sicherheit. NVIDIA bietet zwei primäre Methoden zur Aktualisierung des System-Betriebssystems, der Treiber und der Firmware.

Verwendung des DGX Dashboards (Empfohlen)

Das DGX Dashboard ist der empfohlene Weg, Systemaktualisierungen durchzuführen und die Kompatibilität sicherzustellen. Es ermöglicht Ihnen:

- Verfügbare Systemaktualisierungen anzeigen

- Sicherheitspatches und Systemaktualisierungen installieren

- NVIDIA-Treiber- und Firmware-Updates verwalten

Manuelle System-Updates

Für fortgeschrittene Benutzer können Updates manuell über das Terminal durchgeführt werden:

sudo apt update

sudo apt dist-upgrade

sudo fwupdmgr refresh

sudo fwupdmgr upgrade

sudo reboot

Warnung

Stellen Sie sicher, dass Ihr System an eine stabile Stromquelle angeschlossen ist und Sie wichtige Daten gesichert haben, bevor Sie Updates durchführen.

Nächste Schritte

Für weitere Informationen und Unterstützung siehe die Ultralytics YOLO26 Docs.

FAQ

Wie stelle ich Ultralytics YOLO26 auf NVIDIA DGX Spark bereit?

Die Bereitstellung von Ultralytics YOLO26 auf NVIDIA DGX Spark ist unkompliziert. Sie können das vorgefertigte Docker-Image für eine schnelle Einrichtung verwenden oder die erforderlichen Pakete manuell installieren. Detaillierte Schritte für jeden Ansatz finden Sie in den Abschnitten Quick Start with Docker und Start with Native Installation.

Welche Leistung kann ich von YOLO26 auf NVIDIA DGX Spark erwarten?

YOLO26-Modelle liefern dank des GB10 Grace Blackwell Superchips eine hervorragende Leistung auf DGX Spark. Das TensorRT-Format bietet die beste Inferenzleistung. Spezifische Benchmark-Ergebnisse für verschiedene Modellgrößen und -formate finden Sie im Abschnitt Detailed Comparison Table.

Warum sollte ich TensorRT für YOLO26 auf DGX Spark verwenden?

TensorRT wird für die Bereitstellung von YOLO26-Modellen auf DGX Spark aufgrund seiner optimalen Leistung dringend empfohlen. Es beschleunigt die Inferenz, indem es die Blackwell GPU-Fähigkeiten nutzt und so maximale Effizienz und Geschwindigkeit gewährleistet. Erfahren Sie mehr im Abschnitt Use TensorRT on NVIDIA DGX Spark.

Wie schneidet DGX Spark im Vergleich zu Jetson-Geräten für YOLO26 ab?

DGX Spark bietet deutlich mehr Rechenleistung als Jetson-Geräte mit bis zu 1 PFLOP KI-Leistung und 128 GB vereinheitlichtem Speicher, im Vergleich zu Jetson AGX Thors 2070 TFLOPS und 128 GB Speicher. DGX Spark ist als Desktop-KI-Supercomputer konzipiert, während Jetson-Geräte eingebettete Systeme sind, die für Edge-Deployments optimiert sind.

Kann ich dasselbe Docker-Image für DGX Spark und Jetson AGX Thor verwenden?

Ja! Das ultralytics/ultralytics:latest-nvidia-arm64 Docker-Image unterstützt sowohl NVIDIA DGX Spark (mit DGX OS) als auch Jetson AGX Thor (mit JetPack 7.0), da beide die ARM64-Architektur mit CUDA 13 und ähnlichen Software-Stacks verwenden.