SAM 3: Alles mit Konzepten segmentieren

Jetzt bei Ultralytics verfügbar

SAM 3 ist vollständig in das Ultralytics-Paket integriert seit Version 8.3.237 (PR #22897). Installieren oder aktualisieren Sie mit pip install -U ultralytics um auf alle SAM 3-Funktionen zuzugreifen, einschließlich textbasierter Konzeptsegmentierung, Bild-Exemplar-Prompts und Video-Tracking.

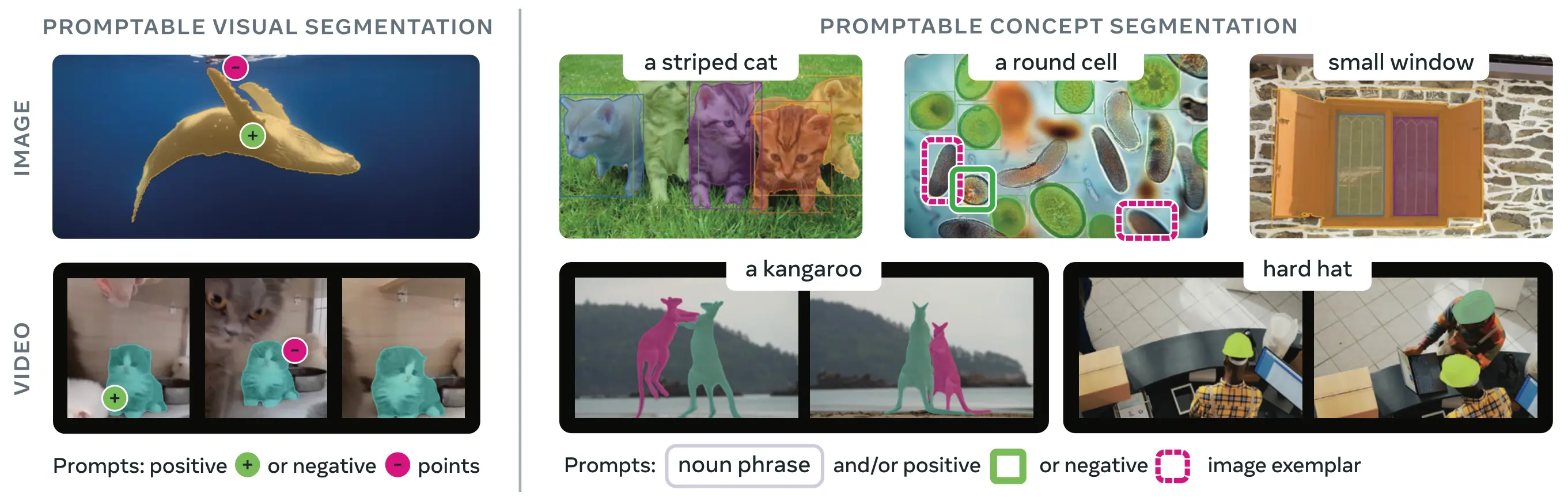

SAM 3 (Segment Anything Model 3) ist Metas veröffentlichtes Grundlagenmodell für Promptable Concept Segmentation (PCS). Aufbauend auf SAM 2 führt SAM 3 eine grundlegend neue Fähigkeit ein: das detect, segment und tracken aller Instanzen eines visuellen Konzepts, das durch Textaufforderungen, Bildbeispiele oder beides spezifiziert wird. Im Gegensatz zu früheren SAM-Versionen, die einzelne Objekte pro Aufforderung segmentieren, kann SAM 3 jedes Vorkommen eines Konzepts, das an beliebiger Stelle in Bildern oder Videos auftaucht, finden und segmentieren, was den Zielen eines offenen Vokabulars in der modernen Instanzsegmentierung entspricht.

Ansehen: Wie man Meta segment Anything 3 mit Ultralytics verwendet | Text-Prompt Segmentation auf Bildern & Videos

SAM 3 ist jetzt vollständig integriert in das ultralytics Paket, das native Unterstützung für die Konzeptsegmentierung mit Text-Prompts, Bild-Exemplar-Prompts und Video-track-Funktionen bietet.

Überblick

SAM 3 erzielt einen 2-fachen Leistungszuwachs gegenüber bestehenden Systemen bei der Promptable Concept Segmentation, während es die Fähigkeiten von SAM 2 für die interaktive visuelle Segmentierung beibehält und verbessert. Das Modell zeichnet sich durch Open-Vocabulary Segmentation aus, indem es Benutzern ermöglicht, Konzepte mithilfe einfacher Nomenphrasen (z. B. „gelber Schulbus“, „gestreifte Katze“) zu spezifizieren oder durch Bereitstellung von Beispielbildern des Zielobjekts. Diese Fähigkeiten ergänzen produktionsreife Pipelines, die auf optimierten predict- und track-Workflows basieren.

Was ist Promptable Concept Segmentation (PCS)?

Die PCS-Aufgabe nimmt einen Konzept-Prompt als Eingabe und gibt Segmentierungsmasken mit eindeutigen Identitäten für alle übereinstimmenden Objektinstanzen zurück. Konzept-Prompts können sein:

- Text: Einfache Nominalphrasen wie „roter Apfel“ oder „Person, die einen Hut trägt“, ähnlich wie beim Zero-Shot-Lernen

- Bild-Exemplare: Bounding Boxes um Beispielobjekte (positiv oder negativ) für schnelle Generalisierung

- Kombiniert: Sowohl Text- als auch Bildexemplare zusammen für präzise Kontrolle.

Dies unterscheidet sich von traditionellen visuellen Prompts (Punkten, Bounding Boxes, Masken), die nur eine einzelne spezifische Objektinstanz segmentieren, wie sie von der ursprünglichen SAM-Familie populär gemacht wurden.

Wichtige Leistungsmetriken

| Metrik | SAM 3 Leistung |

|---|---|

| LVIS Null-Schuss Masken AP | 47.0 (vs previous best 38.5, +22% improvement) |

| SA-Co Benchmark | 2× better than existing systems |

| Inferenzgeschwindigkeit (H200 GPU) | 30 ms per image with 100+ detected objects |

| Videoleistung | Nahezu Echtzeit für ~5 gleichzeitige Objekte |

| MOSEv2 VOS Benchmark | 60.1 J&F (+25.5% over SAM 2.1, +17% over prior SOTA) |

| Interaktive Verfeinerung | +18.6 CGF1 Verbesserung nach 3 exemplarischen Prompts |

| Menschliche Leistungslücke | Erreicht 88% der geschätzten Untergrenze auf SA-Co/Gold |

Für den Kontext zu Modellmetriken und Kompromissen in der Produktion siehe Einblicke in die Modellevaluierung und YOLO-Leistungsmetriken.

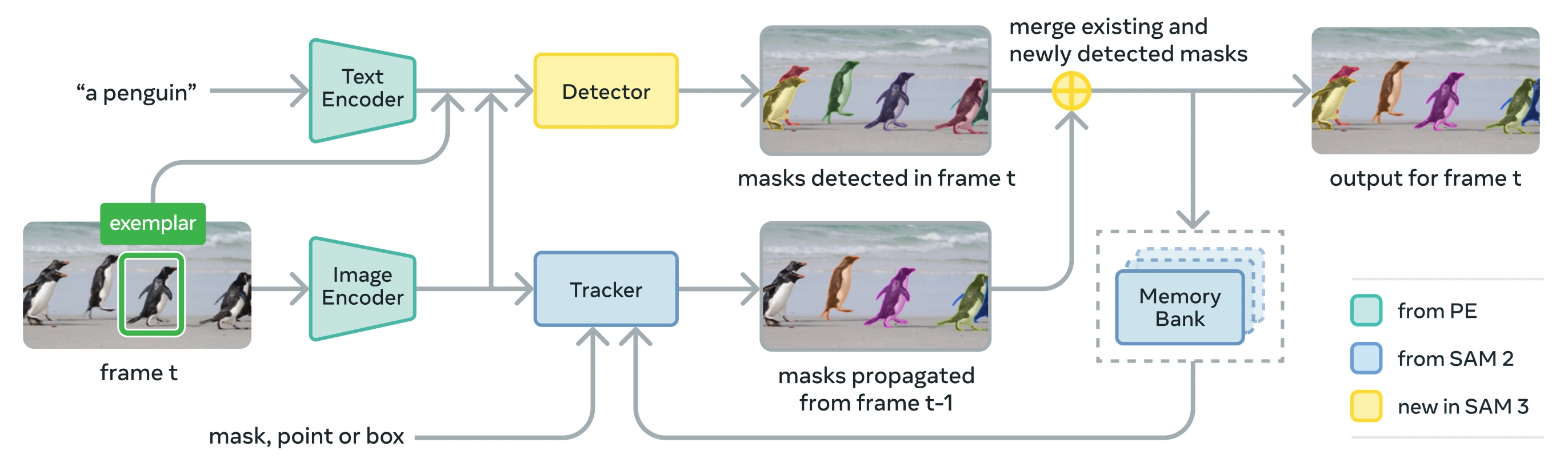

Architektur

SAM 3 besteht aus einem Detektor und einem Tracker, die sich ein Perception Encoder (PE) Vision-Backbone teilen. Dieses entkoppelte Design vermeidet Aufgabenkonflikte und ermöglicht sowohl die Erkennung auf Bildebene als auch die Verfolgung auf Videoebene, mit einer Schnittstelle, die mit der Verwendung von Ultralytics Python und CLI kompatibel ist.

Kernkomponenten

Detektor: DETR-basierte Architektur zur Erkennung von Konzepten auf Bildebene

- Textkodierer für Nomenphrasen-Eingabeaufforderungen

- Exemplar-Encoder für bildbasierte Eingabeaufforderungen

- Fusions-Encoder zur Konditionierung von Bildmerkmalen auf Prompts

- Neuer Presence-Head, der die Erkennung ("was") von der Lokalisierung ("wo") entkoppelt

- Maskenkopf zur Erzeugung von Instanzsegmentierungsmasken

Tracker: Speicherbasierte Videosegmentierung, übernommen von SAM 2

- Prompt-Encoder, Masken-Decoder, Speicher-Encoder

- Speicherbank zum Speichern des Objekterscheinungsbildes über Frames hinweg

- Temporale Disambiguierung, unterstützt durch Techniken wie einen Kalman-Filter in Multi-Objekt-Szenarien

Präsenz-Token: Ein gelerntes globales Token, das vorhersagt, ob das Zielkonzept im Bild/Frame vorhanden ist, wodurch die detect durch Trennung von Erkennung und Lokalisierung verbessert wird.

Schlüsselinnovationen

- Entkoppelte Erkennung und Lokalisierung: Der Presence-Head prognostiziert die globale Präsenz von Konzepten, während Proposal-Queries sich ausschließlich auf die Lokalisierung konzentrieren, wodurch widersprüchliche Ziele vermieden werden.

- Vereinheitlichte Konzept- und visuelle Prompts: Unterstützt sowohl PCS (Konzept-Prompts) als auch PVS (visuelle Prompts wie SAM 2's Klicks/Boxen) in einem einzigen Modell.

- Interaktive Exemplar-Verfeinerung: Benutzer können positive oder negative Bildbeispiele hinzufügen, um die Ergebnisse iterativ zu verfeinern, wobei das Modell auf ähnliche Objekte verallgemeinert, anstatt nur einzelne Instanzen zu korrigieren.

- Temporale Disambiguierung: Nutzt Masklet-Erkennungsergebnisse und periodische Neuaufforderungen, um Verdeckungen, überfüllte Szenen und Tracking-Fehler in Videos zu handhaben, im Einklang mit den Best Practices für Instanzsegmentierung und Tracking.

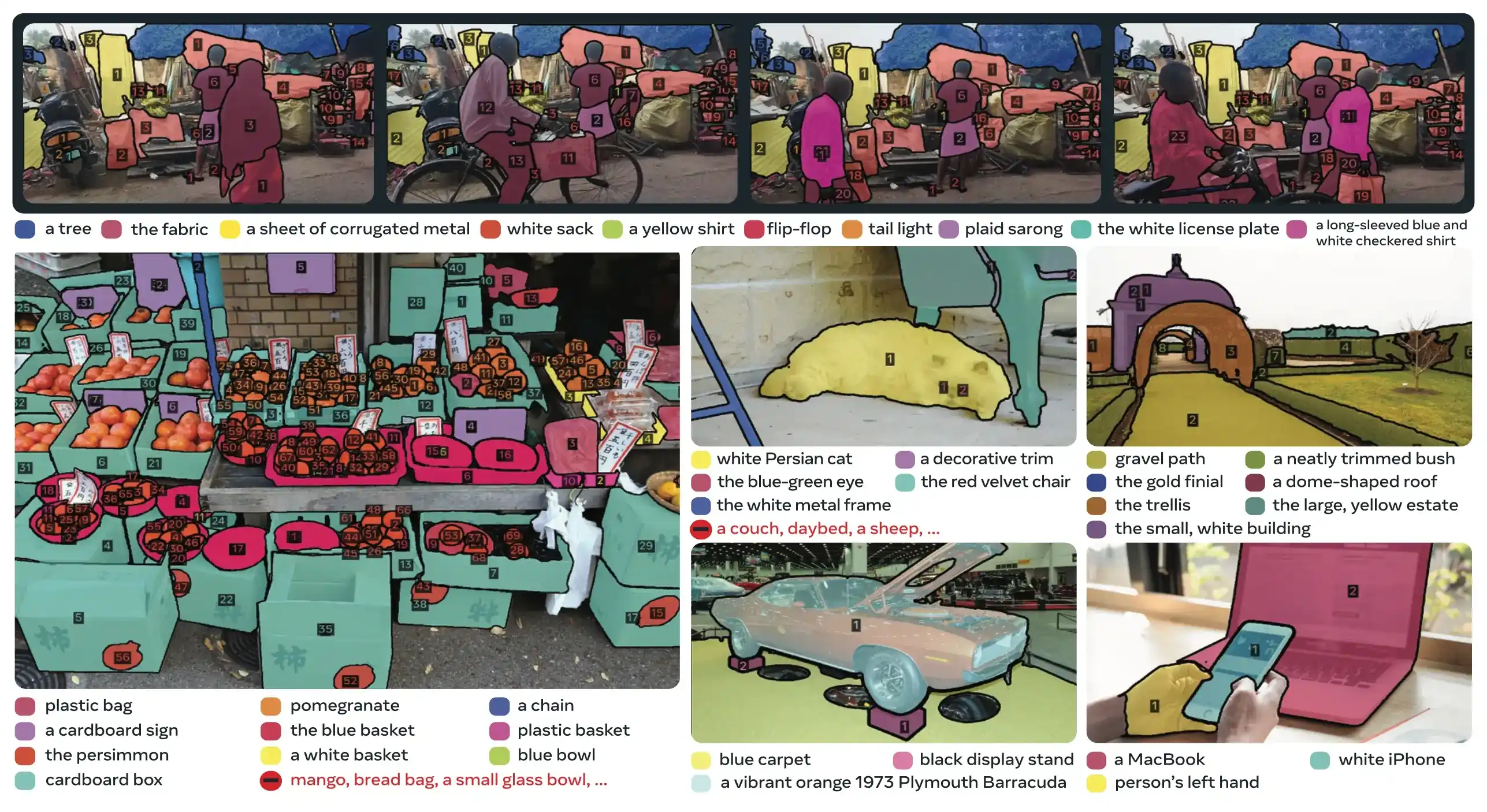

SA-Co Datensatz

SAM 3 wird auf Segment Anything with Concepts (SA-Co) trainiert, Metas größtem und vielfältigstem Segmentierungsdatensatz bis heute, der über gängige Benchmarks wie COCO und LVIS hinausgeht.

Trainingsdaten

| Datensatzkomponente | Beschreibung | Skala |

|---|---|---|

| SA-Co/HQ | Hochwertige, von Menschen annotierte Bilddaten aus einer 4-Phasen-Daten-Engine | 5,2 Mio. Bilder, 4 Mio. einzigartige Substantivgruppen |

| SA-Co/SYN | Synthetischer Datensatz, der von KI ohne menschliche Beteiligung beschriftet wird | 38M Substantivgruppen, 1,4B Masken |

| SA-Co/EXT | 15 externe Datensätze, angereichert mit Hard Negatives | Variiert je nach Quelle |

| SA-Co/VIDEO | Videoanmerkungen mit zeitlicher Verfolgung | 52,5K Videos, 24,8K einzigartige Substantivgruppen |

Benchmark-Daten

Der SA-Co Evaluierungs-Benchmark enthält 214K einzigartige Phrasen über 126K Bilder und Videos und bietet über 50× mehr Konzepte als bestehende Benchmarks. Er umfasst:

- SA-Co/Gold: 7 Domänen, dreifach annotiert zur Messung menschlicher Leistungsgrenzen

- SA-Co/Silver: 10 Domänen, einzelne menschliche Annotation

- SA-Co/Bronze und SA-Co/Bio: 9 bestehende Datensätze, angepasst für die Konzeptsegmentierung

- SA-Co/VEval: Video-Benchmark mit 3 Domänen (SA-V, YT-Temporal-1B, SmartGlasses)

Innovationen der Daten-Engine

Die skalierbare Human- und Model-in-the-Loop-Datenengine von SAM 3 erreicht eine 2-fache Annotationsleistung durch:

- KI-Annotatoren: Auf Llama basierende Modelle schlagen verschiedene Nominalphrasen vor, einschließlich schwieriger Negativbeispiele.

- KI-Verifizierer: Feinabgestimmte multimodale LLMs überprüfen die Maskenqualität und -vollständigkeit mit nahezu menschlicher Leistung.

- Aktives Mining: Konzentriert die menschliche Anstrengung auf schwierige Fehlerfälle, in denen KI Schwierigkeiten hat

- Ontologie-gesteuert: Nutzt eine umfangreiche Ontologie auf der Grundlage von Wikidata zur Erfassung von Konzepten

Installation

SAM 3 ist in Ultralytics Version 8.3.237 und höher verfügbar. Installieren oder aktualisieren Sie mit:

pip install -U ultralytics

SAM 3 Modellgewichte erforderlich

Im Gegensatz zu anderen Ultralytics-Modellen sind die SAM 3 Gewichte (sam3.pt) sind nicht automatisch heruntergeladen. Sie müssen zunächst den Zugriff auf die Modellgewichte auf der SAM 3 Modellseite auf Hugging Face und dann, nach Genehmigung, die sam3.pt Datei definiert. Legen Sie die heruntergeladene sam3.pt Datei in Ihrem Arbeitsverzeichnis ab oder geben Sie den vollständigen Pfad beim Laden des Modells an.

TypeError: 'SimpleTokenizer' object is not callable

Wenn Sie während der Vorhersage die oben genannte Fehlermeldung erhalten, bedeutet dies, dass Sie die falsche clip Paket installiert. Installieren Sie das richtige clip Paket durch Ausführen des folgenden Befehls:

pip uninstall clip -y

pip install git+https://github.com/ultralytics/CLIP.git

Wie man SAM 3 verwendet: Vielseitigkeit in der Konzeptsegmentierung

SAM 3 unterstützt sowohl Promptable Concept Segmentation (PCS) als auch Promptable Visual Segmentation (PVS) Aufgaben über verschiedene Prädiktor-Schnittstellen:

Unterstützte Aufgaben und Modelle

| Aufgabentyp | Prompt-Typen | Ausgabe |

|---|---|---|

| Konzeptsegmentierung (PCS) | Text (Nomenphrasen), Bildbeispiele | Alle Instanzen, die dem Konzept entsprechen |

| Visuelle Segmentierung (PVS) | Punkte, Boxen, Masken | Einzelne Objektinstanz (SAM 2 Stil) |

| Interaktive Verfeinerung | Exemplare oder Klicks iterativ hinzufügen/entfernen | Verfeinerte Segmentierung mit verbesserter Genauigkeit |

Beispiele für Konzeptsegmentierung

segment mit Textaufforderungen

Textbasierte Konzept-Segmentierung

Finden und segmentieren Sie alle Instanzen eines Konzepts anhand einer Textbeschreibung. Text-Prompts erfordern die SAM3SemanticPredictor Schnittstelle.

from ultralytics.models.sam import SAM3SemanticPredictor

# Initialize predictor with configuration

overrides = dict(

conf=0.25,

task="segment",

mode="predict",

model="sam3.pt",

half=True, # Use FP16 for faster inference

save=True,

)

predictor = SAM3SemanticPredictor(overrides=overrides)

# Set image once for multiple queries

predictor.set_image("path/to/image.jpg")

# Query with multiple text prompts

results = predictor(text=["person", "bus", "glasses"])

# Works with descriptive phrases

results = predictor(text=["person with red cloth", "person with blue cloth"])

# Query with a single concept

results = predictor(text=["a person"])

segment mit Bildbeispielen

Bild-Exemplar-basierte Segmentierung

Verwenden Sie Bounding Boxes als visuelle Prompts, um alle ähnlichen Instanzen zu finden. Dies erfordert auch SAM3SemanticPredictor für konzeptbasiertes Matching.

from ultralytics.models.sam import SAM3SemanticPredictor

# Initialize predictor

overrides = dict(conf=0.25, task="segment", mode="predict", model="sam3.pt", half=True, save=True)

predictor = SAM3SemanticPredictor(overrides=overrides)

# Set image

predictor.set_image("path/to/image.jpg")

# Provide bounding box examples to segment similar objects

results = predictor(bboxes=[[480.0, 290.0, 590.0, 650.0]])

# Multiple bounding boxes for different concepts

results = predictor(bboxes=[[539, 599, 589, 639], [343, 267, 499, 662]])

Merkmalbasierte Inferenz für Effizienz

Wiederverwendung von Bildmerkmalen für mehrere Abfragen

Bildmerkmale einmal extrahieren und für mehrere Segmentierungsabfragen wiederverwenden, um die Effizienz zu verbessern.

import cv2

from ultralytics.models.sam import SAM3SemanticPredictor

from ultralytics.utils.plotting import Annotator, colors

# Initialize predictors

overrides = dict(conf=0.50, task="segment", mode="predict", model="sam3.pt", verbose=False)

predictor = SAM3SemanticPredictor(overrides=overrides)

predictor2 = SAM3SemanticPredictor(overrides=overrides)

# Extract features from the first predictor

source = "path/to/image.jpg"

predictor.set_image(source)

src_shape = cv2.imread(source).shape[:2]

# Setup second predictor and reuse features

predictor2.setup_model()

# Perform inference using shared features with text prompt

masks, boxes = predictor2.inference_features(predictor.features, src_shape=src_shape, text=["person"])

# Perform inference using shared features with bounding box prompt

masks, boxes = predictor2.inference_features(predictor.features, src_shape=src_shape, bboxes=[[439, 437, 524, 709]])

# Visualize results

if masks is not None:

masks, boxes = masks.cpu().numpy(), boxes.cpu().numpy()

im = cv2.imread(source)

annotator = Annotator(im, pil=False)

annotator.masks(masks, [colors(x, True) for x in range(len(masks))])

cv2.imshow("result", annotator.result())

cv2.waitKey(0)

Videokonzept-Segmentierung

Konzepte in Videos mit Bounding Boxes verfolgen

Video-Tracking mit visuellen Prompts

detect und track Objektinstanzen über Videobilder hinweg mithilfe von Bounding-Box-Prompts.

from ultralytics.models.sam import SAM3VideoPredictor

# Create video predictor

overrides = dict(conf=0.25, task="segment", mode="predict", model="sam3.pt", half=True)

predictor = SAM3VideoPredictor(overrides=overrides)

# Track objects using bounding box prompts

results = predictor(source="path/to/video.mp4", bboxes=[[706.5, 442.5, 905.25, 555], [598, 635, 725, 750]], stream=True)

# Process and display results

for r in results:

r.show() # Display frame with segmentation masks

Konzepte mit Text-Prompts verfolgen

Video-Tracking mit semantischen Abfragen

Tracken Sie alle Instanzen von Konzepten, die durch Text über Videobilder hinweg spezifiziert werden.

from ultralytics.models.sam import SAM3VideoSemanticPredictor

# Initialize semantic video predictor

overrides = dict(conf=0.25, task="segment", mode="predict", imgsz=640, model="sam3.pt", half=True, save=True)

predictor = SAM3VideoSemanticPredictor(overrides=overrides)

# Track concepts using text prompts

results = predictor(source="path/to/video.mp4", text=["person", "bicycle"], stream=True)

# Process results

for r in results:

r.show() # Display frame with tracked objects

# Alternative: Track with bounding box prompts

results = predictor(

source="path/to/video.mp4",

bboxes=[[864, 383, 975, 620], [705, 229, 782, 402]],

labels=[1, 1], # Positive labels

stream=True,

)

Visuelle Aufforderungen (SAM 2-Kompatibilität)

SAM 3 ist vollständig abwärtskompatibel mit dem visuellen Prompting von SAM 2 für die Segmentierung einzelner Objekte:

SAM 2-Stil Visuelle Prompts

Das grundlegende SAM Die Schnittstelle verhält sich genau wie SAM 2, wobei nur der spezifische Bereich segmentiert wird, der durch visuelle Eingabeaufforderungen (Punkte, Boxen oder Masken) angegeben ist.

from ultralytics import SAM

model = SAM("sam3.pt")

# Single point prompt - segments object at specific location

results = model.predict(source="path/to/image.jpg", points=[900, 370], labels=[1])

results[0].show()

# Multiple points - segments single object with multiple point hints

results = model.predict(source="path/to/image.jpg", points=[[400, 370], [900, 370]], labels=[1, 1])

# Box prompt - segments object within bounding box

results = model.predict(source="path/to/image.jpg", bboxes=[100, 150, 300, 400])

results[0].show()

Visuelle Aufforderungen vs. Konzeptsegmentierung

Verwendung von SAM("sam3.pt") mit visuellen Prompts (Punkten/Boxen/Masken) wird segmentieren nur das spezifische Objekt an diesem Ort, genau wie SAM 2. Zum segment alle Instanzen eines Konzepts, verwenden Sie SAM3SemanticPredictor mit Text- oder Beispiel-Prompts, wie oben gezeigt.

Leistungsbenchmarks

Bildsegmentierung

SAM 3 erzielt modernste Ergebnisse über mehrere Benchmarks hinweg, einschließlich realer Datensätze wie LVIS und COCO für die Segmentierung:

| Benchmark | Metrik | SAM 3 | Bisher bestes Ergebnis | Verbesserung |

|---|---|---|---|---|

| LVIS (Null-Schuss) | Masken AP | 47.0 | 38.5 | +22.1% |

| SA-Co/Gold | CGF1 | 65.0 | 34.3 (OWLv2) | +89.5% |

| COCO (Zero-Shot) | Box AP | 53.5 | 52,2 (T-Rex2) | +2.5% |

| ADE-847 (semantische Seg.) | mIoU | 14.7 | 9.2 (APE-D) | +59.8% |

| PascalConcept-59 | mIoU | 59.4 | 58.5 (APE-D) | +1.5% |

| Cityscapes (semantische Segmentierung) | mIoU | 65.1 | 44.2 (APE-D) | +47.3% |

Entdecken Sie Datensatzoptionen für schnelle Experimente in den Ultralytics Datensätzen.

Videosegmentierungsleistung

SAM 3 zeigt deutliche Verbesserungen gegenüber SAM 2 und dem vorherigen Stand der Technik bei Video-Benchmarks wie DAVIS 2017 und YouTube-VOS:

| Benchmark | Metrik | SAM 3 | SAM 2.1 L | Verbesserung |

|---|---|---|---|---|

| MOSEv2 | J&F | 60.1 | 47.9 | +25.5% |

| DAVIS 2017 | J&F | 92.0 | 90.7 | +1.4% |

| LVOSv2 | J&F | 88.2 | 79.6 | +10.8% |

| SA-V | J&F | 84.6 | 78.4 | +7.9% |

| YTVOS19 | J&F | 89.6 | 89.3 | +0.3% |

Few-Shot-Anpassung

SAM 3 zeichnet sich durch die Anpassung an neue Domänen mit minimalen Beispielen aus, was für datenzentrierte KI-Workflows relevant ist:

| Benchmark | 0-shot AP | 10-shot AP | Bisher bestes Ergebnis (10-Shot) |

|---|---|---|---|

| ODinW13 | 59.9 | 71.6 | 67,9 (gDino1.5-Pro) |

| RF100-VL | 14.3 | 35.7 | 33.7 (gDino-T) |

Effektivität der interaktiven Verfeinerung

SAM 3s konzeptbasiertes Prompting mit Exemplaren konvergiert wesentlich schneller als visuelles Prompting:

| Prompts hinzugefügt | CGF1-Ergebnis | Gewinn im Vergleich zu Text-Only | Gewinn im Vergleich zur PVS-Baseline |

|---|---|---|---|

| Nur Text | 46.4 | Baseline | Baseline |

| +1 exemplar | 57.6 | +11.2 | +6.7 |

| +2 exemplars | 62.2 | +15.8 | +9.7 |

| +3 exemplars | 65.0 | +18.6 | +11.2 |

| +4 exemplars | 65.7 | +19.3 | +11.5 (plateau) |

Genauigkeit der Objektzählung

SAM 3 ermöglicht eine präzise Zählung durch die Segmentierung aller Instanzen, eine gängige Anforderung bei der Objektzählung:

| Benchmark | Genauigkeit | MAE | vs. beste MLLM |

|---|---|---|---|

| CountBench | 95.6% | 0.11 | 92,4% (Gemini 2.5) |

| PixMo-Count | 87.3% | 0.22 | 88,8% (Molmo-72B) |

SAM 3 vs. SAM 2 vs. YOLO Vergleich

Hier vergleichen wir die Fähigkeiten von SAM 3 mit SAM 2 und YOLO11-Modellen:

| Funktionalität | SAM 3 | SAM 2 | YOLO11n-seg |

|---|---|---|---|

| Konzeptsegmentierung | ✅ Alle Instanzen aus Text/Mustern | ❌ Nicht unterstützt | ❌ Nicht unterstützt |

| Visuelle Segmentierung | ✅ Einzelne Instanz (SAM 2 kompatibel) | ✅ Einzelne Instanz | ✅ Alle Instanzen |

| Zero-Shot-Fähigkeit | ✅ Offener Wortschatz | ✅ Geometrische Eingabeaufforderungen | ❌ Geschlossener Satz |

| Interaktive Verfeinerung | ✅ Exemplare + Klicks | ✅ Nur Klicks | ❌ Nicht unterstützt |

| Video-Tracking | ✅ Multi-Objekt mit Identitäten | ✅ Multi-Objekt | ✅ Multi-Objekt |

| LVIS Masken AP (Null-Schuss) | 47.0 | N/A | N/A |

| MOSEv2 J&F | 60.1 | 47.9 | N/A |

| Inferenzgeschwindigkeit (H200) | 30 ms (100+ objects) | ~23 ms (pro Objekt) | 2-3 ms (Bild) |

| Modellgröße | 3.4GB | 162 MB (Basis) | 5,9 MB |

Wichtige Erkenntnisse:

- SAM 3: Am besten geeignet für die Segmentierung von Konzepten mit offenem Wortschatz, um alle Instanzen eines Konzepts mit Text oder Beispielen zu finden

- SAM 2: Am besten geeignet für die interaktive Segmentierung von Einzelobjekten in Bildern und Videos mit geometrischen Eingabeaufforderungen

- YOLO11: Am besten für Echtzeit-, Hochgeschwindigkeits-Segmentierung in ressourcenbeschränkten Einsätzen unter Verwendung effizienter Export-Pipelines wie ONNX und TensorRT

Evaluierungsmetriken

SAM 3 führt neue Metriken ein, die für die PCS-Aufgabe entwickelt wurden und bekannte Maße wie F1-Score, Präzision und Recall ergänzen.

Klassifizierungsgesteuertes F1 (CGF1)

Die primäre Metrik, die Lokalisierung und Klassifizierung kombiniert:

CGF1 = 100 × pmF1 × IL_MCC

Wobei:

- pmF1 (Positives Makro F1): Misst die Lokalisierungsqualität bei positiven Beispielen

- IL_MCC (Matthews-Korrelationskoeffizient auf Bildebene): Misst die binäre Klassifizierungsgenauigkeit ("ist das Konzept vorhanden?")

Warum diese Metriken?

Traditionelle AP-Metriken berücksichtigen keine Kalibrierung, was die Modelle in der Praxis schwer nutzbar macht. Durch die Bewertung nur von Vorhersagen mit einer Konfidenz über 0,5 erzwingen die Metriken von SAM 3 eine gute Kalibrierung und ahmen reale Nutzungsmuster in interaktiven predict- und track-Schleifen nach.

Wichtige Ablationen und Erkenntnisse

Einfluss des Präsenz-Heads

Der Presence-Head entkoppelt die Erkennung von der Lokalisierung und bietet signifikante Verbesserungen:

| Konfiguration | CGF1 | IL_MCC | pmF1 |

|---|---|---|---|

| Ohne Präsenz | 57.6 | 0.77 | 74.7 |

| Mit Präsenz | 63.3 | 0.82 | 77.1 |

Der Presence-Head bietet einen +5.7 CGF1-Boost (+9.9%), der hauptsächlich die Erkennungsfähigkeit verbessert (IL_MCC +6.5%).

Auswirkung von Hard Negatives

| Hard Negatives/Bild | CGF1 | IL_MCC | pmF1 |

|---|---|---|---|

| 0 | 31.8 | 0.44 | 70.2 |

| 5 | 44.8 | 0.62 | 71.9 |

| 30 | 49.2 | 0.68 | 72.3 |

Hard Negatives sind entscheidend für die Open-Vocabulary-Erkennung und verbessern IL_MCC um 54,5% (0,44 → 0,68).

Skalierung von Trainingsdaten

| Datenquellen | CGF1 | IL_MCC | pmF1 |

|---|---|---|---|

| Nur extern | 30.9 | 0.46 | 66.3 |

| Extern + Synthetisch | 39.7 | 0.57 | 70.6 |

| Extern + HQ | 51.8 | 0.71 | 73.2 |

| Alle drei | 54.3 | 0.74 | 73.5 |

Hochwertige menschliche Annotationen bieten große Vorteile gegenüber synthetischen oder externen Daten allein. Hintergrundinformationen zu Datenqualitätspraktiken finden Sie unter Datenerfassung und -annotation.

Anwendungen

Die Konzeptsegmentierungsfähigkeit von SAM 3 ermöglicht neue Anwendungsfälle:

- Inhaltsmoderation: Findet alle Instanzen spezifischer Inhaltstypen in Medienbibliotheken

- E-Commerce: Segmentierung aller Produkte eines bestimmten Typs in Katalogbildern, unterstützt Auto-Annotation

- Medizinische Bildgebung: Identifizieren Sie alle Vorkommen spezifischer Gewebetypen oder Anomalien

- Autonome Systeme: tracken Sie alle Instanzen von Verkehrsschildern, Fußgängern oder Fahrzeugen nach Kategorie.

- Videoanalyse: Zählen und tracken Sie alle Personen, die bestimmte Kleidung tragen oder Aktionen ausführen

- Datensatz-Annotation: Schnelles Annotieren aller Instanzen seltener Objektkategorien

- Wissenschaftliche Forschung: Alle Proben quantifizieren und analysieren, die spezifische Kriterien erfüllen

SAM 3 Agent: Erweitertes sprachliches Reasoning

SAM 3 kann mit Multimodalen Großen Sprachmodellen (MLLMs) kombiniert werden, um komplexe Abfragen zu bearbeiten, die logisches Denken erfordern, ähnlich im Ansatz wie Open-Vocabulary-Systeme wie OWLv2 und T-Rex.

Leistung bei Reasoning-Aufgaben

| Benchmark | Metrik | SAM 3 Agent (Gemini 2.5 Pro) | Bisher bestes Ergebnis |

|---|---|---|---|

| ReasonSeg (Validierung) | gIoU | 76.0 | 65,0 (SoTA) |

| ReasonSeg (Test) | gIoU | 73.8 | 61,3 (SoTA) |

| OmniLabel (Validierung) | AP | 46.7 | 36,5 (REAL) |

| RefCOCO+ | Acc | 91.2 | 89,3 (LISA) |

Beispiel für komplexe Abfragen

SAM 3 Agent kann Abfragen bearbeiten, die logisches Denken erfordern:

- "People sitting down but not holding a gift box in their hands"

- "The dog closest to the camera that is not wearing a collar"

- "Red objects larger than the person's hand"

Das MLLM schlägt einfache Nomenphrasen-Abfragen an SAM 3 vor, analysiert zurückgegebene Masken und iteriert, bis es zufrieden ist.

Einschränkungen

Während SAM 3 einen großen Fortschritt darstellt, weist es bestimmte Einschränkungen auf:

- Phrasenkomplexität: Am besten geeignet für einfache Nominalphrasen; lange referenzielle Ausdrücke oder komplexe Schlussfolgerungen können eine MLLM-Integration erfordern.

- Umgang mit Mehrdeutigkeiten: Einige Konzepte bleiben von Natur aus mehrdeutig (z. B. "kleines Fenster", "gemütliches Zimmer")

- Rechenanforderungen: Größer und langsamer als spezialisierte Detektionsmodelle wie YOLO

- Vokabularumfang: Fokus auf atomare visuelle Konzepte; kompositorisches Denken ist ohne MLLM-Unterstützung begrenzt

- Seltene Konzepte: Die Leistung kann bei extrem seltenen oder feingranularen Konzepten abnehmen, die in den Trainingsdaten nicht gut repräsentiert sind.

Zitierung

@inproceedings{sam3_2025,

title = {SAM 3: Segment Anything with Concepts},

author = {Anonymous authors},

booktitle = {Submitted to ICLR 2026},

year = {2025},

url = {https://openreview.net/forum?id=r35clVtGzw},

note = {Paper ID: 4183, under double-blind review}

}

FAQ

Wann wurde SAM 3 veröffentlicht?

SAM 3 wurde von Meta am 20. November 2025 veröffentlicht und ist seit Version 8.3.237 (PR #22897) vollständig in Ultralytics integriert. Volle Unterstützung ist für den Vorhersagemodus und den track mode verfügbar.

Ist SAM 3 in Ultralytics integriert?

Ja! SAM 3 ist vollständig in das Ultralytics python-Paket integriert, einschließlich Konzept-segmentation, visuellen Prompts im SAM 2-Stil und Multi-Objekt-Video-track.

Was ist Promptable Concept Segmentation (PCS)?

PCS ist eine neue Aufgabe, die in SAM 3 eingeführt wurde und alle Instanzen eines visuellen Konzepts in einem Bild oder Video segmentiert. Im Gegensatz zur traditionellen Segmentierung, die auf eine bestimmte Objektinstanz abzielt, findet PCS jedes Vorkommen einer Kategorie. Zum Beispiel:

- Textaufforderung: „gelber Schulbus“ → segmentiert alle gelben Schulbusse in der Szene

- Bild-Exemplar: Box um einen Hund → segmentiert alle Hunde im Bild

- Kombiniert: „gestreifte Katze“ + Exemplarbox → segmentiert alle gestreiften Katzen, die dem Beispiel entsprechen

Siehe verwandte Hintergrundinformationen zu Objekterkennung und Instanzsegmentierung.

Wie unterscheidet sich SAM 3 von SAM 2?

| Merkmal | SAM 2 | SAM 3 |

|---|---|---|

| Aufgabe | Einzelnes Objekt pro Prompt | Alle Instanzen eines Konzepts |

| Prompt-Typen | Punkte, Boxen, Masken | + Text phrases, image exemplars |

| Detektionsfähigkeit | Erfordert externen Detektor | Integrierter Open-Vocabulary-Detektor |

| Erkennung | Ausschließlich geometriebasiert | Text- und visuelle Erkennung |

| Architektur | Nur Tracker | Detektor + Tracker mit Anwesenheitskopf |

| Zero-Shot-Leistung | N/A (erfordert visuelle Prompts) | 47,0 AP auf LVIS, 2× besser auf SA-Co |

| Interaktive Verfeinerung | Nur Klicks | Klicks + Exemplar-Generalisierung |

SAM 3 ist abwärtskompatibel mit dem visuellen Prompting von SAM 2 und fügt gleichzeitig konzeptbasierte Fähigkeiten hinzu.

Welche Datensätze werden zum Trainieren von SAM 3 verwendet?

SAM 3 wird auf dem Segment Anything with Concepts (SA-Co) Datensatz trainiert:

Trainingsdaten:

- 5.2M images with 4M unique noun phrases (SA-Co/HQ) - high-quality human annotations

- 52.5K videos with 24.8K unique noun phrases (SA-Co/VIDEO)

- 1.4B synthetische Masken über 38M Substantivgruppen (SA-Co/SYN)

- 15 externe Datensätze, angereichert mit Hard Negatives (SA-Co/EXT)

Benchmark-Daten:

- 214K unique concepts across 126K images/videos

- 50× more concepts than existing benchmarks (e.g., LVIS has ~4K concepts)

- Dreifach-Annotation auf SA-Co/Gold zur Messung menschlicher Leistungsgrenzen

Diese enorme Skalierung und Vielfalt ermöglicht die überlegene Zero-Shot-Generalisierung von SAM 3 über Open-Vocabulary-Konzepte hinweg.

Wie vergleicht sich SAM 3 mit YOLO11 bei der Segmentierung?

SAM 3 und YOLO11 bedienen unterschiedliche Anwendungsfälle:

SAM 3 Vorteile:

- Offener Wortschatz: Segmentiert jedes Konzept über Textaufforderungen ohne Training

- Zero-shot: Funktioniert sofort mit neuen Kategorien

- Interaktiv: Exemplar-basierte Verfeinerung verallgemeinert auf ähnliche Objekte

- Konzeptbasiert: Findet automatisch alle Instanzen einer Kategorie

- Genauigkeit: 47,0 AP bei Zero-Shot-Instanzsegmentierung auf LVIS

YOLO11 Vorteile:

- Geschwindigkeit: 10-15x schnellere Inferenz (2-3 ms vs. 30 ms pro Bild)

- Effizienz: 576-mal kleinere Modelle (5.9MB gegenüber 3.4GB)

- Ressourcenschonend: Läuft auf Edge-Geräten und Mobilgeräten

- Echtzeit: Optimiert für Produktionseinsätze

Empfehlung:

- Verwenden Sie SAM 3 für eine flexible, offene Vokabular-segmentation, bei der Sie alle Instanzen von Konzepten finden müssen, die durch Text oder Beispiele beschrieben werden

- Verwenden Sie YOLO11 für Hochgeschwindigkeits-Produktionsbereitstellungen, bei denen Kategorien im Voraus bekannt sind

- Verwenden Sie SAM 2 für die interaktive Einzelobjekt-segmentation mit geometrischen Prompts

Kann SAM 3 komplexe Sprachanfragen verarbeiten?

SAM 3 ist für einfache Substantivphrasen konzipiert (z. B. "roter Apfel", "Person mit Hut"). Für komplexe Abfragen, die logisches Denken erfordern, kombinieren Sie SAM 3 mit einer MLLM als SAM 3 Agent:

Einfache Abfragen (natives SAM 3):

- "yellow school bus"

- "striped cat"

- "person wearing red hat"

Komplexe Abfragen (SAM 3 Agent mit MLLM):

- "People sitting down but not holding a gift box"

- "The dog closest to the camera without a collar"

- "Red objects larger than the person's hand"

SAM 3 Agent erzielt 76.0 gIoU bei der ReasonSeg-Validierung (vs. 65.0 vorheriger Bestwert, +16.9% Verbesserung) durch die Kombination der Segmentierung von SAM 3 mit MLLM-Reasoning-Fähigkeiten.

Wie genau ist SAM 3 im Vergleich zur menschlichen Leistung?

Im SA-Co/Gold-Benchmark mit dreifacher menschlicher Annotation:

- Menschliche Untergrenze: 74.2 CGF1 (konservativster Annotator)

- SAM 3 Leistung: 65.0 CGF1

- Leistung: 88 % der geschätzten unteren Grenze des Menschen

- Menschliche Obergrenze: 81.4 CGF1 (liberalster Annotator)

SAM 3 erzielt eine starke Leistung, die sich der menschlichen Genauigkeit bei der Open-Vocabulary Concept Segmentation nähert, wobei die Lücke hauptsächlich bei mehrdeutigen oder subjektiven Konzepten (z. B. „kleines Fenster“, „gemütliches Zimmer“) liegt.