Guide de démarrage rapide : NVIDIA DGX Spark avec Ultralytics YOLO26

Ce guide complet fournit une présentation détaillée du déploiement d'Ultralytics YOLO26 sur NVIDIA DGX Spark, le superordinateur d'IA de bureau compact de NVIDIA. De plus, il présente des benchmarks de performance pour démontrer les capacités de YOLO26 sur ce système puissant.

Remarque

Ce guide a été testé avec NVIDIA DGX Spark Founders Edition exécutant DGX OS basé sur Ubuntu. Il est censé fonctionner avec les dernières versions de DGX OS.

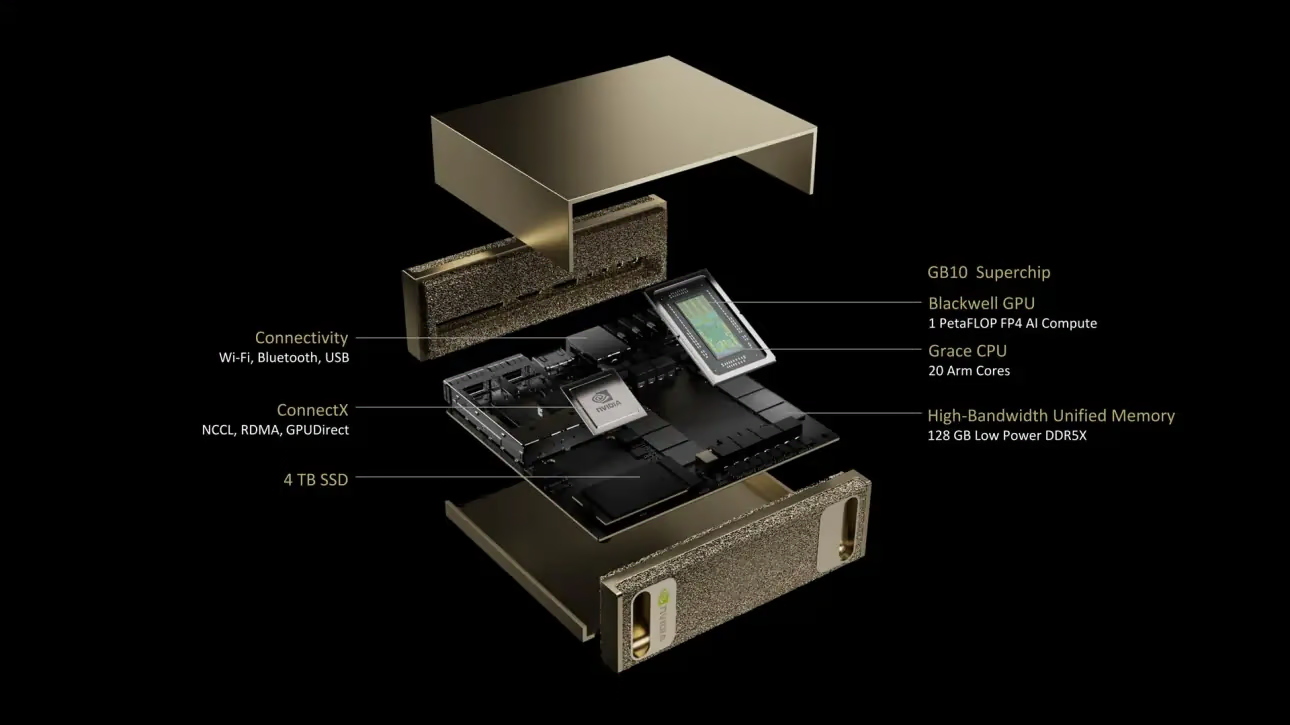

Qu'est-ce que NVIDIA DGX Spark ?

NVIDIA DGX Spark est un superordinateur d'IA de bureau compact alimenté par la superpuce NVIDIA GB10 Grace Blackwell. Il offre jusqu'à 1 pétaFLOP de performance de calcul d'IA avec une précision FP4, ce qui le rend idéal pour les développeurs, les chercheurs et les scientifiques des données qui ont besoin de puissantes capacités d'IA dans un format de bureau.

Spécifications clés

| Spécification | Détails |

|---|---|

| Performance de l'IA | Jusqu'à 1 PFLOP (FP4) |

| GPU | Architecture NVIDIA Blackwell avec cœurs Tensor de 5ème génération, cœurs RT de 4ème génération |

| CPU | Processeur Arm à 20 cœurs (10 Cortex-X925 + 10 Cortex-A725) |

| Mémoire | Mémoire système unifiée LPDDR5x de 128 Go, interface 256 bits, 4266 MHz, bande passante de 273 Go/s |

| Stockage | 1 To ou 4 To NVMe M.2 avec auto-chiffrement |

| Réseau | 1x RJ-45 (10 GbE), ConnectX-7 Smart NIC, Wi-Fi 7, Bluetooth 5.4 |

| Connectivité | 4x USB Type-C, 1x HDMI 2.1a, audio multicanal HDMI |

| Traitement vidéo | 1x NVENC, 1x NVDEC |

DGX OS

NVIDIA DGX OS est une distribution Linux personnalisée qui fournit une base de système d'exploitation stable, testée et supportée pour l'exécution d'applications d'IA, d'apprentissage automatique et d'analyse sur les systèmes DGX. Il comprend :

- Une base Linux robuste optimisée pour les charges de travail d'IA

- Pilotes et paramètres système préconfigurés pour le matériel NVIDIA

- Mises à jour de sécurité et capacités de maintenance du système

- Compatibilité avec l'écosystème logiciel NVIDIA plus large

DGX OS suit un calendrier de publication régulier avec des mises à jour généralement fournies deux fois par an (vers février et août), avec des correctifs de sécurité supplémentaires fournis entre les versions majeures.

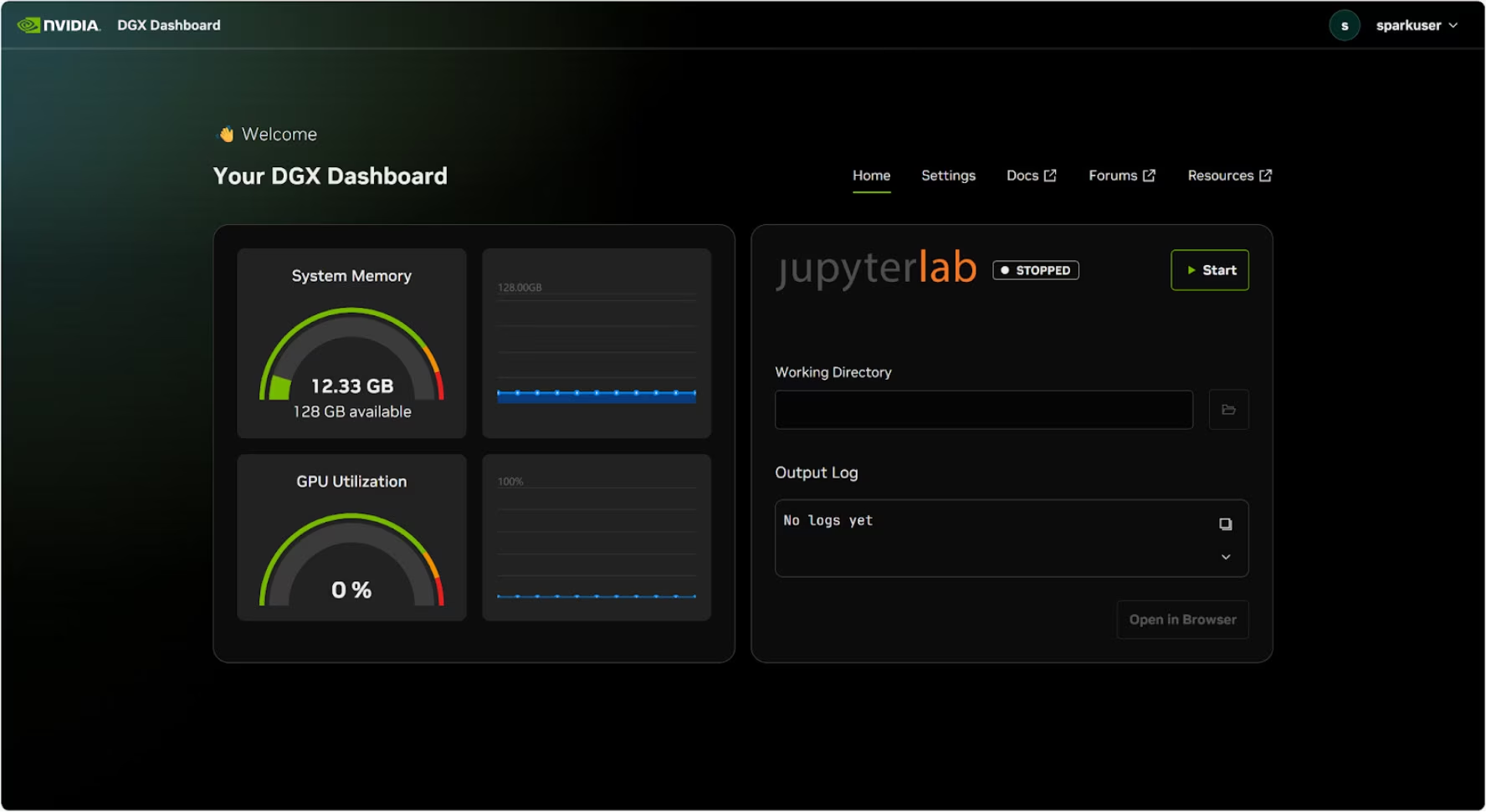

Tableau de bord DGX

DGX Spark est livré avec un tableau de bord DGX intégré qui fournit :

- Surveillance du système en temps réel : Vue d'ensemble des métriques opérationnelles actuelles du système

- Mises à jour du système : Possibilité d'appliquer les mises à jour directement depuis le tableau de bord

- Paramètres système : Modifier le nom de l'appareil et d'autres configurations

- JupyterLab intégré : Accéder aux notebooks Jupyter locaux pour le développement

Accéder au tableau de bord

Cliquez sur le bouton « Afficher les applications » dans le coin inférieur gauche du bureau Ubuntu, puis sélectionnez « DGX Dashboard » pour l'ouvrir dans votre navigateur.

# Open an SSH tunnel

ssh -L 11000:localhost:11000 username@spark-abcd.local

# Then open in browser

# http://localhost:11000

Après vous être connecté avec NVIDIA Sync, cliquez sur le bouton « DGX Dashboard » pour ouvrir le tableau de bord à l'adresse http://localhost:11000.

JupyterLab intégré

Le tableau de bord comprend une instance JupyterLab intégrée qui crée automatiquement un environnement virtuel et installe les paquets recommandés lors de son démarrage. Chaque compte utilisateur se voit attribuer un port dédié pour l'accès à JupyterLab.

Démarrage rapide avec Docker

Le moyen le plus rapide de démarrer avec Ultralytics YOLO26 sur NVIDIA DGX Spark est d'utiliser des images Docker pré-construites. La même image Docker qui prend en charge Jetson AGX Thor (JetPack 7.0) fonctionne sur DGX Spark avec DGX OS.

t=ultralytics/ultralytics:latest-nvidia-arm64

sudo docker pull $t && sudo docker run -it --ipc=host --runtime=nvidia --gpus all $t

Une fois cette étape terminée, passez à la section Utiliser TensorRT sur NVIDIA DGX Spark.

Commencer avec l'installation native

Pour une installation native sans Docker, suivez ces étapes.

Installer le paquet Ultralytics

Ici, nous allons installer le paquet Ultralytics sur DGX Spark avec des dépendances optionnelles afin de pouvoir exporter les modèles PyTorch vers d'autres formats. Nous nous concentrerons principalement sur les exportations NVIDIA TensorRT car TensorRT nous assurera d'obtenir les performances maximales du DGX Spark.

Mettre à jour la liste des paquets, installer pip et mettre à niveau vers la dernière version

sudo apt update sudo apt install python3-pip -y pip install -U pipInstaller

ultralyticsPaquet pip avec des dépendances optionnellespip install ultralytics[export]Redémarrez l'appareil

sudo reboot

Installer PyTorch et Torchvision

L'installation d'Ultralytics ci-dessus installera Torch et Torchvision. Cependant, ces paquets installés via pip pourraient ne pas être entièrement optimisés pour l'architecture ARM64 du DGX Spark avec CUDA 13. Par conséquent, nous recommandons d'installer les versions compatibles CUDA 13 :

pip install torch torchvision --index-url https://download.pytorch.org/whl/cu130

Info

Lors de l'exécution de PyTorch 2.9.1 sur NVIDIA DGX Spark, vous pourriez rencontrer le message suivant UserWarning lors de l'initialisation de CUDA (par exemple, en exécutant yolo checks, yolo predict, etc.) :

UserWarning: Found GPU0 NVIDIA GB10 which is of cuda capability 12.1.

Minimum and Maximum cuda capability supported by this version of PyTorch is (8.0) - (12.0)

Cet avertissement peut être ignoré en toute sécurité. Pour résoudre ce problème de manière permanente, un correctif a été soumis dans la PR PyTorch #164590 qui sera inclus dans la version PyTorch 2.10.

Installer onnxruntime-gpu

L'argument onnxruntime-gpu package hébergé dans PyPI n'a pas aarch64 binaires pour les systèmes ARM64. Nous devons donc installer ce paquet manuellement. Ce paquet est nécessaire pour certaines exportations.

Ici, nous allons télécharger et installer onnxruntime-gpu 1.24.0 avec Python3.12 support.

pip install https://github.com/ultralytics/assets/releases/download/v0.0.0/onnxruntime_gpu-1.24.0-cp312-cp312-linux_aarch64.whl

Utiliser TensorRT sur NVIDIA DGX Spark

Parmi tous les formats d'exportation de modèles pris en charge par Ultralytics, TensorRT offre les performances d'inférence les plus élevées sur NVIDIA DGX Spark, ce qui en fait notre principale recommandation pour les déploiements. Pour les instructions de configuration et l'utilisation avancée, consultez notre guide d'intégration TensorRT dédié.

Convertir le modèle en TensorRT et exécuter l'inférence

Le modèle YOLO26n au format PyTorch est converti en TensorRT pour exécuter l'inférence avec le modèle exporté.

Exemple

from ultralytics import YOLO

# Load a YOLO26n PyTorch model

model = YOLO("yolo26n.pt")

# Export the model to TensorRT

model.export(format="engine") # creates 'yolo26n.engine'

# Load the exported TensorRT model

trt_model = YOLO("yolo26n.engine")

# Run inference

results = trt_model("https://ultralytics.com/images/bus.jpg")

# Export a YOLO26n PyTorch model to TensorRT format

yolo export model=yolo26n.pt format=engine # creates 'yolo26n.engine'

# Run inference with the exported model

yolo predict model=yolo26n.engine source='https://ultralytics.com/images/bus.jpg'

Remarque

Consultez la page d’exportation pour accéder à des arguments supplémentaires lors de l’exportation de modèles vers différents formats de modèles.

Benchmarks YOLO11 sur NVIDIA DGX Spark

Des benchmarks YOLO11 ont été exécutés par l'équipe Ultralytics sur plusieurs formats de modèles, mesurant la vitesse et la précision : PyTorch, TorchScript, ONNX, OpenVINO, TensorRT, TF SavedModel, TF GraphDef, TF Lite, MNN, NCNN, ExecuTorch. Les benchmarks ont été exécutés sur NVIDIA DGX Spark avec une précision FP32 et une taille d'image d'entrée par défaut de 640.

Tableau comparatif détaillé

Le tableau ci-dessous présente les résultats des benchmarks pour cinq modèles différents (YOLO11n, YOLO11s, YOLO11m, YOLO11l, YOLO11x) sur plusieurs formats, nous fournissant le statut, la taille, la métrique mAP50-95(B) et le temps d'inférence pour chaque combinaison.

Performance

| Format | Statut | Taille sur le disque (Mo) | mAP50-95(B) | Temps d'inférence (ms/im) |

|---|---|---|---|---|

| PyTorch | ✅ | 5.4 | 0.5071 | 2.67 |

| TorchScript | ✅ | 10.5 | 0.5083 | 2.62 |

| ONNX | ✅ | 10.2 | 0.5074 | 5.92 |

| OpenVINO | ✅ | 10.4 | 0.5058 | 14.95 |

| TensorRT (FP32) | ✅ | 12.8 | 0.5085 | 1.95 |

| TensorRT (FP16) | ✅ | 7.0 | 0.5068 | 1.01 |

| TensorRT (INT8) | ✅ | 18.6 | 0.4880 | 1.62 |

| TF SavedModel | ✅ | 25.7 | 0.5076 | 36.39 |

| TF GraphDef | ✅ | 10.3 | 0.5076 | 41.06 |

| TF Lite | ✅ | 10.3 | 0.5075 | 64.36 |

| MNN | ✅ | 10.1 | 0.5075 | 12.14 |

| NCNN | ✅ | 10.2 | 0.5041 | 12.31 |

| ExecuTorch | ✅ | 10.2 | 0.5075 | 27.61 |

| Format | Statut | Taille sur le disque (Mo) | mAP50-95(B) | Temps d'inférence (ms/im) |

|---|---|---|---|---|

| PyTorch | ✅ | 18.4 | 0.5767 | 5.38 |

| TorchScript | ✅ | 36.5 | 0.5781 | 5.48 |

| ONNX | ✅ | 36.3 | 0.5784 | 8.17 |

| OpenVINO | ✅ | 36.4 | 0.5809 | 27.12 |

| TensorRT (FP32) | ✅ | 39.8 | 0.5783 | 3.59 |

| TensorRT (FP16) | ✅ | 20.1 | 0.5800 | 1.85 |

| TensorRT (INT8) | ✅ | 17.5 | 0.5664 | 1.88 |

| TF SavedModel | ✅ | 90.8 | 0.5782 | 66.63 |

| TF GraphDef | ✅ | 36.3 | 0.5782 | 71.67 |

| TF Lite | ✅ | 36.3 | 0.5782 | 187.36 |

| MNN | ✅ | 36.2 | 0.5775 | 27.05 |

| NCNN | ✅ | 36.2 | 0.5806 | 26.26 |

| ExecuTorch | ✅ | 36.2 | 0.5782 | 54.73 |

| Format | Statut | Taille sur le disque (Mo) | mAP50-95(B) | Temps d'inférence (ms/im) |

|---|---|---|---|---|

| PyTorch | ✅ | 38.8 | 0.6254 | 11.14 |

| TorchScript | ✅ | 77.3 | 0.6304 | 12.00 |

| ONNX | ✅ | 76.9 | 0.6304 | 13.83 |

| OpenVINO | ✅ | 77.1 | 0.6284 | 62.44 |

| TensorRT (FP32) | ✅ | 79.9 | 0.6305 | 6.96 |

| TensorRT (FP16) | ✅ | 40.6 | 0.6313 | 3.14 |

| TensorRT (INT8) | ✅ | 26.6 | 0.6204 | 3.30 |

| TF SavedModel | ✅ | 192.4 | 0.6306 | 139.85 |

| TF GraphDef | ✅ | 76.9 | 0.6306 | 146.76 |

| TF Lite | ✅ | 76.9 | 0.6306 | 568.18 |

| MNN | ✅ | 76.8 | 0.6306 | 67.67 |

| NCNN | ✅ | 76.8 | 0.6308 | 60.49 |

| ExecuTorch | ✅ | 76.9 | 0.6306 | 120.37 |

| Format | Statut | Taille sur le disque (Mo) | mAP50-95(B) | Temps d'inférence (ms/im) |

|---|---|---|---|---|

| PyTorch | ✅ | 49.0 | 0.6366 | 13.95 |

| TorchScript | ✅ | 97.6 | 0.6399 | 15.67 |

| ONNX | ✅ | 97.0 | 0.6399 | 16.62 |

| OpenVINO | ✅ | 97.3 | 0.6377 | 78.80 |

| TensorRT (FP32) | ✅ | 99.2 | 0.6407 | 8.86 |

| TensorRT (FP16) | ✅ | 50.8 | 0.6350 | 3.85 |

| TensorRT (INT8) | ✅ | 32.5 | 0.6224 | 4.52 |

| TF SavedModel | ✅ | 242.7 | 0.6409 | 187.45 |

| TF GraphDef | ✅ | 97.0 | 0.6409 | 193.92 |

| TF Lite | ✅ | 97.0 | 0.6409 | 728.61 |

| MNN | ✅ | 96.9 | 0.6369 | 85.21 |

| NCNN | ✅ | 96.9 | 0.6373 | 77.62 |

| ExecuTorch | ✅ | 97.0 | 0.6409 | 153.56 |

| Format | Statut | Taille sur le disque (Mo) | mAP50-95(B) | Temps d'inférence (ms/im) |

|---|---|---|---|---|

| PyTorch | ✅ | 109.3 | 0.6992 | 23.19 |

| TorchScript | ✅ | 218.1 | 0.6900 | 25.75 |

| ONNX | ✅ | 217.5 | 0.6900 | 27.43 |

| OpenVINO | ✅ | 217.8 | 0.6872 | 149.44 |

| TensorRT (FP32) | ✅ | 222.7 | 0.6902 | 13.87 |

| TensorRT (FP16) | ✅ | 111.1 | 0.6883 | 6.19 |

| TensorRT (INT8) | ✅ | 62.9 | 0.6793 | 6.62 |

| TF SavedModel | ✅ | 543.9 | 0.6900 | 335.10 |

| TF GraphDef | ✅ | 217.5 | 0.6900 | 348.86 |

| TF Lite | ✅ | 217.5 | 0.6900 | 1578.66 |

| MNN | ✅ | 217.3 | 0.6874 | 168.95 |

| NCNN | ✅ | 217.4 | 0.6901 | 132.13 |

| ExecuTorch | ✅ | 217.4 | 0.6900 | 297.17 |

Benchmarké avec Ultralytics 8.3.249

Reproduire nos résultats

Pour reproduire les benchmarks Ultralytics ci-dessus sur tous les formats d’exportation, exécutez ce code :

Exemple

from ultralytics import YOLO

# Load a YOLO26n PyTorch model

model = YOLO("yolo26n.pt")

# Benchmark YOLO26n speed and accuracy on the COCO128 dataset for all export formats

results = model.benchmark(data="coco128.yaml", imgsz=640)

# Benchmark YOLO26n speed and accuracy on the COCO128 dataset for all export formats

yolo benchmark model=yolo26n.pt data=coco128.yaml imgsz=640

Notez que les résultats de benchmarking peuvent varier en fonction de la configuration matérielle et logicielle exacte d'un système, ainsi que de la charge de travail actuelle du système au moment de l'exécution des benchmarks. Pour les résultats les plus fiables, utilisez un jeu de données avec un grand nombre d'images, par exemple, data='coco.yaml' (5000 images de validation).

Bonnes pratiques pour NVIDIA DGX Spark

Lors de l'utilisation de NVIDIA DGX Spark, il existe quelques bonnes pratiques à suivre afin d'obtenir des performances maximales avec YOLO26.

Surveiller les performances du système

Utilisez les outils de surveillance de NVIDIA pour track l'utilisation du GPU et du CPU :

nvidia-smiOptimiser l'utilisation de la mémoire

Avec 128 Go de mémoire unifiée, DGX Spark peut gérer de grandes tailles de lot et des modèles volumineux. Envisagez d'augmenter la taille du lot pour un débit amélioré :

from ultralytics import YOLO model = YOLO("yolo26n.engine") results = model.predict(source="path/to/images", batch=16)Utiliser TensorRT avec FP16 ou INT8

Pour des performances optimales, exportez les modèles avec une précision FP16 ou INT8 :

yolo export model=yolo26n.pt format=engine half=True # FP16 yolo export model=yolo26n.pt format=engine int8=True # INT8

Mises à jour du système (Édition Fondateurs)

Maintenir votre DGX Spark Founders Edition à jour est crucial pour les performances et la sécurité. NVIDIA propose deux méthodes principales pour mettre à jour le système d'exploitation, les pilotes et le firmware.

Utilisation du tableau de bord DGX (Recommandé)

Le DGX Dashboard est la méthode recommandée pour effectuer les mises à jour du système tout en garantissant la compatibilité. Il vous permet de :

- Afficher les mises à jour système disponibles

- Installer les correctifs de sécurité et les mises à jour du système

- Gérer les mises à jour des pilotes et du firmware NVIDIA

Mises à jour manuelles du système

Pour les utilisateurs avancés, les mises à jour peuvent être effectuées manuellement via le terminal :

sudo apt update

sudo apt dist-upgrade

sudo fwupdmgr refresh

sudo fwupdmgr upgrade

sudo reboot

Avertissement

Assurez-vous que votre système est connecté à une source d'alimentation stable et que vous avez sauvegardé les données critiques avant d'effectuer les mises à jour.

Prochaines étapes

Pour plus d'informations et de support, consultez la documentation Ultralytics YOLO26.

FAQ

Comment déployer Ultralytics YOLO26 sur NVIDIA DGX Spark ?

Le déploiement d'Ultralytics YOLO26 sur NVIDIA DGX Spark est simple. Vous pouvez utiliser l'image Docker pré-construite pour une configuration rapide ou installer manuellement les paquets requis. Les étapes détaillées pour chaque approche se trouvent dans les sections Démarrage rapide avec Docker et Démarrage avec installation native.

Quelles performances puis-je attendre de YOLO26 sur NVIDIA DGX Spark ?

Les modèles YOLO26 offrent d'excellentes performances sur DGX Spark grâce au Superchip GB10 Grace Blackwell. Le format TensorRT offre les meilleures performances d'inférence. Consultez la section Tableau comparatif détaillé pour les résultats de benchmark spécifiques selon les différentes tailles et formats de modèles.

Pourquoi devrais-je utiliser TensorRT pour YOLO26 sur DGX Spark ?

TensorRT est fortement recommandé pour le déploiement des modèles YOLO26 sur DGX Spark en raison de ses performances optimales. Il accélère l'inférence en tirant parti des capacités du GPU Blackwell, garantissant une efficacité et une rapidité maximales. Apprenez-en davantage dans la section Utiliser TensorRT sur NVIDIA DGX Spark.

Comment DGX Spark se compare-t-il aux appareils Jetson pour YOLO26 ?

DGX Spark offre une puissance de calcul nettement supérieure à celle des appareils Jetson, avec jusqu'à 1 PFLOP de performances d'IA et 128 Go de mémoire unifiée, contre 2070 TFLOPS et 128 Go de mémoire pour Jetson AGX Thor. DGX Spark est conçu comme un superordinateur d'IA de bureau, tandis que les appareils Jetson sont des systèmes embarqués optimisés pour le déploiement en périphérie.

Puis-je utiliser la même image Docker pour DGX Spark et Jetson AGX Thor ?

Oui ! L' ultralytics/ultralytics:latest-nvidia-arm64 image Docker prend en charge à la fois NVIDIA DGX Spark (avec DGX OS) et Jetson AGX Thor (avec JetPack 7.0), car les deux utilisent l'architecture ARM64 avec CUDA 13 et des piles logicielles similaires.