Ultralytics YOLO26

Aperçu

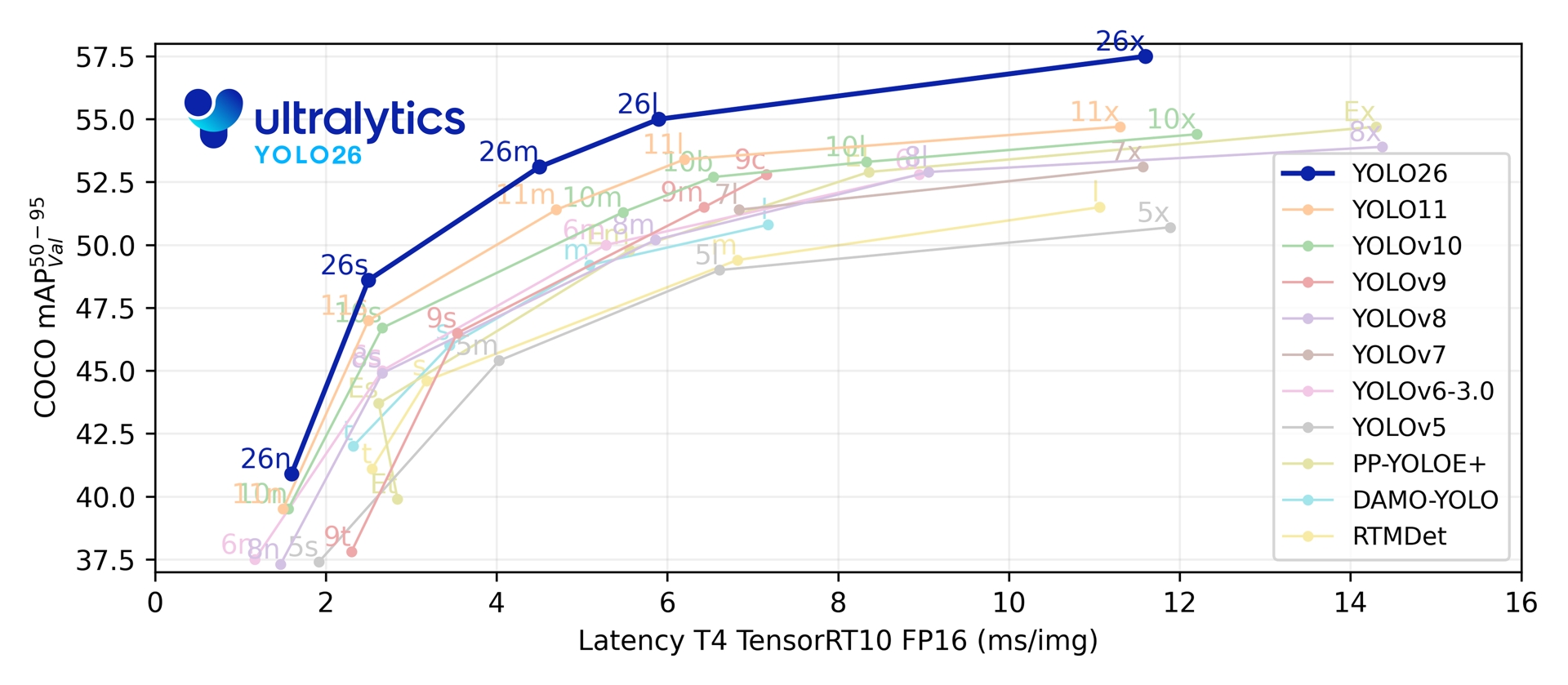

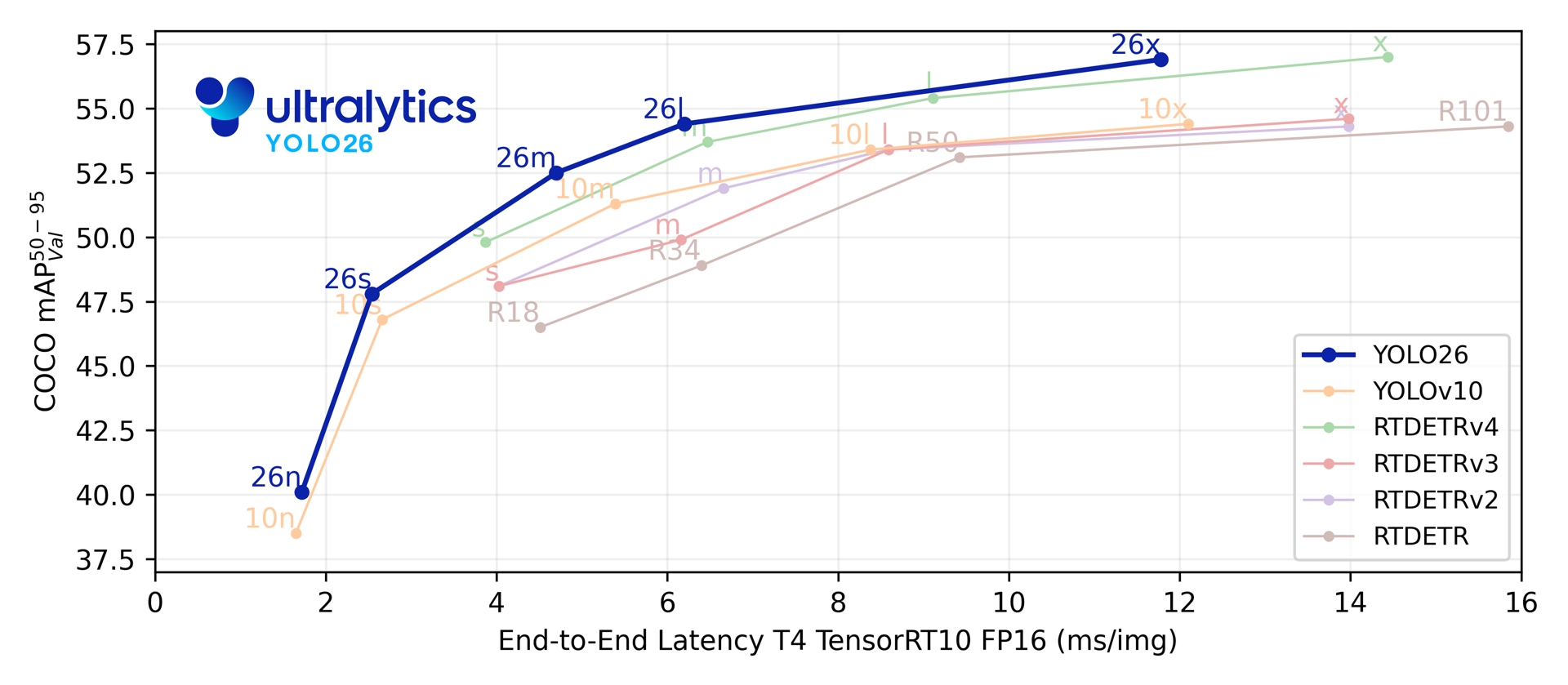

Ultralytics YOLO26 est la dernière évolution de la série YOLO de détecteurs d'objets en temps réel, conçue dès le départ pour les appareils périphériques et à faible consommation d'énergie. Il introduit une conception simplifiée qui supprime la complexité inutile tout en intégrant des innovations ciblées pour offrir un déploiement plus rapide, plus léger et plus accessible.

Essayer Ultralytics

Explorez et exécutez les modèles YOLO26 directement sur Ultralytics .

L'architecture de YOLO26 est guidée par trois principes fondamentaux :

- Simplicité : YOLO26 est un modèle natif de bout en bout, produisant des prédictions directement sans avoir besoin de suppression non maximale (NMS). En éliminant cette étape de post-traitement, l'inférence devient plus rapide, plus légère et plus facile à déployer dans les systèmes du monde réel. Cette approche révolutionnaire a été lancée pour la première fois dans YOLOv10 par Ao Wang à l'université de Tsinghua et a été perfectionnée dans YOLO26.

- Efficacité du déploiement : La conception de bout en bout supprime une étape entière du pipeline, simplifiant considérablement l'intégration, réduisant la latence et rendant le déploiement plus robuste dans divers environnements.

- Innovation en matière d'entraînement : YOLO26 introduit l'optimiseur MuSGD, un hybride de SGD et de Muon — inspiré des percées de Kimi K2 de Moonshot AI dans l'entraînement LLM. Cet optimiseur apporte une stabilité accrue et une convergence plus rapide, transférant les avancées de l'optimisation des modèles linguistiques à la vision par ordinateur.

- Optimisations spécifiques aux tâches : YOLO26 introduit des améliorations ciblées pour des tâches spécialisées, y compris la perte de segmentation sémantique et les modules proto multi-échelle pour la Segmentation, l'estimation du maximum de vraisemblance résiduelle (RLE) pour l'estimation de Pose de haute précision, et un décodage optimisé avec perte angulaire pour résoudre les problèmes de limites dans l'OBB.

Ensemble, ces innovations offrent une famille de modèles qui atteint une plus grande précision sur les petits objets, offre un déploiement transparent et s'exécute jusqu'à 43 % plus rapidement sur les CPU — faisant de YOLO26 l'un des modèles YOLO les plus pratiques et les plus déployables à ce jour pour les environnements aux ressources limitées.

Principales caractéristiques

Suppression de DFL

Le module Distribution Focal Loss (DFL), bien qu’efficace, compliquait souvent l’exportation et limitait la compatibilité matérielle. YOLO26 supprime complètement DFL, simplifiant l’inférence et élargissant la prise en charge des appareils périphériques et à faible consommation d’énergie.Inférence sans NMS de bout en bout

Contrairement aux détecteurs traditionnels qui s'appuient sur la NMS comme étape de post-traitement distincte, YOLO26 est nativement de bout en bout. Les prédictions sont générées directement, ce qui réduit la latence et rend l'intégration dans les systèmes de production plus rapide, plus légère et plus fiable.ProgLoss + STAL

L'amélioration des fonctions de perte augmente la précision de la détection, avec des améliorations notables dans la reconnaissance des petits objets, une exigence essentielle pour l'IoT, la robotique, l'imagerie aérienne et d'autres applications périphériques.Optimiseur MuSGD

Un nouvel optimiseur hybride qui combine SGD avec Muon. Inspiré par Kimi K2 de Moonshot AI, MuSGD introduit des méthodes d'optimisation avancées de l'entraînement LLM dans la vision par ordinateur, permettant un entraînement plus stable et une convergence plus rapide.Inférence CPU jusqu’à 43 % plus rapide

Spécifiquement optimisé pour l’informatique en périphérie, YOLO26 offre une inférence CPU considérablement plus rapide, garantissant des performances en temps réel sur les appareils sans GPU.Améliorations de la segmentation d'instance

Introduit une perte de segmentation sémantique pour améliorer la convergence du modèle et un module proto amélioré qui exploite les informations multi-échelle pour une qualité de masque supérieure.Estimation de pose de précision

Intègre l'estimation de la log-vraisemblance résiduelle (RLE) pour une localisation plus précise des points clés et optimise le processus de décodage pour une vitesse d'inférence accrue.Décodage OBB raffiné

Introduit une perte angulaire spécialisée pour améliorer la précision de détection des objets de forme carrée et optimise le décodage OBB pour résoudre les problèmes de discontinuité des limites.

Tâches et modes pris en charge

YOLO26 s'appuie sur la gamme de modèles polyvalents établie par les versions précédentes d'Ultralytics YOLO, offrant un support amélioré pour diverses tâches de vision par ordinateur :

| Modèle | Noms de fichiers | Tâche | Inférence | Validation | Entraînement | Exporter |

|---|---|---|---|---|---|---|

| YOLO26 | yolo26n.pt yolo26s.pt yolo26m.pt yolo26l.pt yolo26x.pt | Détection | ✅ | ✅ | ✅ | ✅ |

| YOLO26-seg | yolo26n-seg.pt yolo26s-seg.pt yolo26m-seg.pt yolo26l-seg.pt yolo26x-seg.pt | Segmentation d'instance | ✅ | ✅ | ✅ | ✅ |

| YOLO26-pose | yolo26n-pose.pt yolo26s-pose.pt yolo26m-pose.pt yolo26l-pose.pt yolo26x-pose.pt | Pose/Points clés | ✅ | ✅ | ✅ | ✅ |

| YOLO26-obb | yolo26n-obb.pt yolo26s-obb.pt yolo26m-obb.pt yolo26l-obb.pt yolo26x-obb.pt | Détection orientée | ✅ | ✅ | ✅ | ✅ |

| YOLO26-cls | yolo26n-cls.pt yolo26s-cls.pt yolo26m-cls.pt yolo26l-cls.pt yolo26x-cls.pt | Classification | ✅ | ✅ | ✅ | ✅ |

Ce cadre unifié garantit que YOLO26 est applicable à la détection en temps réel, à la segmentation, à la classification, à l'estimation de pose et à la détection d'objets orientés — le tout avec prise en charge de l'entraînement, de la validation, de l'inférence et de l'exportation.

Mesures de performance

Performance

Consultez les Docs de détection pour des exemples d'utilisation avec ces modèles entraînés sur COCO, qui incluent 80 classes pré-entraînées.

| Modèle | Taille (pixels) | mAPval 50-95 | mAPval 50-95(e2e) | Vitesse CPU ONNX (ms) | Vitesse T4 TensorRT10 (ms) | paramètres (M) | FLOPs (B) |

|---|---|---|---|---|---|---|---|

| YOLO26n | 640 | 40.9 | 40.1 | 38.9 ± 0.7 | 1.7 ± 0.0 | 2.4 | 5.4 |

| YOLO26s | 640 | 48.6 | 47.8 | 87.2 ± 0.9 | 2.5 ± 0.0 | 9.5 | 20.7 |

| YOLO26m | 640 | 53.1 | 52.5 | 220.0 ± 1.4 | 4.7 ± 0.1 | 20.4 | 68.2 |

| YOLO26l | 640 | 55.0 | 54.4 | 286.2 ± 2.0 | 6.2 ± 0.2 | 24.8 | 86.4 |

| YOLO26x | 640 | 57.5 | 56.9 | 525.8 ± 4.0 | 11.8 ± 0.2 | 55.7 | 193.9 |

Consultez les Docs de segmentation pour des exemples d'utilisation avec ces modèles entraînés sur COCO, qui incluent 80 classes pré-entraînées.

| Modèle | Taille (pixels) | mAPbox 50-95(e2e) | mAPmasque 50-95(e2e) | Vitesse CPU ONNX (ms) | Vitesse T4 TensorRT10 (ms) | paramètres (M) | FLOPs (B) |

|---|---|---|---|---|---|---|---|

| YOLO26n-seg | 640 | 39.6 | 33.9 | 53.3 ± 0.5 | 2.1 ± 0.0 | 2.7 | 9.1 |

| YOLO26s-seg | 640 | 47.3 | 40.0 | 118.4 ± 0.9 | 3.3 ± 0.0 | 10.4 | 34.2 |

| YOLO26m-seg | 640 | 52.5 | 44.1 | 328.2 ± 2.4 | 6.7 ± 0.1 | 23.6 | 121.5 |

| YOLO26l-seg | 640 | 54.4 | 45.5 | 387.0 ± 3.7 | 8.0 ± 0.1 | 28.0 | 139.8 |

| YOLO26x-seg | 640 | 56.5 | 47.0 | 787.0 ± 6.8 | 16.4 ± 0.1 | 62.8 | 313.5 |

Consultez les Docs de classification pour des exemples d'utilisation avec ces modèles entraînés sur ImageNet, qui incluent 1000 classes pré-entraînées.

| Modèle | Taille (pixels) | acc top1 | acc top5 | Vitesse CPU ONNX (ms) | Vitesse T4 TensorRT10 (ms) | paramètres (M) | FLOPs (B) à 224 |

|---|---|---|---|---|---|---|---|

| YOLO26n-cls | 224 | 71.4 | 90.1 | 5.0 ± 0.3 | 1.1 ± 0.0 | 2.8 | 0.5 |

| YOLO26s-cls | 224 | 76.0 | 92.9 | 7.9 ± 0.2 | 1.3 ± 0.0 | 6.7 | 1.6 |

| YOLO26m-cls | 224 | 78.1 | 94.2 | 17.2 ± 0.4 | 2.0 ± 0.0 | 11.6 | 4.9 |

| YOLO26l-cls | 224 | 79.0 | 94.6 | 23.2 ± 0.3 | 2.8 ± 0.0 | 14.1 | 6.2 |

| YOLO26x-cls | 224 | 79.9 | 95.0 | 41.4 ± 0.9 | 3.8 ± 0.0 | 29.6 | 13.6 |

Consultez les Docs d'estimation de pose pour des exemples d'utilisation avec ces modèles entraînés sur COCO, qui incluent 1 classe pré-entraînée, 'personne'.

| Modèle | Taille (pixels) | mAPpose 50-95(e2e) | mAPpose 50(e2e) | Vitesse CPU ONNX (ms) | Vitesse T4 TensorRT10 (ms) | paramètres (M) | FLOPs (B) |

|---|---|---|---|---|---|---|---|

| YOLO26n-pose | 640 | 57.2 | 83.3 | 40.3 ± 0.5 | 1.8 ± 0.0 | 2.9 | 7.5 |

| YOLO26s-pose | 640 | 63.0 | 86.6 | 85.3 ± 0.9 | 2.7 ± 0.0 | 10.4 | 23.9 |

| YOLO26m-pose | 640 | 68.8 | 89.6 | 218.0 ± 1.5 | 5.0 ± 0.1 | 21.5 | 73.1 |

| YOLO26l-pose | 640 | 70.4 | 90.5 | 275.4 ± 2.4 | 6.5 ± 0.1 | 25.9 | 91.3 |

| YOLO26x-pose | 640 | 71.6 | 91.6 | 565.4 ± 3.0 | 12.2 ± 0.2 | 57.6 | 201.7 |

Consultez les Docs de détection orientée pour des exemples d'utilisation avec ces modèles entraînés sur DOTAv1, qui incluent 15 classes pré-entraînées.

| Modèle | Taille (pixels) | mAPtest 50-95(e2e) | mAPtest 50(e2e) | Vitesse CPU ONNX (ms) | Vitesse T4 TensorRT10 (ms) | paramètres (M) | FLOPs (B) |

|---|---|---|---|---|---|---|---|

| YOLO26n-obb | 1024 | 52.4 | 78.9 | 97.7 ± 0.9 | 2.8 ± 0.0 | 2.5 | 14.0 |

| YOLO26s-obb | 1024 | 54.8 | 80.9 | 218.0 ± 1.4 | 4.9 ± 0.1 | 9.8 | 55.1 |

| YOLO26m-obb | 1024 | 55.3 | 81.0 | 579.2 ± 3.8 | 10.2 ± 0.3 | 21.2 | 183.3 |

| YOLO26l-obb | 1024 | 56.2 | 81.6 | 735.6 ± 3.1 | 13.0 ± 0.2 | 25.6 | 230.0 |

| YOLO26x-obb | 1024 | 56.7 | 81.7 | 1485.7 ± 11.5 | 30.5 ± 0.9 | 57.6 | 516.5 |

Les valeurs des paramètres et des FLOP sont celles du modèle fusionné après model.fuse(), qui fusionne les couches Conv et BatchNorm et supprime la tête de détection auxiliaire un-à-plusieurs. Les points de contrôle pré-entraînés conservent l'architecture d'entraînement complète et peuvent afficher des comptes plus élevés.

Exemples d'utilisation

Cette section fournit des exemples simples d'entraînement et d'inférence YOLO26. Pour une documentation complète sur ces modes et d'autres, consultez les pages de documentation Predict, Train, Val et Export.

Notez que l'exemple ci-dessous concerne les modèles YOLO26 Detect pour la détection d'objets. Pour les tâches supplémentaires prises en charge, consultez la documentation Segment, Classify, OBB et Pose.

Exemple

PyTorch pré-entraînés *.pt ainsi que la configuration des modèles *.yaml fichiers peuvent être passés aux YOLO() class pour créer une instance de modèle en python :

from ultralytics import YOLO

# Load a COCO-pretrained YOLO26n model

model = YOLO("yolo26n.pt")

# Train the model on the COCO8 example dataset for 100 epochs

results = model.train(data="coco8.yaml", epochs=100, imgsz=640)

# Run inference with the YOLO26n model on the 'bus.jpg' image

results = model("path/to/bus.jpg")

Des commandes CLI sont disponibles pour exécuter directement les modèles :

# Load a COCO-pretrained YOLO26n model and train it on the COCO8 example dataset for 100 epochs

yolo train model=yolo26n.pt data=coco8.yaml epochs=100 imgsz=640

# Load a COCO-pretrained YOLO26n model and run inference on the 'bus.jpg' image

yolo predict model=yolo26n.pt source=path/to/bus.jpg

Architecture à double tête

YOLO26 dispose d'une architecture à double tête qui offre une grande flexibilité pour différents scénarios de déploiement :

- Tête individuelle (par défaut): Produit des prédictions de bout en bout sans NMS, en générant

(N, 300, 6)avec un maximum de 300 détections par image. Cette tête est optimisée pour une inférence rapide et un déploiement simplifié. - Tête un-à-plusieurs: Génère YOLO traditionnelles nécessitant NMS , en produisant

(N, nc + 4, 8400)oùncest le nombre de classes. Cette tête atteint généralement une précision légèrement supérieure au prix d'un traitement supplémentaire.

Vous pouvez changer de tête pendant l'exportation, la prédiction ou la validation :

from ultralytics import YOLO

model = YOLO("yolo26n.pt")

# Use one-to-one head (default, no NMS required)

results = model.predict("image.jpg") # inference

metrics = model.val(data="coco.yaml") # validation

model.export(format="onnx") # export

# Use one-to-many head (requires NMS)

results = model.predict("image.jpg", end2end=False) # inference

metrics = model.val(data="coco.yaml", end2end=False) # validation

model.export(format="onnx", end2end=False) # export

# Use one-to-one head (default, no NMS required)

yolo predict model=yolo26n.pt source=image.jpg

yolo val model=yolo26n.pt data=coco.yaml

yolo export model=yolo26n.pt format=onnx

# Use one-to-many head (requires NMS)

yolo predict model=yolo26n.pt source=image.jpg end2end=False

yolo val model=yolo26n.pt data=coco.yaml end2end=False

yolo export model=yolo26n.pt format=onnx end2end=False

Le choix dépend de vos besoins de déploiement : utilisez la tête un-à-un pour une vitesse et une simplicité maximales, ou la tête un-à-plusieurs lorsque la précision est la priorité absolue.

YOLOE-26 : Segmentation d'instance à vocabulaire ouvert

YOLOE-26 intègre l'architecture haute performance de YOLO26 avec les capacités de vocabulaire ouvert de la série YOLOE. Il permet la détection et la segmentation en temps réel de toute classe d'objets en utilisant des invites textuelles, des invites visuelles, ou un mode sans invite pour l'inférence zero-shot, éliminant efficacement les contraintes de l'entraînement à catégories fixes.

En tirant parti de la conception de bout en bout sans NMS de YOLO26, YOLOE-26 offre une inférence rapide dans un monde ouvert. Cela en fait une solution puissante pour les applications embarquées dans des environnements dynamiques où les objets d'intérêt représentent un vocabulaire large et évolutif.

Performance

Consultez la documentation YOLOE pour des exemples d'utilisation avec ces modèles entraînés sur les jeux de données Objects365v1, GQA et Flickr30k.

| Modèle | Taille (pixels) | Type de prompt | mAPminival 50-95(e2e) | mAPminival 50-95 | mAPr | mAPc | mAPf | paramètres (M) | FLOPs (B) |

|---|---|---|---|---|---|---|---|---|---|

| YOLOE-26n-seg | 640 | Textuel/Visuel | 23.7 / 20.9 | 24.7 / 21.9 | 20.5 / 17.6 | 24.1 / 22.3 | 26.1 / 22.4 | 4.8 | 6.0 |

| YOLOE-26s-seg | 640 | Textuel/Visuel | 29.9 / 27.1 | 30.8 / 28.6 | 23.9 / 25.1 | 29.6 / 27.8 | 33.0 / 29.9 | 13.1 | 21.7 |

| YOLOE-26m-seg | 640 | Textuel/Visuel | 35.4 / 31.3 | 35.4 / 33.9 | 31.1 / 33.4 | 34.7 / 34.0 | 36.9 / 33.8 | 27.9 | 70.1 |

| YOLOE-26l-seg | 640 | Textuel/Visuel | 36.8 / 33.7 | 37.8 / 36.3 | 35.1 / 37.6 | 37.6 / 36.2 | 38.5 / 36.1 | 32.3 | 88.3 |

| YOLOE-26x-seg | 640 | Textuel/Visuel | 39.5 / 36.2 | 40.6 / 38.5 | 37.4 / 35.3 | 40.9 / 38.8 | 41.0 / 38.8 | 69.9 | 196.7 |

Consultez la documentation YOLOE pour des exemples d'utilisation avec ces modèles entraînés sur les jeux de données Objects365v1, GQA et Flickr30k.

| Modèle | Taille (pixels) | mAPminival 50-95(e2e) | mAPminival 50(e2e) | paramètres (M) | FLOPs (B) |

|---|---|---|---|---|---|

| YOLOE-26n-seg-pf | 640 | 16.6 | 22.7 | 6.5 | 15.8 |

| YOLOE-26s-seg-pf | 640 | 21.4 | 28.6 | 16.2 | 35.5 |

| YOLOE-26m-seg-pf | 640 | 25.7 | 33.6 | 36.2 | 122.1 |

| YOLOE-26l-seg-pf | 640 | 27.2 | 35.4 | 40.6 | 140.4 |

| YOLOE-26x-seg-pf | 640 | 29.9 | 38.7 | 86.3 | 314.4 |

Exemple d'utilisation

YOLOE-26 prend en charge les prompts textuels et visuels. L'utilisation des prompts est simple : il suffit de les passer via le predict méthode comme indiqué ci-dessous :

Exemple

Les prompts textuels vous permettent de spécifier les classes que vous souhaitez detecter au moyen de descriptions textuelles. Le code suivant montre comment utiliser YOLOE-26 pour detecter des personnes et des bus dans une image :

from ultralytics import YOLO

# Initialize model

model = YOLO("yoloe-26l-seg.pt") # or select yoloe-26s/m-seg.pt for different sizes

# Set text prompt to detect person and bus. You only need to do this once after you load the model.

model.set_classes(["person", "bus"])

# Run detection on the given image

results = model.predict("path/to/image.jpg")

# Show results

results[0].show()

Les invites visuelles vous permettent de guider le modèle en lui montrant des exemples visuels des classes cibles, plutôt qu'en les décrivant par du texte.

import numpy as np

from ultralytics import YOLO

from ultralytics.models.yolo.yoloe import YOLOEVPSegPredictor

# Initialize model

model = YOLO("yoloe-26l-seg.pt")

# Define visual prompts using bounding boxes and their corresponding class IDs.

# Each box highlights an example of the object you want the model to detect.

visual_prompts = dict(

bboxes=np.array(

[

[221.52, 405.8, 344.98, 857.54], # Box enclosing person

[120, 425, 160, 445], # Box enclosing glasses

],

),

cls=np.array(

[

0, # ID to be assigned for person

1, # ID to be assigned for glasses

]

),

)

# Run inference on an image, using the provided visual prompts as guidance

results = model.predict(

"ultralytics/assets/bus.jpg",

visual_prompts=visual_prompts,

predictor=YOLOEVPSegPredictor,

)

# Show results

results[0].show()

YOLOE-26 inclut des variantes sans prompt qui sont livrées avec un vocabulaire intégré. Ces modèles ne nécessitent aucun prompt et fonctionnent comme les modèles YOLO traditionnels. Au lieu de s'appuyer sur des étiquettes fournies par l'utilisateur ou des exemples visuels, ils detectent des objets à partir d'une liste prédéfinie de 4 585 classes basée sur l'ensemble de tags utilisé par le Recognize Anything Model Plus (RAM++).

from ultralytics import YOLO

# Initialize model

model = YOLO("yoloe-26l-seg-pf.pt")

# Run prediction. No prompts required.

results = model.predict("path/to/image.jpg")

# Show results

results[0].show()

Pour une exploration approfondie des techniques de prompting, de l'entraînement à partir de zéro et des exemples d'utilisation complets, consultez la documentation YOLOE.

Citations et remerciements

Publication Ultralytics YOLO26

Ultralytics n'a pas publié d'article de recherche formel pour YOLO26 en raison de la nature rapidement évolutive des modèles. Au lieu de cela, nous nous concentrons sur la fourniture de modèles de pointe et sur leur facilité d'utilisation. Pour les dernières mises à jour sur les fonctionnalités, les architectures et l'utilisation de YOLO, consultez notre dépôt GitHub et notre documentation.

Si vous utilisez YOLO26 ou d'autres logiciels Ultralytics dans votre travail, veuillez le citer comme suit:

@software{yolo26_ultralytics,

author = {Glenn Jocher and Jing Qiu},

title = {Ultralytics YOLO26},

version = {26.0.0},

year = {2026},

url = {https://github.com/ultralytics/ultralytics},

orcid = {0000-0001-5950-6979, 0000-0003-3783-7069},

license = {AGPL-3.0}

}

DOI en attente. YOLO26 est disponible sous les licences AGPL-3.0 et Entreprise.

FAQ

Quelles sont les principales améliorations de YOLO26 par rapport à YOLO11 ?

- Suppression de DFL : Simplifie l'exportation et élargit la compatibilité Edge

- Inférence sans NMS de bout en bout : Élimine la NMS pour un déploiement plus rapide et plus simple

- ProgLoss + STAL : Améliore la précision, en particulier sur les petits objets

- Optimiseur MuSGD : Combine SGD et Muon (inspiré du Kimi K2 de Moonshot) pour un entraînement plus stable et efficace

- Inférence CPU jusqu'à 43 % plus rapide : Gains de performance majeurs pour les appareils utilisant uniquement le CPU

Quelles tâches YOLO26 prend-il en charge ?

YOLO26 est une famille de modèles unifiée, offrant un support de bout en bout pour de multiples tâches de vision par ordinateur :

- Détection d'objets

- Segmentation d'instance

- Classification d'images

- Estimation de pose

- Détection d'objets orientés (OBB)

Chaque variante de taille (n, s, m, l, x) prend en charge toutes les tâches, ainsi que des versions à vocabulaire ouvert via YOLOE-26.

Pourquoi YOLO26 est-il optimisé pour le déploiement en périphérie ?

YOLO26 offre des performances de pointe en périphérie avec :

- Inférence CPU jusqu'à 43 % plus rapide

- Taille du modèle et encombrement mémoire réduits

- Architecture simplifiée pour la compatibilité (pas de DFL, pas de NMS)

- Formats d'exportation flexibles, y compris TensorRT, ONNX, CoreML, TFLite et OpenVINO

Comment démarrer avec YOLO26 ?

Les modèles YOLO26 ont été publiés le 14 janvier 2026 et sont disponibles au téléchargement. Installez ou mettez à jour le ultralytics package et chargez un modèle :

from ultralytics import YOLO

# Load a pretrained YOLO26 nano model

model = YOLO("yolo26n.pt")

# Run inference on an image

results = model("image.jpg")

Consultez la section Exemples d'utilisation pour les instructions de formation, de validation et d'exportation.