इमेजनेट डेटासेट

इमेजनेट दृश्य वस्तु पहचान अनुसंधान में उपयोग के लिए डिज़ाइन की गई एनोटेट छवियों का एक बड़े पैमाने पर डेटाबेस है। इसमें 14 मिलियन से अधिक छवियां हैं, प्रत्येक छवि को वर्डनेट सिंसेट का उपयोग करके एनोटेट किया गया है, जिससे यह कंप्यूटर दृष्टि कार्यों में गहन शिक्षण मॉडल के प्रशिक्षण के लिए उपलब्ध सबसे व्यापक संसाधनों में से एक है।

इमेजनेट प्रीट्रेन्ड मॉडल

| को गढ़ना | आकार वाला (पिक्सेल) |

एसीसी शीर्ष 1 |

एसीसी शीर्ष 5 |

गति CPU ONNX (एमएस) |

गति ए100 TensorRT (एमएस) |

परम (एम) |

फ्लॉप (B) 640 पर |

|---|---|---|---|---|---|---|---|

| YOLOv8n-सीएलएस | 224 | 69.0 | 88.3 | 12.9 | 0.31 | 2.7 | 4.3 |

| YOLOv8s-सीएलएस | 224 | 73.8 | 91.7 | 23.4 | 0.35 | 6.4 | 13.5 |

| YOLOv8m-सीएलएस | 224 | 76.8 | 93.5 | 85.4 | 0.62 | 17.0 | 42.7 |

| YOLOv8l-सीएलएस | 224 | 76.8 | 93.5 | 163.0 | 0.87 | 37.5 | 99.7 |

| YOLOv8x-सीएलएस | 224 | 79.0 | 94.6 | 232.0 | 1.01 | 57.4 | 154.8 |

प्रमुख विशेषताऐं

- इमेजनेट में हजारों ऑब्जेक्ट श्रेणियों में फैले 14 मिलियन से अधिक उच्च-रिज़ॉल्यूशन छवियां हैं।

- डेटासेट को वर्डनेट पदानुक्रम के अनुसार व्यवस्थित किया जाता है, जिसमें प्रत्येक सिंसेट एक श्रेणी का प्रतिनिधित्व करता है।

- इमेजनेट का व्यापक रूप से कंप्यूटर दृष्टि के क्षेत्र में प्रशिक्षण और बेंचमार्किंग के लिए उपयोग किया जाता है, विशेष रूप से छवि वर्गीकरण और ऑब्जेक्ट डिटेक्शन कार्यों के लिए।

- वार्षिक इमेजनेट लार्ज स्केल विजुअल रिकॉग्निशन चैलेंज (ILSVRC) कंप्यूटर दृष्टि अनुसंधान को आगे बढ़ाने में सहायक रहा है।

डेटासेट संरचना

ImageNet डेटासेट को WordNet पदानुक्रम का उपयोग करके व्यवस्थित किया जाता है। पदानुक्रम में प्रत्येक नोड एक श्रेणी का प्रतिनिधित्व करता है, और प्रत्येक श्रेणी को एक सिंसेट (पर्यायवाची शब्दों का एक संग्रह) द्वारा वर्णित किया जाता है। इमेजनेट में छवियों को एक या एक से अधिक सिंसेट के साथ एनोटेट किया जाता है, जो विभिन्न वस्तुओं और उनके संबंधों को पहचानने के लिए प्रशिक्षण मॉडल के लिए एक समृद्ध संसाधन प्रदान करता है।

इमेजनेट लार्ज स्केल विजुअल रिकॉग्निशन चैलेंज (ILSVRC)

वार्षिक इमेजनेट लार्ज स्केल विजुअल रिकॉग्निशन चैलेंज (ILSVRC) कंप्यूटर दृष्टि के क्षेत्र में एक महत्वपूर्ण घटना रही है। इसने शोधकर्ताओं और डेवलपर्स को मानकीकृत मूल्यांकन मेट्रिक्स के साथ बड़े पैमाने पर डेटासेट पर अपने एल्गोरिदम और मॉडल का मूल्यांकन करने के लिए एक मंच प्रदान किया है। ILSVRC ने छवि वर्गीकरण, वस्तु का पता लगाने और अन्य कंप्यूटर दृष्टि कार्यों के लिए गहन शिक्षण मॉडल के विकास में महत्वपूर्ण प्रगति की है।

अनुप्रयोगों

इमेजनेट डेटासेट का व्यापक रूप से विभिन्न कंप्यूटर दृष्टि कार्यों, जैसे छवि वर्गीकरण, ऑब्जेक्ट डिटेक्शन और ऑब्जेक्ट स्थानीयकरण में गहन शिक्षण मॉडल के प्रशिक्षण और मूल्यांकन के लिए उपयोग किया जाता है। कुछ लोकप्रिय डीप लर्निंग आर्किटेक्चर, जैसे एलेक्सनेट, वीजीजी और रेसनेट को इमेजनेट डेटासेट का उपयोग करके विकसित और बेंचमार्क किया गया था।

उपयोग

224x224 के छवि आकार के साथ 100 युगों के लिए इमेजनेट डेटासेट पर एक गहन शिक्षण मॉडल को प्रशिक्षित करने के लिए, आप निम्न कोड स्निपेट का उपयोग कर सकते हैं। उपलब्ध तर्कों की व्यापक सूची के लिए, मॉडल प्रशिक्षण पृष्ठ देखें।

ट्रेन का उदाहरण

नमूना छवियाँ और एनोटेशन

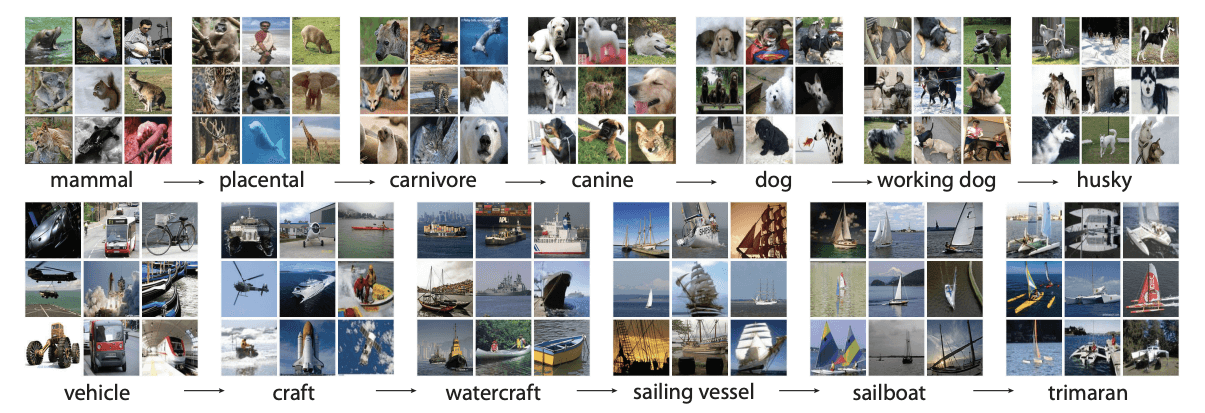

इमेजनेट डेटासेट में हजारों ऑब्जेक्ट श्रेणियों में फैली उच्च-रिज़ॉल्यूशन छवियां होती हैं, जो कंप्यूटर विज़न मॉडल के प्रशिक्षण और मूल्यांकन के लिए एक विविध और व्यापक डेटासेट प्रदान करती हैं। डेटासेट से छवियों के कुछ उदाहरण यहां दिए गए हैं:

उदाहरण इमेजनेट डेटासेट में छवियों की विविधता और जटिलता को प्रदर्शित करता है, जो मजबूत कंप्यूटर विज़न मॉडल के प्रशिक्षण के लिए विविध डेटासेट के महत्व पर प्रकाश डालता है।

प्रशंसा पत्र और पावती

यदि आप अपने शोध या विकास कार्य में इमेजनेट डेटासेट का उपयोग करते हैं, तो कृपया निम्नलिखित पेपर का हवाला दें:

@article{ILSVRC15,

author = {Olga Russakovsky and Jia Deng and Hao Su and Jonathan Krause and Sanjeev Satheesh and Sean Ma and Zhiheng Huang and Andrej Karpathy and Aditya Khosla and Michael Bernstein and Alexander C. Berg and Li Fei-Fei},

title={ImageNet Large Scale Visual Recognition Challenge},

year={2015},

journal={International Journal of Computer Vision (IJCV)},

volume={115},

number={3},

pages={211-252}

}

हम मशीन लर्निंग और कंप्यूटर विज़न रिसर्च कम्युनिटी के लिए एक मूल्यवान संसाधन के रूप में इमेजनेट डेटासेट बनाने और बनाए रखने के लिए ओल्गा रुसाकोवस्की, जिया डेंग और ली फी-फी के नेतृत्व में इमेजनेट टीम को स्वीकार करना चाहते हैं। इमेजनेट डेटासेट और इसके रचनाकारों के बारे में अधिक जानकारी के लिए, इमेजनेट वेबसाइट पर जाएं।

अक्सर पूछे जाने वाले प्रश्न

इमेजनेट डेटासेट क्या है और कंप्यूटर विज़न में इसका उपयोग कैसे किया जाता है?

इमेजनेट डेटासेट एक बड़े पैमाने पर डेटाबेस है जिसमें वर्डनेट सिंसेट का उपयोग करके वर्गीकृत 14 मिलियन से अधिक उच्च-रिज़ॉल्यूशन छवियां शामिल हैं। यह दृश्य वस्तु पहचान अनुसंधान में बड़े पैमाने पर उपयोग किया जाता है, जिसमें छवि वर्गीकरण और वस्तु का पता लगाना शामिल है। डेटासेट के एनोटेशन और सरासर मात्रा गहन शिक्षण मॉडल के प्रशिक्षण के लिए एक समृद्ध संसाधन प्रदान करते हैं। विशेष रूप से, एलेक्सनेट, वीजीजी और रेसनेट जैसे मॉडलों को इमेजनेट का उपयोग करके प्रशिक्षित और बेंचमार्क किया गया है, जो कंप्यूटर दृष्टि को आगे बढ़ाने में अपनी भूमिका प्रदर्शित करता है।

मैं प्रीट्रेन्ड का उपयोग कैसे कर सकता हूं YOLO इमेजनेट डेटासेट पर छवि वर्गीकरण के लिए मॉडल?

एक पूर्व-प्रशिक्षित का उपयोग करने के लिए Ultralytics YOLO छवि वर्गीकरण के लिए मॉडल ImageNet डेटासेट पर, निम्न चरणों का पालन करें:

ट्रेन का उदाहरण

अधिक गहन प्रशिक्षण निर्देश के लिए, हमारे प्रशिक्षण पृष्ठ को देखें।

मुझे Ultralytics YOLOv8 मेरे इमेजनेट डेटासेट प्रोजेक्ट्स के लिए पूर्व-प्रशिक्षित मॉडल?

Ultralytics YOLOv8 पूर्व-प्रशिक्षित मॉडल विभिन्न कंप्यूटर दृष्टि कार्यों के लिए गति और सटीकता के मामले में अत्याधुनिक प्रदर्शन प्रदान करते हैं। उदाहरण के लिए, YOLOv8n-सीएलएस मॉडल, 69.0% की शीर्ष -1 सटीकता और 88.3% की शीर्ष -5 सटीकता के साथ, वास्तविक समय के अनुप्रयोगों के लिए अनुकूलित है। पूर्व-प्रशिक्षित मॉडल खरोंच से प्रशिक्षण के लिए आवश्यक कम्प्यूटेशनल संसाधनों को कम करते हैं और विकास चक्रों में तेजी लाते हैं। निम्न प्रदर्शन मीट्रिक के बारे में अधिक जानें YOLOv8 इमेजनेट प्रीट्रेन्ड मॉडल सेक्शन में मॉडल।

इमेजनेट डेटासेट कैसे संरचित है, और यह महत्वपूर्ण क्यों है?

इमेजनेट डेटासेट को वर्डनेट पदानुक्रम का उपयोग करके व्यवस्थित किया जाता है, जहां पदानुक्रम में प्रत्येक नोड एक सिंसेट (पर्यायवाची शब्दों का संग्रह) द्वारा वर्णित श्रेणी का प्रतिनिधित्व करता है। यह संरचना विस्तृत एनोटेशन की अनुमति देती है, जिससे यह विभिन्न प्रकार की वस्तुओं को पहचानने के लिए प्रशिक्षण मॉडल के लिए आदर्श बन जाता है। इमेजनेट की विविधता और एनोटेशन समृद्धि इसे मजबूत और सामान्य गहन शिक्षण मॉडल विकसित करने के लिए एक मूल्यवान डेटासेट बनाती है। इस संगठन के बारे में अधिक जानकारी डेटासेट संरचना अनुभाग में पाई जा सकती है।

कंप्यूटर दृष्टि में इमेजनेट लार्ज स्केल विजुअल रिकग्निशन चैलेंज (ILSVRC) क्या भूमिका निभाता है?

वार्षिक इमेजनेट लार्ज स्केल विजुअल रिकग्निशन चैलेंज (ILSVRC) बड़े पैमाने पर, मानकीकृत डेटासेट पर एल्गोरिदम के मूल्यांकन के लिए एक प्रतिस्पर्धी मंच प्रदान करके कंप्यूटर दृष्टि में प्रगति को चलाने में महत्वपूर्ण रहा है। यह मानकीकृत मूल्यांकन मेट्रिक्स प्रदान करता है, छवि वर्गीकरण, वस्तु का पता लगाने और छवि विभाजन जैसे क्षेत्रों में नवाचार और विकास को बढ़ावा देता है। चुनौती ने लगातार गहरी शिक्षा और कंप्यूटर दृष्टि प्रौद्योगिकियों के साथ जो संभव है उसकी सीमाओं को आगे बढ़ाया है।