Guida Rapida: NVIDIA DGX Spark con Ultralytics YOLO26

Questa guida completa fornisce una panoramica dettagliata per il deployment di Ultralytics YOLO26 su NVIDIA DGX Spark, il supercomputer AI desktop compatto di NVIDIA. Inoltre, presenta benchmark di performance per dimostrare le capacità di YOLO26 su questo potente sistema.

Nota

Questa guida è stata testata con NVIDIA DGX Spark Founders Edition che esegue DGX OS basato su Ubuntu. Si prevede che funzioni con le ultime release di DGX OS.

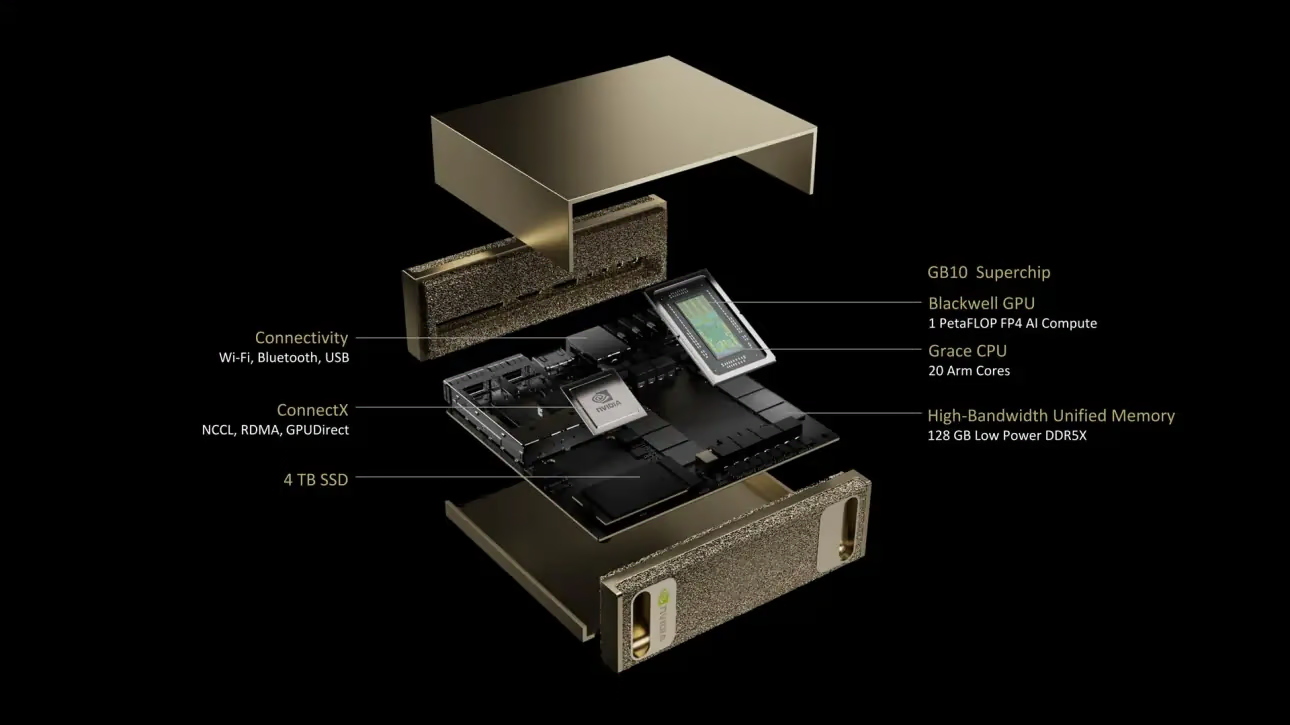

Cos'è NVIDIA DGX Spark?

NVIDIA DGX Spark è un supercomputer AI desktop compatto alimentato dal Superchip NVIDIA GB10 Grace Blackwell. Offre fino a 1 petaFLOP di prestazioni di calcolo AI con precisione FP4, rendendolo ideale per sviluppatori, ricercatori e data scientist che necessitano di potenti capacità AI in un fattore di forma desktop.

Specifiche Chiave

| Specifiche | Dettagli |

|---|---|

| Prestazioni AI | Fino a 1 PFLOP (FP4) |

| GPU | Architettura NVIDIA Blackwell con Tensor Cores di 5a generazione, RT Cores di 4a generazione |

| CPU | Processore Arm a 20 core (10 Cortex-X925 + 10 Cortex-A725) |

| Memoria | Memoria di sistema unificata LPDDR5x da 128 GB, interfaccia a 256 bit, 4266 MHz, larghezza di banda di 273 GB/s |

| Archiviazione | NVMe M.2 da 1 TB o 4 TB con crittografia automatica |

| Rete | 1x RJ-45 (10 GbE), ConnectX-7 Smart NIC, Wi-Fi 7, Bluetooth 5.4 |

| Connettività | 4x USB Type-C, 1x HDMI 2.1a, audio multicanale HDMI |

| Elaborazione video | 1x NVENC, 1x NVDEC |

DGX OS

NVIDIA DGX OS è una distribuzione Linux personalizzata che fornisce una base di sistema operativo stabile, testata e supportata per l'esecuzione di applicazioni di AI, machine learning e analisi sui sistemi DGX. Include:

- Una solida base Linux ottimizzata per carichi di lavoro AI

- Driver e impostazioni di sistema preconfigurati per hardware NVIDIA

- Aggiornamenti di sicurezza e funzionalità di manutenzione del sistema

- Compatibilità con l'ecosistema software NVIDIA più ampio

DGX OS segue un programma di rilascio regolare con aggiornamenti tipicamente forniti due volte all'anno (intorno a febbraio e agosto), con patch di sicurezza aggiuntive fornite tra le versioni principali.

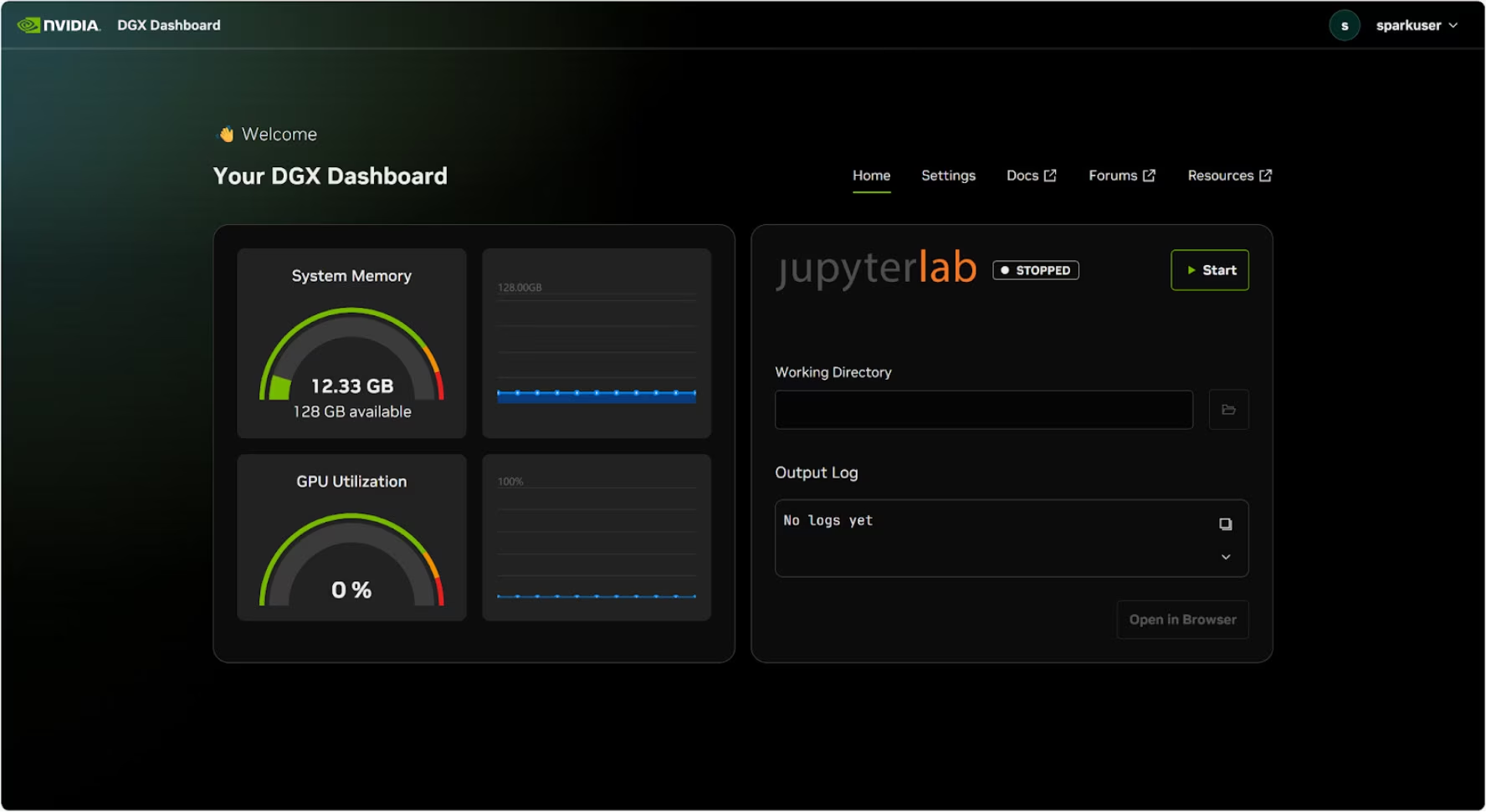

DGX Dashboard

DGX Spark include una DGX Dashboard integrata che fornisce:

- Monitoraggio del sistema in tempo reale: Panoramica delle metriche operative attuali del sistema

- Aggiornamenti di sistema: Possibilità di applicare gli aggiornamenti direttamente dalla dashboard

- Impostazioni di sistema: Modifica del nome del dispositivo e altre configurazioni

- JupyterLab integrato: Accesso ai Jupyter Notebook locali per lo sviluppo

Accesso alla Dashboard

Cliccare sul pulsante "Mostra applicazioni" nell'angolo in basso a sinistra del desktop Ubuntu, quindi selezionare "DGX Dashboard" per aprirlo nel browser.

# Open an SSH tunnel

ssh -L 11000:localhost:11000 username@spark-abcd.local

# Then open in browser

# http://localhost:11000

Dopo aver effettuato la connessione con NVIDIA Sync, cliccare sul pulsante "DGX Dashboard" per aprire la dashboard all'indirizzo http://localhost:11000.

JupyterLab integrato

La dashboard include un'istanza JupyterLab integrata che crea automaticamente un ambiente virtuale e installa i pacchetti raccomandati all'avvio. A ogni account utente viene assegnata una porta dedicata per l'accesso a JupyterLab.

Guida rapida con Docker

Il modo più rapido per iniziare con Ultralytics YOLO26 su NVIDIA DGX Spark è eseguire con immagini Docker pre-costruite. La stessa immagine Docker che supporta Jetson AGX Thor (JetPack 7.0) funziona su DGX Spark con DGX OS.

t=ultralytics/ultralytics:latest-nvidia-arm64

sudo docker pull $t && sudo docker run -it --ipc=host --runtime=nvidia --gpus all $t

Una volta completato, passare alla sezione Utilizzo di TensorRT su NVIDIA DGX Spark.

Inizia con l'installazione nativa

Per un'installazione nativa senza Docker, seguire questi passaggi.

Installa il pacchetto Ultralytics

Qui installeremo il pacchetto Ultralytics su DGX Spark con dipendenze opzionali in modo da poter esportare i modelli PyTorch in altri formati. Ci concentreremo principalmente sulle esportazioni NVIDIA TensorRT perché TensorRT garantirà le massime prestazioni dal DGX Spark.

Aggiorna l'elenco dei pacchetti, installa pip ed esegui l'aggiornamento all'ultima versione

sudo apt update sudo apt install python3-pip -y pip install -U pipInstalla

ultralyticspacchetto pip con dipendenze opzionalipip install ultralytics[export]Riavvia il dispositivo

sudo reboot

Installa PyTorch e Torchvision

L'installazione di Ultralytics sopra menzionata installerà Torch e Torchvision. Tuttavia, questi pacchetti installati tramite pip potrebbero non essere completamente ottimizzati per l'architettura ARM64 del DGX Spark con CUDA 13. Pertanto, si consiglia di installare le versioni compatibili con CUDA 13:

pip install torch torchvision --index-url https://download.pytorch.org/whl/cu130

Info

Quando si esegue PyTorch 2.9.1 su NVIDIA DGX Spark, si potrebbe riscontrare quanto segue: UserWarning durante l'inizializzazione di CUDA (ad esempio, eseguendo yolo checks, yolo predict, ecc.):

UserWarning: Found GPU0 NVIDIA GB10 which is of cuda capability 12.1.

Minimum and Maximum cuda capability supported by this version of PyTorch is (8.0) - (12.0)

Questo avviso può essere ignorato in sicurezza. Per risolverlo in modo permanente, è stata inviata una correzione nella PR di PyTorch #164590 che sarà inclusa nella release di PyTorch 2.10.

Installa onnxruntime-gpu

Il onnxruntime-gpu package ospitato in PyPI non ha aarch64 binari per sistemi ARM64. Pertanto, è necessario installare manualmente questo pacchetto. Questo pacchetto è richiesto per alcune delle esportazioni.

Qui scaricheremo e installeremo onnxruntime-gpu 1.24.0 con Python3.12 supporto.

pip install https://github.com/ultralytics/assets/releases/download/v0.0.0/onnxruntime_gpu-1.24.0-cp312-cp312-linux_aarch64.whl

Utilizzare TensorRT su NVIDIA DGX Spark

Tra tutti i formati di esportazione del modello supportati da Ultralytics, TensorRT offre le massime prestazioni di inferenza su NVIDIA DGX Spark, rendendolo la nostra principale raccomandazione per le distribuzioni. Per le istruzioni di configurazione e l'utilizzo avanzato, consultare la nostra guida dedicata all'integrazione di TensorRT.

Converti il modello in TensorRT ed esegui l'inferenza

Il modello YOLO26n in formato PyTorch viene convertito in TensorRT per eseguire l'inferenza con il modello esportato.

Esempio

from ultralytics import YOLO

# Load a YOLO26n PyTorch model

model = YOLO("yolo26n.pt")

# Export the model to TensorRT

model.export(format="engine") # creates 'yolo26n.engine'

# Load the exported TensorRT model

trt_model = YOLO("yolo26n.engine")

# Run inference

results = trt_model("https://ultralytics.com/images/bus.jpg")

# Export a YOLO26n PyTorch model to TensorRT format

yolo export model=yolo26n.pt format=engine # creates 'yolo26n.engine'

# Run inference with the exported model

yolo predict model=yolo26n.engine source='https://ultralytics.com/images/bus.jpg'

Nota

Visita la pagina di esportazione per accedere ad argomenti aggiuntivi durante l'esportazione di modelli in diversi formati

Benchmark YOLO11 su NVIDIA DGX Spark

I benchmark di YOLO11 sono stati eseguiti dal team Ultralytics su diversi formati di modello misurando velocità e accuratezza: PyTorch, TorchScript, ONNX, OpenVINO, TensorRT, TF SavedModel, TF GraphDef, TF Lite, MNN, NCNN, ExecuTorch. I benchmark sono stati eseguiti su NVIDIA DGX Spark con precisione FP32 e dimensione predefinita dell'immagine di input di 640.

Tabella comparativa dettagliata

La tabella seguente presenta i risultati dei benchmark per cinque diversi modelli (YOLO11n, YOLO11s, YOLO11m, YOLO11l, YOLO11x) su più formati, fornendo lo stato, la dimensione, la metrica mAP50-95(B) e il tempo di inferenza per ogni combinazione.

Prestazioni

| Formato | Stato | Dimensione su disco (MB) | mAP50-95(B) | Tempo di inferenza (ms/im) |

|---|---|---|---|---|

| PyTorch | ✅ | 5.4 | 0.5071 | 2.67 |

| TorchScript | ✅ | 10.5 | 0.5083 | 2.62 |

| ONNX | ✅ | 10.2 | 0.5074 | 5.92 |

| OpenVINO | ✅ | 10.4 | 0.5058 | 14.95 |

| TensorRT (FP32) | ✅ | 12.8 | 0.5085 | 1.95 |

| TensorRT (FP16) | ✅ | 7.0 | 0.5068 | 1.01 |

| TensorRT (INT8) | ✅ | 18.6 | 0.4880 | 1.62 |

| TF SavedModel | ✅ | 25.7 | 0.5076 | 36.39 |

| TF GraphDef | ✅ | 10.3 | 0.5076 | 41.06 |

| TF Lite | ✅ | 10.3 | 0.5075 | 64.36 |

| MNN | ✅ | 10.1 | 0.5075 | 12.14 |

| NCNN | ✅ | 10.2 | 0.5041 | 12.31 |

| ExecuTorch | ✅ | 10.2 | 0.5075 | 27.61 |

| Formato | Stato | Dimensione su disco (MB) | mAP50-95(B) | Tempo di inferenza (ms/im) |

|---|---|---|---|---|

| PyTorch | ✅ | 18.4 | 0.5767 | 5.38 |

| TorchScript | ✅ | 36.5 | 0.5781 | 5.48 |

| ONNX | ✅ | 36.3 | 0.5784 | 8.17 |

| OpenVINO | ✅ | 36.4 | 0.5809 | 27.12 |

| TensorRT (FP32) | ✅ | 39.8 | 0.5783 | 3.59 |

| TensorRT (FP16) | ✅ | 20.1 | 0.5800 | 1.85 |

| TensorRT (INT8) | ✅ | 17.5 | 0.5664 | 1.88 |

| TF SavedModel | ✅ | 90.8 | 0.5782 | 66.63 |

| TF GraphDef | ✅ | 36.3 | 0.5782 | 71.67 |

| TF Lite | ✅ | 36.3 | 0.5782 | 187.36 |

| MNN | ✅ | 36.2 | 0.5775 | 27.05 |

| NCNN | ✅ | 36.2 | 0.5806 | 26.26 |

| ExecuTorch | ✅ | 36.2 | 0.5782 | 54.73 |

| Formato | Stato | Dimensione su disco (MB) | mAP50-95(B) | Tempo di inferenza (ms/im) |

|---|---|---|---|---|

| PyTorch | ✅ | 38.8 | 0.6254 | 11.14 |

| TorchScript | ✅ | 77.3 | 0.6304 | 12.00 |

| ONNX | ✅ | 76.9 | 0.6304 | 13.83 |

| OpenVINO | ✅ | 77.1 | 0.6284 | 62.44 |

| TensorRT (FP32) | ✅ | 79.9 | 0.6305 | 6.96 |

| TensorRT (FP16) | ✅ | 40.6 | 0.6313 | 3.14 |

| TensorRT (INT8) | ✅ | 26.6 | 0.6204 | 3.30 |

| TF SavedModel | ✅ | 192.4 | 0.6306 | 139.85 |

| TF GraphDef | ✅ | 76.9 | 0.6306 | 146.76 |

| TF Lite | ✅ | 76.9 | 0.6306 | 568.18 |

| MNN | ✅ | 76.8 | 0.6306 | 67.67 |

| NCNN | ✅ | 76.8 | 0.6308 | 60.49 |

| ExecuTorch | ✅ | 76.9 | 0.6306 | 120.37 |

| Formato | Stato | Dimensione su disco (MB) | mAP50-95(B) | Tempo di inferenza (ms/im) |

|---|---|---|---|---|

| PyTorch | ✅ | 49.0 | 0.6366 | 13.95 |

| TorchScript | ✅ | 97.6 | 0.6399 | 15.67 |

| ONNX | ✅ | 97.0 | 0.6399 | 16.62 |

| OpenVINO | ✅ | 97.3 | 0.6377 | 78.80 |

| TensorRT (FP32) | ✅ | 99.2 | 0.6407 | 8.86 |

| TensorRT (FP16) | ✅ | 50.8 | 0.6350 | 3.85 |

| TensorRT (INT8) | ✅ | 32.5 | 0.6224 | 4.52 |

| TF SavedModel | ✅ | 242.7 | 0.6409 | 187.45 |

| TF GraphDef | ✅ | 97.0 | 0.6409 | 193.92 |

| TF Lite | ✅ | 97.0 | 0.6409 | 728.61 |

| MNN | ✅ | 96.9 | 0.6369 | 85.21 |

| NCNN | ✅ | 96.9 | 0.6373 | 77.62 |

| ExecuTorch | ✅ | 97.0 | 0.6409 | 153.56 |

| Formato | Stato | Dimensione su disco (MB) | mAP50-95(B) | Tempo di inferenza (ms/im) |

|---|---|---|---|---|

| PyTorch | ✅ | 109.3 | 0.6992 | 23.19 |

| TorchScript | ✅ | 218.1 | 0.6900 | 25.75 |

| ONNX | ✅ | 217.5 | 0.6900 | 27.43 |

| OpenVINO | ✅ | 217.8 | 0.6872 | 149.44 |

| TensorRT (FP32) | ✅ | 222.7 | 0.6902 | 13.87 |

| TensorRT (FP16) | ✅ | 111.1 | 0.6883 | 6.19 |

| TensorRT (INT8) | ✅ | 62.9 | 0.6793 | 6.62 |

| TF SavedModel | ✅ | 543.9 | 0.6900 | 335.10 |

| TF GraphDef | ✅ | 217.5 | 0.6900 | 348.86 |

| TF Lite | ✅ | 217.5 | 0.6900 | 1578.66 |

| MNN | ✅ | 217.3 | 0.6874 | 168.95 |

| NCNN | ✅ | 217.4 | 0.6901 | 132.13 |

| ExecuTorch | ✅ | 217.4 | 0.6900 | 297.17 |

Benchmark eseguiti con Ultralytics 8.3.249

Riproduci i nostri risultati

Per riprodurre i benchmark Ultralytics di cui sopra su tutti i formati di esportazione, esegui questo codice:

Esempio

from ultralytics import YOLO

# Load a YOLO26n PyTorch model

model = YOLO("yolo26n.pt")

# Benchmark YOLO26n speed and accuracy on the COCO128 dataset for all export formats

results = model.benchmark(data="coco128.yaml", imgsz=640)

# Benchmark YOLO26n speed and accuracy on the COCO128 dataset for all export formats

yolo benchmark model=yolo26n.pt data=coco128.yaml imgsz=640

Si noti che i risultati del benchmarking potrebbero variare in base all'esatta configurazione hardware e software di un sistema, nonché al carico di lavoro corrente del sistema al momento dell'esecuzione dei benchmark. Per i risultati più affidabili, utilizzare un dataset con un gran numero di immagini, ad esempio, data='coco.yaml' (5000 immagini val).

Best Practices per NVIDIA DGX Spark

Quando si utilizza NVIDIA DGX Spark, ci sono alcune best practice da seguire per abilitare le massime prestazioni nell'esecuzione di YOLO26.

Monitorare le Prestazioni del Sistema

Utilizzare gli strumenti di monitoraggio di NVIDIA per track l'utilizzo di GPU e CPU:

nvidia-smiOttimizzare l'Utilizzo della Memoria

Con 128GB di memoria unificata, DGX Spark può gestire grandi dimensioni di batch e modelli. Considerare l'aumento della dimensione del batch per un throughput migliorato:

from ultralytics import YOLO model = YOLO("yolo26n.engine") results = model.predict(source="path/to/images", batch=16)Utilizzare TensorRT con FP16 o INT8

Per prestazioni ottimali, esportare i modelli con precisione FP16 o INT8:

yolo export model=yolo26n.pt format=engine half=True # FP16 yolo export model=yolo26n.pt format=engine int8=True # INT8

Aggiornamenti del Sistema (Founders Edition)

Mantenere aggiornata la DGX Spark Founders Edition è fondamentale per le prestazioni e la sicurezza. NVIDIA offre due metodi principali per aggiornare il sistema operativo, i driver e il firmware.

Utilizzo della DGX Dashboard (Consigliato)

La DGX Dashboard è il metodo consigliato per eseguire gli aggiornamenti di sistema garantendo la compatibilità. Consente di:

- Visualizzare gli aggiornamenti di sistema disponibili

- Installare patch di sicurezza e aggiornamenti di sistema

- Gestire gli aggiornamenti dei driver e del firmware NVIDIA

Aggiornamenti Manuali del Sistema

Per gli utenti esperti, gli aggiornamenti possono essere eseguiti manualmente tramite terminale:

sudo apt update

sudo apt dist-upgrade

sudo fwupdmgr refresh

sudo fwupdmgr upgrade

sudo reboot

Attenzione

Assicurarsi che il sistema sia collegato a una fonte di alimentazione stabile e di aver eseguito il backup dei dati critici prima di eseguire gli aggiornamenti.

Prossimi passi

Per ulteriori informazioni e supporto, consultare la documentazione di Ultralytics YOLO26.

FAQ

Come si deploy Ultralytics YOLO26 su NVIDIA DGX Spark?

Il deployment di Ultralytics YOLO26 su NVIDIA DGX Spark è semplice. Puoi utilizzare l'immagine Docker pre-costruita per una configurazione rapida o installare manualmente i pacchetti richiesti. I passaggi dettagliati per ciascun approccio sono disponibili nelle sezioni Avvio Rapido con Docker e Avvio con Installazione Nativa.

Quali prestazioni posso aspettarmi da YOLO26 su NVIDIA DGX Spark?

I modelli YOLO26 offrono prestazioni eccellenti su DGX Spark grazie al Superchip GB10 Grace Blackwell. Il formato TensorRT offre le migliori prestazioni di inferenza. Consulta la sezione Tabella di Confronto Dettagliata per i risultati specifici dei benchmark su diverse dimensioni e formati di modello.

Perché dovrei usare TensorRT per YOLO26 su DGX Spark?

TensorRT è altamente raccomandato per il deployment dei modelli YOLO26 su DGX Spark grazie alle sue prestazioni ottimali. Accelera l'inferenza sfruttando le capacità della GPU Blackwell, garantendo massima efficienza e velocità. Scopri di più nella sezione Utilizzo di TensorRT su NVIDIA DGX Spark.

Come si confronta DGX Spark con i dispositivi Jetson per YOLO26?

DGX Spark offre una potenza di calcolo significativamente maggiore rispetto ai dispositivi Jetson, con prestazioni AI fino a 1 PFLOP e 128 GB di memoria unificata, rispetto ai 2070 TFLOPS e 128 GB di memoria di Jetson AGX Thor. DGX Spark è progettato come un supercomputer AI desktop, mentre i dispositivi Jetson sono sistemi embedded ottimizzati per il deployment edge.

Posso usare la stessa immagine Docker per DGX Spark e Jetson AGX Thor?

Sì! L' ultralytics/ultralytics:latest-nvidia-arm64 immagine Docker supporta sia NVIDIA DGX Spark (con DGX OS) che Jetson AGX Thor (con JetPack 7.0), poiché entrambi utilizzano architettura ARM64 con CUDA 13 e stack software simili.